沖,DeepSeek-R1/V3推理系統架構設計被開源了!

DeepSeek開源周并未結束,One More Thing:DeepSeek-V3/R1 推理系統概述以及高達545%的成本利潤率:

- 通過以下方式優化吞吐量和延遲

?? 跨節點EP驅動的批量擴展

?? 計算-通信重疊

?? 負載均衡

- DeepSeek在線服務的統計數據

? 每個H800節點每秒73.7k/14.8k輸入/輸出 tokens

?? 成本利潤率545%

圖片

圖片

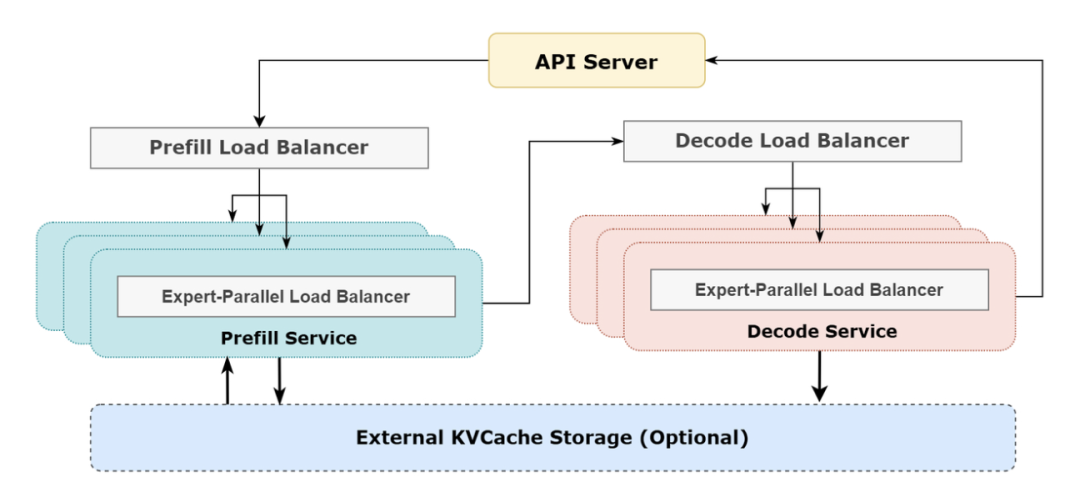

DeepSeek-V3 / R1 推理系統的優化目標是:更大的吞吐,更低的延遲。

圖片

圖片

大規模跨節點專家并行(EP)

由于DeepSeek-V3/R1模型具有高度稀疏性,每層256個專家中僅激活8個,因此必須采用大的overall batch size來為每個專家提供足夠的expert batch size,以實現更大的吞吐和更低的延遲。具體實現包括:

- Prefill階段:采用EP32,MLA和共享專家DP32,一個部署單元由4節點組成,每個節點有32個冗余路由專家,每張卡有9個路由專家和1個共享專家。

- Decode階段:采用EP144,MLA和共享專家DP144,一個部署單元由18節點組成,每個節點有32個冗余路由專家,每張卡有2個路由專家和1個共享專家。

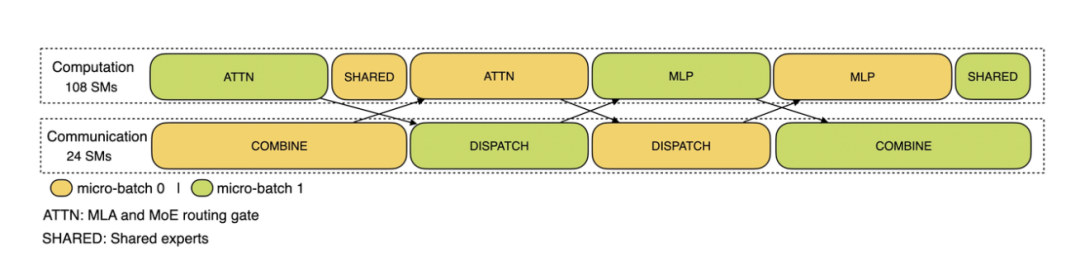

計算-通信重疊

為了掩蓋由多機多卡專家并行引入的通信開銷,系統采用了雙batch重疊策略,以提高整體吞吐量:

- Prefill階段:兩個batch的計算和通信交錯進行,一個batch在進行計算時可以掩蓋另一個batch的通信開銷。

圖片

圖片

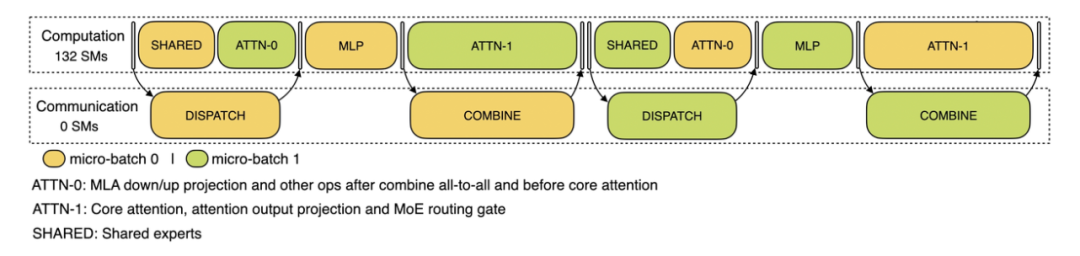

- Decode階段:將attention部分拆分為兩個stage,共計5個stage的流水線,以實現計算和通信的重疊。

圖片

圖片

負載均衡

由于采用了大規模并行(包括數據并行和專家并行),需要為每個GPU分配均衡的計算負載和通信負載,以避免性能瓶頸和資源浪費:

- Prefill Load Balancer:確保各GPU的計算量(core-attention計算負載)和輸入的token數量(dispatch發送量)盡量相同。

- Decode Load Balancer:確保各GPU的KVCache占用量(core-attention計算負載)和請求數量(dispatch發送量)盡量相同。

- Expert-Parallel Load Balancer:確保每個GPU上的專家計算量均衡,即最小化所有GPU的dispatch接收量的最大值。

實際統計數據

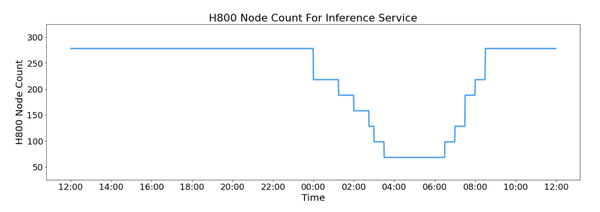

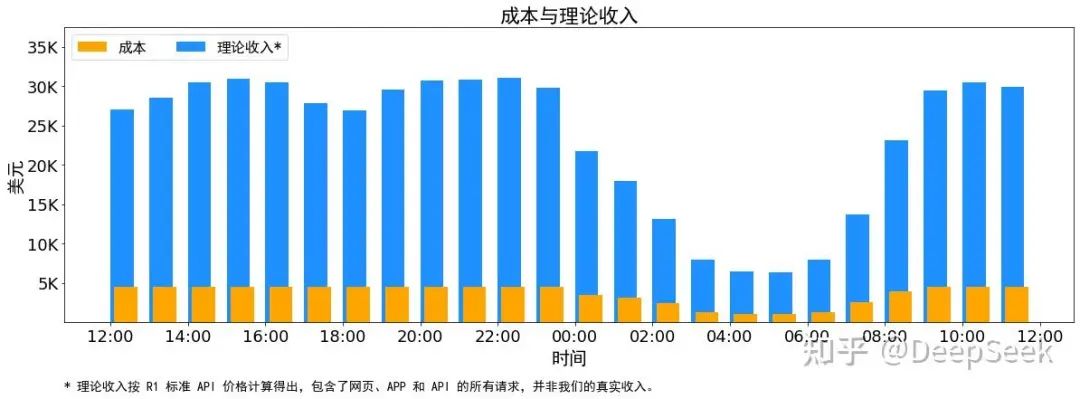

DeepSeek V3和R1的所有服務均使用H800 GPU,并采用與訓練一致的精度格式(FP8和BF16),以最大程度保證服務效果。在最近的24小時內,DeepSeek V3和R1推理服務的峰值占用為278個節點,平均占用226.75個節點。盡管理論上一天的總收入為$562,027,成本利潤率545%,但實際收入會因V3的定價較低、收費服務占比和夜間折扣等因素而有所不同。

圖片

圖片

https://zhuanlan.zhihu.com/p/27181462601

https://github.com/deepseek-ai/open-infra-index/blob/main/202502OpenSourceWeek/day_6_one_mo本文轉載自??PaperAgent??

已于2025-3-4 11:12:35修改

贊

收藏

回復

分享

微博

QQ

微信

舉報

回復

相關推薦