騰訊、上海科大開源InstantMesh,圖片直接生成3D模型

騰訊PCG ARC實驗室和上海科技大學的研究人員聯(lián)合開源了創(chuàng)新模型——InstantMesh。

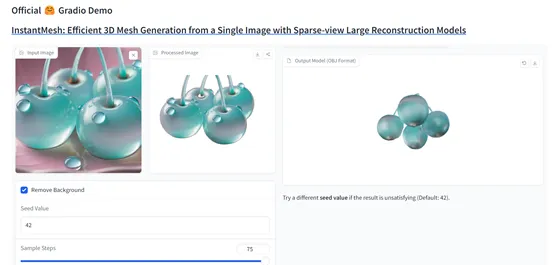

用戶通過InstantMesh上傳一張圖片,只需要十秒的時間就能將圖片變成360度全視角的3D模型。并且可以下載模型將其放在3D Max、瑪雅等專業(yè)軟件中,以簡化游戲、廣告、家居、虛擬現實等開發(fā)流程。

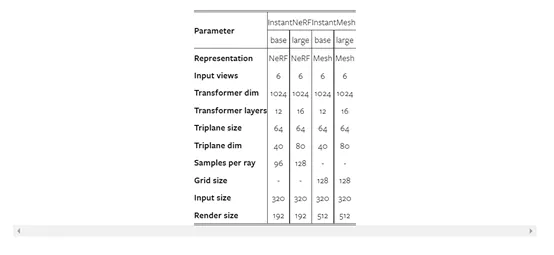

研究人員在公開數據集Google Scanned Objects、OmniObject3D等InstantMesh進行了綜合測試。

結果顯示,其生成的3D模型在視覺質量和幾何精度上都顯著優(yōu)于現有最新方法,如LGM、CRM等。在多視角的合成任務上,InstantMesh也明顯優(yōu)于SV3D等知名擴散模型。

開源地址:https://github.com/TencentARC/InstantMesh

在線demo:https://huggingface.co/spaces/TencentARC/InstantMesh

論文地址:https://arxiv.org/abs/2404.07191

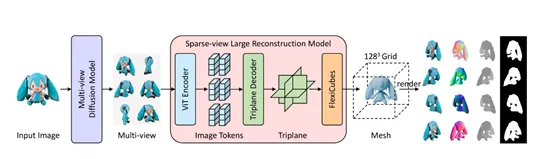

InstantMesh的技術創(chuàng)新在于,將多視圖擴散模型和稀疏視圖重建模型相結合使用。

首先利用多視角擴散模型生成一組一致的多視角圖像,然后利用稀疏視圖重建模型直接預測3D網格,整個過程只需要十幾秒甚至幾秒就能完成。

為了提高訓練效率,并在3D網格表示上應用幾何監(jiān)督信息,InstantMesh還引入了一個可微分的等值面提取模塊。這種方法能夠直接在網格表面上進行優(yōu)化,從而提高訓練效率和模型生成的質量。

多視圖擴散模型

?

多視圖擴散模型的主要作用是將一張靜態(tài)的2D圖片中生成一系列新的視角圖像,這些圖像覆蓋了目標物體的多個方向。

首先,接收用戶輸入的圖片,并利用Zero123++模型生成一系列的新視角圖像,包括了物體的正面、側面、上面、下面和背面等360度視角圖片。

這可以幫助InstantMesh捕捉到圖片的全方位信息,為后續(xù)的3D網格預測打下堅實的基礎。

簡單來說,整個過程就像玩拼圖游戲一樣,例如,需要從一張完整的圖片中找到所有可能的視角,然后將它們拼湊起來,形成一個完整的立體圖像。

所以,也可以把多視圖擴散模型理解成InstantMesh的“眼睛”,幫助它深度剖析每一張上傳的圖片。

稀疏視圖重建模型

?

稀疏視圖重建模型則主要負責將,多視圖擴散模型生成的視圖拼裝成3D模型。首先通過其內部的神經網絡架構,提取輸入圖像的特征,并將其與先前的知識結合起來,以便更好地理解物體的結構和外觀。

利用提取到的特征和輔助知識,稀疏視圖重建模型能預測出一個初步的3D網格模型,包含了物體的基本形狀和結構,但是在質量和細節(jié)方面還差很多。

所以,研究人員使用了可微分的等值面提取模塊對網格表面進行幾何監(jiān)督,大幅度優(yōu)化3D模型的細節(jié)和平滑度。

此外,這種直接在網格表面進行監(jiān)督訓練的優(yōu)化方法,避免了體素渲染的高計算消耗,同時能利用全分辨率的RGB圖像、深度圖和法線圖作為訓練監(jiān)督,也使得生成的3D模型更加適合于后續(xù)的渲染、編輯和分析等應用。

本文轉自 AIGC開放社區(qū) ,作者:AIGC開放社區(qū)