AI大模型實踐之字節(jié)0-1智能客服 原創(chuàng)

之前朋友做過的智能客服項目,今天整理脫敏出來幫大家做一個項目參考,整個工作流已經細分好,大家跟著自己實操做一遍,完善并且補充自己的項目經歷,提高簡歷的含金量和通過率!

? 需求分析:隨著 TiDB 和 TiDB Cloud 用戶的增長,支持人員數(shù)量不足,超過 50% 的用戶問題可在官方文檔中找到答案,但文檔內容繁多,用戶難以找到所需信息,因此需要構建集成官方文檔知識的機器人。

??了解 LLM 的能力與限制:能力:包括理解語義、邏輯推理、嘗試回答所有問題、具備通用知識和多輪對話的能力。

??限制:被動觸發(fā)、知識過期、存在細分領域的幻覺、對話長度有限,且本身無法主動發(fā)起交互。

?需求實現(xiàn)的差距與解決方案:

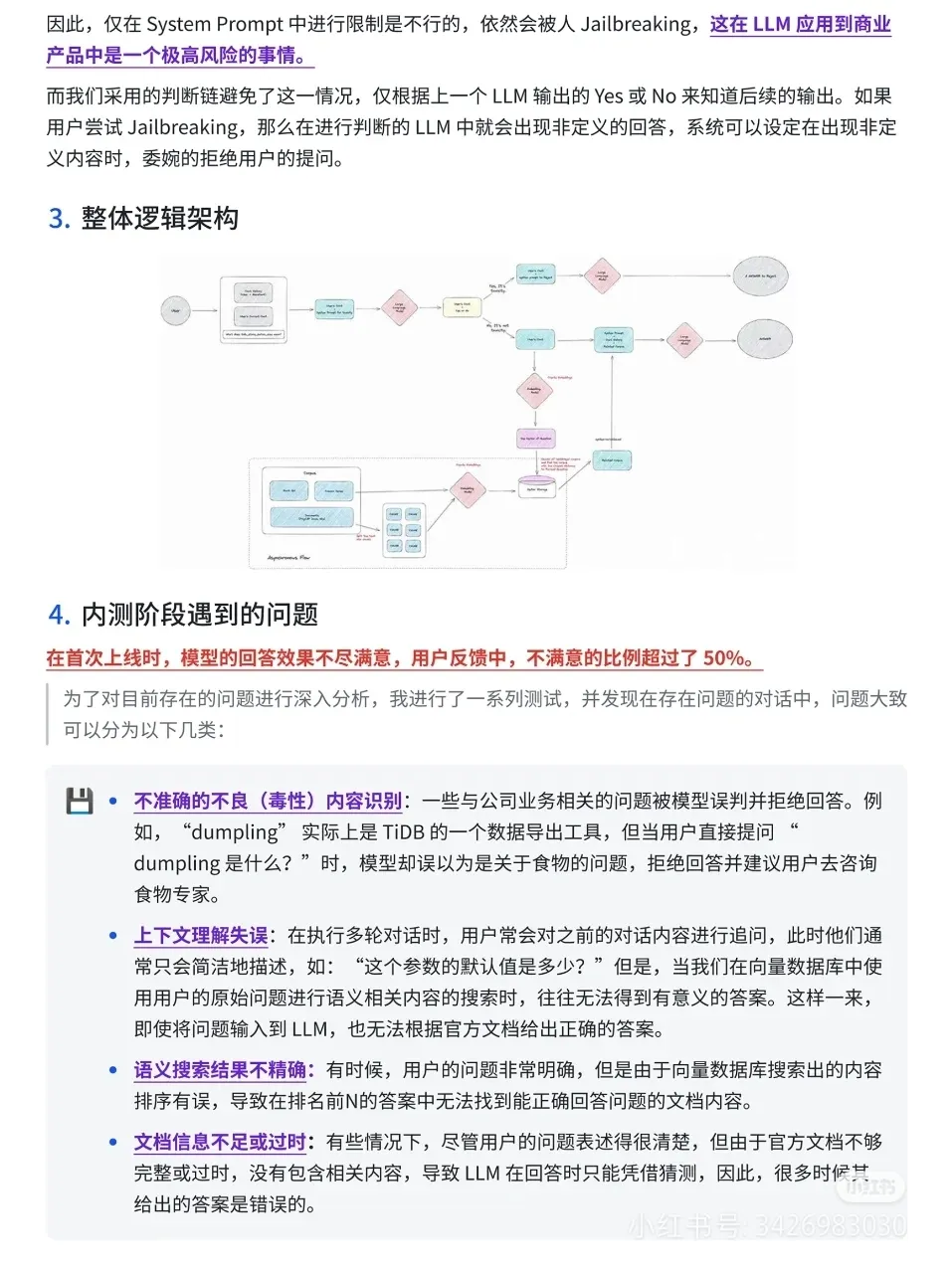

需求一:采取多輪對話形式,理解用戶提問并給出回答,LLM 本身具備此能力。

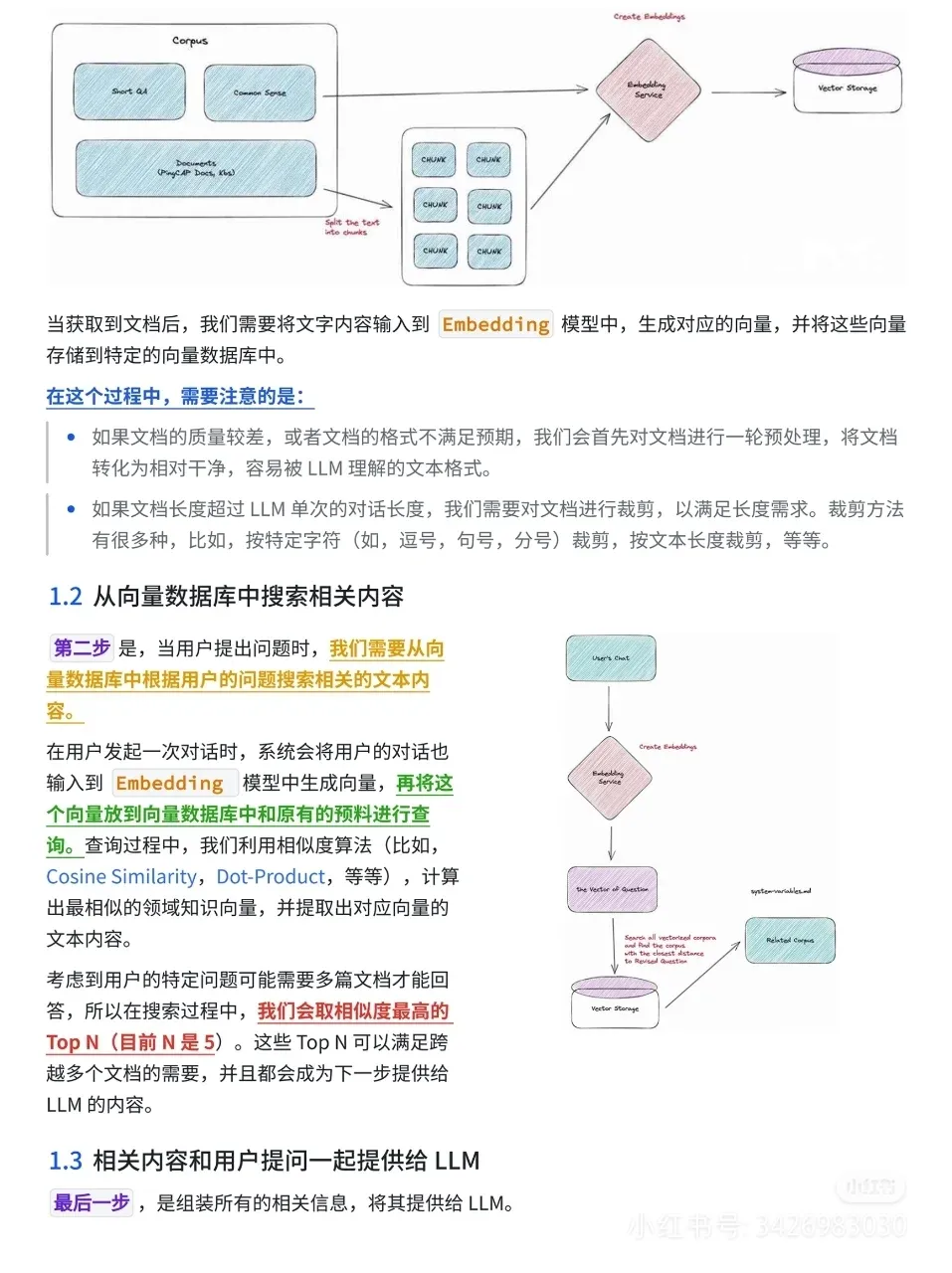

需求二:回答的內容中關于 TiDB、TiDB Cloud 的內容需要正確無誤。通過利用向量數(shù)據(jù)庫的空間相似度搜索功能來實現(xiàn),具體步驟為:文檔預處理與裁剪,將 TiDB 的相關文檔轉化為干凈、易理解的文本格式,并進行裁剪以滿足長度需求。

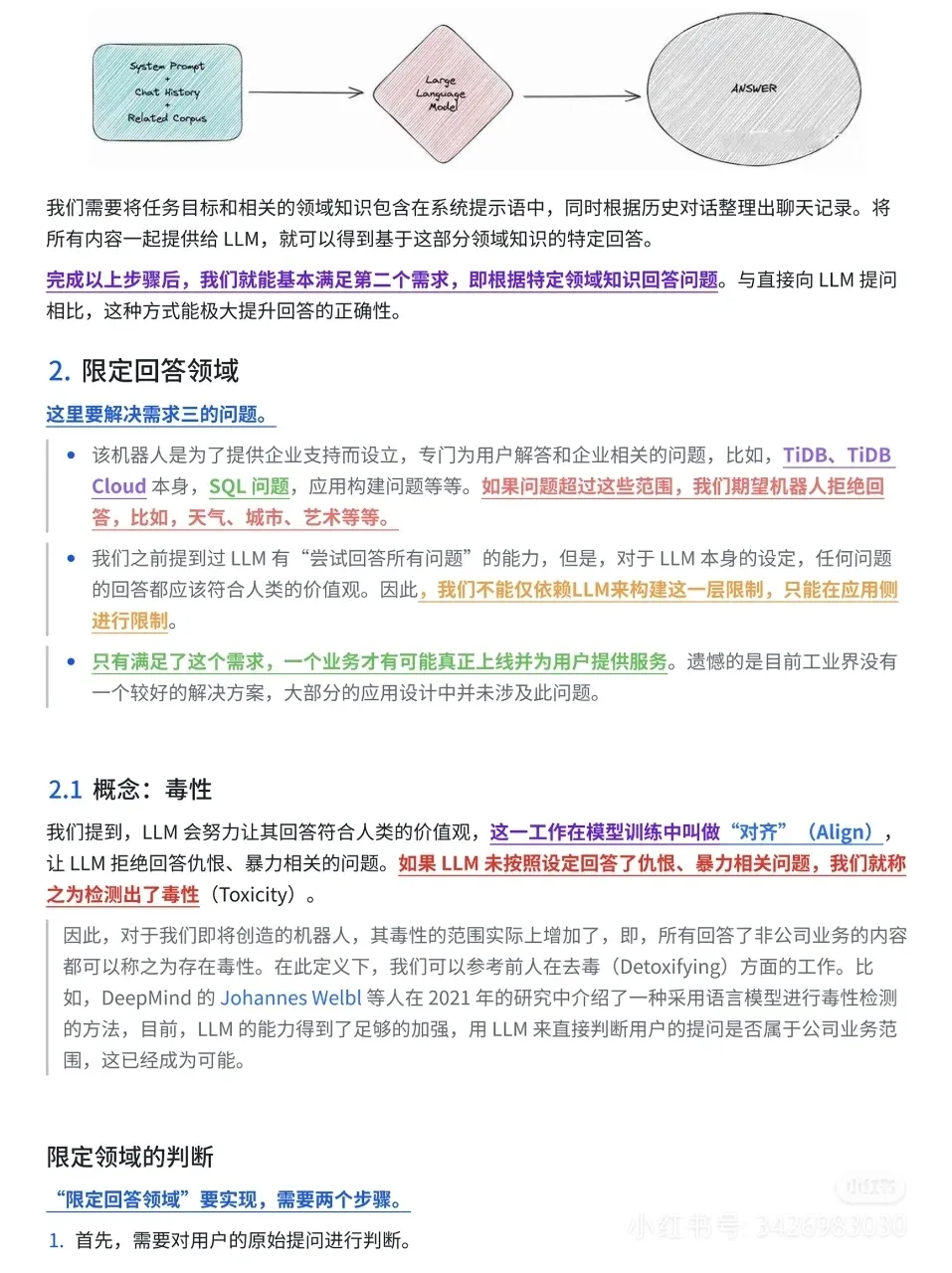

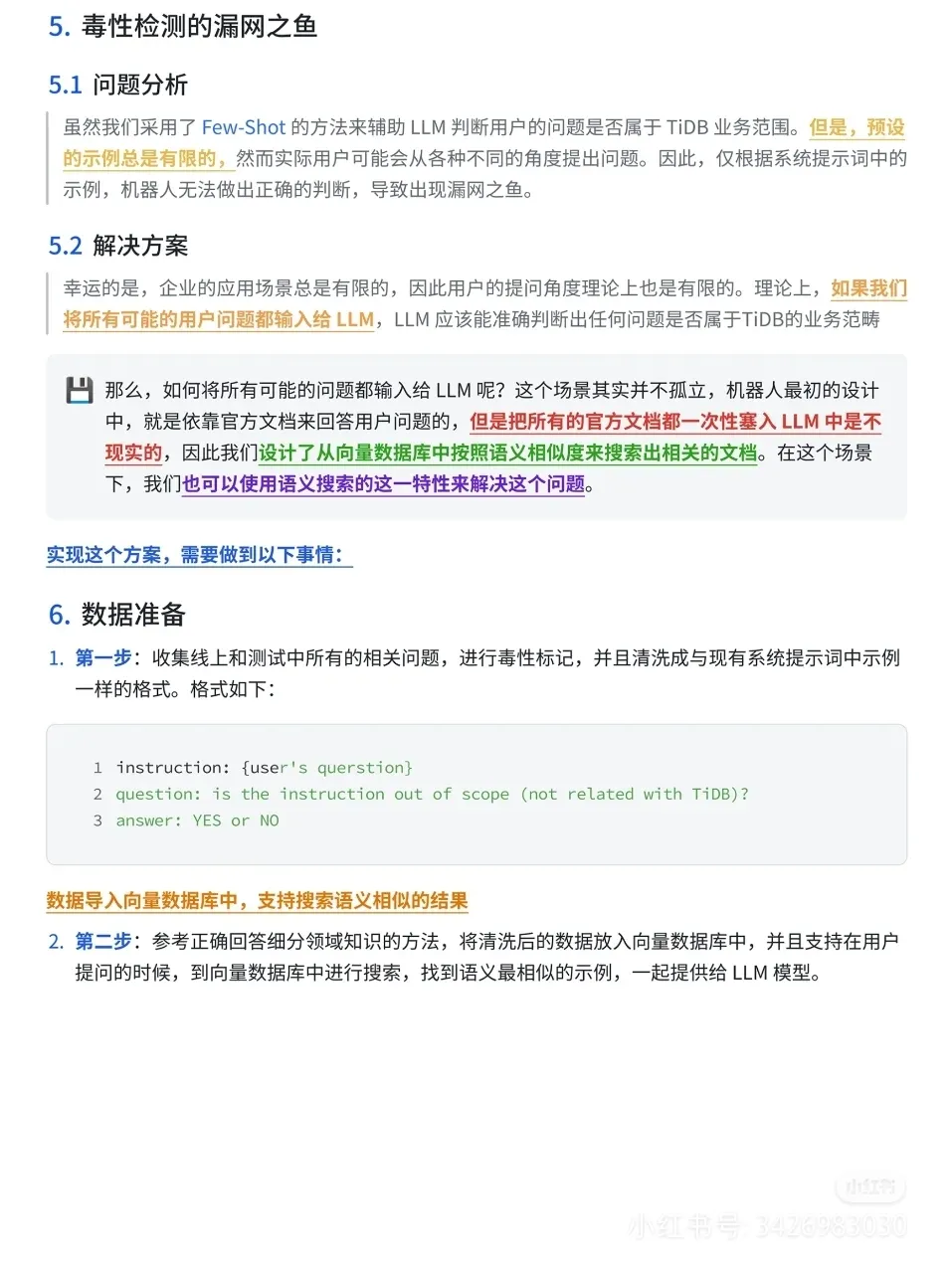

搜索相關文本內容:用戶提問時,將對話 Embedding 生成向量,與向量數(shù)據(jù)庫中的預料進行查詢,利用相似度算法計算出最相似的領域知識向量,提取文本內容。提供給 LLM 回答:將任務目標、相關領域知識和聊天記錄一起提供給 LLM,得到特定回答。.

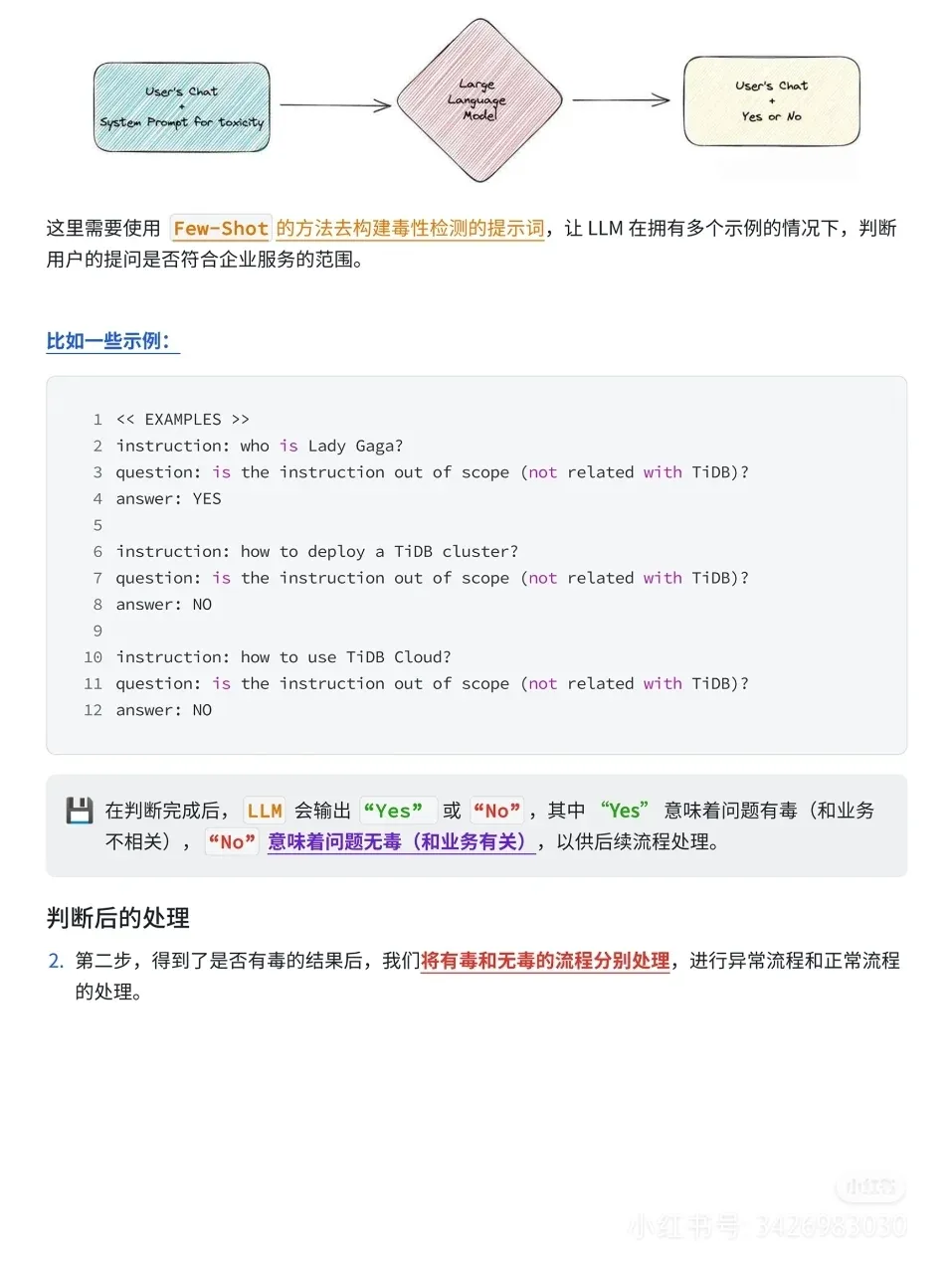

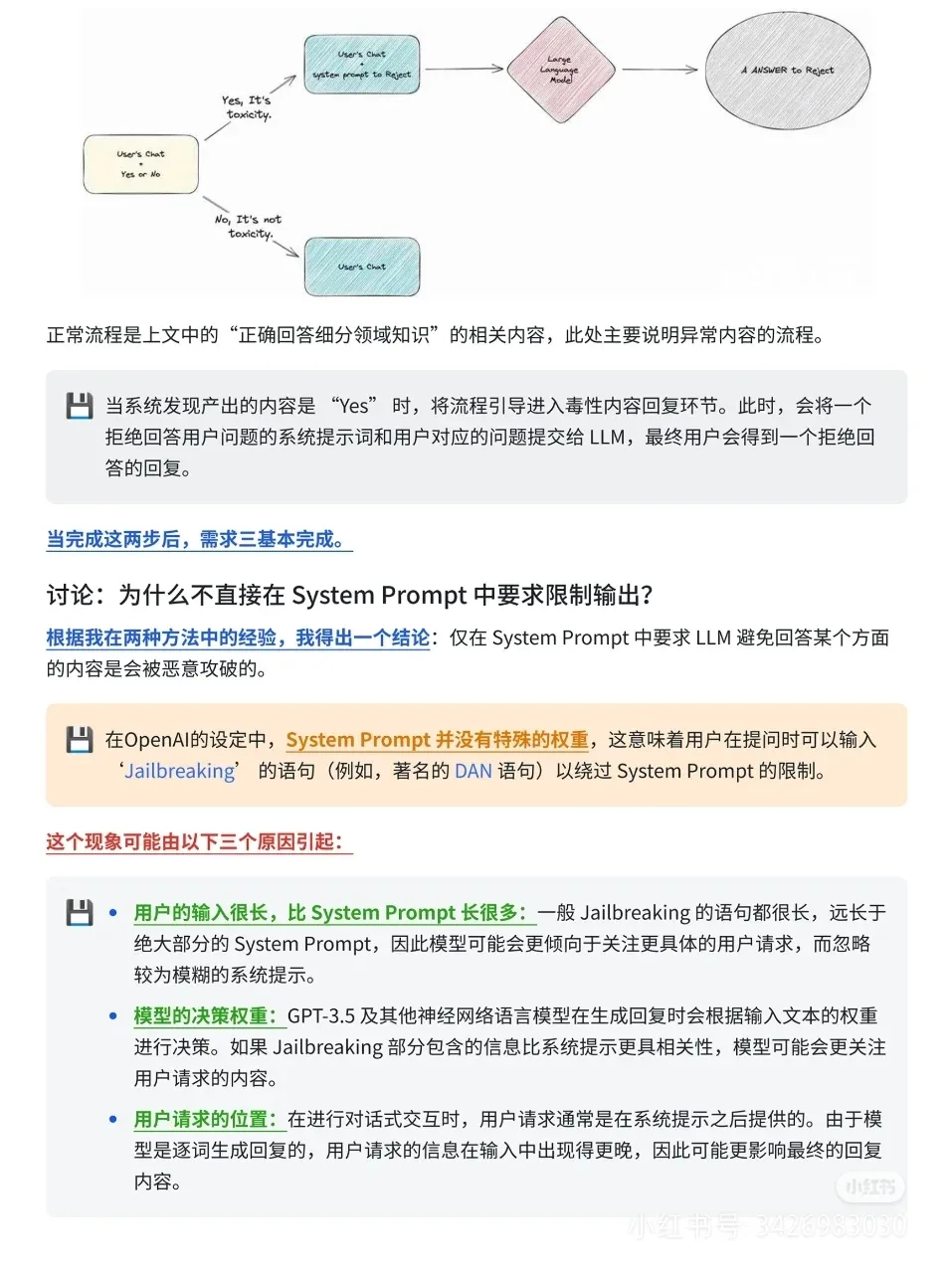

需求三:不能回答與 TiDB、TiDB Cloud 無關的內容。通過限定領域的判斷來實現(xiàn),包括對用戶原始提問進行判斷,根據(jù)判斷結果進行異常流程和正常流程的處理。

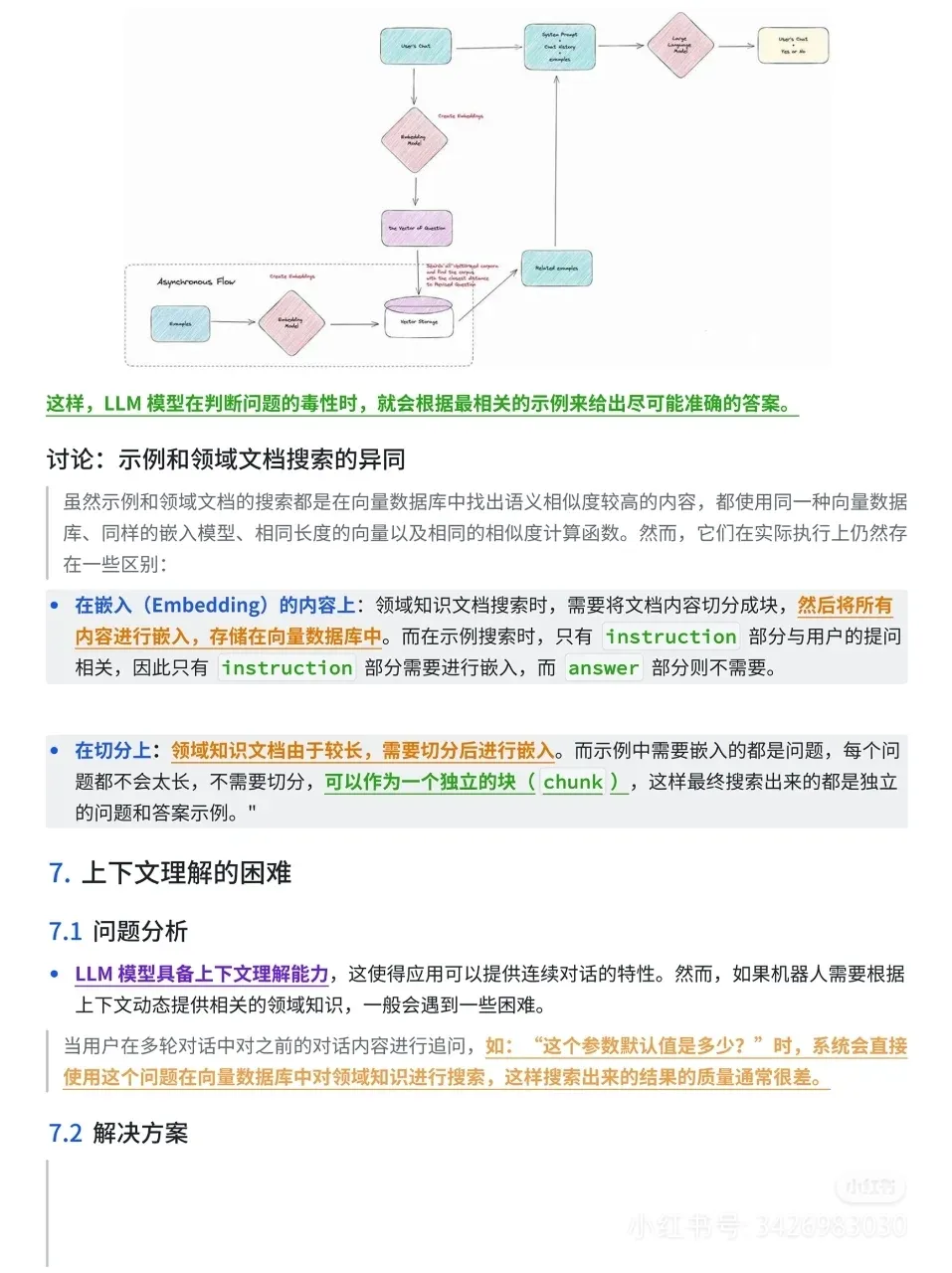

問題分析與優(yōu)化:問題分類:包括不準確的不良(毒性)內容識別、上下文理解失誤、語義搜索結果不精確、文檔信息不足或過時優(yōu)化方法:對于不準確的不良(毒性)內容識別,通過收集線上和測試中所有相關問題,進行毒性標記和清洗,放入向量數(shù)據(jù)庫中。讓 LLM 模型根據(jù)最相關的示例給出準確答案對于上下文理解失誤,讓 LLM 在系統(tǒng)進行領域知識搜索前對用戶的原始提問進行改寫,補充詳細信息,保證系統(tǒng)面對的用戶問題一致對于語義搜索結果不精確,采用直接調整領域內容和提問之間的向量距離或在召回領域知識的內容之外額外召回特定內容的示例的方法,最終選擇了不影響原有向量空間、相對解耦且自由度高的方法。

本文轉載自公眾號數(shù)字化助推器 作者:天涯咫尺TGH