探秘大語言模型數據合成能力:AgoraBench基準測試全解析 精華

現在語言模型用合成數據訓練變得越來越重要,但之前沒標準方法比較不同模型生成數據的能力。這篇文章提出 AgoraBench測試,用它評估模型在生成數據上的水平。結果發現不同模型各有厲害的地方,而且生成數據能力和解決問題能力不一樣,像數據質量的一些特點更能體現其生成能力。這對研究人員和用模型的人都有幫助,能讓研究人員知道什么樣的模型能更好地生成數據,讓用模型的人優化自己生成數據的方法,對語言模型在實際里用得更好很有意義。

鑒于合成數據在語言模型(LM)后訓練中的使用日益增加,語言模型生成高質量數據的能力已幾乎與其直接解決問題的能力同等重要。雖然先前的工作側重于開發有效的數據生成方法,但它們缺乏在統一設置下對不同語言模型作為數據生成器的系統比較。為了彌補這一差距,我們提出了 AGORABENCH,這是一個基準測試,它提供標準化的設置和指標來評估語言模型的數據生成能力。通過使用 6 種語言模型合成 126 萬個訓練實例并訓練 99 個學生模型,我們揭示了關于語言模型數據生成能力的關鍵見解。首先,我們觀察到語言模型表現出不同的優勢。例如,GPT - 4o 在生成新問題方面表現出色,而 Claude - 3.5 Sonnet 在改進現有問題方面表現更好。此外,我們的分析表明,語言模型的數據生成能力與其解決問題的能力并不一定相關。相反,數據質量的多個內在特征——包括響應質量、困惑度和指令難度——共同作為更好的指標。最后,我們證明了輸出格式的策略選擇和具有成本意識的模型選擇顯著影響數據生成的有效性。

?研究背景:語言模型后訓練對合成數據需求攀升,但此前評估模型數據生成能力的工作分散,缺統一實驗設定,不同研究在數據生成方法、模型選用、數據量及評估基準上差異大,難以精準衡量模型生成能力,故需標準框架來有效對比各模型在數據生成任務中的表現,推動該領域發展。

?研究貢獻:

創新提出 AGORABENCH 基準測試,結合多領域與多種數據生成法,統一設置僅變數據生成器,精準度量語言模型數據生成能力,為系統評估奠基。

挖掘模型優勢差異,如 GPT - 4o 實例生成強、Claude - 3.5 Sonnet 質量優化優,打破以解題力衡量生成力局限,發現兩者弱關聯,明確指令難度等多特征聯合為優指標,助選合適模型。

驗證輸出格式與成本選模影響生成,JSON 格式或降性能、預算限定時便宜模型多生數據或更優,為優化生成策略提供關鍵依據。

?實現設計:

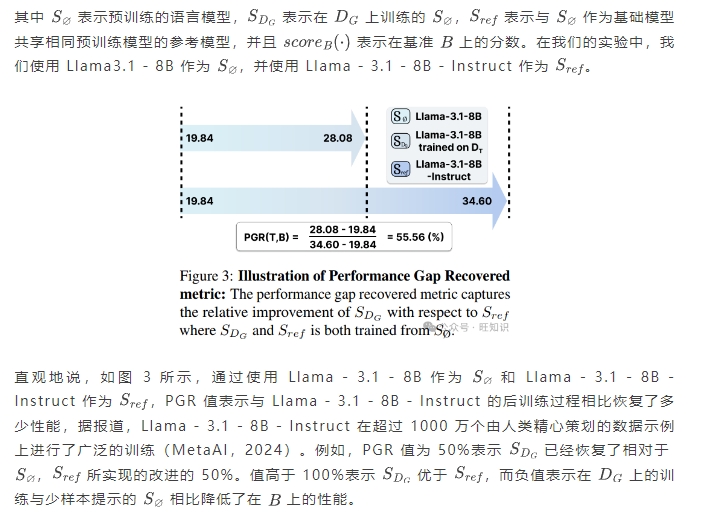

實驗設置:確定數學、代碼、指令跟隨核心領域,依數據生成法擇適配種子數據集與基準測試,使語言模型于各設置造等量訓練實例,以孤立數據質量影響、精準評估生成力。

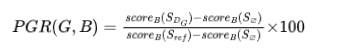

指標構建:創性能差距恢復(PGR)指標,借學生模型在基準測試分數變化,量化其于生成數據訓練后相對基礎模型改進程度,有效度量模型數據生成價值。

評估流程:用監督微調訓練學生模型,依設定超參數直用生成數據訓練,聚焦評估語言模型原始生成力,多維度內在評估含指令質量、響應特性及多樣性衡量,借主成分分析挖掘關鍵影響因素及預測因子。

?實驗結果:

模型性能對比:GPT - 4o 在多設置中 PGR 得分優,實例生成領先;Claude - 3.5 - Sonnet 質量增強佳,特定領域響應生成出色,且弱解題力模型可能優先生成,如代碼域 Llama - 3.1 - 8B - Instruct 超強解題模型。

成本性能平衡:Llama - 3.1 - 8B - Instruct 性價比高,GPT - 4o 較 Claude - 3.5 - Sonnet 低成本優效,為經濟選模供依據,顯示成本非性能決定因素。

其他因素影響:JSON 格式降性能,元提示優化重要,預算約束下弱模型多生成實例在部分領域超強模型少生成情形,表明輸出格式、成本與生成量協同影響生成效果。

1.引言

在合成數據上對語言模型進行后訓練是提高其解決廣泛任務能力的一種有前途的方法(Wang 等人,2023;Honovich 等人,2023;Taori 等人,2023;Liu 等人,2024b)。雖然通過手動標注獲取數據仍然發揮著重要作用,但合成數據生成提供了一種可擴展的替代人工標注的方法(Viswanathan 等人,2023;Kim 等人,2023b)。因此,許多工作提出了新穎的方法來有效地生成高質量的合成數據(Xu 等人,2024a;Gunasekar 等人,2023;Yue 等人,2023,2024)。

隨著多個性能相當的專有語言模型出現以及開源語言模型穩步追趕(Hurst 等人,2024;Anthropic,2024;MetaAI,2024;Team,2024),衡量每個語言模型的數據生成能力變得與開發新的數據生成方法同樣關鍵。此外,提供專有語言模型的公司已開始推廣使用其最新模型來生成合成數據(Nvidia,2024)。仔細比較不同語言模型的數據生成能力有助于驗證這些說法,并使從業者能夠明智地選擇用于數據合成的模型。

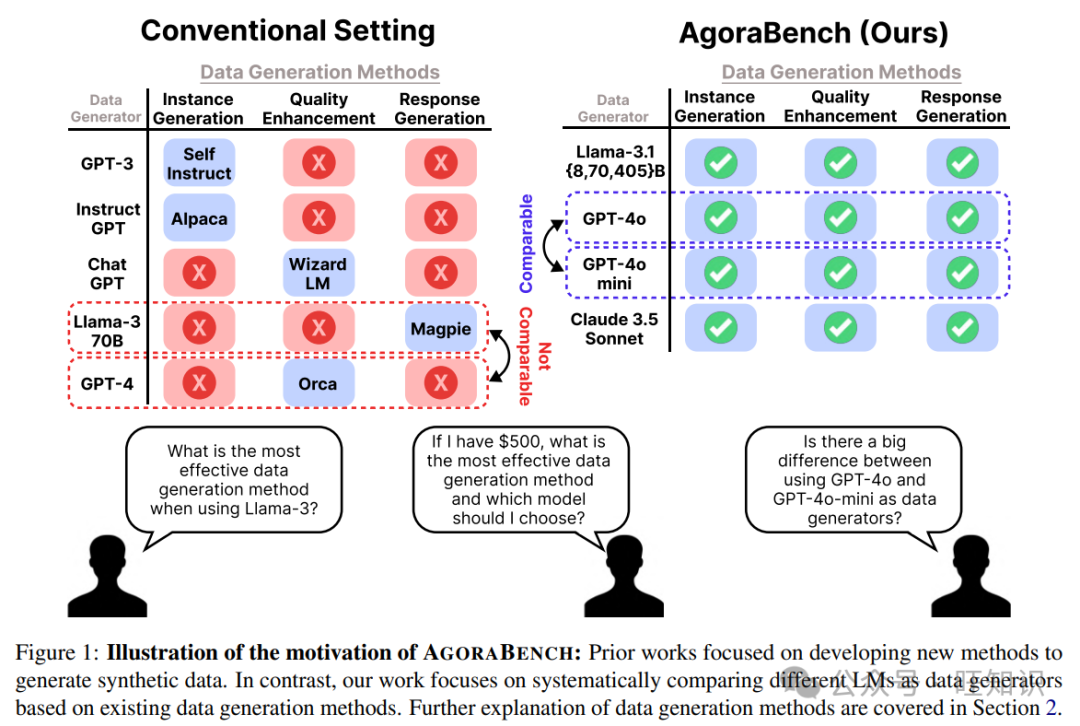

為了系統地比較語言模型作為數據生成器的能力,需要一個統一的實驗設置,其中只有數據生成器變化,而其他組件保持固定。然而,如圖 1 所示,先前的工作更多地側重于展示其數據生成方法的有效性,導致了各種實驗設置,使得這種比較具有挑戰性。例如,Self - Instruct(Wang 等人,2023)、Alpaca(Taori 等人,2023)、WizardLM(Xu 等人,2024a)和 Orca(Mukherjee 等人,2023)在用于數據生成的語言模型選擇、合成訓練數據的數量、用于訓練的基礎模型以及評估在合成數據集上訓練的模型的基準測試方面各不相同。這些不同的設置使得難以分離和衡量語言模型的數據生成能力,突出了對受控設置的需求。

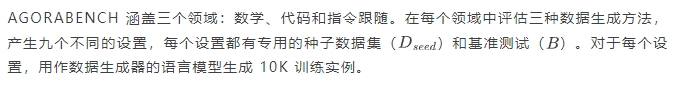

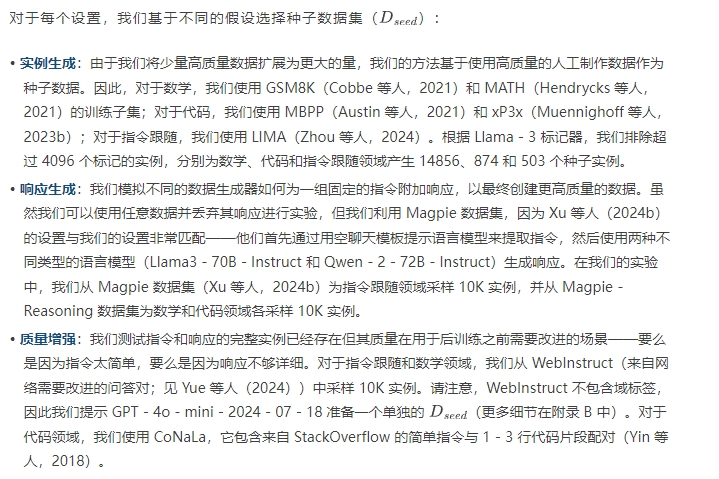

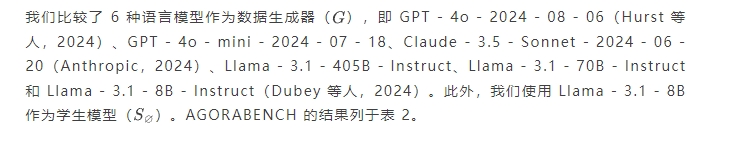

為此,我們提出了 AGORABENCH,這是一個用于評估語言模型在九種設置下的數據生成能力的基準測試,它將三個領域(數學、指令跟隨、代碼)與三種數據生成方法(實例生成、響應生成、質量增強)相結合。在每種設置中,除數據生成器外的所有變量都受到控制:使用相同的元提示和種子數據集,每個語言模型生成相同數量的訓練實例。在每個合成數據集上訓練 Llama3.1 - 8B,并在涵蓋不同能力(數學、編碼和一般指令跟隨)的固定基準測試集上進行評估。為了評估合成數據的質量,我們定義了一個稱為性能差距恢復(PGR)的指標,它衡量在數據上訓練的模型(表示為“學生模型”)相對于其基礎模型的相對改進。基于此設置,我們評估六種語言模型作為數據生成器:GPT - 4o、GPT - 4o - mini、Claude - 3.5 - Sonnet 和 Llama - 3.1 - Instruct(8B、70B、405B)。

我們的分析揭示了不同語言模型在各種數據生成方法中的獨特優勢。例如,GPT - 4o 在生成新實例方面表現出卓越的性能(+ 46.75%),優于 Claude - 3.5 - Sonnet(+ 24.14%)和 Llama - 3.1 - 405B - Instruct(+ 10.10%)。另一方面,Claude - 3.5 - Sonnet 在優化現有實例方面表現出色(+ 17.89%),超過 GPT - 4o(+ 6.69%)和 GPT - 4o - mini(+ 5.49%)。這些發現展示了 AGORABENCH 如何指導從業者為其特定需求選擇合適的語言模型。

出乎意料的是,我們還發現解決問題能力較弱的語言模型有時在數據生成方面優于能力較強的語言模型——例如,在代碼領域生成新實例時,Claude - 3.5 - Sonnet(+ 23.43%)不如 Llama - 3.1 - 8B - Instruct(+ 55.69%)有效。基于這些發現,我們研究語言模型的數據生成能力是否僅由其解決問題的能力預測。我們的分析表明這兩種能力之間沒有很強的相關性。相反,數據質量的多個內在特征——包括指令難度、響應質量和響應困惑度——共同影響學生模型的改進。此外,我們證明從內在測量中提取的前 5 個主成分可以解釋 PGR 值中 93.4%的方差。

最后,我們進行了有效數據生成的分析實驗。例如,我們發現合成數據的輸出格式顯著影響性能:與自由格式生成相比,使用 JSON 格式生成的數據在六個設置中的平均性能低 4.45%。此外,在預算受限的設置中,使用較弱的模型生成更多數據可能優于使用較強的模型生成較少數據。我們發現使用 GPT - 4o - mini 生成 50K 實例,雖然成本低 3.4 倍,但在三個設置中的兩個設置中比使用 GPT - 4o 生成 10K 實例實現了更好的性能。

2.預備知識:測量語言模型的數據生成能力

符號說明

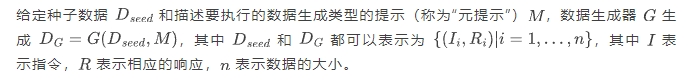

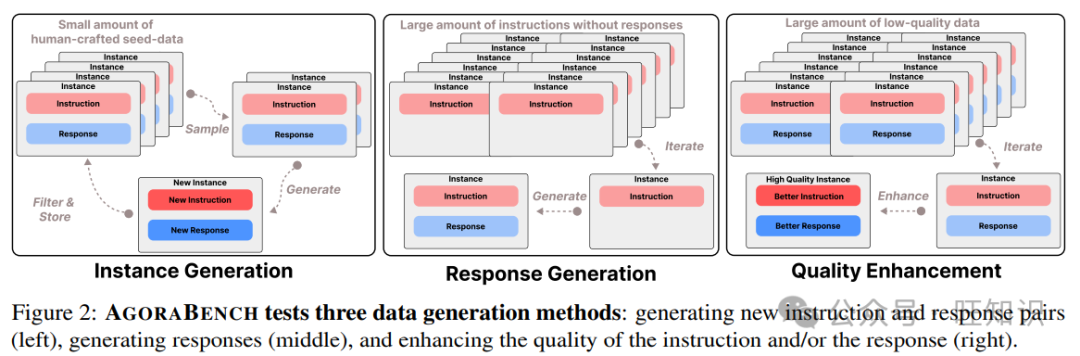

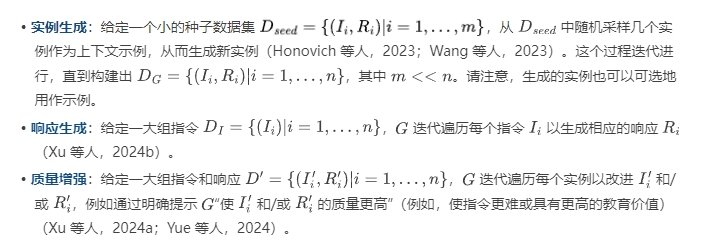

數據生成方法

如圖 2 所示,在各種數據生成方法中,大多數可以分為三類:實例生成、響應生成和質量增強。這些方法的工作原理如下:

指標

語言模型的數據生成能力可以通過評估在教師生成的數據上訓練的學生模型的性能改進來衡量。具體來說,我們提出一個指標,性能差距恢復(PGR),它衡量相對于參考模型在基準 上的改進。

訓練學生模型

3.AGORABENCH 的實驗設置

在各種選擇中,AgoraBench 專注于被認為對語言模型至關重要的三種核心能力:指令跟隨、數學推理和編碼(Chang 等人,2024;Guo 等人,2023;Hurst 等人,2024;Anthropic,2024)。AGORABENCH 的整體實驗設置,包括每個設置的領域、種子數據集和基準測試,列于表 1。

領域

然后,使用來自單個領域的數據訓練學生模型,以隔離生成數據質量的影響,因為跨域訓練可能通過正遷移或負遷移引入混淆因素(例如,在代碼數據上的訓練提高數學能力(Dong 等人,2023;Zhang 等人,2024))。

4.AGORABENCH 的實驗結果

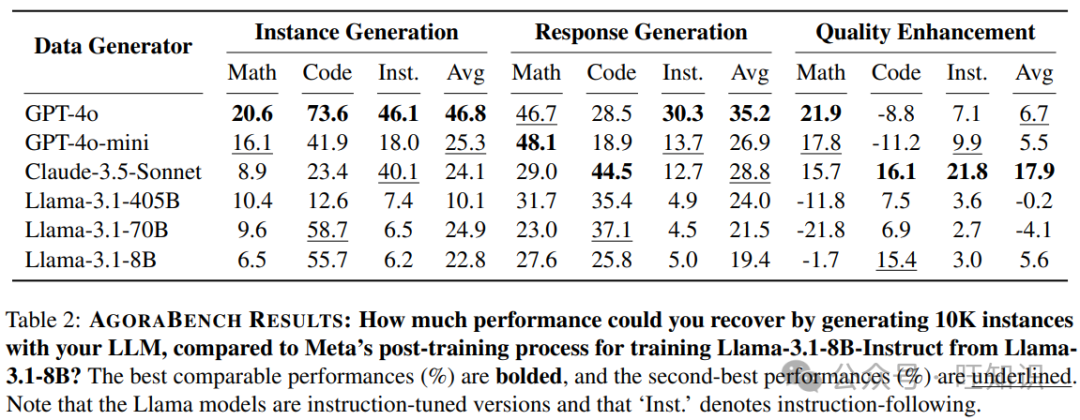

GPT - 4o 是總體性能最佳的數據生成器

在九個實驗設置中,GPT - 4o 在五個設置中獲得了最高的 PGR 分數。它在實例生成方面的性能尤為顯著,在所有三個領域(數學為 20.6%、代碼為 73.6%、指令跟隨為 46.1%,總體平均為 46.8%)中作為數據生成器都優于其他語言模型,并且在響應生成中也獲得了最高的平均 PGR 分數(35.2%)。

Claude - 3.5 - Sonnet 對質量增強特別有效

Claude - 3.5 - Sonnet 在質量增強方面表現出強大的性能,在三個領域中的兩個領域(代碼為 21.8%、指令跟隨為 17.9%,總體平均為 17.9%)獲得了最高的 PGR 分數。此外,它在代碼領域的響應生成中獲得了最佳的 PGR 分數(44.5%),使其在九個設置中的最佳表現總數達到三次。

較弱的語言模型可以優于較強的語言模型

我們觀察到在某些情況下,解決問題能力較弱的語言模型實現的性能差距恢復(PGR)分數高于其較強的對應模型。在實例生成的代碼領域中,Claude - 3.5 - Sonnet(23.4%)和 Llama - 3.1 - 405B - Instruct(12.6%)都被 Llama - 3.1 - 70B - Instruct(58.7%)和 Llama - 3.1 - 8B - Instruct(55.7%)超越。同樣,在代碼領域的質量增強設置中,GPT - 4o(8.8%)和 GPT - 4o - mini(-11.2%)的性能比其他語言模型差。

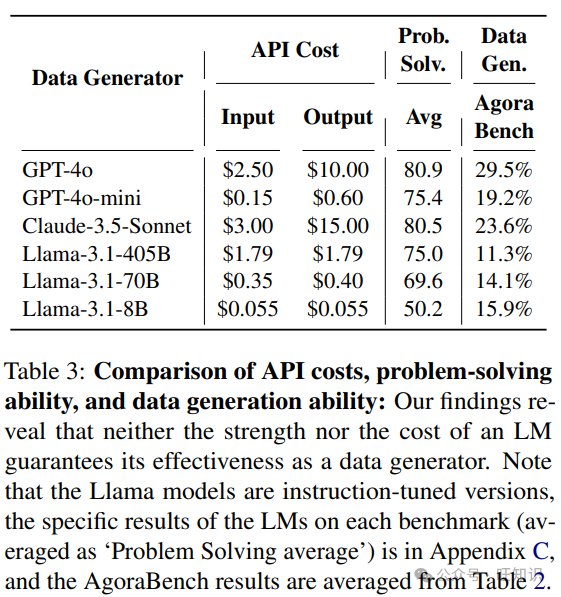

有趣的是,如表 3 所示,在這些情況下表現較差的語言模型實際上在代碼基準測試(MBPP 和 HumanEval)中得分更高,這表明它們具有更強的解決問題能力。這種矛盾表明,更強的語言模型不一定能生成更好的訓練數據。我們將在第 5 節中進一步討論這一現象。

GPT - 4o、GPT - 4o - mini 和 Llama - 3.1 - 8B - Instruct 是平衡成本和性能的有效數據生成器

在生成大量合成數據時,成本是與性能并列的關鍵因素。表 3 列出了所有六種語言模型的 API 成本、解決問題能力(基準測試分數)和在 AGORABENCH 上的平均性能(即數據生成能力)。Llama - 3.1 - 8B - Instruct 的性能優于 Llama - 3.1 - 70B - Instruct 和 Llama - 3.1 - 405B - Instruct,同時成本低 6 到 32.5 倍。同樣,GPT - 4o 以 1.2 到 1.5 倍的較低成本實現了比 Claude - 3.5 - Sonnet 更好的性能。這些發現表明,使用更昂貴的語言模型并不一定保證更好的數據生成,突出了根據特定任務或感興趣的領域仔細選擇模型的重要性。

5.什么使一個有效的數據生成器?

在上一節中,我們觀察到一個意外的發現:在相同條件下生成相同數量的合成數據時,解決問題能力較弱的語言模型有時優于較強的語言模型。為了更好地理解這一現象,我們首先檢查解決問題能力和數據生成能力之間是否存在強相關性(第 5.1 節)。然后,我們研究是否可以通過分析每個語言模型生成的數據來預測學生模型性能的提升程度(第 5.2 節)。

5.1 最佳求解器一定是最佳生成器嗎?

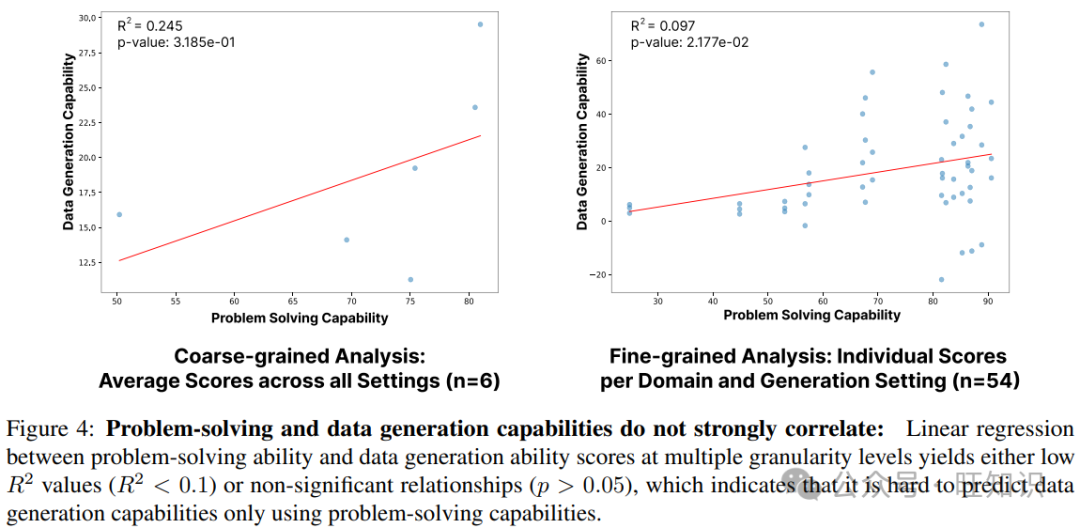

為了檢查數據生成和解決問題能力之間的關系,我們進行了線性回歸分析,比較了兩個指標:多個基準測試(GSM8K、MATH、MBPP、HumanEval、AlpacaEval - 2.0、Arena - Hard)的平均性能和 AGORABENCH 的分數。我們在兩個粒度級別上進行此分析。第一個分析(粗粒度)使用所有領域和數據生成設置的總體平均 AGORABENCH 分數。第二個分析(細粒度)分別檢查 AGORABENCH 中不同領域和數據生成設置的單個分數。

圖 4 所示的結果表明,在任何粒度級別上,解決問題能力(基準測試分數)和數據生成能力(AGORABENCH PGR 分數)之間都沒有強線性相關性。這一發現表明,語言模型在傳統基準測試上的性能可能無法預測其作為數據生成器的有效性。

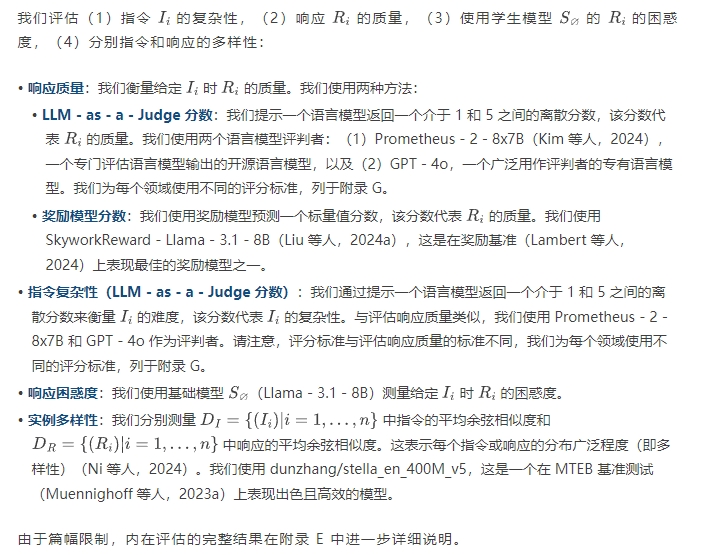

5.2 我們可以通過查看數據來預測學生模型的改進嗎?

內在評估指標

實驗

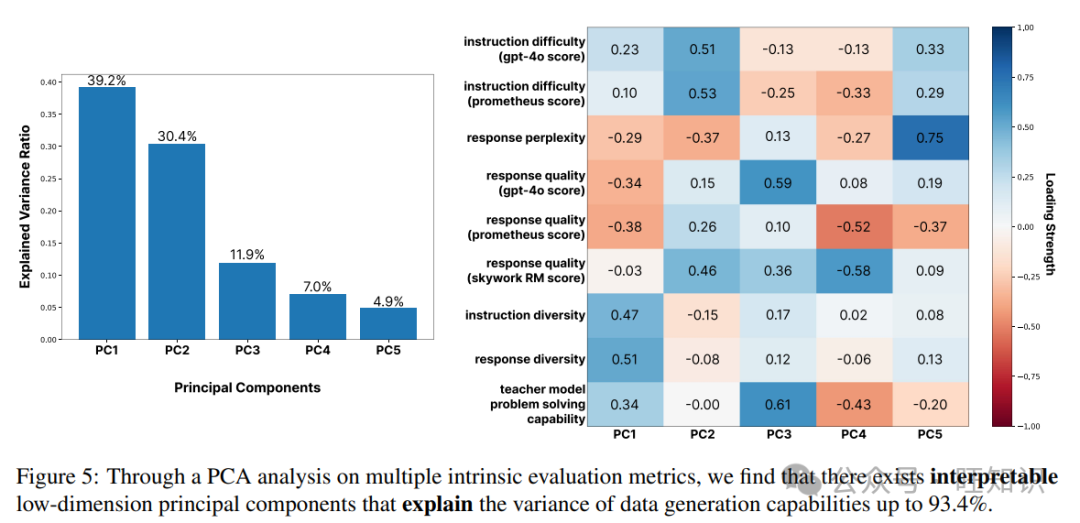

受 Ruan 等人(2024)的實驗啟發,我們進行主成分分析(PCA)以研究內在評估指標是否可以解釋 AGORABENCH 結果的變異性。由于我們的內在評估指標之間存在相互依賴性,我們選擇 PCA 而不是多元線性回歸。

結果如圖 5 所示,前五個主成分解釋了 AGORABENCH 結果中約 93.4%的方差(分別為 39.2%、30.4%、11.9%、7.0%和 4.9%)。此外,我們發現對成分權重的分析揭示了可解釋的模式。第一個主成分(PC - 1)受指令難度和多樣性相關指標的強烈影響。第二個成分(PC - 2)受響應質量和指令難度的影響,而第三個成分(PC - 3)結合了多樣性相關指標、響應質量和語言模型的解決問題能力。

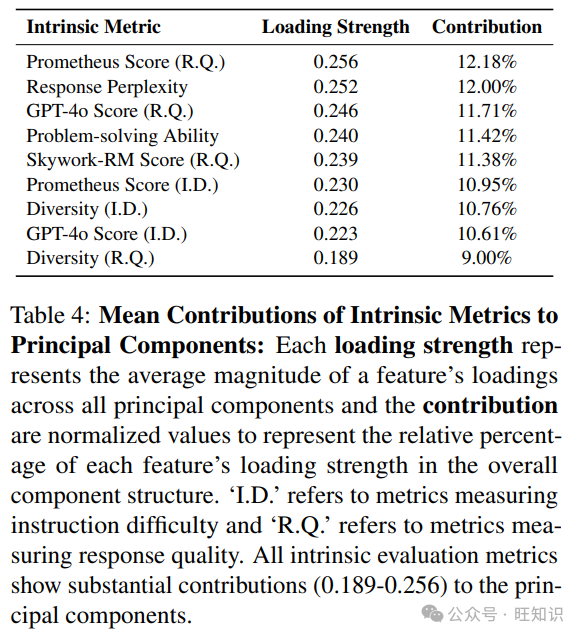

此外,如表 4 所示,當我們分析每個內在評估指標的平均加載強度(所有主成分中一個特征的加載的平均幅度,表示每個指標對數據總體方差的影響程度)時,我們觀察到貢獻范圍從 0.189 到 0.256,表明所有內在評估指標對 PGR 結果的貢獻相似。我們還發現,與多樣性相關指標或指令難度相關指標相比,響應質量相關指標對 PGR 結果的貢獻略強。

最后,我們通過對前 5 個主成分進行線性回歸來預測數據生成能力,通過其相應的回歸系數對每個成分進行加權,如圖 6 所示。與僅使用解決問題分數相比(圖 4),這種方法產生了具有統計顯著性的關系(),解釋能力提高()。然而,中等的 值表明,可能需要超出我們當前集合的額外內在測量來更好地預測數據生成能力。我們將這個問題的進一步探索留給未來的工作。

6.進一步分析實驗

在本節中,我們進一步研究關于數據生成的兩個關鍵問題:(1)我們應該優先使用更便宜的語言模型追求數量,還是使用更昂貴的語言模型追求質量?(第 6.1 節)以及(2)元提示設計的影響是什么,特別是當比較結構化 JSON 格式生成與傳統自由格式方法時?(第 6.2 節)

6.1 數量還是質量?

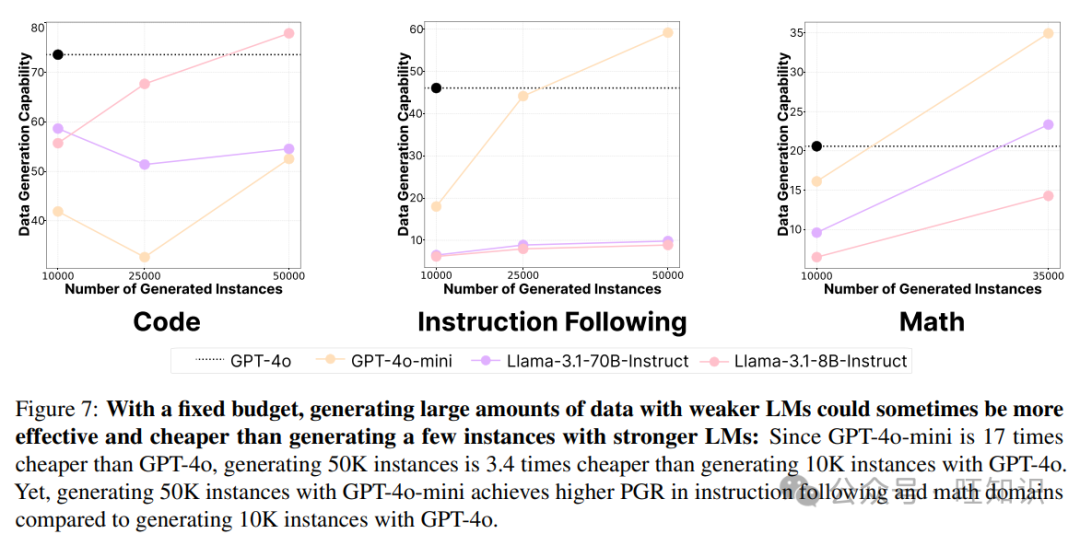

在第 4 節中,我們表明在某些情況下,較便宜的語言模型在生成固定數量的實例時可以比昂貴的語言模型更有效地作為數據生成器,盡管昂貴的模型通常表現更好。這引發了一個實際問題:使用更便宜的模型生成大量實例是否比使用更昂貴的模型生成較少實例更有效?

我們擴大實驗規模,在實例生成場景中使用 GPT - 4o - mini、Llama - 3.1 - 70B - Instruct 和 Llama - 3.1 - 8B - Instruct 在三個領域中生成多達 50K 個實例。如圖 7 所示,使用 GPT - 4o - mini 生成 50K 實例在指令跟隨和數學領域的性能優于使用 GPT - 4o 生成 10K 實例,并且 Llama - 3.1 - 8B - Instruct 在代碼領域表現出類似的模式。鑒于這些語言模型至少比 GPT - 4o 具有五倍的成本效益,我們的發現表明,使用更實惠的語言模型生成大量合成數據可能比使用昂貴的語言模型生成較小的數據集更具優勢。此外,這表明當比較具有不同數量訓練實例的兩個設置時,指令多樣性或響應多樣性可能會影響 PGR 結果。

6.2 元提示的影響

最近,Tam 等人(2024)表明,當語言模型以結構化格式(例如 JSON)生成響應時,其解決問題的能力會下降。鑒于從業者在使用語言模型時傾向于結構化輸出(Shorten 等人,2024;Liang 等人,2024),研究這種格式是否影響數據生成性能很重要。此外,我們檢查元提示設計對生成質量的影響。

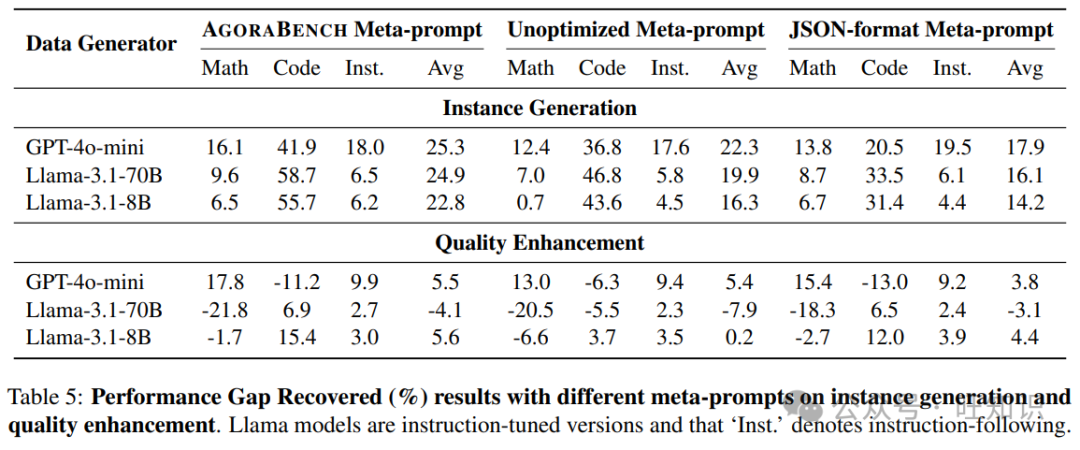

為了研究這些問題,我們創建了四個額外的元提示進行比較。對于每個設置(實例生成和質量增強),我們讓兩位作者創建元提示:一位開發了一個未優化的版本(花費不到 10 分鐘),而另一位創建了一個 JSON 格式的版本。

表 5 展示了我們的發現。與其他元提示相比,AGORABENCH 元提示在六個設置中的五個設置中獲得了最高分數,展示了 AGORABENCH 設置的穩健性。將 AGORABENCH 元提示與未優化版本進行比較,平均性能差距為 3.97%,突出了元提示優化的重要性。此外,使用自由格式生成的 AGORABENCH 元提示比 JSON 格式提示的性能高 4.45%。這與最近的發現一致,即結構化格式要求可能會損害語言模型的輸出質量(Tam 等人,2024)。

7.結論

在本文中,我們引入了 AGORABENCH,這是一個通過標準化設置和指標系統地評估語言模型數據生成能力的基準測試。我們的分析表明,模型在不同的生成方法和領域中表現出獨特的優勢,突出了仔細選擇數據生成器的重要性。雖然語言模型的數據生成能力不能僅由其成本或解決問題的能力預測,但我們從內在評估測量中識別出可解釋的低維主成分,這些主成分解釋了高達 93.4%的方差,并作為更好的預測指標。

展望未來,我們設想 AGORABENCH 將推動該領域的兩個關鍵進展。首先,由于我們的發現表明解決問題的能力不是數據生成質量的主要決定因素,研究人員可以使用我們的基準測試來識別構成有效數據生成器的核心能力,并有可能開發專門用于數據生成的語言模型。其次,AGORABENCH 可以作為從業者評估和改進其數據生成流程的實用評估框架——他們可以使用自己的自定義數據生成方法、種子數據集或元提示,并與我們的基線設置進行比較。此外,他們可以利用我們的系統評估方法在部署大規模數據創建之前優化其生成參數。通過這些互補的研究和應用方向,AGORABENCH 旨在加速我們對語言模型作為數據生成器的理論理解及其在實際應用中的實際部署。

參考資料

? 標題:Evaluating Language Models as Synthetic Data Generators

? 作者:Seungone Kim, Juyoung Suk, Xiang Yue, Vijay Viswanathan, Seongyun Lee, Yizhong Wang, Kiril Gashteovski, Carolin Lawrence, Sean Welleck, Graham Neubig

? 單位:Carnegie Mellon University, KAIST AI, University of Washington, NEC Laboratories Europe, Ss. Cyril and Methodius University of Skopje

? 標簽:語言模型、合成數據生成、數據生成能力評估、基準測試

? 概述:本文提出 AGORABENCH 基準測試,通過標準化設置與指標評估語言模型數據生成能力,揭示模型優勢及影響因素,為模型選擇和數據生成優化提供依據。

? 鏈接:https://arxiv.org/pdf/2412.03679

本文轉載自 ??旺知識??,作者: 旺知識