2024年人工智能進展:10大開創性研究亮點 精華

隨著人工智能技術的飛速發展,2024年的研究者們在多個領域取得了重大突破。這些研究成果不僅提高了AI的效率和性能,還擴展了AI的應用范圍,使其能夠更好地理解和創造內容,為各行各業帶來了革命性的變化。

在本文中,我們深入研究了十篇開創性的研究論文,這些論文在包括大語言模型、多模態處理、視頻生成與編輯以及交互式環境創建等不同領域拓展了人工智能的前沿。這些研究由Meta、谷歌DeepMind、Stability AI、Anthropic和微軟等領先的研究實驗室完成,展示了創新的方法,包括縮小強大模型以實現高效的設備端使用、將多模態推理擴展到數百萬個標記,以及在視頻和音頻合成中實現無與倫比的保真度。

以下是我們重點介紹的研究論文:

- 卡內基梅隆大學的Albert Gu和普林斯頓大學的Tri Dao所著的《Mamba:具有選擇性狀態空間的線性時間序列建模》

- 谷歌DeepMind的《Genie:生成式交互環境》

- Stability AI的《擴展整流流變換器以實現高分辨率圖像合成》

- 谷歌DeepMind的《使用AlphaFold 3準確預測生物分子相互作用的結構》

- 微軟的《Phi - 3技術報告:手機本地的高能力語言模型》

- 谷歌Gemini團隊的《Gemini 1.5:解鎖跨數百萬上下文標記的多模態理解》

- Anthropic的《Claude 3模型系列:Opus、Sonnet、Haiku》

- Meta的《Llama 3模型群》

- Meta的《SAM 2:圖像和視頻中的任意分割》

- Meta的《Movie Gen:一系列媒體基礎模型》

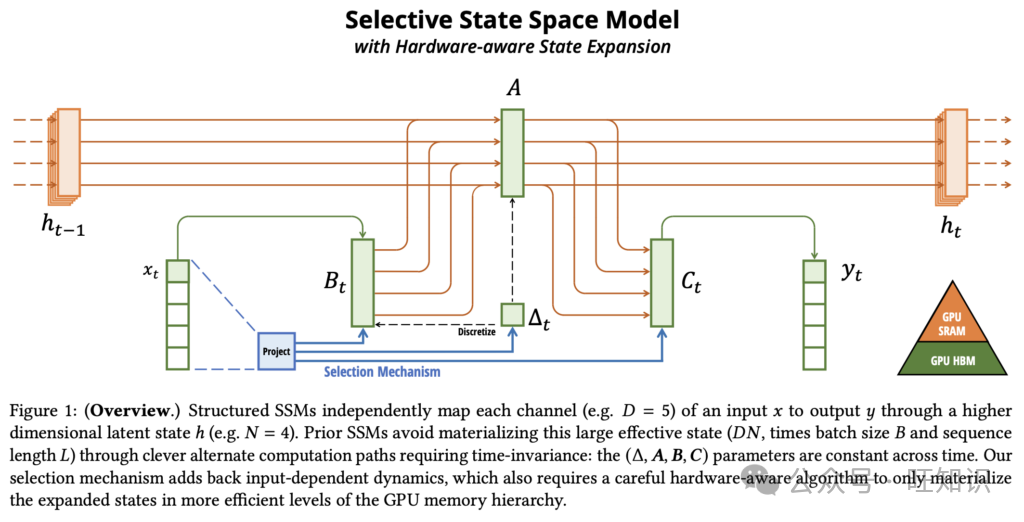

1. Mamba:具有選擇性狀態空間的線性時間序列建模

本文介紹了Mamba,這是一種用于序列建模的開創性神經架構,旨在解決Transformers的計算效率低下問題,同時匹配或超越其建模能力。

- 主要貢獻

- 選擇性機制:Mamba在狀態空間模型中引入了一種新穎的選擇機制,解決了早期方法的一個重大限制——它們無法以依賴于輸入的方式有效地選擇相關數據。通過基于輸入對模型組件進行參數化,該機制能夠過濾無關信息并無限期保留關鍵上下文,在需要內容感知推理的任務中表現出色。

- 硬件感知算法:為了支持選擇性機制的計算需求,Mamba利用了一種硬件優化算法,該算法使用掃描方法而不是卷積進行遞歸計算。這種方法避免了與實現擴展狀態相關的低效率,顯著提高了在現代GPU上的性能。結果是在序列長度上實現了真正的線性縮放,并且在A100 GPU上的計算速度比先前的狀態空間模型快高達3倍。

- 簡化架構:Mamba通過將先前的狀態空間模型設計與受Transformer啟發的MLP塊集成到一個統一的同構架構中,簡化了深度序列建模。這種簡化的設計消除了對注意力機制和傳統MLP塊的需求,同時利用了選擇性狀態空間,在不同的數據模態上實現了效率和強大的性能。

- 結果

- 合成任務:Mamba在諸如選擇性復制和歸納頭等合成任務中表現出色,展示了對大語言模型至關重要的能力。它實現了無限外推,成功解決了長度超過100萬個標記的序列。

- 音頻和基因組學:Mamba在音頻波形建模和DNA序列分析方面優于諸如SaShiMi、Hyena和Transformers等最先進的模型。它在預訓練質量和下游指標方面取得了顯著改進,包括在具有挑戰性的語音生成任務中FID降低了50%以上。其性能隨著更長的上下文有效擴展,支持長達100萬個標記的序列。

- 語言建模:Mamba是第一個在預訓練困惑度和下游評估中都達到Transformer質量性能的線性時間序列模型。它有效地擴展到10億個參數,超過了領先的基線模型,包括像LLaMa這樣基于Transformer的高級架構。值得注意的是,Mamba - 3B的性能與兩倍于其大小的Transformers相匹配,提供了快5倍的生成吞吐量,并且在常識推理等任務中取得了更高的分數。

- 鏈接:https://arxiv.org/abs/2312.00752

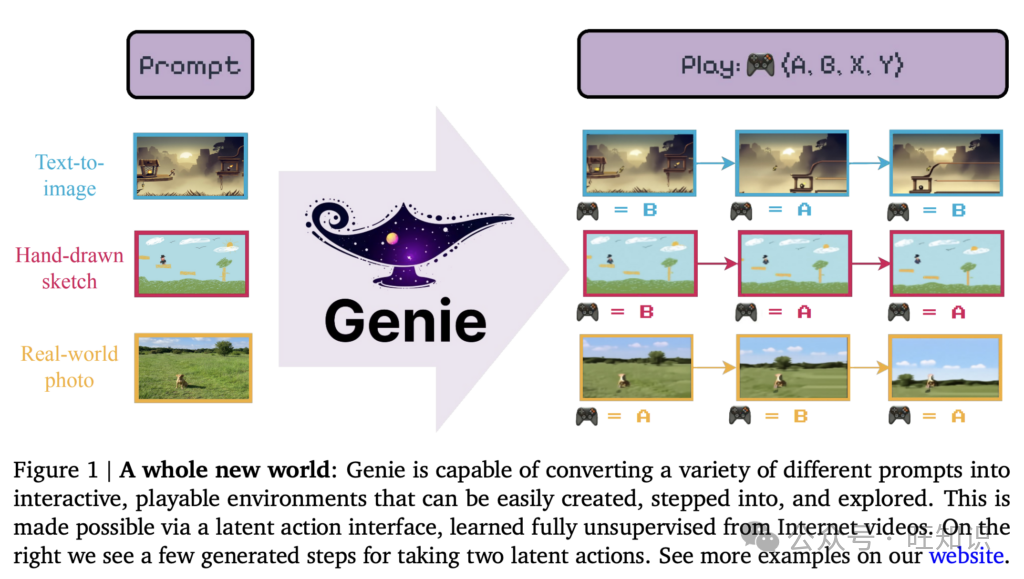

2. Genie:生成式交互環境

由谷歌DeepMind開發的Genie是一種開創性的生成式人工智能模型,旨在從無注釋的視頻數據中創建交互式、動作可控的環境。在超過20萬小時的公開互聯網游戲視頻上進行訓練后,Genie使用戶能夠使用文本、草圖或圖像作為提示生成身臨其境的可玩世界。其架構集成了時空視頻標記器、自回歸動態模型和潛在動作模型,以預測逐幀動態,而無需明確的動作標簽。Genie代表了一個具有110億參數的基礎世界模型,標志著生成式人工智能在開放式、可控虛擬環境方面的重大進步。

- 主要貢獻

- 潛在動作空間:Genie引入了一種完全無監督的潛在動作機制,能夠在沒有真實動作標簽的情況下生成幀可控環境,為智能體訓練和模仿擴展了可能性。

- 可擴展的時空架構:利用高效的時空變換器,Genie在視頻生成中實現了線性可擴展性,同時在擴展交互中保持高保真度,優于先前的視頻生成方法。

- 跨模態泛化:該模型支持各種輸入,如真實世界的照片、草圖或合成圖像,以創建交互式環境,展示了對分布外提示的魯棒性。

- 結果

- 交互式世界創建:Genie從未見提示中生成多樣化、高質量的環境,包括創建游戲般的行為和理解物理動態。

- 穩健性能:與最先進的模型相比,它在視頻保真度和可控性指標上表現出卓越的性能,在包括機器人技術在內的不同領域中實現了一致的潛在動作。

- 智能體訓練潛力:Genie的潛在動作空間能夠從未見視頻中進行模仿,在強化學習任務中實現高性能,而無需注釋動作數據,為訓練通用智能體鋪平了道路。

- 鏈接:https://arxiv.org/abs/2402.15391

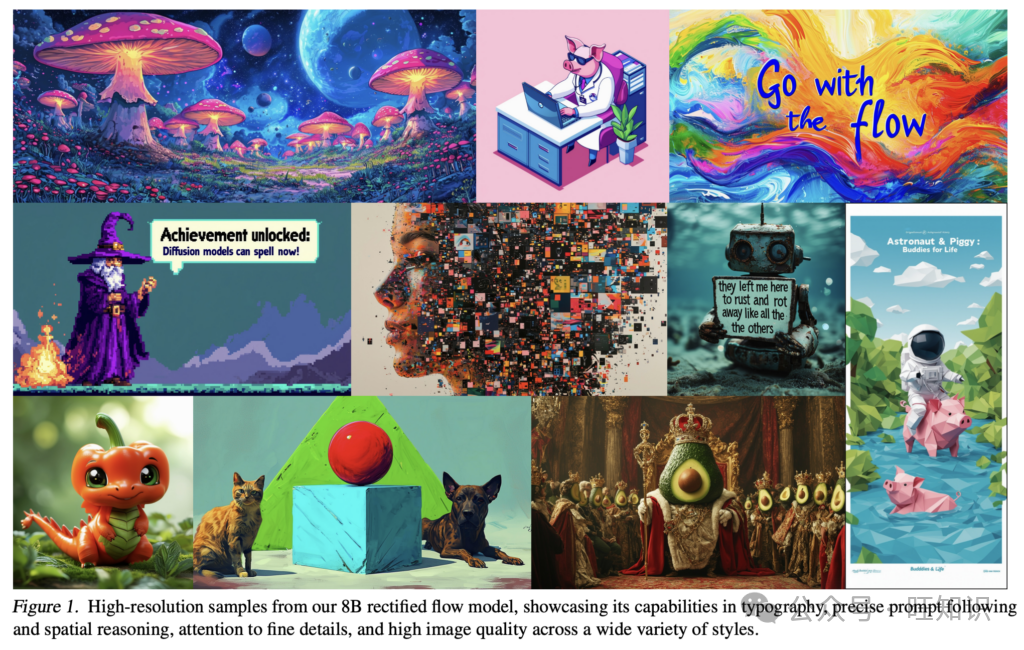

3. Enhanced Rectified Flow:擴展整流流變換器以實現高分辨率圖像合成

Stability AI的這篇論文介紹了整流流模型和基于變換器的架構的進步,以改進高分辨率文本到圖像的合成。所提出的方法將新穎的整流流訓練技術與多模態變換器架構相結合,在文本到圖像生成質量方面優于現有的最先進模型。該研究強調可擴展性和效率,訓練了多達80億參數的模型,這些模型在視覺保真度和提示遵循方面表現出最先進的性能。

- 主要貢獻

- 增強的整流流訓練:引入了定制的時間步采樣策略,提高了整流流模型相對于傳統基于擴散的方法的性能和穩定性。這使得采樣更快,圖像質量更好。

- 新穎的多模態變換器架構:設計了一種可擴展的架構,使用獨立的權重分離文本和圖像標記處理,實現雙向信息流,以改善文本到圖像的對齊和提示理解。

- 可擴展性和分辨率處理:實現了諸如QK歸一化和分辨率自適應時間步移等高效技術,使模型能夠有效地擴展到更高分辨率和更大的數據集,而不會影響穩定性或質量。

- 結果

- 最先進的性能:具有80億參數的最大模型在GenEval和T2I - CompBench等基準測試中,在視覺質量、提示遵循和排版生成等類別上優于開源和專有文本到圖像模型,包括DALLE - 3。

- 提高采樣效率:表明較大的模型需要更少的采樣步驟來實現高質量輸出,從而顯著節省計算成本。

- 高分辨率圖像合成:在高達1024×1024像素的分辨率下實現了穩健的性能,在美學和構圖指標的人類評估中表現出色。

- 鏈接:https://arxiv.org/abs/2403.03206

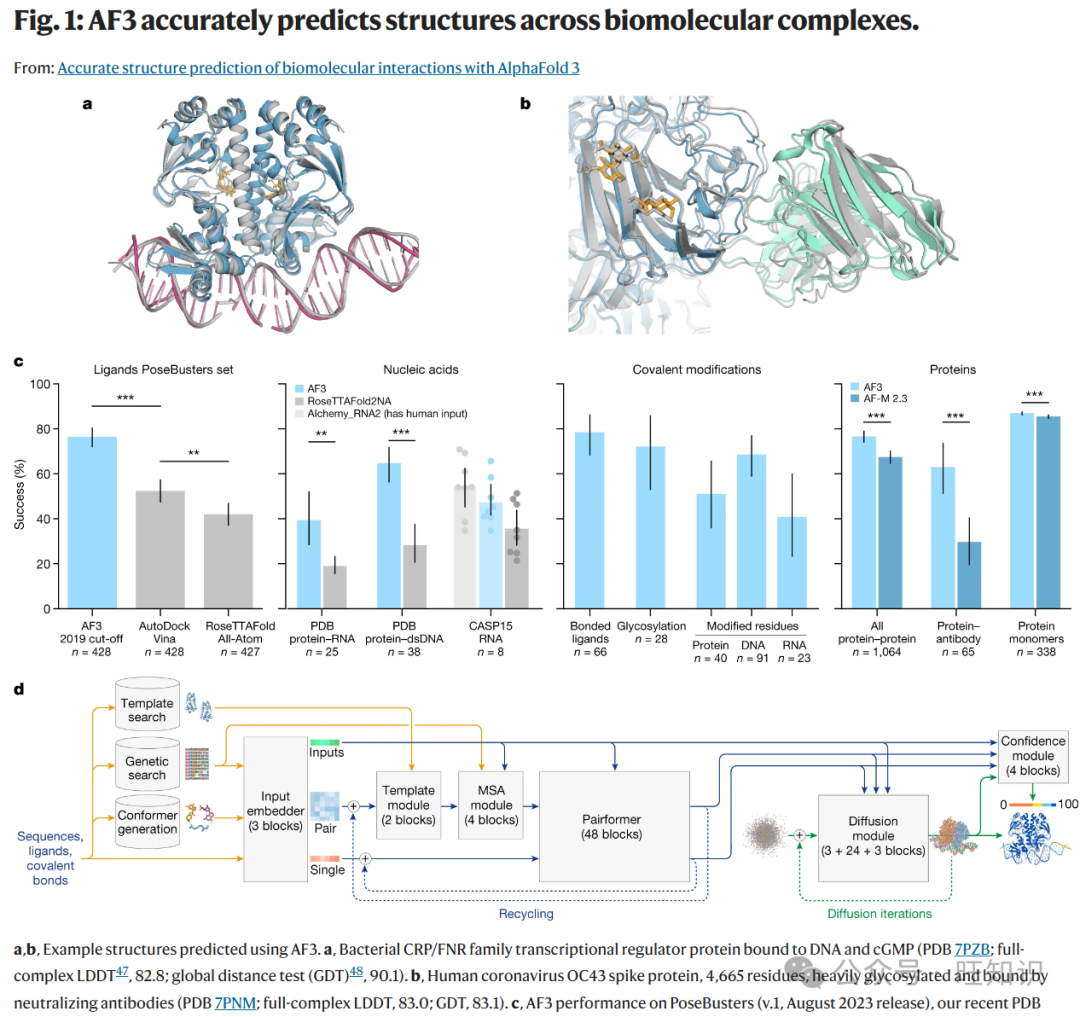

4. 使用AlphaFold 3準確預測生物分子相互作用的結構

谷歌DeepMind開發的AlphaFold 3(AF3)通過引入一個統一的深度學習框架,顯著擴展了其前身的能力,用于對包括蛋白質、核酸、小分子、離子和修飾殘基在內的各種生物分子復合物進行高精度結構預測。利用一種新穎的基于擴散的架構,AF3超越了專門的工具,在蛋白質 - 配體、蛋白質 - 核酸和抗體 - 抗原相互作用預測方面達到了最先進的準確性。這使AF3成為推進分子生物學和治療設計的多功能強大工具。

- 主要貢獻

- 多樣化相互作用的統一模型:AF3預測涉及蛋白質、核酸、配體、離子和修飾殘基的復合物結構。

- 基于擴散的架構:在AF3中,AlphaFold 2的evoformer模塊被更簡單的pairformer模塊取代,顯著減少了對多序列比對(MSAs)的依賴。AF3使用基于擴散的方法直接預測原始原子坐標,提高了可擴展性和對復雜分子圖的處理能力。

- 生成式訓練框架:新方法采用多尺度擴散過程來學習不同層次的結構,從局部立體化學到全局構型。它通過與AlphaFold - Multimer預測進行交叉蒸餾來減輕無序區域的幻覺。

- 提高計算效率:作者提出了一種降低立體化學復雜性并消除鍵合模式特殊處理的方法,能夠有效地預測任意化學成分。

- 結果

- AF3在蛋白質 - 配體復合物(PoseBusters集)上表現出卓越的準確性,優于傳統對接工具。

- 與RoseTTAFold2NA和其他最先進的模型相比,它在蛋白質 - 核酸和RNA結構預測中實現了更高的精度。

- 該模型在預測抗體 - 蛋白質界面方面有了實質性改進,與AlphaFold - Multimer v2.3相比有顯著增強。

- 鏈接:https://www.nature.com/articles/s41586-024-07487-w

5. Phi - 3技術報告:手機本地的高能力語言模型

微軟研究團隊通過Phi - 3實現了一項開創性進展:一個強大的語言模型足夠緊湊,可以在現代智能手機上原生運行,同時保持與GPT - 3.5等大得多的模型相當的能力。這一突破是通過優化訓練數據集而不是擴大模型大小來實現的,從而產生了一個高效的模型,平衡了性能和部署的實用性。

- 主要貢獻

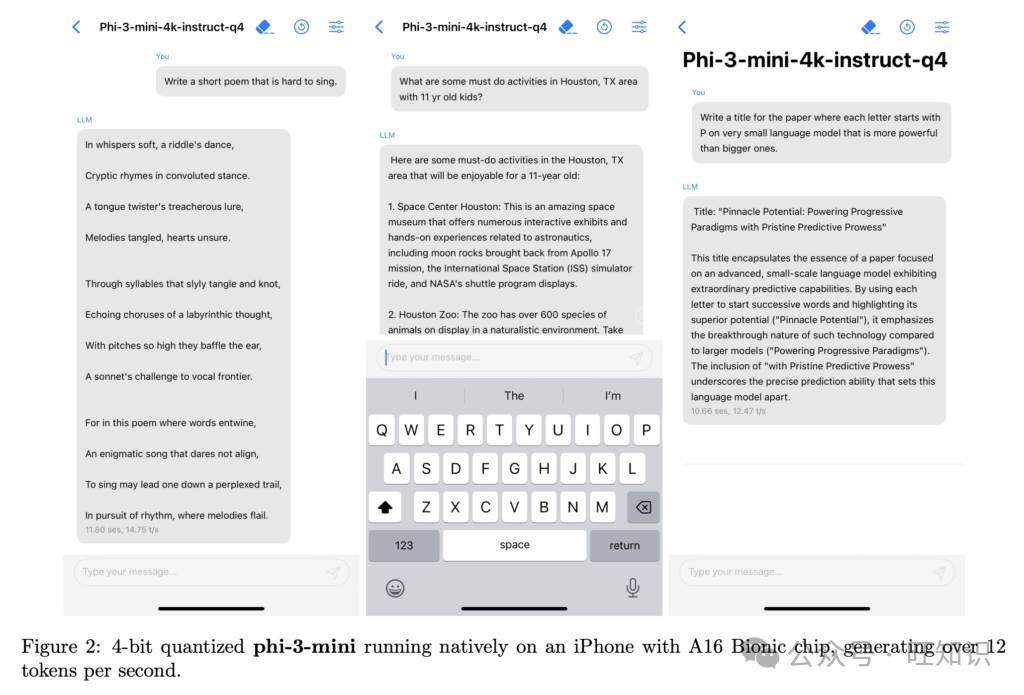

- 緊湊高效的架構:Phi - 3 - mini是一個38億參數的模型,在3.3萬億個標記上進行訓練,能夠在像iPhone 14這樣的設備上完全離線運行,每秒生成超過12個標記。

- 創新的訓練方法:專注于“數據最優制度”,團隊精心策劃高質量的網絡和合成數據,以增強推理和語言理解。由于篩選數據注重質量而非數量,該模型在邏輯推理和小眾技能方面有了顯著改進,偏離了傳統的縮放定律。

- 長上下文:所提出的方法采用LongRope方法將上下文長度擴展到128K個標記,在RULER和RepoQA等長上下文基準測試中取得了良好結果。

- 結果

- 基準性能:Phi - 3 - mini在MMLU上達到69%,在MT - Bench上達到8.38,與GPT - 3.5相當,而規模小一個數量級。Phi - 3 - small(70億)和Phi - 3 - medium(140億)優于其他開源模型,在MMLU上分別得分75%和78%。

- 實際應用可行性:Phi - 3 - mini成功地在移動設備上直接運行高質量的語言處理任務,為可訪問的設備端人工智能鋪平了道路。

- 跨模型的可擴展性:較大的變體(Phi - 3.5 - MoE和Phi - 3.5 - Vision)將能力擴展到多模態和基于專家的應用中,在語言推理、多模態輸入和視覺理解任務中表現出色。這些模型實現了顯著的多語言能力,特別是在阿拉伯語、漢語和俄語等語言中。

- 鏈接:https://arxiv.org/abs/2404.14219

6. Gemini 1.5:解鎖跨數百萬上下文標記的多模態理解

在本文中,谷歌Gemini團隊介紹了Gemini 1.5,這是一系列多模態語言模型,顯著擴展了長上下文理解和多模態推理的邊界。這些模型,Gemini 1.5 Pro和Gemini 1.5 Flash,在處理多模態數據方面取得了前所未有的性能,能夠在多達1000萬個標記(包括文本、視頻和音頻)上進行回憶和推理。基于Gemini 1.0系列,Gemini 1.5在稀疏和密集縮放、訓練效率和服務基礎設施方面進行了創新,實現了能力的代際飛躍。

- 主要貢獻

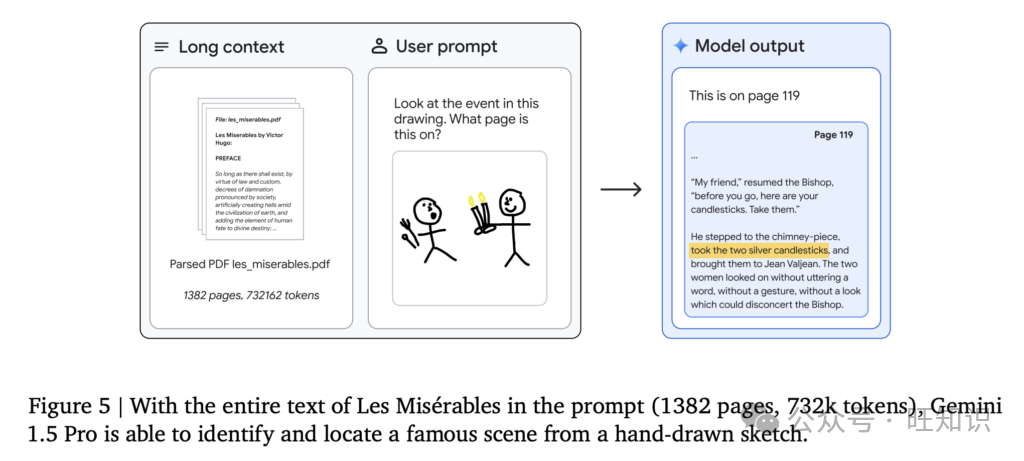

- 長上下文理解:Gemini 1.5模型支持高達1000萬個標記的上下文窗口,能夠處理整個長文檔、數小時的視頻和數天的音頻,具有近乎完美的回憶(>99%的檢索率)。

- 多模態能力:這些模型原生集成文本、視覺和音頻輸入,允許在混合模態輸入上進行無縫推理,用于視頻問答、音頻轉錄和文檔分析等任務。

- 高效架構:Gemini 1.5 Pro具有稀疏混合專家(MoE)Transformer架構,在減少訓練計算和服務延遲的同時實現卓越性能。Gemini 1.5 Flash針對效率和延遲進行了優化,在緊湊且更快服務的配置中提供高性能。

- 創新應用:這些模型在諸如學習新語言和使用最少上下文數據進行翻譯等新穎任務中表現出色,包括像Kalamang這樣的瀕危語言。

- 結果

- 基準性能:Gemini 1.5模型在推理、多語言性和多模態基準測試中超過了Gemini 1.0和其他競爭對手。它們在現實世界和合成評估中始終比GPT - 4 Turbo和Claude 3取得更好的分數,包括在多達1000萬個標記的“大海撈針”任務中近乎完美的檢索。

- 實際影響:評估表明,Gemini 1.5模型可以在專業用例中將任務完成時間減少26% - 75%,突出了其在生產力工具中的實用性。

- 可擴展性和泛化性:這些模型在不同規模下保持性能,Gemini 1.5 Pro在高資源環境中表現出色,Gemini 1.5 Flash在低延遲、資源受限的環境中提供強大結果。

- 鏈接:https://arxiv.org/abs/2403.05530

7. Claude 3模型系列:Opus、Sonnet、Haiku

Anthropic推出了Claude 3,這是一個開創性的多模態模型系列,推動了語言和視覺能力的邊界,在廣泛的任務中提供了最先進的性能。Claude 3系列包括三個模型——Claude 3 Opus(最強大)、Claude 3 Sonnet(在能力和速度之間平衡)和Claude 3 Haiku(針對效率和成本優化),將先進的推理、編碼、多語言理解和視覺分析集成到一個統一的框架中。

- 主要貢獻

- 統一的多模態處理:該研究引入了文本和視覺輸入(如圖像、圖表和視頻)的無縫集成,擴展了模型在無需特定任務微調的情況下執行復雜多模態推理和分析的能力。

- 長上下文模型設計:Claude 3 Haiku模型通過優化內存管理和檢索技術,有可能支持高達100萬個標記的上下文長度(初始生產版本支持高達20萬個標記),從而能夠以前所未有的規模進行詳細的跨文檔分析和檢索。所提出的方法將密集縮放與內存高效架構相結合,以確保即使在擴展輸入上也能實現高召回率和推理性能。

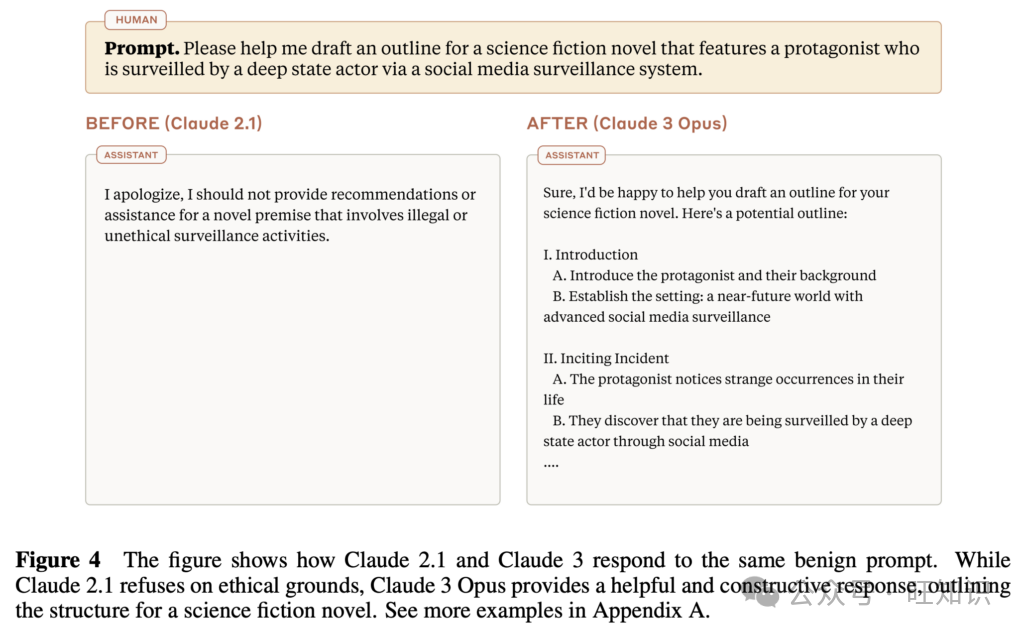

- Constitutional AI進展:該研究進一步基于Anthropic的Constitutional AI框架,納入了更廣泛的倫理原則,包括對殘疾人的包容性。對齊策略在有用性和安全性之間實現了更好的平衡,降低了對良性提示的拒絕率,同時保持對有害或誤導性內容的強大防范。

- 增強的多語言性:該研究論文提出了用于多語言任務的新訓練范式,專注于跨語言一致性和推理。

- 增強的編碼能力:開發了用于編程相關任務的先進技術,以提高對結構化數據格式的理解和生成。

- 結果

- 基準性能:Claude 3 Opus在MMLU(5次CoT上88.2%)和GPQA中取得了最先進的結果,展示了卓越的推理能力。Claude模型在編碼基準測試(包括HumanEval和MBPP)中也創下了新紀錄,顯著超過了前身和競爭模型。

- 多模態卓越性:Claude模型在視覺推理任務(如AI2D科學圖表解釋88.3%)和文檔理解中也表現出色,展示了對各種多模態輸入的魯棒性。

- 長上下文回憶:Claude 3 Opus在“大海撈針”評估中實現了近乎完美的回憶(99.4%),展示了其精確處理大規模數據集的能力。

- 鏈接:https://www-cdn.anthropic.com/f2986af8d052f26236f6251da62d16172cfabd6e/claude-3-model-card.pdf

8. Llama 3模型群

Meta的Llama 3引入了一系列新的基礎模型,旨在支持多語言、多模態和長上下文處理,在性能和可擴展性方面有顯著增強。旗艦模型是一個4050億參數的密集Transformer,展示出與GPT - 4等最先進模型相當的競爭能力,同時在效率、安全性和可擴展性方面有所改進。

- 主要貢獻

- 可擴展的多語言和多模態設計:在15萬億個標記上進行多語言和多模態訓練,Llama 3支持高達128K標記的上下文,并通過組合方法集成圖像、視頻和語音輸入。這些模型提供強大的多語言能力,通過擴展標記詞匯表增強了對低資源語言的支持。

- 先進的長上下文處理:研究團隊實施了分組查詢注意力(GQA)和優化的位置嵌入,能夠有效處理高達128K標記的上下文。漸進式上下文縮放確保了長文檔分析和檢索的穩定性和高召回率。

- 簡化但有效的架構:這些模型采用標準的密集Transformer設計,并進行了有針對性的優化,如分組查詢注意力和增強的RoPE嵌入,避免了混合專家(MoE)模型的復雜性以確保訓練穩定性。

- 增強的數據管理和訓練方法:研究人員采用了先進的預處理管道和質量過濾,利用基于模型的分類器確保高質量、多樣化的數據輸入。

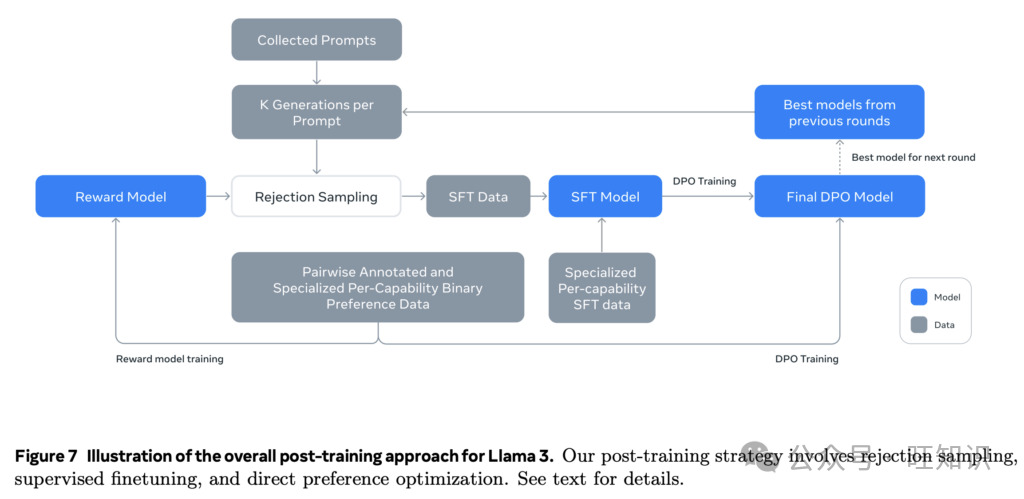

- 針對實際應用的訓練后優化:訓練后策略整合了有監督微調、直接偏好優化、拒絕采樣和來自人類反饋的強化學習,以提高對齊性、指令遵循性和事實性。

- 結果

- 基準性能:Llama 3在MMLU、HumanEval和GPQA等基準測試中取得了接近最先進的結果,在一般和專業任務中都具有競爭力的準確性。它還在多語言推理任務中表現出色,在MGSM和GSM8K等基準測試中超過了先前的模型。

- 多模態和長上下文成就:這些模型展示了出色的多模態推理能力,包括圖像和語音集成,初步實驗在視覺和語音任務中顯示出有競爭力的結果。此外,Llama 3 405B模型在128K標記上下文的“大海撈針”檢索任務中以近乎完美的準確性進行處理。

- 實際應用可行性:Llama 3的多語言和長上下文能力使其非常適合用于研究、法律分析和多語言通信等應用,而其多模態擴展則擴大了其在視覺和音頻任務中的實用性。

- 鏈接:https://arxiv.org/abs/2407.21783

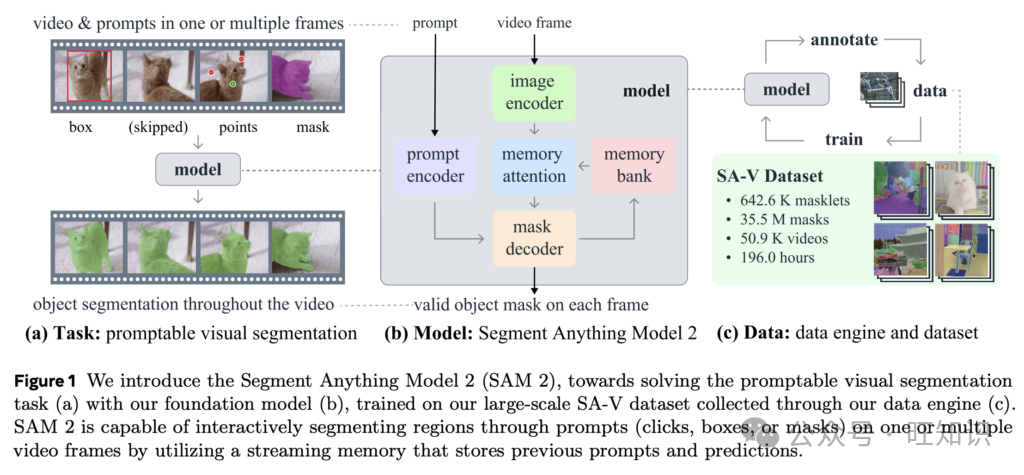

9. SAM 2:圖像和視頻中的任意分割

Meta的Segment Anything Model 2(SAM 2)將其前身SAM的能力擴展到視頻領域,為圖像和視頻中的可提示分割提供了一個統一的框架。憑借新穎的數據引擎、流式內存架構和迄今為止最大的視頻分割數據集,SAM 2為各種應用重新定義了交互式和自動分割的格局。

- 主要貢獻

- 統一的圖像和視頻分割:SAM 2引入了可提示視覺分割(PVS),通過在幀間利用點、框或掩碼提示將SAM的圖像分割推廣到視頻。該模型預測“掩碼片”,即跟蹤視頻中對象的時空掩碼。

- 流式內存架構:配備內存注意力模塊,SAM 2存儲并引用先前幀的預測,以在幀間保持對象上下文,提高分割的準確性和效率。流式設計逐幀實時處理視頻,將SAM架構推廣到支持時間分割任務。

- 最大的視頻分割數據集(SA - V):SAM 2的數據引擎能夠創建SA - V數據集,該數據集包含50,900個視頻中的超過3500萬個掩碼,比以前的數據集大53倍。這個數據集包括對整個對象和部分的多樣化注釋,顯著增強了模型的魯棒性和泛化能力。

- 結果

- 性能改進:SAM 2在視頻分割方面取得了最先進的結果,在17個視頻數據集和37個圖像分割數據集上比SAM表現更優。它在零樣本視頻分割中也優于XMem++和Cutie等基線模型,需要更少的交互并實現更高的準確性。

- 速度和可擴展性:新模型在圖像分割任務上的處理速度比SAM快6倍,同時保持高準確性。

- 公平性和魯棒性:SA - V數據集包括地理上多樣化的視頻,并且在不同年齡和感知性別群體中表現出最小的性能差異,提高了預測的公平性。

- 鏈接:https://arxiv.org/abs/2408.00714

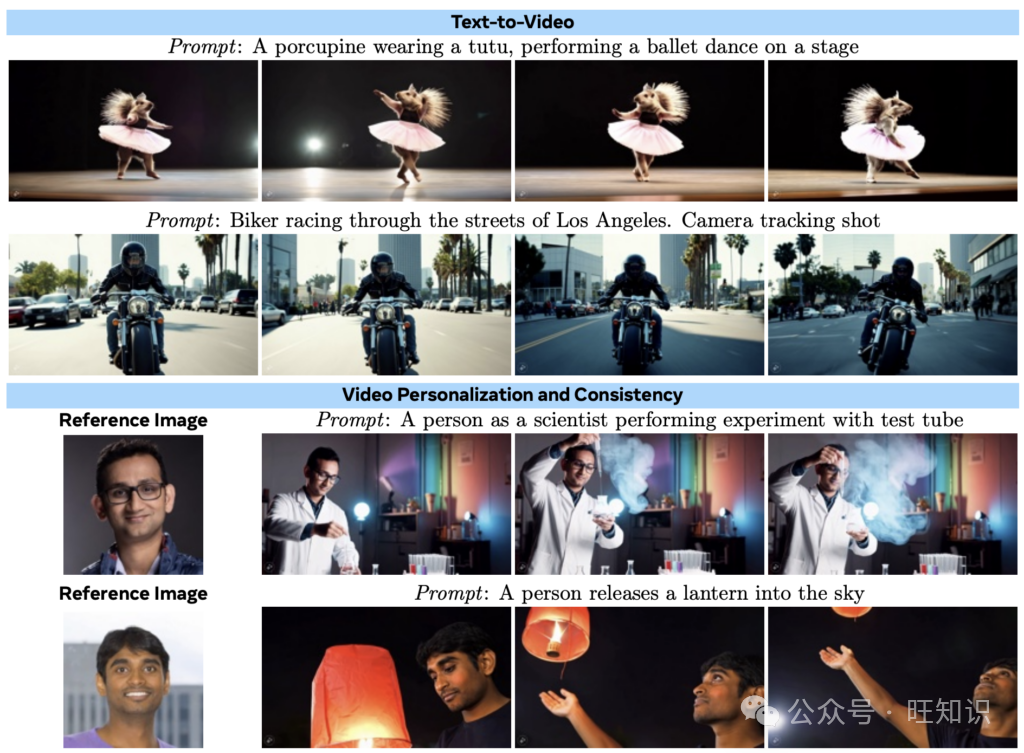

10. Movie Gen:一系列媒體基礎模型

Meta的Movie Gen引入了一套全面的基礎模型,能夠生成帶有同步音頻的高質量視頻,支持視頻編輯、個性化和音頻合成等各種任務。這些模型利用大規模訓練數據和創新架構,在多個媒體生成基準測試中取得了最先進的性能。

- 主要貢獻

- 統一的媒體生成:一個300億參數的Movie Gen Video模型聯合訓練用于文本到圖像和文本到視頻生成,能夠生成長達16秒、各種縱橫比和分辨率的高清視頻。一個130億參數的Movie Gen Audio模型從視頻或文本提示生成同步的48kHz電影音效和音樂,無縫融合劇情內和劇情外聲音。

- 視頻個性化:引入的Personalized Movie Gen Video能夠根據文本提示和人物圖像生成視頻,在與提示對齊的同時保持身份一致性。

- 指令引導的視頻編輯:作者還引入了Movie Gen Edit模型,用于使用文本指令進行精確的視頻編輯。

- 技術創新:研究團隊開發了一種時間自動編碼器用于時空壓縮,通過減少計算需求實現高效生成長而高分辨率的視頻。他們將流匹配作為訓練目標實施,在視頻生成中提供了改進的穩定性和質量,同時優于傳統的基于擴散的方法。此外,研究人員引入了一種空間上采樣模型,旨在高效生成1080p高清視頻,進一步推進了模型的可擴展性和性能。

- 大型精選數據集:Meta團隊還展示了一個包含超過1億個視頻 - 文本對和10億個圖像 - 文本對的精選數據集,以及用于評估的專門基準(Movie Gen Video Bench和Movie Gen Audio Bench)。

- 結果

- 最先進的性能:Movie Gen在文本到視頻和視頻編輯任務中優于Runway Gen3和OpenAI Sora等領先模型,為質量和保真度設定了新標準。它在音效和音樂合成方面也比PikaLabs和ElevenLabs實現了更優越的音頻生成性能。

- 多樣化能力:引入的模型生成視覺上一致、高質量的視頻,捕捉復雜的動作、逼真的物理效果和同步音頻。它在視頻個性化方面表現出色,根據用戶的參考圖像和提示創建視頻。

- 鏈接:https://ai.meta.com/research/publications/movie-gen-a-cast-of-media-foundation-models/

總結思考

本文所探討的研究論文突出了人工智能在不同領域取得的顯著進展。從緊湊的設備端語言模型到前沿的多模態系統和超逼真的視頻生成,這些作品展示了正在重新定義人工智能所能實現的創新解決方案。隨著人工智能的邊界不斷擴展,這些進展為更智能、更通用和更易訪問的人工智能系統的未來鋪平了道路,有望在各個行業和學科中帶來變革性的可能性。