多模態大語言模型的空間智能探秘:突破與挑戰

人們在日常生活中需要視覺空間智能來處理空間信息,但多模態大語言模型在這方面的能力尚未得到充分研究。本文構建了 VSI - Bench 基準測試,對模型進行評估和分析,有助于了解模型的優勢和不足,為提升模型的視覺空間智能提供方向,推動相關領域發展,如機器人、自動駕駛和 AR/VR 等,使模型能更好地應用于實際場景。

本文圍繞多模態大語言模型(MLLMs)的視覺空間智能展開研究。首先介紹了視覺空間智能的概念及相關能力分類,接著提出了包含 5000 多個問答對的 VSI - Bench 基準,涵蓋多種類型任務及不同場景視頻。通過對 15 個模型的評估,發現 MLLMs 雖有一定視覺空間智能但低于人類,空間推理是其性能瓶頸,傳統語言推理技術效果不佳,而生成認知地圖可提升空間距離能力。

摘要&解讀

人類擁有從連續的視覺觀察中記住空間的視覺空間智能。然而,在百萬規模視頻數據集上訓練的多模態大語言模型(MLLMs)能否也從視頻中“在空間中思考”呢?我們提出了一個新的基于視頻的視覺空間智能基準(VSI - Bench),包含超過5000個問答對,并發現MLLMs展現出了具有競爭力的——盡管低于人類的——視覺空間智能。我們通過語言和視覺方式探究模型如何表達它們在空間中的思考,并發現雖然空間推理能力仍然是MLLMs達到更高基準性能的主要瓶頸,但局部世界模型和空間感知確實在這些模型中出現了。值得注意的是,流行的語言推理技術(例如,思維鏈、自一致性、思維樹)未能提高性能,而在問答過程中明確生成認知地圖則增強了MLLMs的空間距離能力。

- 研究背景:隨著多模態大語言模型(MLLMs)在語言智能方面取得進展,其視覺空間智能的研究相對不足,盡管該能力在機器人、自動駕駛和 AR/VR 等領域具有重要性。以往的空間智能測試多關注紙筆任務或 2D 圖像、純語言方面的理解,缺乏基于真實視頻對 MLLMs 視覺空間智能的有效評估。

- 研究貢獻:

a.提出了新的基于視頻的視覺空間智能基準 VSI - Bench,包含豐富多樣的任務和真實場景視頻數據,能全面評估 MLLMs 的視覺空間智能。

b.通過語言和視覺兩種方式探究 MLLMs 在空間中的思考過程,發現了其空間推理能力的瓶頸以及局部世界模型和空間感知的存在。

c.證明了在問答過程中明確生成認知地圖可增強 MLLMs 的空間距離能力,為提升模型性能提供了新的方向。

- 實現設計:

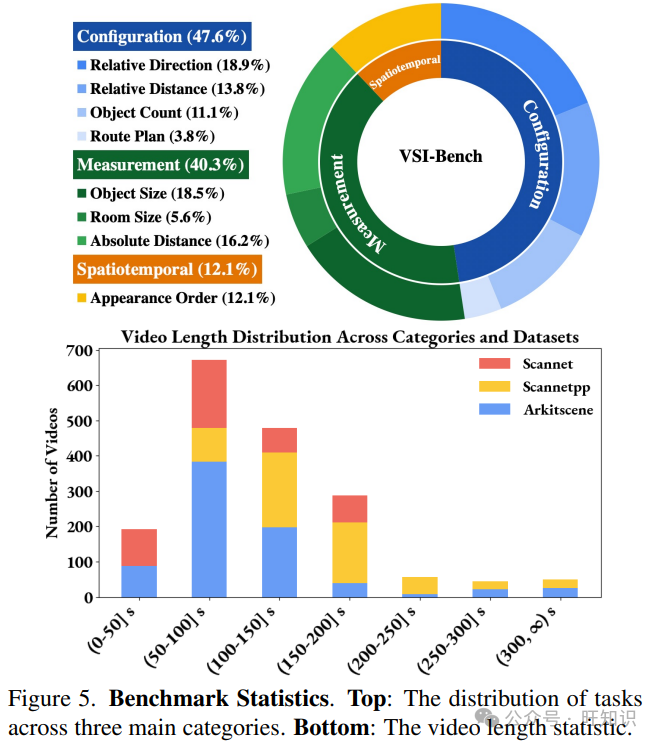

a.數據收集與處理:整合 ScanNet、ScanNet++和 ARKitScenes 等數據集,統一數據格式,包括視頻處理、元信息提取和類別篩選等步驟,為基準構建提供數據基礎。

b.問答對生成:基于統一的元信息和精心設計的問題模板自動生成大部分問答對,并對路線規劃任務進行人工注釋,同時設計了嚴格的質量審查流程,確保數據質量。

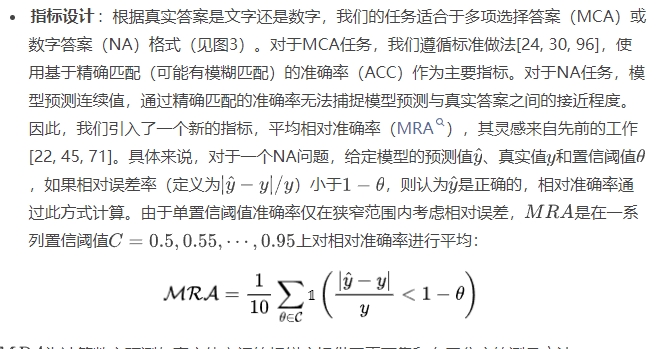

c.模型評估設置:選擇 15 個涵蓋不同模型家族和規模的 MLLMs,采用零樣本設置和貪婪解碼,根據答案類型設計了合適的評估指標(如 MCA 任務用準確率,NA 任務用平均相對準確率),并設定了機會水平基線和人類水平性能參考。

- 實驗結果:

a.人類在基準測試中平均準確率達 79%,遠超 MLLMs。專有模型 Gemini1.5 Pro 表現較好但仍有差距,開源模型中部分表現出競爭力,但多數低于機會水平基線。

b.空間推理是 MLLMs 性能的主要瓶頸,約 71%的錯誤源于此,而傳統語言推理技術如思維鏈、自一致性和思維樹等在基準上反而導致性能下降。

c.MLLMs 在記憶空間時形成局部世界模型,在定位相鄰物體的認知地圖中準確率達 64%,但隨距離增加準確性下降;使用認知地圖可使相對距離任務準確率提高 10%,使用真實認知地圖比基線有 20% - 32%的增益。

1. 引言

在購買家具時,我們經常會試著回憶起客廳的樣子,以想象想要的柜子是否合適。估計距離是困難的,但即使只看過一次,人類也能在腦海中重構空間,回憶起房間里的物體、它們的位置和大小。我們生活在一個充滿感官信息的三維世界中,視覺信號圍繞著我們并為我們提供基礎,使我們能夠感知、理解并與之互動。

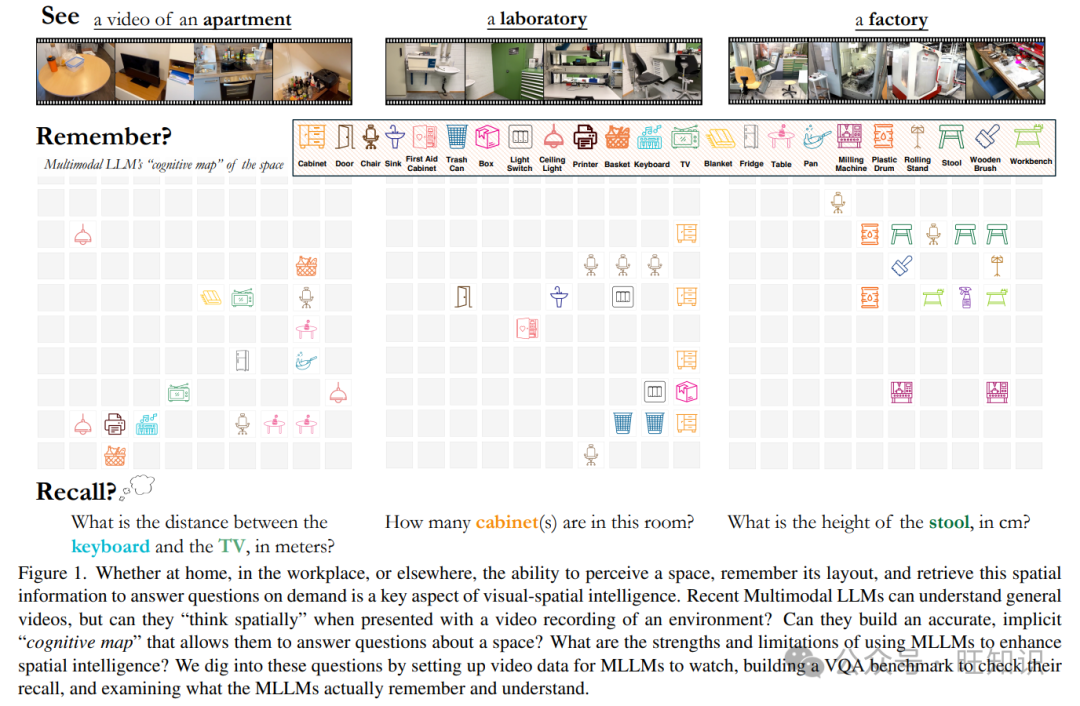

圖1:無論是在家中、工作場所還是其他地方,感知空間、記住其布局并按需檢索這些空間信息以回答問題的能力是視覺空間智能的一個關鍵方面。最近的多模態大語言模型(MLLMs)能夠理解一般視頻,但當面對環境的視頻記錄時,它們能“在空間中思考”嗎?它們能否構建一個準確的、隱性的“認知地圖”,從而使它們能夠回答關于空間的問題?使用MLLMs增強空間智能的優勢和局限性是什么?我們通過為MLLMs設置視頻數據、構建視覺問答(VQA)基準來檢查它們的回憶,并檢查MLLMs實際記住和理解的內容來深入研究這些問題。

視覺空間智能需要感知和在心理上操縱空間關系[26];它需要多種能力,包括關系推理以及在自我中心和非自我中心視角之間轉換的能力(見第2節)。雖然大語言模型(LLMs)[3, 6, 9, 35, 59, 65, 66, 75, 79, 80, 85, 100]已經提高了語言智能,但視覺空間智能盡管與機器人技術[7, 8, 21, 62]、自動駕駛[77]和增強現實/虛擬現實(AR/VR)[12, 27, 53]相關,但仍未得到充分探索。

多模態大語言模型(MLLMs)[1, 4, 15, 33, 41, 47, 47, 76]整合了語言和視覺,在開放式對話和實際任務(如網絡智能體[21, 28, 32, 34])中表現出強大的思考和推理能力。為了在視覺空間領域提升這種智能,我們引入了VSI - Bench,這是一個基于視頻的基準,包含來自近290個真實室內場景視頻的超過5000個問答對(見第3節)。視頻數據通過捕捉連續的時間輸入,既類似于我們觀察世界的方式,又能實現比靜態圖像更豐富的空間理解和推理。在VSI - Bench上評估開源和閉源模型表明,盡管模型和人類之間存在很大的性能差距,但MLLMs在視頻理解、文本理解和空間推理等挑戰下仍展現出了新興的視覺空間智能(見第4節)。

為了分析模型行為,并受到雙重編碼理論[18]的啟發——該理論認為語言和視覺處理是不同但互補的,我們提示選定的模型進行自我解釋(語言方面)和生成認知地圖(視覺方面)。對自我解釋的分析表明,與視覺感知、語言智能或時間處理相比,空間推理是VSI - Bench上性能不佳的主要因素(見第5節)。“認知地圖”代表環境的內部布局[60, 78],使我們能夠評估MLLMs的隱性空間世界模型,并發現MLLMs構建了強大的局部模型,但全局模型較弱(見第6節)。此外,標準的語言推理技術未能提高我們基準測試的性能。然而,明確生成和使用認知地圖可以提高空間距離問答的能力。

即使對于人類來說,表達視覺空間智能也是困難的(而且通常是零碎的)[26]。通過這項工作,我們旨在鼓勵社區探索為前沿模型賦予視覺空間智能,并為這個方向鋪平道路并提供啟示。

2. 視覺空間智能

我們討論視覺空間智能的預備知識和范圍,為后續分析提供背景和框架。

- 術語使用:我們使用“智能”而不是“認知”,因為它的范圍更廣,并且“空間認知”是認知心理學的一個分支[81]。在我們的工作中,我們在“空間智能”前加上“視覺”,因為空間智能的存在與感官模式無關(例如,盲人可以通過其他感官感知空間)[26]。鑒于我們專注于視頻輸入,我們討論視覺空間智能。

- 研究范圍:雖然經典的空間智能測試也包括紙筆任務,如心理旋轉測試[72],但我們的重點是適用于現實世界環境的視覺空間智能,特別是在家庭、辦公室和工廠等常見空間中。

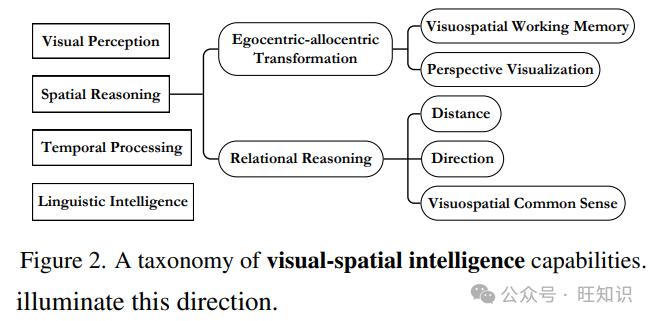

- 分類:基于認知心理學[11, 26, 55, 60]和我們在第3節中的基準任務的人類經驗,我們提供了視覺空間智能可能需要的能力分類(圖2)。視覺感知、語言智能、時間處理和空間推理是VSI - Bench所需的四個領域。例如,[11]表明視覺對象和空間處理在神經上是不同的,這促使將“視覺感知”和“空間推理”作為獨立的領域。我們將空間推理分為兩個廣泛的能力:關系推理和自我中心 - 非自我中心轉換。

關系推理是通過距離和方向識別物體之間關系的能力。它還包括依靠關于其他物體大小的視覺空間常識來推斷物體之間的距離。例如,知道一個標準飲料罐大約12厘米高,人類可以通過比較視覺比例來估計其他物體的大小。

自我中心 - 非自我中心轉換涉及在以自我為中心(自我中心)的視圖和以環境為中心(非自我中心)的視圖之間切換。在我們的設置中,每個自我中心視頻幀都映射到非自我中心的物體位置和相機軌跡。當人類觀察空間時,他們將自我中心的感知轉換為非自我中心的心理地圖,從而能夠從不同的視角進行觀察——這對于相對方向或路線規劃等任務至關重要。這種轉換依賴于新視角的可視化和視覺空間工作記憶[2],即保持和操作空間信息的能力,例如通過從新的自我中心輸入更新物體位置[20, 54]。

VSI - Bench中的每個任務都需要感知、語言和時間能力以及不同程度的空間推理。例如,對于路線規劃任務,自我中心 - 非自我中心轉換比物體大小估計重要得多。這些因素為視覺空間智能的復雜性提供了一些背景信息。

3. VSI - Bench

3.1. 概述

我們引入VSI - Bench來從自我中心視頻中定量評估MLLMs的視覺空間智能。VSI - Bench由來自288個真實視頻的超過5000個問答對組成。這些視頻來自公共室內3D場景重建數據集ScanNet[19]、ScanNet++[94]和ARKitScenes[5]的驗證集,代表了不同的環境——包括住宅空間、專業環境(如辦公室、實驗室)和工業空間(如工廠)——以及多個地理區域。重新利用這些現有的3D重建和理解數據集提供了準確的對象級注釋,我們在問題生成中使用這些注釋,并可能有助于未來研究MLLMs與3D重建之間的聯系。VSI - Bench質量很高,經過了迭代審查,以盡量減少問題的模糊性并去除從源數據集中傳播的錯誤注釋。

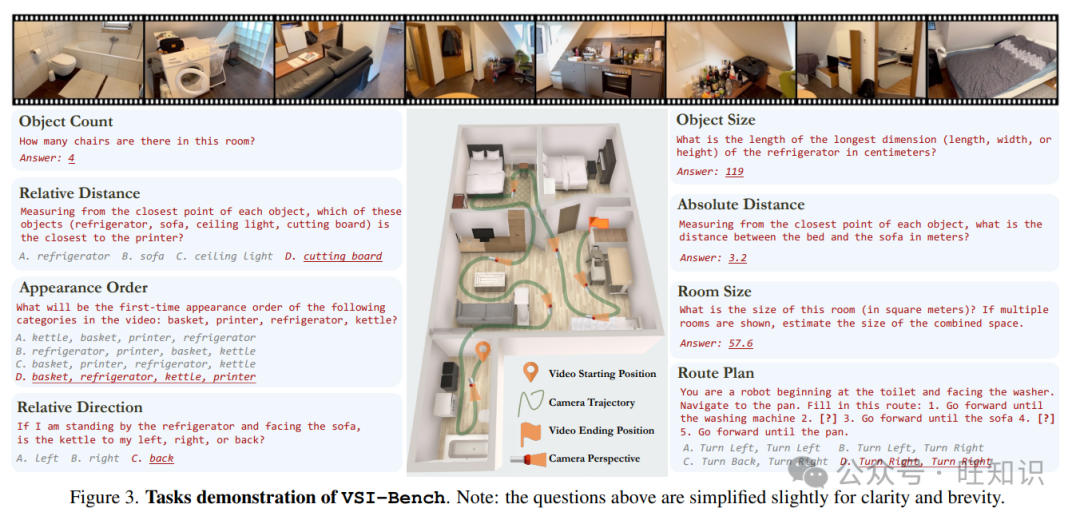

VSI - Bench包括三種類型的八個任務:配置、測量估計和時空。配置任務(物體計數、相對距離、相對方向、路線規劃)測試模型對空間配置的理解,對人類來說更直觀(見第4節中MLLM和人類性能的比較)。測量估計(物體大小、房間大小和絕對距離)對任何具身智能體都有價值。雖然對人類和模型來說,精確預測測量值都非常困難,但更好的距離和其他測量的感知直觀上與更好的視覺空間智能相關,并支持許多需要空間意識的任務,如與物體的交互和導航。時空任務如出現順序測試模型對視頻中所見空間的記憶。圖3展示了VSI - Bench任務的概述,圖5展示了數據集的統計信息。

3.2. 基準構建

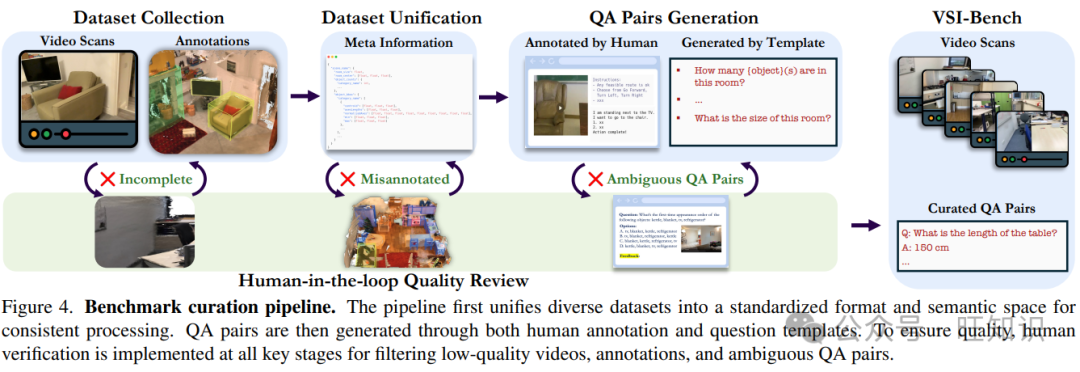

我們開發了一個復雜的基準構建管道,以有效地大規模生成高質量的問答(QA)對,如圖4所示。

- 數據收集和統一:我們通過將各種數據集標準化為統一的元信息結構來開始數據集構建,確保與數據集無關的QA對生成。我們的基準匯總了現有的3D室內場景理解和重建數據集:ScanNet[19]、ScanNet++[94]和ARKitScenes[5]。這些數據集提供了能夠進行空間重建的高保真視頻掃描,確保MLLMs僅通過視頻輸入就能回答空間級別的問題。此外,它們的對象級3D注釋有助于我們生成問題。我們將數據集解析為統一的元信息格式,包括對象類別、邊界框、視頻規格(分辨率和幀率)等。

- 問答生成:QA對主要使用元信息和問題模板自動注釋;路線規劃任務是人工注釋的。我們為每個任務精心設計和完善了問題模板,并為人工注釋者提供了指導方針。有關更詳細的設計,請參見附錄B.1。

- 人工參與的質量審查:盡管使用了人工注釋的數據源和精心設計的QA生成方法,但某些模糊性和錯誤不可避免地仍然存在,主要是由于源數據集中固有的注釋錯誤。我們在整個基準構建過程中實施了人工參與的驗證協議。這種迭代的質量保證是雙向的:當評估者標記出模糊或錯誤的問題時,我們追溯錯誤來源并刪除有問題的數據樣本或相應地修改元信息、問題模板或QA生成規則,以糾正來自同一來源的其他錯誤問題。在每次人工審查周期后,我們更新和迭代基準,直到它滿足我們的質量標準。

4. 在VSI - Bench上的評估

4.1. 評估設置

- 基準模型:我們全面評估了來自不同模型家族的15個支持視頻的MLLMs,涵蓋了各種參數規模和訓練方法。對于專有模型,我們考慮Gemini1.5[76]和GPT - 4o[33]。對于開源模型,我們評估了來自InternVL2[14]、ViLA[44]、LongViLA[88]、LongVA[98]、LLaVA - OneVision[39]和LLaVA - NeXT - Video[99]的模型。所有評估均在零樣本設置下進行,并使用每個模型的默認提示。為確保可重復性,我們對所有模型使用貪婪解碼。

MRA為計算數字預測與真實值之間的相似度提供了更可靠和有區分度的測量方法。

- 機會水平基線:我們提供了兩個基線:

- 機會水平(隨機)是MCA任務的隨機選擇準確率(不適用于NA任務)。

- 機會水平(頻率)表示MLLMs通過總是為每個任務選擇最頻繁的答案所能達到的最高性能。這確定了由于固有長尾答案或不平衡多項選擇分布可能導致的性能提升。

- 人類水平性能:我們隨機抽取400個問題(每個任務50個)的子集,我們將其稱為VSI - Bench(tiny)。人類評估者獨立回答每個問題,并使用上述指標評估他們的表現。為了進行比較,我們還報告了Gemini1.5 Pro在VSI - Bench(tiny)上的表現。有關評估設置的詳細信息,請參見附錄C。

4.2. 主要結果

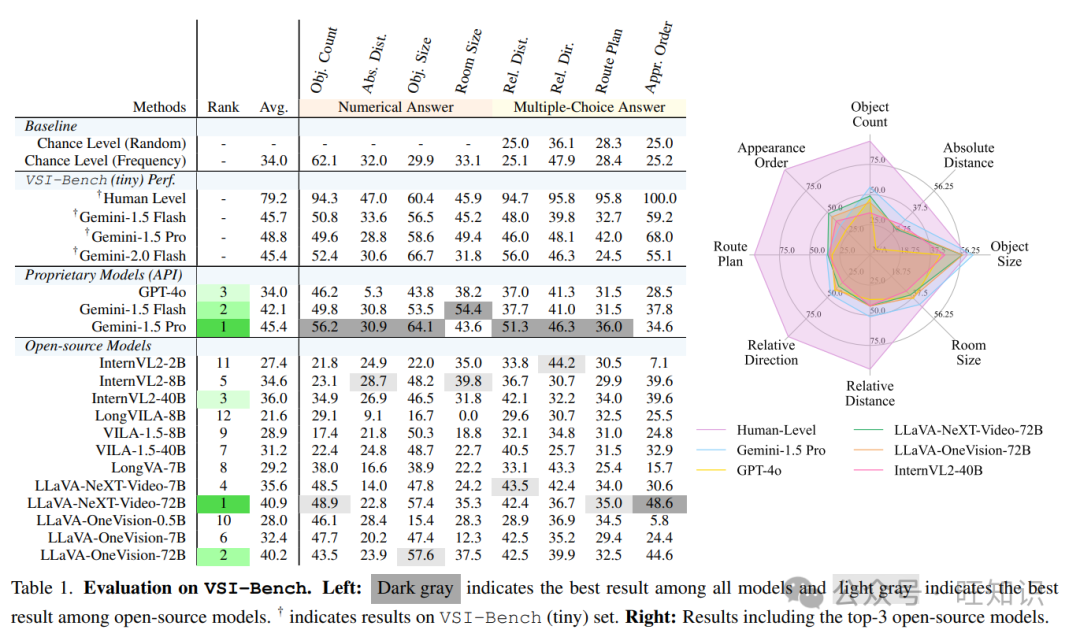

表1展示了模型在VSI - Bench上的整體表現。我們的主要觀察結果如下:

- 人類水平性能:不出所料,人類評估者在我們的基準測試中平均準確率達到79%,比表現最好的模型高出33%。值得注意的是,人類在配置和時空任務上的表現非常高,從94%到100%不等,這表明人類的直觀性。相比之下,在需要精確估計絕對距離或大小的三個測量任務上,人類和表現最好的MLLM之間的性能差距要小得多,這表明MLLMs在需要定量估計的任務中可能具有相對優勢。

- 專有MLLMs:盡管與人類存在顯著的性能差距,但領先的專有模型Gemini1.5 Pro取得了有競爭力的結果。它大大超過了機會水平基線,并在絕對距離和房間大小估計等任務中接近人類水平的表現。值得注意的是,雖然人類評估者在空間理解物理世界方面有多年的經驗,但MLLMs僅在互聯網視頻等二維數字數據上進行訓練。

- 開源MLLMs:頂級開源模型如LLaVA - NeXT - Video - 72B和LLaVA - OneVision - 72B表現出與閉源模型高度競爭的性能,僅比領先的Gemini1.5 Pro落后4%到5%。然而,大多數開源模型(12個中的7個)的表現低于機會水平基線,這表明它們的視覺空間智能存在顯著局限性。

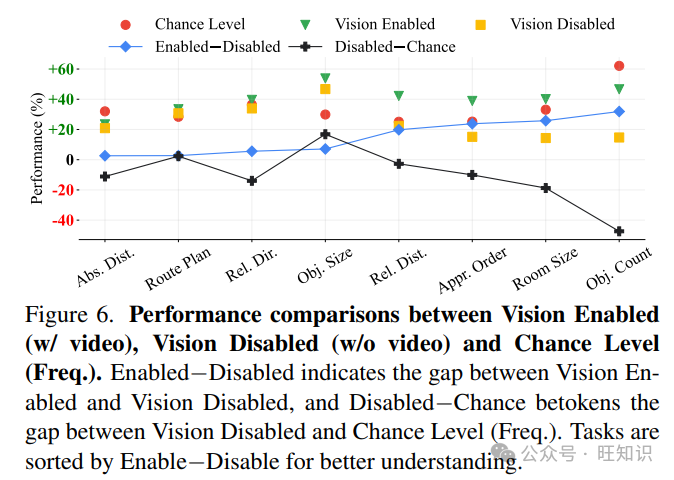

盲評:我們比較了MLLMs的性能與“機會水平(頻率)”和“無視覺(blind)”結果,使用了六個最強模型(3個開源和3個閉源)的平均值。如圖6所示,“啟用 - 禁用”的持續改進和“禁用 - 機會”的普遍下降表明,視頻對我們的VSI - Bench是必要且有益的,盲模型的表現低于機會水平。同時,無論是否啟用視覺,MLLMs在絕對距離估計、路線規劃和相對方向任務上都難以超越機會水平,這凸顯了這些任務的難度。需要注意的是,在物體大小方面,“無視覺”模型已經明顯優于機會水平,這可能是由于在語言模型訓練期間學到的常識知識。

5. MLLMs在空間中的語言思考方式

為了更好地理解模型何時以及為何成功或失敗,并闡明它們所具備的視覺空間智能的方面,我們在這里從語言角度以及在第6節從視覺角度研究MLLMs在空間中的思考方式。我們首先提示在VSI - Bench中表現最好的MLLM,Gemini1.5 Pro[76],用語言表達其內部推理過程。

5.1. 通過自我解釋進行探究

自我解釋是一種與傳統模型解釋(如LIME顯著圖[69])相當的流行方法,用于理解LLM生成的響應[25, 31, 51],并廣泛用于分析語言模型行為[64, 96]。我們隨機抽取了163個錯誤答案的子集,提示MLLM為預測答案提供解釋,并手動仔細審查這些解釋。

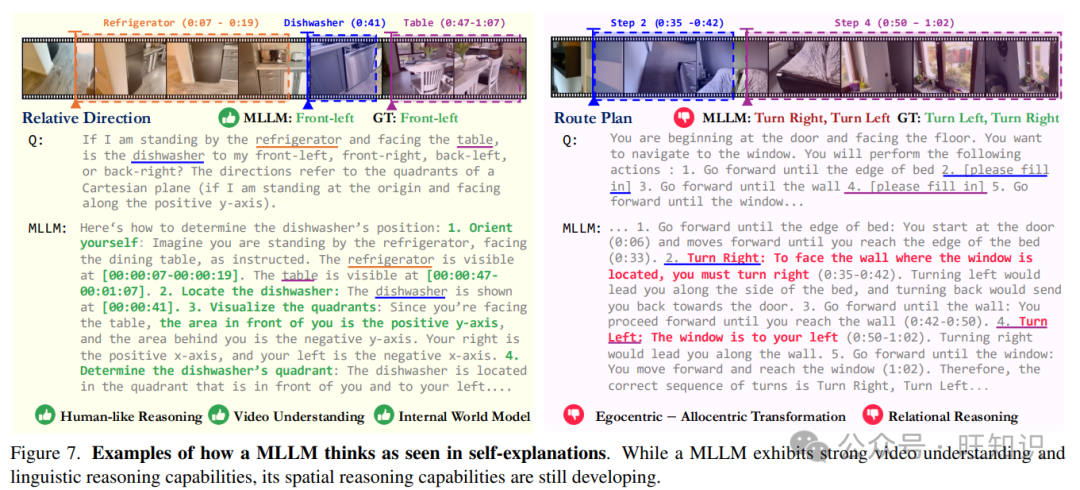

- 案例研究:圖7展示了一個成功案例和一個錯誤案例的自我解釋。在這兩個例子中,當在空間中思考時,MLLM表現出了先進的視頻理解能力,其時間戳描述的準確性令人印象深刻。該模型還形成了正確的逐步推理過程,為相對方向任務概述了“確定自身方向”、“定位洗碗機”和“可視化象限”等步驟。此外,全局坐標系的構建(圖 7,左)表明 MLLMs 可能擁有或構建了一個隱性的世界模型。MLLM 并非使用孤立的幀、短片段或隨機猜測,而是利用全局空間上下文和推理來正確推斷。

在錯誤示例(圖 7,右)中,我們可以識別出諸如自我中心 - 非自我中心轉換和關系推理等有缺陷的視覺空間能力,如在圖 2 中所介紹的。在視頻中,相機向右平移,將視角從床邊轉移到墻壁和窗戶。模型遵循這個自我中心視角,回答說“要面向窗戶所在的墻壁,必須向右轉”,而不是創建一個反映從門到床的路線實際需要向左轉的非自我中心視角。

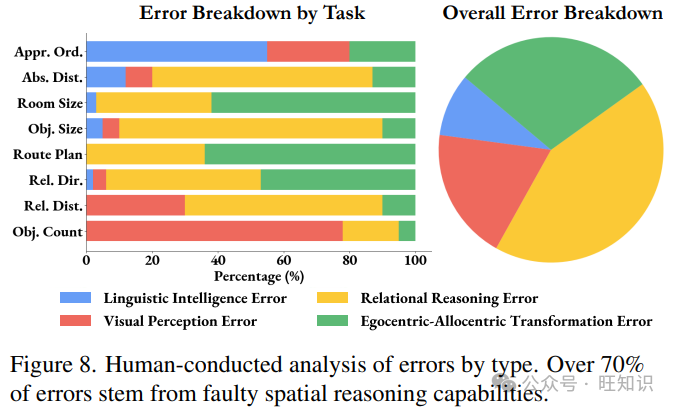

- 錯誤分析:為了量化并確定在我們的基準測試中表現最佳的 MLLM 的主要瓶頸,我們分析了它在 VSI - Bench(tiny)上的錯誤,將它們分為四種不同類型,這些類型源于我們概述的視覺空間能力(圖 2)以及在檢查時對錯誤的明確四類分類:

- 視覺感知錯誤,源于未識別的對象或錯誤分類的對象類別;

- 語言智能錯誤,由邏輯、數學推理或語言理解缺陷引起;

- 關系推理錯誤包括空間關系推理中的錯誤,即距離、方向和大小;

- 自我中心 - 非自我中心轉換錯誤,源于錯誤的非自我中心空間布局或不恰當的視角轉換。

如圖 8 所示,大約 71%的錯誤歸因于空間推理(如在圖 2 中的本體概念),這表明:

空間推理是 MLLM 在 VSI - Bench 上性能的主要瓶頸。

進一步的分析和案例研究見附錄 E.2。

5.2. 思維鏈方法在視覺空間任務中的局限性

提示技術提高了大型模型在各種任務中的推理和問題解決能力[32, 34, 73, 82]。它們的成功促使我們研究這些語言提示方法是否也能提高 MLLMs 在 VSI - Bench 中的視覺空間能力。我們研究了三種流行的提示技術(更多細節見附錄 B.3):

- 零樣本思維鏈(CoT)。遵循[37, 86],我們在提示中添加“讓我們逐步思考”。

- 帶有 CoT 的自一致性。我們遵循[84],將 MLLM 的溫度設置為 1.0 以鼓勵多樣化推理,然后將五次運行(與零樣本 CoT 一起使用)中的多數共識作為最終預測。

- 思維樹(ToT)。遵循[92]中的“創意寫作”實踐,我們將推理分為計劃生成和答案預測。MLLM 首先起草并選擇一個計劃,然后生成三個候選答案并選擇最自信的一個作為預測。

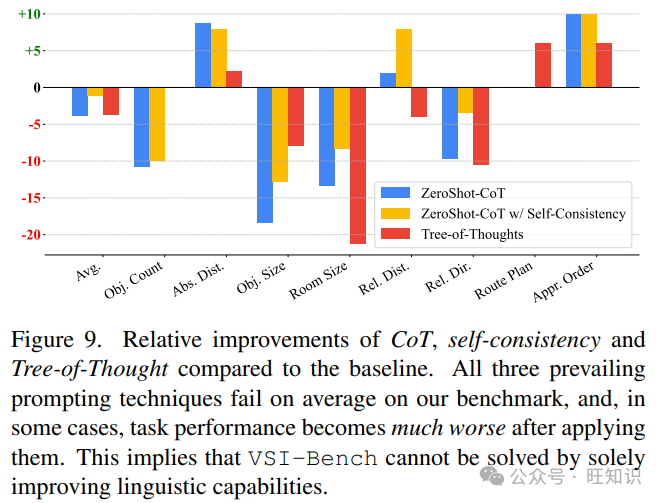

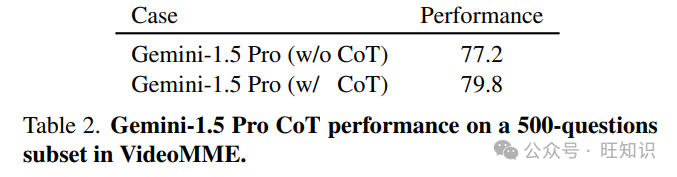

如圖 9 所示,令人驚訝的是,所有三種語言推理技術都導致了 VSI - Bench 上的性能下降。零樣本 CoT 和 ToT 使平均性能降低了約 4%,而自一致性雖然略好,但仍比無提示基線低 1.1%。外觀順序和絕對距離估計任務的單方面改進很容易解釋,因為它們在語言智能錯誤中占很大比例(見圖 8)。相比之下,房間大小和物體大小任務有 8%到 21%的大幅下降,這表明鼓勵模型更多地思考不僅不可靠,而且可能有害。同時,如表 2 所示,零樣本 CoT 在通用視頻理解基準 VideoMME[24]上實現了 1.6%的改進。因此,我們的結果表明:

語言提示技術雖然在語言推理和一般視覺任務中有效,但對空間推理有害。

6. MLLMs在空間中的視覺思考方式

由于人類在進行空間推理時會下意識地構建空間的心理表征[58, 78],我們探索 MLLMs 如何記憶空間。

6.1. 通過認知地圖進行探究

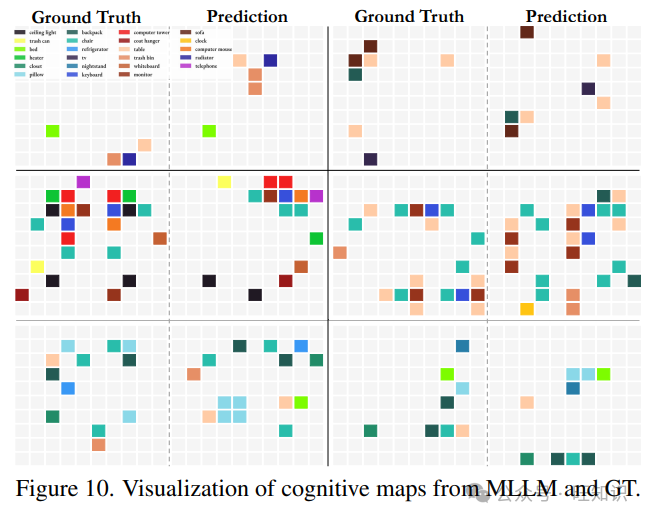

我們提示 MLLMs 使用認知地圖來表達它們對所看到空間的內部表征,認知地圖是一種在特定環境中記憶物體的成熟框架[60, 78]。我們提示表現最佳的 MLLM,Gemini1.5 Pro,根據視頻輸入在一個 10×10 的網格中預測物體中心位置(見圖 11b 關于網格大小的消融實驗和附錄 B.4 中的提示)。我們在圖 10 中展示了生成的認知地圖的示例。

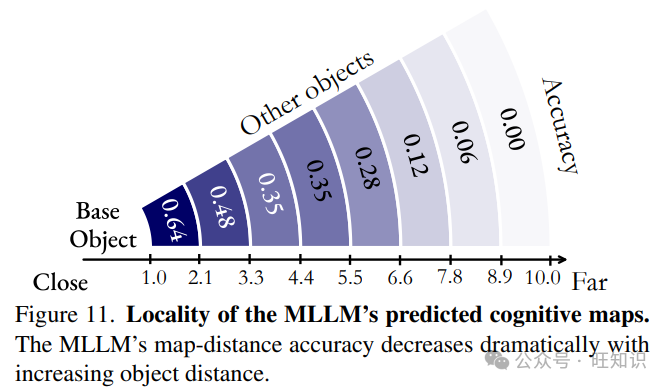

為了定量評估這些認知地圖,我們評估了每個地圖中所有對象對之間的歐幾里得距離。如果兩個對象在網格上的距離與真實認知地圖中的距離偏差不超過一個網格單元,我們就認為該距離是正確的。如圖 11 所示,我們將地圖距離分為八個不同的區間進行分析。有趣的是,我們發現 MLLM 在其認知地圖中定位相鄰對象的準確率達到了 64%,這表明它具有較強的局部空間意識。然而,隨著兩個對象之間距離的增加,這種準確率顯著下降,這表明:

當記憶空間時,MLLM 從給定視頻中在其腦海中形成一系列局部世界模型,而不是一個統一的全局模型。

這一觀察結果與從離散視頻幀形成全局空間表示的挑戰相一致,這對 MLLMs 來說本身就是困難的。雖然這對人類來說可能也不是一件容易的事,但他們可能能夠更準確地構建這樣的全局空間表示。

6.2. 通過認知地圖更好地進行距離推理

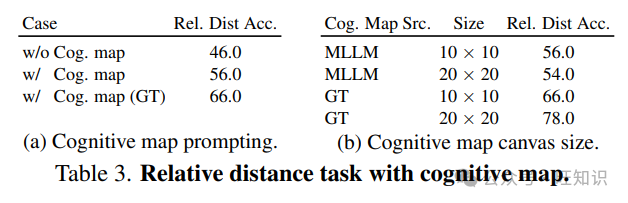

鑒于 MLLMs 在記憶空間時的局部意識(見圖 10 和圖 11)以及心理意象對人類空間思維的重要性,我們研究生成和使用認知地圖是否可以幫助 MLLMs 在 VSI - Bench 的相對距離任務中進行空間推理。這測試了通過認知地圖產生的局部距離意識是否能轉化為更好的距離回憶和推理。

我們提示 Gemini1.5 Pro 首先根據給定的視頻和問題生成一個認知地圖,然后使用預測的地圖來回答問題。如表 3a 所示,我們發現使用心理意象使 MLLM 的相對距離準確率提高了 10%。使用真實認知地圖比基線提高 20%到 32%的增益凸顯了構建場景準確心理地圖的重要性,這強制了全局一致的拓撲結構,但也表明這種心理意象只是難題的一部分,盡管是關鍵的一部分。這些結果表明構建一個心理空間世界模型或認知地圖作為 MLLMs 解決視覺空間推理的有價值的前置任務或有前途的解決方案。

7. 相關工作

除了第 2 節中的視覺空間智能,我們還在以下兩個相關領域為我們的工作奠定基礎:

- 具有視覺空間意識的 MLLMs:基于 LLMs[3, 9, 65, 66, 75, 79, 80]強大的語言和推理能力以及現代視覺編碼器[29, 63, 67]的特征提取能力,MLLMs,尤其是視覺 MLLMs,展現出了前所未有的視覺理解能力[33, 39, 76, 83, 88, 99],這是朝著開發世界模型[48]和具身智能體[17, 21, 36, 57]的有前途的方向。然而,將 MLLMs 基于現實世界對模型的視覺空間智能提出了重大挑戰,促使了最近的努力[10, 13, 16, 40, 46, 91, 102]。與先前主要關注通過 2D 圖像[68, 74, 90]或僅通過語言[56, 70, 87, 87, 89]理解空間信息的工作不同,我們的工作使用真實世界視頻評估模型的視覺空間智能,這更緊密地反映了人類對世界的理解和具身智能體的應用場景。

- 在視頻上對 MLLMs 進行基準測試:隨著 MLLMs 在靜止圖像的感知、推理和多學科任務中表現出令人印象深刻的性能[38, 50, 95, 96],人們越來越關注評估 MLLMs 的視頻理解能力[23, 24, 42, 43, 49, 52, 53, 61, 93]。例如,Video - MME[24]全面評估了 MLLMs 在各種視頻相關任務中的表現,包括識別和感知。EgoSchema[53]和 OpenEQA[62]使用自我中心視頻評估 MLLMs 的理解能力。盡管它們很重要,但大多數先前的工作都集中在內容級別的理解[24, 42, 53, 61],這主要是 2D 圖像理解的時間擴展,沒有考慮 3D 空間。超越先前的基準,我們的工作建立了一個測試平臺,使用視頻作為理解現實世界的接口,評估基于 3D 視頻的模型視覺空間智能。

8. 討論與未來工作

我們通過構建 VSI - Bench 并研究 MLLMs 在其上的性能和行為來研究模型如何觀察、記憶和回憶空間。我們對 MLLMs 在空間中的語言和視覺思考方式的分析確定了視覺空間智能的現有優勢(例如,突出的感知、時間和語言能力)和瓶頸(例如,自我中心 - 非自我中心轉換和關系推理)。雖然流行的語言提示方法未能提高空間推理能力,但構建明確的認知地圖確實增強了 MLLMs 的空間距離推理能力。未來的改進途徑包括特定任務的微調、開發用于空間推理的自監督學習目標或為 MLLMs 定制的視覺空間提示技術。

參考資料

- 標題:Thinking in Space: How Multimodal Large Language Models See, Remember, and Recall Spaces

- 作者:Jihan Yang1* Shusheng Yang1? Anjali W. Gupta1? Rilyn Han2? Li Fei-Fei3 Saining Xie1

- 單位:1紐約大學 2耶魯大學 3斯坦福大學

- 標簽:多模態大語言模型、視覺空間智能、人工智能、基準測試

- 概述: 本文主要研究多模態大語言模型(MLLMs)的視覺空間智能,通過構建 VSI - Bench 基準測試,分析 MLLMs 在其中的表現、思考方式及能力瓶頸,并探討了提升其視覺空間智能的方法。

- 鏈接:https://arxiv.org/pdf/2412.14171

本文轉載自 ??旺知識??,作者: 旺知識