北大字節開辟圖像生成新范式!超越Sora核心組件DiT,不再預測下一個token

北大和字節聯手搞了個大的:

提出圖像生成新范式,從預測下一個token變成預測下一級分辨率,效果超越Sora核心組件Diffusion Transformer(DiT)。

并且代碼開源,短短幾天已經攬下1.3k標星,登上GitHub趨勢榜。

具體是個什么效果?

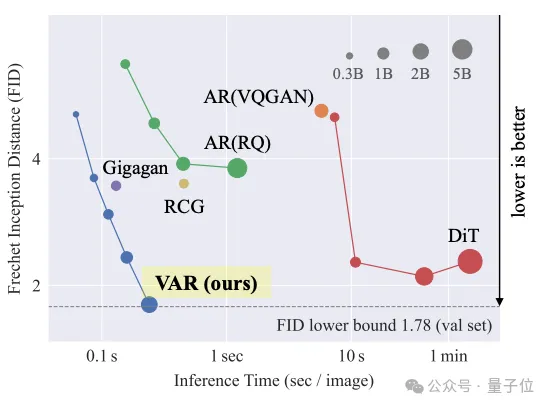

實驗數據上,這個名為VAR(Visual Autoregressive Modeling)的新方法不僅圖像生成質量超過DiT等傳統SOTA,推理速度也提高了20+倍。

這也是自回歸模型首次在圖像生成領域擊敗DiT。

?

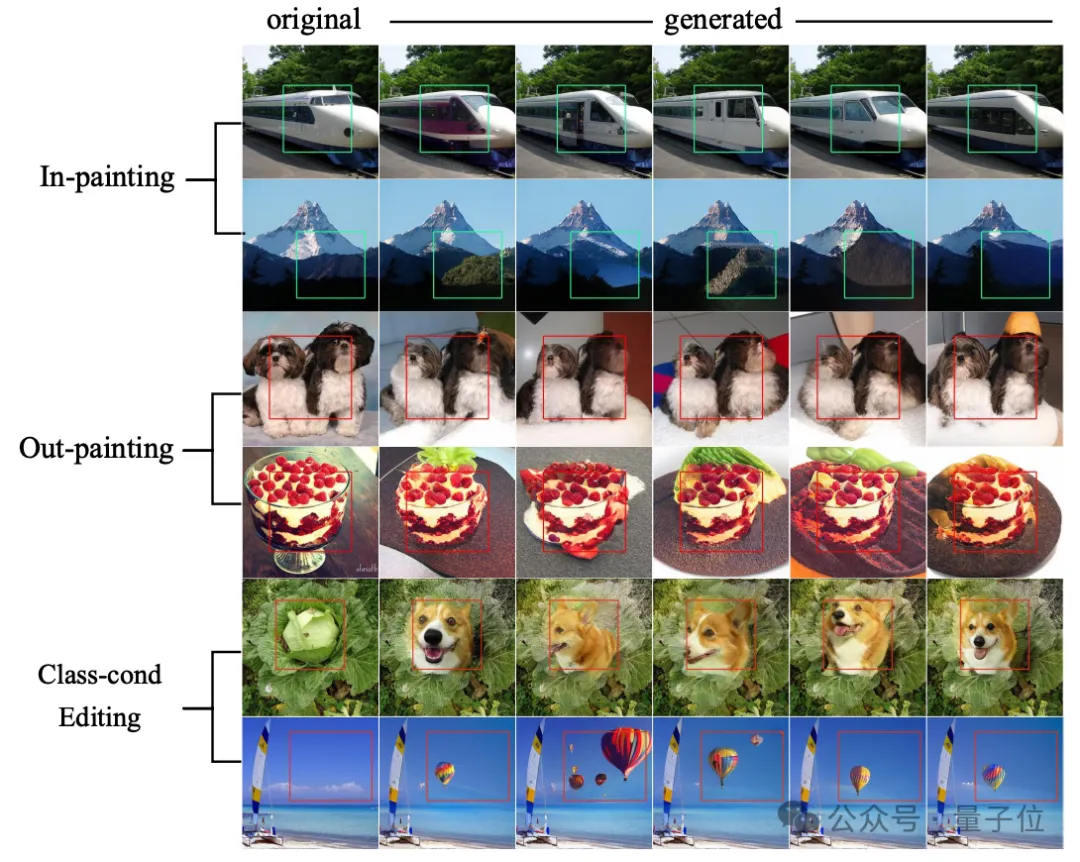

直觀感受上,話不多說,直接看圖:

值得一提的是,研究人員還在VAR上,觀察到了大語言模型同款的Scaling Laws和零樣本任務泛化。

論文代碼上線,已經引發不少專業討論。

有網友表示有被驚到,頓時覺得其他擴散架構的論文有點索然無味。

還有人認為,這是一種通向Sora的更便宜的潛在途徑,計算成本可降低一個乃至多個數量級。

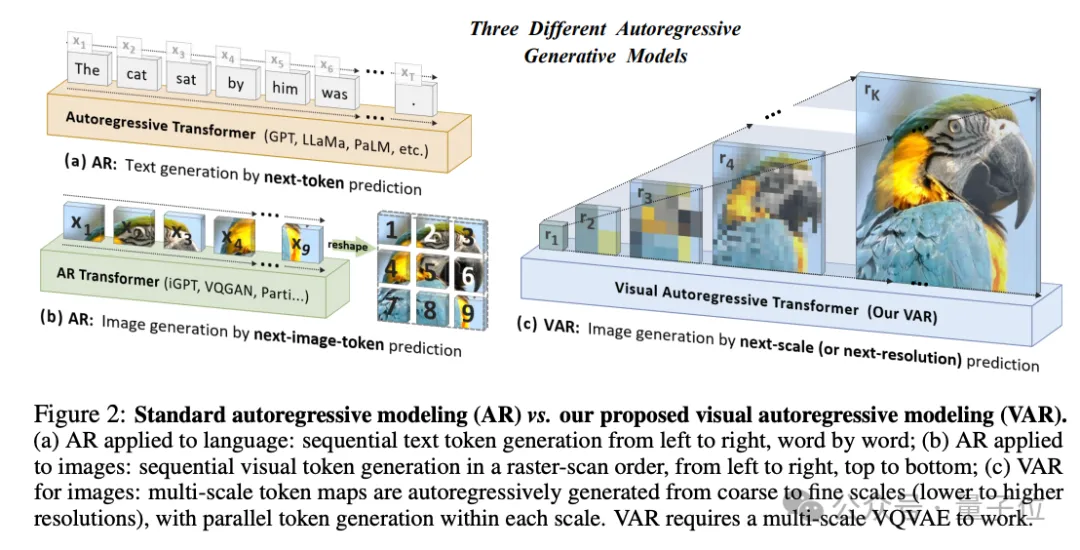

預測下一級分辨率

簡單來說,VAR的核心創新,就是用預測下一級分辨率,替代了預測下一個token的傳統自回歸方法。

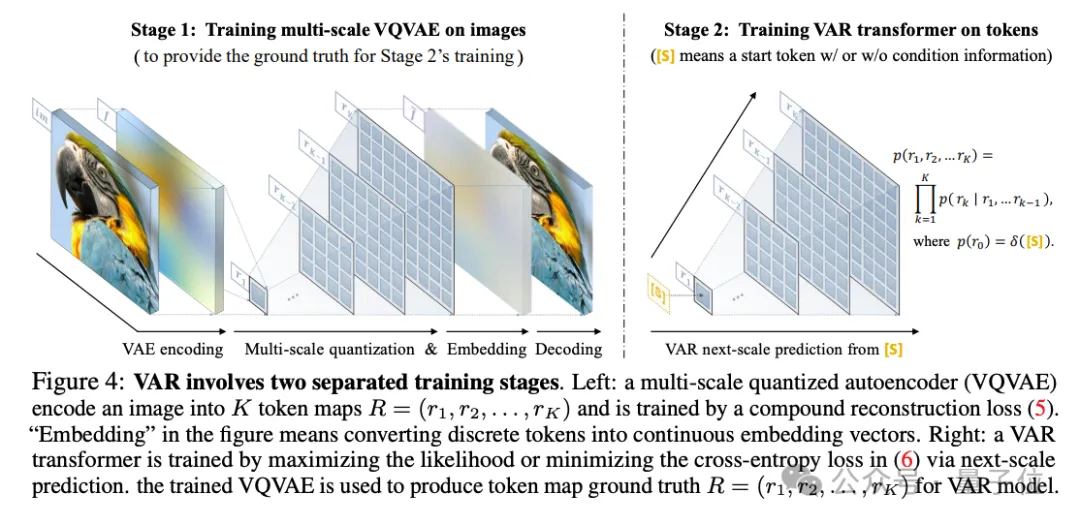

VAR的訓練分為兩個階段。

第一階段,VAR引入了多尺度離散表示,使用VQ-VAE將連續圖像編碼為一系列離散的token map,每個token map有不同的分辨率。

第二階段,主要是對VAR Transformer的訓練,通過預測更高分辨率的圖像,來進一步優化模型。具體過程是這樣的:

從最低分辨率(比如1×1)的token map開始,預測下一級分辨率(比如4×4)的完整token map,并以此類推,直到生成最高分辨率的token map(比如256×256)。在預測每個尺度的token map時,基于Transformer,模型會考慮之前所有步驟生成的映射信息。

在第二階段中,之前訓練好的VQ-VAE模型發揮了重要作用:為VAR提供了“參考答案”。這能幫助VAR更準確地學習和預測圖像。

另外,在每個尺度內,VAR是并行地預測所有位置的token,而不是線性逐個預測,這大大提高了生成效率。

研究人員指出,采用這樣的方法,VAR更符合人類視覺感知從整體到局部的特點,并能保留圖像的空間局部性。

符合Scaling Laws

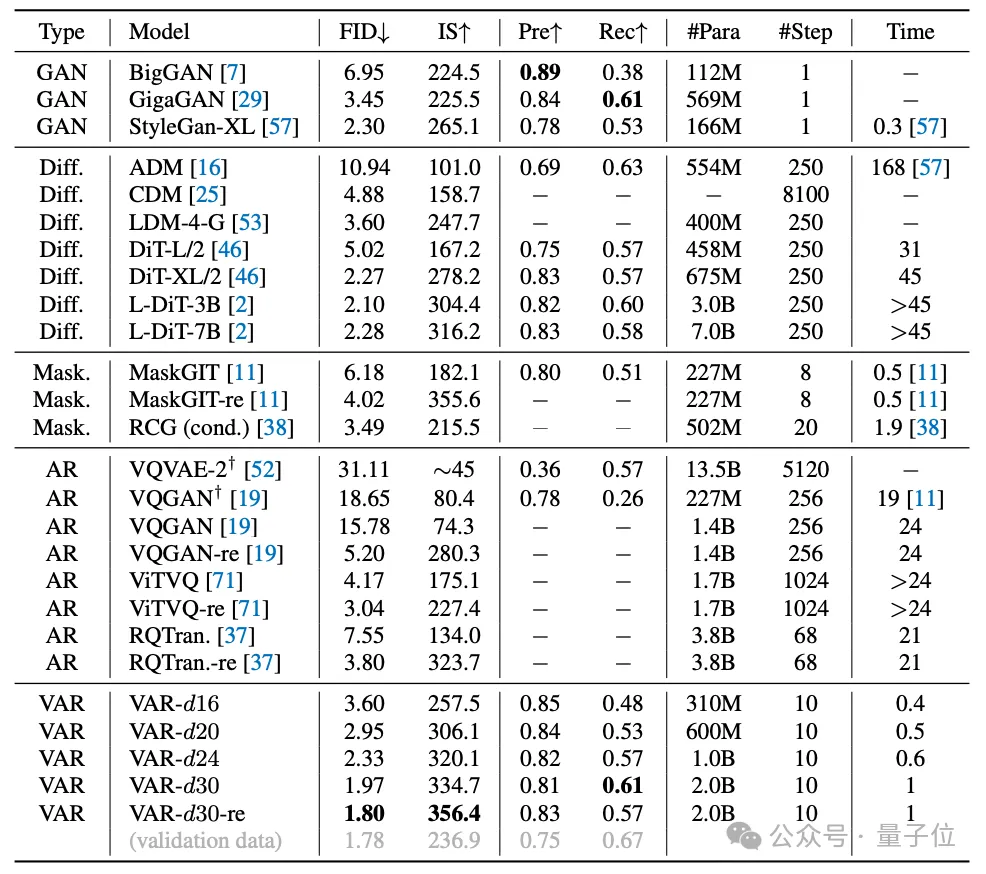

從實驗結果來看,在圖像生成質量、推理速度、數據效率和可擴展性等方面,VAR都超過了DiT。

在ImageNet 256×256上,VAR將FID從18.65降到了1.8,IS從80.4提高到356.4,顯著改善了自回歸模型基線。

注:FID越低,說明生成圖像的質量和多樣性越接近真實圖像。

推理速度方面,相較于傳統自回歸模型,VAR實現了約20倍的效率提升。而DiT消耗的時間是VAR的45倍。

數據效率方面,VAR只需要350個訓練周期(epoch),遠少于DiT-XL/2的1400個。

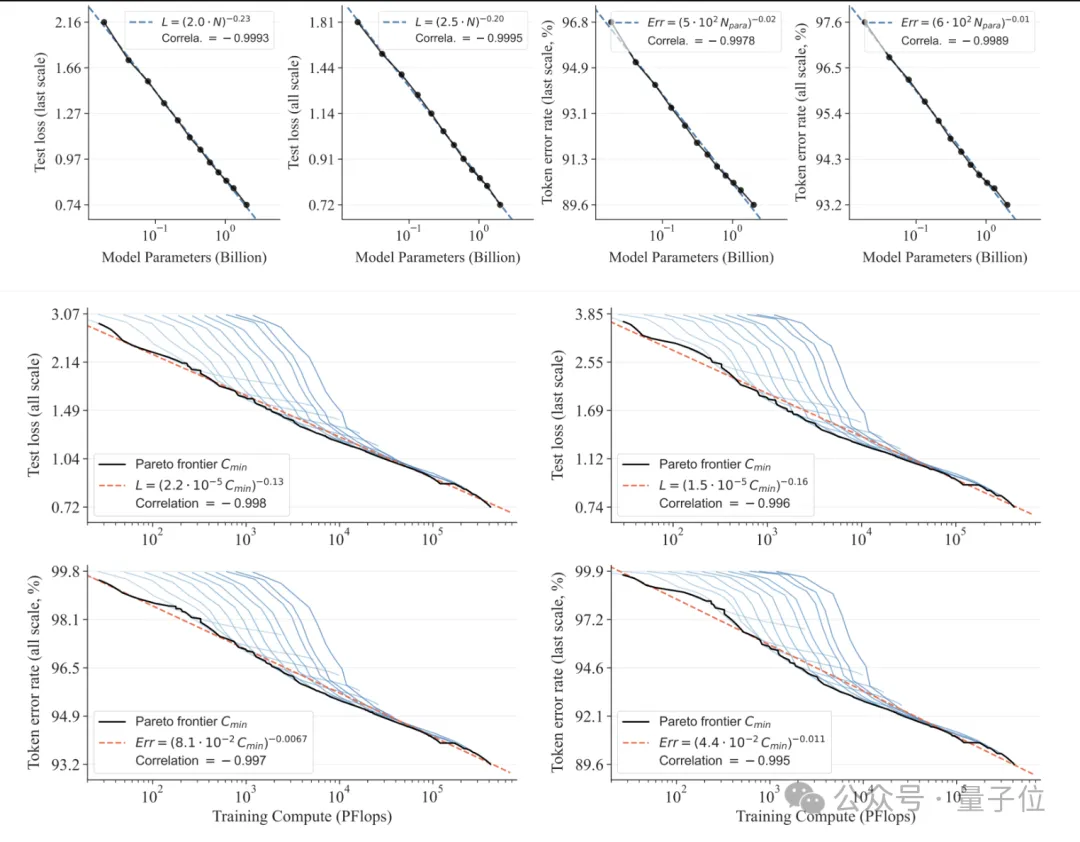

可擴展性方面,研究人員觀察到VAR有類似于大語言模型的Scaling Laws:隨著模型尺寸和計算資源的增加,模型性能持續提升。

另外,在圖像修補、擴展和編輯等下游任務的零樣本評估中,VAR表現出了出色的泛化能力。

目前,在GitHub倉庫中,推理示例、demo、模型權重和訓練代碼均已上線。

不過,在更多討論之中,也有網友提出了一些問題:

VAR不如擴散模型靈活,并且在分辨率上存在擴展問題。

北大字節聯合出品

VAR的作者們,來自字節跳動AI Lab和北大王立威團隊。

一作田柯宇,本科畢業自北航,目前是北大CS研究生,師從北京大學信息科學技術學院教授王立威。2021年開始在字節AI Lab實習。

論文通訊作者,是字節跳動AI Lab研究員袁澤寰和王立威。

袁澤寰2017年博士畢業于南京大學,目前專注于計算機視覺和機器學習研究。王立威從事機器學習研究20余年,是首屆“優青”獲得者。

該項目的項目主管,是字節跳動廣告生成AI研究主管Yi jiang。他碩士畢業于浙江大學,目前的研究重點是視覺基礎模型、深度生成模型和大語言模型。

本文轉自 量子位 ,作者:量子位