深入探討語音轉(zhuǎn)文本技術(shù)的演進

語音轉(zhuǎn)文本 (STT),也稱為自動語音識別 (ASR),是一種將口語轉(zhuǎn)錄成書面文本的 AI 技術(shù),現(xiàn)在越來越多的公司利用 STT 在現(xiàn)有應(yīng)用程序中嵌入新的音頻功能,并為一系列用例創(chuàng)建智能助手。

語音轉(zhuǎn)文本模型簡史

首先,一些背景信息。語音轉(zhuǎn)文本是 AI 中自然語言處理 (NLP) 分支的一部分。它的目標是使機器能夠理解人類語音并將其轉(zhuǎn)錄成書面格式。

你可能會想,轉(zhuǎn)錄語音有多難。簡短的回答是:非常難。與可以以相對簡單的方式放入矩陣中的圖像不同,音頻數(shù)據(jù)受背景噪聲、音頻質(zhì)量、口音和行業(yè)術(shù)語的影響,這使得機器難以掌握。

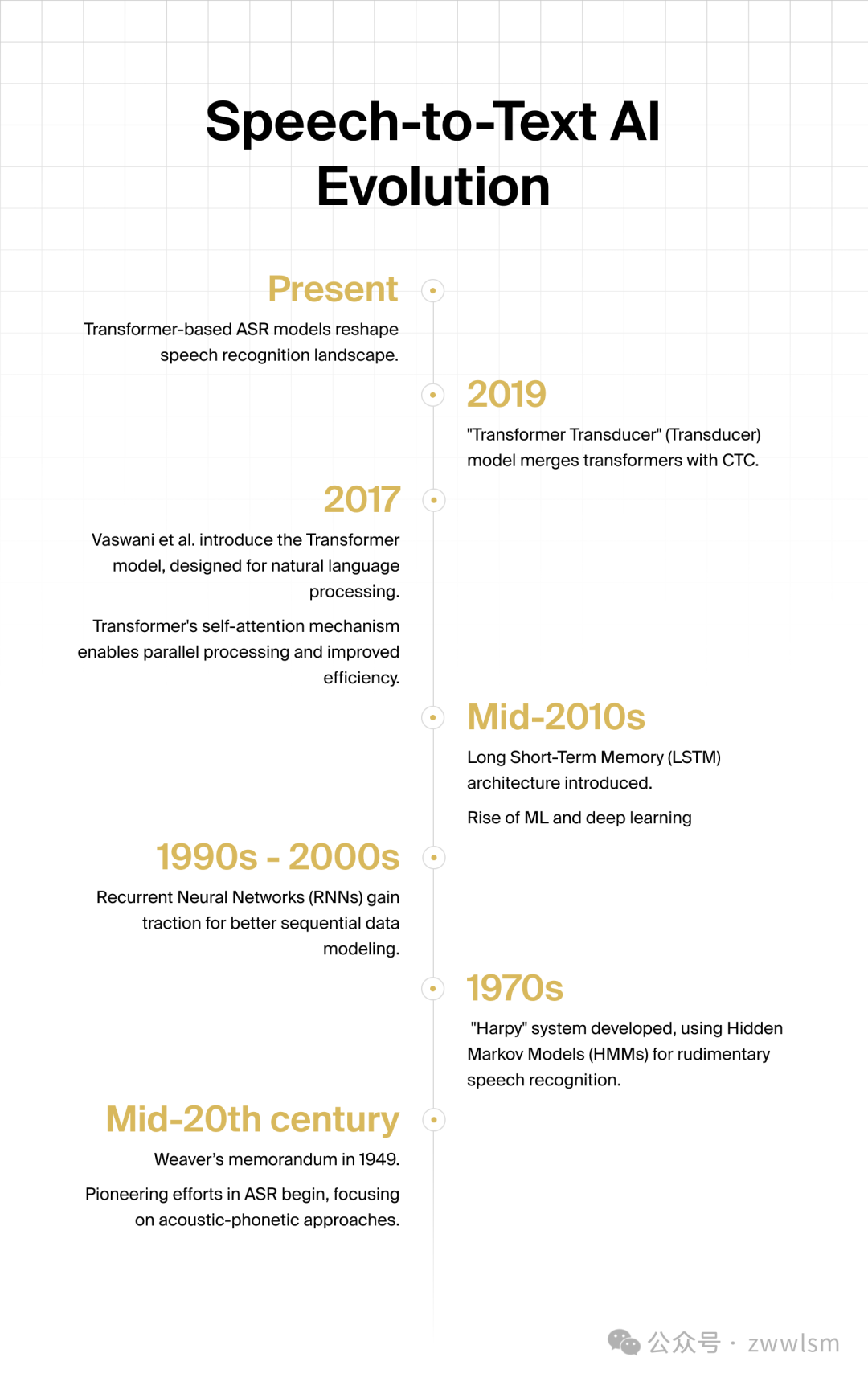

幾十年來,研究人員一直在努力應(yīng)對這些挑戰(zhàn)。這一切都始于 1949 年 Weaver 的備忘錄,它激發(fā)了使用計算機處理語言的想法。早期的自然語言處理 (NLP) 模型使用隱馬爾可夫模型 (HMM) 等統(tǒng)計方法來轉(zhuǎn)錄語音,但它們準確識別不同口音、方言和語音風(fēng)格的能力受到限制。

在接下來的幾十年里,從語法理論到符號 NLP 再到統(tǒng)計模型,見證了許多重要的發(fā)展,所有這些都為我們今天所知道的 ASR 系統(tǒng)鋪平了道路。但該領(lǐng)域真正的重大變化發(fā)生在 2010 年代,隨著機器學(xué)習(xí) (ML) 和深度學(xué)習(xí)的興起。

統(tǒng)計模型被 ML 算法所取代,例如深度神經(jīng)網(wǎng)絡(luò) (DNN) 和遞歸神經(jīng)網(wǎng)絡(luò) (RNN),這些算法能夠捕獲以前難以檢測的慣用表達和其他細微差別。不過,仍然存在上下文問題:模型無法根據(jù)整個句子推斷特定單詞的含義,這不可避免地導(dǎo)致了錯誤。

然而,這十年來最大的發(fā)明是 2017 年發(fā)明 Transformers。Transformers 的自注意力機制徹底改變了 ASR。 與以前的所有模型不同,Transformers 成功地捕獲了不同詞性之間的長期依賴關(guān)系,使它們能夠考慮每個轉(zhuǎn)錄句子的更廣泛上下文。

基于 Transformers 的 ASR 模型的出現(xiàn)重塑了語音識別領(lǐng)域。其卓越的性能和效率為各種應(yīng)用程序提供支持,從語音助手到高級轉(zhuǎn)錄和翻譯服務(wù)。

許多人認為,正是在那時,我們從單純的“語音識別”過渡到更全面的“語言理解”領(lǐng)域。

由于最新的突破,ASR 系統(tǒng)的整體性能(在速度和質(zhì)量方面)多年來得到了顯著提高,這得益于開源存儲庫的可用性、來自 Web 的大型訓(xùn)練數(shù)據(jù)集以及更易于訪問的 GPU/CPU 硬件成本。

Speech-to-Text 的工作原理

如今,尖端的 ASR 解決方案依靠各種模型和算法來產(chǎn)生快速準確的結(jié)果。但是 AI 究竟是如何將語音轉(zhuǎn)換為書面形式的呢?

轉(zhuǎn)錄是一個復(fù)雜的過程,涉及多個階段和 AI 模型協(xié)同工作。以下是 speech-to-text 中關(guān)鍵步驟的概述:

- 預(yù)處理。 在轉(zhuǎn)錄輸入音頻之前,它通常會經(jīng)歷一些預(yù)處理步驟。這可能包括降噪、回聲消除和其他提高音頻信號質(zhì)量的技術(shù)。

- 特征提取。 然后將音頻波形轉(zhuǎn)換為更適合分析的表示形式。這通常涉及從音頻信號中提取特征,以捕獲聲音的重要特征,例如頻率、振幅和持續(xù)時間。梅爾頻率倒譜系數(shù) (MFCC) 是語音處理中常用的特征。

- 聲學(xué)建模。 涉及訓(xùn)練一個統(tǒng)計模型,該模型將提取的特征映射到音素,音素是語言中的最小聲音單位。

- 語言建模。 語言建模側(cè)重于語音的語言方面。它涉及創(chuàng)建一個概率模型,說明單詞和短語在特定語言中的可能顯示方式。這有助于系統(tǒng)根據(jù)句子中的前一個單詞,就哪些單詞更有可能出現(xiàn)做出明智的決定。

- 譯碼。 在解碼階段,系統(tǒng)使用聲學(xué)和語言模型將音頻轉(zhuǎn)錄為單詞或標記序列。此過程涉及搜索與給定音頻特征對應(yīng)的最可能的單詞序列。

- 后處理。 解碼后的轉(zhuǎn)錄可能仍包含錯誤,例如誤識別或同音異義詞(發(fā)音相同但含義不同的單詞)。在生成最終輸出之前,應(yīng)用后處理技術(shù)(包括語言約束、語法規(guī)則和上下文分析)來提高轉(zhuǎn)錄的準確性和連貫性。

STT 模型的主要類型

轉(zhuǎn)錄發(fā)生的確切方式取決于所使用的 AI 模型。一般來說,我們可以區(qū)分聲學(xué)遺留系統(tǒng)和基于端到端深度學(xué)習(xí)模型的系統(tǒng)。

聲學(xué)系統(tǒng)依賴于隱馬爾可夫模型 (HMM) 和深度神經(jīng)網(wǎng)絡(luò) (DNN) 等傳統(tǒng)模型的組合來執(zhí)行一系列子過程來執(zhí)行上述步驟。

這里的轉(zhuǎn)錄過程是通過傳統(tǒng)的聲學(xué)-語音匹配完成的,即系統(tǒng)嘗試根據(jù)聲音猜測單詞。由于每個步驟都由單獨的模型執(zhí)行,因此這種方法容易出錯,并且由于需要獨立訓(xùn)練所涉及的每個模型,因此成本相當高且效率低下。

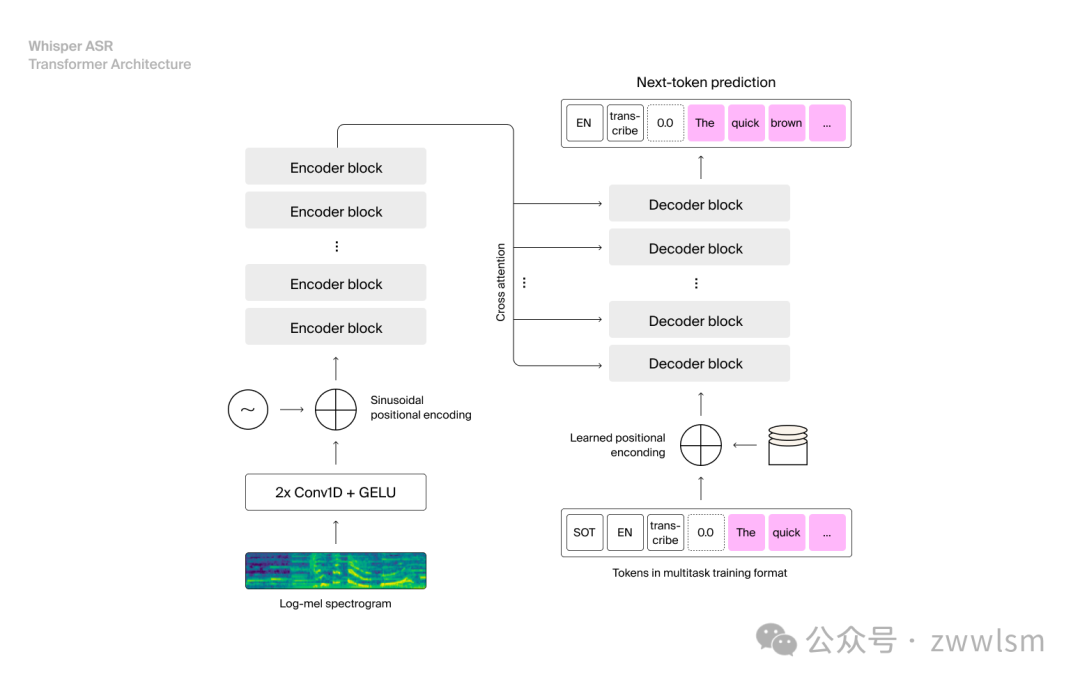

相比之下,由 CNN、RNN 和/或變壓器提供支持的端到端系統(tǒng)作為單個神經(jīng)網(wǎng)絡(luò)運行,所有關(guān)鍵步驟都合并到一個互連的過程中。一個值得注意的例子是 OpenAI 的 Whisper ASR。

這種方法旨在解決遺留系統(tǒng)的局限性,由于采用了更精細的基于嵌入的機制,因此可以提高準確性,從而根據(jù)每個給定單詞的語義接近性實現(xiàn)語言的上下文理解。

關(guān)于微調(diào)的注意事項

盡管上一代轉(zhuǎn)錄模型非常準確,但得益于新技術(shù)和大型語言模型 (LLMs) 的支持,它們?nèi)匀恍枰稽c幫助才能應(yīng)用于特定用例,而不會影響輸出準確性。更具體地說,這些模型可能需要額外的工作才能用于特定的轉(zhuǎn)錄或音頻智能任務(wù)。

微調(diào)包括通過在特定于任務(wù)的數(shù)據(jù)上訓(xùn)練預(yù)先訓(xùn)練的神經(jīng)網(wǎng)絡(luò),使其適應(yīng)新的應(yīng)用程序。這是使高質(zhì)量 STT 具有商業(yè)可行性的關(guān)鍵。

在音頻中,微調(diào)用于使模型適應(yīng)技術(shù)專業(yè)領(lǐng)域(即醫(yī)學(xué)詞匯、法律術(shù)語)、口音、語言、噪音水平、特定說話人等。在我們的微調(diào) ASR 模型的指南中,我們更詳細地探討了這項技術(shù)的機制、用例和應(yīng)用。

主要特點和參數(shù)

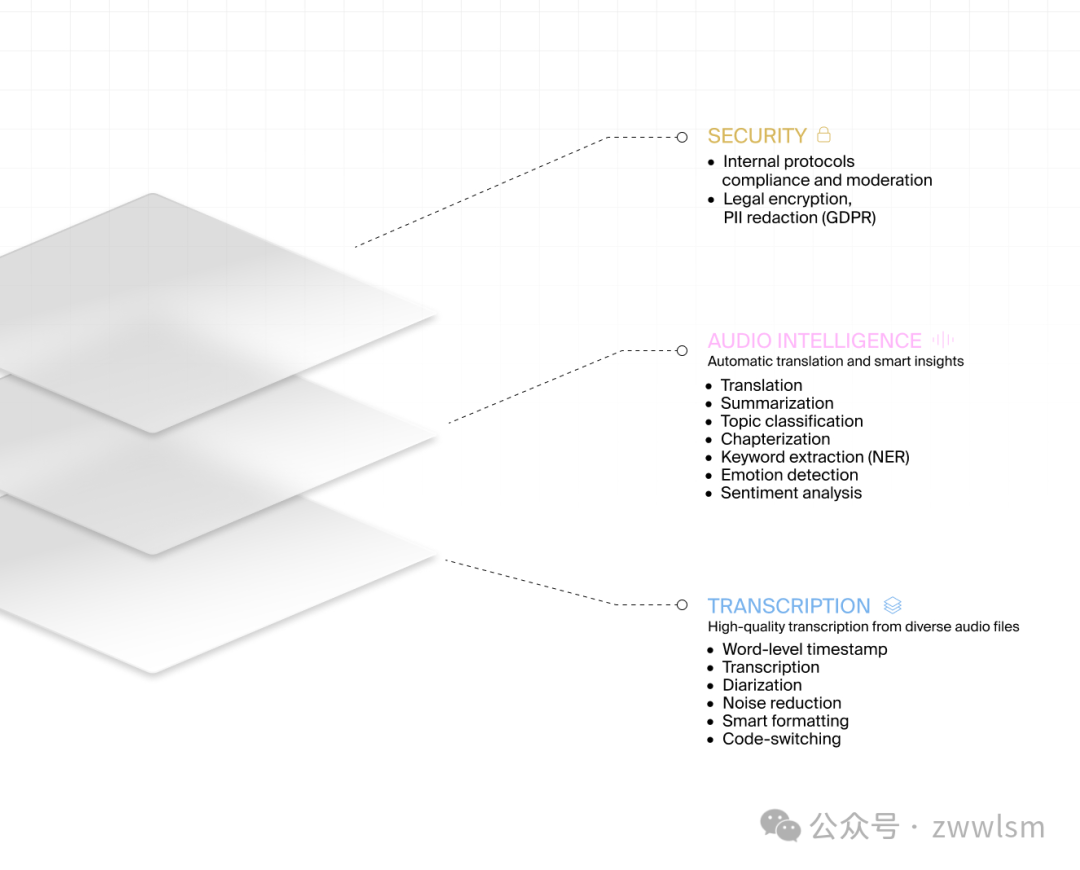

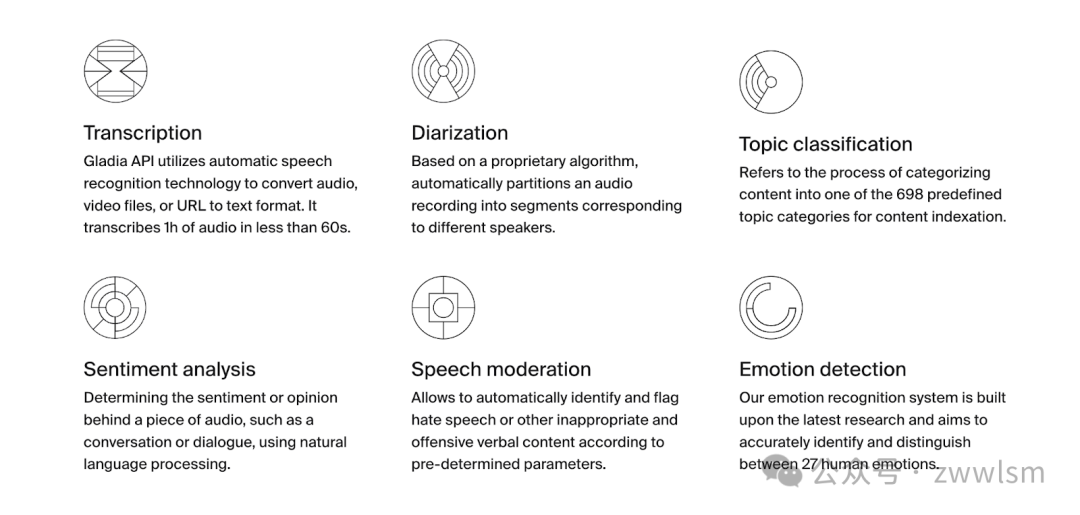

除了核心轉(zhuǎn)錄技術(shù)之外,如今大多數(shù)提供商還提供一系列附加功能,從說話人分類到摘要,再到情感分析,統(tǒng)稱為“音頻智能”。

使用 API,基礎(chǔ)轉(zhuǎn)錄輸出并不總是由負責(zé) “智能” 層的同一模型執(zhí)行。事實上,商業(yè)語音文本提供商通常使用多種模型的組合來創(chuàng)建高質(zhì)量和多功能的企業(yè)級 STT API。

轉(zhuǎn)錄:關(guān)鍵概念

有許多參數(shù)會影響轉(zhuǎn)錄過程,并可能影響一個人對 STT 解決方案或提供者的選擇。以下是需要考慮的關(guān)鍵因素。

輸入

- 格式: 大多數(shù)轉(zhuǎn)錄模型根據(jù)音頻文件格式(m4a、mp3、mp4、mpeg)提供不同級別的質(zhì)量,其中一些模型只接受特定格式。根據(jù)轉(zhuǎn)錄是異步轉(zhuǎn)錄還是實時轉(zhuǎn)錄,格式的應(yīng)用會有所不同。

- 音頻編碼:音頻編碼是將音頻文件從一種格式更改為另一種格式的過程,例如,為了減少傳輸音頻信息所需的位數(shù)。

- 頻率: 對于語音轉(zhuǎn)文本模型,聲音可以理解的最小頻率。目前生成的大多數(shù)音頻文件的最低頻率為 40 kHz,但某些類型的音頻(例如來自呼叫中心的電話錄音)的頻率較低,導(dǎo)致錄音頻率為 16 kHz 甚至 8 kHz。需要對更高的頻率(如 128Khz 的 mp3 文件)進行重新采樣。

- 位深度: 位深度表示錄制了音頻樣本的振幅量。它有點像圖像分辨率,但用于聲音。具有較高位深度的文件將表示更廣泛的聲音范圍,從非常柔和到非常響亮。例如,大多數(shù) DVD 的音頻為 24 位,而大多數(shù)電話的音頻為 8 位。

- 渠道: 輸入音頻可以有多個通道:單聲道(單聲道)、立體聲(雙聲道); 多通道(多個軌道)。

輸出

任何轉(zhuǎn)錄輸出都應(yīng)該包含一些基本組件,并且通常以一系列轉(zhuǎn)錄文本的形式出現(xiàn),其中包含關(guān)聯(lián)的 ID 和時間戳。

除此之外,請務(wù)必考慮轉(zhuǎn)錄輸出的格式。大多數(shù)提供商至少會提供至少包含上述數(shù)據(jù)點的轉(zhuǎn)錄文本的 JSON 文件。有些還將提供轉(zhuǎn)錄的純文本版本,例如 .txt 文件,或適合字幕的格式,例如 SRT 或 VTT。

性能

延遲

延遲是指模型接收到輸入(即語音或音頻信號)與開始生成輸出(即轉(zhuǎn)錄文本)之間的延遲。在 STT 系統(tǒng)中,延遲是一個關(guān)鍵因素,因為它直接影響用戶體驗。延遲越短,響應(yīng)時間越短,聽錄體驗越實時。

推理

在 AI 中,推理是指根據(jù)數(shù)據(jù)和以前的學(xué)習(xí)“推斷”輸出的操作。在 STT 中,在推理階段,該模型利用其學(xué)到的語音模式和語言知識來生成準確的轉(zhuǎn)錄。

推理的效率和速度會影響 STT 系統(tǒng)的延遲。

準確性

STT 模型的性能結(jié)合了許多因素,例如:

- 端到端延遲(上傳、編碼等期間)

- 在惡劣環(huán)境(例如背景噪聲或靜電)下的穩(wěn)健性。

- 涵蓋復(fù)雜的詞匯和語言。

- 模型架構(gòu)、訓(xùn)練數(shù)據(jù)數(shù)量和質(zhì)量。

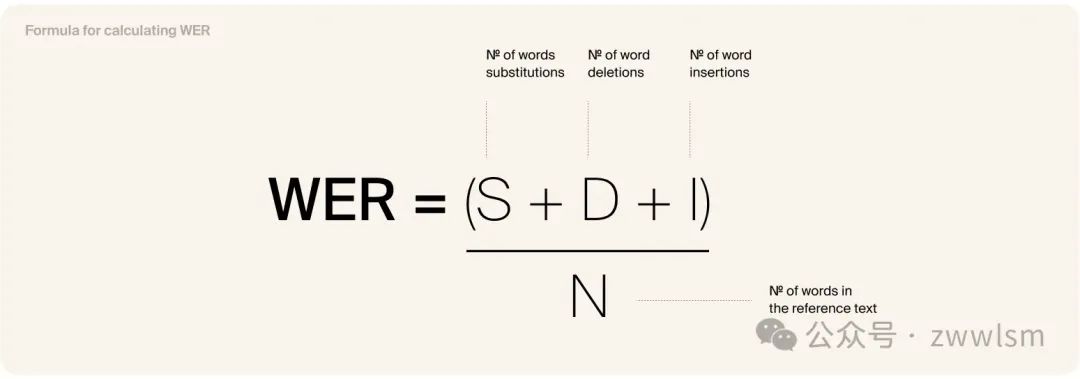

單詞錯誤率 (WER) 是用于評估語音識別系統(tǒng)或機器翻譯系統(tǒng)準確性的行業(yè)范圍指標。它測量系統(tǒng)輸出中與參考或真實文本中的單詞不同的單詞的百分比。

用于對準確性進行基準測試的其他指標是誤差率 (DER),它評估說話人分類和單詞級時間戳的平均絕對對齊誤差 (MAE)。

語言

即使是最先進的多語言模型,如 OpenAI 的 Whisper,也嚴重偏向于某些語言,如英語、法語和西班牙語。發(fā)生這種情況是因為用于訓(xùn)練它們的數(shù)據(jù),或者因為模型在轉(zhuǎn)錄過程中權(quán)衡不同參數(shù)的方式。

為了擴展語言和方言的范圍,需要額外的微調(diào)和優(yōu)化技術(shù),尤其是在涉及開源模型的情況下。

音頻智能

對于越來越多的使用案例,僅靠轉(zhuǎn)錄是不夠的。如今,大多數(shù)商業(yè) STT 提供商都至少提供一些附加功能,也稱為附加組件,旨在使成績單更易于消化和提供信息,以及獲得演講者的見解。以下是一些示例:

安全

在數(shù)據(jù)安全方面,托管架構(gòu)起著重要作用。希望將 Language AI 集成到現(xiàn)有技術(shù)堆棧中的公司需要決定底層網(wǎng)絡(luò)基礎(chǔ)設(shè)施的位置以及他們希望誰擁有它:云多租戶 (SaaS)、云單租戶、本地、氣隙。

可以使用 Speech-to-Text 構(gòu)建什么

AI 語音轉(zhuǎn)文本是一項用途廣泛的技術(shù),可解鎖各行各業(yè)的一系列用例。借助專門的 API,可以將 Language AI 功能嵌入到現(xiàn)有應(yīng)用程序和平臺中,讓你的用戶能夠享受轉(zhuǎn)錄、字幕、關(guān)鍵字搜索和分析。還可以構(gòu)建全新的支持語音的應(yīng)用程序,例如虛擬助手和機器人。

一些更具體的例子:

- 轉(zhuǎn)錄服務(wù):采訪、講座、會議等的書面記錄。

- 呼叫中心自動化:將客戶互動的錄音轉(zhuǎn)換為文本以供分析和處理。

- 語音筆記和聽寫:允許用戶聽寫筆記、消息或電子郵件,并將其轉(zhuǎn)換為書面文本。

- 實時字幕:為實時活動、會議、網(wǎng)絡(luò)研討會或視頻提供實時字幕和配音。

- 譯本:用于多語言交流的實時翻譯服務(wù)。

- 語音和關(guān)鍵字搜索:使用語音命令或語義搜索搜索信息。

- 語音分析:分析錄制的音頻以進行情緒分析、客戶反饋或市場研究。

- 輔助功能:開發(fā)應(yīng)用程序,通過將口語轉(zhuǎn)換為文本來幫助殘障人士,以便于溝通和理解。

語音轉(zhuǎn)文本 AI 的終極詞匯表

- 語音轉(zhuǎn)文本也稱為自動語音識別 (ASR),它是將口語轉(zhuǎn)換為書面文本的技術(shù)。

- 自然語言處理 (NLP)AI 的一個子領(lǐng)域,專注于計算機和人類語言之間的交互。

- 機器學(xué)習(xí)人工智能的一個領(lǐng)域,涉及開發(fā)算法和模型,使計算機能夠根據(jù)數(shù)據(jù)學(xué)習(xí)并做出預(yù)測或決策,而無需為特定任務(wù)明確編程。

- 神經(jīng)網(wǎng)絡(luò)一種以人腦結(jié)構(gòu)為模型的機器學(xué)習(xí)算法。

- 深度學(xué)習(xí) 機器學(xué)習(xí)的一個子集,涉及使用深度神經(jīng)網(wǎng)絡(luò)。

- 聲學(xué)模型用于語音識別的模型,用于將聲學(xué)特征映射到語音單元。

- 語言模型NLP 中用于確定單詞序列概率的統(tǒng)計模型。

- 大型語言模型(LLM)像 GPT-3 這樣的高級 AI 系統(tǒng),它們經(jīng)過大量文本數(shù)據(jù)的訓(xùn)練,以生成類似人類的文本并執(zhí)行各種自然語言處理任務(wù)。

- 音素語言中的最小聲音單位,由特定符號表示。

- Transformers一種依賴于多頭自我注意機制的神經(jīng)網(wǎng)絡(luò)架構(gòu) - 除其他外 - 它允許模型關(guān)注輸入序列的不同部分以捕獲其關(guān)系和依賴關(guān)系。

- 編碼器在神經(jīng)網(wǎng)絡(luò)的上下文中,將輸入數(shù)據(jù)轉(zhuǎn)換為壓縮或抽象表示的組件,通常用于特征提取或創(chuàng)建嵌入等任務(wù)。

- 解碼器一種神經(jīng)網(wǎng)絡(luò)組件,它采用壓縮表示(通常來自編碼器)并重建或生成有意義的輸出數(shù)據(jù),經(jīng)常用于語言生成或圖像合成等任務(wù)。

- 嵌入對象(如單詞或圖像)在低維空間中的數(shù)字表示形式,其中保留了對象之間的關(guān)系。嵌入通常用于將分類數(shù)據(jù)轉(zhuǎn)換為適合 ML 算法的格式,并捕獲單詞之間的語義相似性。

- 依賴關(guān)系給定文本中單詞和句子之間的關(guān)系。可以與語法和句法相關(guān),也可以與內(nèi)容的含義相關(guān)。

- 說話人分類分離和識別錄音或音頻流中發(fā)言者的過程。

- 說話人適應(yīng)調(diào)整語音識別模型以更好地識別特定說話人的聲音的過程。

- Language Identification自動識別錄音中所說的語言的過程。

- 關(guān)鍵字識別檢測錄音中特定單詞或短語的過程。

- 自動字幕為視頻或音頻錄制生成字幕或字幕的過程。

- 說話人驗證驗證說話人身份的過程,通常用于安全或身份驗證目的。

- 語音合成從書面文本生成口語的過程,也稱為文本轉(zhuǎn)語音 (TTS) 技術(shù)。

- 單詞錯誤率 (WER)用于衡量語音識別系統(tǒng)準確性的指標。

- 遞歸神經(jīng)網(wǎng)絡(luò) (RNN)一種特別適合于序列數(shù)據(jù)(如語音)的神經(jīng)網(wǎng)絡(luò)。

- 微調(diào)與優(yōu)化微調(diào)涉及在特定數(shù)據(jù)集或域上訓(xùn)練預(yù)先存在的模型,以使其適應(yīng)以獲得更好的性能,而優(yōu)化側(cè)重于微調(diào)超參數(shù)和訓(xùn)練設(shè)置,以最大限度地提高模型的整體效率。這兩個過程都有助于提高語音轉(zhuǎn)文本模型對特定應(yīng)用程序或領(lǐng)域的準確性和適用性。

- 模型并行性使大型模型的不同部分能夠分布在多個 GPU 上,從而允許使用 AI 芯片以分布式方式訓(xùn)練模型。通過將模型劃分為更小的部分,可以并行訓(xùn)練每個部分,與在單個 GPU 或處理器上訓(xùn)練整個模型相比,訓(xùn)練過程更快。

本文轉(zhuǎn)載自 ??芝士AI吃魚??,作者: 芝士AI吃魚