一張圖片是否勝過千言萬語?微軟發(fā)表的深入探討視覺語言模型的空間推理能力 精華

一、結論寫在前面

下面介紹的論文是微軟發(fā)表的。

論文標題:Is A Picture Worth A Thousand Words? Delving Into Spatial Reasoning for Vision Language Models

論文鏈接:??https://arxiv.org/pdf/2406.14852??

大語言模型(LLMs)和視覺語言模型(VLMs)在廣泛的任務和領域中展示了卓越的性能。盡管有此潛力,空間理解和推理——人類認知的基本組成部分——仍然未被充分探索。

論文開發(fā)了涵蓋空間推理多樣方面(如關系理解、導航和計數(shù))的新穎基準。論文對競爭性的語言和視覺語言模型進行了全面評估。論文的研究發(fā)現(xiàn)了幾點在文獻中被忽視的反直覺見解:(1)空間推理面臨重大挑戰(zhàn),競爭模型可能落后于隨機猜測;(2)盡管有額外的視覺輸入,VLMs往往表現(xiàn)不如其LLM同類模型;(3)當文本和視覺信息均可用時,多模態(tài)語言模型在提供足夠文本線索的情況下,變得不太依賴視覺信息。

此外,論文證明了利用視覺和文本之間的冗余可以顯著提升模型性能。論文希望論文的研究能指導多模態(tài)模型的發(fā)展,以提高空間智能,并進一步縮小與人類智能的差距。

?二、論文的簡單介紹

2.1 論文的背景?

基礎模型的近期突破對研究和產業(yè)產生了變革性影響,論文看到這些模型迅速融入產品和新業(yè)務中,正為人們的生活帶來積極變化。這一巨變最初由大型語言模型(LLMs)推動,這些模型在多種任務上展現(xiàn)出近乎不可思議的人類水平表現(xiàn)。過去一年中,許多模型已擴展到處理圖像和文本,導致視覺語言模型(VLMs)尤其是多模態(tài)大型語言模型(MLLMs)顯著增加,它們在圖像相關任務中展現(xiàn)出與文本領域相媲美的突破性性能。

然而,現(xiàn)實并不像宣傳的那般美好。盡管這些模型在推進常識推理、數(shù)學問題解決和科學問題回答等復雜推理任務的前沿方面發(fā)揮了重要作用,但它們在許多問題領域中的效果并不顯著。特別是,如本文所示,它們在需要對圖像進行詳細視覺理解和推理的任務上表現(xiàn)有限。

視覺理解和推理——人類感知和認知能力的內在部分——在視覺語言模型(VLMs)領域中很大程度上未被充分探索。事實上,人們常常認為視覺是人類的主要感官,然而在當前的模型中,它似乎相當次要。特別是空間推理,對日常人類活動如環(huán)境導航、地圖理解和物體操控至關重要。它涵蓋了對于生存和高級認知都至關重要的技能,包括空間導航、模式識別和從空間配置中推斷關系的能力。

論文開發(fā)了三個新穎的視覺問答(VQA)風格基準測試(Spatial-Map、Maze-Nav和Spatial-Grid),以探索VLMs在空間推理的多個方面的表現(xiàn),包括關系、導航、位置理解和物體計數(shù)。人類在這些任務上表現(xiàn)出色,因此這些能力對于智能系統(tǒng)在現(xiàn)實世界中安全有效地部署至關重要。

論文的數(shù)據(jù)集構建有一個關鍵的轉折點——論文的基準測試中的每個問題都有一個圖像和一個文本表示,足以回答每個空間理解問題。論文將這些來源的使用表示為VQA(視覺問答,標準任務,包括僅視覺輸入和問題),TQA(僅文本輸入和問題),以及VTQA(結合前兩者,包括視覺和文本輸入)。

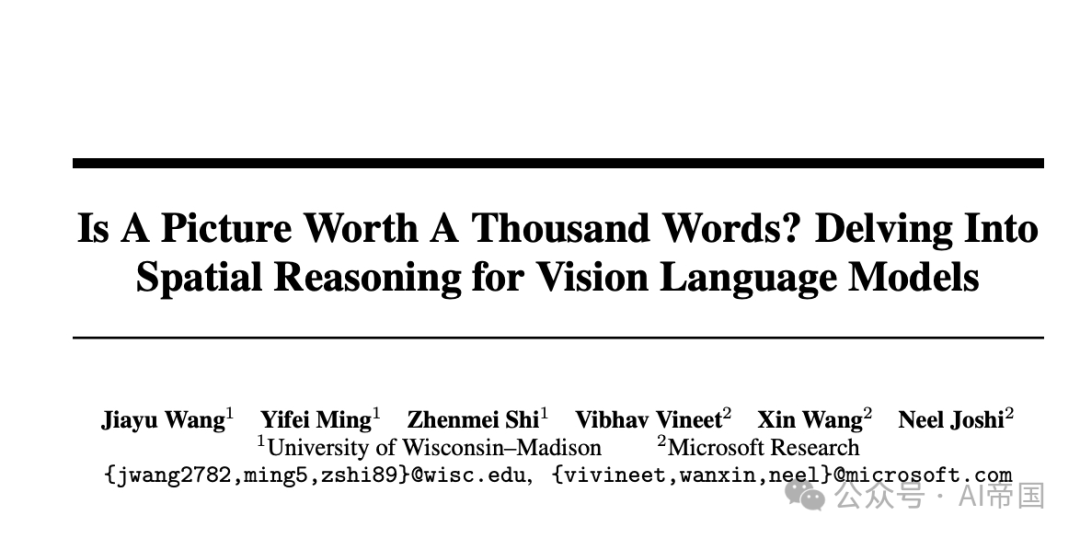

圖1:空間地圖任務的圖示,模擬包含多個位置的地圖。為了研究模態(tài)的影響,論文考慮了三種輸入格式:純文本、純視覺和視覺-文本。論文在同一組問題上評估僅使用文本輸入的語言模型和使用純視覺及視覺-文本輸入的多模態(tài)語言模型

?2.2 數(shù)據(jù)集與任務構建

2.2.1 數(shù)據(jù)集設置?

為了評估大型語言模型(LLMs)和視覺語言模型(VLMs)的空間推理能力,論文構建了包括空間關系、導航、位置理解和計數(shù)在內的三個多樣化任務。為了系統(tǒng)地研究模態(tài)的影響,論文為每個任務設計了三種類型的輸入提示:(1)純文本:輸入純粹是文本形式,包含回答問題所需的所有必要信息。(2)純視覺:輸入僅由一張圖片組成,提供了足夠詳細的信息,使人能夠輕松回答,這種格式在文獻中也被稱為視覺問答(VQA)。(3)視覺-文本:輸入包括一張圖片及其詳細的文本描述,使得兩種模態(tài)的信息都具有冗余性。論文使用純文本輸入評估語言模型,使用純文本、純視覺和視覺-文本輸入評估多模態(tài)語言模型,在同一組問題上進行。論文選擇使用合成數(shù)據(jù)。

合成數(shù)據(jù)具有以下幾個顯著優(yōu)勢:(1)避免數(shù)據(jù)泄露——由于大型語言模型是在網(wǎng)絡規(guī)模的數(shù)據(jù)上預訓練的,確保測試數(shù)據(jù)在訓練過程中未被見過至關重要;(2)可配置性——完全可配置允許進行受控實驗,并可擴展到其他任務;(3)可擴展性——易于擴展測試樣本數(shù)量,增強了結果的統(tǒng)計顯著性。

空間地圖。理解地圖上物體之間的空間關系是人類認知能力的基本方面。為了模擬這一環(huán)境,論文創(chuàng)建了一個名為Spatial-Map的地圖類數(shù)據(jù)集,包含K個物體,其中K是可配置的。每個物體都關聯(lián)一個唯一的位置名稱,例如獨角獸雨傘和蓋爾禮品。為了研究模態(tài)的影響,每個輸入的文本表示包括成對關系,例如“Brews Brothers Pub位于鯨魚瞭望的東南方”。圖1展示了一個K=6的示例,包括僅文本、僅視覺和視覺-文本輸入。這些問題涉及詢問兩個位置之間的空間關系以及滿足特定空間標準的物體數(shù)量。

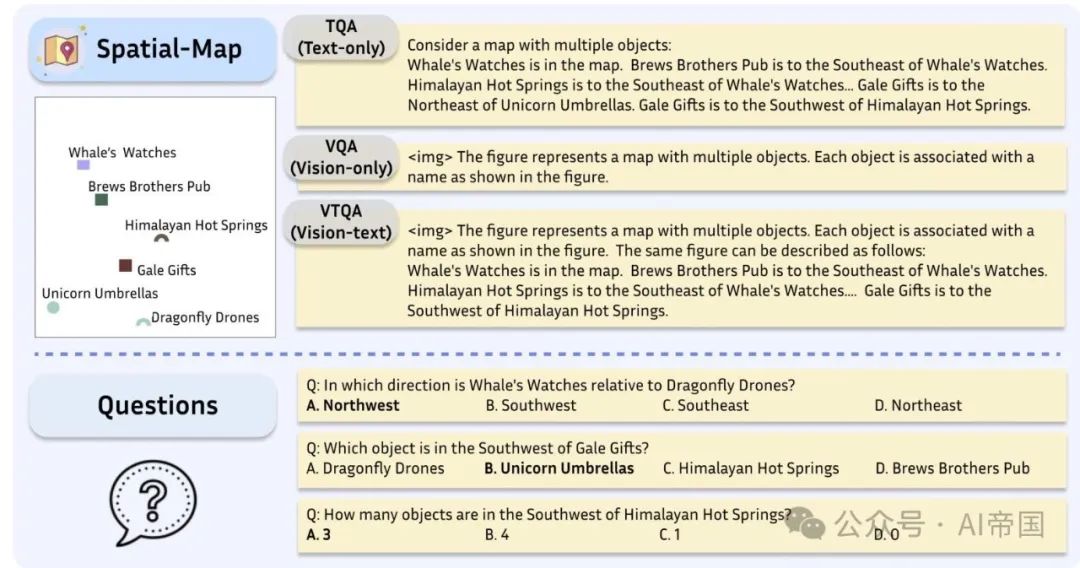

圖2:迷宮導航任務示意圖,評估模型從起點(S)到出口(E)的導航能力。論文考慮三種輸入格式:純文本、純視覺和視覺-文本。論文對語言模型(僅文本輸入)和多模態(tài)語言模型(純視覺和視覺-文本輸入)在同一組問題上進行評估

迷宮導航任務。在復雜空間中的導航能力對智能系統(tǒng)至關重要。為了評估這些能力,論文開發(fā)了一個名為Maze-Nav的迷宮式數(shù)據(jù)集。從視覺上看,每個樣本可以表示為彩色塊,不同顏色代表不同元素:綠色塊標記起點(S),紅色塊表示出口(E),黑色塊代表不可通過的墻壁,白色塊表示可通行的路徑,而藍色塊則描繪從S到E的路徑。目標是沿著藍色路徑從S導航到E,允許在四個基本方向(上、下、左、右)移動。或者,每個輸入可以用ASCII碼以文本格式表示。圖2展示了一個示例,包括純文本、純視覺和視覺-文本輸入。論文基于一個開源庫[24]構建此任務。提出的問題包括計算從S到E的轉彎次數(shù)以及確定S和E之間的空間關系。盡管這些問題對人類來說很容易,論文將在第4節(jié)中展示,它們對現(xiàn)代多模態(tài)語言模型構成了重大挑戰(zhàn)。

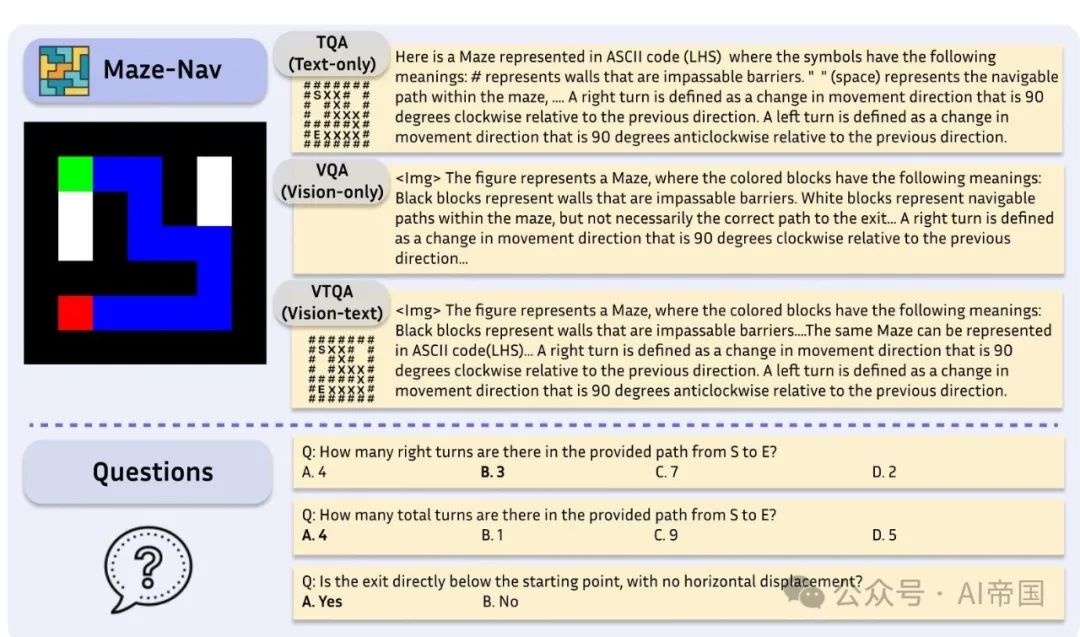

空間網(wǎng)格(Spatial-Grid)。為了研究結構化環(huán)境中的空間理解能力,論文引入了一個名為Spatial-Grid的網(wǎng)格狀數(shù)據(jù)集,與對象任意放置的Spatial-Map形成對比。從視覺上看,每個輸入由一個包含圖像(例如,一只兔子)的單元格網(wǎng)格組成。圖3展示了一個示例。或者,這個網(wǎng)格也可以用純文本格式表示;例如,第一行可以描述為:大象 | 貓 | 長頸鹿 | 大象 貓。評估重點在于任務,如計數(shù)特定對象(例如,兔子)和識別位于網(wǎng)格特定坐標處的對象(例如,第一行,第二列)。

2.2.2 模型

論文考慮了多種規(guī)模不同的競爭性開源語言模型,包括Phi2-2.7B 、LLaMA系列模型(LLaMA-2-7B、LLaMA-2-13B和LLaMA-3-8B)、Mistral-7B 、Vicuna系列(Vicuna-7B-1.5和Vicuna-13B-1.5),以及Nous-Hermes-2-Yi-34B。

對于多模態(tài)語言模型,論文考慮了Bunny系列(Bunny-Phi-2-SigLIP、Bunny-Phi-1.5-SigLlP、Bunny-Phi-2-EVA和Bunny-Phi-1.5-EVA)、CogVLM 、CogAgent 、InstructBLIP系列(InstructBLIP-Vicuna-7B和InstructBLIP-Vicuna-13B),以及LLaVA系列(LLaVA-1.6-Mistral-7B、LLaVA-1.6-Vicuna-7B、LLaVA-1.6-Vicuna-13B和LLaVA-1.6-34B)。論文還評估了專有模型:OpenAI的GPT-4V、GPT-40、GPT-4、Google Gemini Pro 1.0和Anthropic Claude 3 Opus。

圖3:空間網(wǎng)格任務的圖示,該任務評估模型在剛性格子結構中的空間推理能力。論文考慮三種輸入格式:純文本、純視覺和視覺-文本。論文評估僅使用文本輸入的語言模型和使用純視覺及視覺-文本輸入的多模態(tài)語言模型在同一組問題上的表現(xiàn)

評估方法。默認情況下,每個任務中的每個樣本關聯(lián)3個問題(稱為Q1至Q3)。由于每個問題包含四個選項,論文采用準確率作為主要評估指標。每個問題末尾附加相同的用戶提示:首先,用一句話提供簡潔的答案。然后,詳細地逐步解釋你答案背后的推理過程。對于每個模型,論文采用默認配置和解碼策略,例如,確定性解碼使用argmax,非確定性解碼使用top-p。對于非確定性解碼,開源模型的結果在三個獨立運行中取平均值。對于專有模型,由于其可用性有限以及計算時間和成本增加,論文僅進行了一次運行。

2.3 主要結果與分析

空間推理仍然出人意料地具有挑戰(zhàn)性。開源模型在空間地圖、迷宮導航和空間網(wǎng)格任務上的評估結果如圖4所示。對于每個任務,報告的準確率是所有問題的平均值。對于視覺-語言模型,論文選擇純視覺輸入格式,這是視覺問答(VQA)中常用的格式。

論文在每個圖中用一條虛線紅線表示隨機猜測時的預期準確率。論文的發(fā)現(xiàn)揭示了幾個顯著的見解:(1)純視覺輸入:盡管人類處理這些任務很容易,但大多數(shù)競爭性多模態(tài)語言模型的表現(xiàn)僅相當于或略高于隨機猜測。(2)純文本輸入:文本表示包含了必要空間信息。然而,這種輸入格式通常不會增強競爭性語言模型的空間推理能力。在空間網(wǎng)格任務中有一個例外,Llama-3達到了71.9%的準確率,其次是Mistral-7B-Instruct的62.1%,兩者都顯著超過了隨機猜測。盡管取得了這些成功,這些模型的性能仍然遠遠落后于人類水平。這些結果強調了針對空間理解和推理開發(fā)更先進技術的必要性。

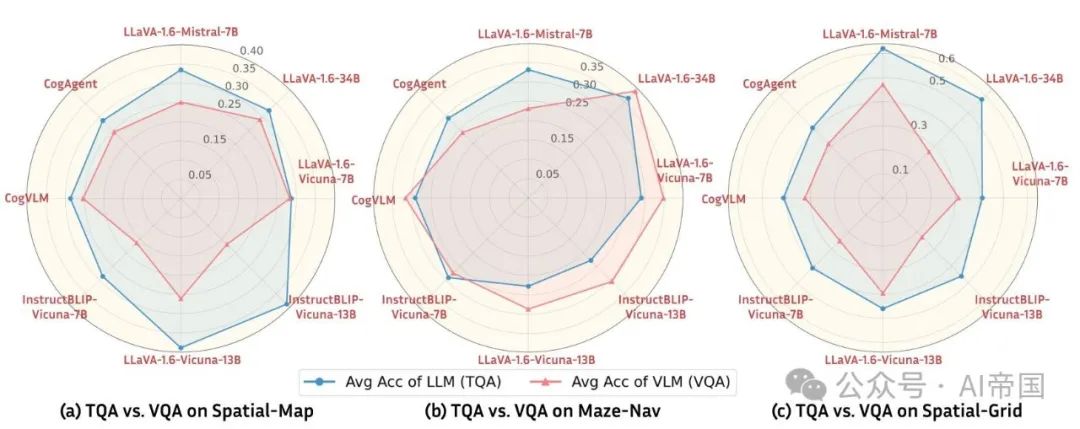

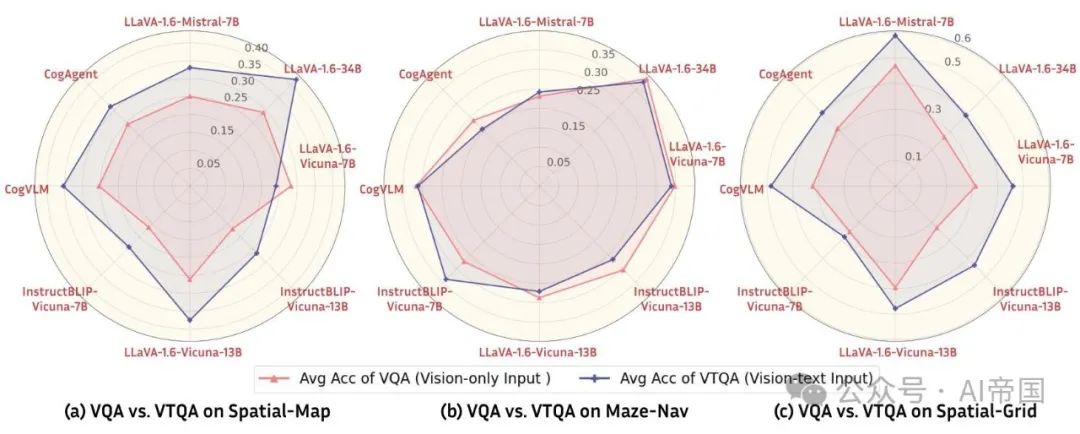

輸入模態(tài)的影響。為了探究模態(tài)的影響,論文比較了具有相同語言骨干的大型語言模型(LLM)和視覺-語言模型(VLM)的性能。論文考慮了視覺-語言模型的VQA(僅視覺)格式。結果如圖5所示。蜘蛛圖上的每個頂點代表一個(VLM, LLM)對的平均準確率。論文觀察到,在Spatial-Map和Spatial-Grid上,盡管VLM具有額外的視覺編碼器,但大多數(shù)VLM的表現(xiàn)相比其對應的LLM較差。例如,在 Spatial-Grid 任務中,Mixtral-7B 達到了 62.19% 的平均準確率,而 LLaVA-v1.6-Mistral-7B 僅達到 47.1%(相差 15%)。

圖4:空間推理任務性能概覽。論文報告了所有問題的平均準確率。對于視覺-語言模型,論文考慮了僅視覺(Vision-only)的VQA格式。虛線紅線表示隨機猜測的預期準確率。在空間地圖(Spatial-Map)和迷宮導航(Maze-Nav)任務中,僅有少數(shù)模型能顯著超越隨機猜測的準確率

圖 5:TQA 與 VQA 在空間推理任務上的比較。蜘蛛圖上的每個頂點代表一個(VLM \mathrm{LLM})對的平均準確率,其中語言骨干相同,即 LLM 與在相應任務上進一步微調的 VLM 的對比。VLM 以紅色表示,LLM 以藍色表示。可以看出,VLM 相對于其 LLM 對應物很少能提升性能

2?.4 深入探究視覺-語言模型的空間推理能力

2.4.1 視而不見:多模態(tài)語言模型的盲點

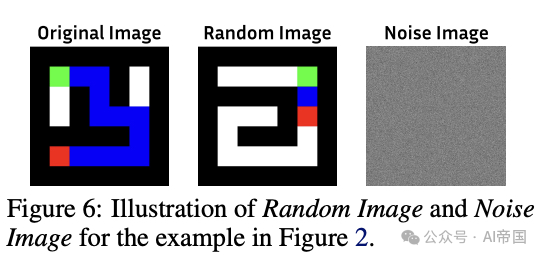

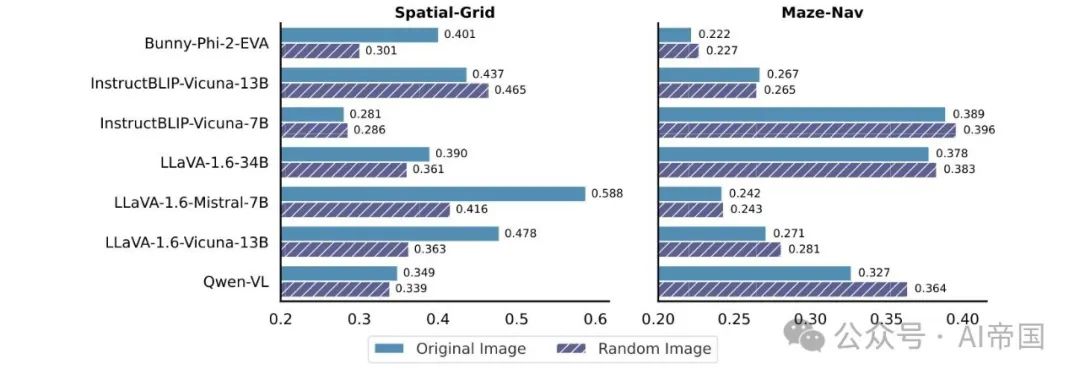

為了更好地理解多模態(tài)語言模型如何處理視覺信息,論文在 VTQA(視覺-文本輸入)設置下進行了一系列控制實驗。對于每個樣本,論文將原始圖像輸入(與文本描述匹配)替換為以下三種之一:(1) 無圖像:僅保留文本輸入,不包含圖像輸入;(2) 噪聲圖像:與任務無關的高斯噪聲圖像;(3) 隨機圖像:從數(shù)據(jù)集中隨機選取的不匹配文本描述的圖像,如圖 6 所示。

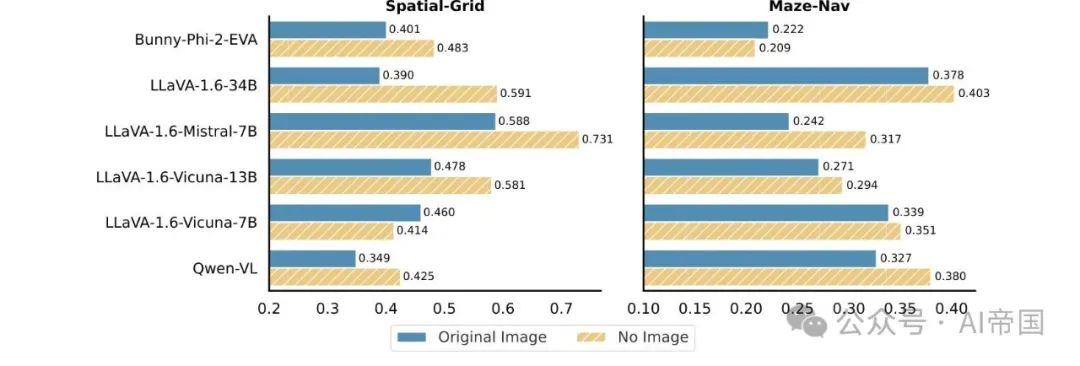

VLMs在視覺輸入缺失時表現(xiàn)出更佳的性能。論文通過完全移除原始圖像并僅依賴文本描述進行了實驗。結果如圖7所示。對于每個任務,論文報告了所有問題的平均準確率。值得注意的是,視覺輸入的缺失導致了一系列VLM架構性能的提升。例如,在無圖像情況下,LLaVA-1.6-34B在Spatial-Grid任務上的表現(xiàn)比有原始圖像時提高了20.1%。這一觀察強調了當僅憑文本信息就能解答問題時,額外的視覺輸入并不一定會增強,甚至可能阻礙性能,這與人類能力形成鮮明對比,因為在人類認知中,視覺線索顯著有助于理解。移除視覺輸入迫使模型利用文本信息來解決空間推理任務。

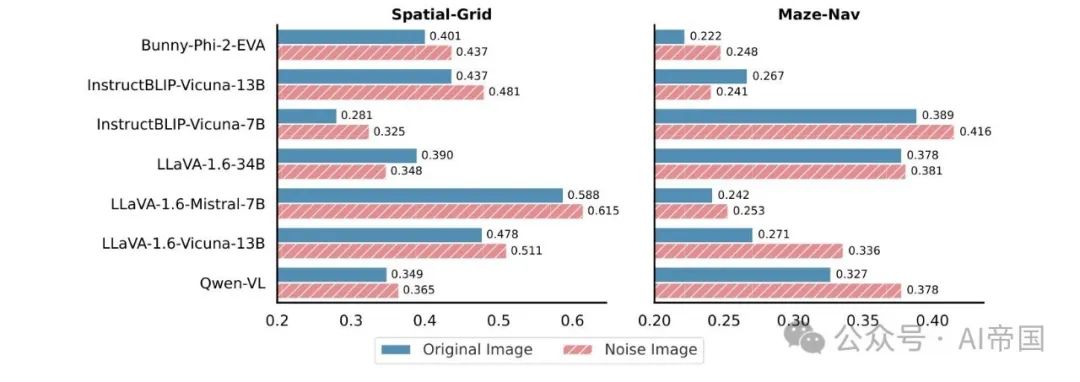

噪聲圖像可以提升性能。論文用噪聲圖像替換原始圖像,同時保留原始文本描述。結果如圖8所示。與原始圖像與無圖像的發(fā)現(xiàn)一致,使用噪聲圖像也在各種VLM架構中提升了性能。例如,在使用噪聲圖像而非原始圖像的情況下,LLaVA-1.6-Vicuna-13B在Maze-Nav任務上的準確率提高了6.5%。與無圖像設置相比,噪聲圖像提供了有限的視覺線索。盡管如此,模型傾向于優(yōu)先處理文本信息,尤其是在視覺線索與任務無關時。

2.4.2 利用多模態(tài)輸入中的冗余

多模態(tài)語言模型在處理多模態(tài)輸入方面展現(xiàn)出極大的靈活性。盡管單獨的視覺輸入通常足以讓人類輕松解決空間推理任務,但論文提出,VLM從視覺數(shù)據(jù)與文本描述的結合中顯著受益,即使這引入了大量冗余。

論文通過比較不同VLM架構下的VQA(僅視覺輸入)和VTQA(視覺文本輸入)來驗證這一假設。結果如圖10所示,蜘蛛圖上的每個頂點代表基于同一VLM的(僅視覺,視覺文本)對的平均準確率。在Spatial-Map和Spatial-Grid任務中,論文可以清楚地看到,與僅使用圖像(VQA)相比,增加文本輸入(VTQA)在不同VLM架構中提升了性能。這表明文本輸入提高了VLM在空間推理方面的準確性。論文進一步在附錄C中比較了TQA和VTQA。詳細結果包含在附錄D中。

圖 7:原始圖像與無圖像在 VTQA 中的對比。當視覺輸入缺失時,視覺語言模型在空間推理任務中表現(xiàn)出性能提升

噪聲圖像的影響。為了建立在先前發(fā)現(xiàn)的基礎上,論文進一步研究了用隨機圖像替換原始圖像的效果(如圖 6 所示)。與噪聲圖像不同,隨機圖像與任務相關,但可能提供沖突的信息。直觀上,人們可能會預期這種隨機圖像會因提供矛盾的線索而導致視覺語言模型性能下降。然而,如圖 9 所示,這種預期并不總是成立。例如,在迷宮導航任務中,隨機圖像導致不同視覺語言模型架構的性能提升。這一結果表明,視覺語言模型并不嚴重依賴視覺信息,尤其是在提供了充分的文本線索時。

圖8:VTQA中的原始圖像與噪聲圖像對比。將原始圖像替換為高斯噪聲圖像可提升多種VLM架構的性能

圖9:VTQA中的原始圖像與隨機圖像對比。在Maze-Nav任務中,將原始圖像替換為隨機圖像會導致不同VLM架構的性能提升

圖10:空間推理任務中VQA與VTQA的比較。蜘蛛圖上的每個頂點代表一個(僅視覺,視覺-文本)對的平均準確率,且使用相同的VLM模型。可以看出,相較于僅使用圖像(VQA),增加文本輸入(VTQA)能提升性能

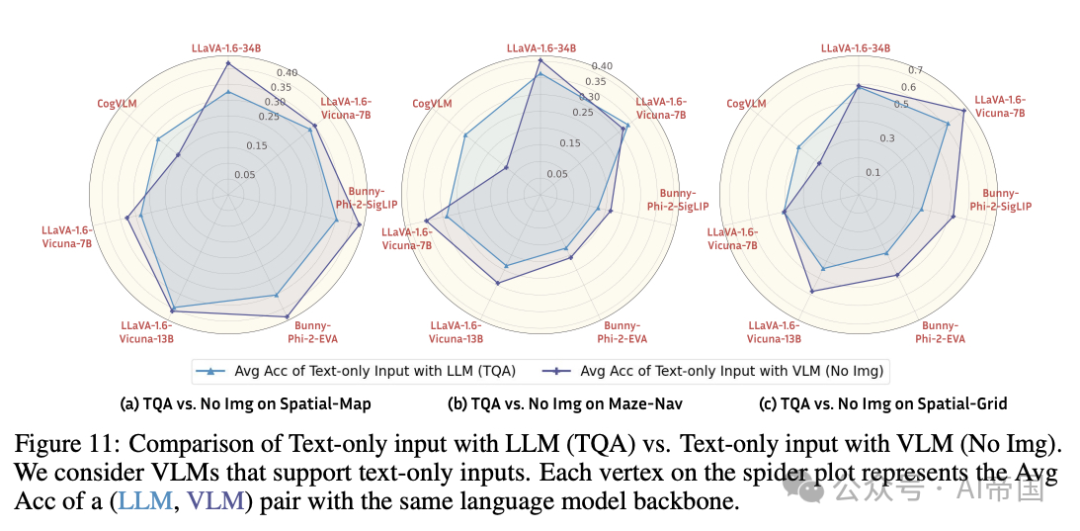

僅文本輸入的LLM與僅文本輸入的VLM對比。鑒于僅文本輸入的有效性,論文進行了一項消融研究,以比較僅使用文本輸入的LLMs和VLMs。論文考慮了那些能夠在沒有伴隨視覺數(shù)據(jù)的情況下處理文本的VLMs。結果如圖11所示。除了CogVLM外,大多數(shù)VLMs的表現(xiàn)優(yōu)于其對應的LLM骨干。這表明,VLMs中的語言模型骨干通過多模態(tài)學習展示了增強的空間推理能力。相反,增加視覺信息并不一定會帶來進一步的好處。

圖11:純文本輸入與LLM(TQA)對比純文本輸入與VLM(無圖像),論文考慮支持純文本輸入的VLMs。蜘蛛圖上的每個頂點代表具有相同語言模型骨干的(LLM, VLM)對的平均準確率(Avg Acc)

圖12:專有模型的結果。與開源模型類似,觀察到相似的趨勢

2.4.3 專有模型 vs. 開源模型

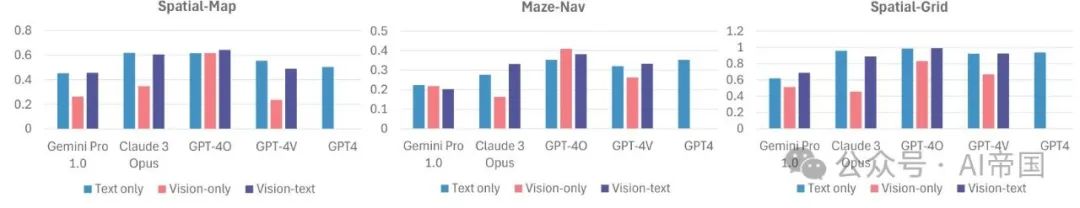

正如許多最近的基準測試所示,專有模型通常優(yōu)于開源模型,因此了解論文觀察到的趨勢是否適用于專有模型至關重要。圖12展示了幾個頂尖專有模型(GPT-4、GPT-4V、GPT-4O、Gemini Pro 1.0和Claude 3 Opus)的性能。

論文有以下顯著觀察:(1)正如預期,SoTA開源模型與專有模型之間存在顯著的性能差距。此外,無論是純文本還是視覺-文本格式,GPT-4V和GPT-4O在所有任務中都顯著優(yōu)于隨機猜測。例如,在視覺-文本格式中,GPT-4O在Spatial-Grid上的準確率達到0.989(表2)。(2)然而,論文觀察到的開源模型的趨勢仍然成立,例如,VQA相對于TQA和VTQA持續(xù)表現(xiàn)不佳,GPT-4V在從僅視覺切換到視覺-文本輸入時,在Spatial-Grid上的性能提升了25.6%;并且在TQA和VTQA之間沒有明顯的勝者(詳見附錄C),這表明即使是新的GPT-4O模型,似乎仍然沒有完全利用視覺輸入。