TAVGBench: 文本生成語音-視頻最新基準

鏈接地址:https://arxiv.org/pdf/2404.14381

代碼鏈接:https://github.com/OpenNLPLab/TAVGBench

文本到可聽視頻生成(TAVG)任務(wù)涉及根據(jù)文本描述生成帶有配套音頻的視頻。要實現(xiàn)這一目標,需要巧妙地對齊音頻和視頻元素。為了支持這一領(lǐng)域的研究,本文開發(fā)了一個全面的文本到可聽視頻生成基準(TAVGBench),其中包含超過170萬個片段,總時長為11800小時。

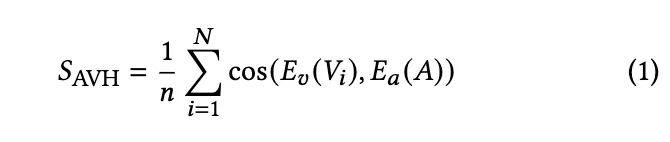

本文提出了一個自動標注pipeline,以確保每個可聽視頻都有關(guān)于其音頻和視頻內(nèi)容的詳細描述。還引入了音頻-視覺和諧分數(shù)(AVHScore),以提供生成的音頻和視頻模態(tài)之間對齊的定量度量。

此外,本文提出了一個名為TAVDiffusion的TAVG基線模型,該模型使用雙流潛在擴散模型為這一領(lǐng)域的進一步研究提供了一個基本起點。通過采用交叉注意力和對比學(xué)習(xí)來實現(xiàn)音頻和視頻的對齊。通過在TAVGBench上進行廣泛的實驗和評估,展示了提出的模型在傳統(tǒng)指標和提出的指標下的有效性。

介紹

文本到視頻生成任務(wù)通過整合計算機視覺和自然語言處理得到了提升。這一任務(wù)將文本描述轉(zhuǎn)化為視覺表現(xiàn)形式,豐富了多媒體體驗,并提高了視覺障礙人士的可訪問性。然而,雖然現(xiàn)有方法在將文本描述轉(zhuǎn)化為視覺內(nèi)容方面表現(xiàn)出色,但將同步音頻整合到這些視頻中的努力仍然大部分未被探索。這一差距突顯了在多模態(tài)生成領(lǐng)域中的一個基本必要性——即通過文本描述單獨引導(dǎo)生成帶有聽覺組件的視頻內(nèi)容。

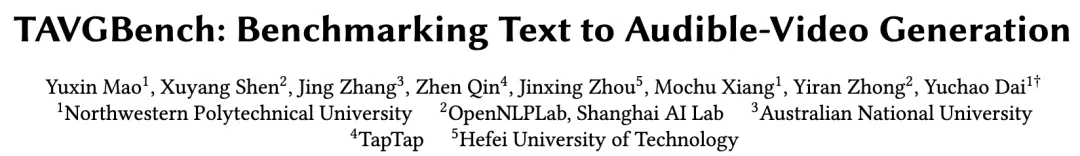

在本文中,考慮到當前研究存在明顯差距,引入了一個新任務(wù):文本到可聽視頻生成(TAVG)。這一任務(wù)標志著一個重大變革,要求模型不僅要生成視覺內(nèi)容,還要同時創(chuàng)建音頻。與典型的文本到視頻任務(wù)只關(guān)注單模態(tài)視頻生成不同,TAVG要求同時生成音頻和視頻,由書面描述引導(dǎo)。通過承擔這一任務(wù),推動多模態(tài)生成的邊界,使得僅使用文本提示就能夠創(chuàng)建沉浸式的視聽體驗成為可能。任務(wù)定義如下圖1所示。

要成功實現(xiàn)TAVG,一個包含良好對齊的音頻和視頻組件的全面數(shù)據(jù)集至關(guān)重要。然而,發(fā)現(xiàn)目前沒有成熟的基準可用于支持訓(xùn)練和測試,主要是因為缺乏這樣一個大規(guī)模的數(shù)據(jù)集。

在TAVG的基礎(chǔ)上提出建立一個文本到可聽視頻生成基準(TAVGBench),允許以監(jiān)督方式訓(xùn)練模型。TAVGBench的核心是一個精心選擇的數(shù)據(jù)集,包括多樣化的文本描述及其對應(yīng)的音頻-視覺對。這個數(shù)據(jù)集有助于全面評估和比較各種方法。數(shù)據(jù)集包含超過170萬個來源于YouTube視頻的音頻-視覺對。

作者設(shè)計了一個粗到細的pipeline來自動實現(xiàn)數(shù)據(jù)集中的音頻-視覺對的文本標注。具體來說,分別利用BLIP2和WavCaps來描述視頻和音頻組件。此外,還利用ChatGPT來重新表述和整合來自兩個模態(tài)的標注,從而使得標注pipeline在理解上下文和生成類似人類的文本描述方面表現(xiàn)出色。為了評估生成的音頻和視頻之間的對齊程度,引入了一個新的度量標準,用于衡量生成結(jié)果的和諧程度,稱為音頻-視覺和諧分數(shù)(AVHScore)。這個度量標準在多模態(tài)、高維語義空間中量化了視頻和音頻之間的對齊程度。

基于本文提出的TAVGBench,提出了一個名為文本到可聽視頻擴散(TAVDiffusion)的基線方法。這個方法基于潛在擴散模型,代表了從文本生成音頻和視頻的初步嘗試。鑒于多模態(tài)對齊的要求,提出了兩種策略來實現(xiàn)來自特征交互和特征約束的多模態(tài)潛在變量的對齊。通過使用傳統(tǒng)指標和本文提出的指標對基線模型進行了廣泛的評估,并展示了本文的方法在TAVG任務(wù)中的有效性。

總的來說,主要貢獻包括:

- 引入了TAVG任務(wù),通過將同步音頻與視覺內(nèi)容整合,擴展了多模態(tài)生成,解決了一個關(guān)鍵的研究空白。

- 提出了TAVGBench,這是一個大規(guī)模基準數(shù)據(jù)集,具有自動文本描述標注pipeline和新穎的音頻-視覺和諧分數(shù)(AVHScore),極大地促進了TAVG任務(wù)。

- 提出了文本到可聽視頻擴散(TAVDiffusion)模型作為基線方法,基于潛在擴散模型構(gòu)建。

相關(guān)工作

文本到視頻生成任務(wù)是一個具有挑戰(zhàn)性且被廣泛研究的任務(wù)。先前的研究利用了各種生成模型,如GANs和自回歸模型。近年來,擴散模型在內(nèi)容生成(即文本到圖像生成)領(lǐng)域的出現(xiàn),催生了文本到視頻生成研究的重大進展。Imagen-Video、Make-A-Video和show-1提出了深層級時空上采樣器的深層級串聯(lián),用于視頻生成,同時在圖像和視頻數(shù)據(jù)集上聯(lián)合訓(xùn)練模型。

隨后大部分工作基于潛在擴散模型,利用預(yù)訓(xùn)練的2D圖像的UNet權(quán)重。VideoLDM采用潛在擴散模型,通過微調(diào)預(yù)訓(xùn)練的潛在圖像生成器和解碼器來確保生成視頻的時間連貫性。LAVIE將旋轉(zhuǎn)位置編碼(RoPE)整合到網(wǎng)絡(luò)中,捕獲視頻幀之間的時間關(guān)系。

AnimateDiff采用一種策略,凍結(jié)預(yù)訓(xùn)練的潛在圖像生成器,同時專門訓(xùn)練新插入的運動建模模塊。SimDA提出了一種高效的時間適配器,幫助訓(xùn)練好的2D擴散模型提取時間信息。這些進展為高效的多模態(tài)擴散pipeline奠定了基礎(chǔ)。

文本到音頻生成任務(wù)類似于視頻生成任務(wù),也是從GANs和自回歸模型到擴散模型的演變。DiffSound提出了一個VQVAE模型和一種基于掩碼的文本生成策略,以解決音頻-文本配對數(shù)據(jù)稀缺的問題,盡管由于缺乏詳細的文本信息可能會限制其性能。AudioGen采用自回歸框架,利用基于Transformer的解碼器直接從波形中生成token。它應(yīng)用數(shù)據(jù)增強,并將語言描述簡化為標簽,犧牲了詳細的時間和空間信息。AudioLDM將潛在擴散模型從視覺生成領(lǐng)域轉(zhuǎn)移到了文本到音頻生成領(lǐng)域。它通過CLAP嵌入來編碼文本信息以實現(xiàn)引導(dǎo)。Tango遵循LDM流程,將CLAP替換為T5以獲得更富表現(xiàn)力的文本embedding。

除了文本引導(dǎo)的內(nèi)容生成之外,近年來,音頻和視頻的相互或聯(lián)合生成逐漸成為研究的焦點。典型地,音頻和視頻模態(tài)作為彼此的條件信號,以實現(xiàn)相互生成,即從視頻生成音頻或從音頻生成視頻。在前者方面,SpecVQGAN、CondFoleyGen和Diff-Foley分別利用VQGAN、自回歸Transformer和擴散模型實現(xiàn)了從視頻生成音頻。關(guān)于后者,soundini利用音頻作為控制信號來指導(dǎo)視頻擴散模型進行視頻編輯。Sung等人利用對比學(xué)習(xí)將從音頻生成的視頻內(nèi)容約束為更接近原始音頻的生成視頻內(nèi)容。TempoTokens引入了一個AudioMapper,它使用由預(yù)訓(xùn)練音頻編碼器編碼的token作為條件,以在擴散框架內(nèi)實現(xiàn)從音頻到視頻的生成。

基于兩種模態(tài)的相互生成,一些研究探索了可聽視頻內(nèi)容的聯(lián)合生成。MM-diffusion采用了一個擴散UNet,同時接收來自兩種模態(tài)的輸入和輸出,首次實現(xiàn)了兩種模態(tài)的聯(lián)合生成。朱等人采用視頻擴散架構(gòu)生成視頻,然后檢索音頻,提出了一種替代的聯(lián)合生成方法。興等人提出在推理過程中通過優(yōu)化操作來增強現(xiàn)有擴散模型,以實現(xiàn)音頻視頻的生成并保持對齊。

我們基準的獨特之處在于,盡管對多模態(tài)生成任務(wù)進行了廣泛探索,但目前還缺乏專門用于文本到可聽視頻生成任務(wù)的綜合基準和大規(guī)模數(shù)據(jù)集。針對這一差距,我們的解決方案提供了用于訓(xùn)練和評估的數(shù)據(jù)集,以及用于評估多模態(tài)對齊的指標。此外,我們還提供了一個簡單的基線方法。

TAVGBENCH

數(shù)據(jù)集統(tǒng)計

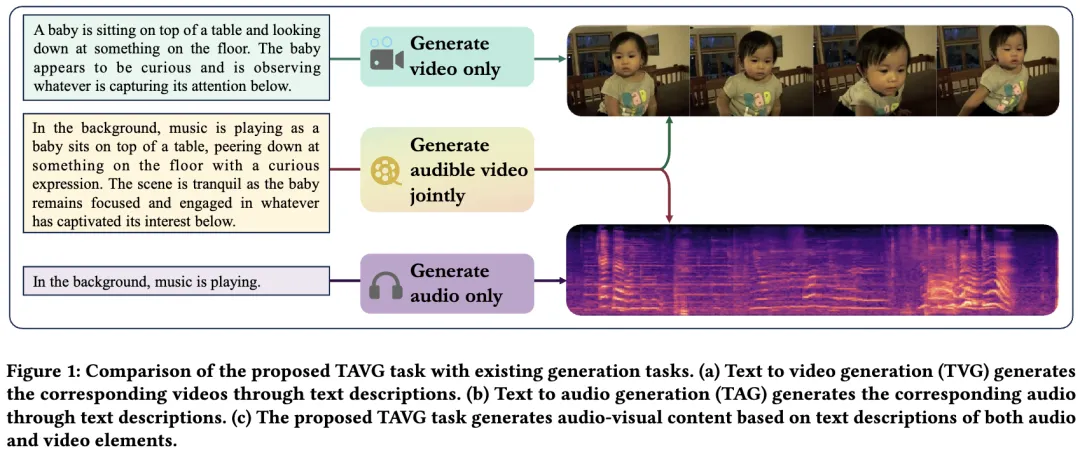

TAVG任務(wù)涉及根據(jù)輸入文本提示生成可聽視頻。為了支持這一任務(wù),我們引入了一個名為TAVGBench的基準。我們的數(shù)據(jù)集來自AudioSet,包括來自YouTube的200萬對齊的音頻-視頻對。在排除無效視頻后,我們獲得了170萬條原始數(shù)據(jù)。每個視頻樣本的持續(xù)時間為10秒,貢獻了數(shù)據(jù)集中總共11800小時的視頻時長。為了全面了解我們數(shù)據(jù)集的規(guī)模和特征,我們將其與其他相關(guān)任務(wù)的數(shù)據(jù)集進行了比較。表1對TAVGBench與這些數(shù)據(jù)集進行了大小、來源和其他相關(guān)屬性的比較分析。

從下表1中可以看出,AudioCaps、MSR-VTT和WebVid只描述了單模態(tài)的內(nèi)容(僅音頻或視頻模態(tài))。雖然FAVDBench描述了兩種模態(tài),但數(shù)據(jù)集的規(guī)模有限。我們提出的TAVGBench考慮了音頻和視頻兩種模態(tài)的描述,同時確保了足夠大的數(shù)據(jù)集規(guī)模。此外,WebVid中的視頻帶有水印,這在實際場景中大大限制了它們的應(yīng)用。這種比較突顯了TAVGBench數(shù)據(jù)集的規(guī)模和獨特特性,強調(diào)了它在推動可聽視頻生成研究方面的潛力。此外,TAVGBench表現(xiàn)出文本描述的平衡分布,每個視頻標注平均有2.32個句子和49.98個單詞,為每個片段提供了豐富的上下文信息。這些比較統(tǒng)計突顯了TAVGBench數(shù)據(jù)集的廣泛規(guī)模、多模態(tài)特性和語言豐富性,使其成為推動我們TAVG任務(wù)研究的寶貴資源。

標注細節(jié)

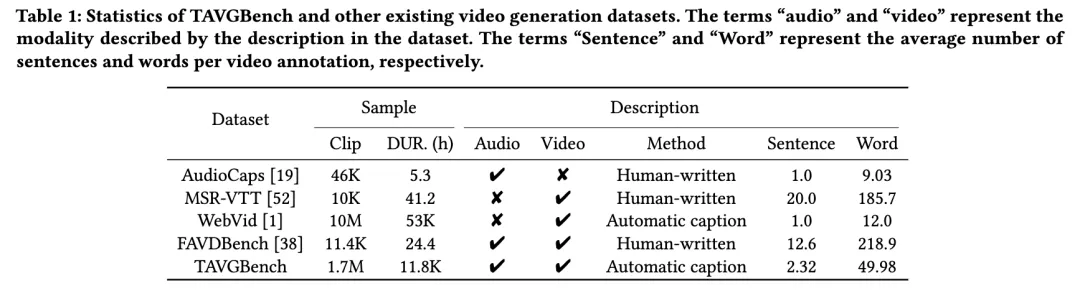

鑒于AudioSet對其視頻和音頻內(nèi)容均缺乏詳細的文本標注,我們實施了一個由粗到細的pipeline來自動生成文本描述。完整的pipeline如下圖2所示。首先,我們分別使用兩種先進的方法,即BLIP2用于視頻描述和WavCaps用于音頻描述,對視頻和音頻組件進行標注。

然而,盡管這些方法在捕捉視頻和音頻內(nèi)容的精髓方面很有效,但生成的標注通常缺乏連貫性和上下文。為了解決這一限制并提高標注的整體質(zhì)量,我們引入了一個通過ChatGPT進行精煉的步驟,ChatGPT是一個功能強大的語言模型,能夠重新表述和豐富文本輸入。

在精煉階段,利用ChatGPT重新表述和增強BLIP2和WavCaps生成的標注。通過將初始標注輸入ChatGPT模型,我們獲得了修訂后的標注,這些標注具有增強的連貫性、上下文相關(guān)性和語言精煉度。最初,我們分別重新表述視頻和音頻描述,以糾正語法錯誤并增強描述性內(nèi)容。隨后,我們利用ChatGPT將兩種模態(tài)的描述合并成一個統(tǒng)一、連貫的句子。這個迭代過程不僅增強了標注的可讀性,還確保了整個標注語料庫的一致性和準確性。

將ChatGPT納入我們的pipeline顯著增強了檢測視頻和音頻內(nèi)容中微妙細微之處和語義復(fù)雜性的能力。因此,我們的標注pipeline在理解上下文和生成類似人類的文本描述方面表現(xiàn)出色,從而促進了更精確地捕捉底層內(nèi)容精髓的標注的創(chuàng)建。

評估指標

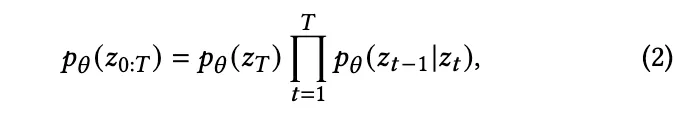

現(xiàn)有的視頻(FVD、KVD)和音頻(FAD)生成的指標主要側(cè)重于分別評估每種模態(tài)的質(zhì)量。然而,對于TAVG任務(wù),我們不僅需要生成高質(zhì)量的音頻和視頻,還需要確保這兩種模態(tài)的準確同步。為了解決評估生成的音頻和視頻之間的對齊程度的必要性,我們提出了一種稱為音頻-視覺和諧分數(shù)(AVHScore)的新指標。該指標通過計算提取的音頻-視頻特征的乘積來量化音頻-視頻對的對齊程度。我們使用了一個強大的特征提取器(ImageBind)將視頻幀和音頻投影到一個統(tǒng)一的特征空間中。形式上,我們定義AVHScore ??AVH 如下:

其中,cos表示余弦相似度。Ev和Ea 分別代表ImageBind模型中的視覺編碼器和音頻編碼器。?? 表示視頻幀的數(shù)量,我們計算每個視頻幀與相應(yīng)音頻輸入之間的相似度,并對所有幀的結(jié)果進行平均。

一個基準方法

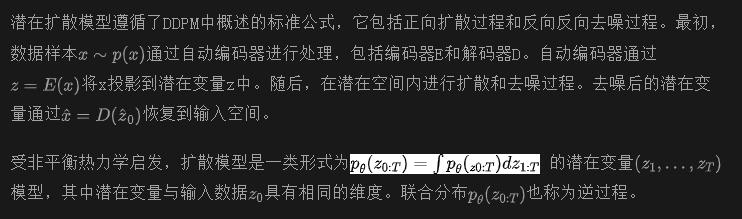

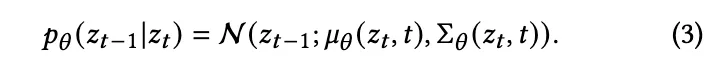

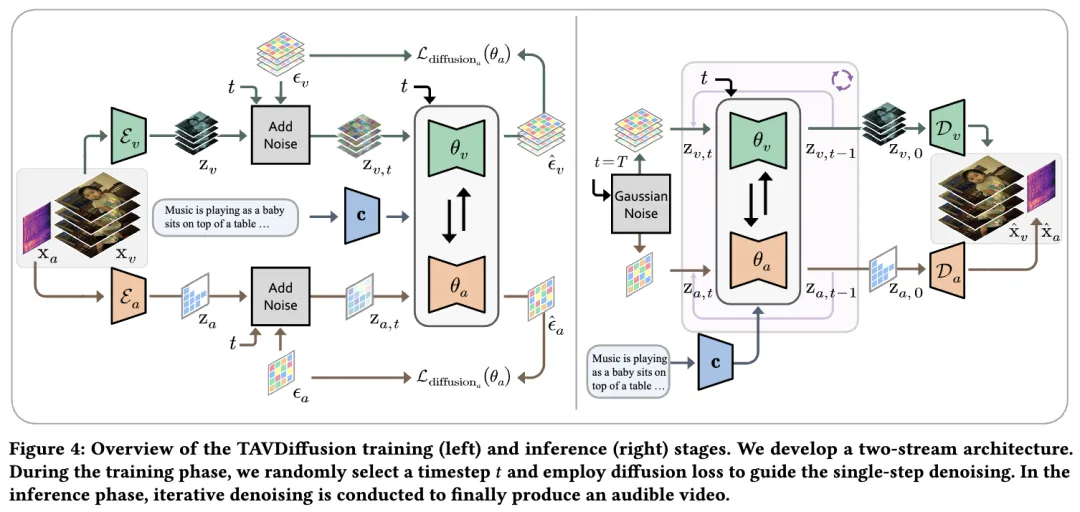

我們提出了一種新的文本到可聽視頻生成(TAVG)任務(wù)的基準方法,如圖4所示,名為TAVDiffusion。整個網(wǎng)絡(luò)結(jié)構(gòu)基于潛在擴散模型。

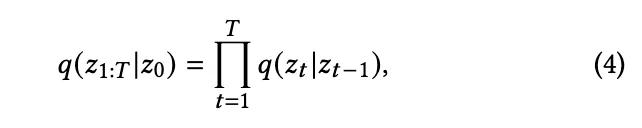

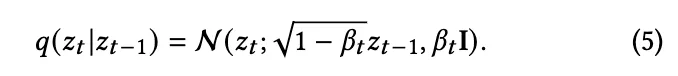

初步:潛在擴散模型

當

這里

訓(xùn)練通過最小化對負對數(shù)似然的變分界限來進行。

因此,?? 的最終訓(xùn)練目標是一個噪聲估計損失,帶有條件變量 c,可以表述為:

TAVDiffusion

根據(jù)前面定義的潛在擴散模型的正向和反向過程,進一步提出了基準的雙流擴散pipeline,用于聯(lián)合文本到可聽視頻的擴散。

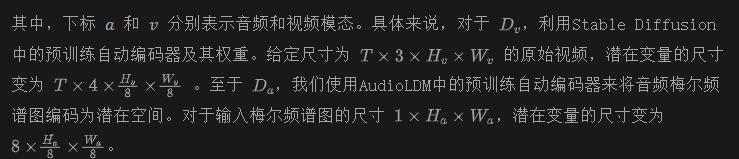

多模態(tài)潛在編碼器。使用兩個獨立的潛在自動編碼器來處理我們的多模態(tài)輸入,進行潛在空間的編碼和解碼。這個過程可以表述為:

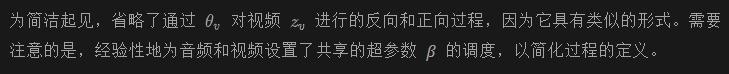

多模態(tài)擴散過程。對于音頻和視頻模態(tài)的輸入,我們使用兩個流結(jié)構(gòu)來對潛在變量Za和Zv執(zhí)行正向和反向擴散過程,如下圖4所示。與普通的擴散不同,普通擴散是生成單一模態(tài),我們的目標是在單一擴散過程中同時恢復(fù)兩種一致的模態(tài)(即音頻和視頻)。

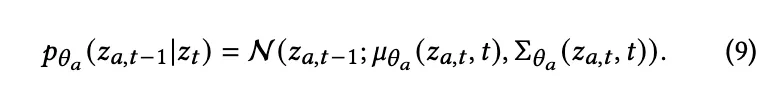

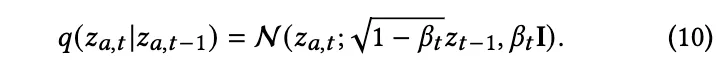

我們認為每種模態(tài)的反向和正向過程是獨立的,因為它們具有不同的分布。以音頻潛在變量 為例,其在時間步 ?? 的反向過程定義為:

時間步 ?? 的正向過程定義如下:

總結(jié)上述公式,多模態(tài)擴散損失的最終定義是:

任務(wù)中,條件變量 c 表示輸入的文本embeddings,使用CLIP文本編碼器及其分詞器來獲取文本嵌入。

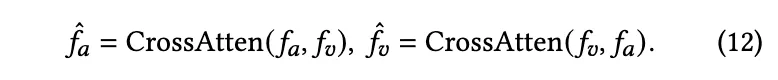

多模態(tài)交互

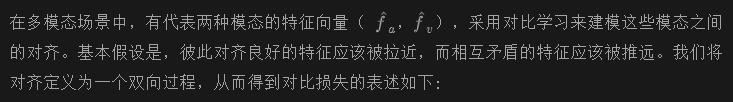

多模態(tài)對齊

特征交互機制并沒有顯式地強制執(zhí)行多模態(tài)特征的對齊。因此,集成一個能夠保證音頻和視覺模態(tài)特征表示對齊的損失函數(shù)至關(guān)重要。為了解決這個問題,我們提出了一種基于對比學(xué)習(xí)的顯式音頻-視覺對齊策略(EAS)。

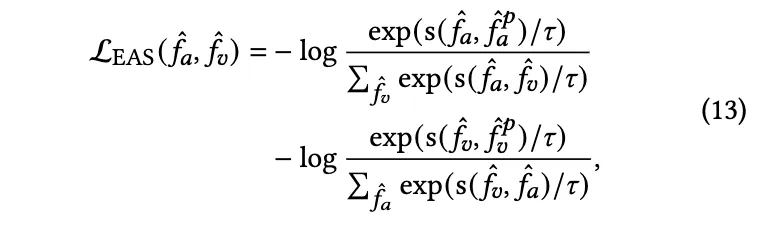

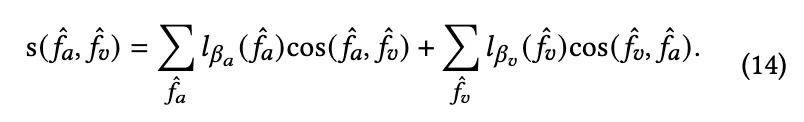

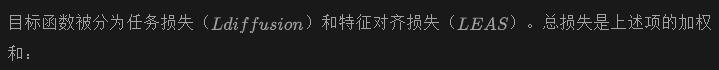

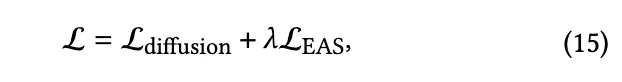

對比學(xué)習(xí)的瓶頸在于設(shè)計具有有效相似度度量的正/負樣本對,即我們情況下的 s(·,·)。使用具有 softmax 激活的線性投影 ???? (·) 來根據(jù)特定模態(tài)的輸入計算相似度權(quán)重,不同信息包含在不同的tokens中。給定兩種模態(tài) (??,??),加權(quán)相似度函數(shù) s(·,·) 為:

目標函數(shù)

其中,?? 表示訓(xùn)練過程中的平衡權(quán)重。根據(jù)經(jīng)驗,損失權(quán)重被設(shè)置為 ?? =0.1。

實驗結(jié)果

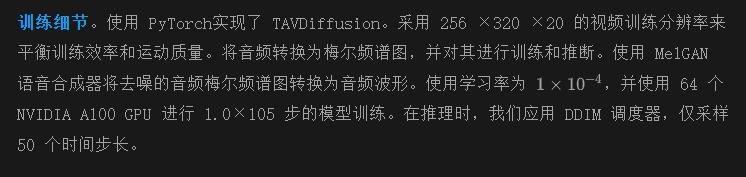

實現(xiàn)細節(jié)

數(shù)據(jù)集。在TAVGBench 數(shù)據(jù)集上訓(xùn)練模型。在評估階段,我們從 TAVGBench 的評估子集中選擇了 3,000 個樣本。此外,還評估了我們模型在 FAVDBench的測試子集上的性能,該子集包含 1,000 個樣本。FAVDBench 提供了更細粒度的可聽視頻描述,能夠生成更詳細的視頻。重要的是,由于 FAVDBench 的數(shù)據(jù)在訓(xùn)練階段未被使用,我們可以根據(jù)模型在 FAVDBench 上的性能評估其零樣本能力。

評估指標。 首先分別測量生成的音頻和視頻的質(zhì)量。為了評估視頻,采用 Frechet Video Distance (FVD)、Kernel Video Distance (KVD)和 CLIPSIM指標。FVD 和 KVD 使用在 Kinetics-400 數(shù)據(jù)集上預(yù)訓(xùn)練的 I3D分類器。對于音頻評估,采用 FAD 來衡量生成音頻與參考音頻之間的距離。還使用我們提出的 AVHScore 來衡量生成結(jié)果的對齊程度。對于所有評估,我們?yōu)槊總€文本生成一個隨機樣本,沒有任何自動排序。

主要結(jié)果

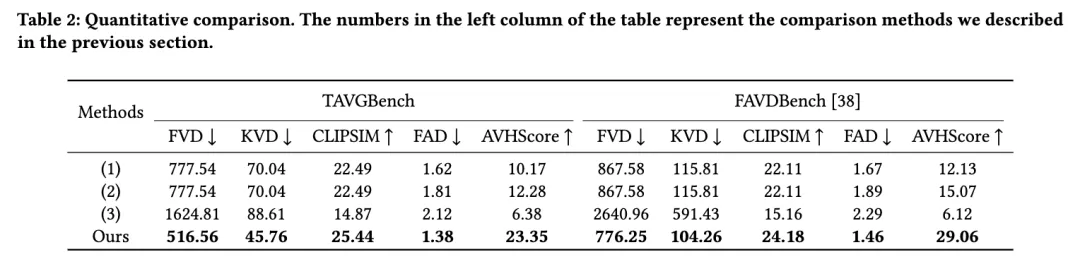

比較方法設(shè)置。據(jù)我們所知,目前沒有現(xiàn)有的可用方法直接與我們提出的任務(wù)相關(guān),供比較。因此,我們結(jié)合現(xiàn)有的相關(guān)模型,設(shè)計了兩階段方法進行比較。

- (1) AnimateDiff + AudioLDM: 輸入文本,并利用這兩個模型分別生成音頻和視頻。

- (2) AnimateDiff + Diff-Foley: 輸入文本,使用 AnimateDiff 生成視頻,然后利用 Diff-Foley 根據(jù)視頻生成音頻。

- (3) AudioLDM + TempoToken: 輸入文本,使用 AudioLDM 生成音頻,然后利用 TempoToken 根據(jù)音頻生成視頻。

?

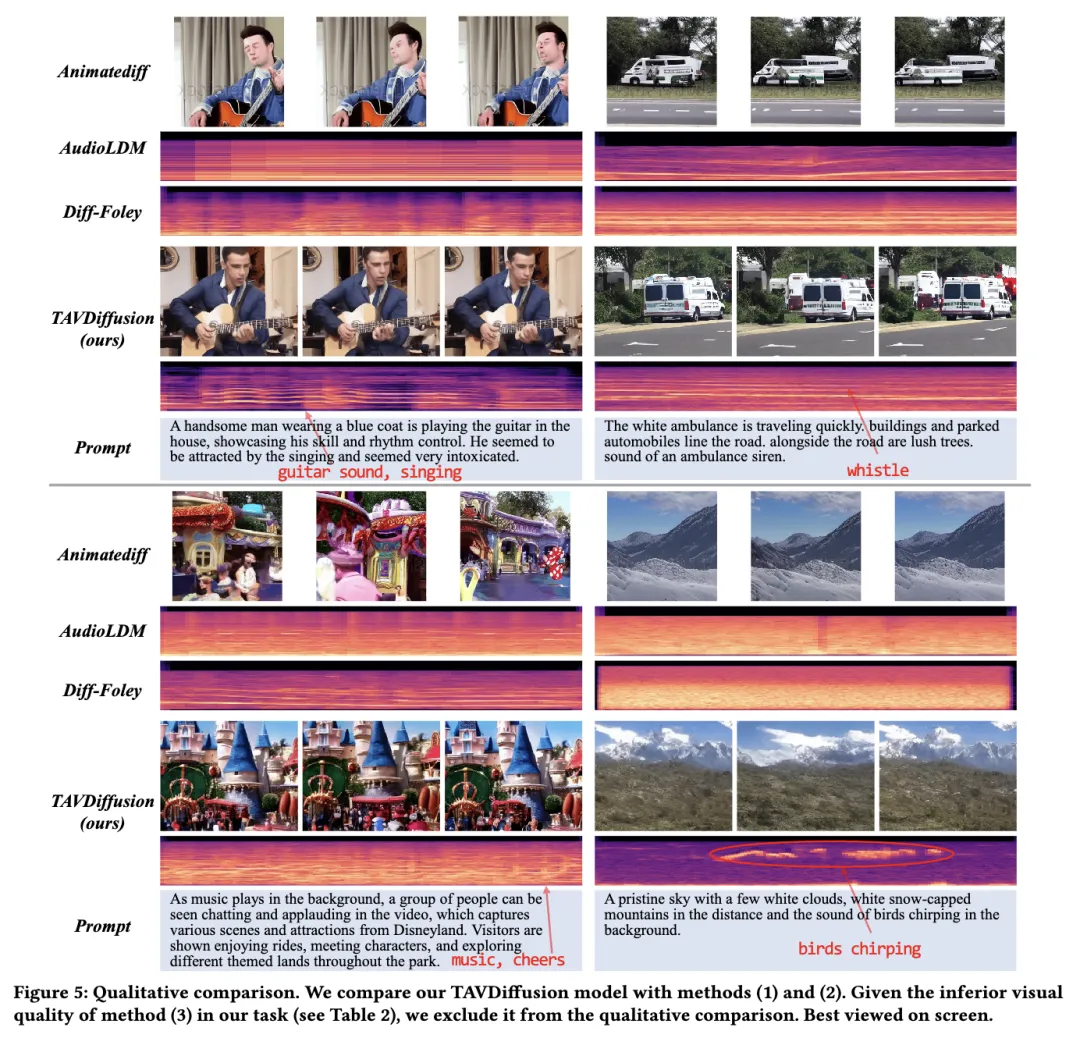

定量比較。在下表 2 中將本文的方法與 TAVGBench 和 FAVDBench 數(shù)據(jù)集的比較方法進行了定量結(jié)果展示。結(jié)果表明,TAVDiffusion 模型在視頻和音頻質(zhì)量指標方面優(yōu)于所有比較方法。具體來說,F(xiàn)VD 和 KVD 的得分分別為 776.25 和 65.53,而 FAD 的得分為 1.46。這表明我們生成的可聽視頻與原始內(nèi)容之間存在顯著的一致性,質(zhì)量更高。這些結(jié)果突出顯示了我們的模型生成的視頻與原始內(nèi)容之間的顯著一致性,表明了其優(yōu)越的質(zhì)量。此外,我們的模型達到了顯著的 CLIPSIM 分數(shù) (24.18),加強了生成視頻與相關(guān)提示之間的語義連貫性。值得注意的是,我們的模型和比較模型在訓(xùn)練階段都沒有接觸過 FAVDBench 數(shù)據(jù),因此在該數(shù)據(jù)集上的結(jié)果進一步強調(diào)了我們的零樣本能力。

定性比較。在下圖 5 中,展示了本文的方法與其他生成器的定性結(jié)果比較。該圖表明,在視覺保真度和文本、視頻和音頻的對齊方面,TAVDiffusion 優(yōu)于比較模型。在第一個示例中,TAVDiffusion 生成的“表演者”顯示出顯著增強的逼真度,特別是在面部表情和手部動作方面。生成的音頻也遵循提示中的“吉他聲”和“歌聲”兩個元素。

在第二個示例中,TAVDiffusion 展示了其產(chǎn)生復(fù)雜真實場景的能力,保持了關(guān)鍵對象的精確形狀。它巧妙地處理了前景對象(如汽車)與背景場景之間的動態(tài),輔以逼真的音頻。還展示了我們模型在兩種不同場景下的性能:存在顯著背景噪聲和顯著較安靜的環(huán)境。對于前者,我們的模型根據(jù)提示生成各種類型的音頻,如音樂和人類歡呼聲。對于后者,我們的模型獨特而準確地產(chǎn)生了“鳥叫聲”。這種比較顯示了該模型的多功能性,展示了其在廣泛的音頻-視頻場景中的有效性。通過在這些對比設(shè)置中評估模型,我們突出了其在處理多樣化的聽覺和視覺輸入方面的普遍適用性和穩(wěn)健性。誠摯地希望讀者在補充材料中找到更多的可聽視頻示例。

消融研究

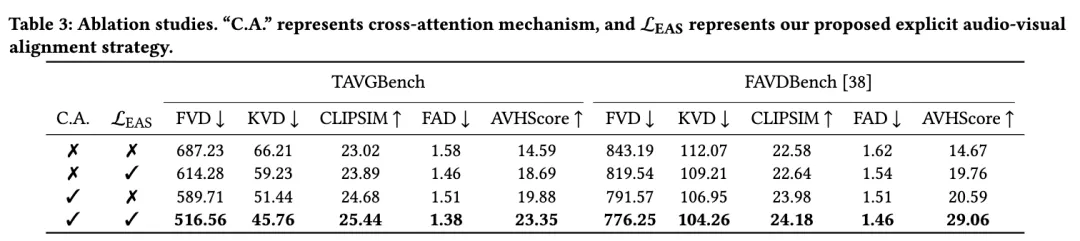

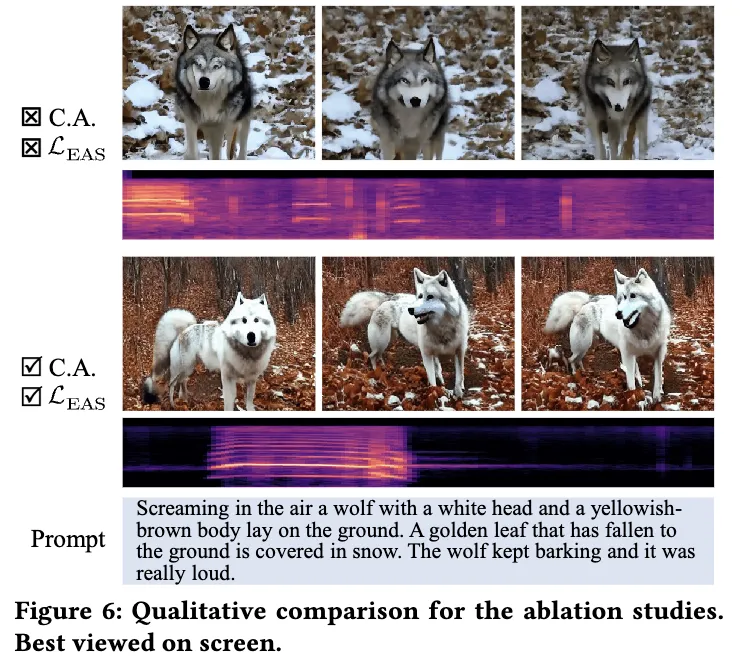

為了展示我們提出的模塊的有效性,進行了消融研究,從定量指標(見下表 3)和定性可視化(見下圖 6)兩個方面進行。從表 3 中可以看出,我們提出的兩種策略,即多模態(tài)交叉注意力和多模態(tài)對齊,提高了視頻和音頻生成的質(zhì)量以及對齊分數(shù)。在圖6中,可以觀察到,我們最終模型產(chǎn)生的“狼”比其他比較更加逼真,其口部動作準確地反映了“不停吠叫”的提示和生成的音頻。請參閱補充材料獲取更多示例。

潛在應(yīng)用

TAVGBench 數(shù)據(jù)集和基準模型 TAVDiffusion 在多媒體應(yīng)用領(lǐng)域具有廣泛的潛力。數(shù)據(jù)集包含大量的視頻、音頻和相應(yīng)的文本描述,非常適合各種多模態(tài)任務(wù)。它允許同時使用文本和音頻作為提示來生成視頻。此外,TAVGBench 還可以用于訓(xùn)練可聽視頻字幕模型,顯著降低了數(shù)據(jù)不足的音頻-視頻-文本數(shù)據(jù)對模型訓(xùn)練的影響,正如 [38] 中所提到的。

結(jié)論

本文探索了根據(jù)文本描述創(chuàng)建具有匹配音頻的視頻的挑戰(zhàn),這一任務(wù)被稱為文本到可聽視頻生成(TAVG)。為了幫助這項研究,引入了一個名為 TAVGBench 的新基準,其中包含超過 170 萬個視頻剪輯。這個資源旨在幫助改進和評估 TAVG 模型。開發(fā)了一種方法,自動描述每個音頻-視覺元素,確保為研究人員提供詳細且有用的標注。設(shè)計了一個新的度量標準,稱為音頻-視覺和諧分數(shù)(AVH-Score),用于評估生成的可聽視頻的對齊情況。引入了 TAVDiffusion,這是一個利用潛在擴散的基線模型。該模型結(jié)合了交叉注意力和對比學(xué)習(xí)機制,在擴散 UNet 框架內(nèi)實現(xiàn)了音頻-視頻對齊。廣泛的實驗結(jié)果驗證了提出的框架的有效性,為多媒體內(nèi)容創(chuàng)作開辟了新的途徑。在未來,我們的目標是探索一種多模態(tài)擴散Transformer,通過統(tǒng)一的架構(gòu)促進可聽視頻的生成。

本文轉(zhuǎn)自 AI生成未來 ,作者:Yuxin Mao等