手把手教你將本地部署的DeepSeek R1集成到Dify

今天,手把手教大家在本地部署DeepSeek R1,并將其集成到Dify中,實打實提升你的工作效率!

一、本地部署模型

本部分介紹在本地通過ollama部署DeepSeek R1。

1、安裝ollama

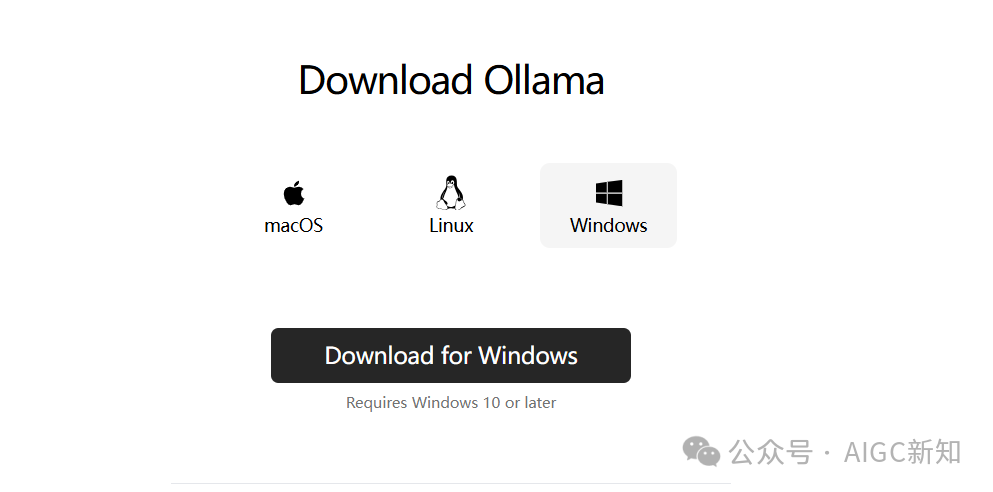

在ollama官網,選擇操作系統,下載ollama應用程序并安裝

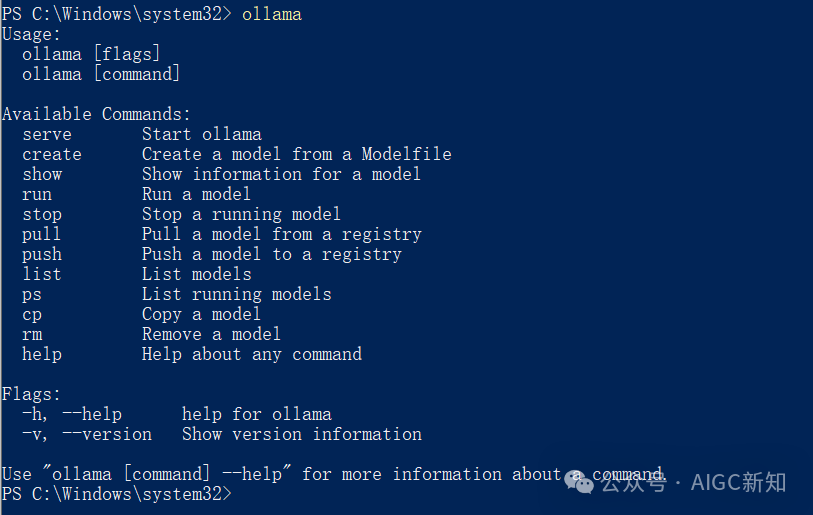

命令行輸入ollama,出現下面的提示,則說明安裝成功。

2、部署deepseek模型

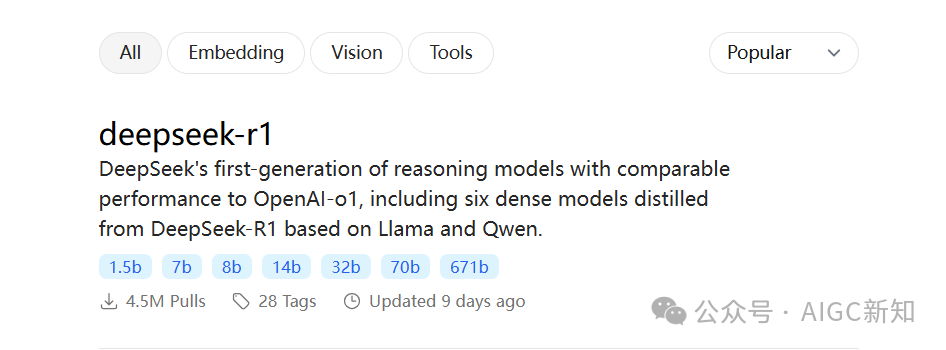

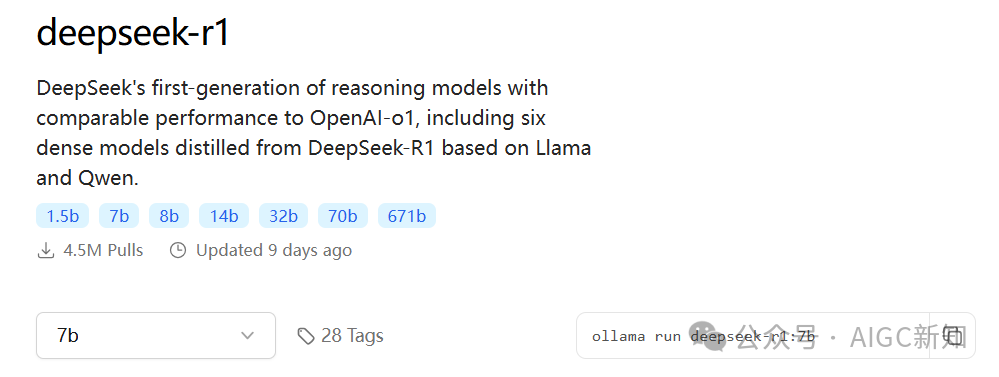

在ollama官網,點擊「Models」,選擇第一個「DeepSeek R1」

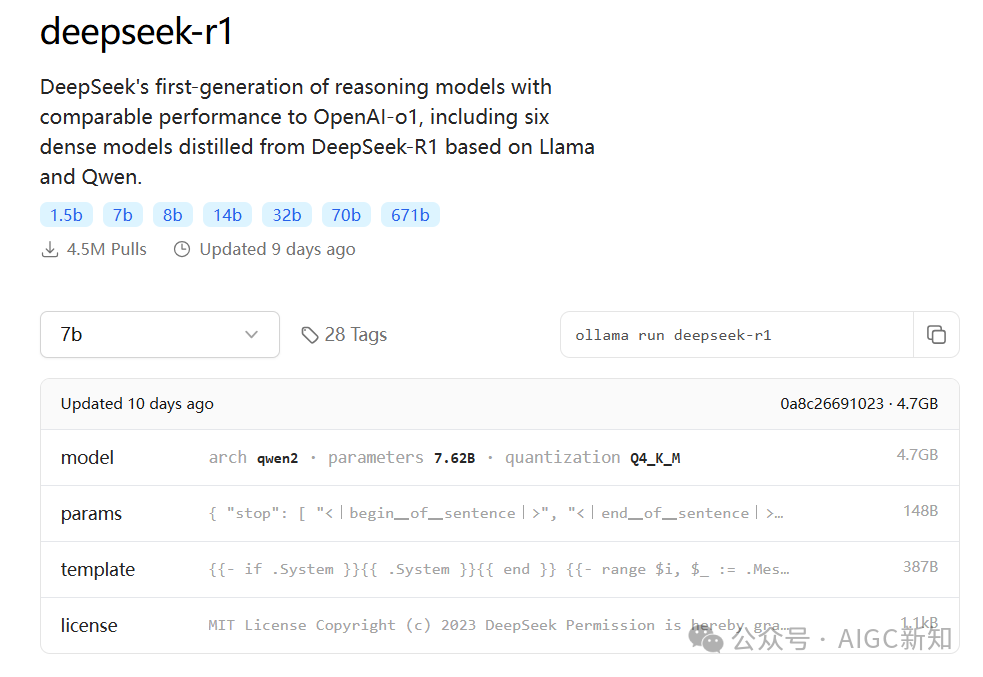

根據自己的顯存選擇對應的版本大小。

模型名稱 | 參數規模(b) | 顯存需求(FP16,GB) | 顯存需求(4位量化,GB) |

7b模型 | 7 | 16 | 4 |

16b模型 | 16 | 37 | 9 |

67b模型 | 67 | 154 | 38 |

236b模型 | 236 | 543 | 136 |

671b模型 | 671 | 1543 | 386 |

推薦GPU:

- 7B和16B之類的較小型號,消費者GPU(例如NVIDIA RTX 4090)是合適的。

- 較大的模型,超過1000億個參數的模型,通常需要數據中心GPU,例如NVIDIA H100或分布式設置中的多個高端消費者GPU。

如何查看自己電腦顯存呢?

在windows10電腦上,右鍵點擊左下方的Win10圖標,彈出下拉菜單,選擇【運行】選項并點擊進入運行對話窗口,在運行對話窗口內輸入dxdiag命令【主要查看N卡】。

計算:電腦顯存==>16112MB / 1024MB約等于16GB,選擇最小7B參數的模型。

點擊7b,然后在右側會出現下載命令:

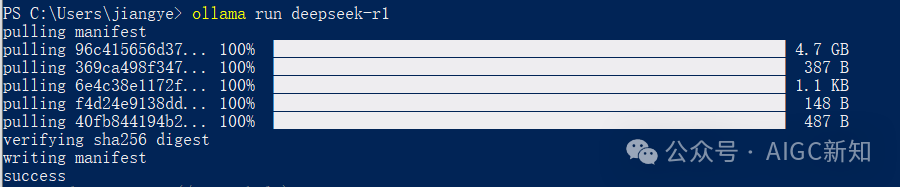

將下載命令復制,到命令行中執行:

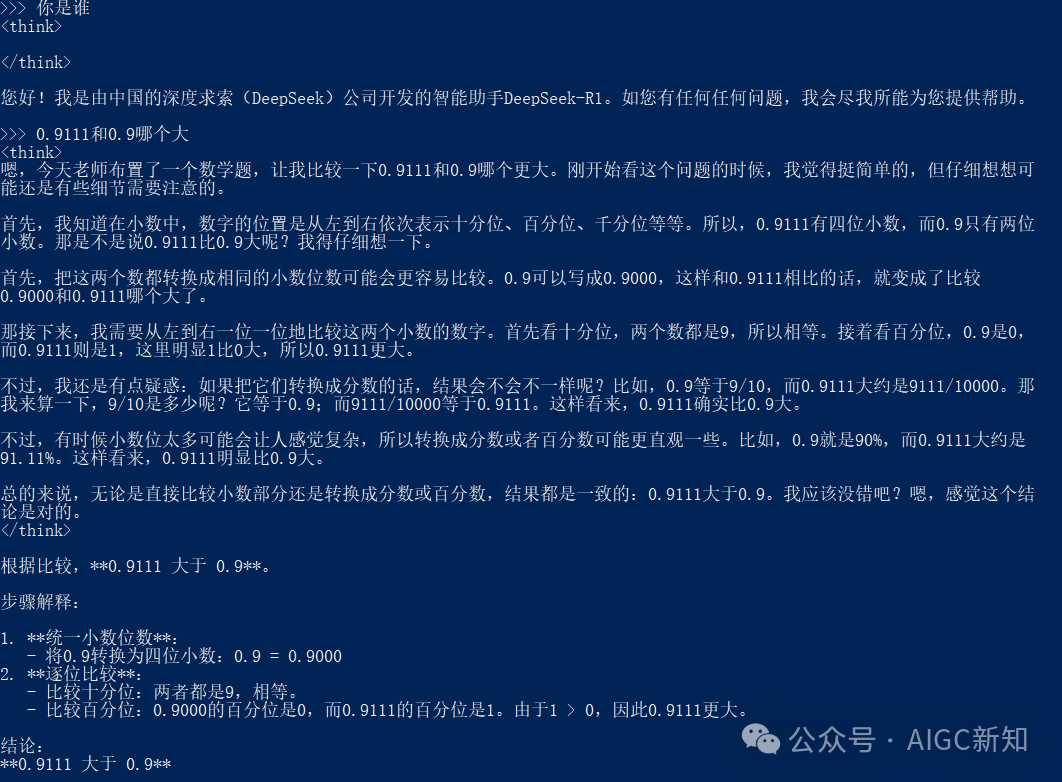

下載之后,就可以通過命令行和大模型進行對話了:

通過命令行和大模型進行對話不太方便,接下來,介紹一下將其集成到Dify中,通過可視化的方式調用。

二、Dify中配置DeepSeek R1

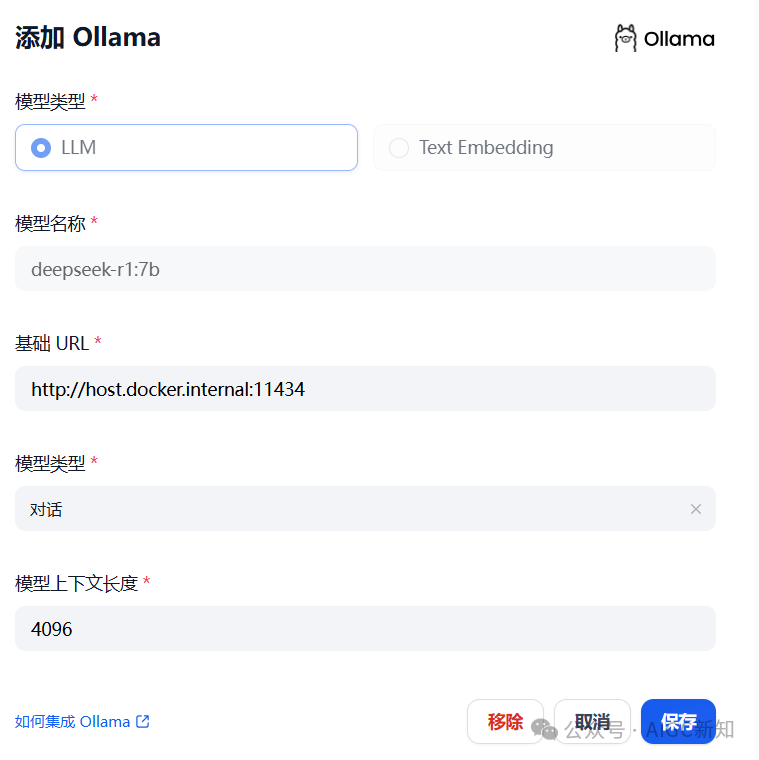

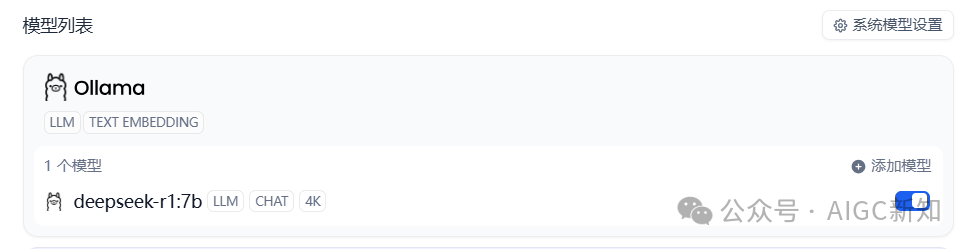

登錄到已經部署好的Dify中,點擊設置,在「模型供應商」選擇「ollama」

「模型名稱」填:deepseek-r1:7b。

「基礎URL中」,若ollama和Dify是同一臺機器部署,并且Dify是通過Docker部署,那么填http://host.docker.internal:11434,

其他情況填http://localhost:11434,填完之后點擊保存即可。

三、創建應用

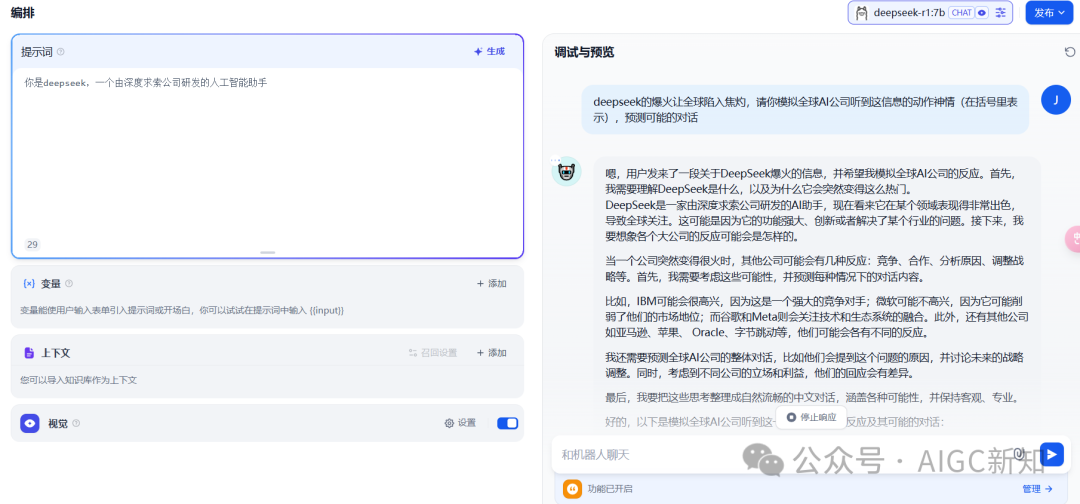

在Dify中創建一個應用來使用DeepSeek R1模型。

創建一個「聊天助手」,填寫「應用名稱」和「描述」,點擊創建:

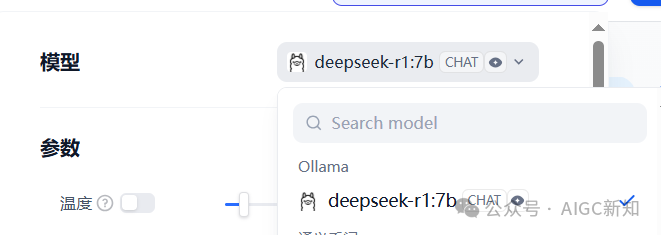

選擇添加好的DeepSeek R1模型:

需要注意的是,DeepSeek R1是一個推理模型,不支持函數調用,也就是說無法集成在DIfy的智能體中,但是DeepSeek V3可以。

沒有聯網的deepseek-r1存在嚴重的幻覺。

本文轉載自 ??AIGC新知??,作者: 絳燁