不到140塊!李飛飛團隊超低成本復刻DeepSeek R1推理!16張H100只訓練了26分鐘,與R1訓練方法不同! 原創

編輯 | 伊風

出品 | 51CTO技術棧(微信號:blog51cto)

太魔鬼了!上周李飛飛團隊發了篇新論文,再次降低了復刻o1能力的成本。

低到什么程度呢?論文里說,在現成的預訓練模型(用的是阿里系開源的Qwen2.5- 32B-Instruct)進行監督微調(SFT),使用構建的小規模數據集,僅耗時26分鐘,就在16張 H100 GPU上完成訓練。

據研究人員介紹,這樣的算力租賃成本大約在20美元左右!

圖片

圖片

這么省時省錢的模型,居然和o1預覽版性能掰手腕:實驗結果顯示,在數學競賽類問題上,s1-32B的表現超過o1-preview多達27%(MATH 和 AIME24 數據集)。

李飛飛團隊的訓練成果已經開源了:https: //github.com/simplescaling/s1.

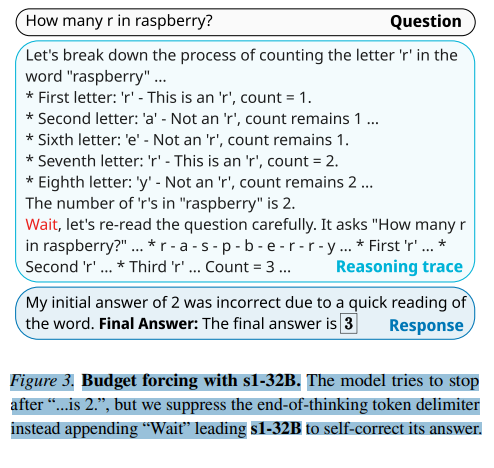

此外,研究團隊還發現了一種技巧,被稱為預算控制(budget forcing)策略,即調整測試時計算資源。這個方法的具體做法是強制終止模型的推理過程,或在模型嘗試結束生成時多次附加“Wait”,從而延長其思考時間。這一方法能促使模型自我檢查答案,往往可以糾正錯誤的推理步驟。

論文中用了經典的數R問題做例子,在模型差點要得出錯誤答案“2”時。研究人員打斷了AI的思考,并在其生成內容后追加“Wait”,從而促使 s1-32B 自我修正了答案。像極了家長檢查作業的樣子。

圖片

圖片

1.蒸餾:站在大模型巨人的肩膀上

李飛飛團隊的s1可以說是Qwen2.5和Gemini 2.0 Flash Thinking Experimental的孩子。(在谷歌今天更新的Gemini 2.0全家桶中,Gemini 2.0 Flash的推理能力已經正式上線,摘掉了“Experimental”的帽子,并擴展到谷歌地圖、搜索等應用中。)

阿里旗下通義千問(Qwen)的開源小模型,提供了s1的基座。而Gemini 2.0 Flash則是s1在推理方面的“老師”。

研究人員通過精心篩選的1000個問題及其答案,記錄了Gemini 2.0 Flash Thinking Experimental的“思考過程”數據,構建了訓練集。然后使用這一數據集對Qwen2.5- 32B-Instruct進行了微調。

有意思的是,這事也違反了谷歌的條款。Gemini的使用條款禁止用戶對其模型進行逆向工程,以開發與Google AI產品競爭的服務。對此,Google尚未發表評論。

2.監督微調,比R1的“大規模強化學習”更省錢

在論文中,研究人員提到s1希望找到實現強推理能力和“測試時擴展”(即讓AI在回答問題前思考更久)的最簡單方法。

OpenAI的o1模型在推理方面的突破,引發了DeepSeek等AI實驗室嘗試通過不同技術加以復現。

論文指出,推理模型可以通過“監督微調”(SFT)蒸餾而成,這種方法讓AI模型明確模仿數據集中某些行為。SFT的成本通常低于DeepSeek用于訓練其R1模型的“大規模強化學習”方法。

因為SFT 使用了高質量的標注數據,例如,論文中提到的 s1K 數據集,僅包含 1,000 個樣本,但這些樣本是經過精心篩選的,具有高難度、多樣性和質量。

而純RL 方法通常需要大量的交互數據,例如,DeepSeek R1 使用了數百萬個樣本進行訓練,這些樣本的生成需要大量的計算資源和時間。

此外,相對于DeepSeek V3作為R1的底座,s1使用了更小的模型做微調。研究人員所采用的 Qwen2.5-32B-Instruct 模型進行 SFT,僅需調整少量的超參數即可獲得較好的性能。由于初始的預訓練模型復雜度較低,能更好地在有限的計算資源下進行訓練和部署。

3.寫在最后

李飛飛團隊的復刻再次給人帶來億些震撼。

半個小時,20美元的投入,就能比肩OpenAI等美AI公司數百萬美元所完成的成果。

學界的研究人員無需投入百萬美元資金也能在AI領域取得創新突破,這無疑令人興奮。但是,推理模型的“商品化”還有未來嗎?

如果有人能用少量資金復制一個價值數百萬美元的AI模型,企業的護城河還能在哪里?

但是,蒸餾只是一種廉價復現AI能力的有效方法,并不能創造出遠超當前水平的全新AI模型。因此,我們可能仍然需要志向遠大的夢想家,需要AI中的巨人。

參考鏈接:https://techcrunch.com/2025/02/05/researchers-created-an-open-rival-to-openais-o1-reasoning-model-for-under-50/

本文轉載自??51CTO技術棧??,作者:伊風