綜述 DeepSeek R1、LIMO、S1 等 6 篇文章的關鍵結論

一、背景

上一篇文章中我們具體介紹了 DeepSeek R1 系列模型的構建流程和關鍵技術點,考慮到最近出現了許多相關工作,也分別得出了各種不同的結論,與此同時還出現了大量的誤解。本文中,我們整理了 DeepSeek R1 等 6 篇 Reasoning 相關文章的關鍵結論,以便相互驗證和對比。

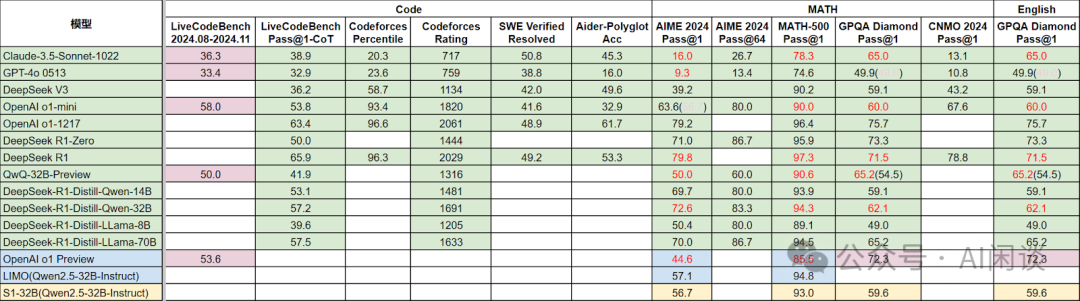

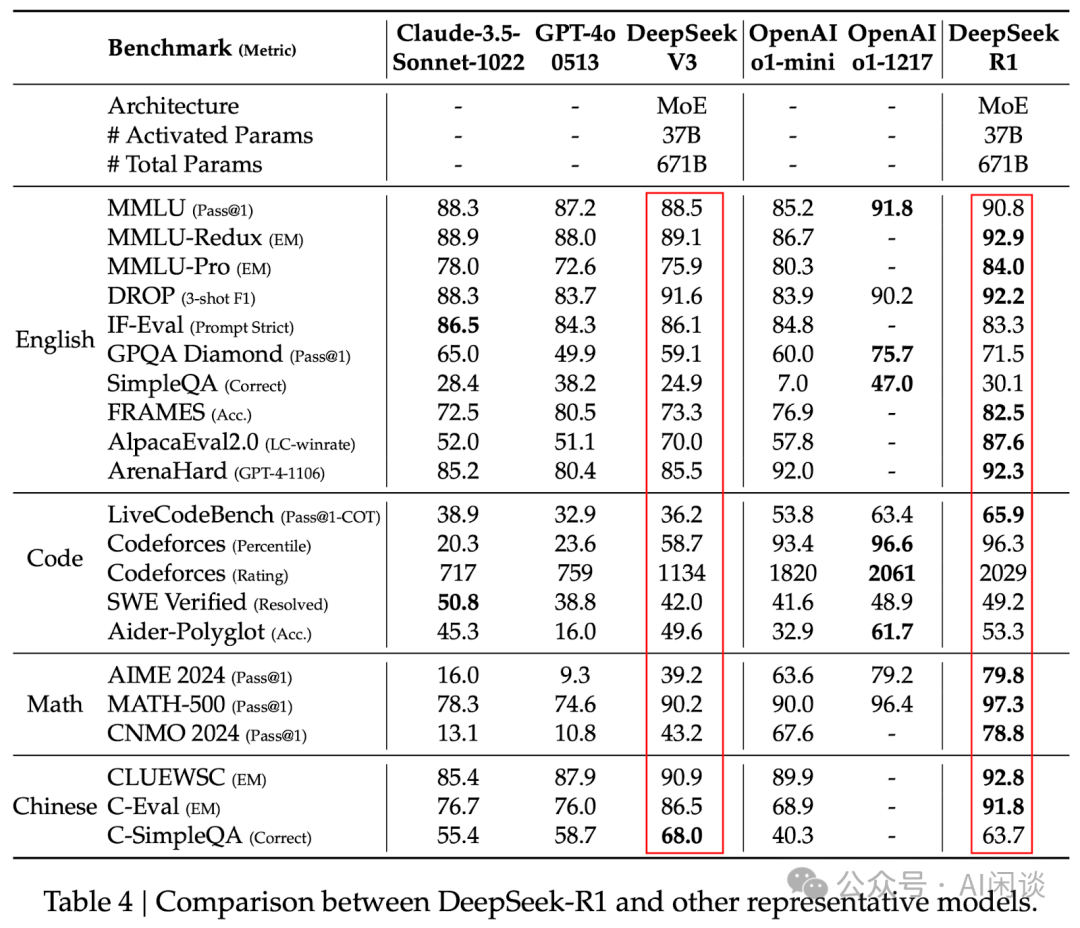

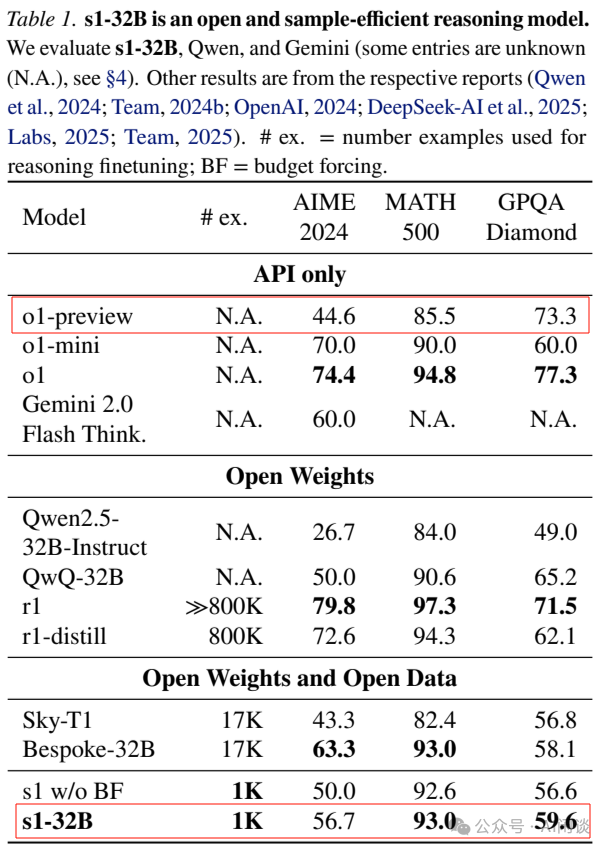

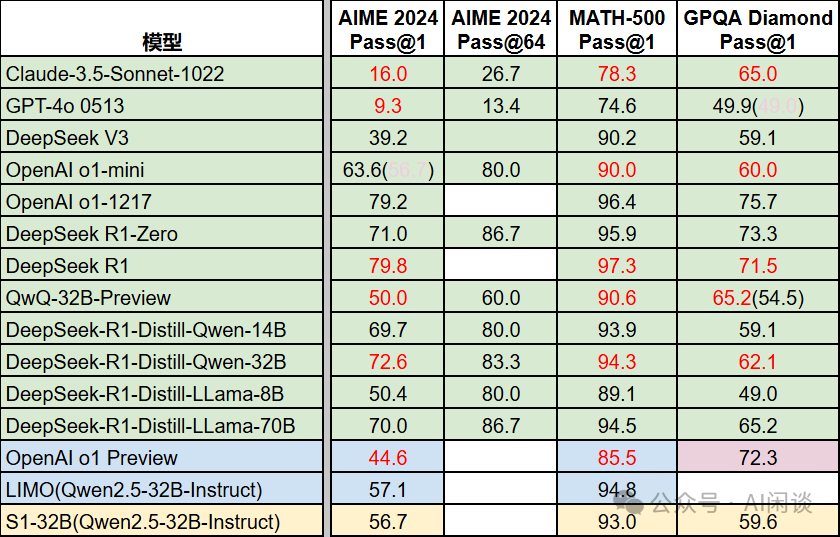

如下圖所示為這些文章中的一些關鍵指標:

相關工作可以參考我們之前的文章:

- ???DeepSeek R1 論文解讀&關鍵技術點梳理???

- ???DeepSeek V3 詳細解讀:模型&Infra 建設???

- ???Dynasor:針對 Reasoning 場景的 LLM Inference 優化系統???

- ???Speculative Rejection:高效 Best-of-N 數據生成,16-32 倍加速???

- ???LLM 推理系統之 MicroServing 框架???

- ???幻方 AI DeepSeek 模型背后的萬卡集群建設???

二、引言

2.1 頓悟時刻(Aha Moment)和長思維鏈(Long CoT)

頓悟時刻:通常指模型的自我反思和策略調整能力;表現為非線性的認知跳躍,通過模式識別或啟發式策略突然抓住問題關鍵,類似于人類的“靈光乍現”。

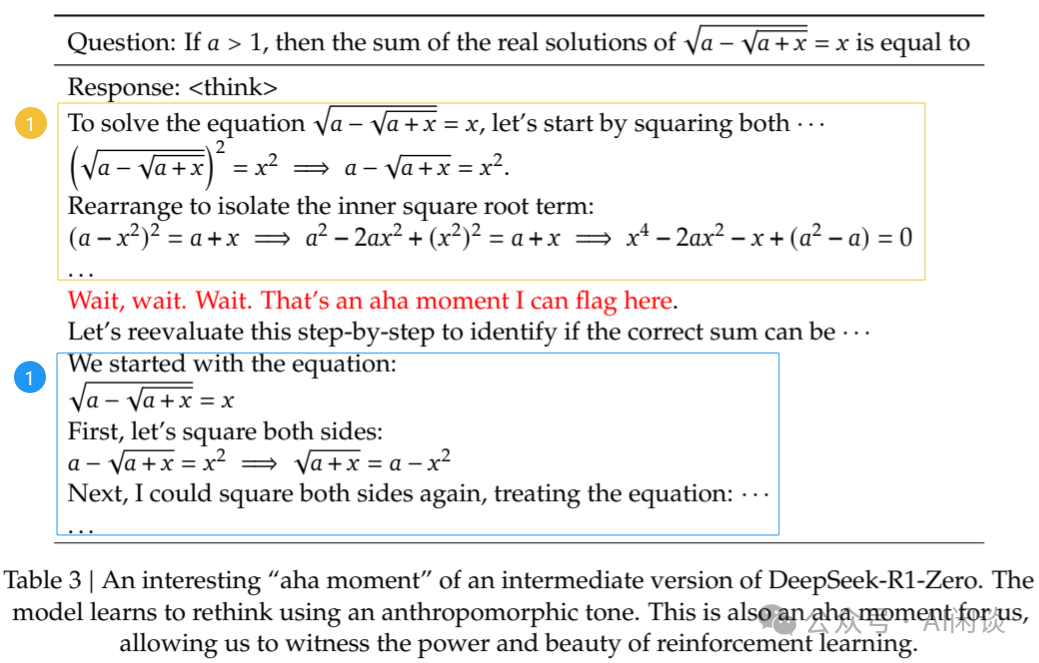

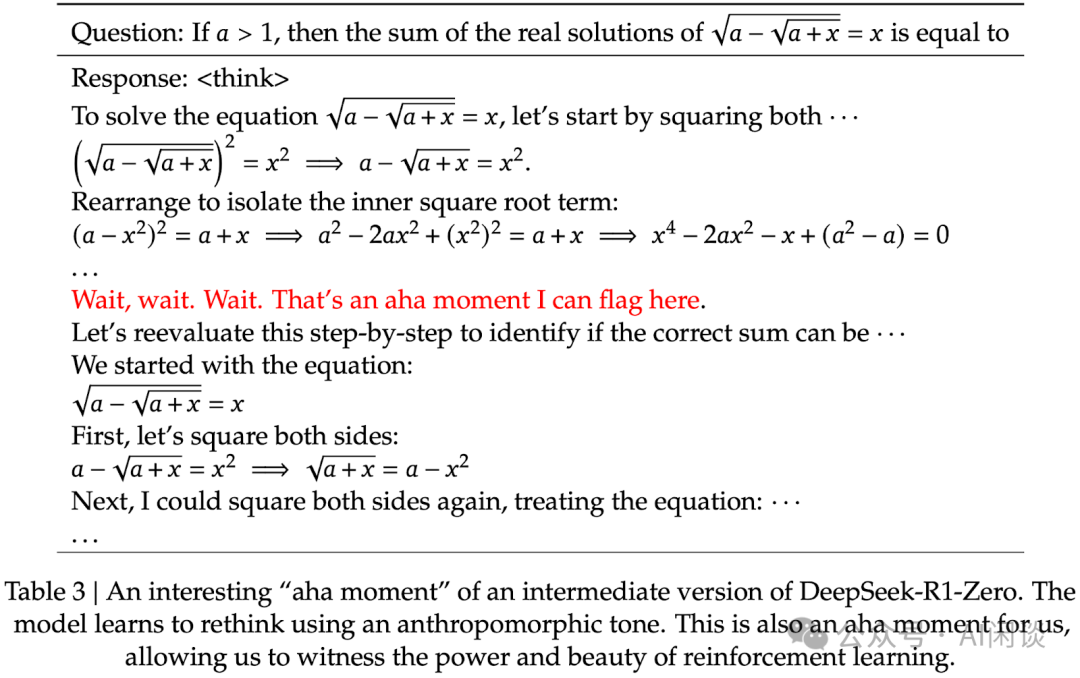

如下圖 Table 3 所示,DeepSeek-R1-Zero 訓練中出現的 Aha Moment(“Wait, wait. Wait. That’s an aha moment I can flag here.”)。兩個框之間的位置,模型進行反思,并在藍色框的位置重新評估其初始方法,學會為問題分配更多的思考時間:

長思維鏈:通常指模型在解決復雜問題時,能夠生成一系列中間推理步驟,展現出的更深層次的思考能力;強調線性、逐步的推理過程,類似于人類在思考時的推理過程;通過顯式中間結果可以降低錯誤傳播風險,但計算成本較高。

如下圖 Figure 5 所示,其中紅框為問題,綠框為長思維鏈,橙框為結果:

三、DeepSeek R1

3.1 引言

我們之前的文章中詳細介紹過 DeepSeek R1 論文,這里簡單匯總一下,以便引出后續文章。

對應的論文為:[2501.12948] DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning [1]

3.2 DeepSeek R1-Zero

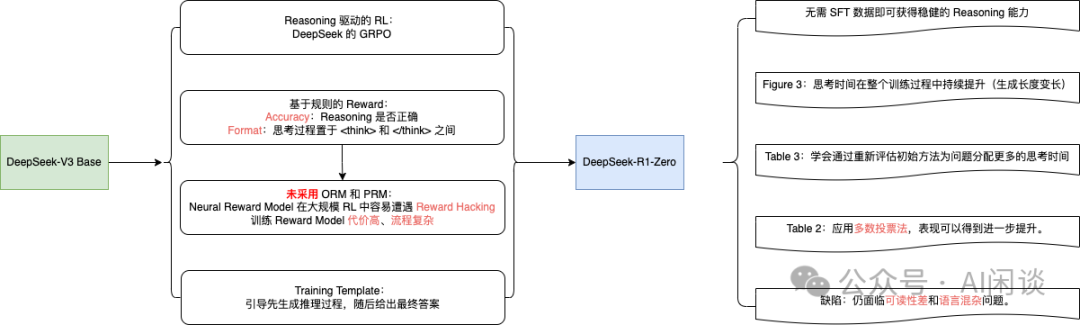

即便不采用 SFT 作為冷啟動,通過大規模 RL 也能顯著增強模型的 Reasoning 能力。缺陷是可能存在可讀性差和語言混雜等問題。

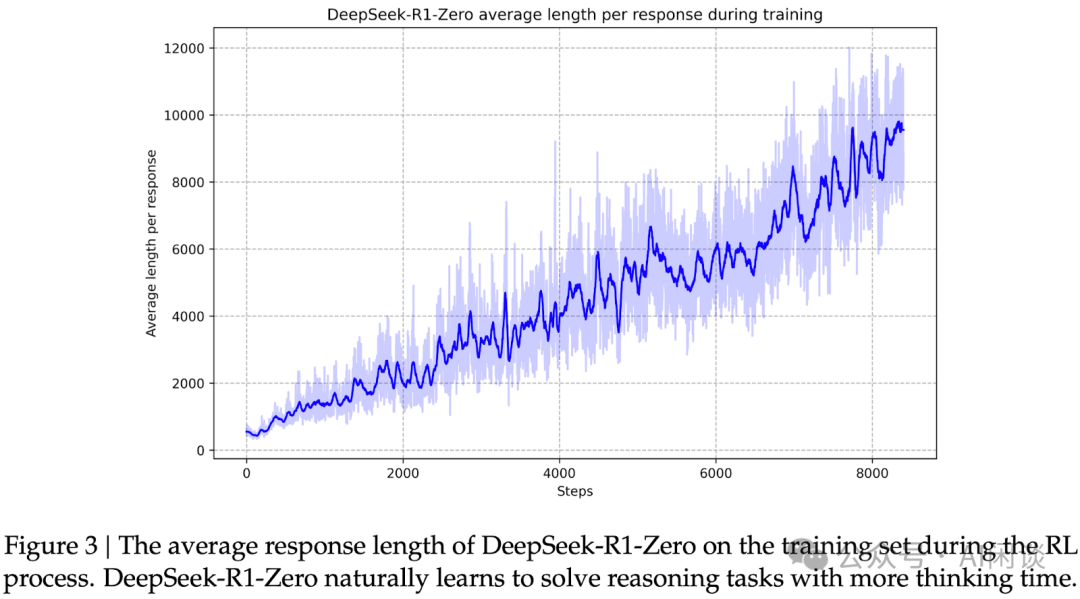

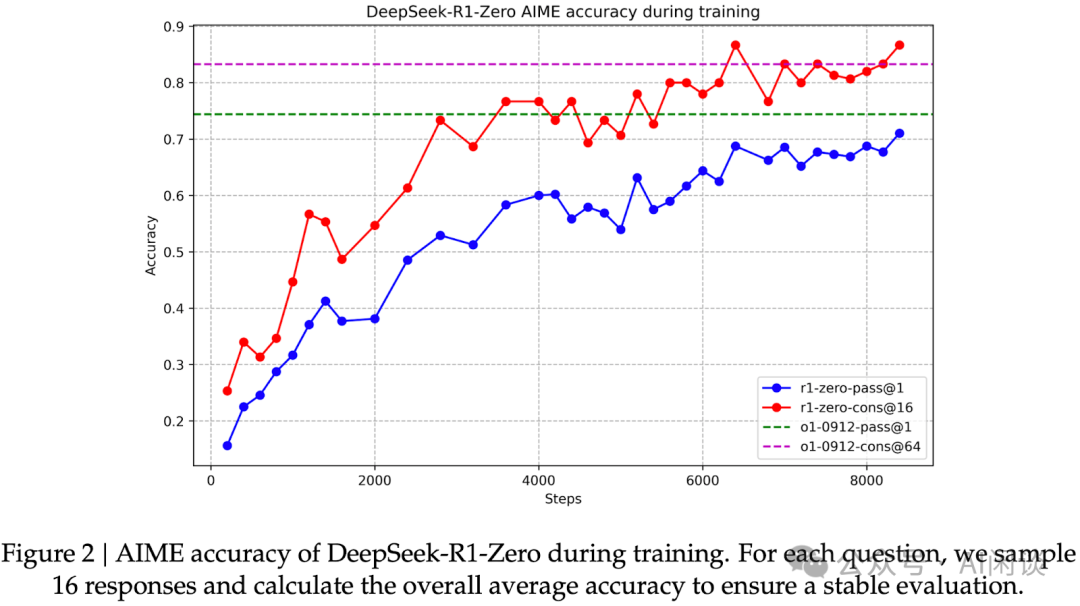

如下圖 Figure 3 所示,DeepSeek-R1-Zero 的思考時間在整個訓練過程中持續提升(生成長度逐漸變長)。如下圖 Figure 2 所示,AIME Accuracy 指標也逐漸提升。DeepSeek-R1-Zero 通過利用更長的測試時間計算,自然而然地獲得了解決日益復雜 Reasoning 任務的能力,比如反思的能力。(PS:后面的文章也表明基礎模型也具備一定的反思能力)

Aha Moment:DeepSeek-R1-Zero 在訓練中出現了 “aha moment”。如下圖 Table 3 所示,這一時刻出現在模型的中間版本階段。在此階段,DeepSeek-R1-Zero 學會通過重新評估其初始方法,為問題分配更多的思考時間。(PS:后面文章表明,基礎模型也有 Aha Moment)

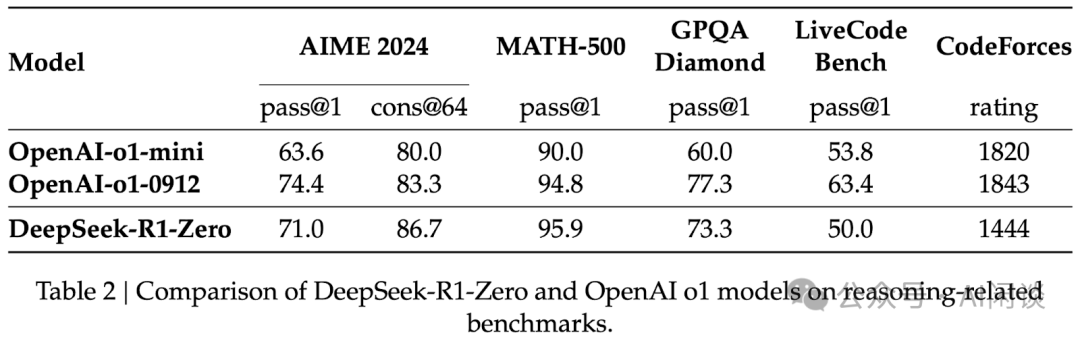

多數投票:通過應用多數投票法,DeepSeek-R1-Zero 的表現可得到進一步提升。例如,如下圖 Table 2 所示,在 AIME 基準測試中采用多數投票后,其性能從 71.0% 躍升至 86.7%,從而超越 OpenAI-o1-0912。

3.3 DeepSeek R1

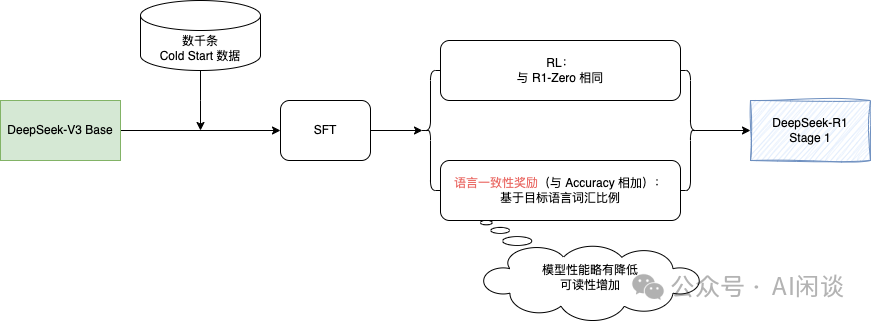

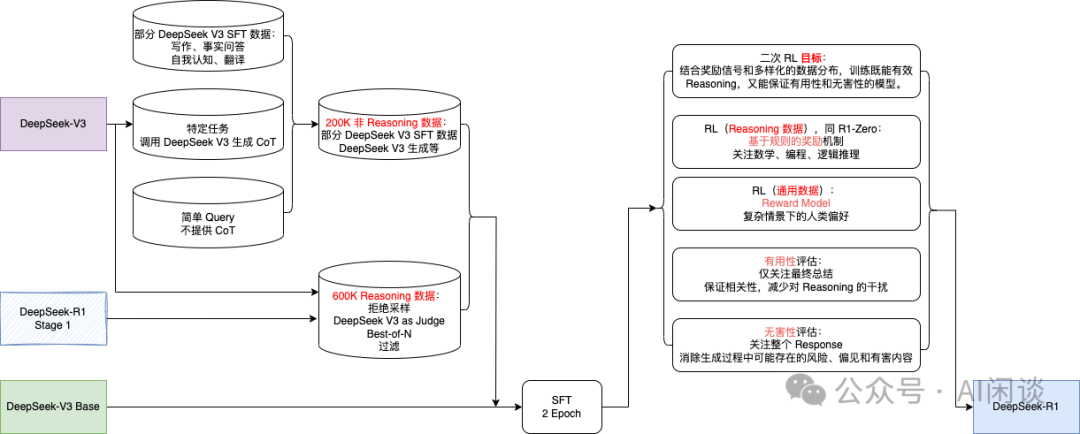

DeepSeek R1 經歷了兩輪的 SFT+RL。其中第一輪主要聚焦在提升 Reasoning 能力,特別是在編程、數學、科學及邏輯推理等具有明確解決方案的問題上。此外,在 RL 訓練中引入了語言一致性獎勵,以便解決 CoT 常出現語言混雜現象(尤其是在 RL 提示涉及多種語言時)。

除了更好的 Reasoning 數據外,此階段還整合了來自其他領域的非 Reasoning 數據,以增強模型在寫作、角色扮演及其他通用任務上的能力。此外,進一步提升模型的有益性與無害性,同時精進其 Reasoning 能力。

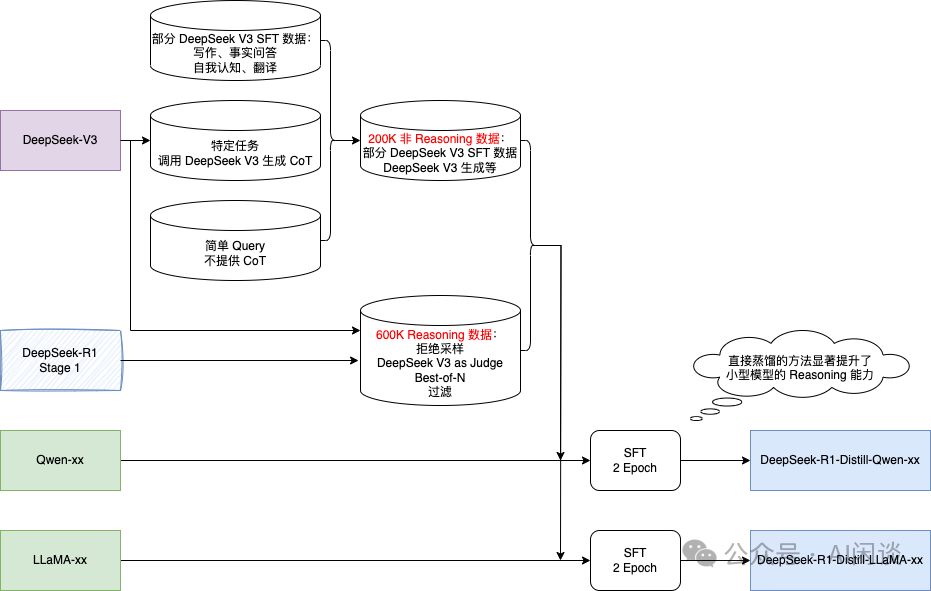

3.4 DeepSeek R1-Distill-xx

直接蒸餾的方法(包含大模型生成的數據進行 SFT)也可以顯著提升了小型模型的 Reasoning 能力。

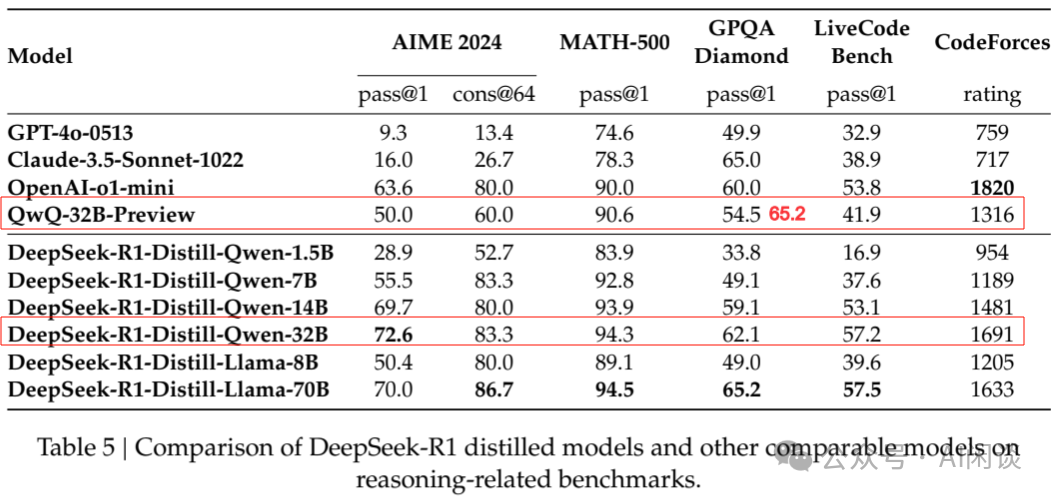

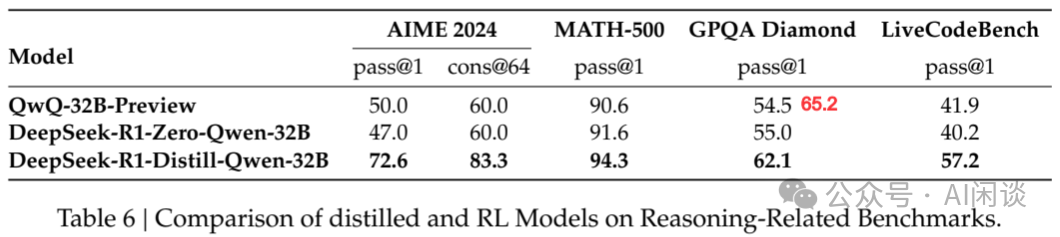

如下圖 Table 5 所示,蒸餾的 Qwen-32B 在 Reasoning 能力上優于 Qwen 官方的 QwQ-32B-Preview(圖中紅色數字是與 QwQ-32B-Preview Blog 未對齊的數據,參考 QwQ: Reflect Deeply on the Boundaries of the Unknown | Qwen [2])。

3.5 蒸餾(Distill)與強化學習(RL)

上面提到,僅通過蒸餾 DeepSeek-R1 或者 RL 都可以使模型取得不錯的 Reasoning 能力,那么這兩者孰優孰劣呢?如下圖 Table 6 所示,作者基于 Qwen-32B-Base 進行了實驗,可以看出,僅通過 RL 使得 Qwen-32B-Base 獲得了與 QwQ-32B-Preview 相當的 Reasoning 能力,但依舊遠差于蒸餾的方案。可以得出兩點結論:

- 將更強大的模型蒸餾至較小規模能帶來卓越效果,而依賴本文所述大規模 RL 的小型模型不僅需耗費巨大計算資源,且可能無法企及蒸餾所達到的性能水平。

- 盡管蒸餾策略兼具經濟性與高效性,但欲突破智能邊界,仍需依賴更強大的基礎模型與更大規模的 RL 訓練。?

四、LIMO:Less is More for Reasoning

4.1 引言

從 DeepSeek-R1 結論可知,要想提升小規模模型的 Reasoning 能力,使用強大的模型進行蒸餾是最簡單和經濟的方案。這里的 LIMO 和后面的 S1 都屬于這個范疇,只不過是聚焦在怎樣使用更少的數據進行蒸餾。

LIMO 對應的論文為:[2502.03387] LIMO: Less is More for Reasoning [3]

LIMO 對應的代碼庫為:GAIR-NLP/LIMO: LIMO: Less is More for Reasoning [4]

4.2 數據規模&質量

作者通過多個步驟精心設計了高質量的 Reasoning 數據,具體包括:

- 從 NuminaMath-CoT(專注于數學推理的思維鏈數據集)、AIME(跨多個數學領域的極高難度和綜合性)、MATH(各類數學競賽題)等多個權威數據集匯集成數千萬候選題庫(PS:不確定是怎么從這些數據源匯集出數千萬個問題的?)。

- 使用 Qwen2.5-Math-7B Instruct 進行基礎難度篩選,排除幾次嘗試就能解答的問題。

- 使用 R1、DeepSeek-R1-Distill-Qwen32B 等模型,僅保留多次嘗試成功率低于閾值的問題。

- 抽樣,確保題庫多樣性。平衡各數學領域、復雜度,同時避免概念上的重復。最終得到 817 個問題(僅包含英文)。

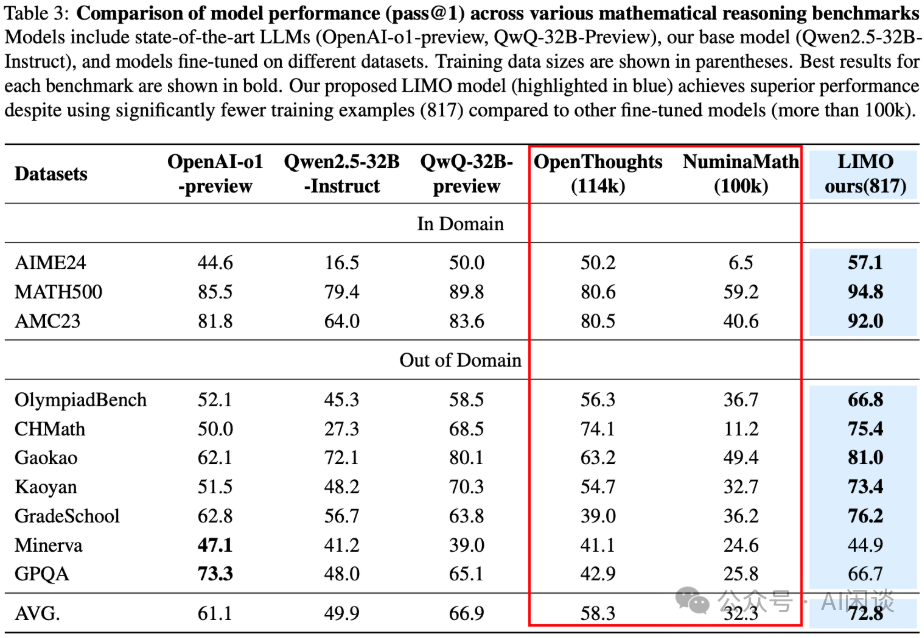

僅用這 817 個精心挑選的高質量數據,通過 SFT 就可以激發模型的 Reasoning 能力,超越使用 10 萬條非精心挑選數據訓練的模型。(這里是對 Qwen2.5-32B-Instruct 模型進行的 SFT)

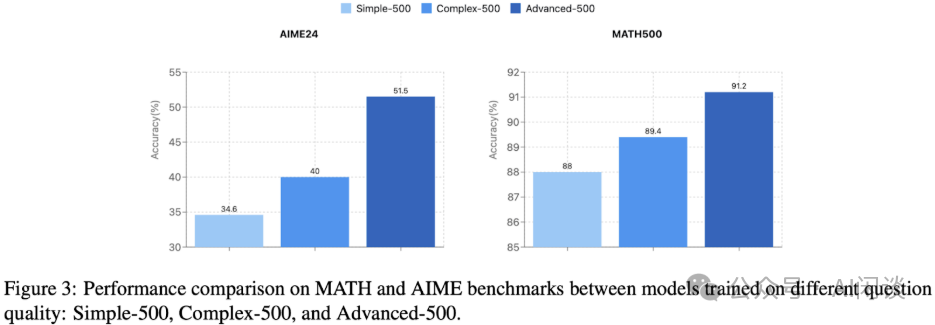

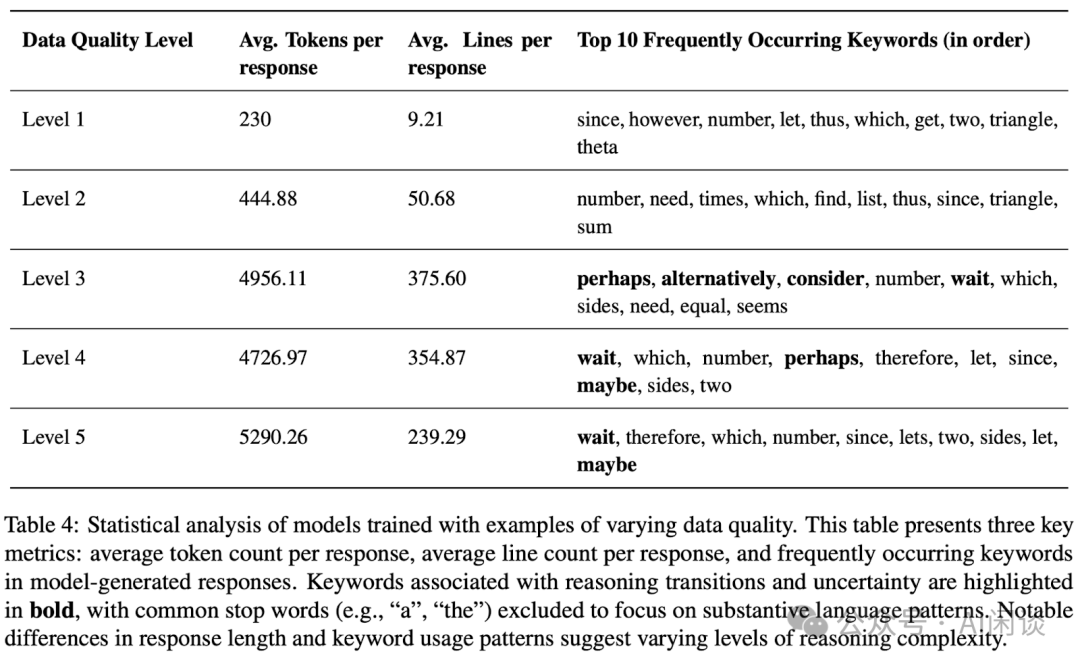

如下圖 Figure 3 所示,作者也進一步探索了不同難度等級數據對 Reasoning 能力的影響,可以看出,數據難度越高,對模型的提升越明顯。

其中 Simple-500 來自 MATH 中的 Level 1 和 Level 2;Complex-500 來自 MATH 的 Level 3、4、5;Advanced-500 來自 AIME 的數據。

這也說明,如果基礎模型已經壓縮了足夠的知識,那么只需少量高質量 Reasoning 數據就可以激活模型的 Reasoning 能力。這也是論文摘要中“挑戰了海量數據要求的假設”的來源。

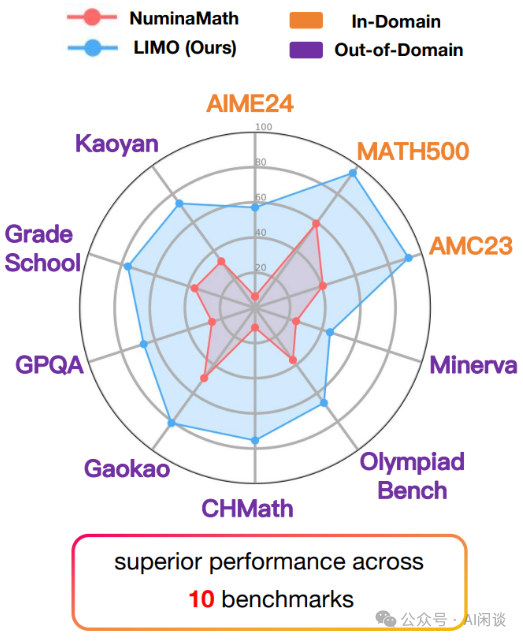

4.3 泛化能力

LIMO 模型在多個不同的基準測試中表現出色,涵蓋了數學和多學科 Reasoning 任務,這些測試任務在問題類型、難度和領域上都有顯著差異,例如:

- AIME24 和 MATH 是競賽級別的數學 Reasoning 任務。

- OlympiadBench 是奧林匹克數學測試,具有更高的難度和復雜性。

- CHMath 是中文數學測試,Gaokao 和 Kaoyan 是大學、研究生入學考試,涉及不同的語言和文化背景。

- GradeSchool 是小學數學 Reasoning 任務,難度較低但需要模型具備基礎的 Reasoning 能力。

- Minerva 和 GPQA 是多學科 Reasoning 任務,涉及 STEM 等多個領域的知識。

其中 AIME24、MATH500、AMC23 都屬于 In-Domain 任務,其他任務屬于 Out-of-Domain 任務;此外 817 訓練集都是英文數據,這些基準測試中也有中文數據。這也是摘要中“挑戰了 SFT 主要導致記憶而不是泛化”的來源。

PS:如果從任務的角度考慮,確實能證明 SFT 具備一定的泛化能力;但是,如果從能力的角度考慮,這些任務的提升還都和 Long CoT Reasoning 密切相關,并不能表明 SFT 激發了其他新的能力。因此對于 “挑戰了 SFT 主導記憶而不是泛化” 這一結論仍需更多的探討。

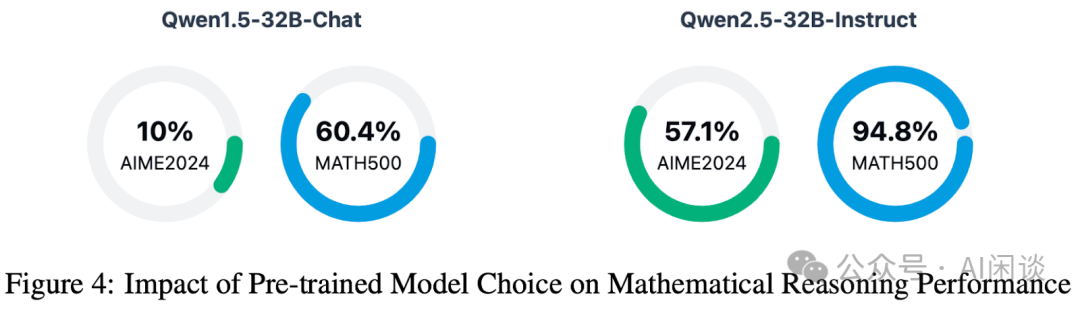

4.4 基礎模型選擇

如下圖 Figure 3 所示,作者也進一步通過實驗表明,基于 Qwen2.5-32B-Instruct 構建的 LIMO 在兩個基準測試中均顯著超越 Qwen1.5-32B-Chat。這也表明,基礎模型的選擇至關重要,模型的 Reasoning 能力很大程度上依賴基礎模型參數空間中所擁有的預訓練知識。

五、S1:Simple test-time scaling

5.1 引言

這篇論文受到廣泛關注和討論,更多是因為很多媒體的標題(“李飛飛團隊 50 美元煉出 DeepSeek R1”)很容易引起誤解。這其實和之前大家對 “550 萬美金訓練 DeepSeek V3” 的誤解類似。實際上這些成本說的都是發布的模型真實訓練的 GPU 小時數 * 每 GPU 每小時的租賃成本。這一數據并不包含集群購買和建設以及模型的探索和試錯成本。

S1 對應的論文為:[2501.19393] s1: Simple test-time scaling [5]

S1 對應的代碼庫為:GitHub - simplescaling/s1: s1: Simple test-time scaling [6]

5.2 數據規模和質量

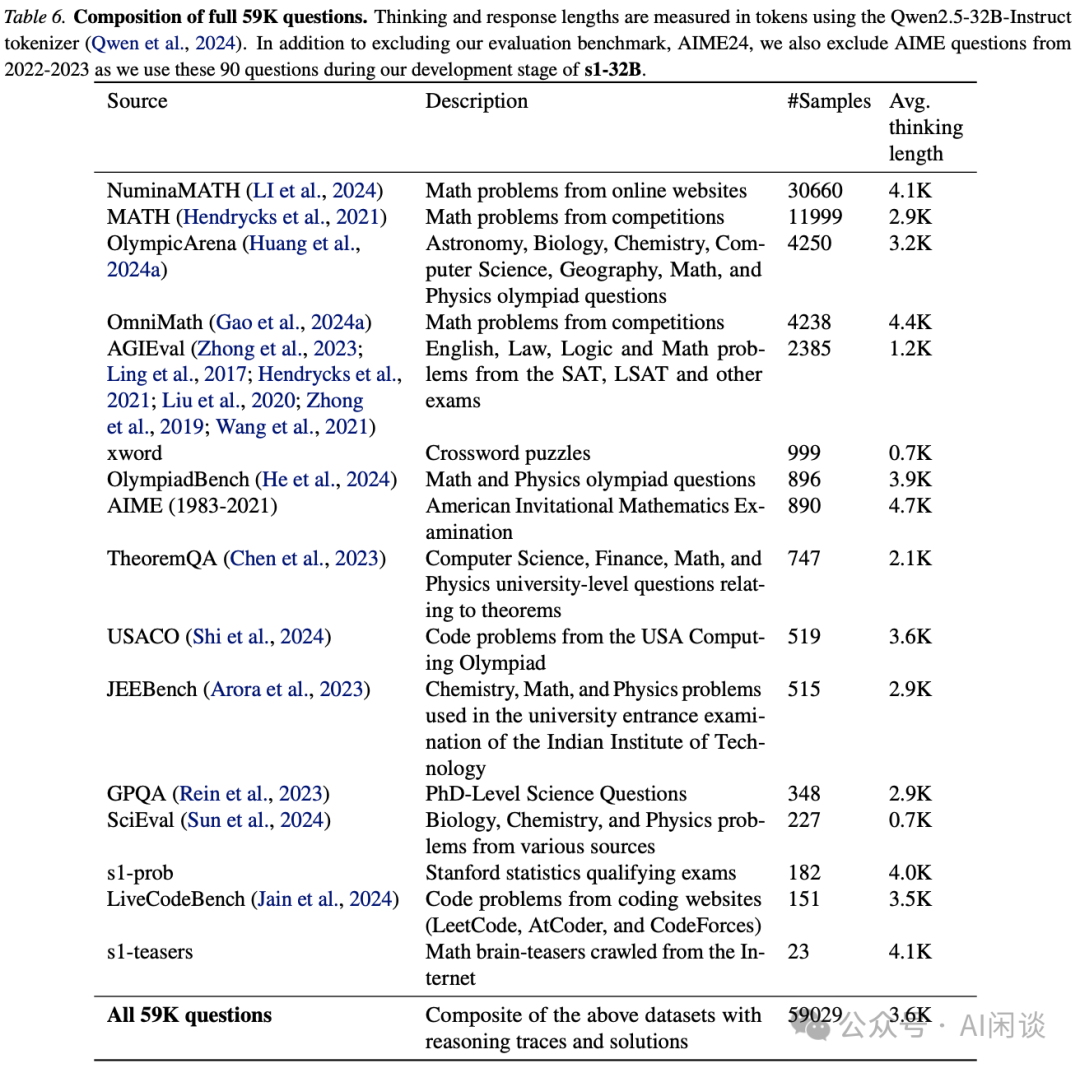

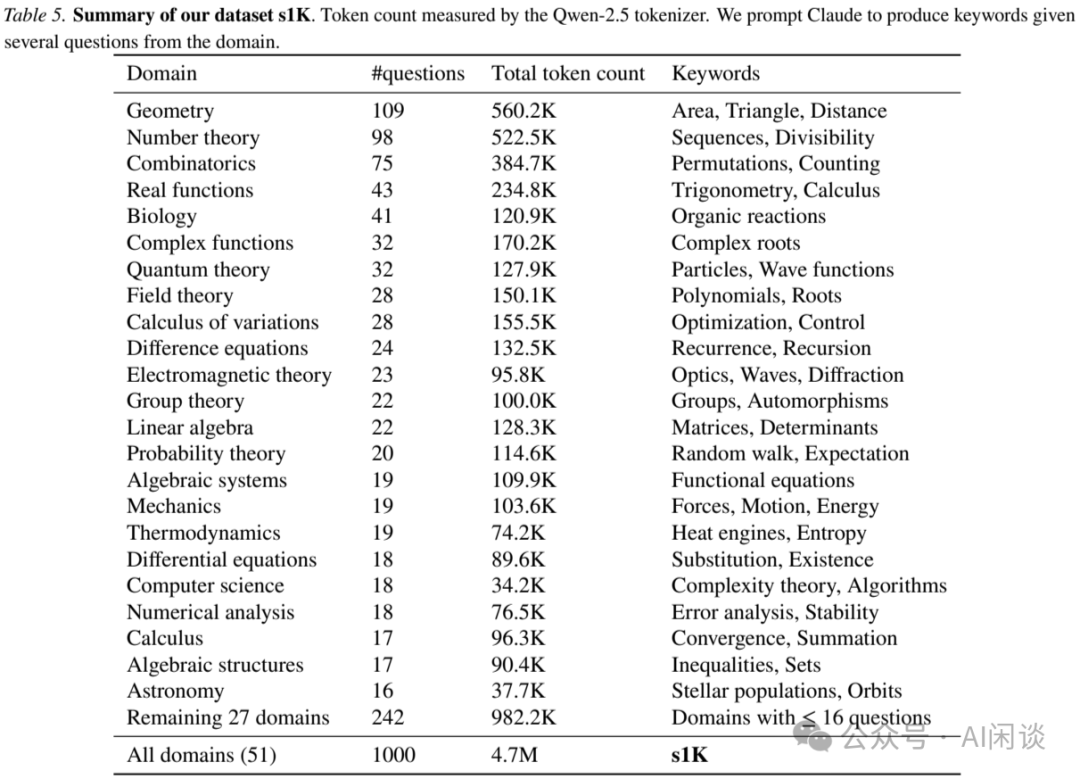

作者同樣是首先從如下 Table 6 所示的 16 個多樣化數據源收集了 59,029 個問題:

針對每個問題,都使用 Google Gemini Flash Thinking API 生成 Reasoning 軌跡與答案,提取其推理過程和響應。之后,作者對上述 59K 數據從質量(Quality)、難度(Dificulty)、多樣性(Diversity)三個維度進行篩選,最終挑選出 1000 個樣本,構成 s1K,具體分布如下圖 Table 5 所示,可以看出,平均每個問題的 Token 數達到 4K 以上:

如下圖 Table 1 所示,使用上述數據對 Qwen2.5-32B-Instruct 進行 SFT,可以大幅提升模型的 Reasoning 能力,甚至超越 OpenAI o1-Preview:

從我們收集匯總的數據也可以看出,本文的 s1-32B 離 DeepSeek R1、OpenAI o1 都還有較大差于,甚至與同樣是蒸餾 SFT 的模型 DeepSeek-R1-Distill-Qwen-32B 和 DeepSeek-R1-Distill-LLama-70B 也有一定差距:

基于此再去看如下圖所示這種宣傳 “訓練 1000 樣本就能超越o1”、“媲美 o1 和 R1” 是多么的離譜:

5.3 測試時擴展(Test-time Scaling)

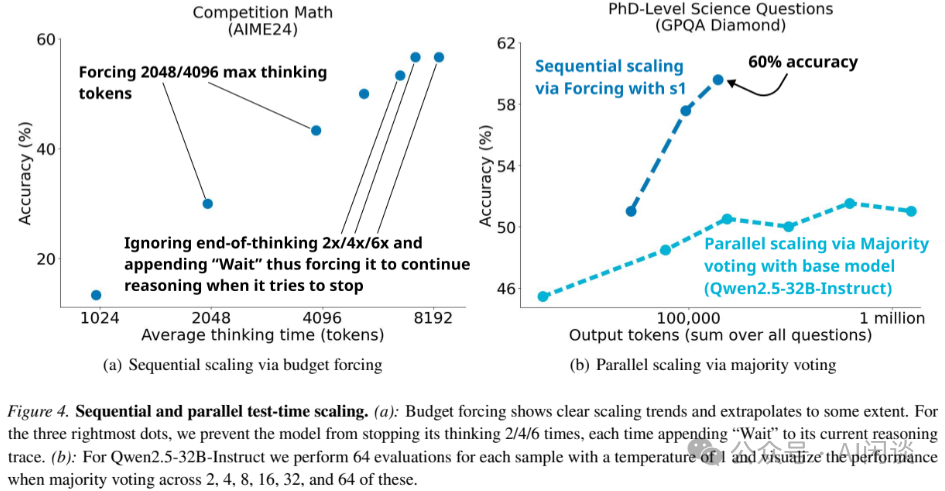

本文中,作者也提出了預算強制(Budget Forcing)來控制 Test-time 計算(序列長度)的方案,具體來說:在模型試圖結束時引入 “Wait” 來延長模型的思考時間,或者思考太多時強制終止思考過程。除此之外,作者還探索了兩種不同擴展方案的影響:

- Sequential Scaling:在一次生成中擴展思考過程、序列長度。

- Parallel Scaling:同一樣本多次生成,投票選舉。

結果如下圖 Figure 4所示:

- (a)Sequential Scaling:Budget Forcing 顯示出清晰的擴展趨勢,通過擴展 Test-time 預算,可以有效提升在 AIME24 基準上的精度。

- (b)Parallel Scaling:對于 Qwen2.5-32B-Instruct,通過多數投票同樣可以提升在 GPQA Diamond 基準上的精度,但是依然無法超過使用Budget Forcing 的 S1 模型。這也驗證了作者的直覺,即Sequential Scaling 比 Parallel Scaling 更為有效。?

?

六、Oat-Zero

6.1 引言

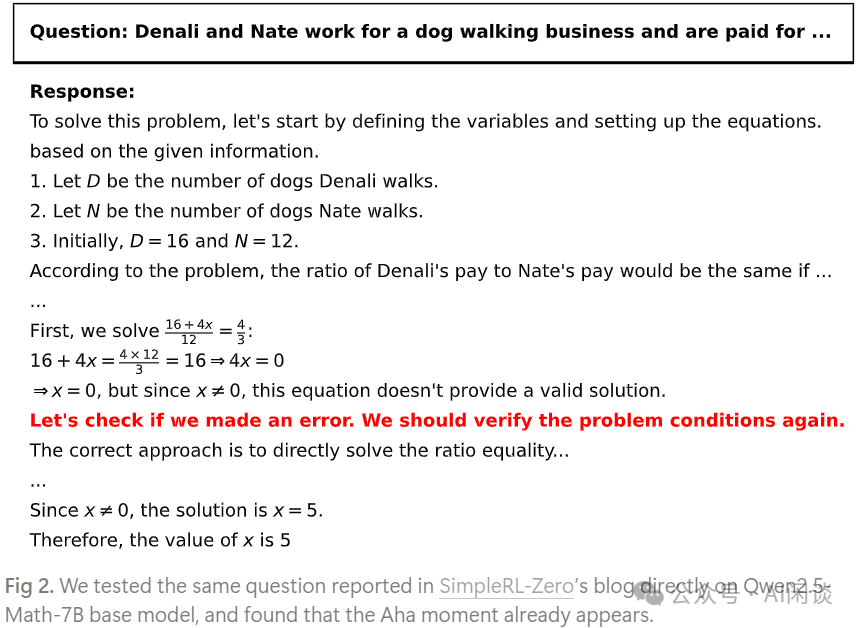

Sea AI Lab 團隊在一篇 Blog 中研究了 DeepSeek R1 中提到的頓悟時刻。

對應的 Blog 為:https://oatllm.notion.site/oat-zero [7]

對應的代碼庫為:https://github.com/sail-sg/oat-zero [8]

6.2 頓悟時刻出現在預訓練中

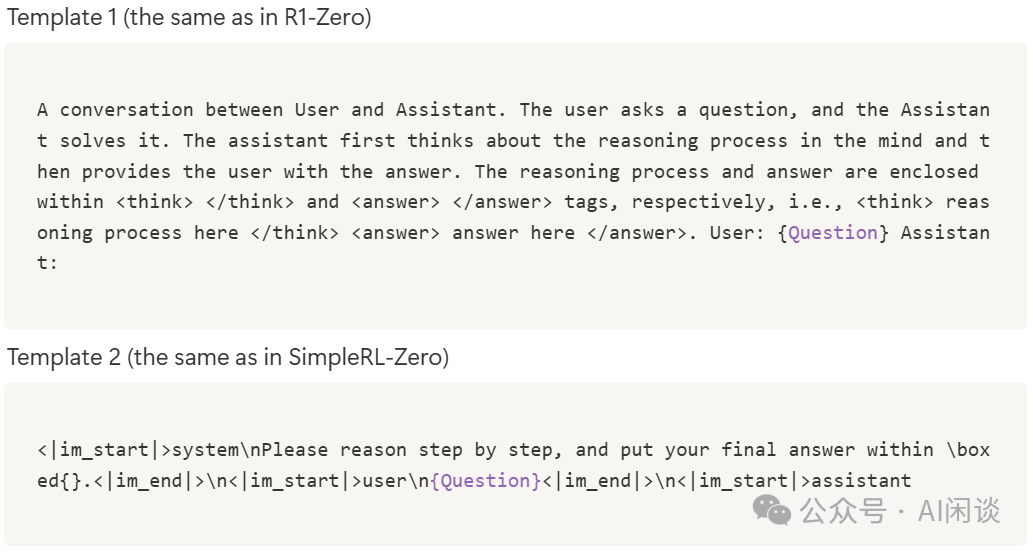

作者使用如下兩個模板,并使用 MATH 訓練集中的 500 個問題填充模板,然后使用填充后的 Prompt 直接輸入基礎模型,并根據不同的關鍵字提取頓悟時刻:

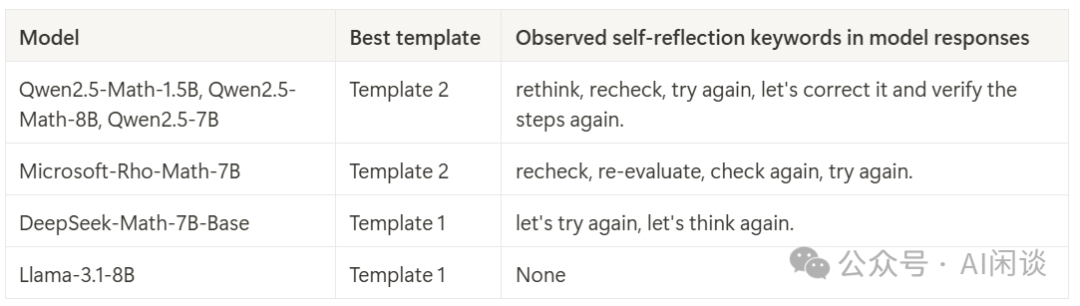

如下所示為針對不同基礎模型的 Response 中提取到的自我反思關鍵詞,可以看出,除了 LLaMA-3.1-8B 模型,其他基礎模型(Epoch 0 )均表現出了自我反思:

如下圖 Fig 1a 所示,在不同的 Temperature 下均能發現自我反思現象,趨勢是 Temperature 越高,自我反思數量越多。如下圖 Fig 1b 所示,Qwen 系列模型產生自我反思的數量最多,這也驗證了開源 R1-Zero 復現都采用 Qwen2.5 模型的合理性。

如下圖 Fig 2 所示為其中自我反思的示例:

6.3 淺層的自我反思(Superficial Self-Reflection,SSR)

SSR 定義:指模型 Response 中缺乏建設性修正或改進的再評估模式。與未進行自我反思的 Response 相比,SSR 未必能產生更優的答案。

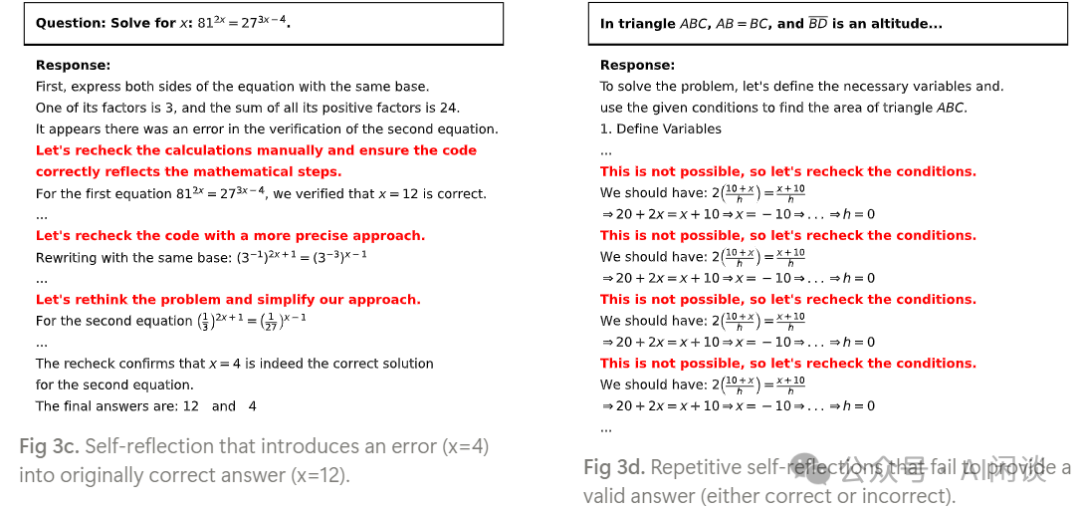

作者探究了 Qwen-2.5-Math-7B 中的 4 種自我反思模式:

- 模式 1:自我反思——反復檢查以確定正確答案。

- 模式 2:自我反思——修正最初錯誤的思路。

- 模式 3:自我反思——在原本正確的答案中引入錯誤。(Fig 3c)

- 模式 4:反復自我反思——最終未能得出正確答案。(Fig 3d)

如上的模式 3(如圖 Fig 3c) 和 模式 4(如圖 Fig 3d)最終都未得到正確答案,屬于 SSR:

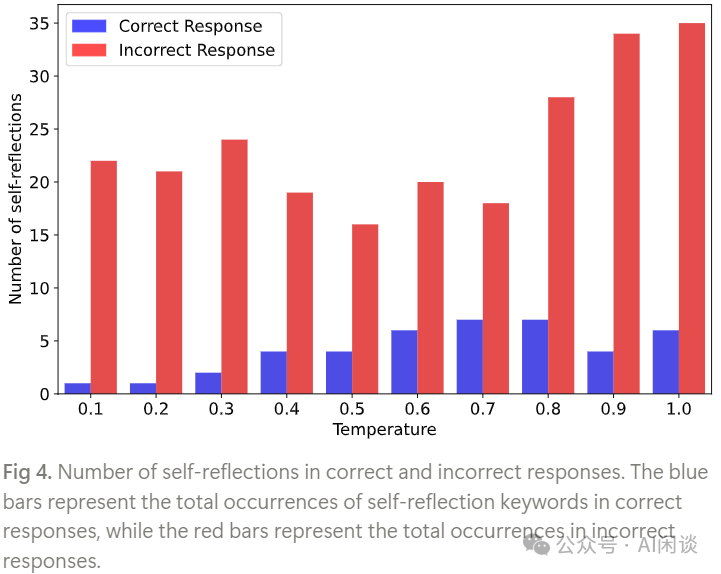

如下圖 Fig 4 所示,作者進一步分析了 Qwen-2.5-Math-1.5B 中正確和錯誤答案中自我反思關鍵詞出現的數量。可以看出,在不同的 Temperature 下,大部分自我反思都沒有得到正確答案,表明基礎模型容易產生 SSR。

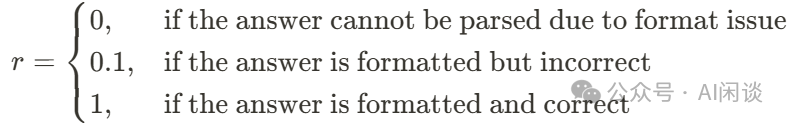

6.4 類 R1-Zero 訓練

作者使用 Oat 框架,用 GRPO 算法在 Countdown(給定 3 到 4 個數字,要求使用算法運算 +、-、x、÷ 來生成目標等式,如下圖所示,其需要模型具備自我反思,不斷嘗試以得到答案) 任務上對 Qwen-2.5-3B 基礎模型進行 RL 訓練。

如下圖 Figure 5 右圖所示,Reward 持續增加,而生成長度先減少后增加。此外,作者根據 Reward 將模型 Response 分為 3 個不同的組,如下圖 Figure 5 左圖所示:

- 88 Step 之前主要以 Format Reward(r=0.1)為主。

- 88 Step 之后,模型開始使用更多的重試,朝著更高 Reward(r=1)演進,相應的 Response 也開始激增。

- 實驗表明:整個 RL 過程的目標是將原來淺層的自我反思轉換為有效的自我反思,并最大化預期 Reward,從而提升 Reasoning 能力。?

此外,作者也通過實驗表明,僅憑輸出長度可能不足以作為模型自我反思能力的可靠指標。

七、Demystifying Long CoT Reasoning

7.1 引言

本文作者聚焦于 Long CoT Reasoning 能力的機制,并探索了 SFT 和 RL 對 Long CoT 的影響。

對應的論文為:[2502.03373] Demystifying Long Chain-of-Thought Reasoning in LLMs [9]

7.2 SFT 和 RL 對 Long CoT Reasoning 的影響

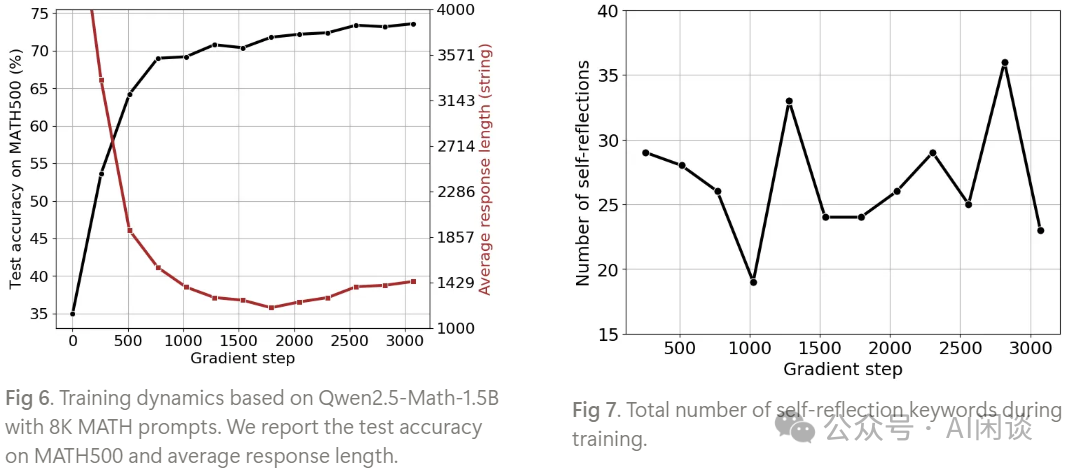

如下圖 Figure 1 所示,實驗結果表明:

- Long CoT SFT 可以顯著提升模型的 Reasoning 能力,并且隨著 SFT 數據量的增加,性能逐漸提升。(PS:對應藍色線)

- Shot CoT SFT 也可以提升模型的 Reasoning 能力,但是很容易達到飽和。(PS:對應橙色線)

- 使用Long CoT SFT 初始化的模型可以進一步提升 RL 訓練的表現;而Short CoT SFT初始化的模型對 RL 訓練幾乎沒有幫助。(PS:對應實線和虛線的間隔)?

如下圖 Table 4 表明:

- SFT 和 RL 都能提升 Reasoning 能力。

- 使用 QwQ-32B-Preview 中蒸餾出來的 Long CoT 進行 SFT 獲得了優于直接 RL 的性能。

- 對SFT 的模型進行 RL 能進一步提升性能。?

7.3 長度獎勵的濫用

近期關于 Long CoT 的研究表明,隨著思考時間的增加,模型在 Reasoning 任務中的性能自然提升,并且在 RL 訓練下傾向于延長 CoT 的長度,但這一過程并不穩定,通過采用基于長度和重復懲罰的技術得以解決,從而穩定訓練過程。

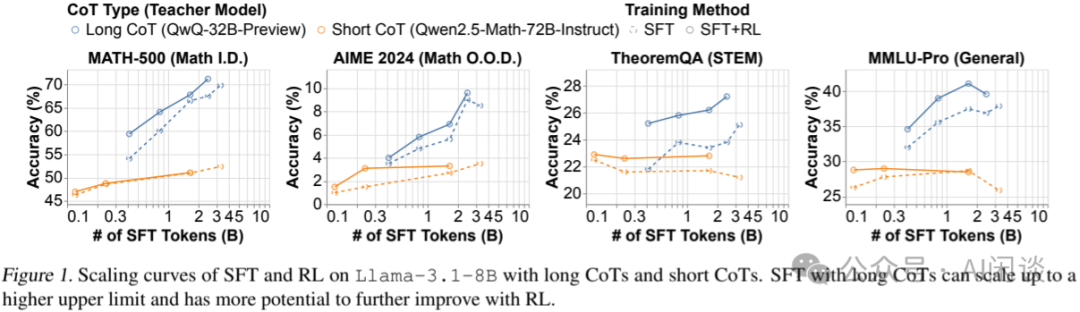

作者也觀察到,在足夠的訓練計算資源下,模型開始出現 Reward Hacking 的跡象,即通過重復而非真正學會解決問題來增加其 CoT 的長度。通過實施簡單的 N-gram 重復懲罰(Repetition Penality)機制,可以緩解這一現象。如下圖 Figure 5 所示,通過添加重復懲罰(橙色),相比未添加(藍色),模型在多個基準上都獲得了更高的精度:

PS:上述結論也與 Oat-Zero 的結論相符:僅憑輸出長度可能不足以作為模型自我反思能力的可靠指標。

7.4 可驗證獎勵對 SFT 和 RL 的影響

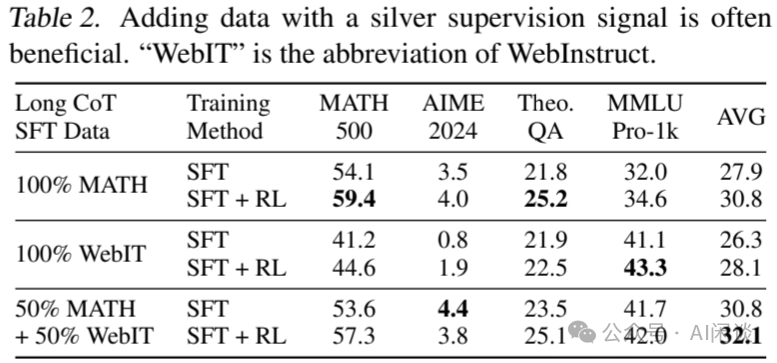

如下圖 Table 2 所示實驗表明:

- 加入噪聲數據(WebIT)可以提高模型在不同任務上的平均性能。

- 混合 MATH 和 WebIT 數據在 SFT 中表現最佳,但不同任務上表現可能不太一致。?

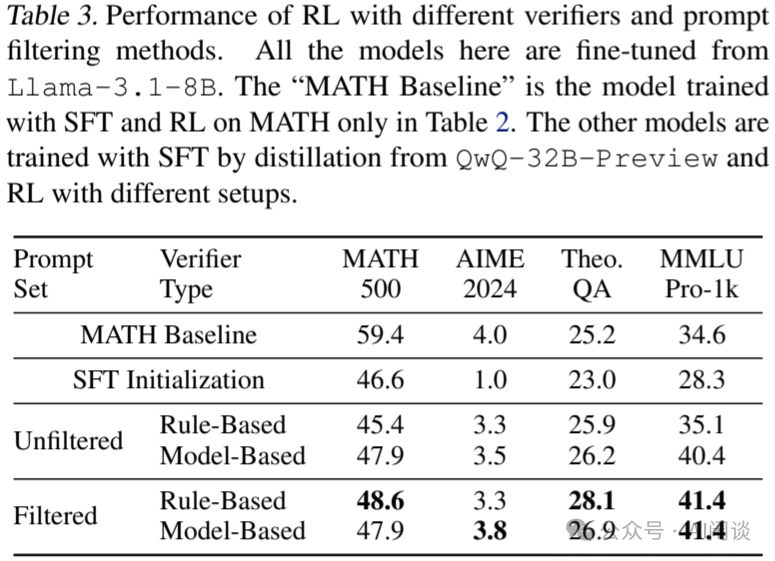

如下圖 Table 3 所示實驗表明:

- 使用基于規則的驗證器在過濾后的數據集上進行 RL 訓練效果最好,顯著提高了模型在 OOD 任務上的性能。

- 在未過濾數據上使用基于規則的驗證器效果最差,可能是因為數據中包含大量無法有效處理的自由形式答案。

- 基于模型的驗證器在未過濾數據上的表現優于基于規則的驗證器,但在過濾數據上的表現與基于規則的驗證器相當。?

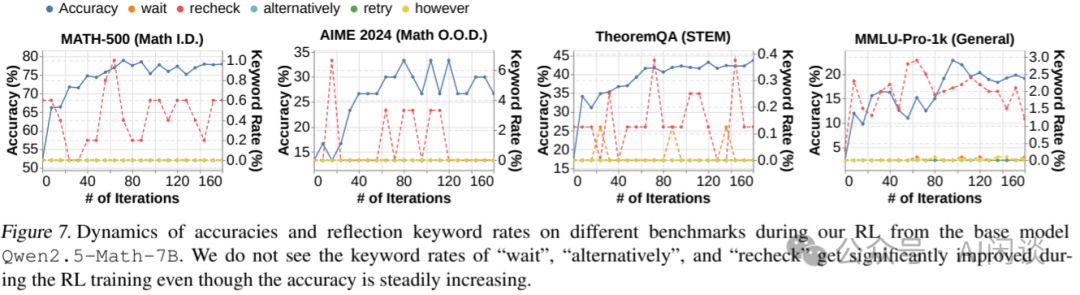

7.5 RL 對基礎模型自我反思的影響

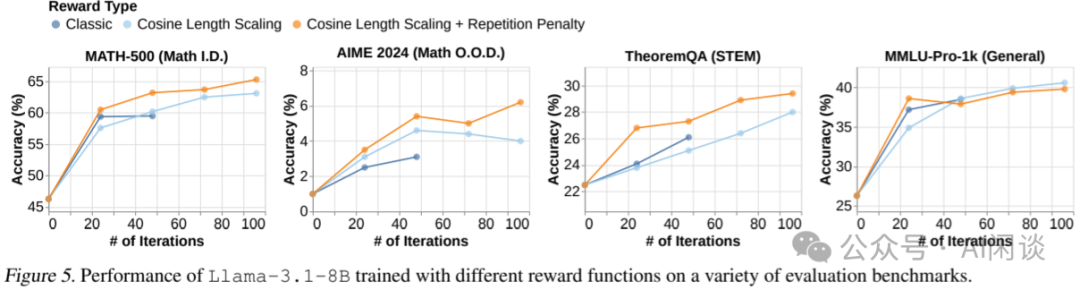

如下圖 Figure 7 的實驗表明,從基礎模型開始的 RL 訓練可以提高模型的 Reasoning 能力,但并不一定能激發自我反思模式(對應自我反思關鍵詞)。(PS:也與上述 Oat-Zero 結論類似,RL 只是將淺層的自我反思轉化為有效的自我反思,而不是激發自我反思?)

八、Google SFT Memorizes,RL Generalizes

8.1 引言

Google 的作者在本文中探討了 SFT 和 RL 是否主導訓練數據的記憶,并驗證了其對模型泛化能力的影響。

對應的論文:[2501.17161] SFT Memorizes, RL Generalizes: A Comparative Study of Foundation Model Post-training [10]

8.2 評估基準

為了評估 SFT 和 RL 的效果,作者設計了兩種基準測試。

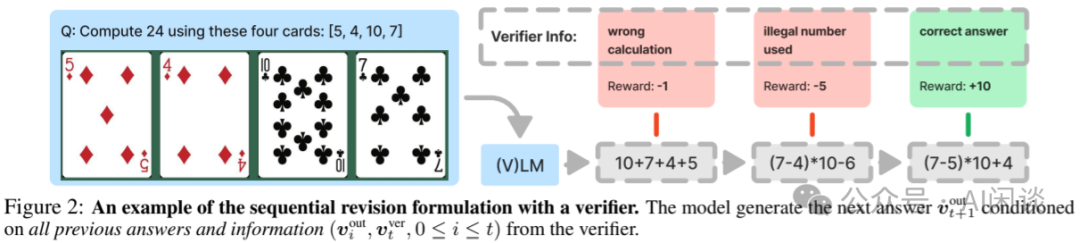

24 點紙牌基準(GeneralPoints):如下圖 Figure 2 所示,給模型展示 4 張紙牌(文字描述或圖像),模型需要用這 4 張牌上的數字,通過 +、-、x、/,湊出目標數字 24,并且每張牌只能使用一次。

- 規則變化:J、Q、K 都代表 10;或者 J、Q、K 分別代表 11、12、13。可以評估模型是僅僅記住了 JQK=10 還是理解了算術 Reasoning 的原理。

- 視覺變化:也可以將牌的顏色作為變體。訓練中使用一種顏色,評估中使用其他顏色做 OOD 測試。?

虛擬城市導航(V-IRL):如下圖 Figure 4 所示,在虛擬城市中,模型需要根據街景圖像和文字指令導航到目的地。

- 規則變化:一種是絕對空間方向('north', 'northeast', 'east', 'southeast', 'south', 'southwest', 'west', 'northwest');另一種是相對空間方向('left', 'right', 'slightly left', 'slightly right')。以便評估模型是記住了訓練數據,還是理解了空間知識。

- 視覺變化:主要是不同城市的街景圖片,訓練和評估中提供不同城市的圖片,來評估模型的視覺泛化能力。?

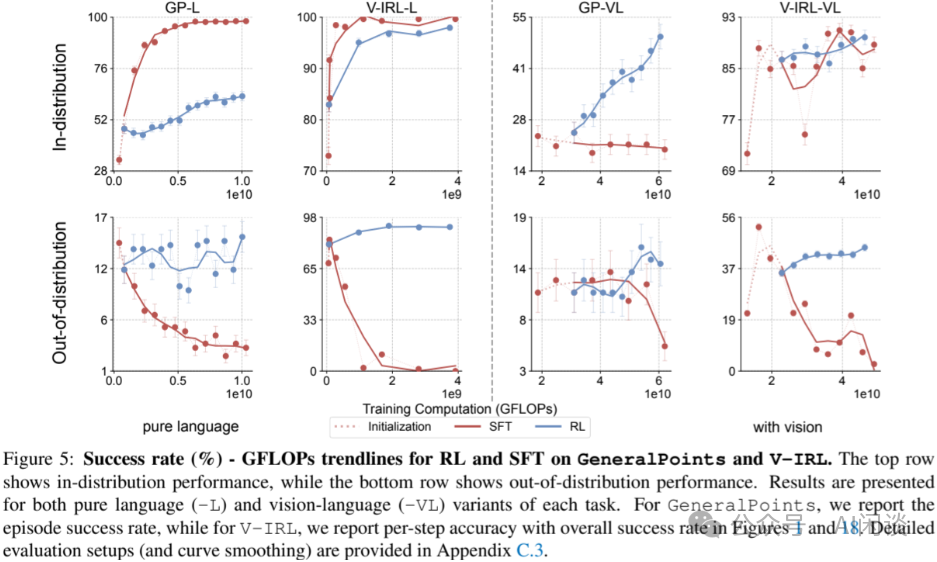

8.3 SFT 主導記憶、RL 主導泛化

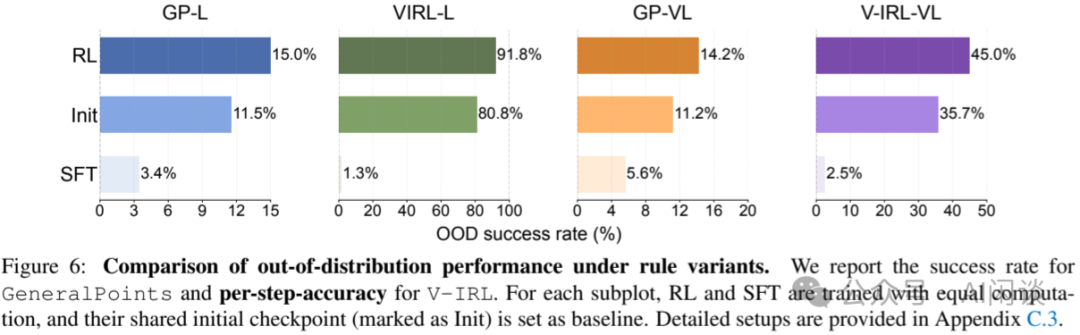

如下圖 Figure 5 所示,在兩個基準上的實驗表明(左側兩列為純語言評測,右側兩列包含視覺輸入)。其中 GP 的分布內(ID)表示都把 JQK 當做 10,分布外(OOD)表示評測時將 JQK 當做 11、12、13;V-ITL 的 ID 表示都是用絕對位置,OOD 表示評估時使用相對位置:

- 第一行所示:SFT 和 RL 均能提升在分布內的性能。

- 第二行所示:RL 可以提升在分布外(OOD)的性能,但SFT 在分布外(OOD)上表現不佳。?

如下圖 Figure 6 所示,RL 在所有 OOD 任務上均有提升,而 SFT 在所有 OOD 任務上均有下降。表明 SFT 更傾向于記憶,而非泛化。

8.4 SFT 在 RL 訓練中的作用

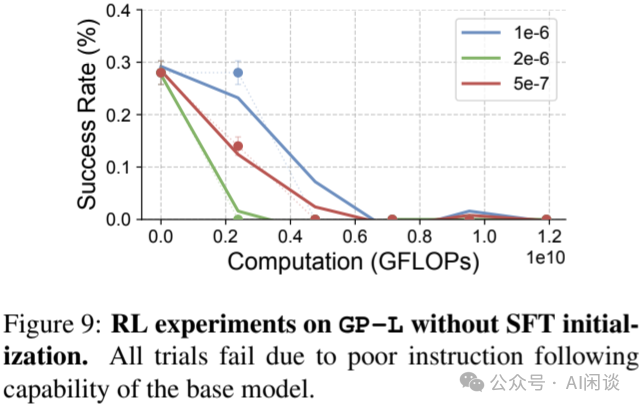

作者也進一步探索了 SFT 對 RL 的影響,如下圖 Figure 9 所示,在不具備指令遵循能力的基礎模型上進行端到端 RL 訓練,發現性能無法提升,此時通過 SFT 增強基礎模型的指令遵循能力是必須的。

九、參考鏈接

- ???https://arxiv.org/abs/2501.12948???

- ???https://qwenlm.github.io/blog/qwq-32b-preview/???

- ???https://arxiv.org/abs/2502.03387???

- ???https://github.com/GAIR-NLP/LIMO???

- ???https://arxiv.org/abs/2501.19393???

- ???https://github.com/simplescaling/s1???

- ???https://oatllm.notion.site/oat-zero???

- ???https://github.com/sail-sg/oat-zero???

- ???https://arxiv.org/abs/2502.03373???

- ???https://arxiv.org/abs/2501.17161????