ReFT:通過強化微調增強LLMs 原創

01、概述

近年來,隨著大規模語言模型(LLMs)的迅猛發展,如何讓這些模型更高效地適應特定任務和領域成為了人工智能領域的熱點話題。在這場競賽中,**強化微調(Reinforced Fine-Tuning,ReFT)**脫穎而出,為語言模型的優化提供了一種創新性的解決方案。無論是OpenAI還是字節跳動,均采用了不同的路徑對這一技術進行了深入探索,展示了ReFT在提升推理能力、優化性能上的巨大潛力。

今天,我們將帶你全面了解ReFT技術的背景、核心機制、以及它如何在實際應用中為AI模型注入新的活力。

02、什么是強化微調(ReFT)?

強化微調(ReFT)是一種結合強化學習(Reinforcement Learning, RL)與傳統微調(Fine-Tuning)的訓練方法,通過獎勵機制引導模型更高效地優化性能。

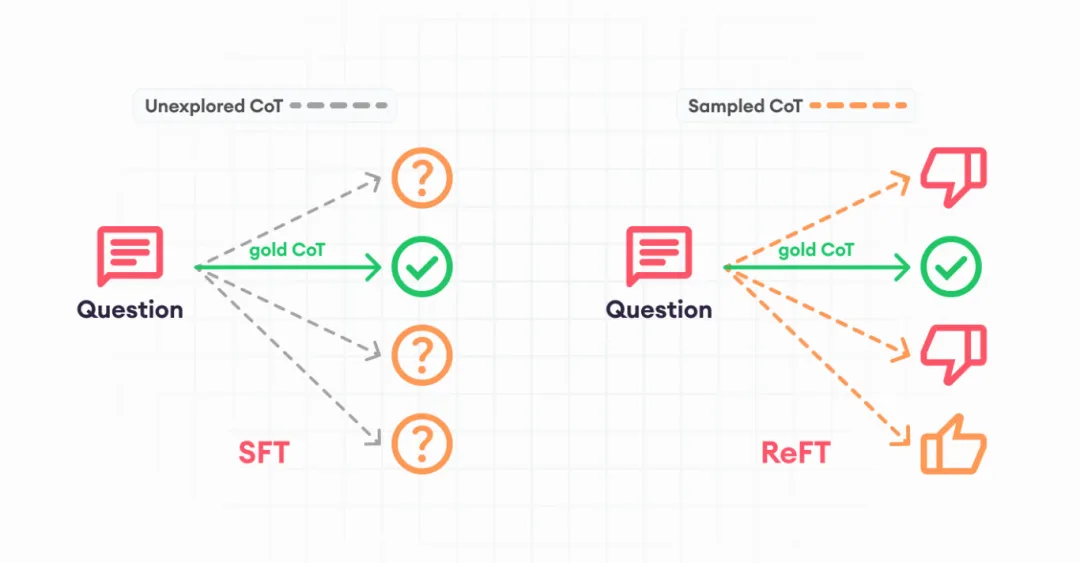

傳統的微調通常需要大量標注數據,并專注于讓模型學習特定任務的“正確答案”。而ReFT更進一步,它不僅關注“對與錯”,還讓模型理解推理過程本身。

在ReFT中,模型輸出的答案會被評分系統(也被稱為“打分器”)賦予一定的獎勵分值,這個分值反映了答案與目標期望的契合程度。通過多輪迭代訓練,模型的參數會逐步調整,以生成更高質量的推理結果。

這項技術尤其適用于數據稀缺或領域專用場景,例如醫療建議生成或復雜的數學推理任務。值得注意的是,ReFT在部分實驗中,即使僅使用少量數據(如1,100個示例),也能推動小型模型超越更大規模的傳統模型,展現出驚人的效率。

03、強化微調的工作流程

ReFT的訓練過程大致可以分為以下幾個階段:

1) 數據準備階段

在這個階段,我們需要準備一個標注數據集,并將其分為訓練集和驗證集。數據集可以包含問題、答案及推理鏈條(Chain of Thought, CoT)的標注內容。

2) 打分器指導學習

與普通微調不同,ReFT利用一個“打分器”系統對模型生成的輸出進行評估,并根據評估結果為其分配獎勵。例如,打分器可能會根據模型生成答案的準確性為其評分(如從0到1)。

- 獎勵機制:分值越高,表示模型的回答越接近預期目標。

- 迭代優化:模型根據得分信號調整參數,使后續生成的答案更符合預期。

3) 多輪訓練與驗證

在訓練過程中,模型會反復生成答案,并通過驗證集檢測其是否“真正學習了”推理能力,而非簡單記憶數據。這種反復迭代的機制確保了ReFT的高效性和穩定性。

04、OpenAI與字節跳動的ReFT實踐

1) OpenAI的強化微調探索

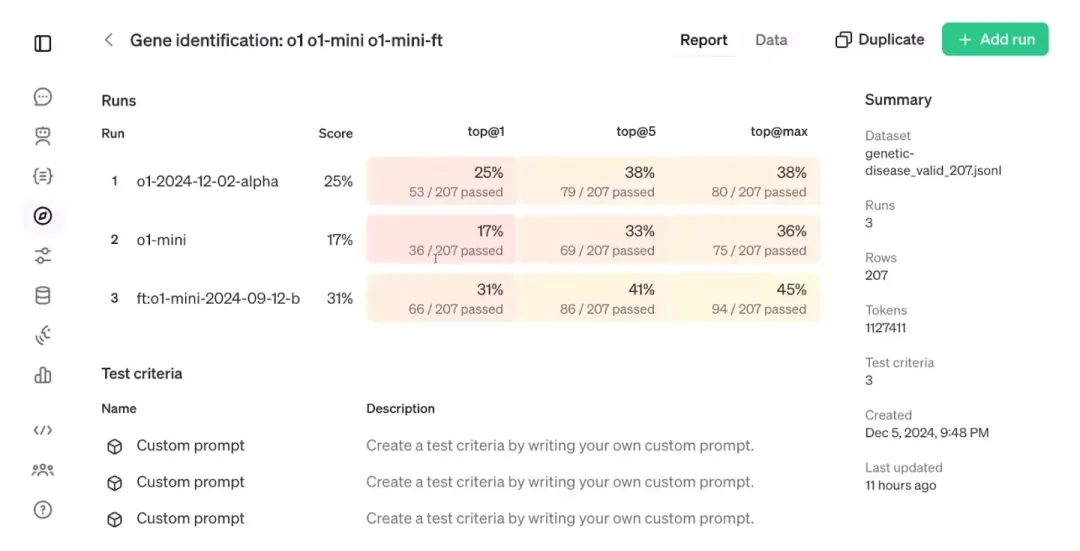

在OpenAI的“12 Days of OpenAI”活動中,他們正式推出了ReFT這一技術。與傳統微調相比,OpenAI的ReFT不僅能適應更廣泛的任務,還能用極少的數據實現優異表現。例如:

- 小樣本高效性:即使只有1,100個訓練示例,ReFT也能將小型模型(如o1-mini)的性能提升到超越更大模型(如標準o1)的水平。

- 節省計算資源:相比于需要大量標注數據的傳統方法,ReFT的獎勵機制使得模型能夠通過更少的訓練輪次獲得更高效的優化。

OpenAI的研究表明,ReFT可以快速適應特定的風格或領域(如醫療建議、分類任務等),為行業帶來了更靈活的語言模型優化方案。

2) 字節跳動的強化微調方案

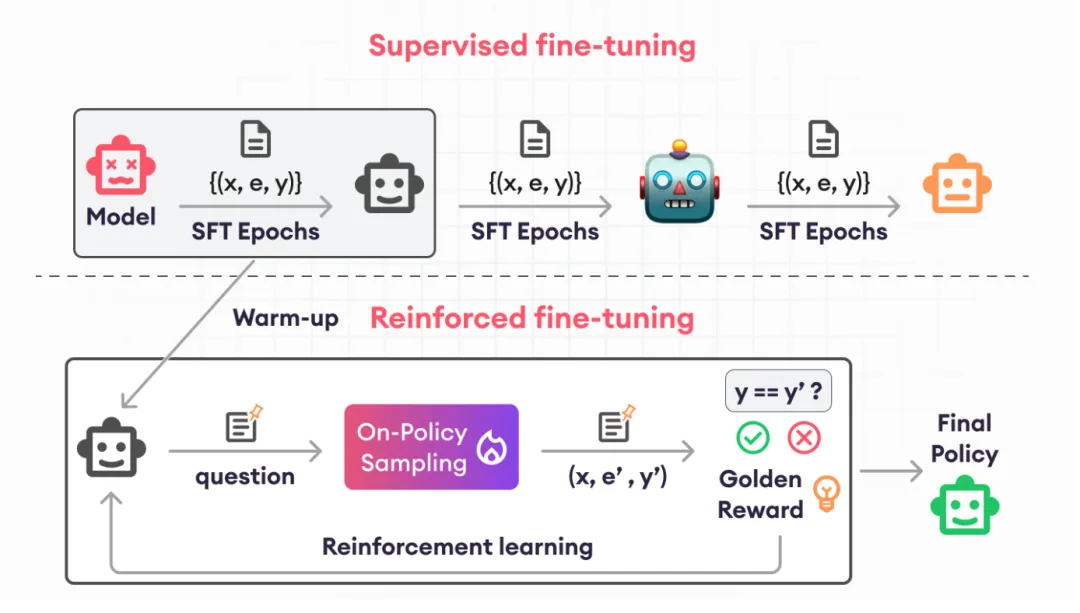

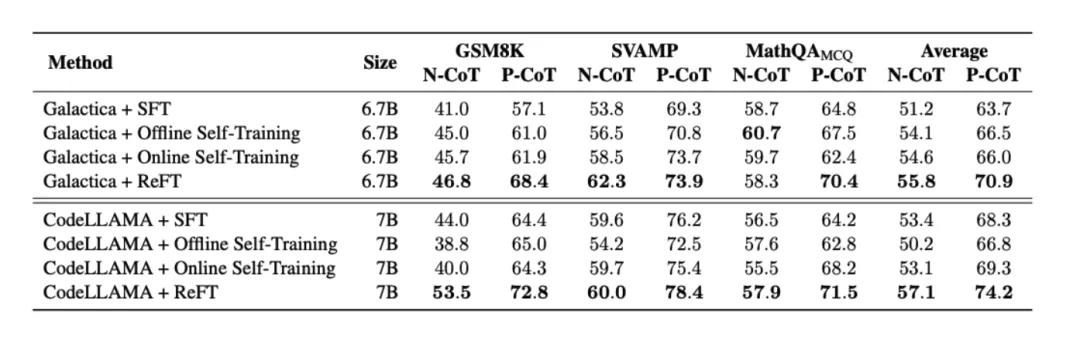

2024年初,字節跳動團隊提出了自己的ReFT訓練方法,并在數學推理任務上實現了重大突破。其獨特之處在于結合了**監督微調(SFT)**和強化學習(RL)的優勢:

- 熱身階段(Warm-Up Stage):通過幾輪SFT,讓模型學習基本的數學解題能力。

- 強化學習階段:采用近端策略優化(PPO)算法,讓模型在探索多種正確解法和推理路徑時不斷優化自身性能。

字節跳動的研究進一步表明,ReFT不需要額外的人類標注獎勵系統,可以直接利用現有的標注數據完成訓練。這種方法的高效性和兼容性使其成為解決復雜推理任務的理想工具。

05、ReFT與傳統微調方法的對比

為了更直觀地展示ReFT的優勢,我們將其與傳統的監督微調(SFT)進行對比:

06、ReFT的實際應用及未來展望

1) 實際應用

ReFT已經在多個領域展現出其巨大的潛力:

- 醫療領域:通過獎勵機制微調,模型可以更準確地生成醫學建議。

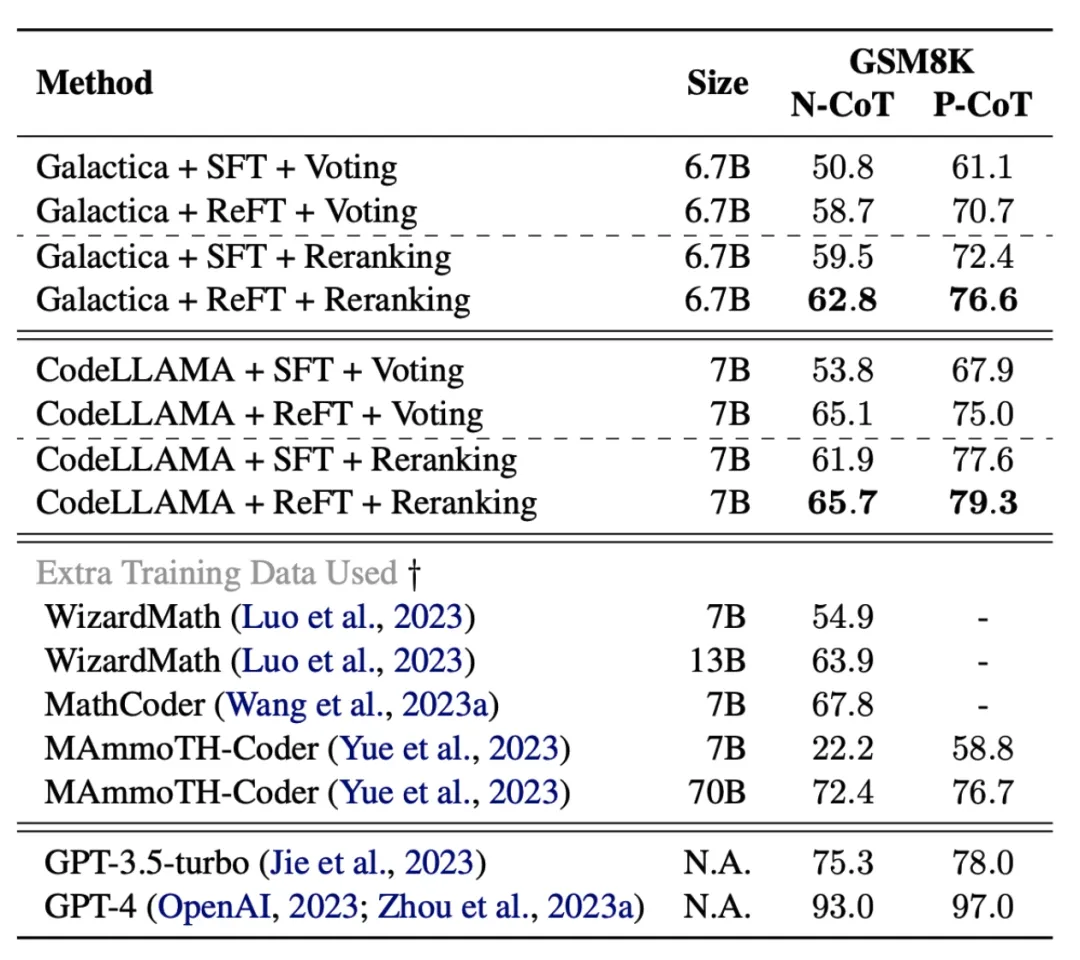

- 數學推理:ReFT在數學基準測試(如GSM8K)中的表現顯著優于傳統方法。

- 低資源場景:在數據有限的情況下,ReFT依然能快速提升模型性能,特別適合中小型企業或非盈利研究機構。

2) 挑戰與改進方向

盡管ReFT已經取得了顯著的成就,但它仍面臨一些挑戰:

- 獎勵黑客問題:模型可能通過不正確的推理路徑獲取高分,影響最終結果的可信度。

- 計算資源需求:盡管數據需求較少,但ReFT的訓練仍需要較高的計算資源支持。

未來,進一步優化獎勵機制,并探索更加輕量化的訓練框架,將是推動ReFT發展的重要方向。

07、總結

強化微調(ReFT)代表了一種更智能、更高效的語言模型訓練方法,它不僅能在有限數據下實現出色性能,還能推動模型更深入地理解推理過程。無論是OpenAI還是字節跳動的探索,都展示了ReFT在實際應用中的巨大潛力。

在人工智能領域,ReFT的成功也為我們提供了一個重要的啟示:通過強化學習和微調的結合,我們能夠更有效地釋放語言模型的潛能,推動技術不斷進步。

參考:

本文轉載自公眾號Halo咯咯 作者:基咯咯

原文鏈接:??https://mp.weixin.qq.com/s/6RAPVP7UPDdwpjqYgAC9gw??