谷歌通過數據增強、對比調優,減少多模態模型幻覺

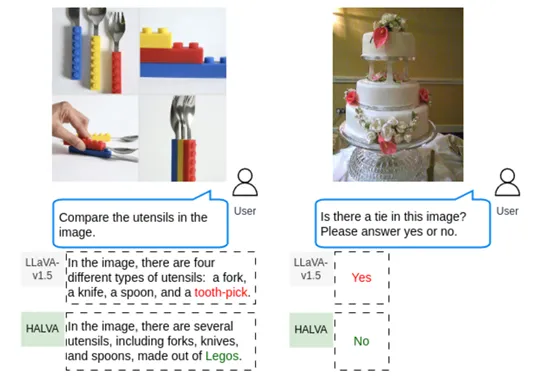

隨著Gemini、GPT-4o等模型的出現,具備看、聽、說的多模態大模型成為了新的主流。由于訓練數據復雜、模型架構過于復雜,在生成、識別內容時很容易出現錯誤描述也稱為“幻覺”,例如,當看到一張包含刀、叉和勺子的餐具圖片時,模型會錯誤地描述為牙簽。

為了解決這個難題,谷歌DeepMind、谷歌云AI研究、向量研究所和皇后大學的研究人員通過數據增強和對比調優的方法開發了HALVA模型。

論文地址:https://arxiv.org/abs/2405.18654

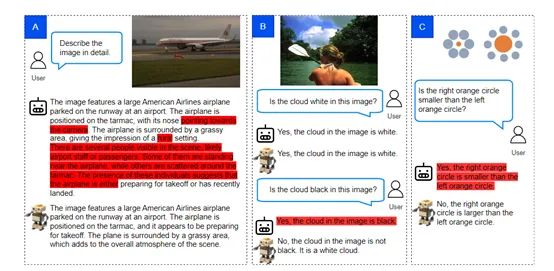

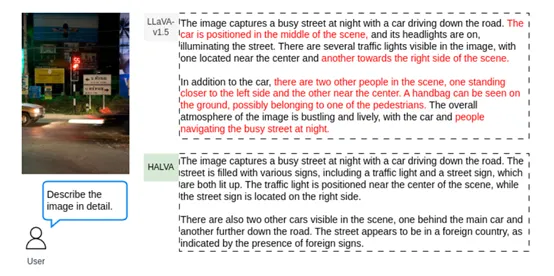

HALVA的核心思想是通過對比學習,來提高模型對真實和幻覺對象的區分能力。這種方法利用正確的對象描述和對應的幻覺描述來訓練多模態模型,引導模型識別和生成與輸入圖像更加一致的描述。

首先,HALVA接收來自生成數據增強模塊的輸出,這些輸出包括正確描述和幻覺化描述的對。這些成對的數據點是通過對原始圖像進行智能的數據增強生成的,其中包括替換圖像中的對象集合,引入了不存在的共現概念。例如,一個原本包含水果籃的圖像可能會被增強為包含一個虛構的魔法球。

然后,HALVA將視覺-語言輸入對送入預訓練的多模態模型中。這些輸入包括圖像特征和相關的語言描述。多模態模型會對每個輸入計算輸出序列的概率分布,生成兩組概率:一組對應于正確的描述,另一組對應幻覺錯誤的描述。

HALVA定義了一個對比損失函數,該函數基于正確描述和幻覺化描述的相對概率。損失函數的目標是最大化正確描述的概率,同時最小化幻覺化描述的概率。通過反向傳播和梯度下降,模塊優化損失函數,調整模型參數以減少幻覺描述的生成。

為了保證模型在調整過程中不會偏離其原始的預訓練狀態,對比調整模塊引入了KL散度作為正則化項。這一步驟確保了模型在減輕幻覺化問題的同時,保持了其在一般視覺-語言任務上的性能。

在整個對比調整過程是端到端的,從輸入的視覺-語言對到輸出的損失函數,整個過程是連貫的,允許模型在訓練過程中學習如何更好地區分真實和幻覺對象。

訓練數據方面,HALVA是基于VG提供了豐富的視覺信息和語言描述,包含108K張圖像及其詳細注釋的對象中心圖像數據集。正確數據描述是Gemini Vision Pro通過 VG 數據集生成。

幻覺描述則比較麻煩一些,通過VG的封閉和開放兩個數據集,封閉集是基于 VG 數據集中對象的已知共現關系來生成的,而開放集則是通過直接提示大語言模型來生成與原始對象共現的新對象。在生成了正確描述和幻覺描述的樣本對之后,用于訓練HALVA模型。

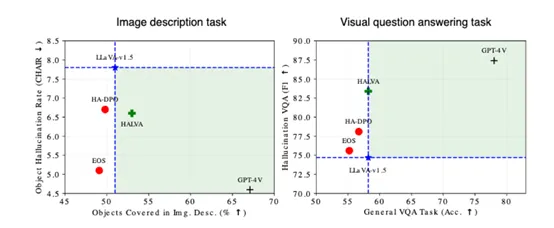

研究人員在CHAIR、MME - Hall、AMBER和 MMHal – Bench等平臺中對HALVA進行了綜合評估。結果顯示,HALVA在減少模型幻覺方面非常出色,同時在一般視覺-語言任務上也表現出了良好的性能。

例如,在AMBER數據集上,HALVA在幻覺率指標上明顯優于基礎模型LLaVA-v1.5;在MMHal – Bench測試中,HALVA比基于RLHF、SFT 或 DPO的方法更有效地緩解了模型的幻覺問題。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區