HippoRAG 2發布,GraphRAG退位!

?為解決現有檢索增強生成(RAG)系統在模擬人類長期記憶的動態和關聯性方面的局限性,一種新型框架HippoRAG 2提出并將開源!

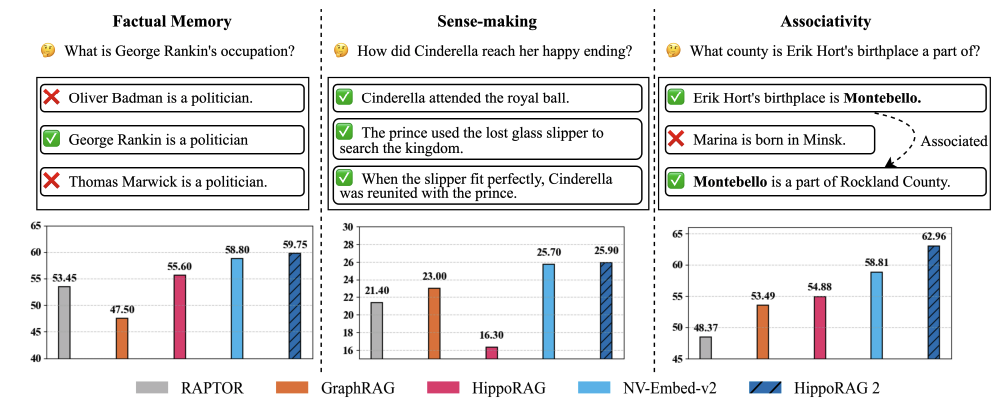

在三個關鍵維度上評估持續學習能力:事實記憶、感知構建和關聯性。HippoRAG 2在所有基準類別中均超越了其他方法(RAPTOR、GraphRAG、LightRAG、HippoRAG),使其更接近真正的長期記憶系統。?

HippoRAG 2框架的核心思想:HippoRAG 2基于HippoRAG的個性化PageRank算法,通過深度段落整合和更有效的在線LLM使用,推動RAG系統更接近人類長期記憶的效果。

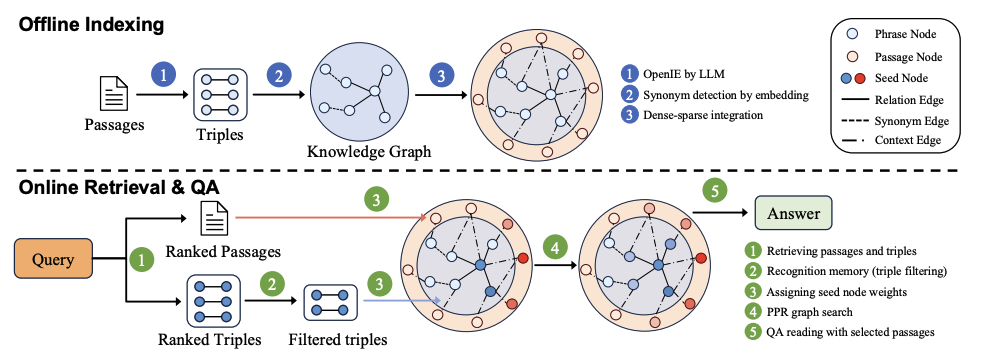

離線索引:

- 使用LLM從段落中提取三元組,并將其整合到開放知識圖譜(KG)中。

- 通過嵌入模型檢測同義詞,并在KG中添加同義詞邊。

- 將原始段落與KG結合,形成包含概念和上下文信息的開放KG。

在線檢索:

- 使用嵌入模型將查詢與KG中的三元組和段落鏈接,確定圖搜索的種子節點。

- 通過LLM過濾檢索到的三元組,保留相關三元組。

- 應用個性化PageRank算法進行上下文感知檢索,最終為下游問答任務提供最相關的段落。

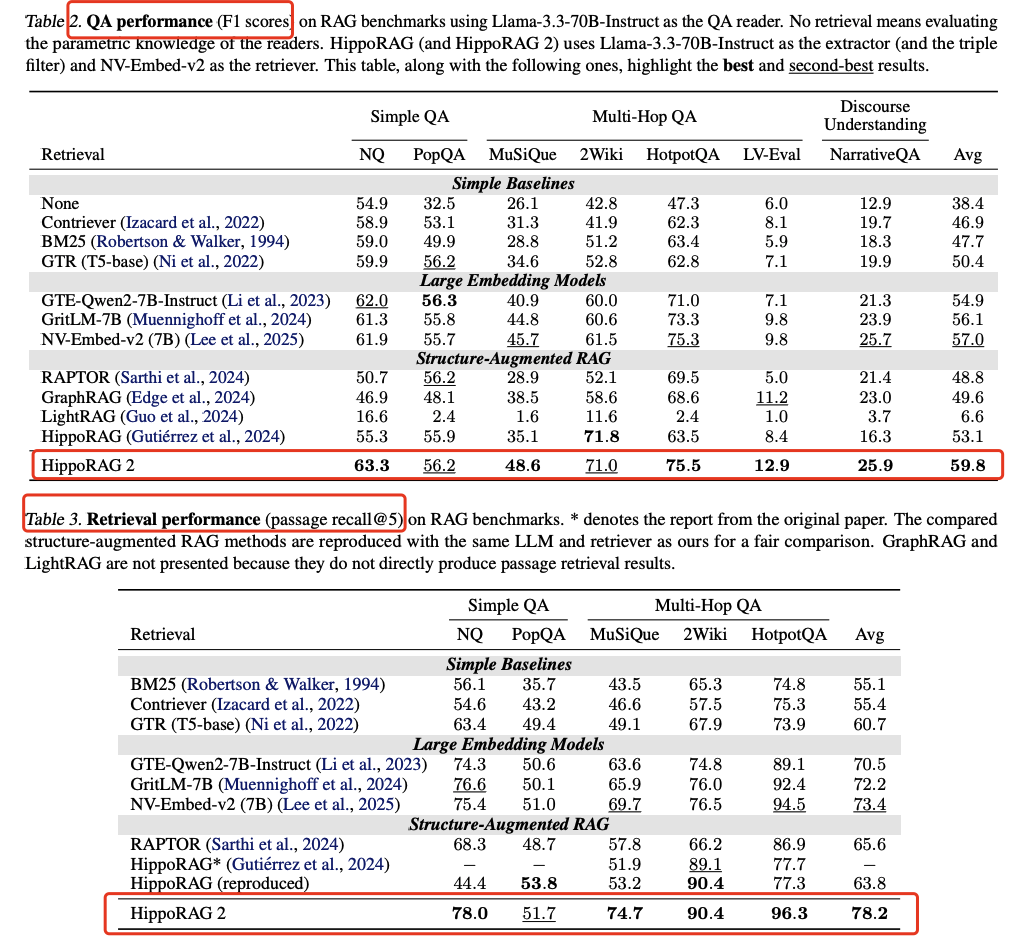

基線方法:包括經典檢索器(BM25、Contriever、GTR)、大型嵌入模型(GTE-Qwen2-7B-Instruct、GritLM-7B、NV-Embed-v2)和結構增強RAG方法(RAPTOR、GraphRAG、LightRAG、HippoRAG)。

評估指標:問答任務使用F1分數,檢索任務使用passage recall@5。

性能提升:HippoRAG 2在所有基準類別上均超越其他方法,平均F1分數比標準RAG高出7個百分點,特別是在關聯記憶任務上表現突出。

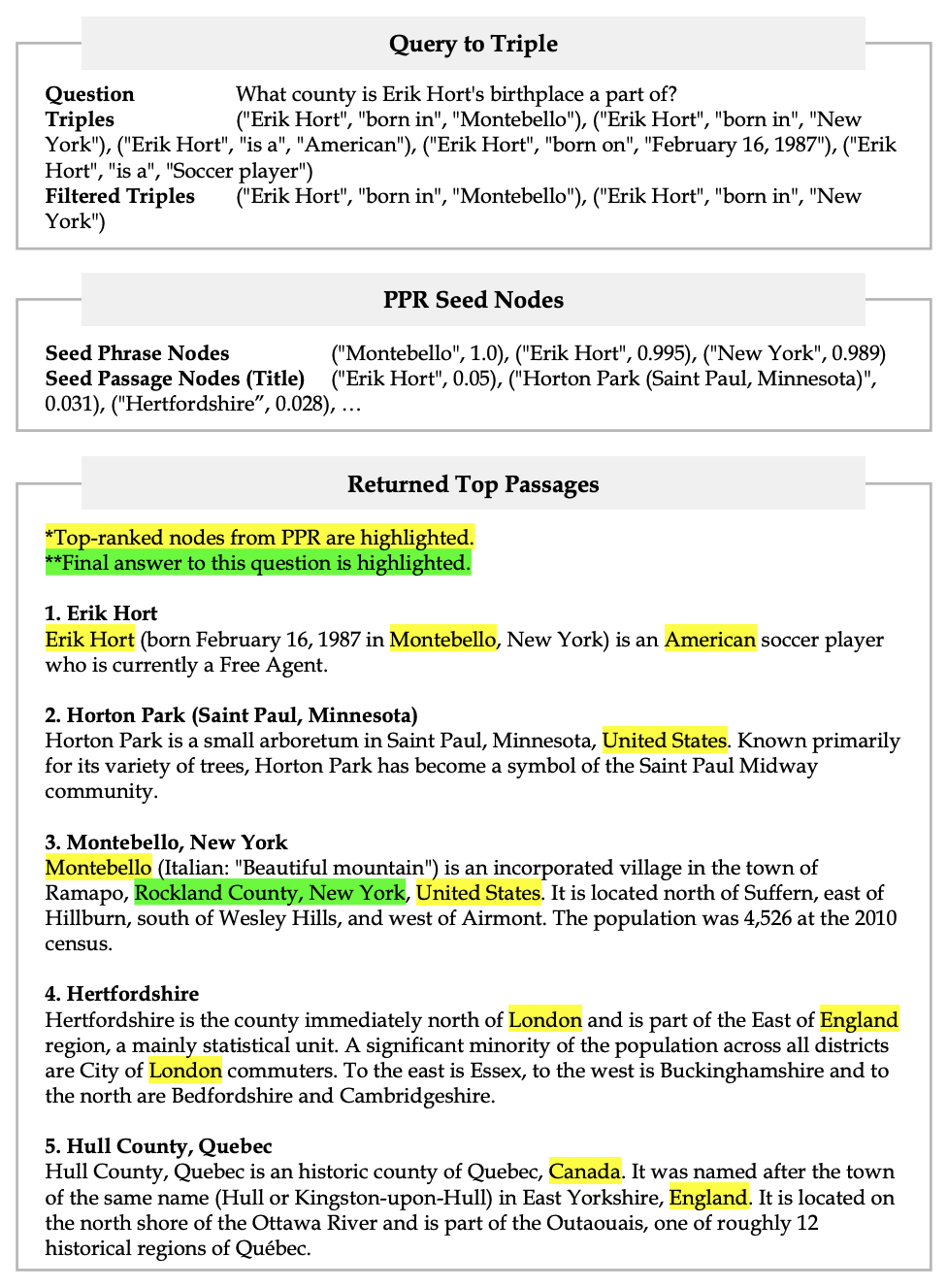

一個HippoRAG 2 pipeline示例

https://github.com/OSU-NLP-Group/HippoRAG

From RAG to Memory: Non-Parametric Continual Learning for Large Language Models

https://arxiv.org/pdf/2502.14802本文轉載自??PaperAgent??

贊

收藏

回復

分享

微博

QQ

微信

舉報

回復

相關推薦