HippoRAG:協同LLM、KG與PPR的新型開源檢索框架,R@5比RAPTOR提高28%

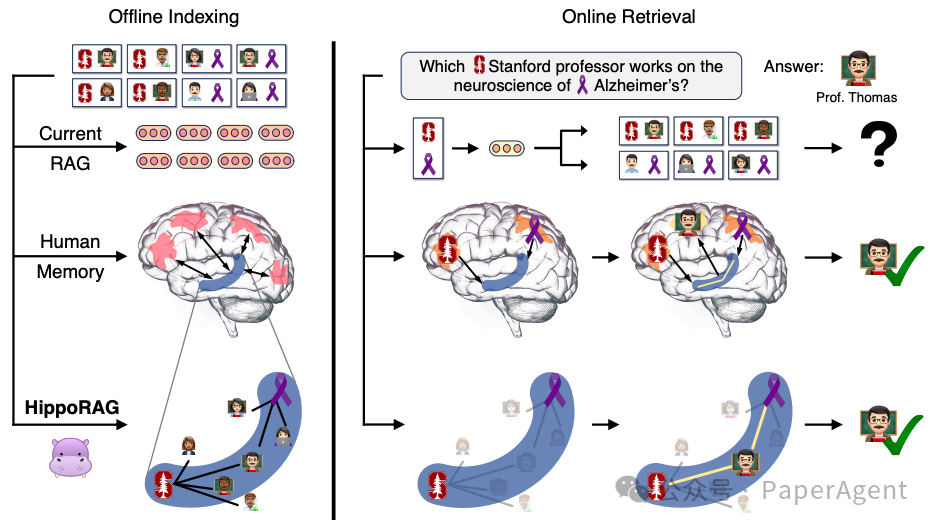

大型語言模型(LLMs)在預訓練后仍難以有效整合大量新經驗,當前使用的檢索增強生成(RAG)方法無法幫助LLMs跨段落整合新知識。人類大腦通過海馬體的索引結構來實現關聯記憶能力,這是當前RAG系統所缺乏的。

知識整合與RAG。需要知識整合的任務對于當前的RAG系統來說特別具有挑戰性。在上述例子中,從描述可能成千上萬的斯坦福教授和阿爾茨海默癥研究人員的段落中找到一位從事阿爾茨海默癥研究的斯坦福教授。由于當前方法孤立地對段落進行編碼,除非一個段落同時提到了這兩個特征,否則它們很難識別出托馬斯教授。相比之下,大多數熟悉這位教授的人會由于我們大腦的聯想記憶能力而迅速記住他,這種能力被認為是由圖中C形海馬體(藍色)所描繪的索引結構驅動的。受這種機制的啟發,HippoRAG允許大型語言模型構建并利用類似的關聯圖來解決知識整合任務。

HippoRAG是一個受人類長期記憶的海馬索引理論啟發的新型檢索框架。HippoRAG旨在通過模仿人類大腦中新皮層和海馬體的不同角色,來實現更深層次、更高效的知識整合,整個框架包括離線索引階段與在線檢索階段。

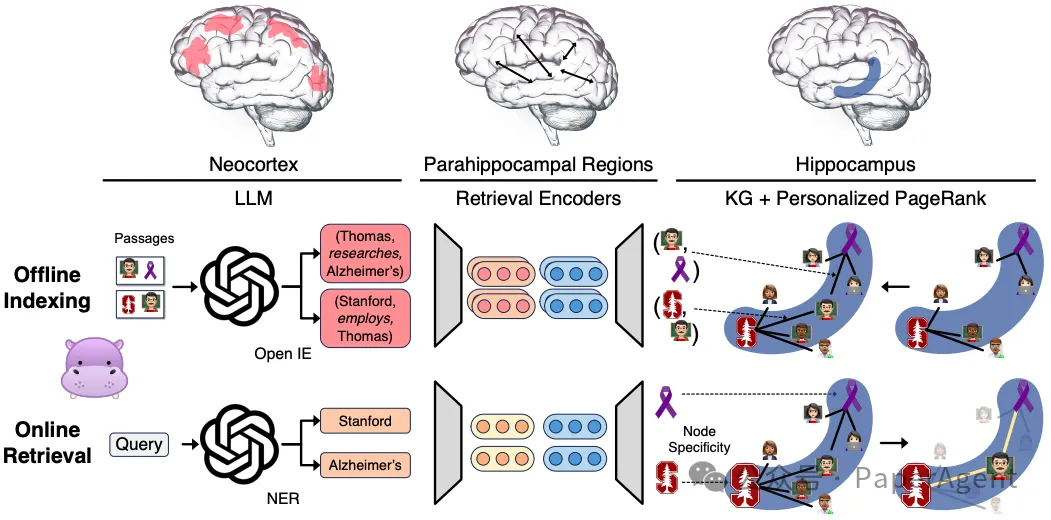

詳細的HippoRAG方法論。模擬人類長期記憶的三個組成部分,以模仿其模式分離和完成功能。對于離線索引(中間),使用LLM處理段落,將其轉化為開放知識圖譜(KG)三元組,然后添加到我們的人工海馬體索引中,而合成海馬旁回區域(PHR)檢測同義性。在上面的例子中,涉及Thomas教授的三元組被提取并整合到知識圖譜中。對于在線檢索(底部),的LLM新皮質從查詢中提取命名實體,而海馬旁回檢索編碼器將它們鏈接到我們的海馬體索引。然后我們利用個性化PageRank算法來實現基于上下文的檢索,并提取Thomas教授。?

離線索引(Offline Indexing):

- 新皮層模擬:使用一個指令調整的大型語言模型(LLM),作為人工新皮層,通過開放信息提取(OpenIE)從文檔集合中提取知識圖譜(KG)三元組。這一過程被稱為開放信息提取,它從文檔中提取名詞短語作為離散信號,而不是密集的向量表示,從而實現更細粒度的模式分離。

- 知識圖譜構建:構建的KG是無模式的(schemaless),允許更靈活的模式分離和新信息整合。

- 海馬索引構建:使用標準的檢索編碼器(retrieval encoders),這些編碼器為KG中的相似但不完全相同的名詞短語提供額外的邊,幫助下游的模式完成。

在線檢索(Online Retrieval):

- 查詢處理:LLM基于新皮層從查詢中提取一組顯著的命名實體(query named entities),這些實體隨后通過檢索編碼器與KG中的節點鏈接。

- 模式完成:選定的查詢節點成為部分線索,人工海馬體執行模式完成,通過個性化PageRank(PPR)算法在KG上運行,使用查詢概念作為種子,整合跨文檔的信息進行檢索。

- 個性化PageRank(PPR):PPR算法是一種PageRank的變體,它只通過一組用戶定義的源節點(即查詢節點)在圖中分布概率。這使得PPR輸出只偏向于查詢節點集,模仿海馬體從特定部分線索中提取相關信號。

HippoRAG展示了處理當前方法難以觸及的新類型場景的潛力:

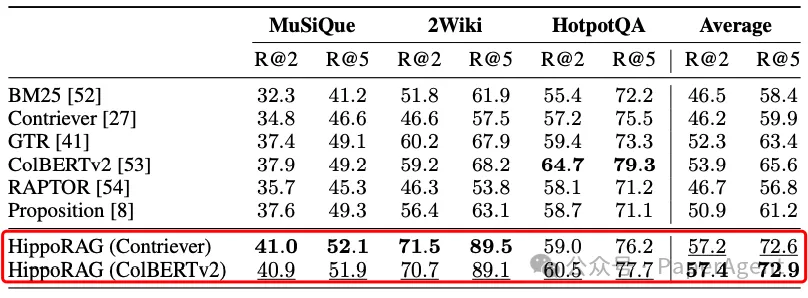

- HippoRAG在多跳問答(QA)基準測試中表現出色,相較于現有RAG方法顯著提高了性能,最高可達20%。

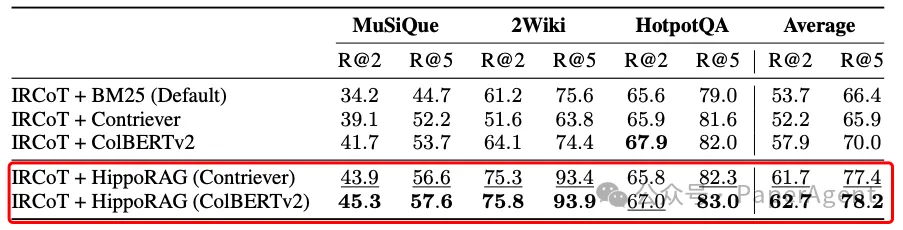

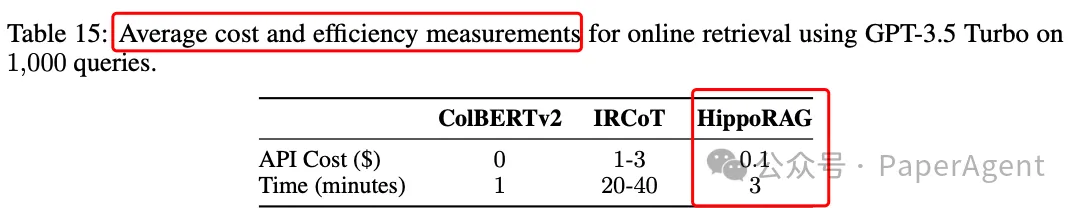

- 與迭代檢索方法如IRCoT相比,HippoRAG的單步檢索在成本上節省10-30倍,在速度上快6-13倍,并且與IRCoT結合使用可以帶來進一步的顯著增益。?

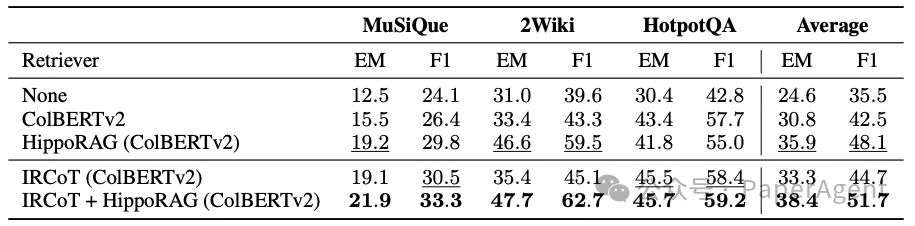

單步檢索性能。HippoRAG在MuSiQue和2WikiMultiHopQA上的表現超過了所有基線,并且在挑戰性較小的HotpotQA數據集上達到了可比的性能。?

多步檢索性能。將HippoRAG與IRCoT等標準多步檢索方法相結合,在所有三個數據集上都取得了顯著的改進。

問答性能。HippoRAG的問答改進與其在單步檢索(行1-3)和多步檢索(行4-5)的檢索改進相關聯。

成本與速度評測

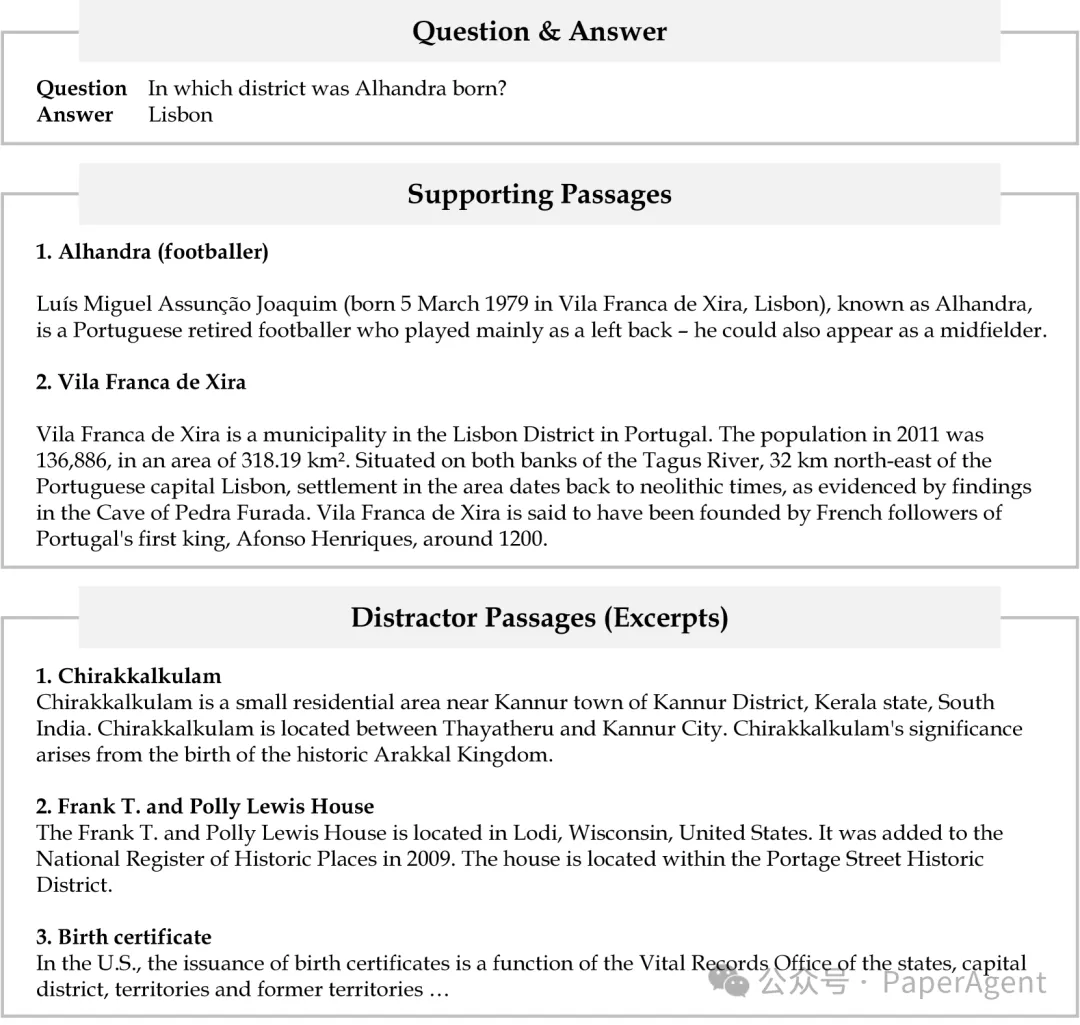

圖3:HippoRAG流程示例(問題和注釋),(頂部)一個示例問題及其答案。(中間和底部)這個問題的支持段落和干擾段落。解決這個問題需要兩個支持段落。干擾段落的摘錄與問題中提到的“區”有關。

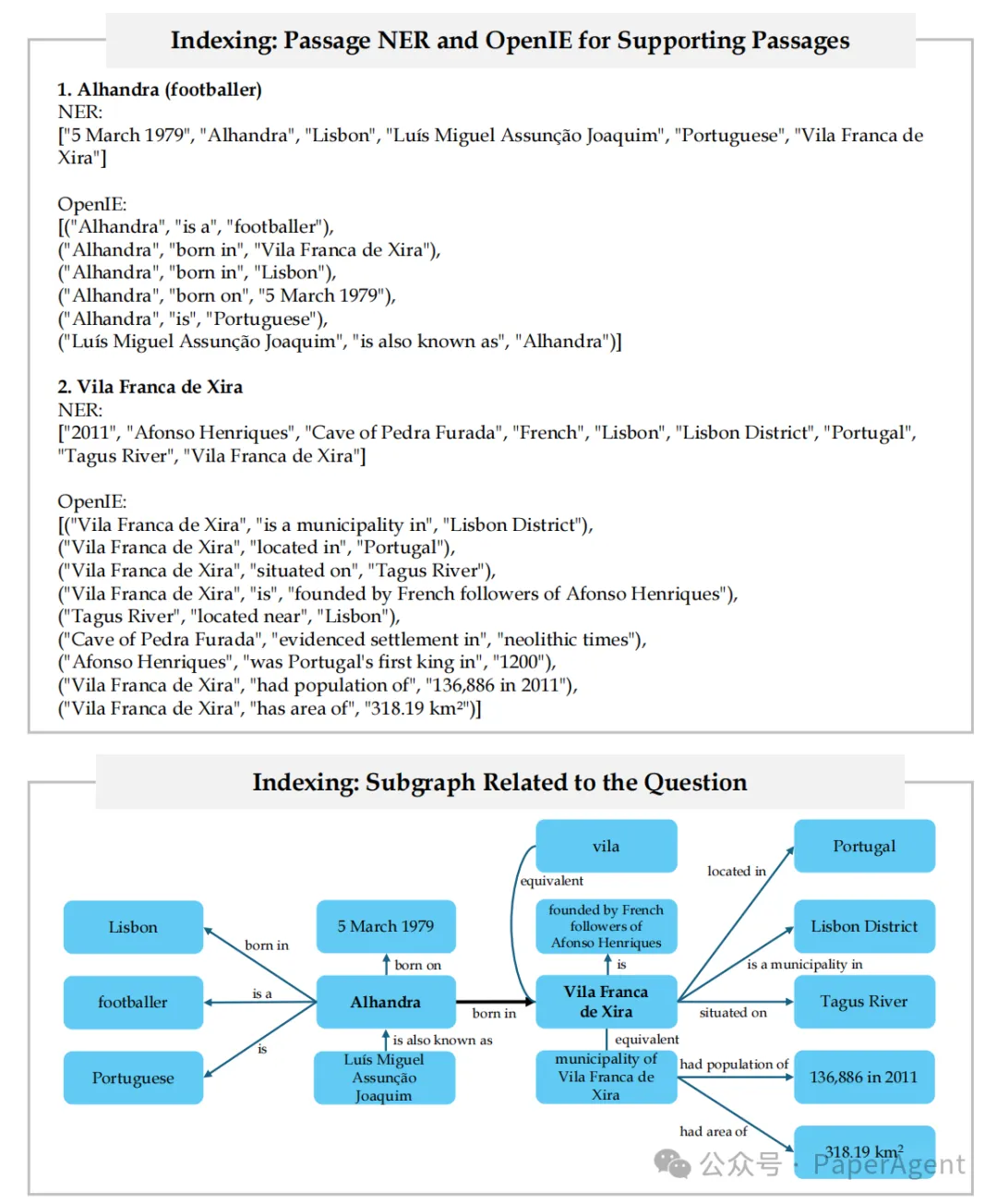

圖4:HippoRAG流程示例(索引)。對語料庫中的每個段落依次進行命名實體識別(NER)和開放信息抽取(OpenIE)。因此,為整個語料庫形成了一個開放的知識圖譜。只展示了知識圖譜(KG)中與此相關的子圖。

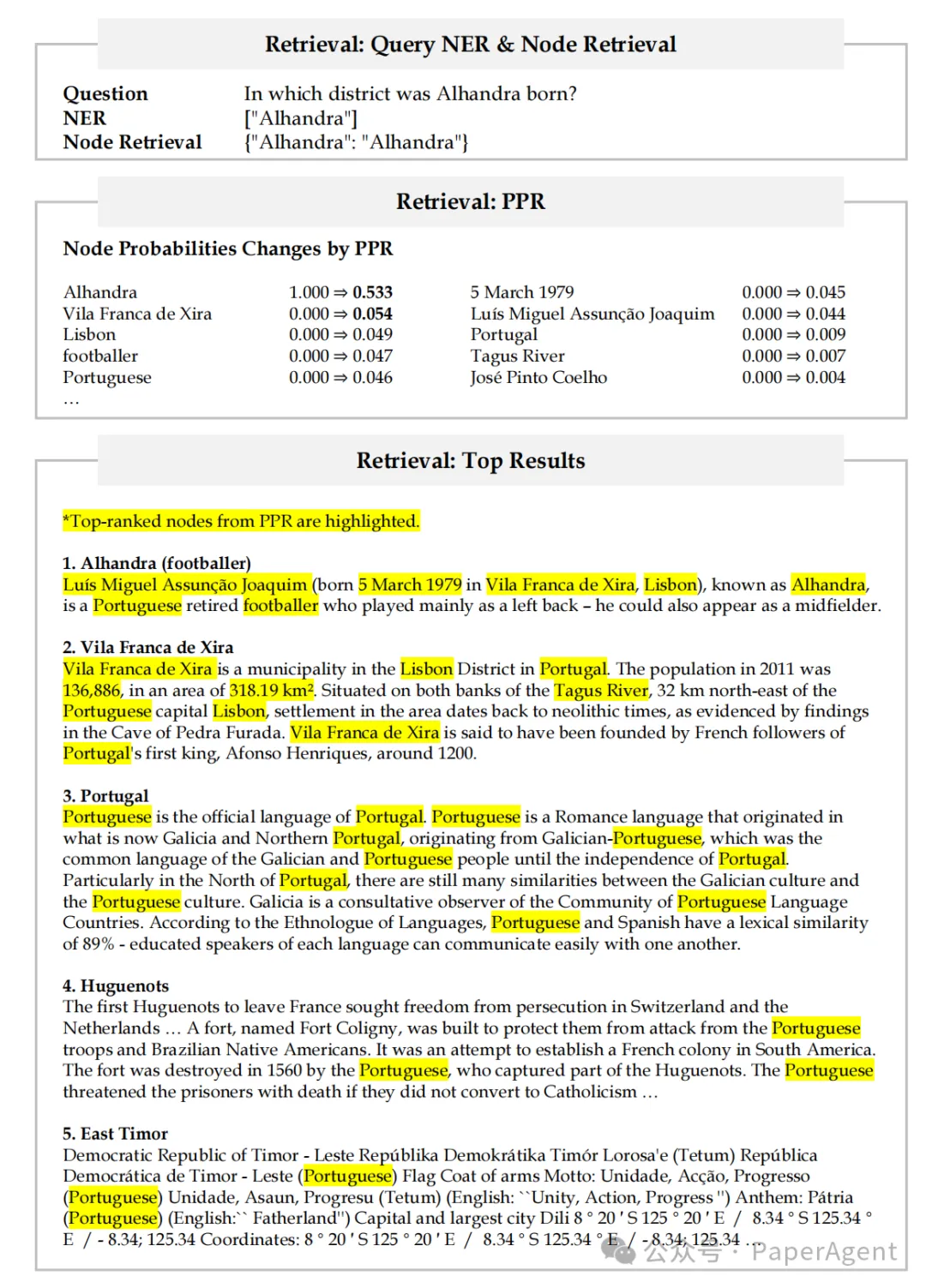

圖5:HippoRAG流程示例(檢索)。在檢索過程中,首先從問題中提取查詢的命名實體(頂部),然后使用檢索編碼器選擇查詢節點。在本例中,查詢命名實體的名稱“Alhandra”與其知識圖譜(KG)中的節點相對應。(中間)然后我們根據檢索到的查詢節點設置PPR的個性化概率。PPR運行后,查詢節點的概率根據圖4中的子圖進行分配,導致一些概率質量落在節點“Vila France de Xira”上。(底部)然后,這些節點概率被加總到它們出現的段落上,以獲得段落級別的排名。PPR后排名最高的節點在排名最高的段落中被突出顯示。

HippoRAG: Neurobiologically Inspired Long-Term Memory for Large Language Models

https://arxiv.org/pdf/2405.14831

https://github.com/OSU-NLP-Group/HippoRAG本文轉載自??PaperAgent??,作者: PaperAgent