理解什么是推理模型,看懂這篇就夠了 精華

DeepSeek-R1、OpenAI o3-mini 和 Google Gemini 2.0 Flash Thinking 是通過(guò)“推理”框架將 LLMs 擴(kuò)展到新高度的典范。

它們標(biāo)志著從擴(kuò)展訓(xùn)練時(shí)計(jì)算轉(zhuǎn)變?yōu)閿U(kuò)展測(cè)試時(shí)計(jì)算的范式轉(zhuǎn)變。

在這篇文章中,有超過(guò) 40 個(gè)自定義視覺(jué)效果,你將探索推理領(lǐng)域、測(cè)試時(shí)計(jì)算,并深入研究 DeepSeek-R1。

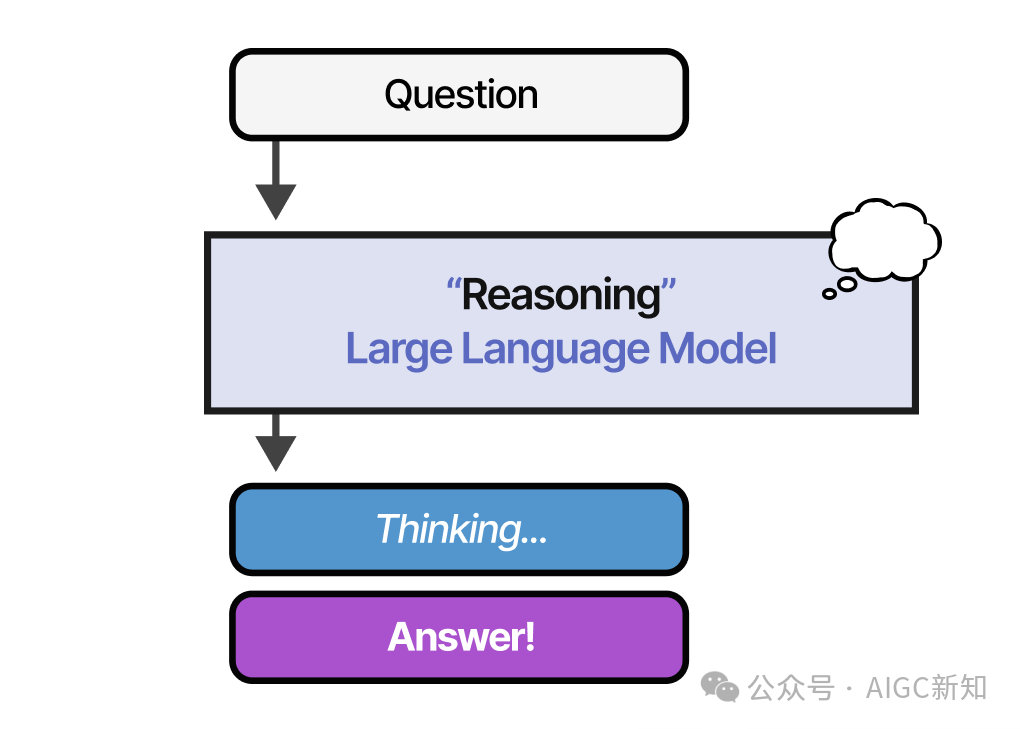

什么是推理 LLMs?

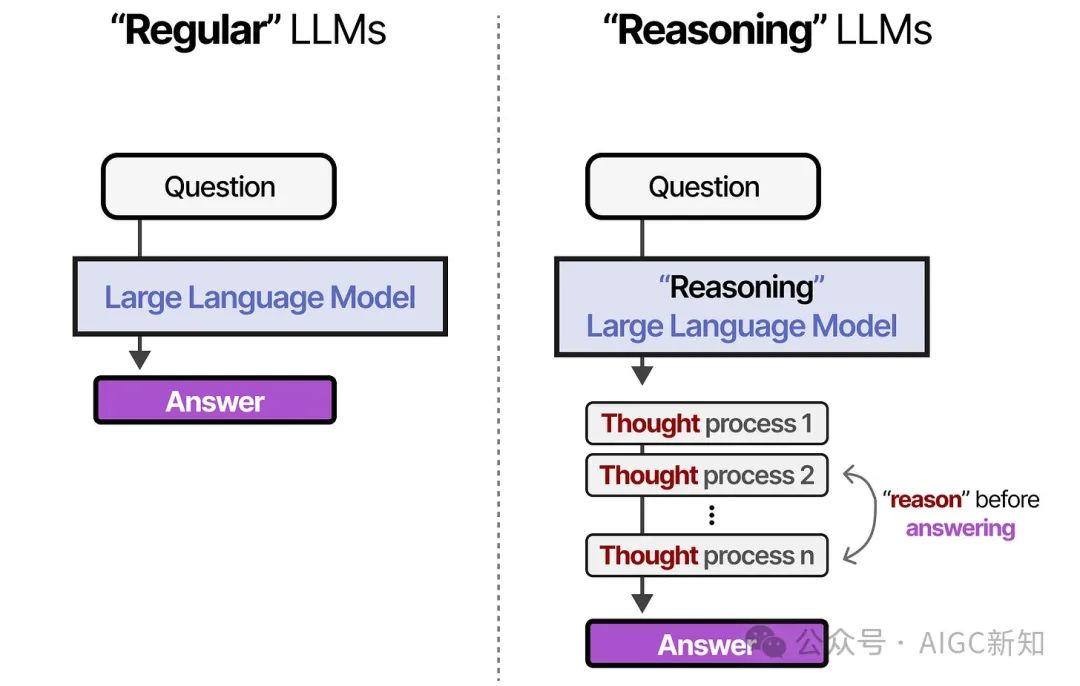

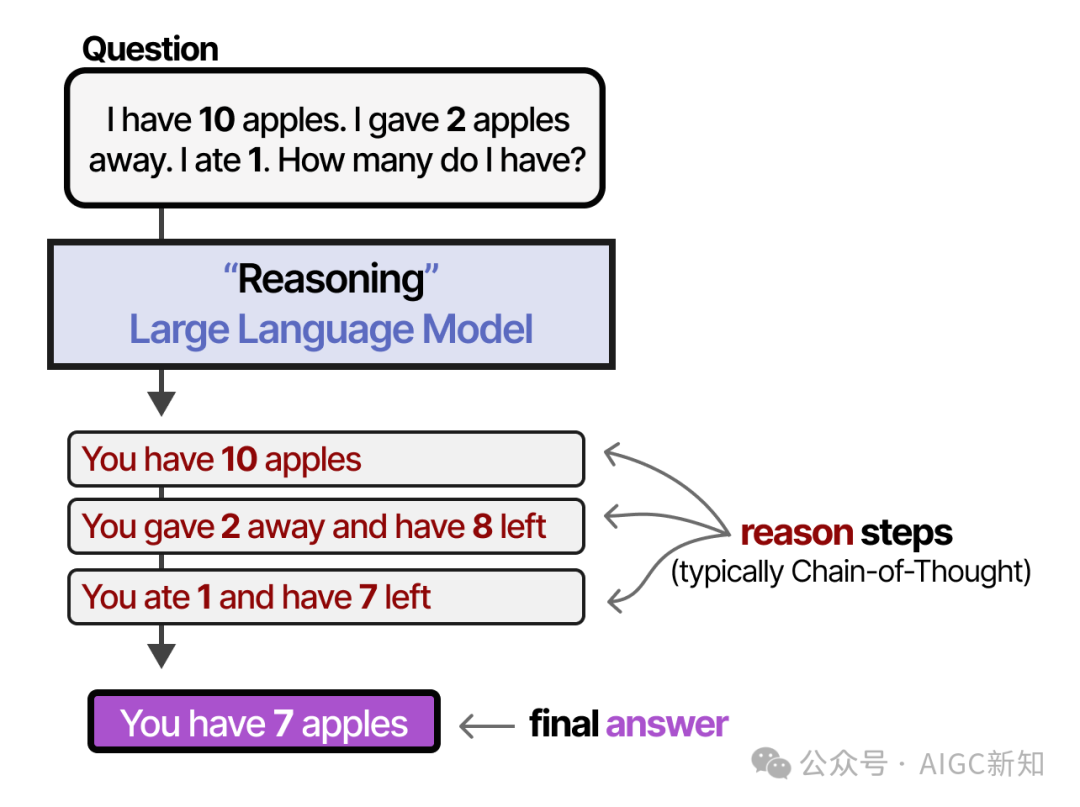

與常規(guī)的LLMs相比,推理LLMs通常會(huì)在回答給定問(wèn)題之前將問(wèn)題分解為更小的步驟(通常稱為推理步驟或思維過(guò)程)。

那么,“思考過(guò)程”、“推理步驟”或“思維鏈”究竟意味著什么呢?

盡管我們可以哲學(xué)地探討LLMs是否真的能夠像人類一樣思考 ,這些推理步驟將過(guò)程分解為更小的、結(jié)構(gòu)化的推斷。

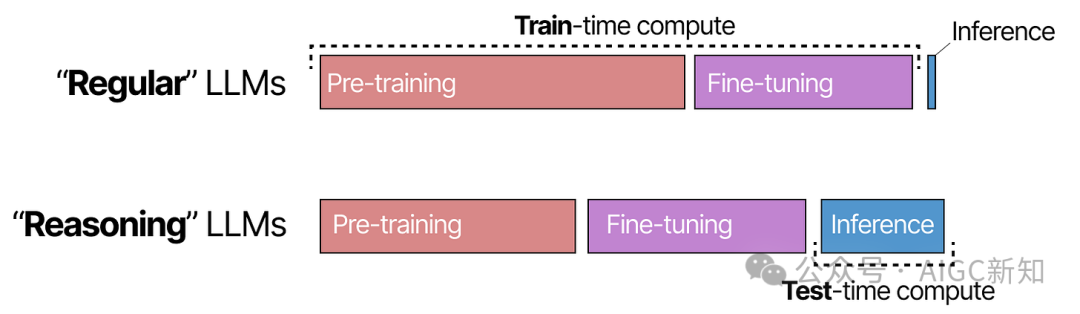

為了理解如何創(chuàng)建推理LLMs,我們首先探討從關(guān)注訓(xùn)練( 訓(xùn)練 -時(shí)間計(jì)算)轉(zhuǎn)向推理( 測(cè)試 -時(shí)間計(jì)算)的范式轉(zhuǎn)變。

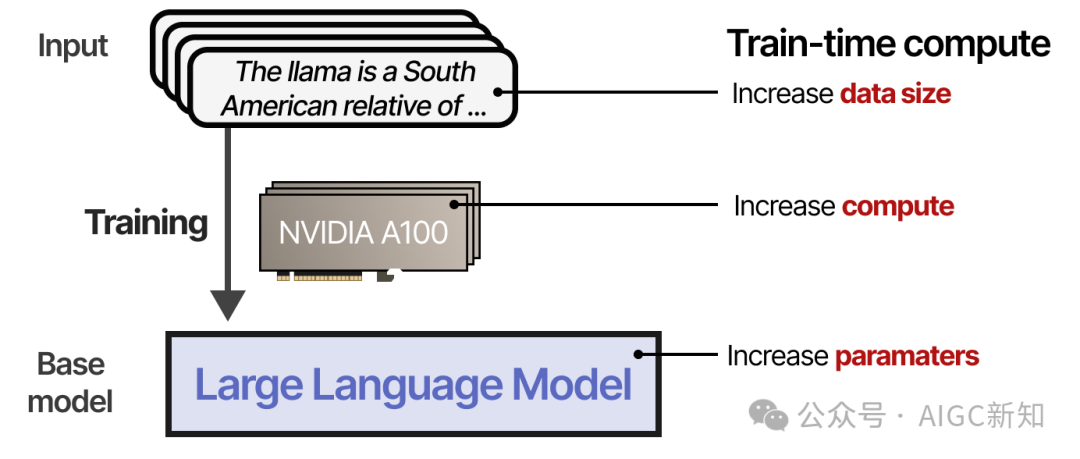

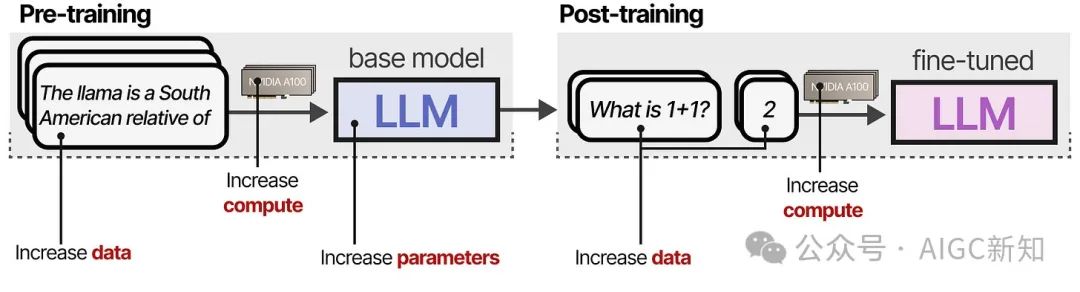

什么是訓(xùn)練時(shí)間計(jì)算?

直到 2024 年中,為了在預(yù)訓(xùn)練階段提高LLMs的表現(xiàn),開(kāi)發(fā)者們?cè)黾右韵聟?shù)的大小:

- 模型(參數(shù)數(shù)量 )

- 數(shù)據(jù)集(token數(shù)量 )

- 計(jì)算能力(浮點(diǎn)運(yùn)算數(shù)量)

綜合起來(lái),這被稱為訓(xùn)練計(jì)算量 ,指的是預(yù)訓(xùn)練數(shù)據(jù)是“人工智能的化石燃料”的概念。簡(jiǎn)而言之,預(yù)訓(xùn)練預(yù)算越大,最終得到的模型效果越好.

訓(xùn)練時(shí)計(jì)算可能包括訓(xùn)練和微調(diào)期間所需的計(jì)算。

共同成為提高 LLM 性能的主要關(guān)注點(diǎn)。

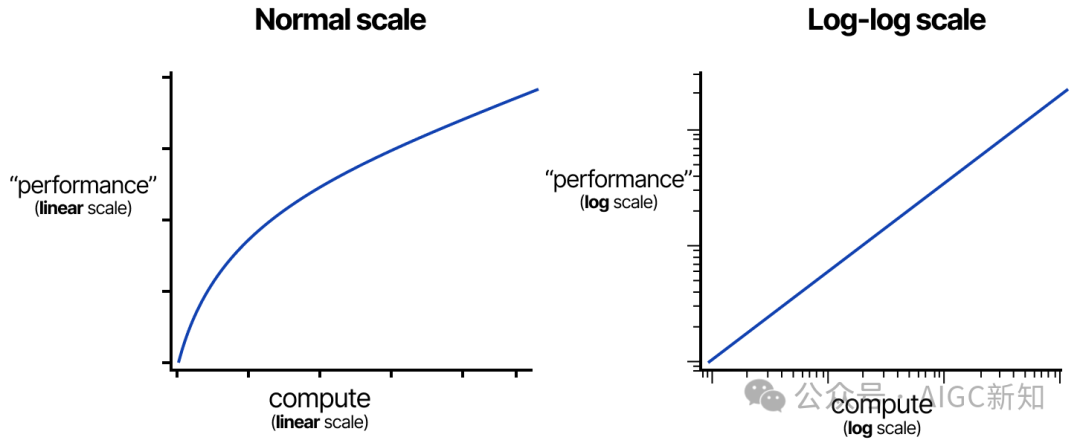

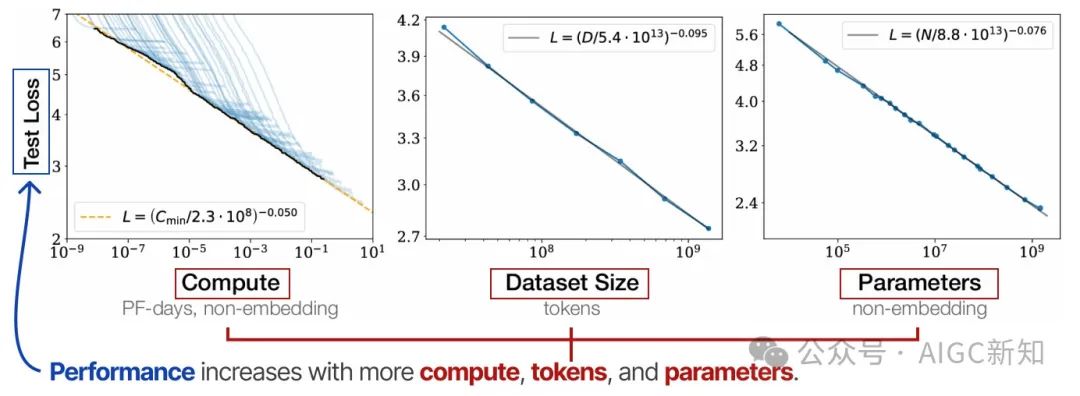

縮放法則

模型的規(guī)模(通過(guò)計(jì)算、數(shù)據(jù)集大小和模型大小)如何與模型的性能相關(guān),通過(guò)各種縮放定律進(jìn)行研究。

它們是所謂的“冪律”,其中一個(gè)變量(例如計(jì)算)的增加會(huì)導(dǎo)致另一個(gè)變量(例如性能)的比例變化。

這些通常是在對(duì)數(shù)-對(duì)數(shù)尺度下顯示的(這會(huì)結(jié)果為一條直線),以展示計(jì)算能力的大幅增加。

最著名的有“Kaplan” 和“Chinchilla” 規(guī)律。這些規(guī)律大致表明,模型的性能會(huì)隨著計(jì)算量、標(biāo)記數(shù)和參數(shù)數(shù)的增加而提高。

它們建議,為了實(shí)現(xiàn)最佳性能,這三個(gè)因素必須同步擴(kuò)大規(guī)模。

Kaplan 的擴(kuò)展定律指出,通常情況下,增加模型規(guī)模比增加數(shù)據(jù)更為有效(給定固定的計(jì)算資源)。相比之下,Chinchilla 的擴(kuò)展定律表明,模型規(guī)模和數(shù)據(jù)同樣重要。

然而,從 2024 年起,計(jì)算能力、數(shù)據(jù)集規(guī)模和模型參數(shù) steadily 增長(zhǎng),但收益已經(jīng)開(kāi)始遞減。

就像這些冪律一樣,隨著規(guī)模的擴(kuò)大,邊際收益遞減。

這個(gè)問(wèn)題引發(fā)了思考:“我們是否已經(jīng)到達(dá)了瓶頸?”

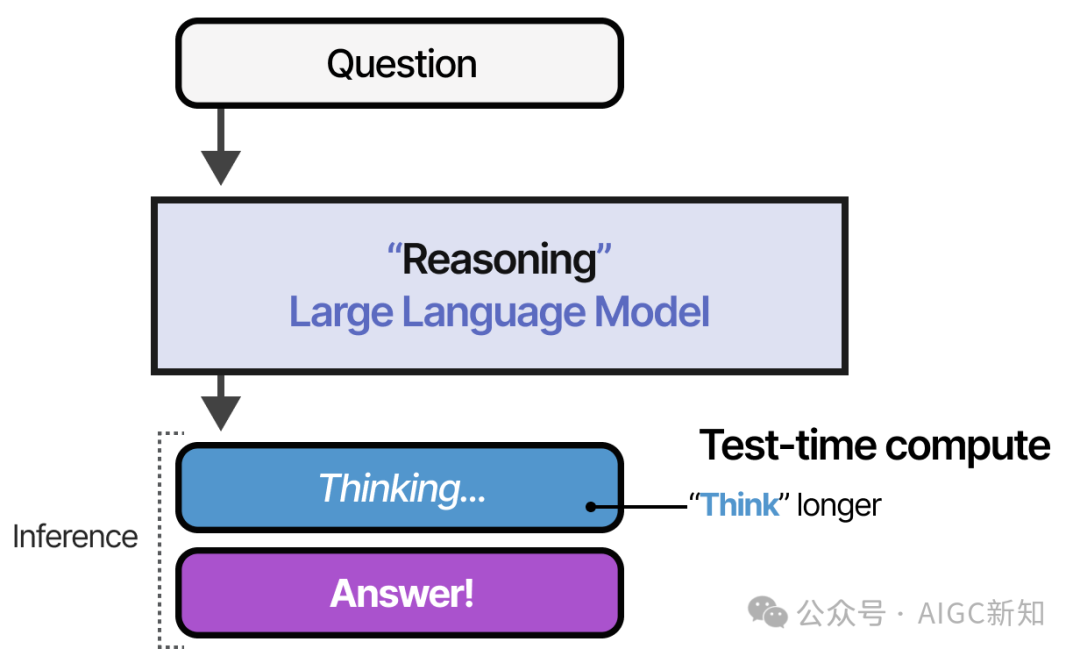

測(cè)試時(shí)的計(jì)算是什么?

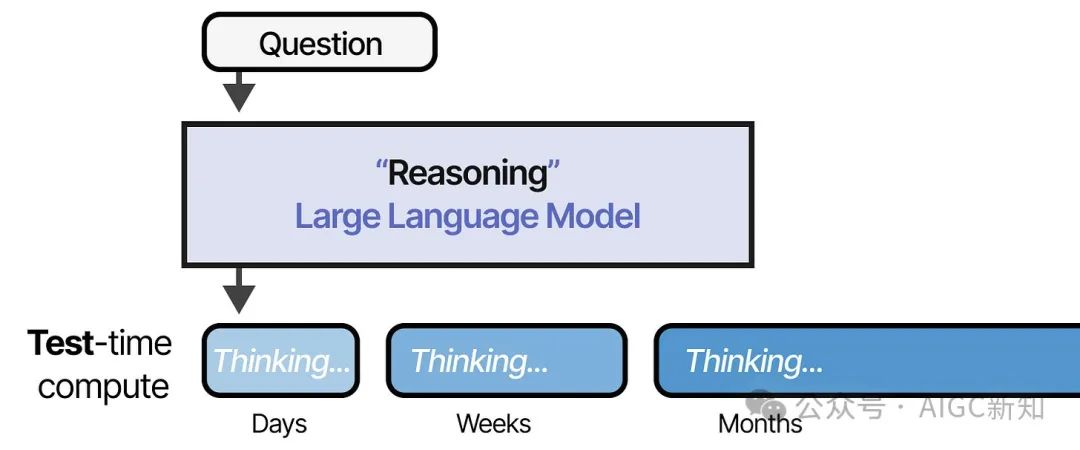

而不是不斷增加預(yù)訓(xùn)練預(yù)算,推理時(shí)的計(jì)算允許模型在推理時(shí)“ 思考更長(zhǎng)時(shí)間 ”。

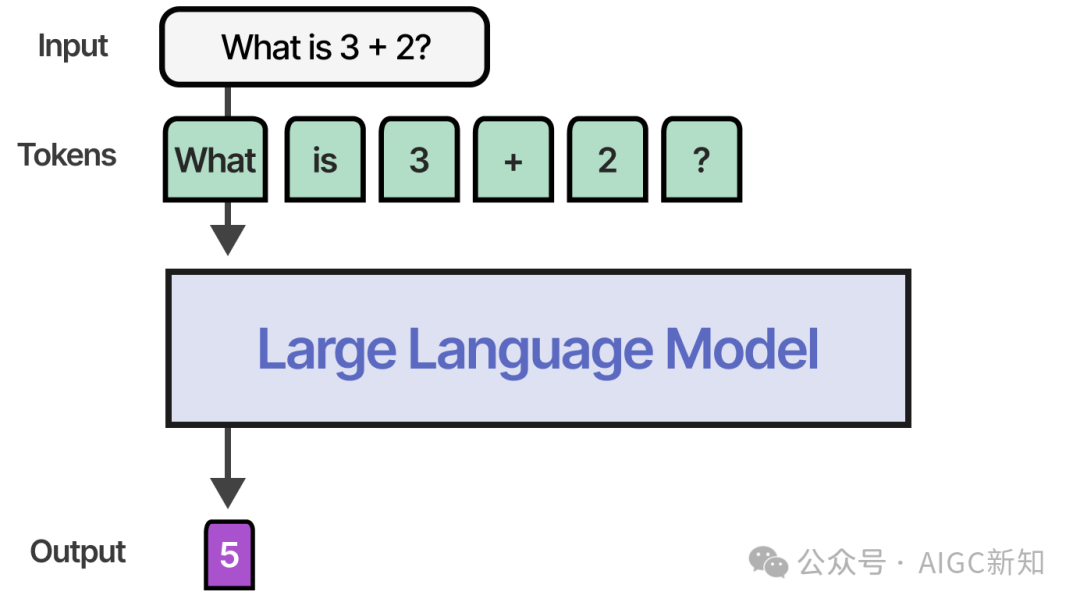

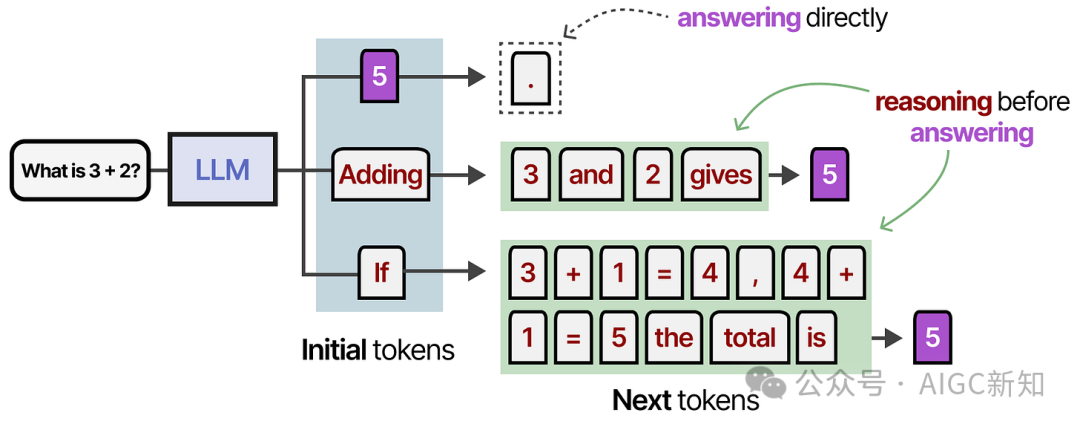

使用非推理模型時(shí),它通常只會(huì)輸出答案并跳過(guò)任何“推理”步驟:

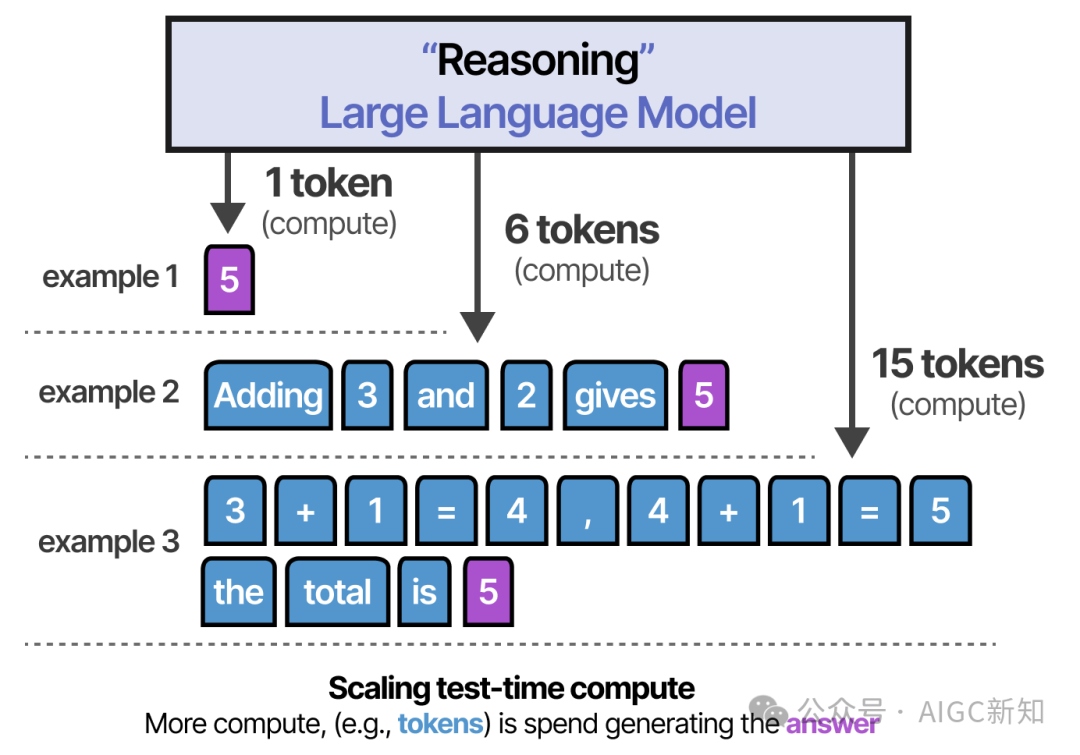

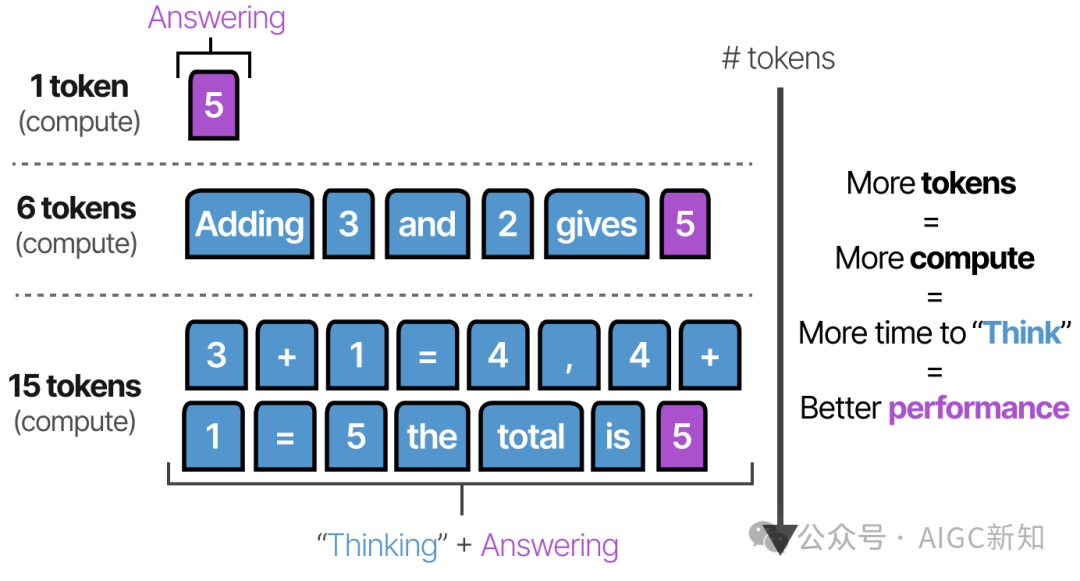

然而,推理模型會(huì)通過(guò)一個(gè)系統(tǒng)的“ 思考 ”過(guò)程使用更多的令牌來(lái)推導(dǎo)出答案:

想法是,LLM 必須花費(fèi)資源(例如 VRAM 計(jì)算能力)來(lái)生成答案。然而,如果所有的計(jì)算資源都用于生成答案,這似乎有些效率低下!

相反,通過(guò)預(yù)先創(chuàng)建包含更多信息、關(guān)系和新想法的標(biāo)記,模型在生成最終答案時(shí)消耗了更多的計(jì)算資源。

規(guī)模法則

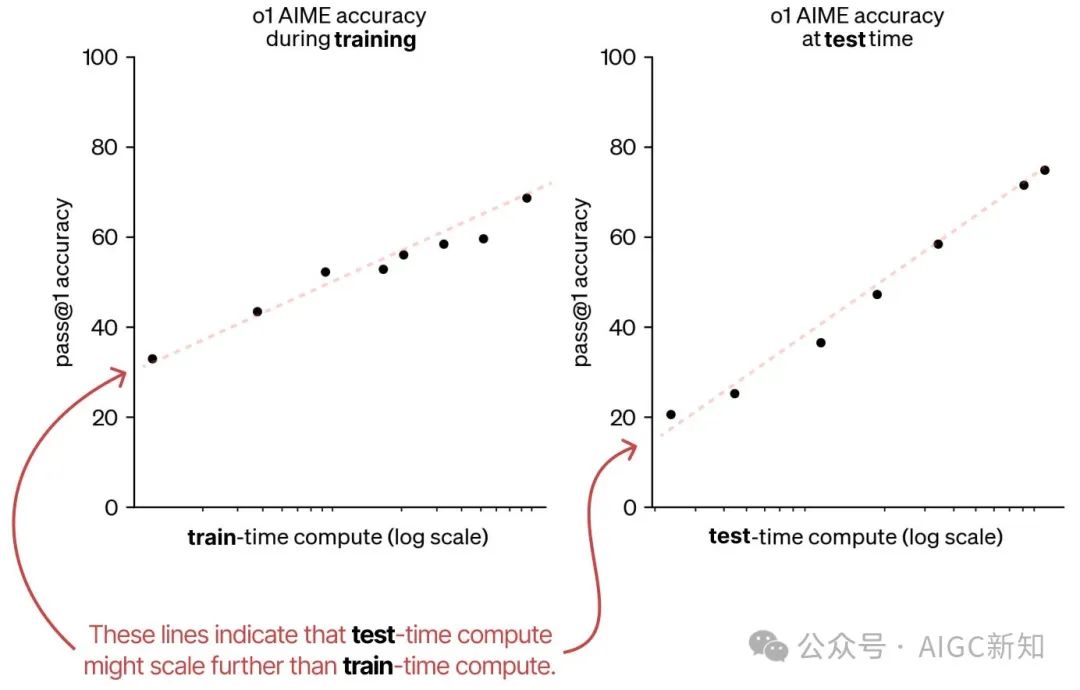

首先,是一篇來(lái)自 OpenAI 的文章,展示了測(cè)試時(shí)計(jì)算量實(shí)際上可能與訓(xùn)練時(shí)計(jì)算量的擴(kuò)展趨勢(shì)一致。

因此,他們認(rèn)為可能會(huì)出現(xiàn)一種范式轉(zhuǎn)變,即在測(cè)試時(shí)增加計(jì)算量,因?yàn)檫@仍是一個(gè)新興領(lǐng)域。

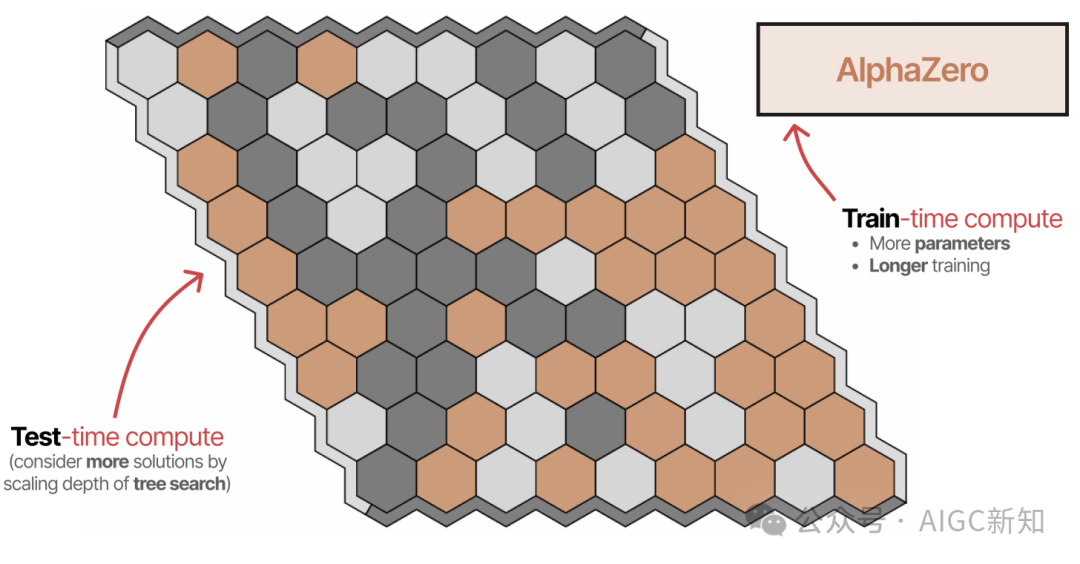

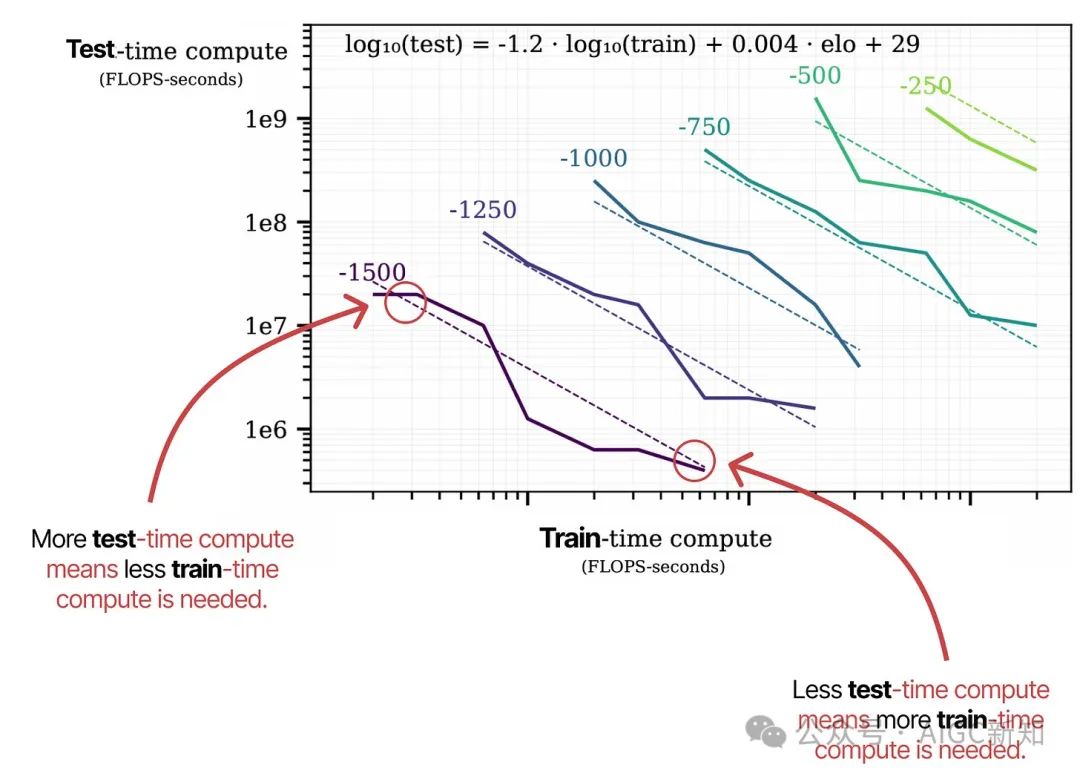

第二,一篇名為“棋盤(pán)游戲中的擴(kuò)展擴(kuò)展定律”的論文探討了 AlphaZero,并將其訓(xùn)練到不同程度的計(jì)算能力來(lái)玩六角棋。

他們的研究顯示,訓(xùn)練時(shí)的計(jì)算量和測(cè)試時(shí)的計(jì)算量密切相關(guān)。每條虛線表示達(dá)到特定 ELO 分?jǐn)?shù)所需的最小計(jì)算量。

在測(cè)試時(shí)計(jì)算擴(kuò)展與訓(xùn)練時(shí)計(jì)算擴(kuò)展類似,正發(fā)生著一種范式轉(zhuǎn)變,即使用更多測(cè)試時(shí)計(jì)算來(lái)構(gòu)建“推理”模型。

在這種范式轉(zhuǎn)變中,這些“推理”模型不再僅僅專注于訓(xùn)練時(shí)的計(jì)算(預(yù)訓(xùn)練和微調(diào)),而是平衡了訓(xùn)練與推理。

測(cè)試時(shí)的計(jì)算甚至可以按長(zhǎng)度進(jìn)行擴(kuò)展:

在深入探討深度搜索-R1 時(shí),我們還將研究長(zhǎng)度上的擴(kuò)展問(wèn)題!

測(cè)試時(shí)的計(jì)算類別

類似 DeepSeek R-1 和 OpenAI o1 這樣的推理模型取得了令人難以置信的成功,這表明除了“思考更長(zhǎng)時(shí)間”之外,還有其他更多技術(shù)手段。

作為我們將要探討的內(nèi)容,測(cè)試時(shí)的計(jì)算可以包括多種方式,如鏈?zhǔn)剿伎肌⑿拚鸢浮⒒厮荨⒉蓸拥取?/p>

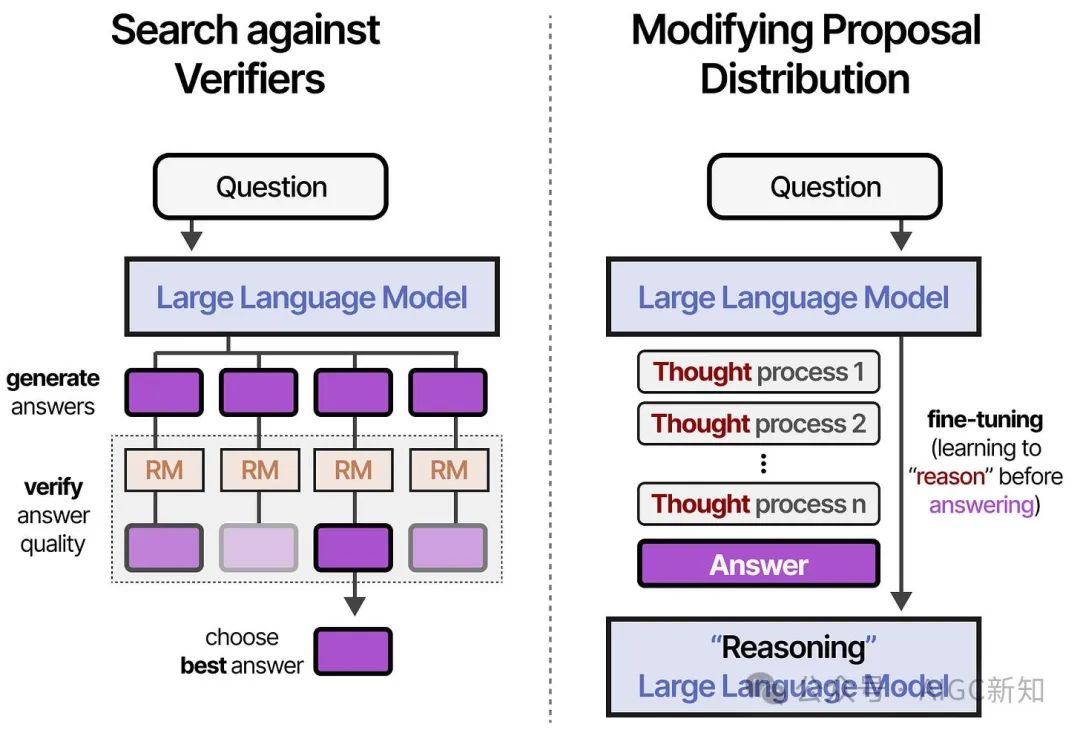

這可以大致分為兩個(gè)類別

- 在驗(yàn)證器中進(jìn)行搜索(從生成中采樣并選擇最佳答案)

- 修改提案分配(訓(xùn)練中的“思考”過(guò)程)

對(duì)驗(yàn)證器的搜索側(cè)重于輸出,而修改提案分布則側(cè)重于輸入。

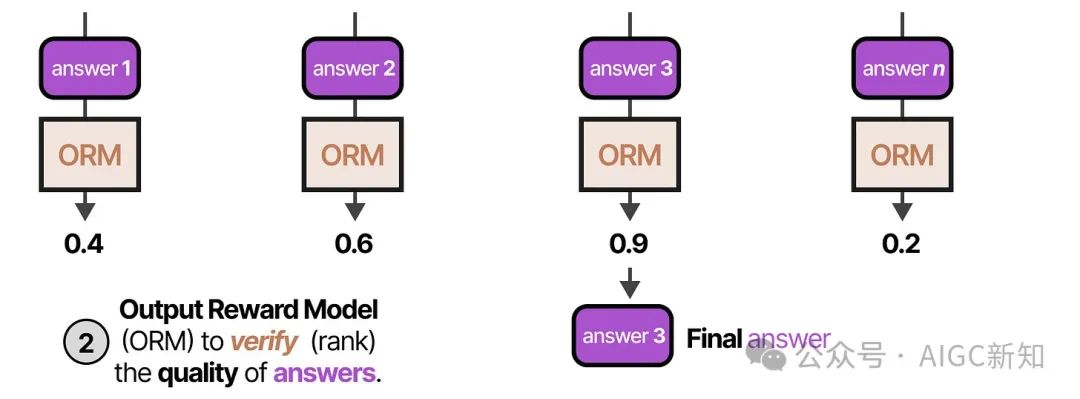

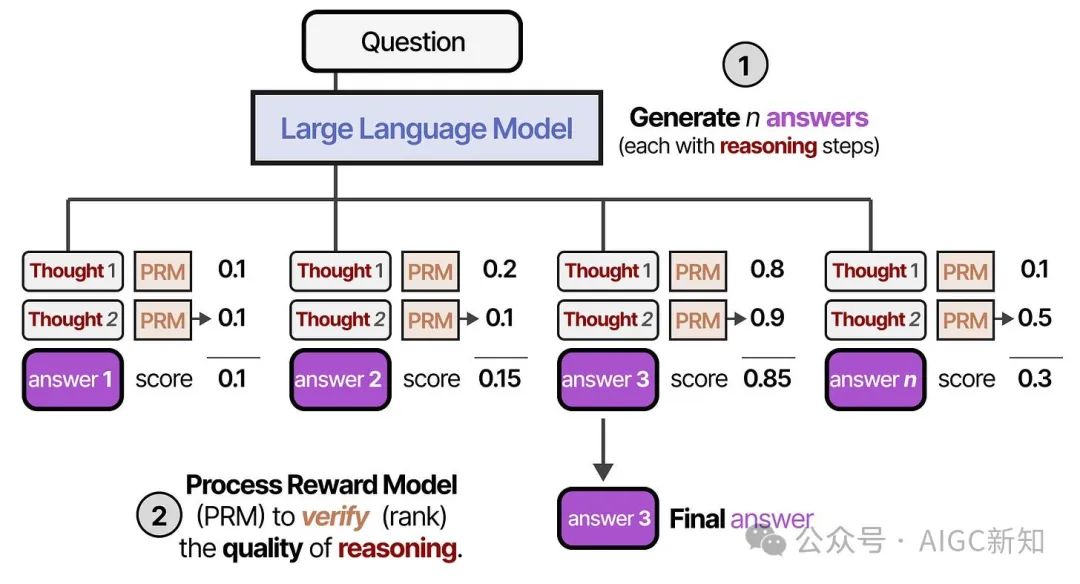

我們將探討兩種類型的驗(yàn)證者:

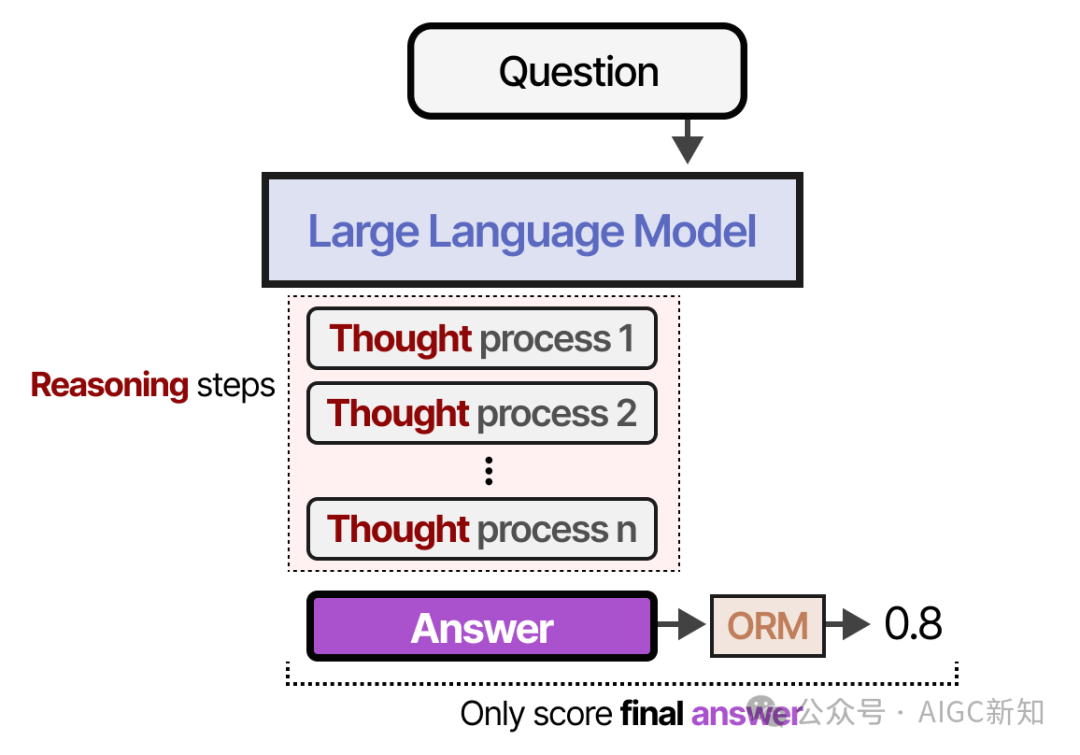

- 結(jié)果獎(jiǎng)勵(lì)模型(ORM)

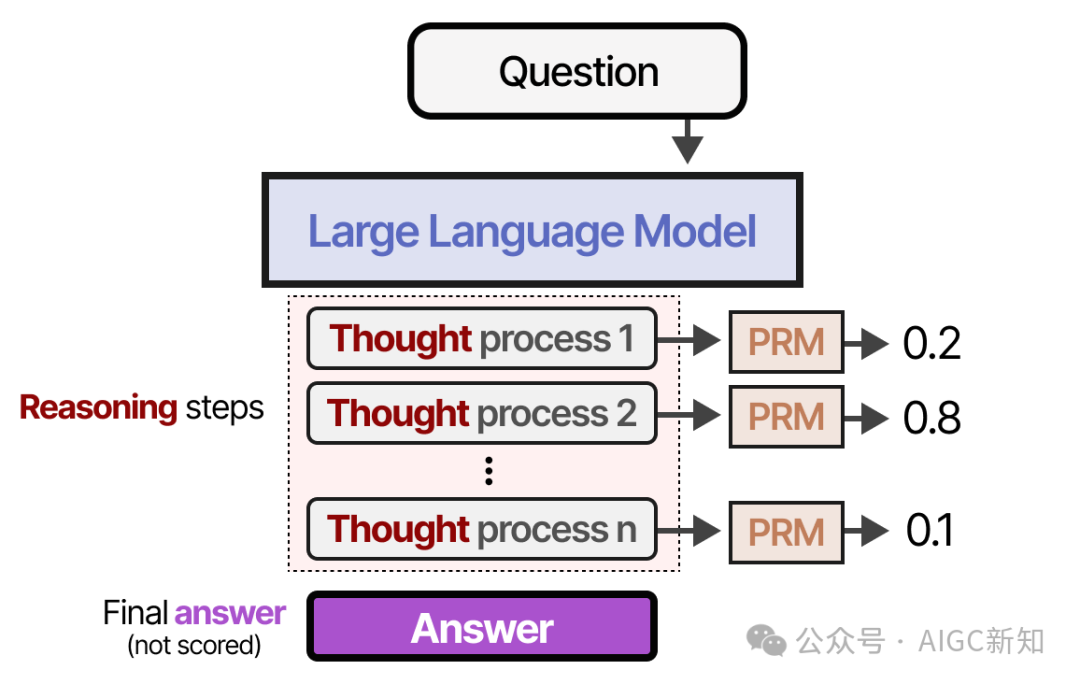

- 過(guò)程獎(jiǎng)勵(lì)模型 (PRM)

他們的名字已經(jīng)表明,ORM 只關(guān)注結(jié)果而不考慮底層過(guò)程:

相反,PRM 也會(huì)評(píng)估導(dǎo)致結(jié)果的推理過(guò)程:

為了讓這些推理步驟更加清晰:

注意第 2 步是一個(gè)糟糕的推理步驟,PRM 會(huì)給出較低的評(píng)分!

現(xiàn)在你已經(jīng)了解了 ORMs 和 PRMs 的區(qū)別,接下來(lái)讓我們探討一下它們?cè)诟鞣N驗(yàn)證技術(shù)中的應(yīng)用吧!

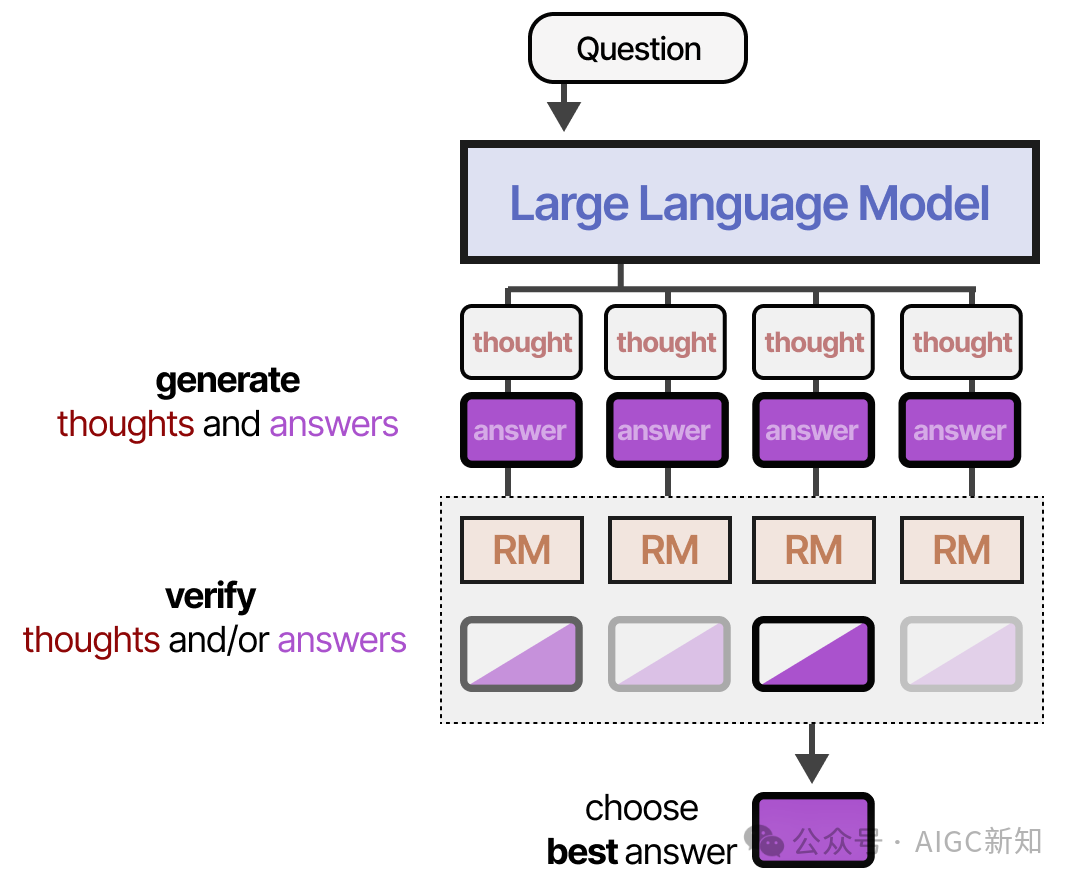

在驗(yàn)證器中搜索

- 首先,創(chuàng)建了多個(gè)推理過(guò)程和答案的示例。

- 第二,一個(gè)驗(yàn)證器(獎(jiǎng)勵(lì)模型)會(huì)評(píng)估生成的輸出得分

驗(yàn)證器通常是LLM,經(jīng)過(guò)微調(diào)以判斷結(jié)果(ORM)或過(guò)程(PRM)。

使用驗(yàn)證器的一個(gè)主要優(yōu)勢(shì)是,無(wú)需重新訓(xùn)練或微調(diào)用于回答問(wèn)題的模型。

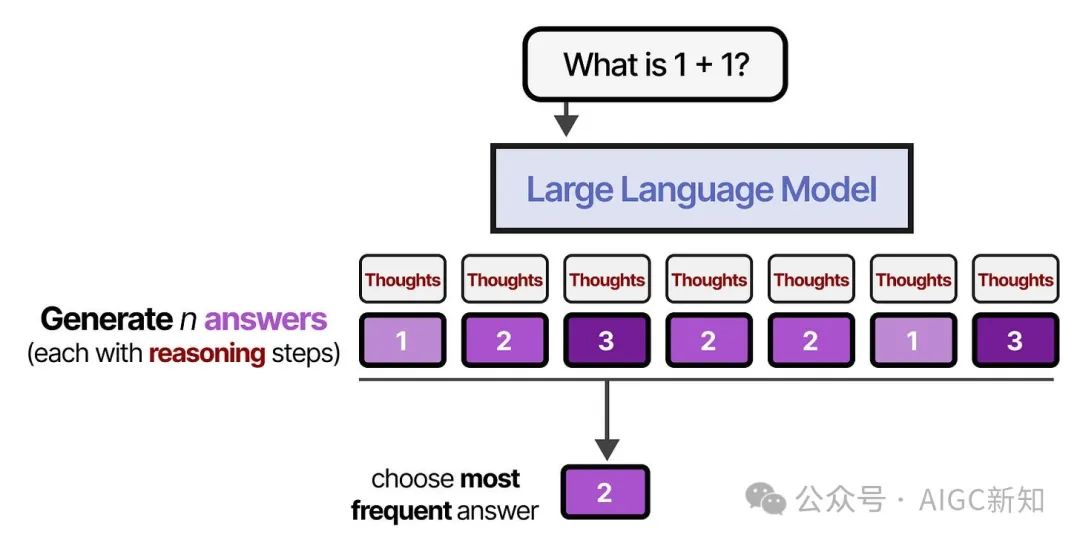

多數(shù)投票法

最簡(jiǎn)單的方法其實(shí)是不使用獎(jiǎng)勵(lì)模型或驗(yàn)證器,而是進(jìn)行多數(shù)表決。

我們讓模型生成多個(gè)答案,出現(xiàn)頻率最高的那個(gè)答案將是最終答案。

這種方法也稱為自我一致性,旨在強(qiáng)調(diào)生成多個(gè)答案和推理步驟的重要性。

最佳 N 個(gè)樣本

首先,LLM(通常稱為提案者)生成多個(gè)答案,使用的是高溫度或不同的溫度。

第二,每個(gè)答案都會(huì)通過(guò)輸出獎(jiǎng)勵(lì)模型(ORM)進(jìn)行評(píng)分,根據(jù)答案的質(zhì)量打分。得分最高的答案會(huì)被選中:

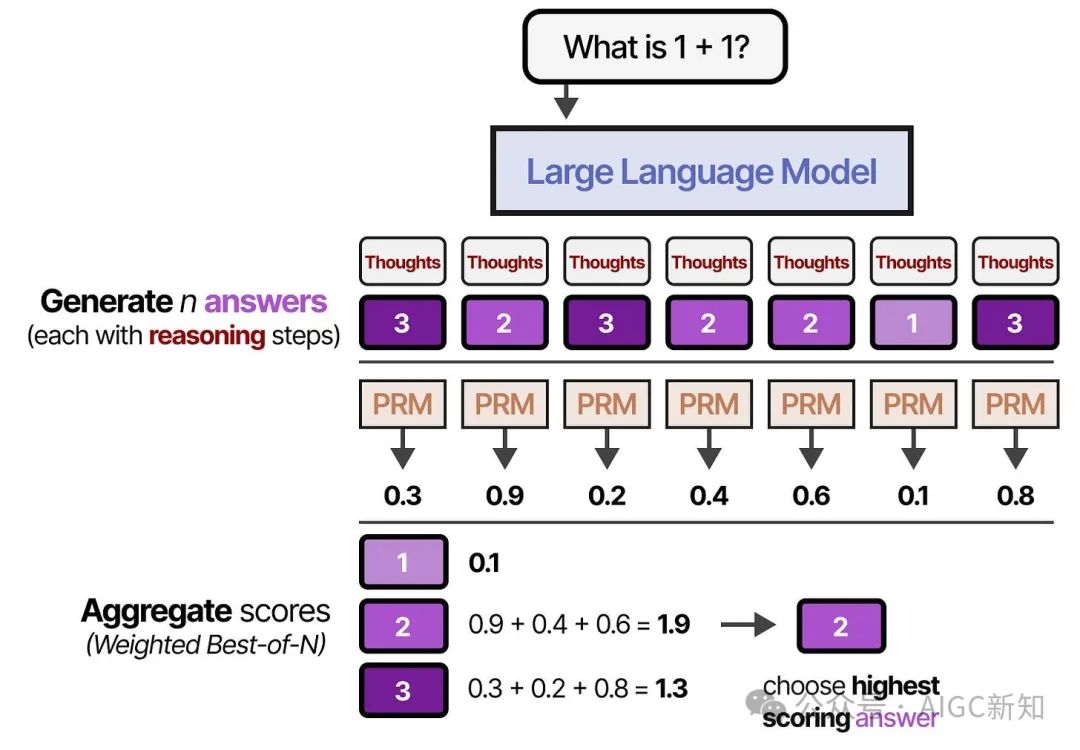

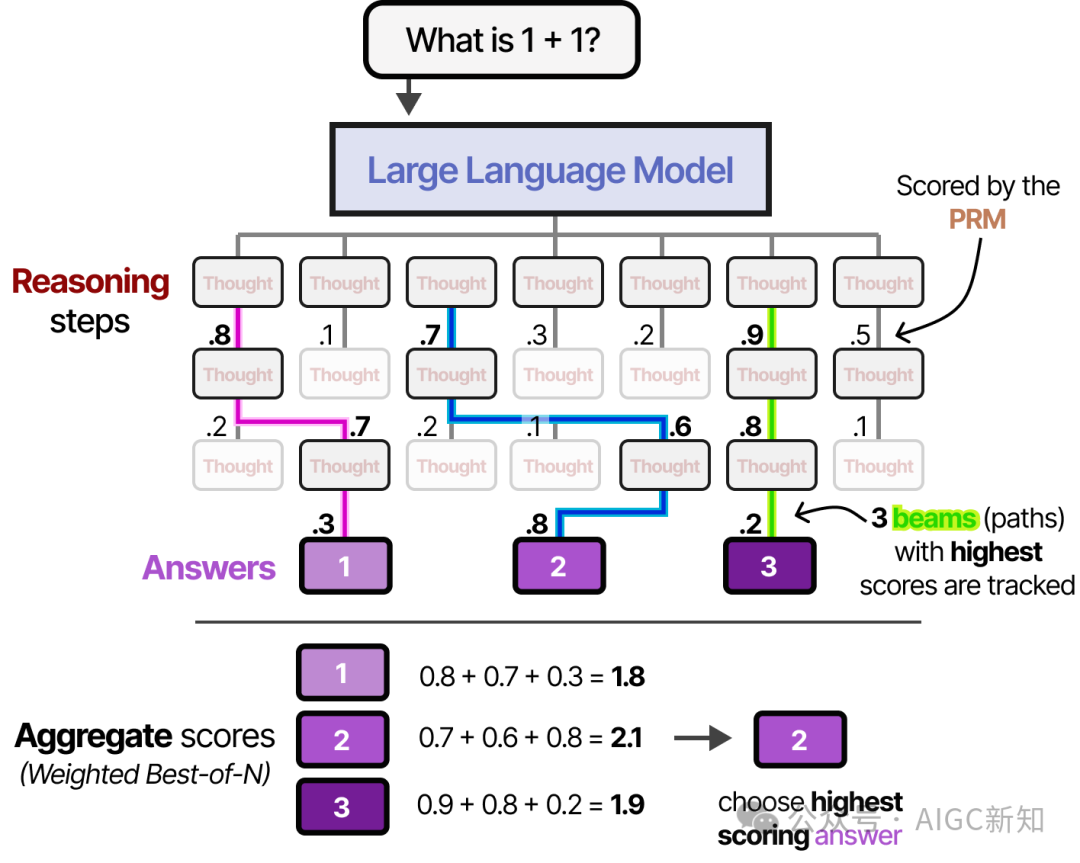

而不是評(píng)判答案,過(guò)程獎(jiǎng)勵(lì)模型(PRM)也可以用來(lái)評(píng)估每一步推理的質(zhì)量,最終選擇總權(quán)重最高的候選答案。

使用這兩種驗(yàn)證器類型,我們也可以根據(jù) RM 對(duì)每個(gè)答案候選項(xiàng)進(jìn)行加權(quán),并選擇總權(quán)重最高的一個(gè)。這被稱為加權(quán)的 N 選一樣本:

基于過(guò)程獎(jiǎng)勵(lì)模型的束搜索算法

這種方法可以快速停止那些最終評(píng)分較低的“推理”路徑。

結(jié)果的答案隨后使用我們之前探討的 Best-of-N 方法進(jìn)行加權(quán)。

蒙特卡洛樹(shù)搜索算法

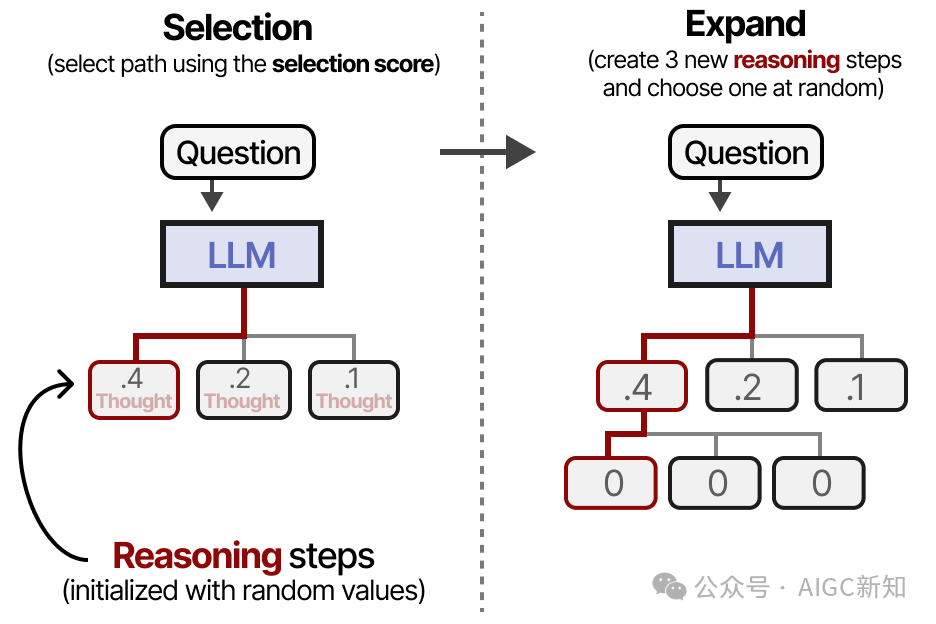

- 選擇(根據(jù)預(yù)設(shè)公式選擇給定的葉節(jié)點(diǎn))

- 擴(kuò)展(創(chuàng)建額外節(jié)點(diǎn))

- 隨機(jī)生成新節(jié)點(diǎn)直至到達(dá)終點(diǎn)

- 根據(jù)輸出更新父節(jié)點(diǎn)得分(反向傳播)

這些步驟的主要目標(biāo)是不斷擴(kuò)展最佳推理步驟,同時(shí)探索其他可能的路徑。

因此,這是一個(gè)探索與利用之間的平衡。以下是一個(gè)節(jié)點(diǎn)評(píng)分和選擇的示例:

因此,當(dāng)我們選擇新的推理步驟來(lái)探索時(shí),這不一定是最優(yōu)路徑。

使用這種類型的公式,我們首先選擇一個(gè)節(jié)點(diǎn)(推理步驟),然后通過(guò)生成新的推理步驟來(lái)擴(kuò)展它。如前所述,這可以通過(guò)使用合理且不同的溫度值來(lái)實(shí)現(xiàn):

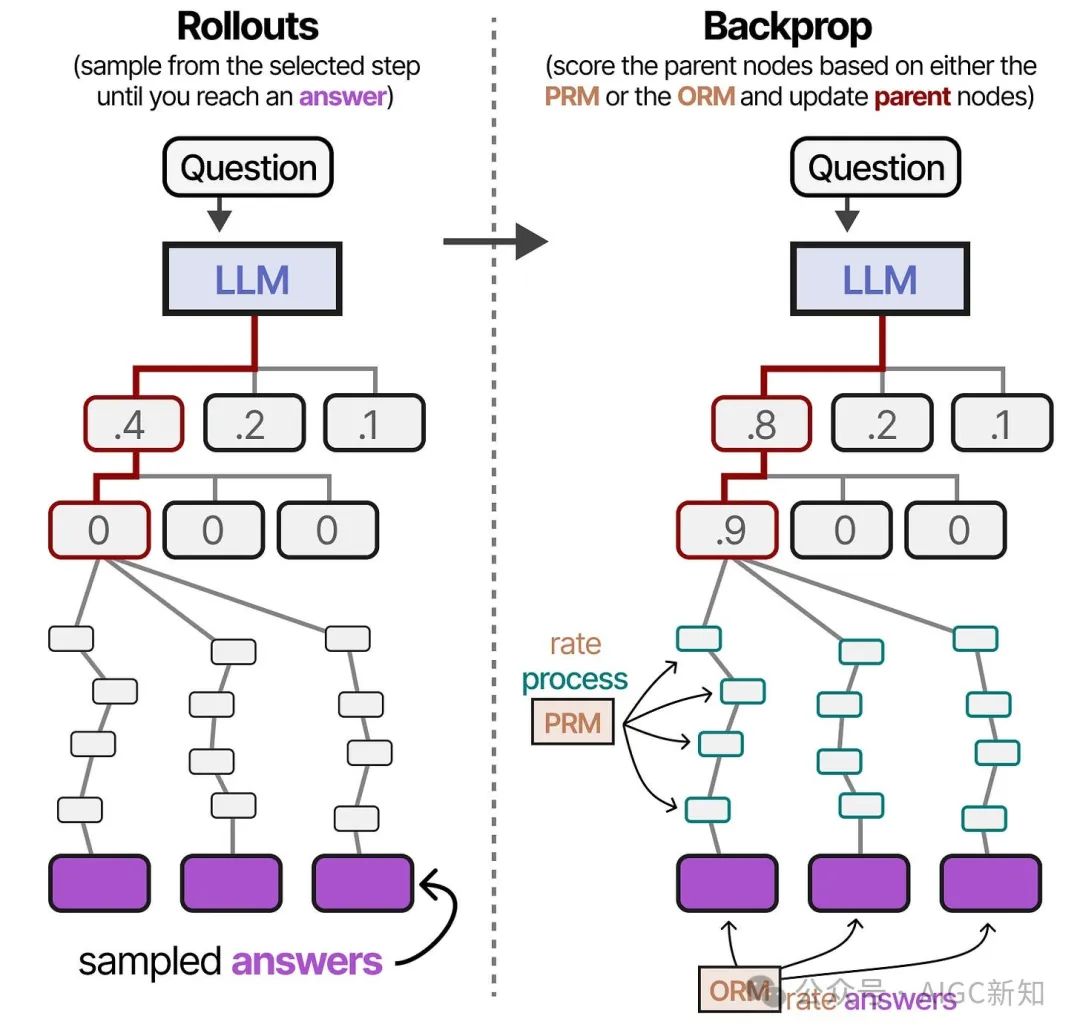

選擇并多次展開(kāi)其中一個(gè)擴(kuò)展的推理步驟,直到得到多個(gè)答案。

這些迭代可以根據(jù)推理步驟(PRM)、獎(jiǎng)勵(lì)(ORM)或兩者的組合來(lái)進(jìn)行評(píng)估。

父節(jié)點(diǎn)的分?jǐn)?shù)將被更新(反向傳播),然后我們可以從選擇步驟重新開(kāi)始這個(gè)過(guò)程。

修改提案分發(fā)

換句話說(shuō),采樣完成/想法/令牌的分布被改變了。

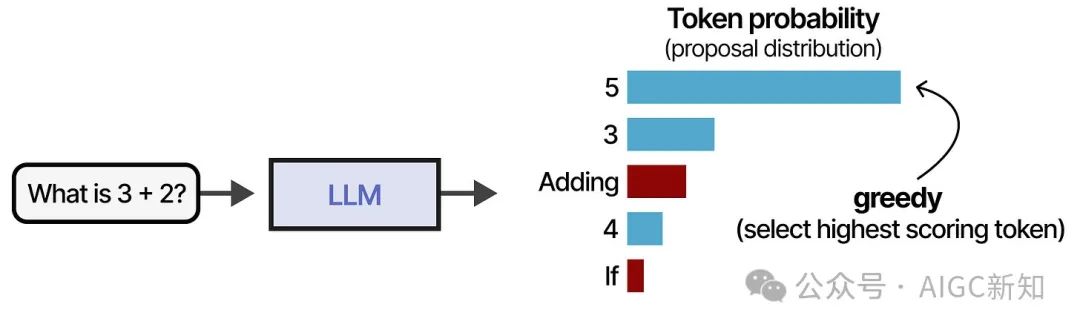

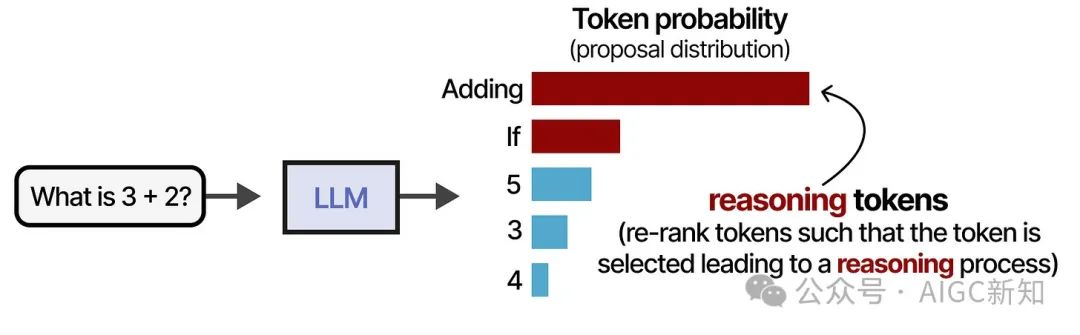

假設(shè)我們有一個(gè)問(wèn)題和一個(gè)可以從其中抽樣標(biāo)記的分布。一種常見(jiàn)的策略是獲取最高分的標(biāo)記:

請(qǐng)注意,上面的圖片中有一些標(biāo)記為紅色的標(biāo)記。這些標(biāo)記更有可能引發(fā)推理過(guò)程:

雖然選擇貪婪標(biāo)記不一定錯(cuò)誤,但選擇能引發(fā)推理過(guò)程的標(biāo)記通常能得到更好的答案。

當(dāng)我們調(diào)整建議分布(即標(biāo)記的概率分布),實(shí)際上就是讓模型重新排序這個(gè)分布,使得“推理”標(biāo)記被更頻繁地選擇:

修改建議分布的方法有很多種,但通常可以歸為兩大類:

- 通過(guò)提示工程更新提示內(nèi)容

- 訓(xùn)練模型專注于推理標(biāo)記和過(guò)程

提示調(diào)用

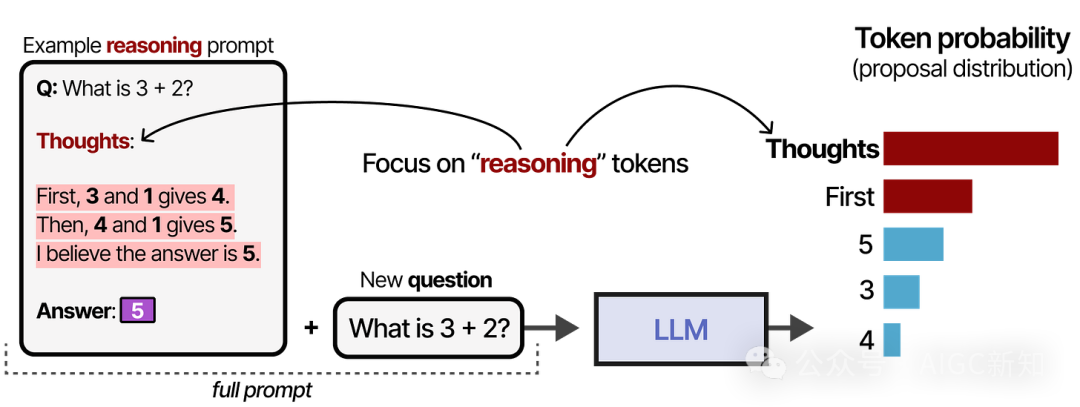

通過(guò)提示,我們可以向模型提供示例(上下文學(xué)習(xí)),使其生成類似推理的行為:

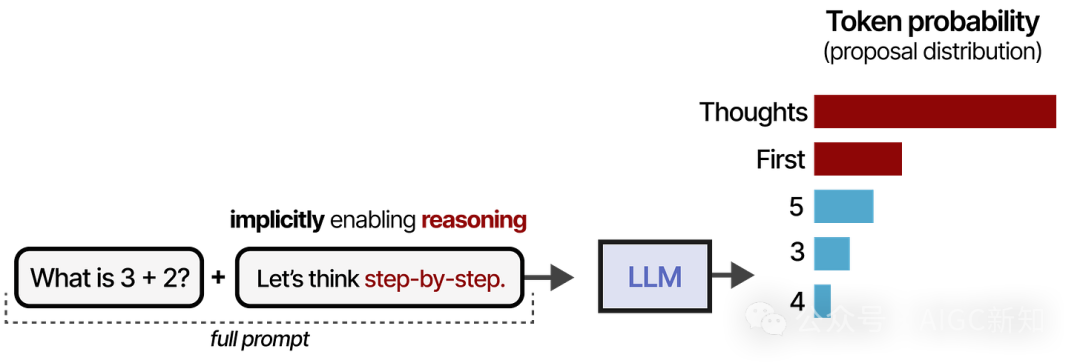

這個(gè)過(guò)程可以通過(guò)簡(jiǎn)單地說(shuō)“讓我們一步一步地思考”來(lái)進(jìn)一步簡(jiǎn)化。同樣地,這會(huì)改變建議分布的方式,使得LLM在回答之前更傾向于先分解過(guò)程:

然而,模型并沒(méi)有天生學(xué)會(huì)遵循這個(gè)過(guò)程。此外,這是一個(gè)靜態(tài)且線性的過(guò)程,這限制了自我改進(jìn)。如果模型一開(kāi)始使用了一個(gè)錯(cuò)誤的推理過(guò)程,它往往會(huì)保持這個(gè)過(guò)程而不進(jìn)行修正。

STaR

一個(gè)備受爭(zhēng)議的技術(shù)被稱為 STaR 或自我教學(xué)推理器 。STaR 是一種使用LLM生成自身推理數(shù)據(jù)的方法,作為模型微調(diào)的輸入。

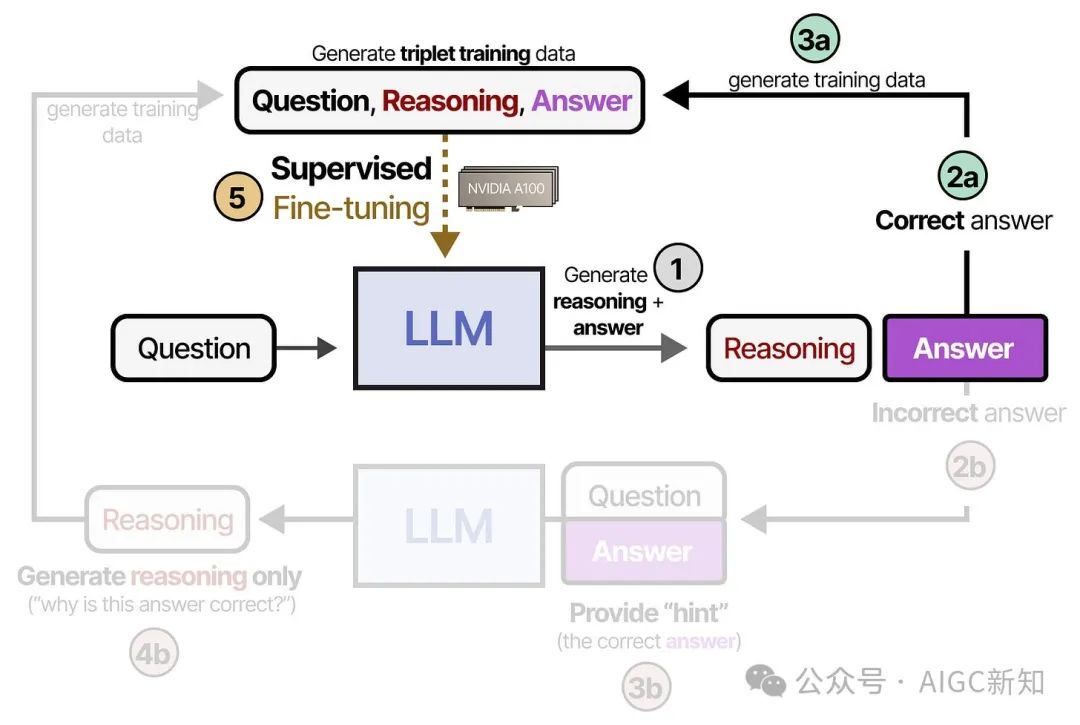

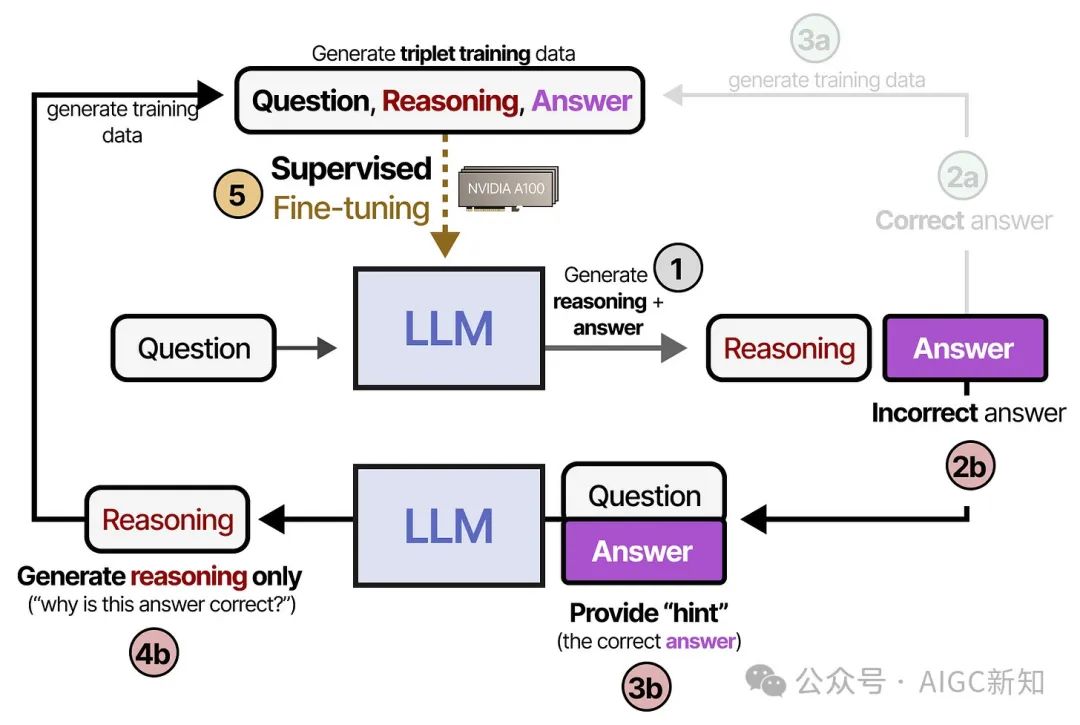

在第一步(1),系統(tǒng)會(huì)生成推理步驟和答案。如果答案正確(2a),則將推理和答案添加到三元組訓(xùn)練數(shù)據(jù)集(3b)。這些數(shù)據(jù)將用于對(duì)模型進(jìn)行監(jiān)督微調(diào)(5):

如果模型給出了錯(cuò)誤的答案(2b),我們提供正確的答案作為提示,并要求模型解釋為什么這個(gè)答案是正確的(4b)。最后,我們將這些數(shù)據(jù)添加到用于模型監(jiān)督微調(diào)的訓(xùn)練數(shù)據(jù)中(5):

在這里(和其他許多修改提議分布的技術(shù)一起),關(guān)鍵在于明確訓(xùn)練模型遵循我們展示給它的推理過(guò)程。

換句話說(shuō),我們通過(guò)監(jiān)督微調(diào)來(lái)確定推理過(guò)程應(yīng)該如何進(jìn)行。

整個(gè)流程非常有趣,因?yàn)樗鼘?shí)際上生成了合成訓(xùn)練示例。使用合成訓(xùn)練示例(如我們?cè)?nbsp;

DeepSeek R-1 中將要探討的)是一種在其他模型中提煉這種推理過(guò)程的驚人方法。

DeepSeek-R1

DeepSeek 通過(guò)各種技術(shù)出色地將推理精煉到了基礎(chǔ)模型(DeepSeek-V3-Base)中。

有趣的是,沒(méi)有涉及驗(yàn)證者,而是將重點(diǎn)放在強(qiáng)化學(xué)習(xí)上,而不是通過(guò)監(jiān)督微調(diào)來(lái)提煉推理行為。

讓我們探索他們是如何在模型中訓(xùn)練出推理行為的!

使用 DeepSeek-R1 Zero 進(jìn)行推理

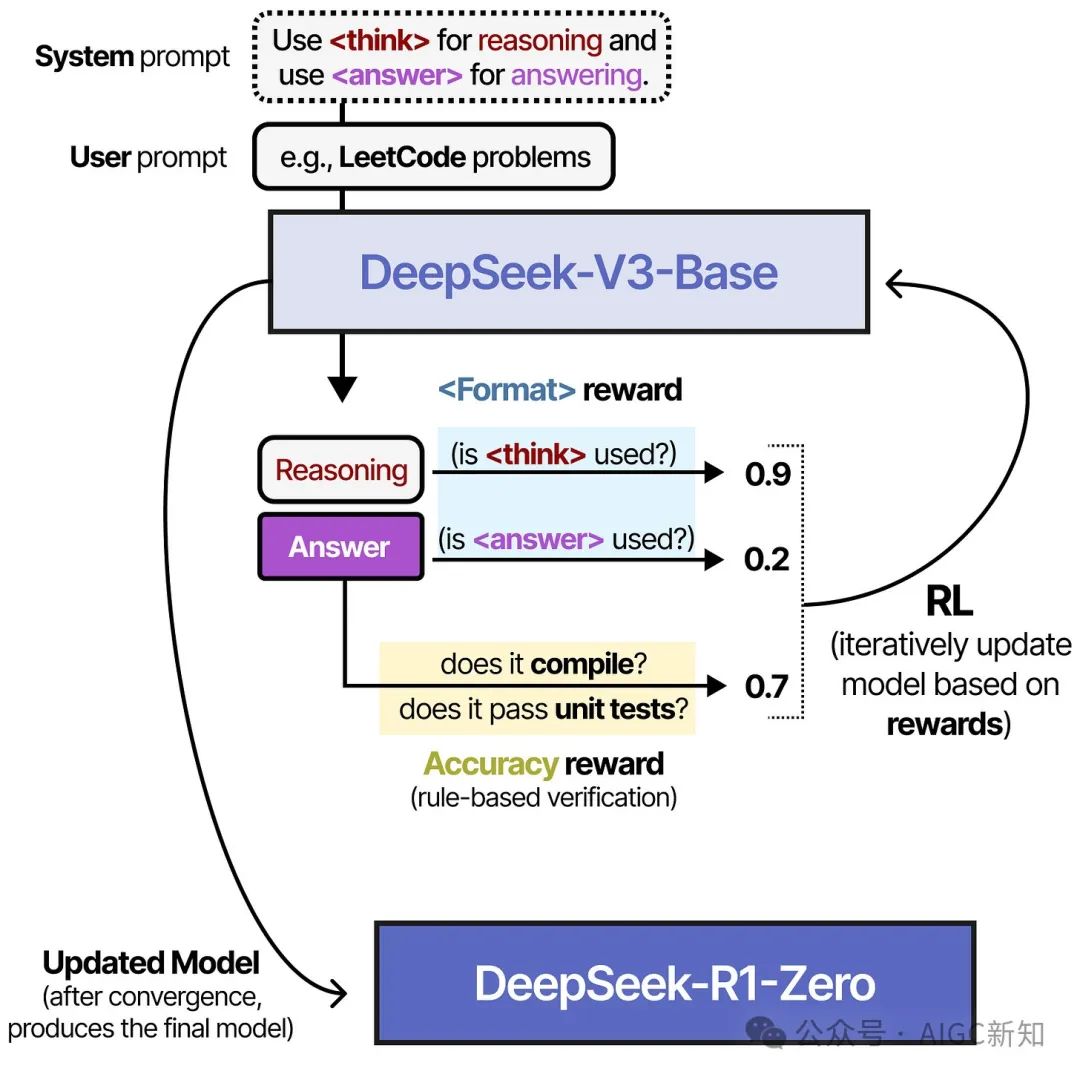

從 DeepSeek-V3-Base 開(kāi)始,他們沒(méi)有采用基于大量推理數(shù)據(jù)的監(jiān)督微調(diào),而是僅通過(guò)強(qiáng)化學(xué)習(xí)(RL)來(lái)實(shí)現(xiàn)推理行為。

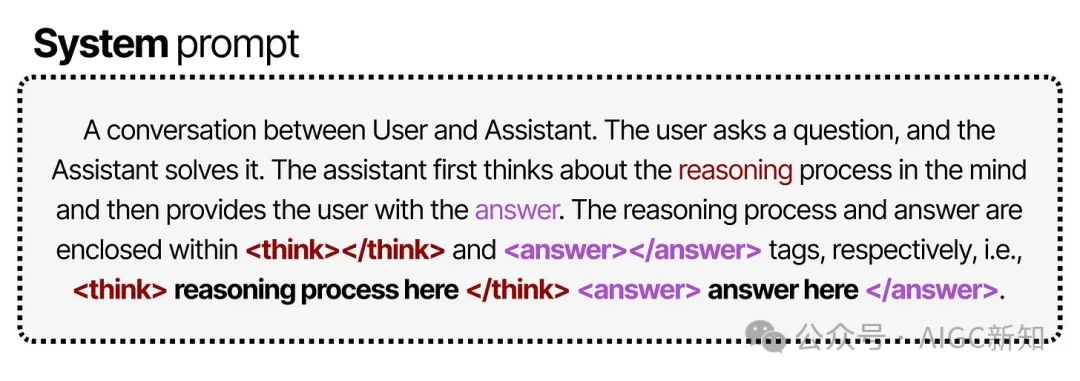

為此,他們從一個(gè)非常簡(jiǎn)單的提示(類似于系統(tǒng)提示)開(kāi)始,用于流水線中:

注意他們明確指出,推理過(guò)程應(yīng)放在標(biāo)簽之間,但沒(méi)有具體說(shuō)明推理過(guò)程應(yīng)如何呈現(xiàn)。

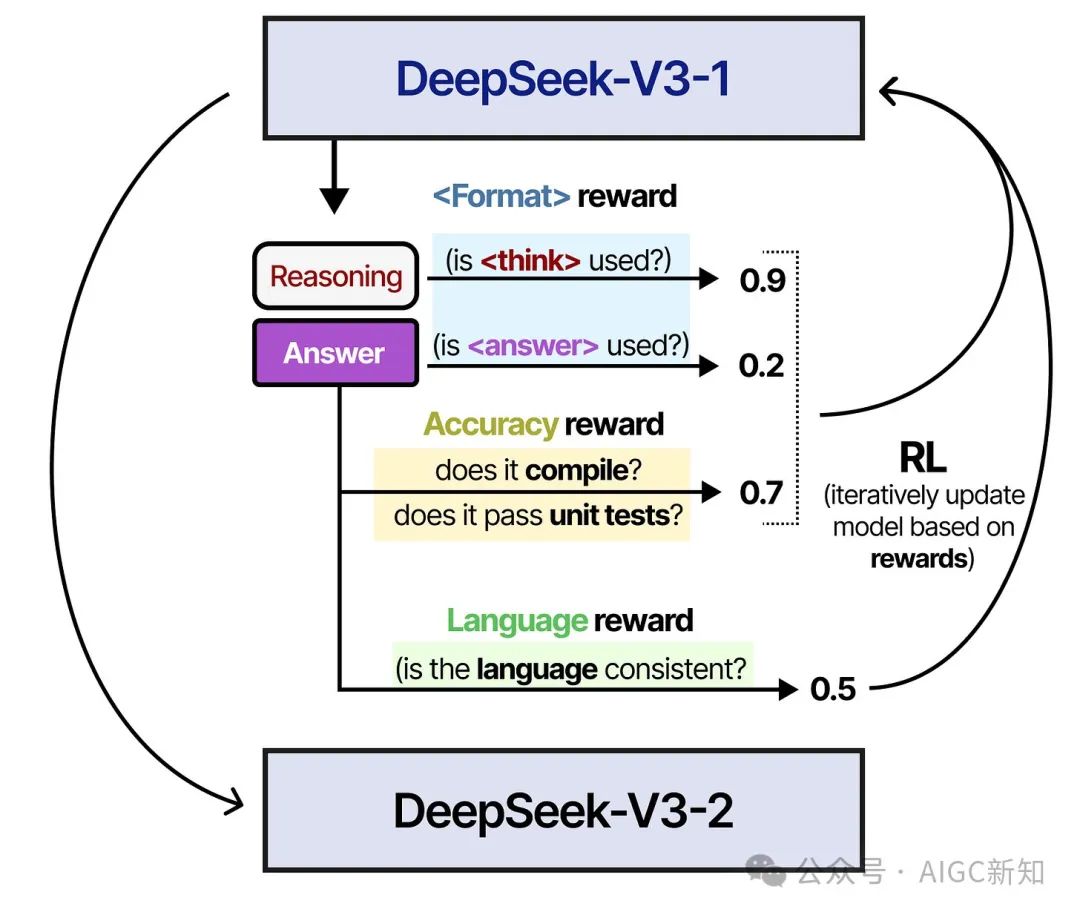

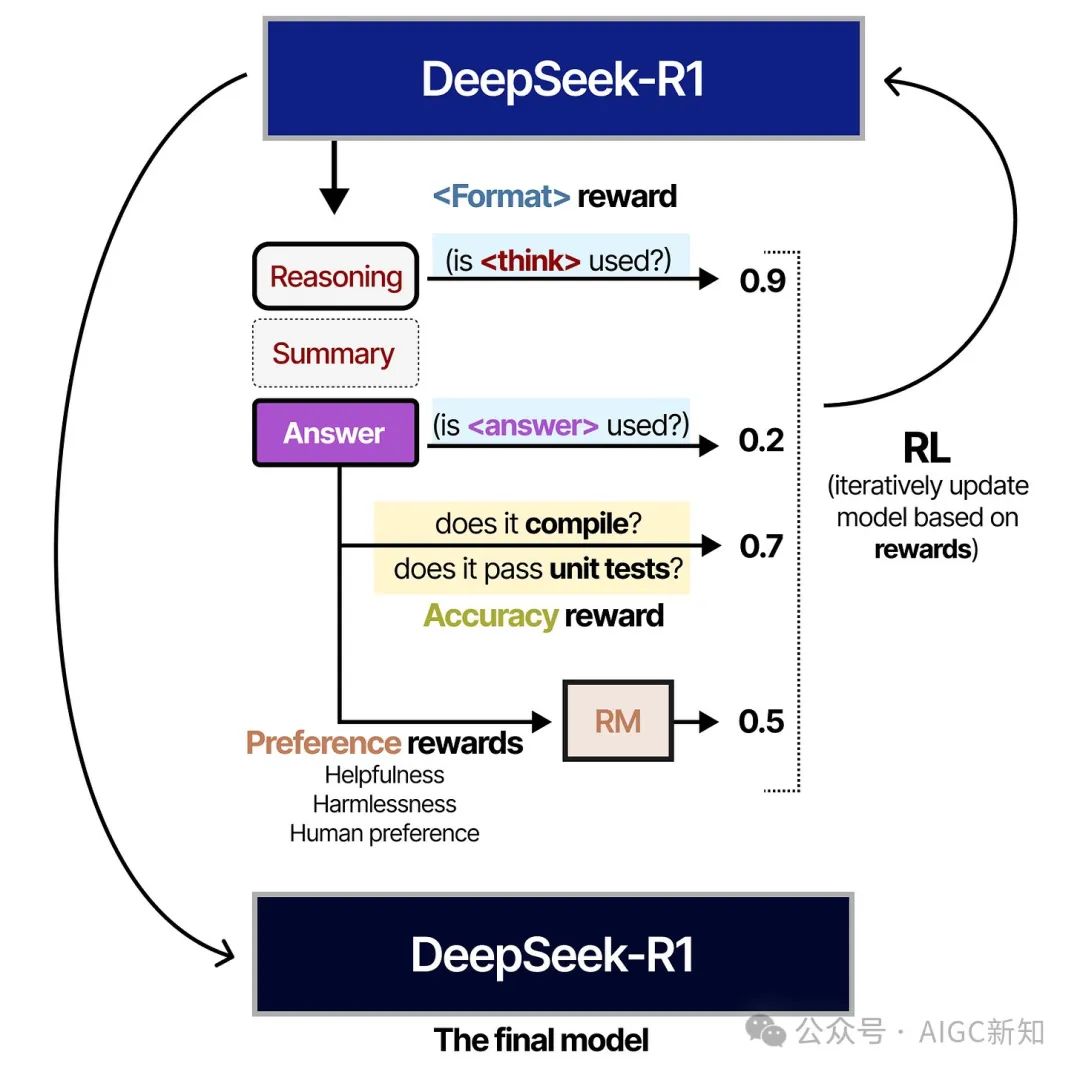

在強(qiáng)化學(xué)習(xí)過(guò)程中,創(chuàng)建了兩種具體的基于規(guī)則的獎(jiǎng)勵(lì):

- 準(zhǔn)確性獎(jiǎng)勵(lì) - 通過(guò)驗(yàn)證答案來(lái)給予獎(jiǎng)勵(lì)。

- 使用 和 標(biāo)簽來(lái)設(shè)置獎(jiǎng)勵(lì)。

在這個(gè)過(guò)程中使用的 RL 算法稱為組相對(duì)策略優(yōu)化(GRPO)11。該算法的直觀想法是,它使導(dǎo)致正確或錯(cuò)誤答案的所有選擇更有可能或更不可能。這些選擇既可以是詞組集,也可以是推理步驟。

有趣的是,并沒(méi)有給出 過(guò)程的具體示例。它僅說(shuō)明應(yīng)使用 標(biāo)簽,除此之外沒(méi)有更多的說(shuō)明!

通過(guò)提供與鏈?zhǔn)剿季S行為相關(guān)的間接獎(jiǎng)勵(lì),模型自己發(fā)現(xiàn),推理過(guò)程越長(zhǎng)且越復(fù)雜,答案越可能是正確的。

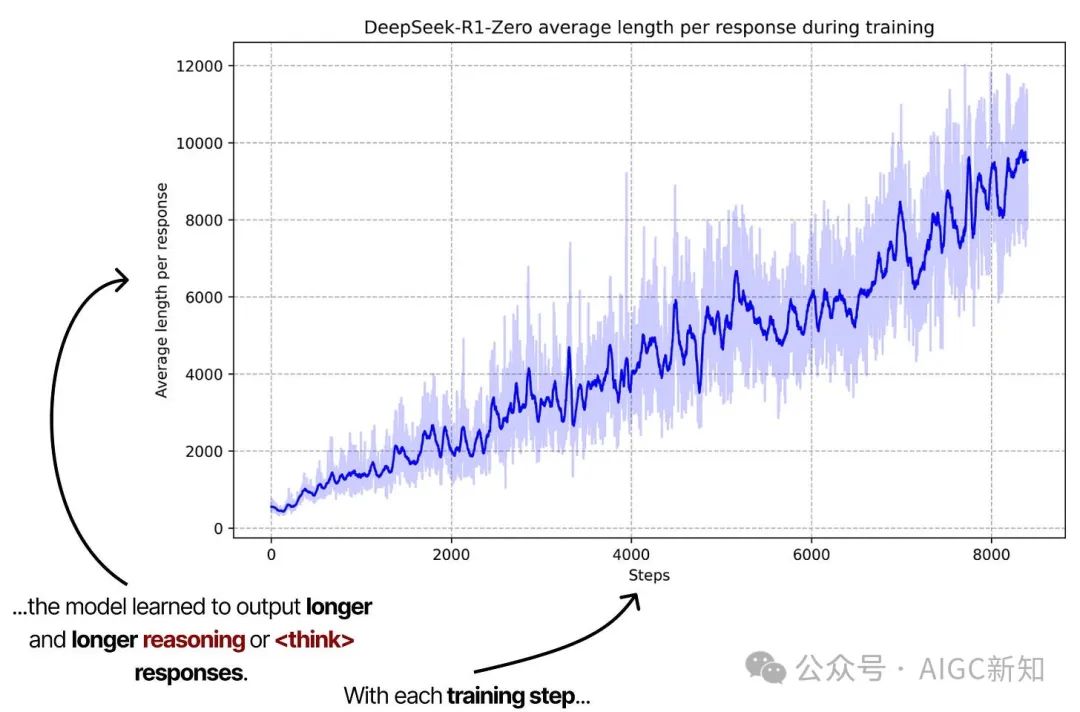

標(biāo)注圖來(lái)自“DeepSeek-R1:通過(guò)強(qiáng)化學(xué)習(xí)激勵(lì)推理能力”。通過(guò)使用間接的 RL 獎(jiǎng)勵(lì),模型可以自由探索最優(yōu)化的推理過(guò)程,逐步增加推理步驟。

這個(gè)圖表尤為重要,因?yàn)樗鼜?qiáng)調(diào)了從訓(xùn)練時(shí)計(jì)算轉(zhuǎn)向測(cè)試時(shí)計(jì)算的范式轉(zhuǎn)變。隨著這些模型生成更長(zhǎng)的思考序列,它們更加注重測(cè)試時(shí)的計(jì)算。

通過(guò)這個(gè)訓(xùn)練管道,他們發(fā)現(xiàn)模型能夠自主發(fā)現(xiàn)最優(yōu)的鏈?zhǔn)剿伎夹袨椋ǜ呒?jí)的推理能力,如自我反思和自我驗(yàn)證。

然而,它仍然存在一個(gè)重大缺陷,即可讀性較差且往往會(huì)混用語(yǔ)言。因此,他們探索了另一種替代方案,即如今廣為人知的 DeepSeek R1。

讓我們探討它們是如何穩(wěn)定推理過(guò)程的!

DeepSeek-R1

- 冷啟動(dòng)階段

- 基于推理的強(qiáng)化學(xué)習(xí)算法

- 拒絕采樣

- 監(jiān)督微調(diào)

- 所有場(chǎng)景的強(qiáng)化學(xué)習(xí)算法

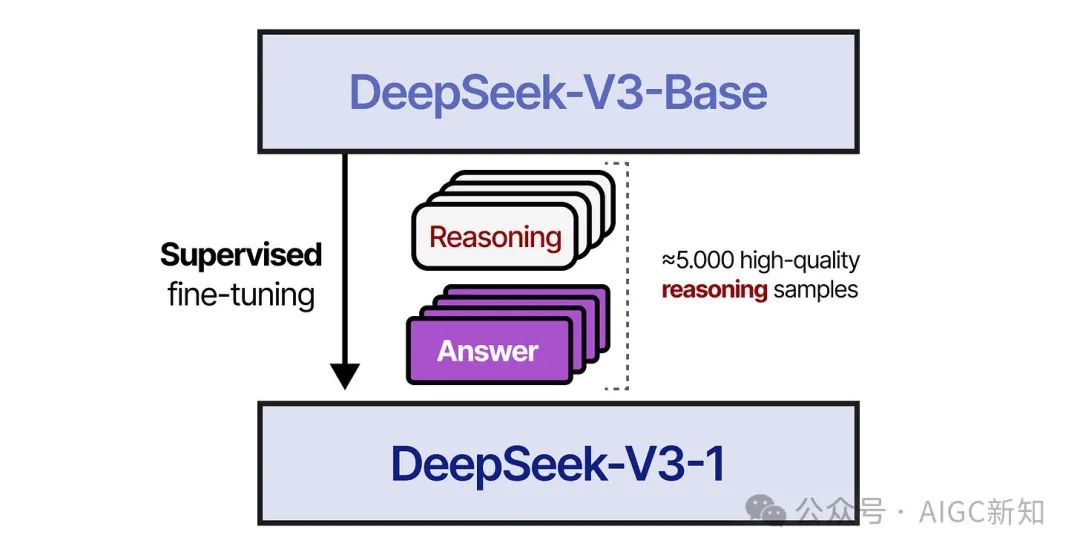

在第一步中,DeepSeek-V3-Base 使用了一個(gè)約 5000 個(gè)標(biāo)記的小型高質(zhì)量推理數(shù)據(jù)集進(jìn)行了微調(diào),以避免冷啟動(dòng)問(wèn)題導(dǎo)致可讀性差。

在第二步中,生成的模型使用與訓(xùn)練 DeepSeek-R1-Zero 時(shí)類似的過(guò)程進(jìn)行了訓(xùn)練。為了確保目標(biāo)語(yǔ)言的一致性,還添加了一個(gè)額外的獎(jiǎng)勵(lì)指標(biāo)。

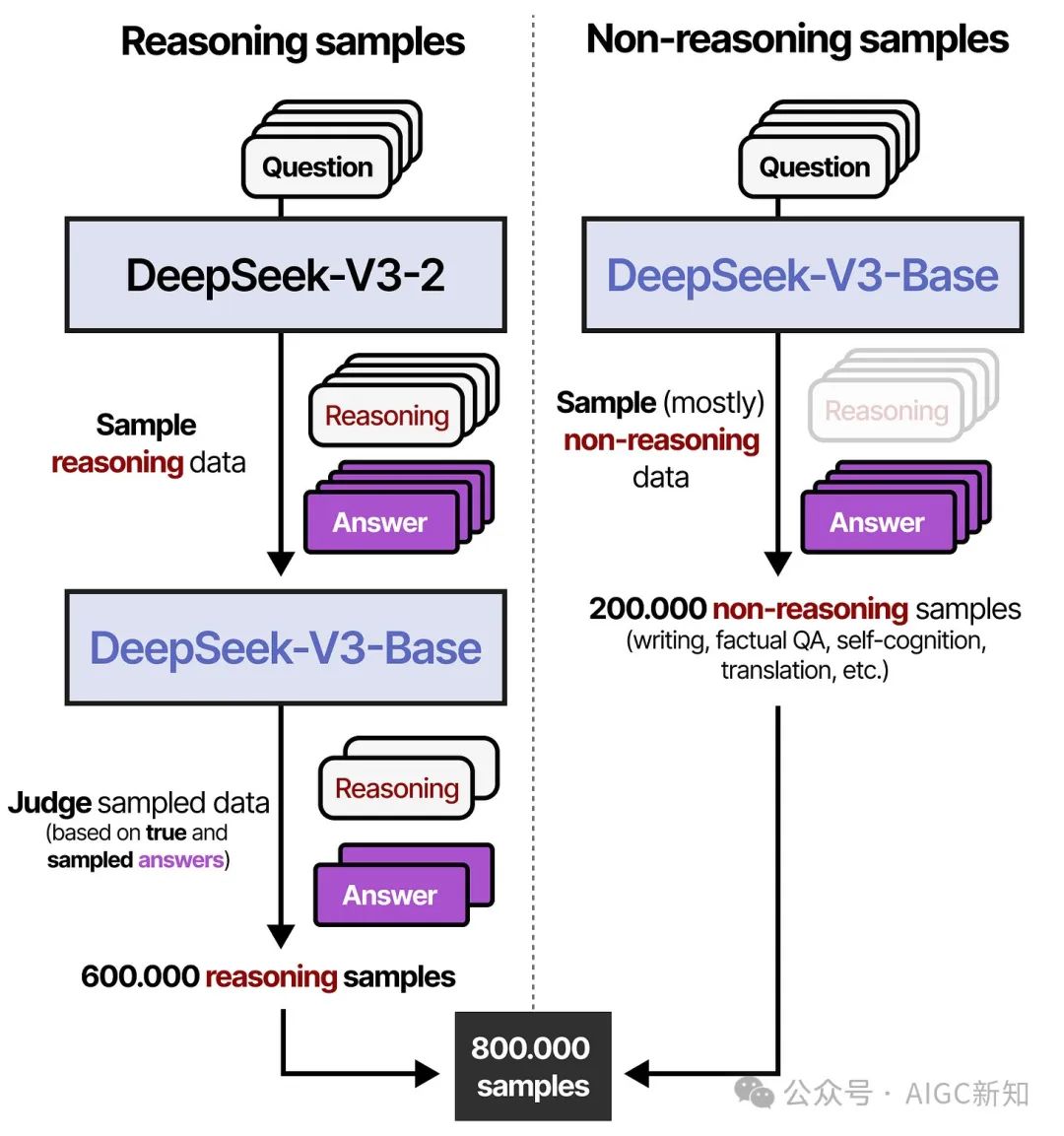

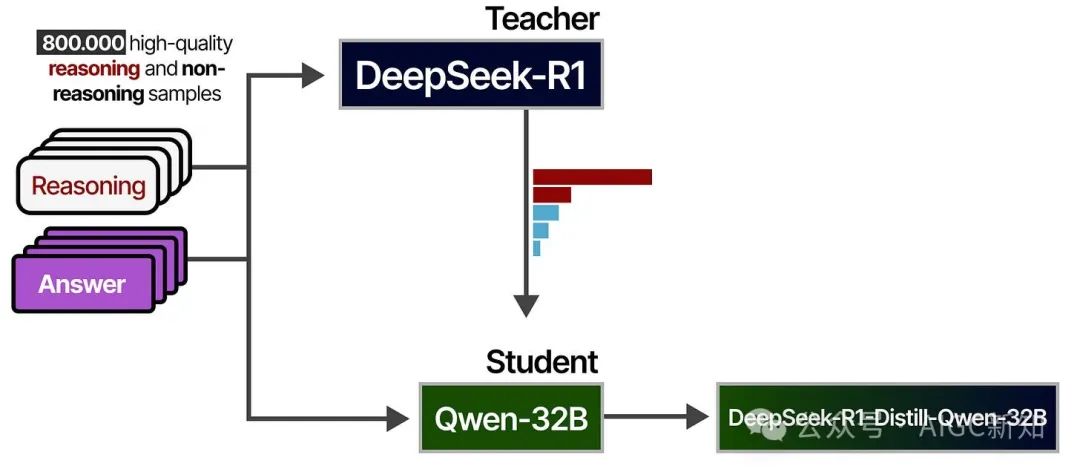

在第三步中,經(jīng)過(guò) RL 訓(xùn)練的模型被用來(lái)生成合成推理數(shù)據(jù),這些數(shù)據(jù)將在稍后的階段用于監(jiān)督微調(diào)。通過(guò)基于規(guī)則的采樣(規(guī)則獎(jiǎng)勵(lì))和獎(jiǎng)勵(lì)模型(DeepSeek-V3-Base),共生成了 600,000 個(gè)高質(zhì)量的推理樣本。

此外,使用 DeepSeek-V3 和部分訓(xùn)練數(shù)據(jù)生成了 200,000 個(gè)非推理樣本。

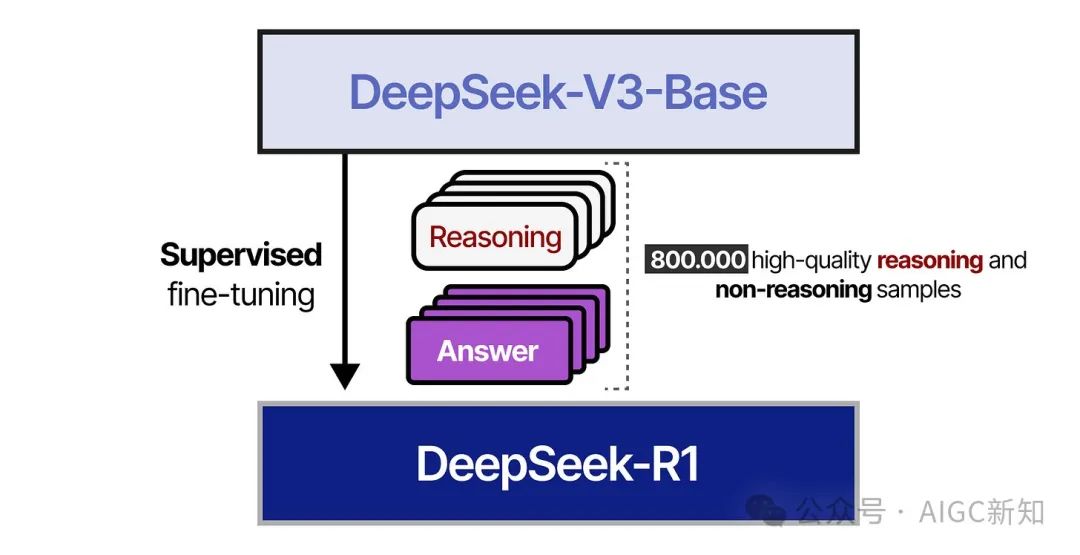

在第 4 步中,生成了 800,000 個(gè)樣本的數(shù)據(jù)集,并用于監(jiān)督微調(diào) DeepSeek-V3-Base 模型。

在第 5 步中,使用類似于 DeepSeek-R1-Zero 的方法對(duì)生成的模型進(jìn)行了基于強(qiáng)化學(xué)習(xí)的訓(xùn)練。為了與人類偏好保持一致,還添加了專注于有用性和無(wú)害性的額外獎(jiǎng)勵(lì)信號(hào)。模型還被要求總結(jié)推理過(guò)程,以避免可讀性問(wèn)題。

這就是全部!這意味著 DeepSeek-R1 實(shí)際上是通過(guò)監(jiān)督微調(diào)和強(qiáng)化學(xué)習(xí)從 DeepSeek-V3-Base 微調(diào)而來(lái)的。

大部分工作是確保生成高質(zhì)量樣本!

使用 DeepSeek-R1 精煉推理

DeepSeek-R1 是一個(gè)擁有 671 億個(gè)參數(shù)的巨大模型。不幸的是,在消費(fèi)級(jí)硬件上運(yùn)行這樣一個(gè)模型將會(huì)非常困難。

幸運(yùn)的是,作者探索了將 DeepSeek-R1 的推理質(zhì)量提煉到 Qwen-32B 等其他模型的方法,我們可以在消費(fèi)級(jí)硬件上運(yùn)行這些模型!

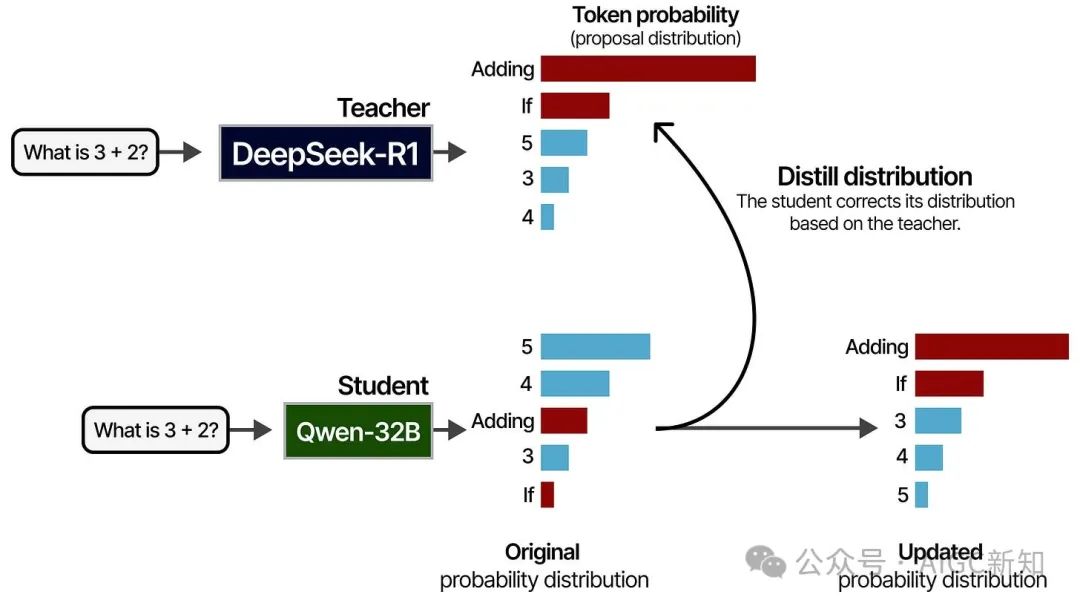

為此,他們使用 DeepSeek-R1 作為教師模型,較小的模型作為學(xué)生。兩個(gè)模型都會(huì)接收到一個(gè)提示,并生成一個(gè)標(biāo)記的概率分布。在訓(xùn)練過(guò)程中,學(xué)生將試圖緊密跟隨教師的概率分布。

這個(gè)過(guò)程是使用之前看到的 80 萬(wàn)個(gè)高質(zhì)量樣本完成的:

經(jīng)過(guò)提煉的模型表現(xiàn)非常出色,因?yàn)樗鼈儾粌H學(xué)習(xí)了 800,000 個(gè)樣本,還學(xué)習(xí)了 DeepSeek-R1 老師是如何回答這些問(wèn)題的方法!

不成功的嘗試

使用 MCTS 時(shí),他們面臨了搜索空間大的問(wèn)題,因此不得不限制節(jié)點(diǎn)擴(kuò)展。此外,訓(xùn)練精細(xì)的獎(jiǎng)勵(lì)模型本身就非常困難。

使用 PRMs 進(jìn)行 Best-of-N 技術(shù)時(shí),他們遇到了計(jì)算開(kāi)銷問(wèn)題,需要不斷重新訓(xùn)練獎(jiǎng)勵(lì)模型以防止獎(jiǎng)勵(lì)作弊。

這并不表示這些技術(shù)無(wú)效,但它揭示了這些技術(shù)的一些局限性!