基于MoE的通用圖像融合模型,添加2.8%參數完成多項任務

- 論文鏈接:https://arxiv.org/abs/2403.12494

- 代碼鏈接:https://github.com/YangSun22/TC-MoA

- 論文題目:Task-Customized Mixture of Adapters for General Image Fusion

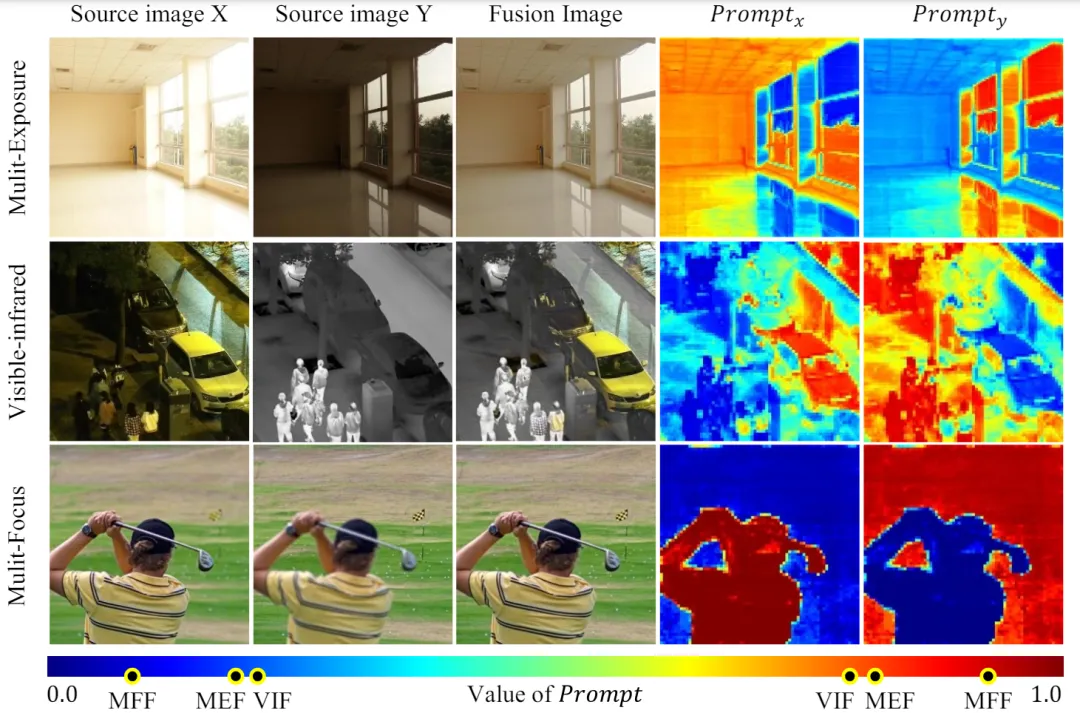

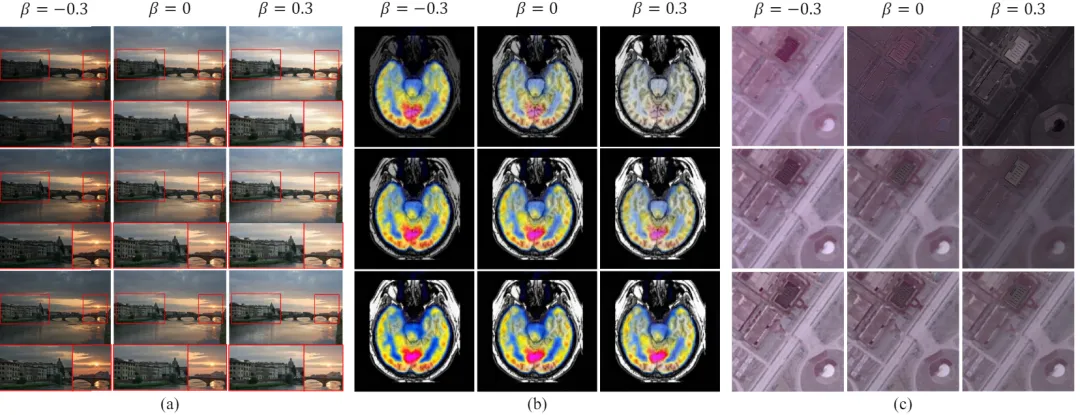

圖 1 不同融合任務的源圖像對融合結果的主導強度變化

研究背景與動機

圖像融合的目的是將同一場景中不同傳感器捕獲的多源圖像的互補信息整合到單個圖像上。這種方式通常被用于提取圖片重要信息和提高視覺質量。

目前,一般的圖像融合主要包括多模態、多曝光、多焦圖像融合等。融合任務表現出不同的融合機制。多曝光圖像融合(MEF)的重點是將具有多個曝光程度的圖像序列轉換成一個高質量的全曝光圖像。每個源圖像為融合的圖像提供自己的光照和結構信息。可見紅外圖像融合(VIF)是一種多模態圖像融合(MMF),旨在融合紅外和可見模態的互補信息,產生魯棒且信息豐富的融合圖像。紅外圖像提供更多的強度信息,而可見圖像提供更多的紋理和梯度信息。多聚焦圖像融合(MFF)的目的是從一系列部分聚焦的圖像中生成一個全聚焦的圖像。多聚焦融合圖像的每個清晰區域通常只需要學習一個源圖像。因此,可以觀察到,MEF 和 VIF 任務是多源相對平等的融合,而 MFF 是多源地位較為極端的任務,對圖像的某一區域而言,往往表現出極化的選擇。

隨著深度學習技術的快速發展,近年來圖像融合領域取得了很大的進展,而現有的方法大多只關注單一圖像融合場景,通常為單一任務采用特定策略,如為某任務設計的復雜網絡或任務特定的損失函數,導致無法直接應用在其他任務上。考慮到不同融合任務的本質相同,即整合來自多個源圖像的重要信息,最近提出的一些方法,試圖使用統一的模型處理多種融合任務,構建通用的圖像融合。然而,這些方法要么有主導任務偏差,要么為了多任務共性而犧牲個性,導致次優的性能。這促使我們探索一個更兼容的融合范式,它可以自適應地動態地兼容不同的融合場景。

為了處理這一挑戰,受到預訓練基座模型強大的特征表示能力的啟發,我們引入了基座模型作為一個凍結的編碼器來提取多源圖像的互補特征。與大多數現有方法不同的是,我們借鑒了混合專家(MoE)的思想,將每個專家作為一個高效的微調適配器,基于基座模型執行自適應視覺特征提示融合。任務特定的路由網絡定制這些適配器的混合,為不同的源生成任務特定的融合提示,形成一種新的任務定制混合適配器(TC-MoA)架構。另外,我們設計了互信息正則化來約束融合提示,從而保證了對不同來源的互補性。值得注意的是,融合提示具有顯著的任務偏差和模態主導強度差異。如圖 1 所示,MFF 的提示比 VIF 和 MEF 的色差更大,說明特征選擇在優勢模態的強度偏差上具有更多的雙極性。我們的模型有效地感知了單一模型中不同融合任務之間的融合強度偏差,因此與更廣泛的融合任務相兼容。

大量的實驗驗證了我們在通用圖像融合方面的優越性,包括多模態、多曝光和多焦點融合。更重要的是,我們的 TC-MoA 甚至對未知的融合任務顯示出了創造性的可控性和泛化性,充分展示了我們在更廣泛的融合場景中的潛力。

主要貢獻

- 我們提出了一個統一的通用圖像融合模型,提供了一種新的任務定制混合適配器(TC-MoA)用于自適應多源圖像融合(受益于動態聚合各自模式的有效信息)。

- 我們為適配器提出了一種互信息正則化方法,這使得我們的模型能夠更準確地識別不同源圖像的主導強度。

- 據我們所知,我們首次提出了一種基于 MoE 的靈活適配器。通過只添加 2.8% 的可學習參數,我們的模型可以處理許多融合任務。大量的實驗證明了我們的競爭方法的優勢,同時顯示了顯著的可控性和泛化性。

核心方法

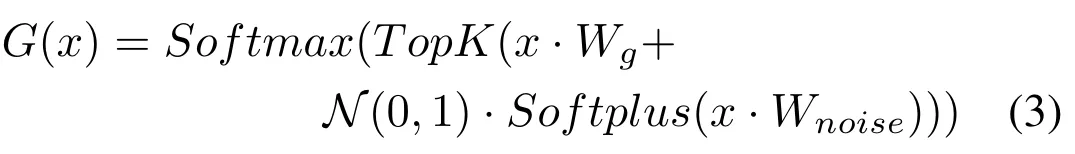

如圖 2 所示,給定一對源圖像

,網絡整合來自不同源的互補信息,獲得融合圖像

。我們將源圖像輸入 ViT 網絡,并通過 patch 編碼層獲得源圖像的 Token。ViT 由一個用于特征提取的編碼器和一個用于圖像重建的解碼器組成,這兩者都是由 Transformer 塊組成的。

在編碼器和解碼器中,每

個 Transformer 塊插入一個 TC-MoA。網絡通過這些 TC-MoA 逐步調制融合的結果。每個 TC-MoA 由一個特定于任務的路由器銀行

,一個任務共享適配器銀行

和一個提示融合層F組成。TC-MoA 包括兩個主要階段:提示生成和提示驅動的融合。為了便于表達,我們以 VIF 為例,假設輸入來自 VIF 數據集,并使用G來表示

。

。

圖 2 TC-MoA 的總體架構

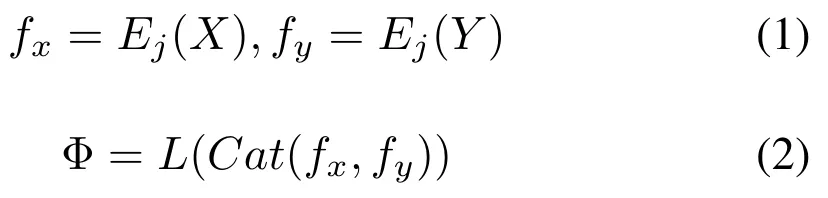

提示生成。首先,獲得后續處理的多源特征。將第 j 個 TC-MoA 之前的網絡結構定義為

,并提取提示生成特征定義為

。我們將

作為多源 Token 對的特征表示拼接起來。這允許來自不同來源的 Token 在后續的網絡中交換信息。然而,直接計算高維的拼接特征會帶來大量不必要的參數。因此,我們使用

進行特征降維,得到處理后的多源特征

,如下:

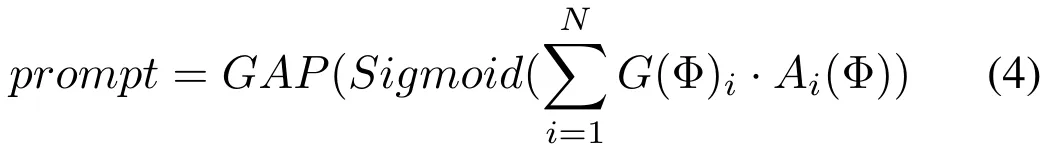

然后,根據 Φ 所屬的任務,我們從路由器銀行中選擇一個任務特定的路由器來定制路由方案,即,每對源 Token 應該輸入適配器銀行中的哪個適配器。

最后,我們對適配器的輸出進行加權求和,以獲得融合提示。每個路由器都有任務偏好來定制合適的適配器混合,然后通過適配器混合生成提示,計算方法如下:

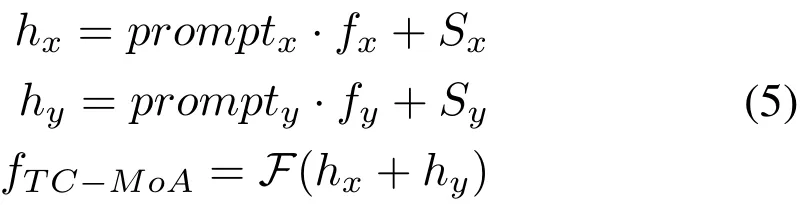

提示驅動的融合。任務定制的提示受到互信息正則化(MIR)的約束,這保證了對不同源的互補性。因此,提示可以作為對每個來源中重要信息的比例的估計。通過多源特征和提示的點乘,我們在去除冗余信息的同時保留了互補信息。然后,考慮到特征表示應該包含源相關的偏置(如可見或紅外圖像),我們為每個源引入輸入無關的可學習參數,即源編碼 s。特征在經過提示修飾和源偏置,我們得到細化的源特征

,然后經過融合層 F 獲得融合特征,過程如下:

最終,我們通過任務定制的提示獲得了一個融合特征。為了鼓勵模型逐步地提取重要信息,我們對輸出到下一個 Transformer 塊的特征定義如下(

是一個超參數):

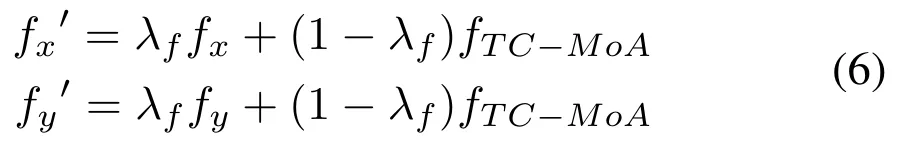

互信息正則。為了保證模型在丟棄多源特征冗余信息的同時,動態地保留互補信息,我們對提示符施加了正則化約束。假設特征表示呈線性變化,我們定義 MIR 如下:

實驗效果

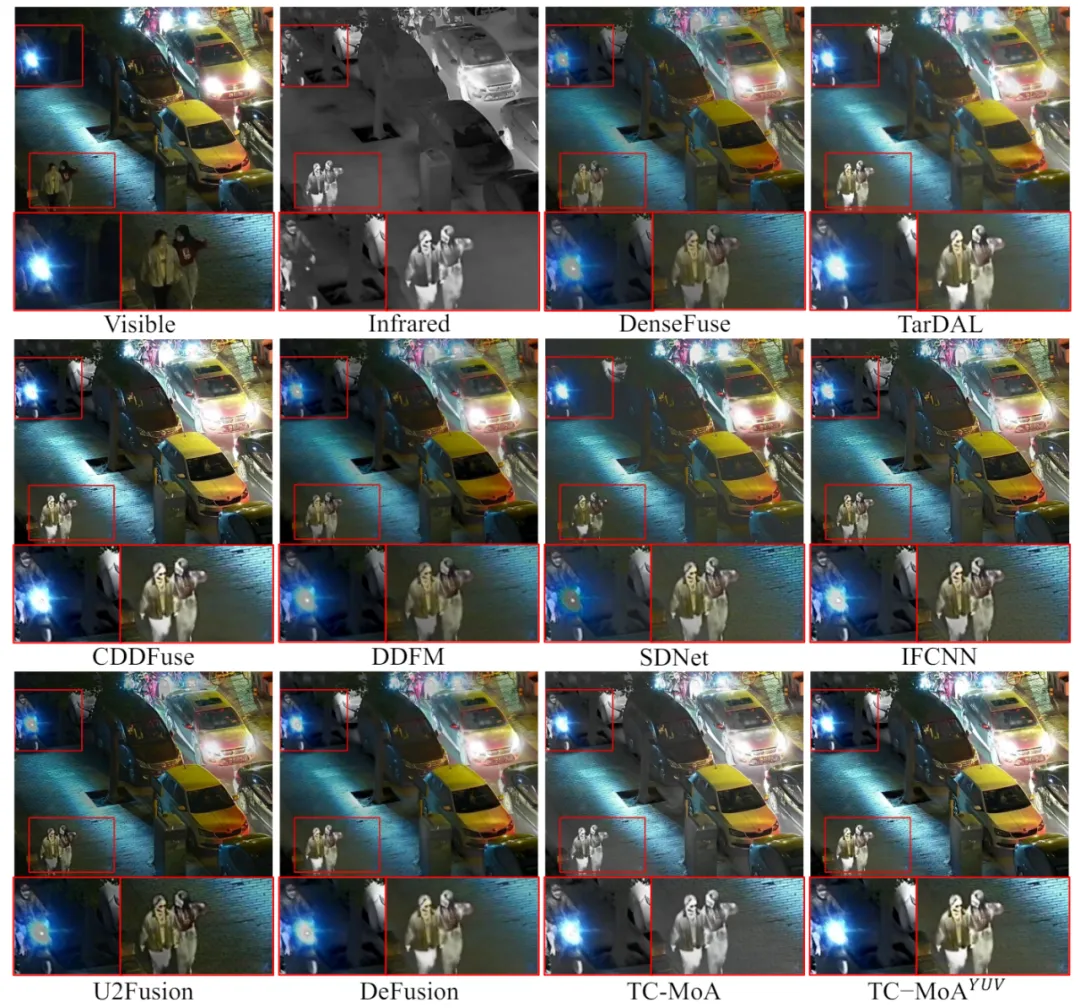

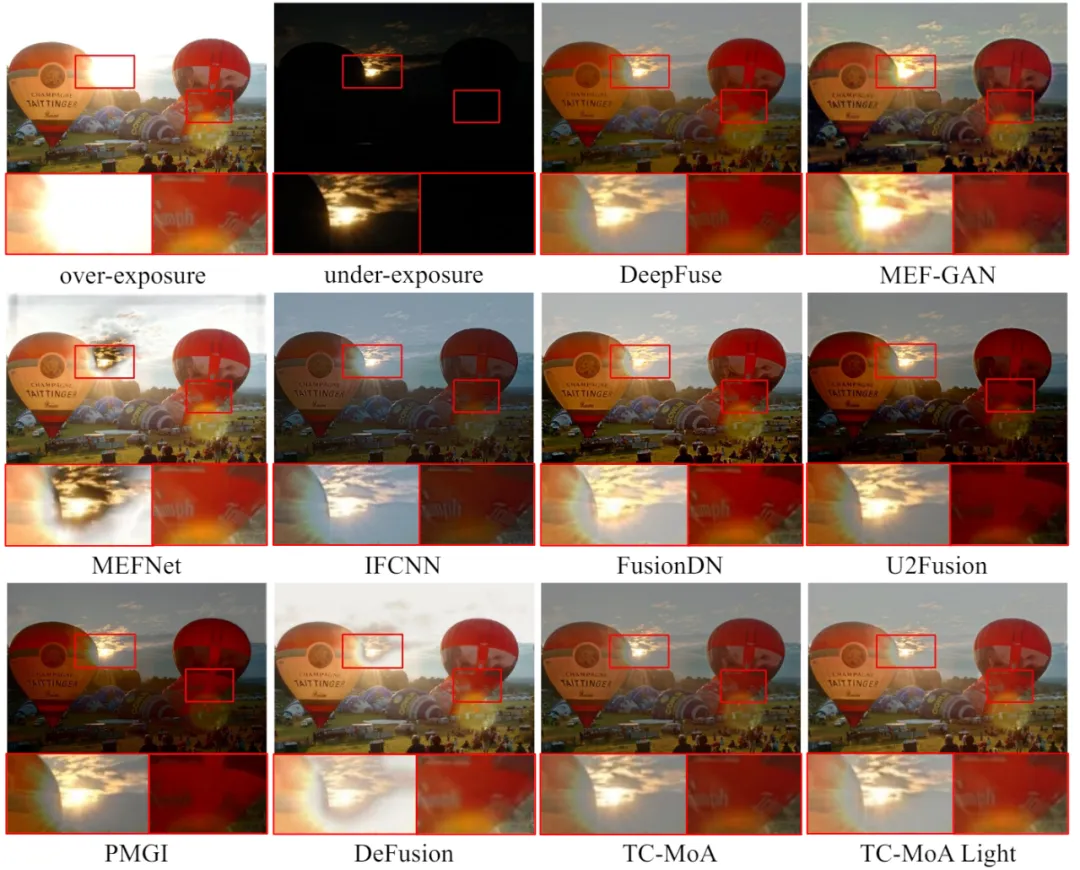

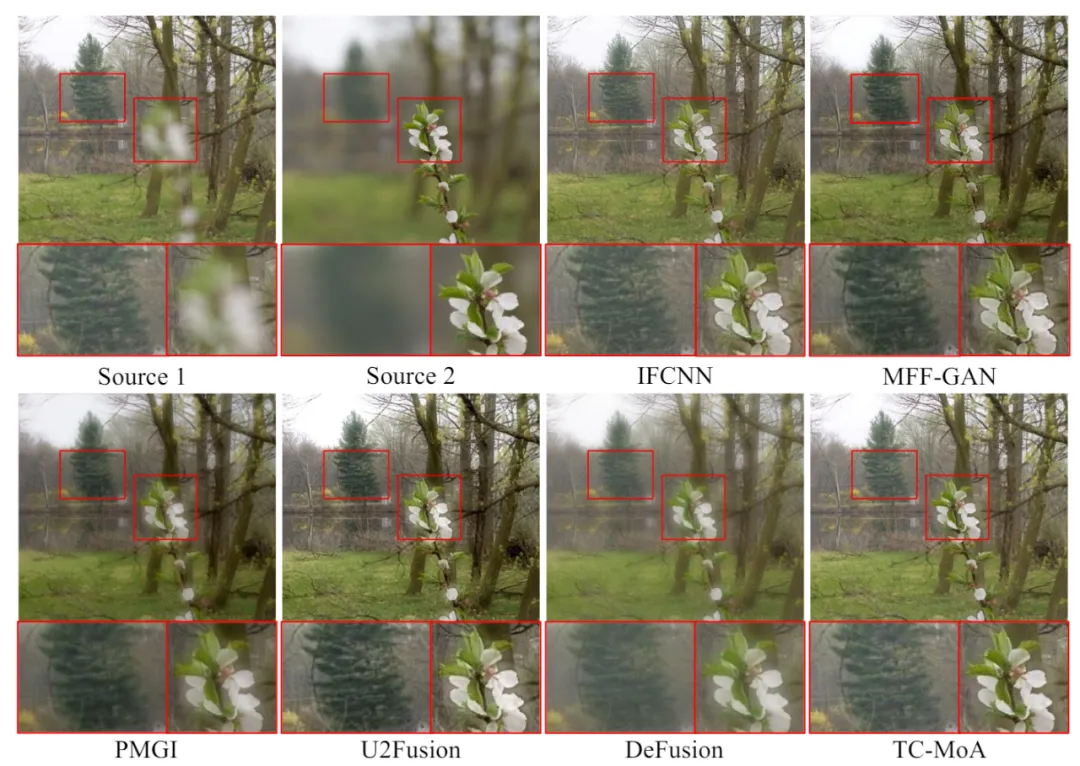

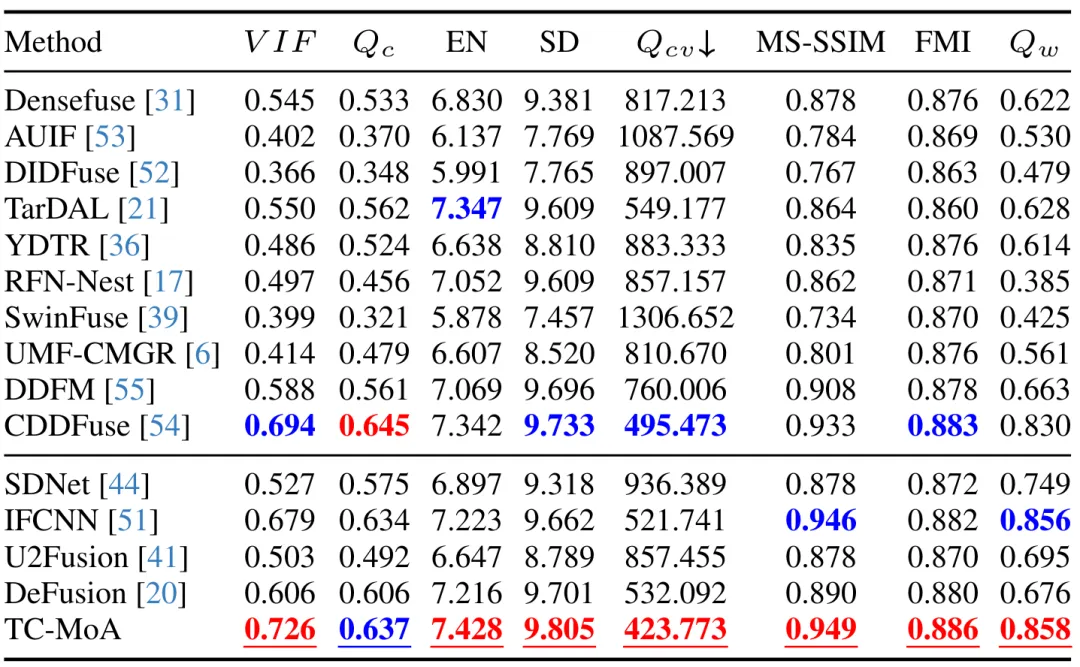

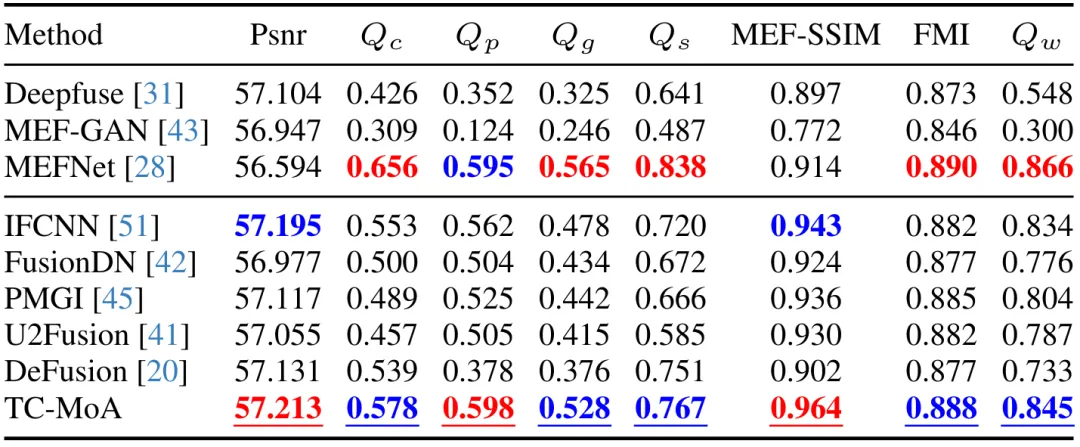

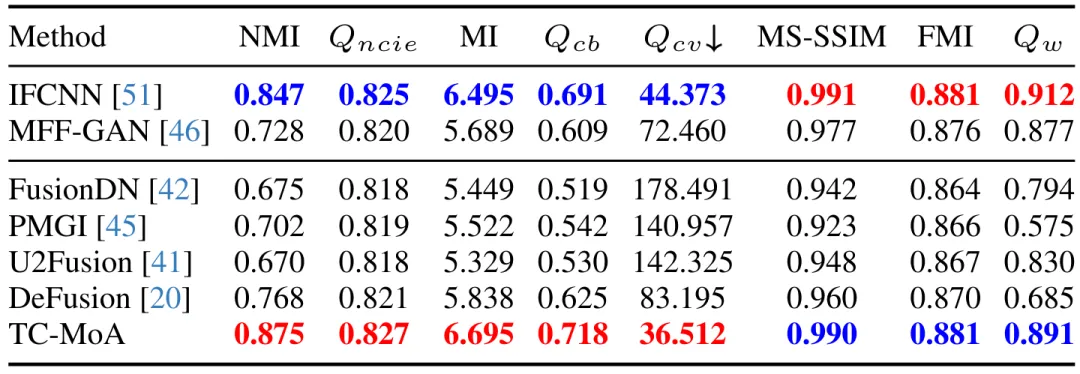

定性和定量實驗。如圖 3-5 和表 1-3 所示,在三個融合任務上的定性和定量對比表明我們的方法性能超越以往的通用融合方法。與特定任務的方法相比,我們的方法在所有任務上也達到了先進水平,甚至在部分任務(VIF)上達到了領先水平。證明了所提方法的優越性。

圖 3 VIF 任務 LLVIP 數據集上的定性比較實驗

圖 4 MEF 任務 MEFB 數據集上的定性比較實驗

圖 5 MFF 任務數據集上的定性比較實驗

表 1 VIF 任務 LLVIP 數據集上的定量比較實驗

表 2 MEF 任務 LLVIP 數據集上的定量比較實驗

表 3 MFF 任務 LLVIP 數據集上的定量比較實驗

圖 6 域內任務的可控性和未知任務的泛化性

可控性和泛化性。如圖 6 所示,通過控制融合提示的超參數 α 和 β,我們可以分別控制模型對源圖像互補信息的特征選擇強度(區域級)和融合圖像與某個源圖像的相似度(圖像級)。我們可以通過線性變換融合提示,最終實現生成定制的融合圖像。對于已知的任務,如多曝光融合,我們可以得到定制化的最符合人類感知的融合結果。對于未知任務,我們可以調制出最合適的融合參數,將模型泛化到未知任務。

本文轉自 機器之心 ,作者:機器之心