CVPR 2025 | 低層交互破局!GIFNet實(shí)現(xiàn)多模態(tài)融合通用模型,單一框架橫掃多任務(wù)場(chǎng)景

文章鏈接:https://arxiv.org/pdf/2502.19854

項(xiàng)目鏈接:https://github.com/AWCXV/GIFNet

亮點(diǎn)直擊

- 證明了低層次融合任務(wù)之間的協(xié)作訓(xùn)練(這一策略的重要性此前未被認(rèn)識(shí)到)通過(guò)利用跨任務(wù)協(xié)同效應(yīng),能夠顯著提升性能。

- 引入了重建任務(wù)和基于RGB的增強(qiáng)聯(lián)合數(shù)據(jù)集,以對(duì)齊不同融合任務(wù)的特征并解決數(shù)據(jù)支持問(wèn)題。

- 本文的方法顯著增強(qiáng)了融合系統(tǒng)的多功能性,消除了耗時(shí)的任務(wù)特定適配需求。

- GIFNet 率先將圖像融合與單模態(tài)增強(qiáng)過(guò)程集成,將圖像融合模型的應(yīng)用范圍擴(kuò)展到多模態(tài)領(lǐng)域之外。

本文的第一作者同期還發(fā)表了其他關(guān)于圖像融合的工作FusionBooster(融合通用助推器)和MMDRFuse(蒸餾實(shí)現(xiàn)超輕量化),分別發(fā)表在IJCV 25' 和ACM MM 24' (Oral) 上。代碼倉(cāng)庫(kù):

- FusionBooster: https://github.com/AWCXV/FusionBooster

- MMDRFuse: https://github.com/yanglinDeng/MMDRFuse

總結(jié)速覽

解決的問(wèn)題

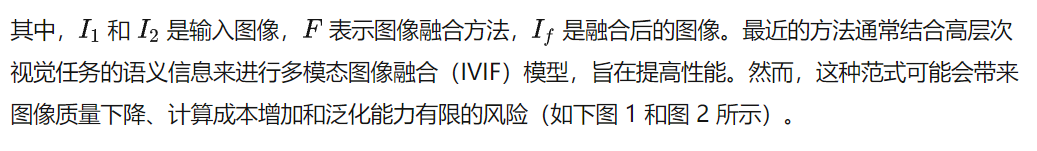

- 高層次任務(wù)與圖像融合之間的語(yǔ)義鴻溝:現(xiàn)有的高級(jí)圖像融合方法通常依賴(lài)于高層次視覺(jué)任務(wù)(如目標(biāo)檢測(cè)、語(yǔ)義分割)來(lái)提供監(jiān)督信號(hào),但這些高層次任務(wù)與像素級(jí)的圖像融合之間存在語(yǔ)義不匹配,導(dǎo)致需要復(fù)雜的橋接機(jī)制。

- 模型泛化能力差:由于不同融合任務(wù)需要不同的模型,導(dǎo)致模型在小設(shè)備(如手機(jī))上部署困難,且難以在不同融合場(chǎng)景中有效泛化。

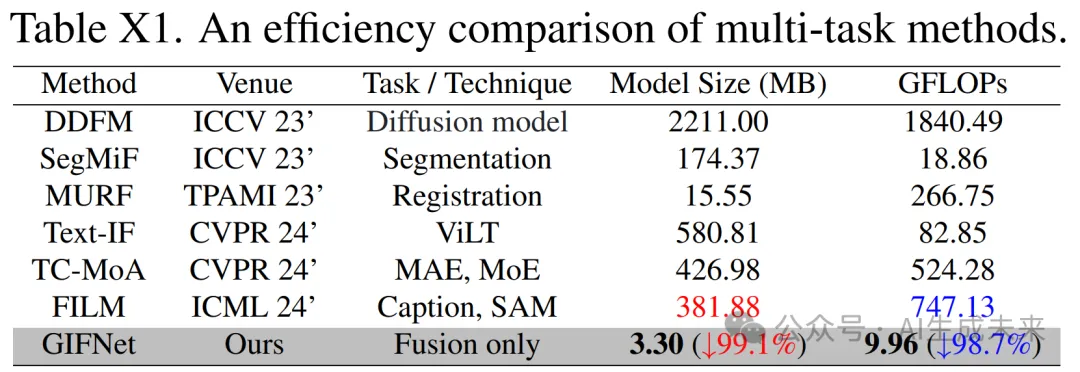

- 計(jì)算資源消耗大:現(xiàn)有方法依賴(lài)于計(jì)算密集型預(yù)訓(xùn)練模型或復(fù)雜的橋接模塊,導(dǎo)致計(jì)算成本高,難以在資源有限的設(shè)備上運(yùn)行。

提出的方案

- 低層次視覺(jué)任務(wù)驅(qū)動(dòng)的融合:提出利用低層次的數(shù)字?jǐn)z影融合任務(wù)(如多焦點(diǎn)圖像融合、多曝光圖像融合)來(lái)提供監(jiān)督信號(hào),避免高層次語(yǔ)義的干擾,增強(qiáng)任務(wù)共享的特征學(xué)習(xí)。

- GIFNet網(wǎng)絡(luò)架構(gòu):設(shè)計(jì)了一個(gè)三分支網(wǎng)絡(luò)架構(gòu)(GIFNet),包括主任務(wù)分支、輔助任務(wù)分支和調(diào)和分支。主任務(wù)分支和輔助任務(wù)分支分別處理多模態(tài)和數(shù)字?jǐn)z影特征,調(diào)和分支通過(guò)共享的重建任務(wù)促進(jìn)通用特征表示的學(xué)習(xí)。

- 跨任務(wù)特征融合機(jī)制:引入跨融合門(mén)控機(jī)制,迭代優(yōu)化每個(gè)任務(wù)特定的分支,整合多模態(tài)和數(shù)字?jǐn)z影特征,生成融合結(jié)果。

- RGB聯(lián)合數(shù)據(jù)集:通過(guò)數(shù)據(jù)增強(qiáng)技術(shù)創(chuàng)建基于RGB的聯(lián)合數(shù)據(jù)集,減少多模態(tài)和數(shù)字?jǐn)z影任務(wù)之間的數(shù)據(jù)域差距,使模型能夠在統(tǒng)一上下文中提取一致的特征。

應(yīng)用的技術(shù)

- 低層次視覺(jué)任務(wù)監(jiān)督:利用數(shù)字?jǐn)z影融合任務(wù)(如多焦點(diǎn)圖像融合、多曝光圖像融合)提供像素級(jí)監(jiān)督信號(hào)。

- 三分支網(wǎng)絡(luò)架構(gòu):GIFNet網(wǎng)絡(luò)包含主任務(wù)分支、輔助任務(wù)分支和調(diào)和分支,分別處理多模態(tài)特征、數(shù)字?jǐn)z影特征和共享重建任務(wù)。

- 跨融合門(mén)控機(jī)制:通過(guò)門(mén)控機(jī)制迭代優(yōu)化多模態(tài)和數(shù)字?jǐn)z影特征的融合。

- 數(shù)據(jù)增強(qiáng)與聯(lián)合數(shù)據(jù)集:通過(guò)數(shù)據(jù)增強(qiáng)技術(shù)創(chuàng)建RGB聯(lián)合數(shù)據(jù)集,減少多模態(tài)和數(shù)字?jǐn)z影任務(wù)之間的數(shù)據(jù)域差距。

達(dá)到的效果

- 高效的特征學(xué)習(xí):通過(guò)低層次任務(wù)監(jiān)督,GIFNet能夠在不依賴(lài)高層次語(yǔ)義的情況下,有效學(xué)習(xí)任務(wù)共享的基礎(chǔ)特征,增強(qiáng)了模型的泛化能力。

- 廣泛的應(yīng)用場(chǎng)景:GIFNet能夠支持多種融合任務(wù)(如多模態(tài)融合、數(shù)字?jǐn)z影融合),并且在未見(jiàn)過(guò)的場(chǎng)景中也能表現(xiàn)出色,實(shí)現(xiàn)了單一模型的廣泛適用性。

- 計(jì)算成本大幅降低:與現(xiàn)有高級(jí)圖像融合方法相比,GIFNet的計(jì)算成本降低了96%以上,適合在資源有限的設(shè)備上部署。

- 單模態(tài)增強(qiáng)能力:GIFNet不僅支持多模態(tài)融合,還能夠?qū)文B(tài)輸入進(jìn)行增強(qiáng),提供了更高的應(yīng)用靈活性。

提出的 GIFNet

公式化

圖像融合范式通常可以定義為:

本文提出了一種新穎的方法,引入了兩個(gè)創(chuàng)新點(diǎn)。第一個(gè)是跨任務(wù)交互機(jī)制,利用各種融合任務(wù)中的低層次處理操作。本文使用數(shù)字?jǐn)z影圖像融合任務(wù)為無(wú)監(jiān)督的 IVIF 任務(wù)提供額外的任務(wù)特定特征和監(jiān)督信號(hào),從而提高融合模型的泛化能力和魯棒性。選擇多焦點(diǎn)圖像融合(MFIF)作為數(shù)字?jǐn)z影融合的代表性示例來(lái)展示GIFNet 模型,因?yàn)樗谖覀兊慕换ハ趯?shí)驗(yàn)中表現(xiàn)最佳。

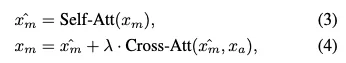

本文方法的第二個(gè)創(chuàng)新點(diǎn)是引入了單模態(tài)圖像增強(qiáng)能力。通過(guò)引入數(shù)字?jǐn)z影融合任務(wù)(一張圖像具有不同的設(shè)置),模型學(xué)會(huì)在不依賴(lài)多模態(tài)輸入的情況下增強(qiáng)特征。通過(guò)將兩個(gè)輸入設(shè)置為同一張圖像,模擬了一種類(lèi)似融合的增強(qiáng)過(guò)程,專(zhuān)注于優(yōu)化單張圖像中的細(xì)節(jié)。這一推理過(guò)程公式化為:

緩解域差距和任務(wù)差異的措施

本文的多任務(wù)學(xué)習(xí)框架要求模型從輸入圖像中提取并學(xué)習(xí)每個(gè)任務(wù)的獨(dú)特特征。如果不采取明確措施,這種多樣性可能會(huì)導(dǎo)致模型的學(xué)習(xí)目標(biāo)不一致,從而難以開(kāi)發(fā)出在所有任務(wù)中都能有效執(zhí)行的統(tǒng)一表示。

為了解決這個(gè)問(wèn)題,本文采用數(shù)據(jù)增強(qiáng)技術(shù)從 IVIF 基準(zhǔn)數(shù)據(jù)集生成一個(gè)以 RGB 為中心的聯(lián)合數(shù)據(jù)集。這個(gè)增強(qiáng)數(shù)據(jù)集包括對(duì)齊的 RGB、紅外、遠(yuǎn)焦和近焦圖像。多焦點(diǎn)數(shù)據(jù)是通過(guò)部分模糊清晰的 RGB 圖像獲得的(詳細(xì)信息見(jiàn)補(bǔ)充材料)。由于數(shù)據(jù)來(lái)自同一場(chǎng)景的單個(gè)數(shù)據(jù)集,域差距得到了有效減少。此外,在跨任務(wù)交互中引入了重建(REC)任務(wù)。

REC 任務(wù)通過(guò)關(guān)注對(duì)多個(gè)任務(wù)都有益的特征,促進(jìn)了不同任務(wù)之間的特征對(duì)齊。這種方法確保為一個(gè)任務(wù)學(xué)習(xí)的特征在其他任務(wù)中仍然相關(guān)且兼容,從而促進(jìn)任務(wù)之間更一致和有效的交互。

模型架構(gòu)

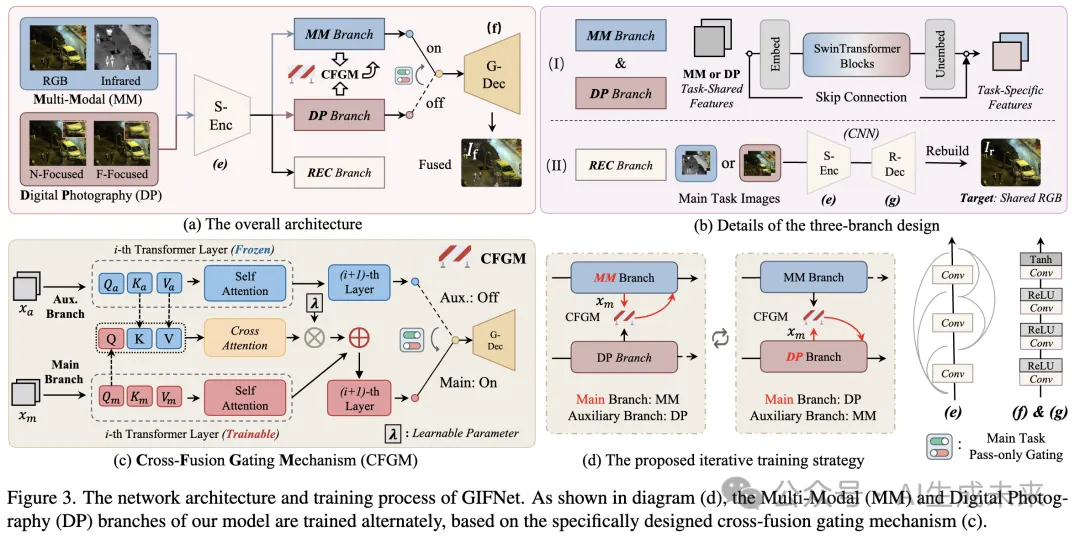

當(dāng)前的圖像融合方法由于其單一的網(wǎng)絡(luò)設(shè)計(jì)(多個(gè)任務(wù)依賴(lài)于單一的編碼器-解碼器結(jié)構(gòu)),在協(xié)作學(xué)習(xí)方面常常遇到困難。為了解決這個(gè)問(wèn)題,我們的框架引入了一種三分支架構(gòu)(如下圖 3 (a) 所示),該架構(gòu)解耦了特征提取過(guò)程,并促進(jìn)了低層次任務(wù)之間的交互。在我們的模型中,只有基礎(chǔ)特征提取部分在不同任務(wù)之間共享。

通過(guò)專(zhuān)注于低層次任務(wù)之間的交互,我們的方法允許任務(wù)特定特征直接在網(wǎng)絡(luò)內(nèi)組合,從而無(wú)需額外的模塊來(lái)橋接特征或語(yǔ)義差距。這種交互發(fā)生在多模態(tài)(MM)和數(shù)字?jǐn)z影(DP)分支之間,其中跨任務(wù)機(jī)制交替主分支和輔助分支的角色(圖 3 (d))。然后,門(mén)控模塊選擇性地將主分支的混合特征路由到全局解碼器(G-Dec)以生成融合結(jié)果。重建(REC)分支通過(guò)提取任務(wù)無(wú)關(guān)的特征來(lái)支持這一過(guò)程。

重建分支:如圖 3 (b) (II) 所示,REC 分支采用自編碼器從各種圖像融合任務(wù)中提取通用特征。通過(guò)針對(duì)增強(qiáng)數(shù)據(jù)中的共同 RGB 模態(tài)進(jìn)行重建,我們確保有效提取任務(wù)共享特征。共享編碼器(S-Enc)中的密集連接最大化特征利用率,使原始視覺(jué)信號(hào)能夠傳輸?shù)狡渌种А?/p>

跨融合門(mén)控機(jī)制:在獲得這些共享特征后,MM 和 DP 分支繼續(xù)提取不同融合類(lèi)型的任務(wù)特定特征(圖 3 (b) (I))。提出的跨融合門(mén)控機(jī)制(CFGM)作為控制這些分支的核心技術(shù),使它們能夠融合任務(wù)特定特征并自適應(yīng)地穩(wěn)定跨任務(wù)交互。鑒于其眾所周知的魯棒全局特征提取能力及其在捕獲任務(wù)感知特征方面的成功,使用高效的 SwinTransformer 模塊來(lái)構(gòu)建 CFGM。

在 CFGM 中,主分支和輔助分支通過(guò)交替更新一個(gè)分支并凍結(jié)另一個(gè)分支來(lái)進(jìn)行訓(xùn)練(圖 3 (c))。在每個(gè)訓(xùn)練步驟中:

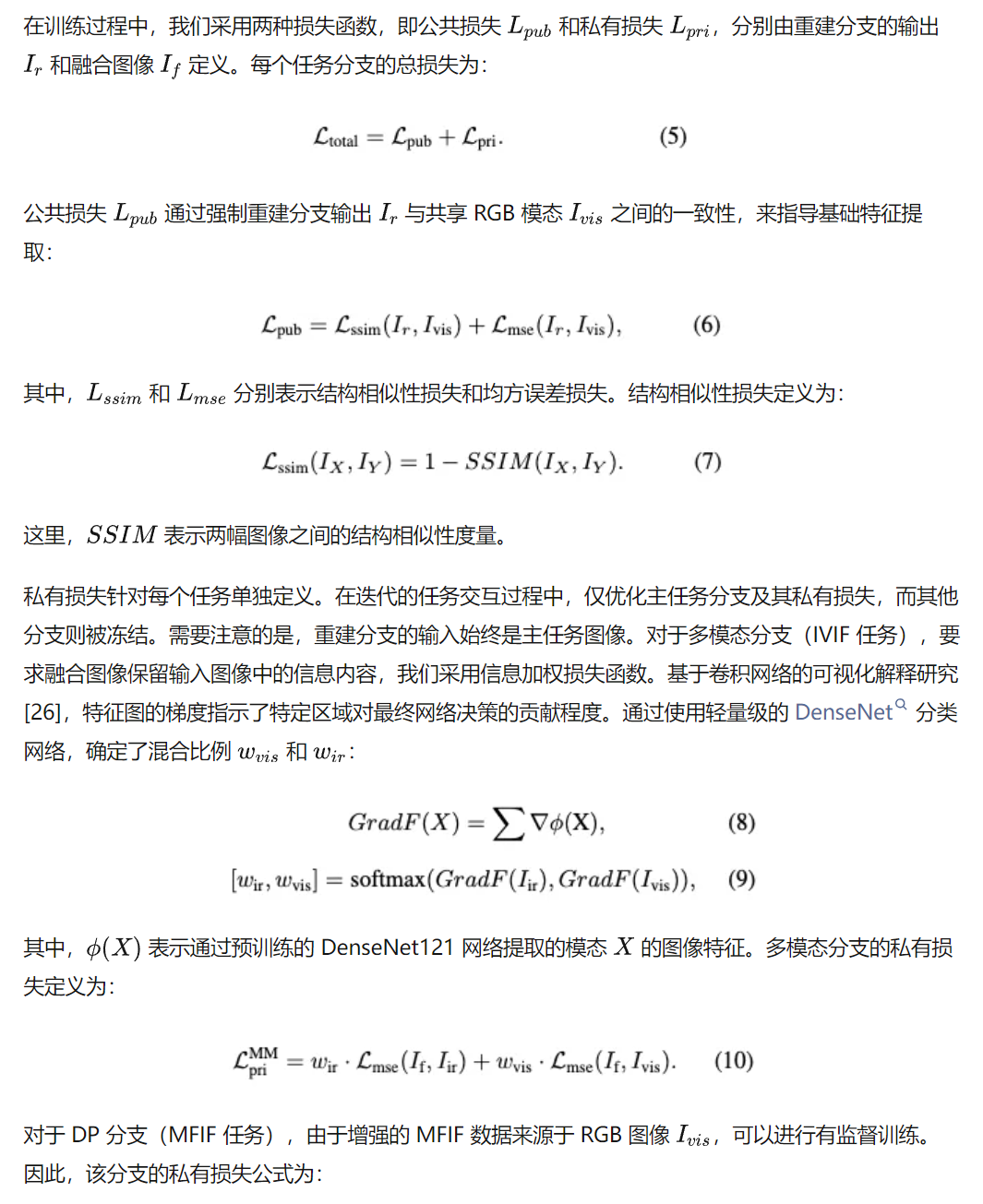

訓(xùn)練與推理

如下圖 4 所示,在推理過(guò)程中,與訓(xùn)練過(guò)程不同,單個(gè)融合任務(wù)只需要一對(duì)圖像。我們首先提取共享圖像特征,使用跨融合門(mén)控機(jī)制(CFGM)融合兩組特定表示,最后通過(guò)全局解碼器重建融合圖像。

實(shí)驗(yàn)結(jié)果

實(shí)驗(yàn)設(shè)置

訓(xùn)練:在訓(xùn)練過(guò)程中,僅使用 IVIF 數(shù)據(jù)集(LLVIP的訓(xùn)練集)和 DP 任務(wù)對(duì)應(yīng)的增強(qiáng)數(shù)據(jù)。評(píng)估:訓(xùn)練完成后,直接將模型應(yīng)用于各種已見(jiàn)和未見(jiàn)的圖像融合任務(wù),無(wú)需任何適配或微調(diào)。使用的任務(wù)和數(shù)據(jù)集包括:

- IVIF 任務(wù):LLVIP 和 TNO數(shù)據(jù)集

- MFIF 任務(wù):Lytro 和 MFI-WHU 數(shù)據(jù)集

- 醫(yī)學(xué)圖像融合任務(wù):Harvard 數(shù)據(jù)集

- 近紅外和可見(jiàn)光圖像融合任務(wù):VIS-NIR Scene 數(shù)據(jù)集

- 多曝光圖像融合任務(wù):SCIE 數(shù)據(jù)集

- 遙感圖像融合任務(wù):Quickbird 數(shù)據(jù)集此外,還在 CIFAR100 數(shù)據(jù)集 上驗(yàn)證了 GIFNet 在分類(lèi)任務(wù)中的有效性。

評(píng)估指標(biāo):

- 圖像融合:使用兩種常用的基于相關(guān)性的指標(biāo)——視覺(jué)信息保真度(VIF)和相關(guān)性差異總和(SCD),以及無(wú)參考圖像質(zhì)量評(píng)估指標(biāo)——邊緣強(qiáng)度(EI)和平均梯度(AG)來(lái)衡量融合結(jié)果的清晰度。

- 分類(lèi)任務(wù):使用 top-1 和 top-5 準(zhǔn)確率。

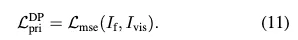

消融實(shí)驗(yàn)

本節(jié)在 IVIF 任務(wù)上進(jìn)行了消融實(shí)驗(yàn),以驗(yàn)證 GIFNet 的有效性。主要研究了多任務(wù)學(xué)習(xí)(MTL)策略、跨融合門(mén)控機(jī)制(CFGM)和重建分支(REC)的影響。更多消融實(shí)驗(yàn)將在補(bǔ)充材料中提供。

主要組件:如下表 1 所示,將單任務(wù)訓(xùn)練策略與 REC 結(jié)合(案例 (e)),所提出的模型已經(jīng)取得了令人印象深刻的結(jié)果。然而,在沒(méi)有引入所提出組件的情況下添加另一個(gè)任務(wù)會(huì)導(dǎo)致融合網(wǎng)絡(luò)無(wú)法收斂(案例 (g))。單獨(dú)引入 CFGM 或 REC 可以使網(wǎng)絡(luò)生成有效的融合結(jié)果(案例 (h) 和 (i))。兩者的結(jié)合優(yōu)化了跨任務(wù)交互并增強(qiáng)了特征對(duì)齊,從而使 GIFNet 達(dá)到最佳性能。

任務(wù)組合:數(shù)字?jǐn)z影任務(wù)的額外監(jiān)督信號(hào)有助于提升融合性能。通過(guò)使用有監(jiān)督的 MEIF 任務(wù)進(jìn)一步驗(yàn)證了這一結(jié)論。關(guān)于訓(xùn)練數(shù)據(jù),使用 FusionBooster中的信息探測(cè)模塊分解 LLVIP 數(shù)據(jù)集中的可見(jiàn)光圖像,以獲得過(guò)曝光和欠曝光圖像(示例見(jiàn)補(bǔ)充材料)。原始可見(jiàn)光圖像被視為 GT 圖像。如案例 (j) 所示,與單任務(wù)范式(設(shè)置 (d))相比,額外的有監(jiān)督任務(wù)可以持續(xù)提升多模態(tài)融合的性能。然而,MEIF 任務(wù)作為輔助任務(wù),其性能不如使用 MFIF 任務(wù)。這種現(xiàn)象的原因可能是生成更高清晰度的圖像提供了更兼容的像素級(jí)監(jiān)督,因?yàn)閺?qiáng)制融合圖像感知更高清晰度的內(nèi)容與盡可能保留信息之間沒(méi)有沖突。相比之下,MEIF 任務(wù)僅涉及整體曝光度的調(diào)整,并不總是與 IVIF 任務(wù)的目標(biāo)一致。

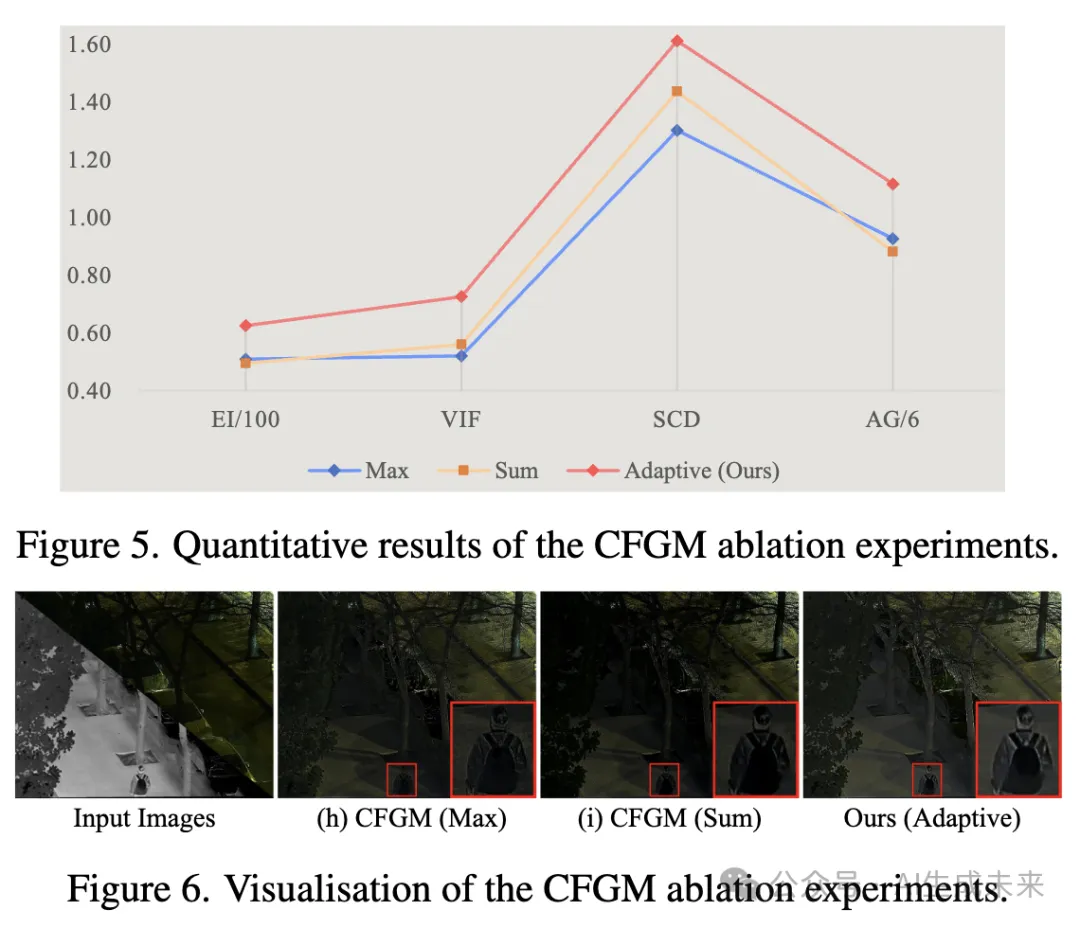

CFGM 模塊:如下圖 5 和圖 6 所示,將自適應(yīng)的 CFGM 策略(通過(guò)可學(xué)習(xí)參數(shù) 控制混合比例)替換為傳統(tǒng)的融合操作,定量和定性結(jié)果表明,我們的自適應(yīng)方法在交互過(guò)程中提供了更優(yōu)的控制,生成了更魯棒的融合圖像。

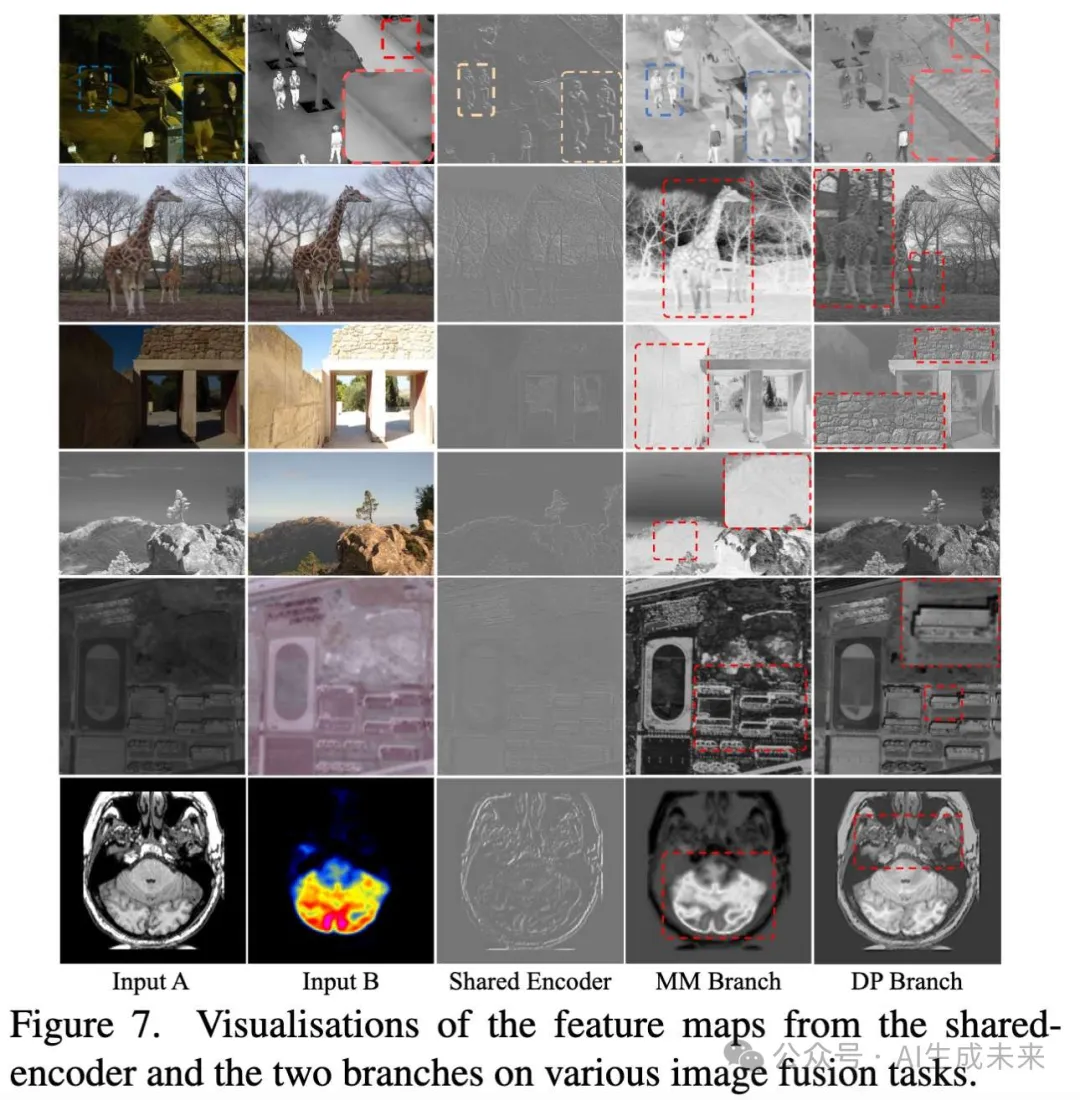

特征可視化

本文展示了來(lái)自不同組件的特征圖可視化結(jié)果,包括共享編碼器(S-Enc)、多模態(tài)分支(MM)和數(shù)字?jǐn)z影分支(DP),如下圖 7 所示。由圖像重建目標(biāo)驅(qū)動(dòng)的 S-Enc 捕捉了基礎(chǔ)圖像特征,例如目標(biāo)輪廓和結(jié)構(gòu)細(xì)節(jié),這些特征對(duì)于高質(zhì)量圖像融合至關(guān)重要。

MM 和 DP 分支的可視化結(jié)果揭示了每個(gè)分支對(duì)融合過(guò)程的不同貢獻(xiàn)。例如,在第一個(gè)案例中,MM 特征專(zhuān)注于保留源輸入中的顯著信息(如熱目標(biāo)),而 DP 特征則增強(qiáng)了更精細(xì)的細(xì)節(jié),捕捉了更清晰的邊緣和更明確的紋理,以及地面上更清晰的陰影。在其他已見(jiàn)和未見(jiàn)的融合任務(wù)中也觀察到了類(lèi)似的模式。值得注意的是,數(shù)字?jǐn)z影特征的額外學(xué)習(xí)通過(guò)生成視覺(jué)魯棒輸出所需的特征,持續(xù)為各種融合任務(wù)帶來(lái)益處,如第三個(gè)示例(MEIF 任務(wù))中增強(qiáng)的紋理細(xì)節(jié)所示。

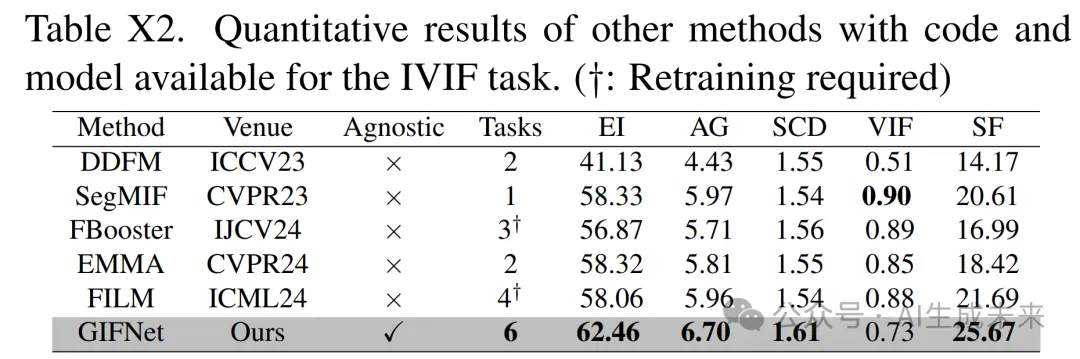

多模態(tài) - 已見(jiàn)任務(wù)

本節(jié)展示了 GIFNet 在與訓(xùn)練數(shù)據(jù)相關(guān)的任務(wù)(即 MFIF 和 IVIF 任務(wù))上的融合結(jié)果。將所提出的方法與針對(duì)這兩個(gè)任務(wù)的專(zhuān)用算法進(jìn)行了比較,包括 Text-IF、CDDFuse、DDFM、LRRNet、ZMFF 和 UNIFusion。還與廣義圖像融合方法進(jìn)行了比較,包括 MURF、MUFusion、U2Fusion 和 SDNet。

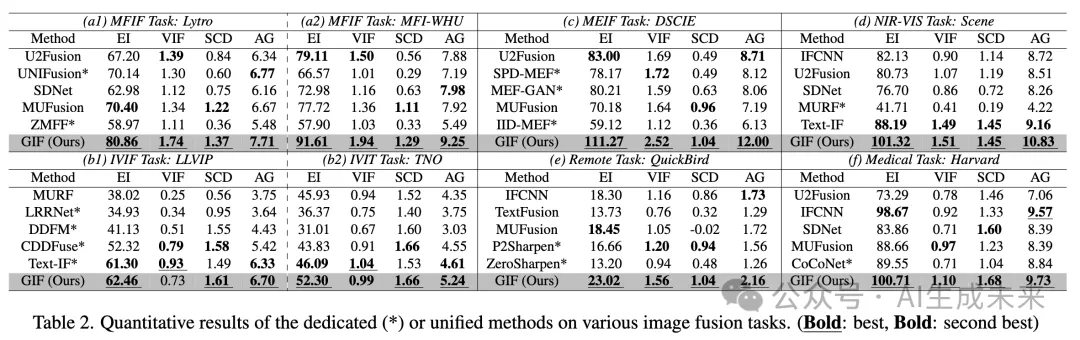

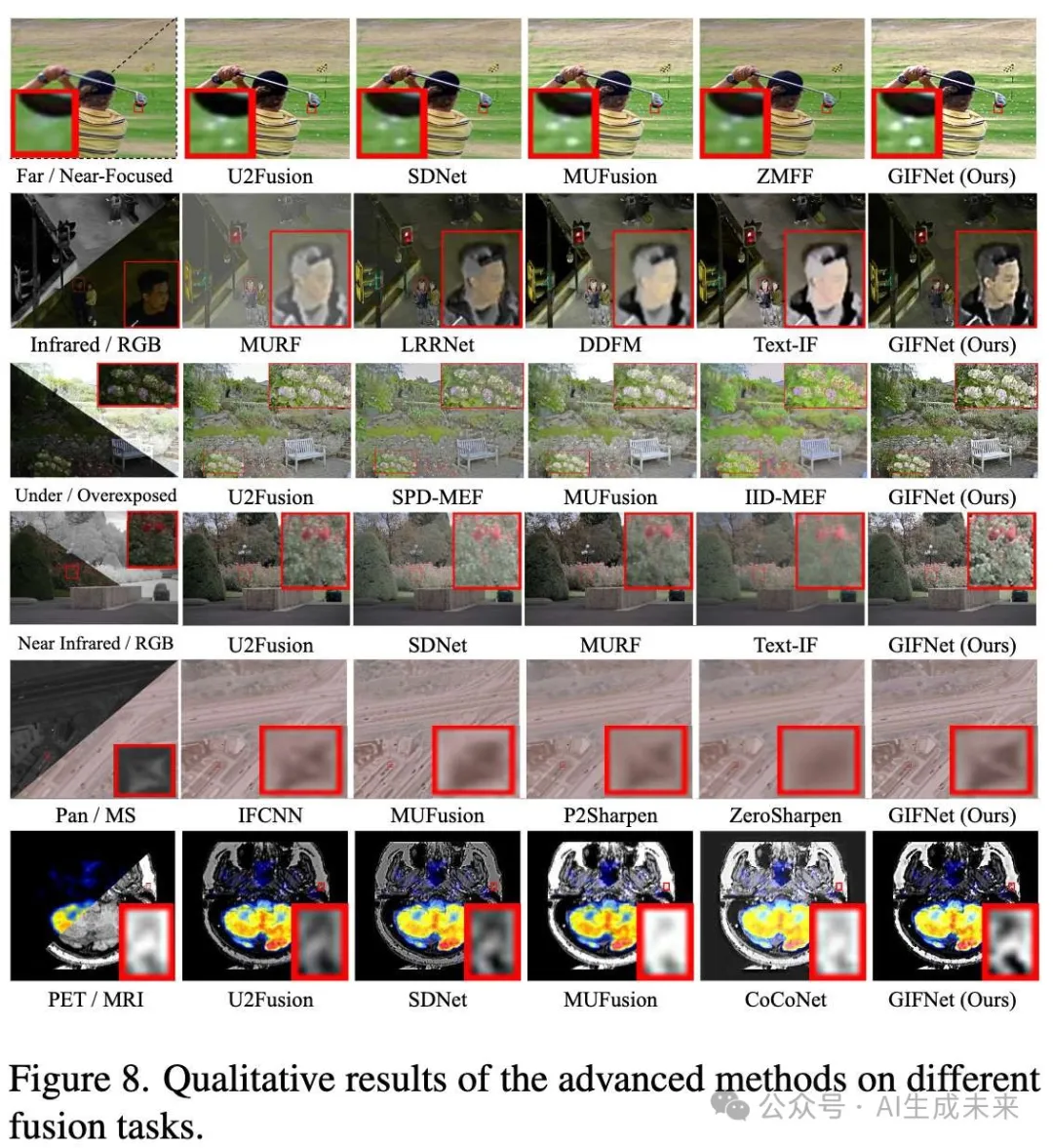

MFIF 任務(wù):如下表 2 (a1) 和 (a2) 所示,GIFNet 在各種圖像融合評(píng)估指標(biāo)上取得了顯著成果。例如,在 VIF 指標(biāo)上表現(xiàn)最佳,提升了 25%,表明我們的融合結(jié)果能夠有效增強(qiáng)源信息,如下圖 8 第一行所示。

IVIF 任務(wù):對(duì)于 IVIF 任務(wù),如圖 8 第二行所示,得益于協(xié)作訓(xùn)練,我們的融合結(jié)果能夠更好地調(diào)整源模態(tài)的混合比例。RGB 圖像中的豐富紋理細(xì)節(jié)得到了很好的保留,熱輻射信息則使場(chǎng)景外觀更加明亮。因此,在低光和普通條件下,GIFNet 在所有定量實(shí)驗(yàn)中普遍表現(xiàn)最佳(表 2 (b1) 和 (b2))。在 LLVIP 數(shù)據(jù)集上 VIF 指標(biāo)相對(duì)較差的結(jié)果可以歸因于 CDDFuse 和 Text-IF 中的“選擇最大值”融合策略,該策略保留了輸入中像素值較高的源內(nèi)容。雖然這種方法確保了高視覺(jué)保真度(VIF),但融合圖像往往偏向于一種輸入模態(tài),而忽略了另一種模態(tài)的信息(見(jiàn) Text-IF 的可視化結(jié)果)。

多模態(tài) - 未見(jiàn)過(guò)任務(wù)

本節(jié)展示了GIFNet 在未參與訓(xùn)練的任務(wù)上的融合結(jié)果,包括多曝光圖像融合、近紅外與可見(jiàn)光圖像融合、遙感圖像融合和醫(yī)學(xué)圖像融合任務(wù)。同樣,進(jìn)一步將我們的方法與專(zhuān)門(mén)為這四項(xiàng)任務(wù)設(shè)計(jì)的算法進(jìn)行了比較,包括 MEF-GAN 、SPD-MEF、IID-MEF、MURF、P2Sharpen、ZeroSharpen、CoCoNet、TextFusion(在圖像融合領(lǐng)域引入文本信息的方法)以及廣義方法 IFCNN。

MEIF 任務(wù):GIFNet 在 MEIF 任務(wù)中對(duì)曝光不良的圖像表現(xiàn)良好。如前面圖 8 第三行所示,在整體曝光度(該任務(wù)的重要標(biāo)準(zhǔn))方面,我們的結(jié)果具有更合適的亮度,且沒(méi)有嚴(yán)重的顏色失真(見(jiàn)高亮區(qū)域)。在定量評(píng)估中(表 2 (c)),與先進(jìn)方法相比,我們?cè)谒袌D像融合指標(biāo)上均取得了更高的性能,例如 VIF(+46.7%)和 AG(+37.8%)。

NIR-VIS 任務(wù):該任務(wù)與 IVIF 類(lèi)似,但將中遠(yuǎn)紅外模態(tài)替換為近紅外圖像。如圖 8 第四行所示,現(xiàn)有融合方法利用 NIR 模態(tài)信息持續(xù)改善了 RGB 圖像的低光條件,而我們的 GIFNet 則表現(xiàn)出最清晰的紋理細(xì)節(jié)。定量結(jié)果也表明,GIFNet 優(yōu)于現(xiàn)有算法(表 2 (d))。值得注意的是,盡管 MURF 在該任務(wù)上進(jìn)行了訓(xùn)練,但其更側(cè)重于解決配準(zhǔn)問(wèn)題,導(dǎo)致性能相對(duì)較差。

遙感任務(wù):該任務(wù)也稱(chēng)為全色銳化,旨在同時(shí)保持全色和多光譜圖像的空間和光譜分辨率。如圖 8 倒數(shù)第二行所示,與之前的任務(wù)類(lèi)似,GIFNet 獲得了具有更清晰邊緣信息和更高成像質(zhì)量的融合圖像。相比之下,其他方法未能保持高分辨率全色模態(tài)中物體的形狀。盡管 P2Sharpen 和 ZeroSharpen 專(zhuān)門(mén)為該任務(wù)設(shè)計(jì),但在多個(gè)指標(biāo)上均被我們的方法超越,如表 2 (e) 的定量結(jié)果所示。

醫(yī)學(xué)任務(wù):醫(yī)學(xué)圖像融合任務(wù)旨在保留磁共振成像(MRI)中的顯著器官結(jié)構(gòu)和正電子發(fā)射斷層掃描(PET)中的清晰功能信息。如表 2 (f) 所示,盡管未專(zhuān)門(mén)針對(duì)該任務(wù)進(jìn)行訓(xùn)練,GIFNet 在其融合結(jié)果中表現(xiàn)出強(qiáng)大的視覺(jué)信息保真度(VIF)并保持了與源輸入的高相關(guān)性(SCD)。這一性能與圖 8 最后一行的可視化結(jié)果一致,即細(xì)節(jié)增強(qiáng),清楚地表明 GIFNet 的結(jié)果很好地呈現(xiàn)了 MRI 模態(tài)的局部結(jié)構(gòu)。

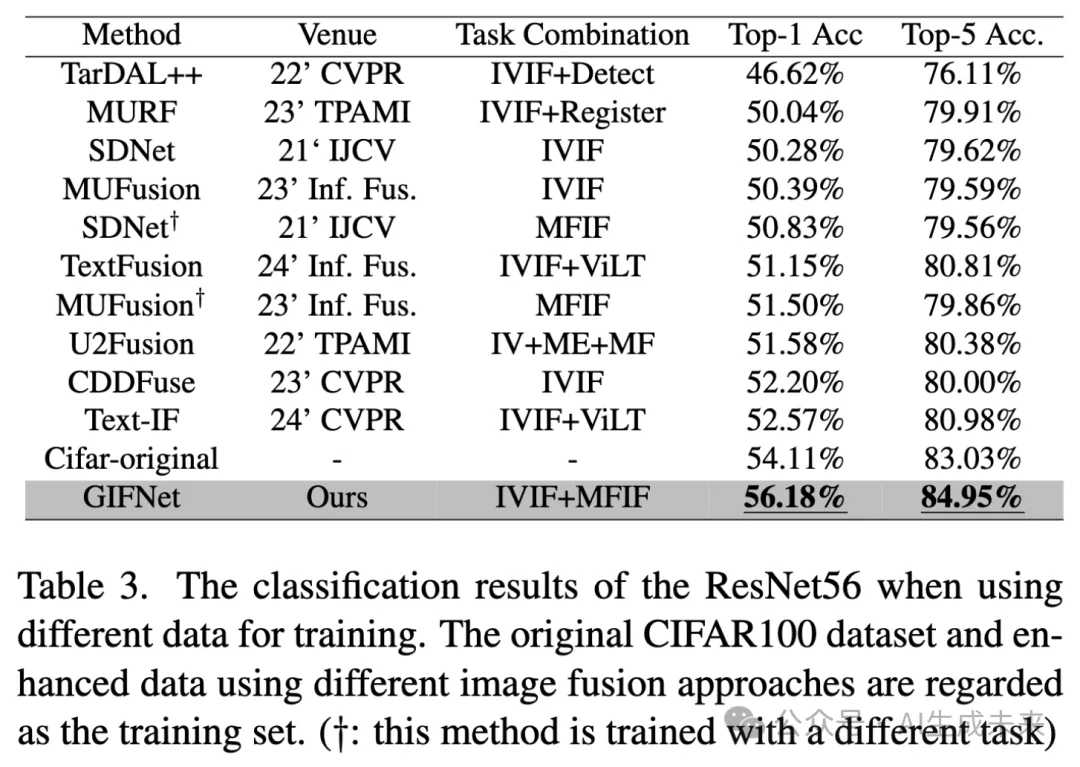

單模態(tài):分類(lèi)任務(wù)

GIFNet 的多功能性涵蓋了多模態(tài)圖像處理和單模態(tài)任務(wù)。本實(shí)驗(yàn)評(píng)估了 GIFNet 通過(guò)增強(qiáng)圖像作為輸入來(lái)提升 RGB 圖像分類(lèi)的能力。使用原始 CIFAR100 訓(xùn)練集和通過(guò)不同圖像融合方法獲得的增強(qiáng)數(shù)據(jù)從頭訓(xùn)練 ResNet56 網(wǎng)絡(luò)。訓(xùn)練完成后,ResNet56 分類(lèi)器用于評(píng)估在原始測(cè)試集上的性能。

如下圖 9 所示,展示了原始 CIFAR100 RGB 圖像以及通過(guò)不同方法生成的增強(qiáng)版本。GIFNet 在圖像質(zhì)量上表現(xiàn)出顯著提升。例如,在第一行中,原始數(shù)據(jù)中的模糊現(xiàn)象得到了緩解,保留了更清晰的信息。在第二個(gè)示例中,我們的方法在邊緣增強(qiáng)方面表現(xiàn)出色,優(yōu)于其他技術(shù)。

定量評(píng)估結(jié)果(下表 3)表明,某些融合方法在不提高圖像質(zhì)量的情況下,其分類(lèi)性能與原始數(shù)據(jù)集相當(dāng),例如 SDNet 和 MUFusion。需要注意的是,U2Fusion 雖然利用了更多的融合任務(wù),但由于其順序訓(xùn)練策略缺乏有效交互,導(dǎo)致增強(qiáng)效果不佳。相比之下,利用跨任務(wù)交互中的任務(wù)無(wú)關(guān)表示,GIFNet 是唯一超越原始訓(xùn)練設(shè)置的方法。

關(guān)鍵模型大小對(duì)比和與更先進(jìn)方法的性能比較

結(jié)論

本文提出了一種新穎的低層次任務(wù)交互方法,用于廣義圖像融合,解決了該領(lǐng)域一個(gè)長(zhǎng)期被忽視的問(wèn)題。通過(guò)整合共享重建任務(wù)和基于 RGB 的聯(lián)合數(shù)據(jù)集,我們有效減少了任務(wù)和領(lǐng)域差異,建立了一個(gè)協(xié)作訓(xùn)練框架。模型在跨融合門(mén)控機(jī)制的支持下,展示了卓越的泛化能力和魯棒的融合性能。此外,GIFNet 率先將融合技術(shù)應(yīng)用于單模態(tài)增強(qiáng),代表了圖像融合研究領(lǐng)域的重要進(jìn)展。

本文轉(zhuǎn)自AI生成未來(lái) ,作者:AI生成未來(lái)