超越CVPR 2024方法,DynRefer在區域級多模態識別任務上,多項SOTA

本文作者來自于中國科學院大學LAMP實驗室,其中第一作者趙毓鐘是中國科學院大學的2023級博士生,共同一作劉峰是中國科學院大學2020級直博生。他們的主要研究方向是視覺語言模型和視覺目標感知。

簡介

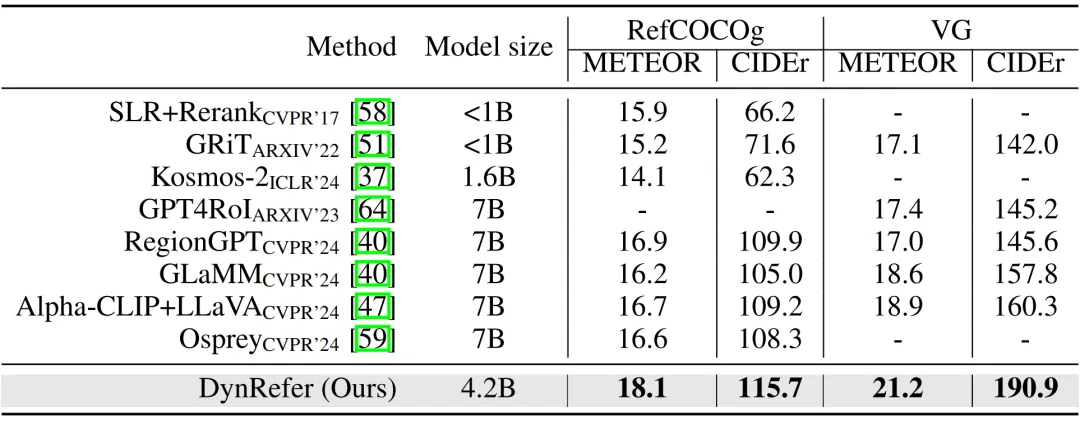

DynRefer 通過模擬人類視覺認知過程,顯著提升了區域級多模態識別能力。通過引入人眼的動態分辨率機制,DynRefer 能夠以單個模型同時完成區域識別、區域屬性檢測和區域字幕生成(region-level captioning)任務,并在上述任務都取得 SOTA 性能。其中在 RefCOCOg 數據集的 region-level captioning 任務上取得了 115.7 CIDEr,顯著高于 RegionGPT,GlaMM,Osprey,Alpha-CLIP 等 CVPR 2024 的方法。

- 論文標題:DynRefer: Delving into Region-level Multi-modality Tasks via Dynamic Resolution

- 論文鏈接:https://arxiv.org/abs/2405.16071

- 論文代碼:https://github.com/callsys/DynRefer

動機

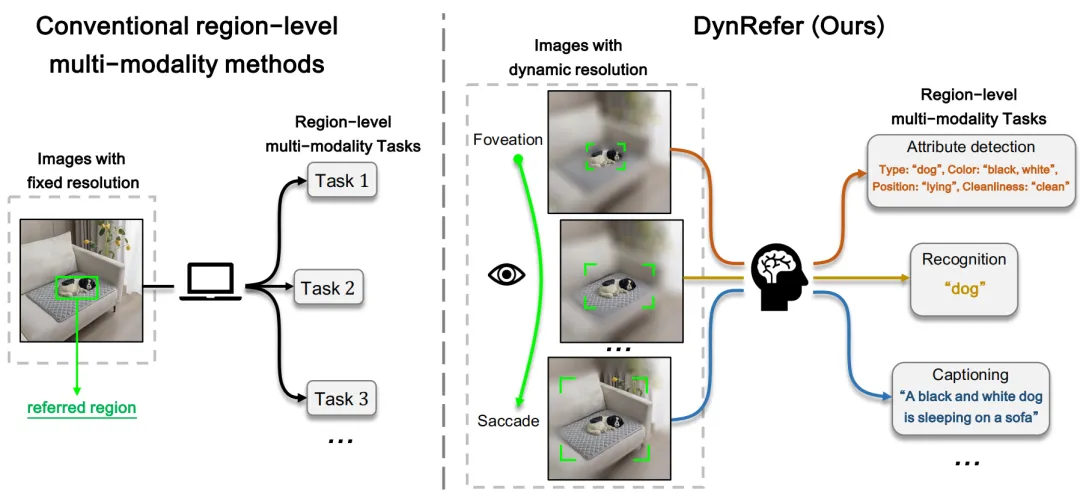

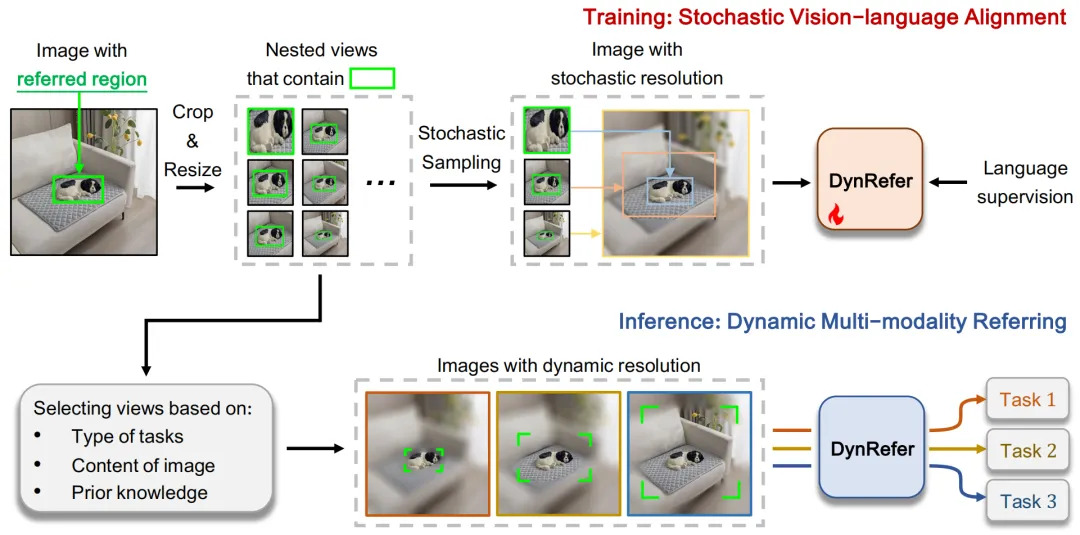

區域級多模態任務致力于將指定的圖像區域轉換為符合人類偏好的語言描述。人類完成區域級多模態任務時具有一種分辨率自適應能力,即關注區域是高分辨率的,非關注區域是低分辨率的。然而,目前的區域級多模態大語言模型往往采用固定分辨率編碼的方案,即對整張圖像進行編碼,然后通過 RoI Align 將區域特征提取出來。這種做法缺乏人類視覺認知系統中的分辨率自適應能力,對關注區域的編碼效率和能力較低。為了實現高精度的區域級多模態理解,我們提出了一種動態分辨率方案來模擬人類視覺認知系統,如下圖所示。

圖 1:傳統的區域級多模態方法(左)與 DynRefer 方法(右)的比較。

方法

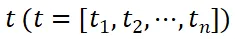

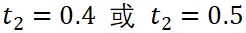

1、模擬動態分辨率的圖像(Multi-view construction)。由于主流的預訓練視覺語言模型(CLIP)只能接收均勻分辨率的輸入,我們通過構造多個均勻分辨率的視圖來模擬一幅動態分辨率圖像。該圖像在指代區域具有高分辨率,而在非指代區域低分辨率。具體流程如圖 2 上。原始圖像 x 被裁剪并調整大小為多個候選視圖。裁剪區域的計算方式為

,其中

。這里的

表示參考區域的邊界框,

表示整個圖像的尺寸,t 表示插值系數。在訓練過程中,我們從候選視圖中隨機選擇 n 個視圖,以模擬由于注視和眼球快速運動而生成的圖像。這些 n 個視圖對應于插值系數 t,即

。我們固定保留僅包含參考區域的視圖(即

)。經實驗證明該視圖有助于保留區域細節,對于所有區域多模態任務都至關重要。

圖 2:DynRefer 訓練(上)與 推理(下)。

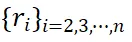

2、隨機動態視圖嵌入(Stochastic Multi-view Embedding)。具體流程如圖 3 所示。采樣的 n 個視圖通過凍結的 CLIP 編碼成空間特征,然后經過 RoI-Align 模塊處理,以獲取區域嵌入,即

。如圖 3 左側所示。由于裁剪、調整大小和 RoI-Align 引入的空間誤差,這些區域嵌入在空間上并不對齊。受 deformable convolution 操作啟發,我們提出了一個對齊模塊,通過將

對齊到

來減少偏差,其中

是僅包含參考區域的視圖編碼的區域嵌入。對于每個區域嵌入

,首先將其與

連接,然后通過卷積層計算一個二維偏移圖。

的空間特征然后根據二維偏移重新采樣。最后,對齊后的區域嵌入沿通道維度連接并通過 linear 層進行融合。輸出進一步通過視覺重采樣模塊,即 Q-former,進行壓縮,從而提取原始圖像 x 的參考區域

的區域表示(圖 3 中的

)。

圖 3:DynRefer 網絡結構

3、視覺語言對齊 (Vision-language Alignment)。通過隨機多視圖嵌入模塊計算得到的區域表示

,由三個解碼器

解碼,如圖 3(右)所示,分別受三個多模態任務的監督:?

i) 圖像區域標簽生成。我們采用基于查詢的輕量級識別解碼器進行區域標簽生成。解碼器

如圖 3(右側)所示。通過使用標簽作為查詢,

作為鍵和值,計算預定義標記的置信度來完成標記過程。我們從真值字幕中解析出標簽,以監督識別解碼器。ii) 區域 - 文本對比學習。類似于區域標記解碼器,解碼器

定義為基于查詢的識別解碼器。該解碼器計算字幕與區域特征之間的相似性分數,使用 SigLIP loss 進行監督。iii) 語言建模。我們采用預訓練的大語言模型

將區域表示

轉換為語言描述。

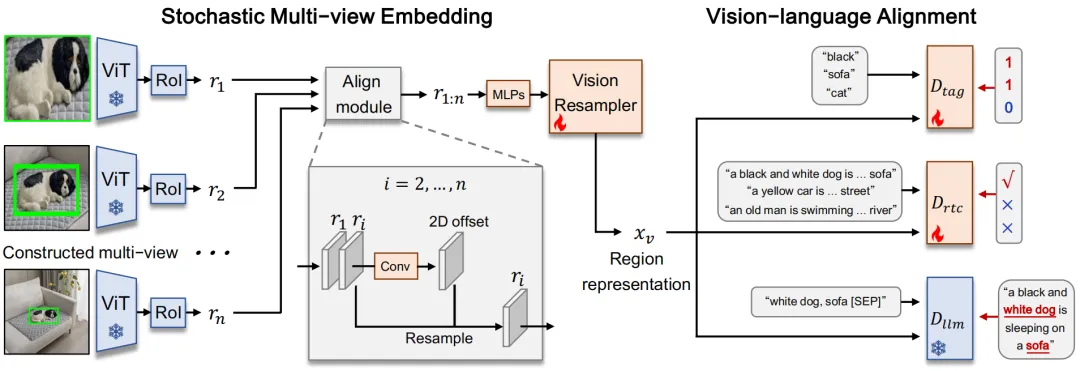

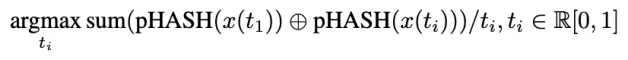

圖 4:雙視圖(n=2)DynRefer 模型在區域級多模態任務上的表現。在不同的插值系數 t 下,

。視圖一是固定的(

),視圖二隨機選擇或固定。

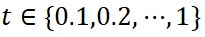

4、在推理過程中,經過訓練的 DynRefer 模型通過動態分辨率在圖像上執行多模態任務。通過調整采樣的 n 個視圖的插值系數

,我們可以得到具有動態分辨率特性的區域表示。為了評估不同動態分辨率下的特性,我們訓練了一個雙視圖(n=2)的 DynRefer 模型,并在四個多模態任務上進行評估。從圖 4 中的曲線可以看出,對于沒有上下文信息的視圖(

),屬性檢測(Attribute detection)獲得了更好的結果。這可以解釋為這種任務通常需要詳細的區域信息。而對于區域級字幕(Region-level captioning)和密集字幕生成(Dense captioning)任務,需要上下文豐富的視圖(

),以便完整理解參考區域。需要注意的是,過多上下文的視圖(

)會降低所有任務的性能,因為它們引入了過多與區域無關的信息。當已知任務類型時,我們可以根據任務特性采樣適當的視圖。當任務類型未知時,我們首先構建一組在不同插值系數 t 下的候選視圖集合,

。從候選集中,通過貪婪搜索算法采樣 n 個視圖。搜索的目標函數定義為:

其中

表示第 i 個視圖的插值系數,

表示第 i 個視圖,pHASH (?) 表示感知圖像哈希函數,

表示異或操作。為了從全局視角比較視圖的信息,我們利用 "pHASH (?)" 函數將視圖從空間域轉換到頻域,然后編碼成哈希碼。對于

這一項,我們減少上下文豐富視圖的權重,以避免引入過多冗余信息。

實驗

Region-level Captioning

在區域字幕生成任務,DynRefer 以更小的模型(4.2B v.s. 7B),在 RefCOCOg 和 VG 兩個數據集上、在 METEOR 和 CIDEr 兩個指標上都顯著超過了 CVPR 2024 中的眾多方法,如 RegionGPT,GlaMM,Alpha-CLIP 和 Osprey 等,展現出 DynRefer 巨大的性能優勢。

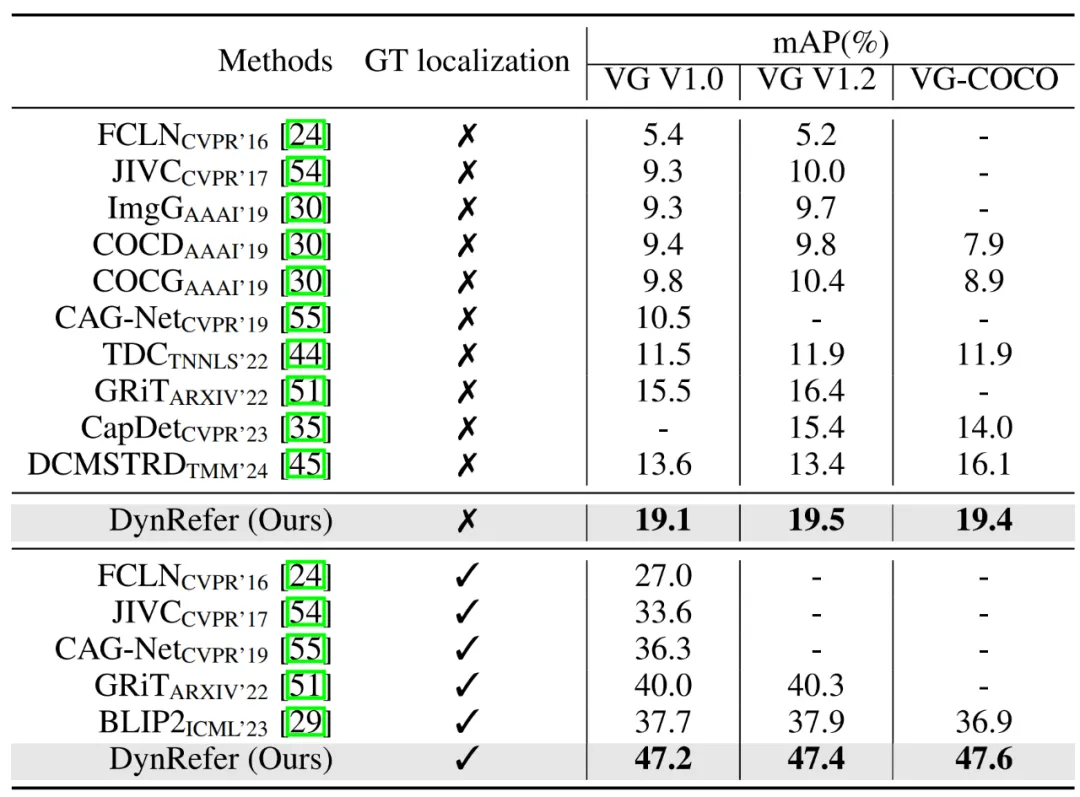

Dense Captioning

在密集字幕生成任務,在 VG1.2 數據集,DynRefer 相較之前的 SOTA 方法 GRiT 提升了 7.1% mAP。

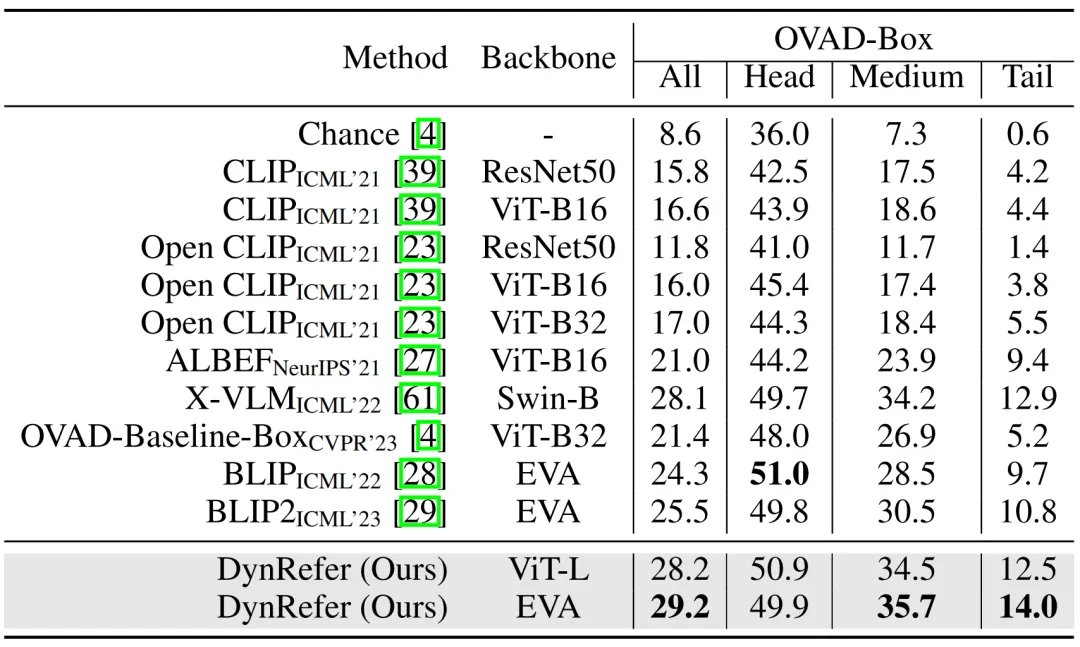

Open Vocabulary Attribute Detection

在區域屬性檢測任務,DynRefer 也取得了 SOTA 的性能。

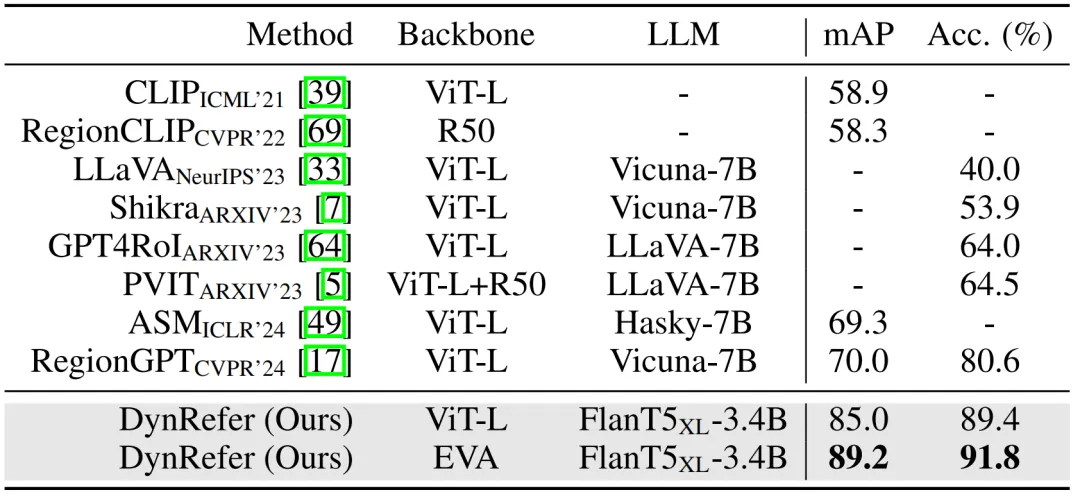

Open Vocabulary Region Recognition

在區域識別任務,DynRefer 比 CVPR 24 的 RegionGPT 提升了 15% mAP 和 8.8% Accuracy,比 ICLR 24 的 ASM 高 15.7% mAP。

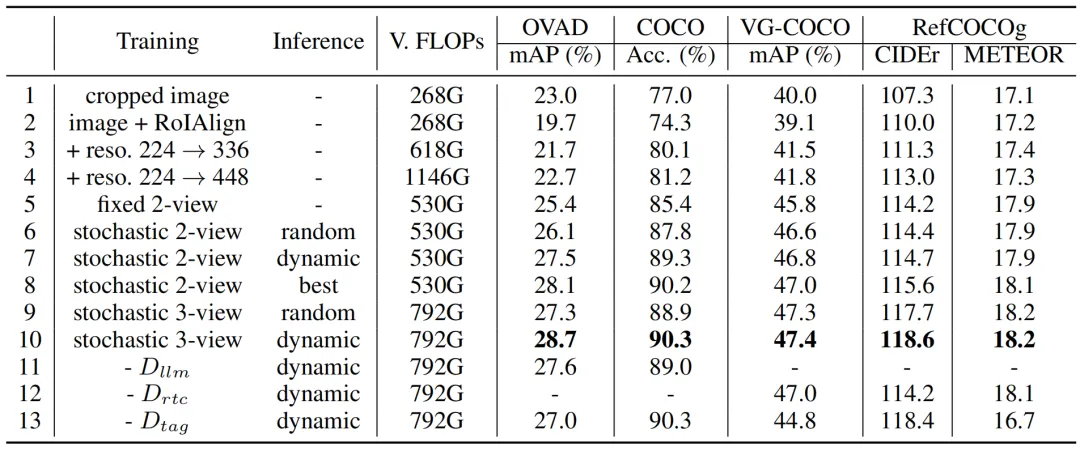

消融實驗

- Line 1-6:隨機動態多視圖要優于固定視圖。

- Line 6-10:通過最大化信息選擇視圖優于隨機選擇視圖。

- Line 10-13:多任務訓練可以學習得到更好的區域表征。

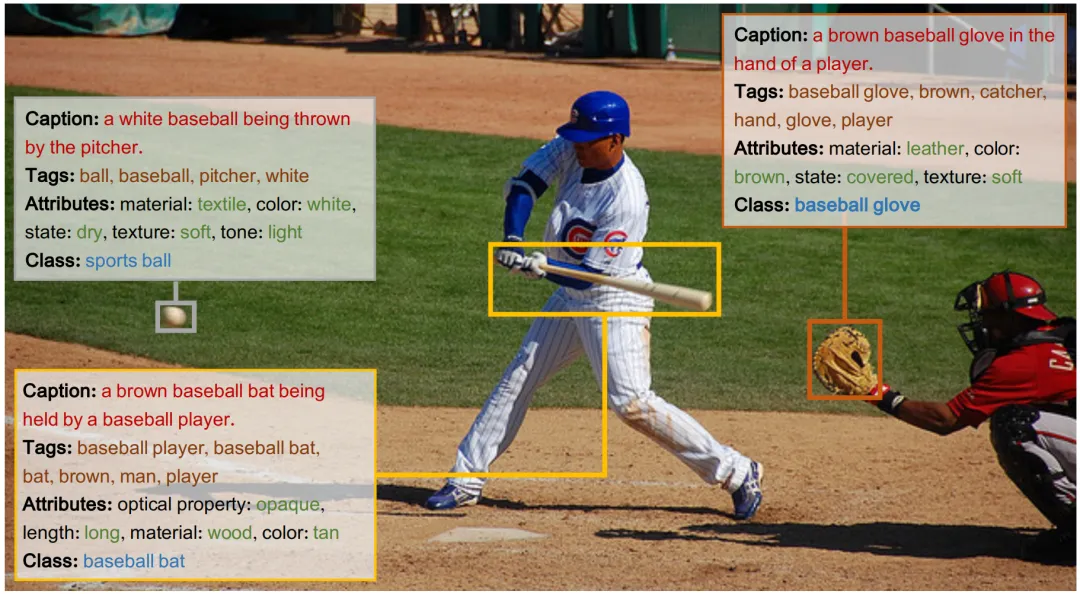

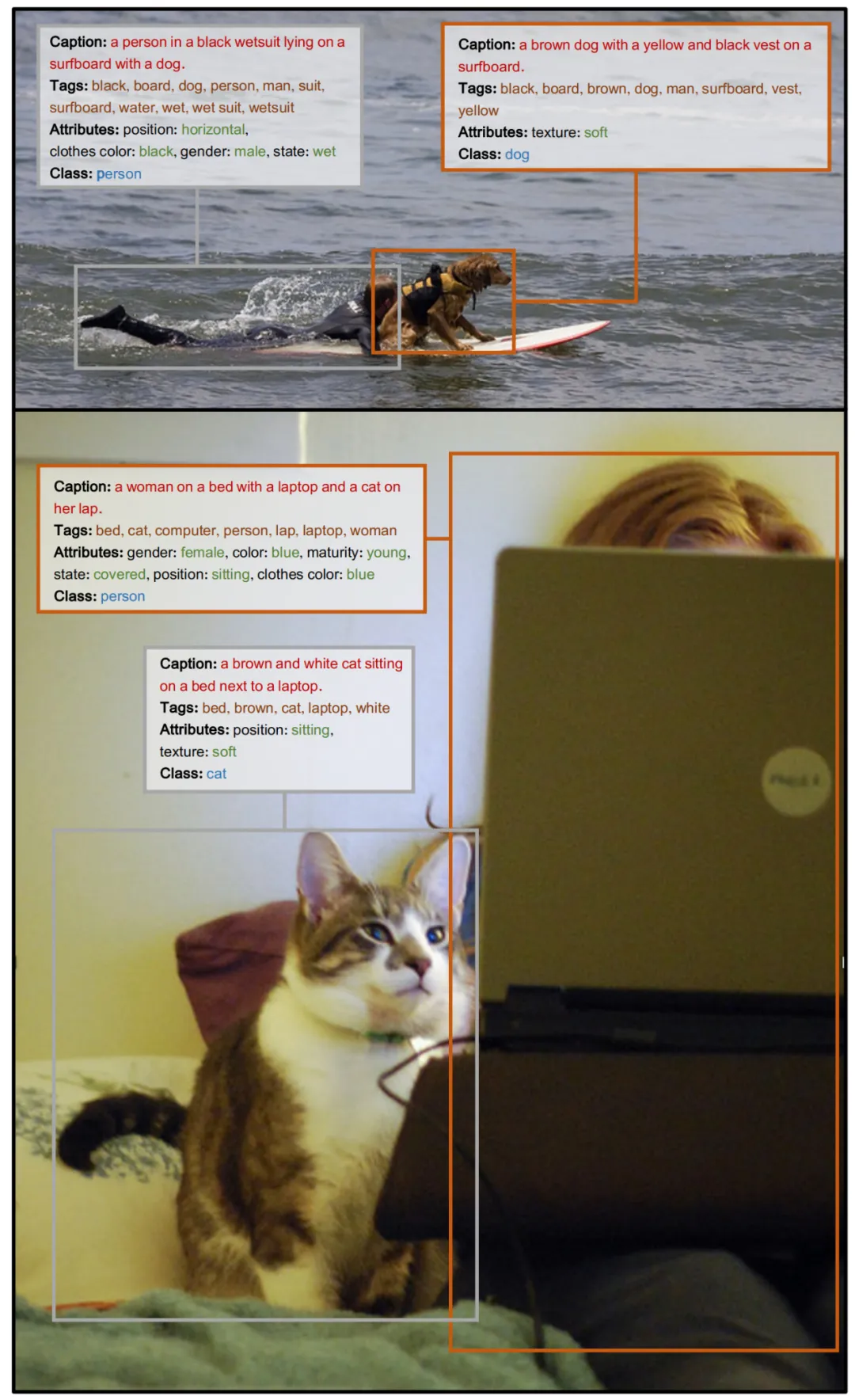

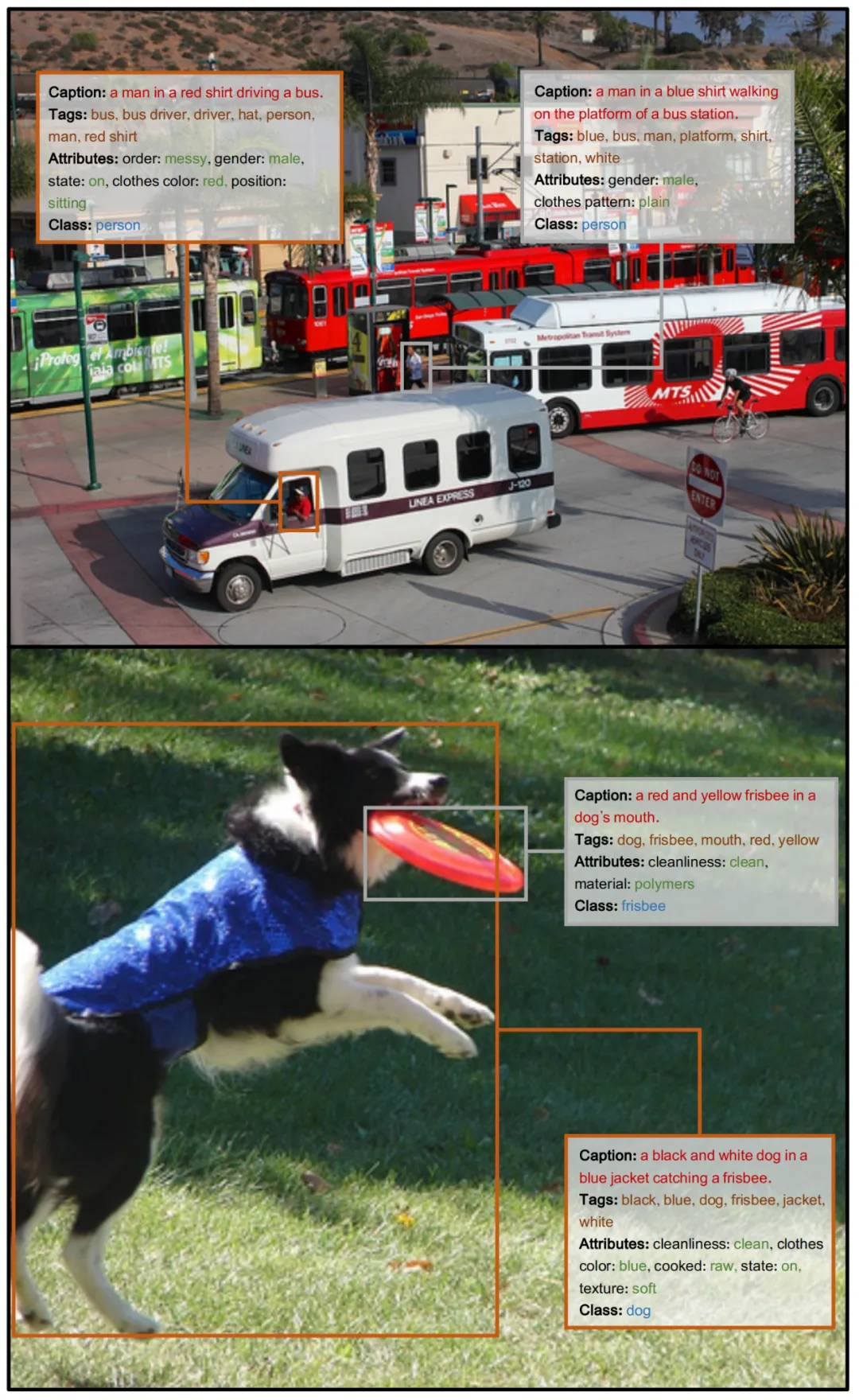

可視化

下面幾張圖展示了 DynRefer 的推理結果,DynRefer 可以用一個模型同時輸出區域字幕、標簽、屬性和類別。

本文轉自 機器之心 ,作者:機器之心