Microsoft提出FILM-7B,解決大模型lost-in-the-middle問題,達到GPT-4-Turbo水平!

盡管許多大型語言模型(LLMs)能夠處理長篇輸入,但它們仍然難以充分利用長文本中的信息,這被稱為“中間丟失(lost-in-the-middle)”挑戰。這個問題可能是源于長文本訓練期間缺乏明確的監督,未能強調長文本中任何位置都可能包含關鍵信息。基于這一直覺,提出了一種名為INformation-INtensive(IN2,信息密集)訓練的方法,這是一種純粹的數據驅動解決方案,用以克服“中間丟失”的問題,達到GPT-4-Turbo同等水平!

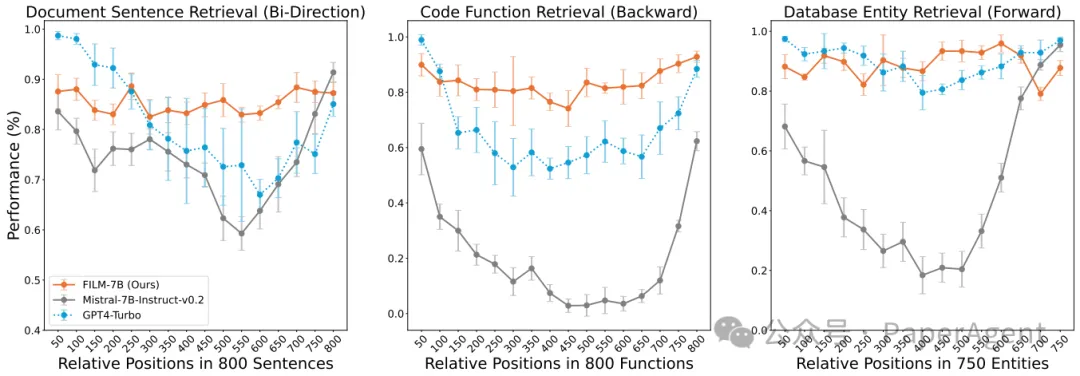

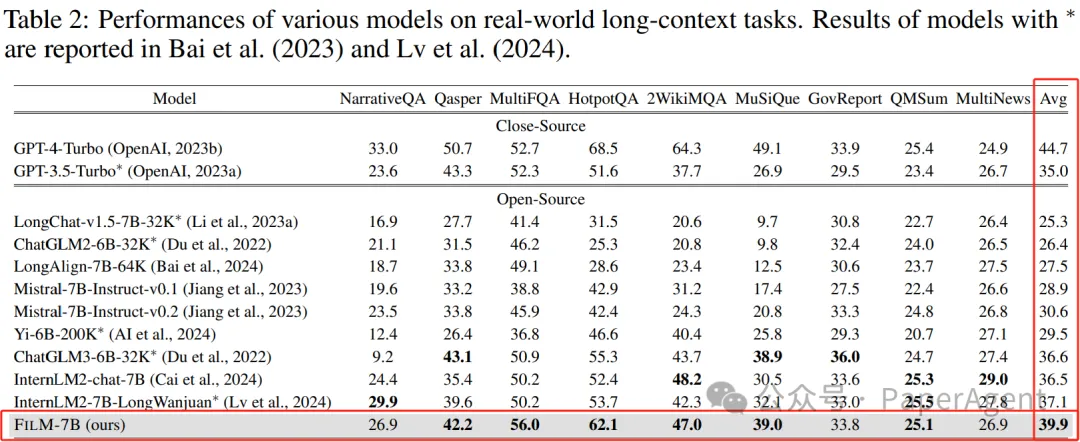

探測結果表明,IN2訓練顯著克服了骨干模型的“中間丟失”問題。它還能增強開源模型的性能,使其達到與GPT-4-Turbo等專有大型語言模型(LLMs)相當甚至更加穩健的性能水平。

Information-Intensive訓練

- 訓練數據構建

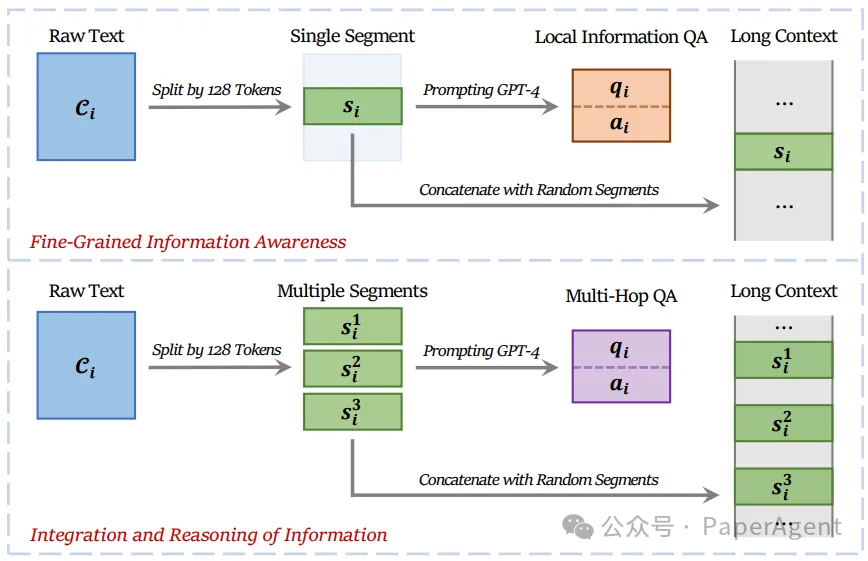

IN2訓練的目標是明確教會模型,長文本中的任何位置都可能包含關鍵信息。利用了一個合成的長文本問答數據集,其中的答案需要(1)對合成的長文本(4K-32K個token)中的一個短片段(約128個token)有細粒度的信息意識,(2)整合和推理兩個或更多短片段中的信息。

IN2訓練的數據構建過程,旨在提高細粒度信息意識(上部),以及信息的整合和推理(下部)

圖片

圖片

- FILM-7B訓練細節(Filling-the-Middle,填補中間)

使用上述構建的訓練數據,對Mistral-7B-Instruct-v0.2模型進行進一步的微調,得到FILM-7B模型。

IN2訓練采用指令調整范式:長文本和問題用作指令,答案部分的損失用于更新模型。

Information-Intensive評測

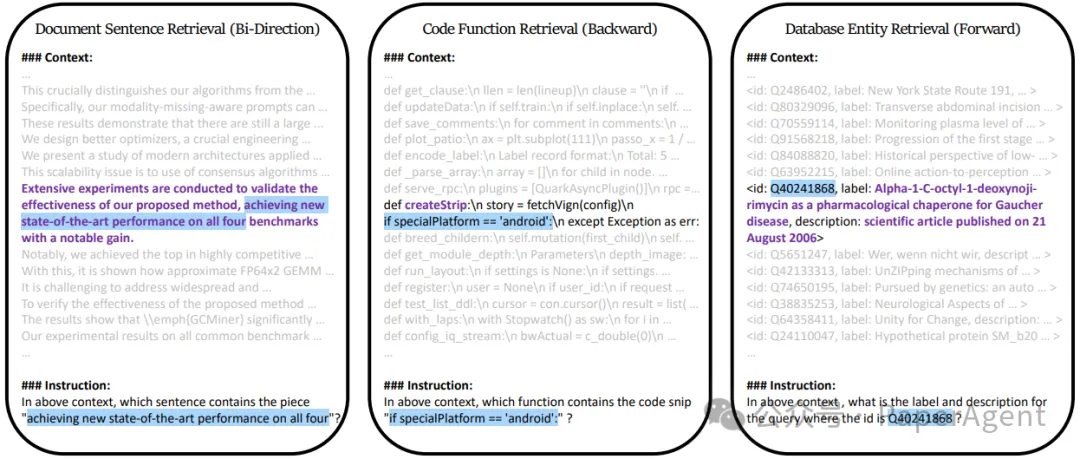

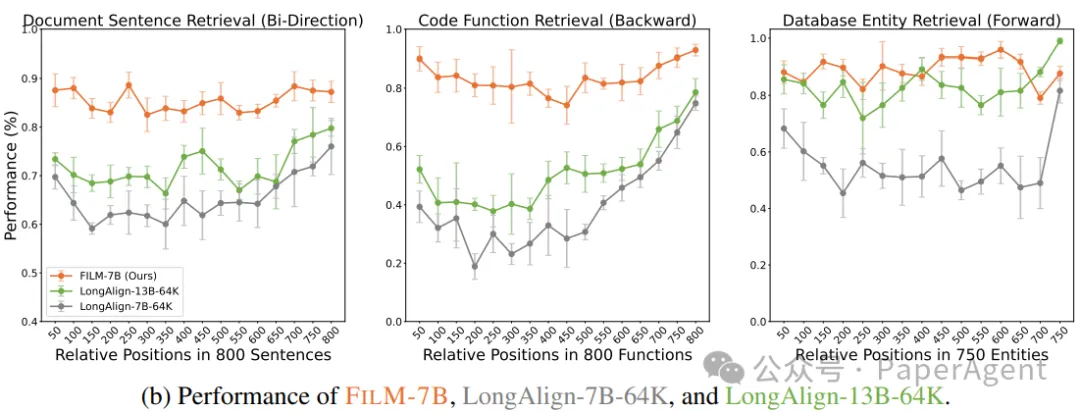

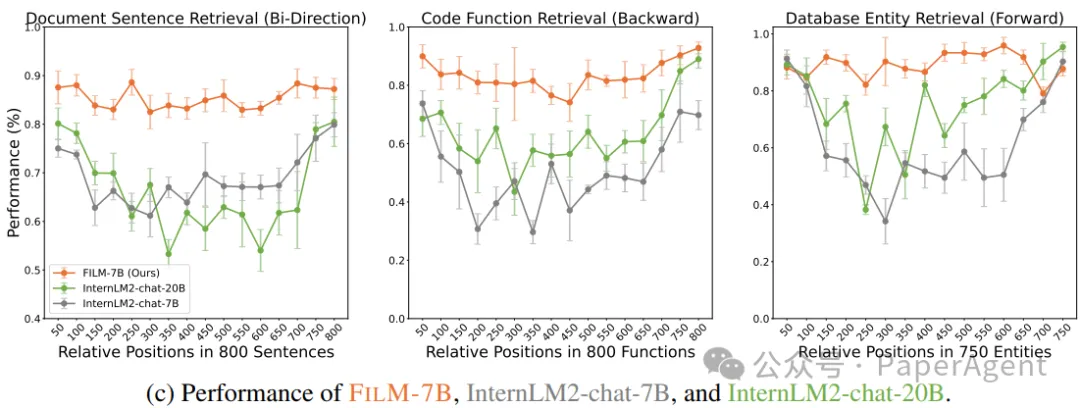

為了全面評估FILM-7B利用長文本的能力,設計了三種探測任務,涵蓋了各種上下文風格(文檔、代碼和結構化數據上下文)和信息檢索模式(前向、后向和雙向檢索)。

在VAL探測中的三個任務,檢索模式由檢索關鍵詞與要檢索的信息之間的相對位置決定。

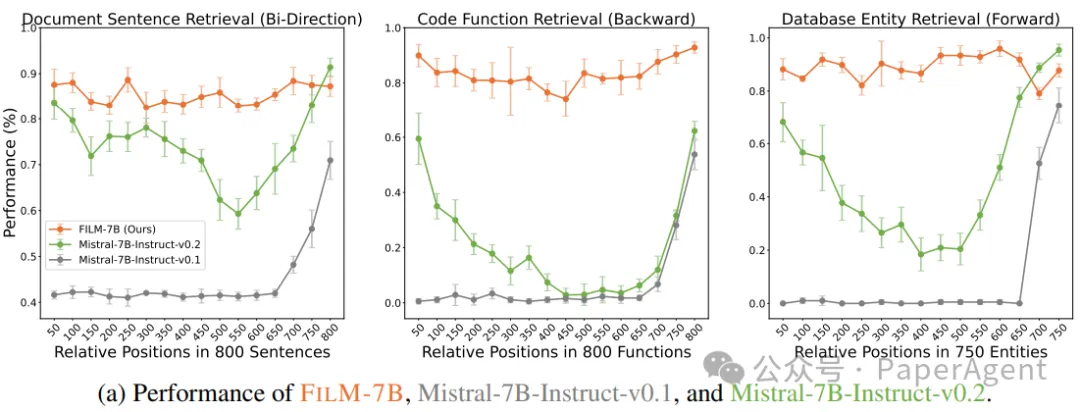

探測任務結果表明,FILM-7B能夠在其32K的上下文窗口中穩健地檢索信息。

FILM-7B在VAL探測中的性能以及與(a) Mistral、(b) LongAlign和(c) InternLM2的比較。X軸是上下文中的相對位置(約32K個token)。

除了這些探測任務,FILM-7B在真實世界的長文本任務上顯著提高了性能(例如,在NarrativeQA上,F1分數從23.5提高到26.9)

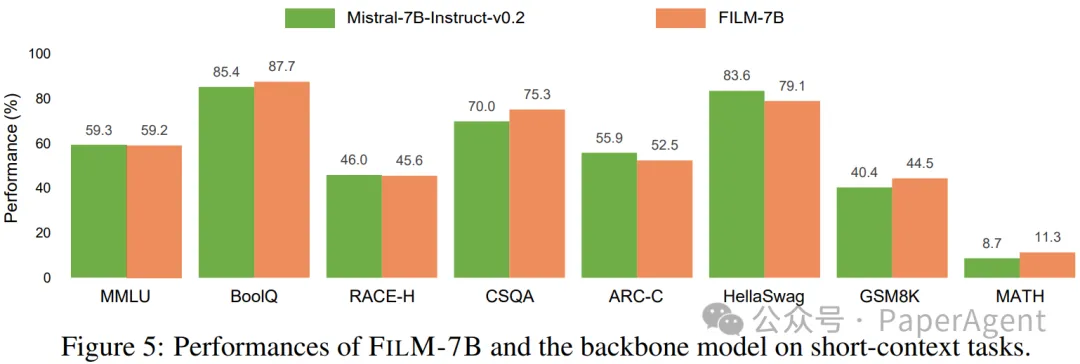

FILM-7B同時在短文本任務上保持了相當的性能(例如,在MMLU上的準確率保持在59.3、59.2,GSM8K,MATH上則有不少提升)。

Make Your LLM Fully Utilize the Context

https://arxiv.org/pdf/2404.16811

https://github.com/microsoft/FILM/tree/main本文轉載自??PaperAgent??,作者:PaperAgent