清華SuperBench全球測評出爐,Claude 3拿下多個冠軍!合成數(shù)據(jù)才是人類未來?

就在最近,清華大學SuperBench團隊的新一輪全球大模型評測結(jié)果出爐了!

此次測評,還增加了Llama 3-8b 和Llama 3-70b兩個最近炙手可熱的模型。

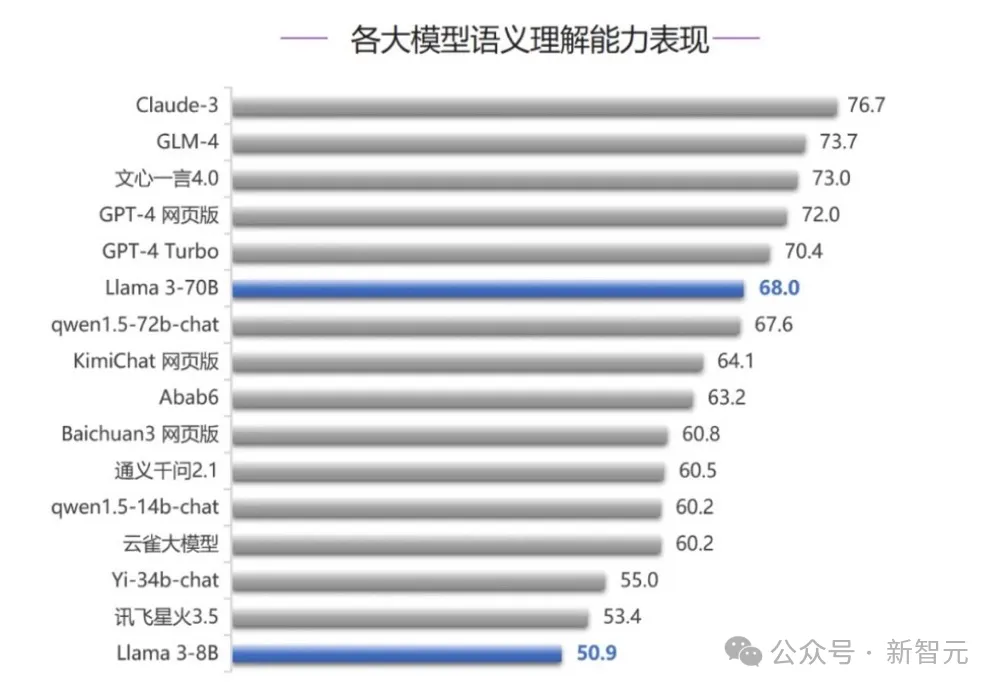

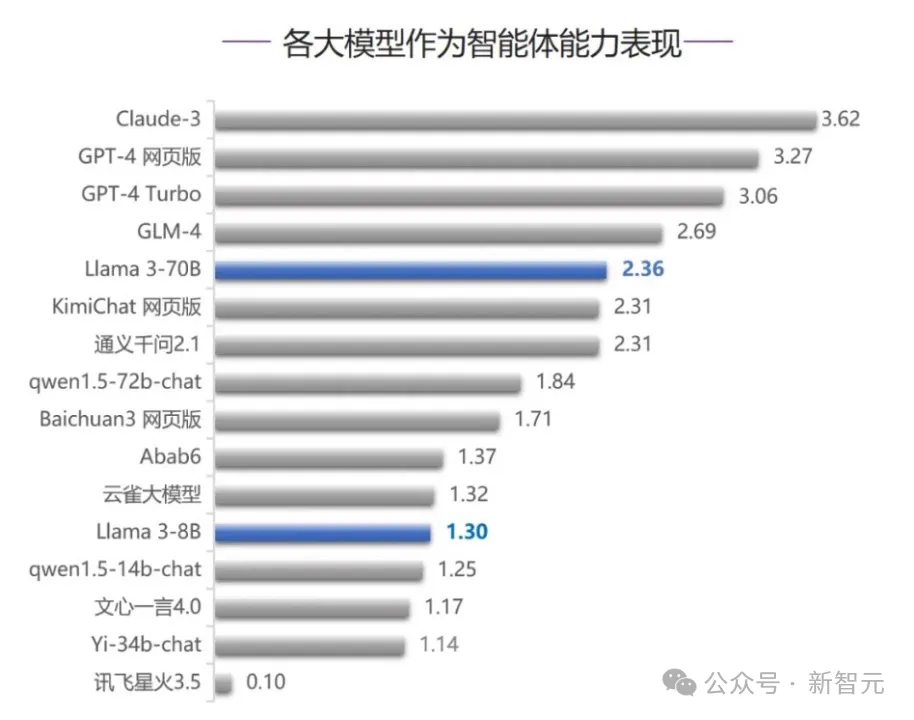

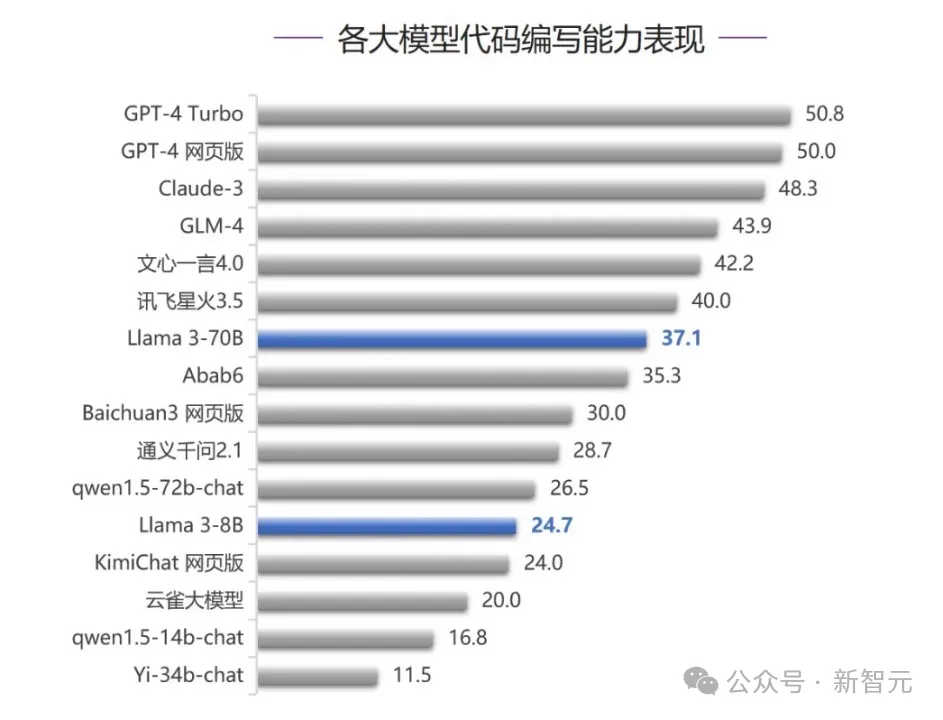

在語義理解、智能體能力、代碼能力三個測評中,我們發(fā)現(xiàn):Claude-3拿下兩個top 1,穩(wěn)穩(wěn)位于前三之列。

Claude 3果然實強。

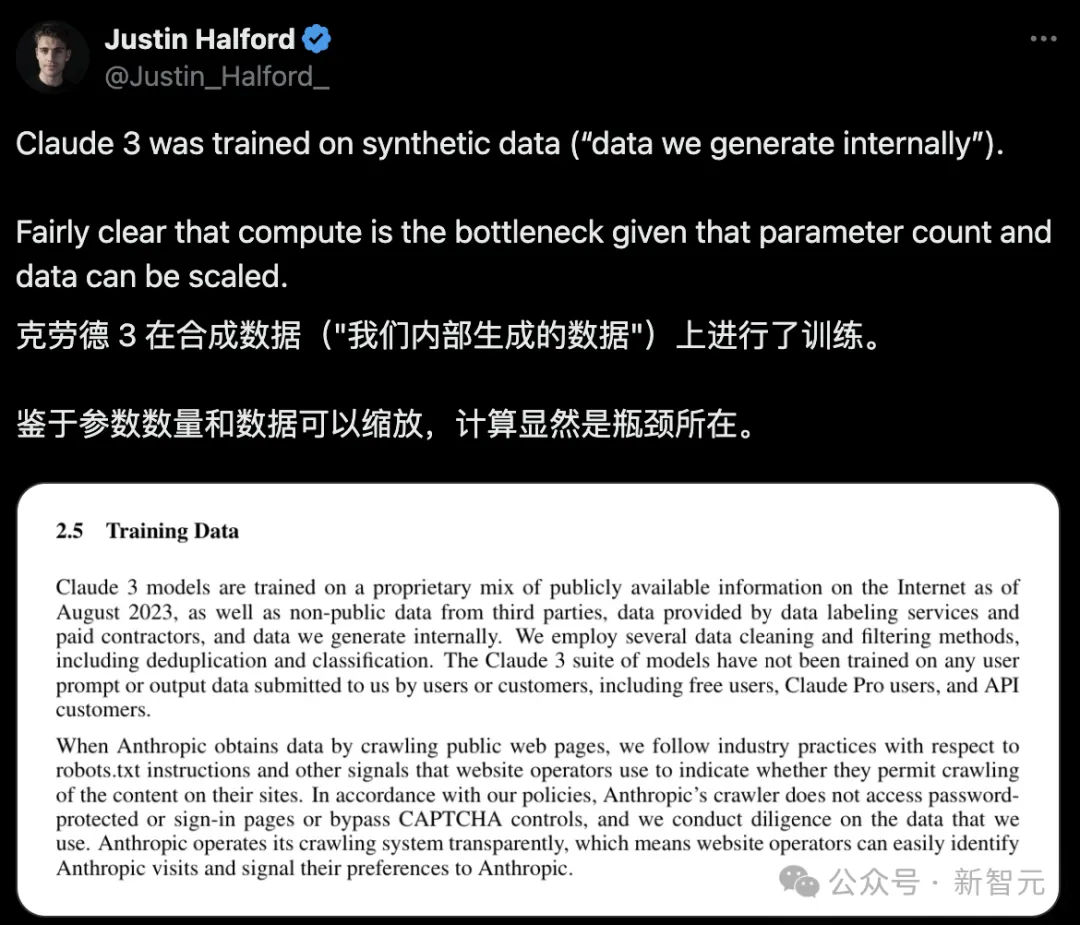

技術(shù)報告曝出:Claude 3靠合成數(shù)據(jù)

在技術(shù)報告中,大家發(fā)現(xiàn)了Claude 3的亮點——

它是在合成數(shù)據(jù)上訓練的。

鑒于大模型的參數(shù)數(shù)量和數(shù)據(jù)都是可以縮放的,所以以后計算就是瓶頸了。

所以,Claude 3的成功,可以說是對合成數(shù)據(jù)而言是一個巨大的進步。

其實,此前艾倫人工智能研究所的科學家Nathan Lambert就曾經(jīng)就Anthropic的合成數(shù)據(jù)做了一些猜測。

而現(xiàn)在詳細技術(shù)報告的發(fā)布,將他的猜測完全證實了!

合成數(shù)據(jù)的探索

關(guān)于合成數(shù)據(jù),Lambert曾在23年11月寫下了一篇文章《合成數(shù)據(jù):Anthropic 的 CAI,從微調(diào)到預訓練,OpenAI 的超對齊,提示、類型和開放示例》。

在這篇文章里,他做出判斷——合成數(shù)據(jù)是AI下一階段的加速器,并且詳細解釋了合成數(shù)據(jù)是什么,以及它意味著什么。

合成數(shù)據(jù),也就是由機器生成而非人工創(chuàng)建的數(shù)據(jù),在自然語言處理(NLP)和整個機器學習(ML)領(lǐng)域都有著長久的歷史背景。與之密切相關(guān)的概念是數(shù)據(jù)增強,即通過對數(shù)據(jù)進行細微調(diào)整來豐富數(shù)據(jù)集的多樣性。

在NLP領(lǐng)域,一個經(jīng)典的應用是回譯,即利用ML模型的輸出對原始文本進行重新翻譯,生成新的數(shù)據(jù)。

如今,合成數(shù)據(jù)的使命變得更加重大:通過去除人類的介入,讓AI更加符合預期且用戶友好。

這一任務由Anthropic的訓練方法和OpenAI新成立的、充滿神秘色彩的超對齊團隊牽頭,后者致力于利用AI反饋解決對齊問題。

同時,合成數(shù)據(jù)已經(jīng)成為眾多知名開源模型供應商微調(diào)Meta和Mistral模型的首選工具。

合成數(shù)據(jù),能成為下一次技術(shù)突破的關(guān)鍵嗎?

隨著當前或下一代模型很可能已經(jīng)用盡了互聯(lián)網(wǎng)上所有的高質(zhì)量數(shù)據(jù)源,模型開發(fā)者正在尋找新的途徑來獲取所需的大規(guī)模數(shù)據(jù),以支持模型的持續(xù)擴展。

合成數(shù)據(jù)的支持者認為,增加更多的數(shù)據(jù)有助于模型更好地解決那些長尾任務或評估問題。為了模型能夠擴大100倍,將需要大量的合成或數(shù)字化數(shù)據(jù)。

反對者則認為,我們生成的所有數(shù)據(jù)都來源于與當前SOTA模型相同的分布,因此不太可能推動技術(shù)產(chǎn)生新的進展。

盡管如此,開源領(lǐng)域仍然遠遠落后于GPT-4和GPT-4-Turbo,這意味著我們想要在開發(fā)的各個階段復制這些數(shù)據(jù),還有很長的路要走。

開源的支持者和HuggingFace Hub 上的大多數(shù)趨勢模型都將合成數(shù)據(jù)作為一種快速行動的方式,并有能力在行業(yè)中嘗試 SOTA 語言模型背后的技術(shù)。

開源支持者和HuggingFace Hub上大多數(shù)流行模型,都將合成數(shù)據(jù)作為一種快速發(fā)展,并嘗試業(yè)內(nèi)最先進SOTA語言模型的方法。

像Anthropic和OpenAI這樣的公司使用合成數(shù)據(jù),因為這是他們在規(guī)模和能力上取得進展的唯一方式,而小模型之所以使用合成數(shù)據(jù),是因為相同規(guī)模的人類數(shù)據(jù)的成本要高出數(shù)千倍。

在這種二分法中,雖然方法看起來相似,但大公司會在創(chuàng)建數(shù)據(jù)集(預訓練規(guī)模的合成數(shù)據(jù))上投入超過1000萬美元的推理計算成本,而開源競爭者可能只需要花費大約10美元。

盡管開源和閉源這兩個社區(qū)追求的目標截然不同,合成數(shù)據(jù)卻同時為他們雙方提供了支持。

合成數(shù)據(jù)可以讓模型在訓練中能多次看到某些不常見的數(shù)據(jù)點,從而使模型的魯棒性得到提升。

通過投喂大量數(shù)據(jù),模型在小眾事實、語言和任務的處理能力也都將顯著提高。

Anthropic的CAI技術(shù)與合成數(shù)據(jù)的復雜性

關(guān)于Anthropic大量使用合成數(shù)據(jù)的傳言眾所周知,這種做法顯著提升了他們的模型魯棒性。

盡管Meta的Llama 2聊天機器人因基于隱藏的觸發(fā)詞列表而做出荒謬的拒絕而受到批評,但Anthropic的模型在拒絕不了解的問題時表現(xiàn)出了更加合理的判斷,值得我們給予肯定。

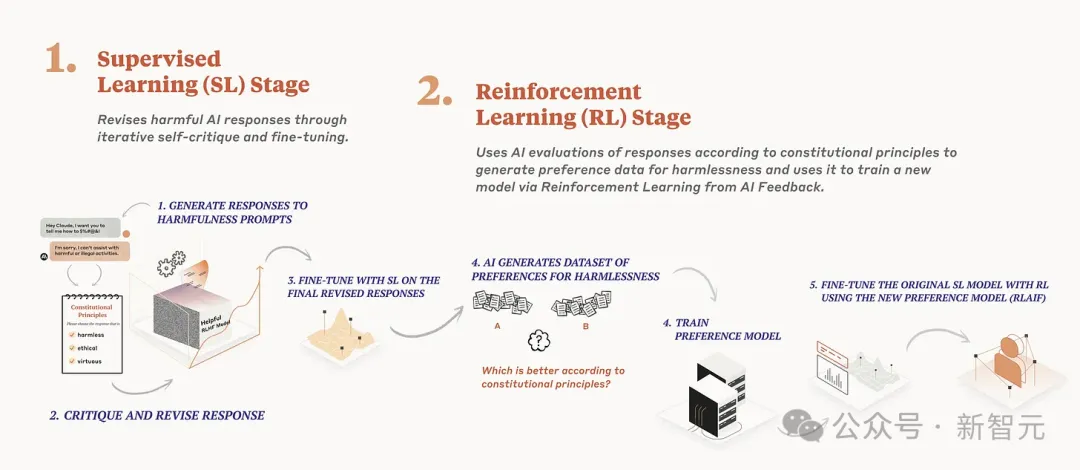

Anthropic在其Claude系列模型中廣泛采用的憲法AI(Constitutional AI, CAI)技術(shù),是迄今為止已知最大規(guī)模的合成數(shù)據(jù)應用實例。

具體來說,憲法AI通過兩種方式利用合成數(shù)據(jù):

1. 對指令調(diào)整數(shù)據(jù)進行評估,確保其遵循一系列原則,如「答案是否鼓勵暴力」或「答案是否真實」。模型在生成問題答案時會根據(jù)這些原則進行檢查,并隨時間優(yōu)化答案。之后,模型會根據(jù)這些經(jīng)過篩選的數(shù)據(jù)進行微調(diào)。

2. 利用語言模型生成成對偏好數(shù)據(jù),評估在特定原則指導下哪個答案更為恰當(類似于某篇論文中對原則引導獎勵模型的使用)。隨后,模型通過合成數(shù)據(jù)進行正常的從人類反饋中學習(RLHF),這一過程也稱為RLAIF。

如今,RLAIF已成為業(yè)界廣泛認可的術(shù)語,很多研究人員都會通過使用GPT-4來獲取評分或選擇,這些評分或選擇可以轉(zhuǎn)化為RLHF所需的接受/拒絕樣本。

然而,由于在生成批評/對多個答案進行評分與在合成數(shù)據(jù)生成階段確定一套經(jīng)驗穩(wěn)定原則之間存在細微差別,CAI的復雜性和細節(jié)并未被充分理解。

在進行CAI的兩個核心步驟時,Anthropic必須確保各項原則長度一致,避免概念上的重疊,并且不能隨意更改其規(guī)模。此外,有些原則所生成的數(shù)據(jù)在數(shù)值上可能會出現(xiàn)不穩(wěn)定。

合成指令、偏好和評論

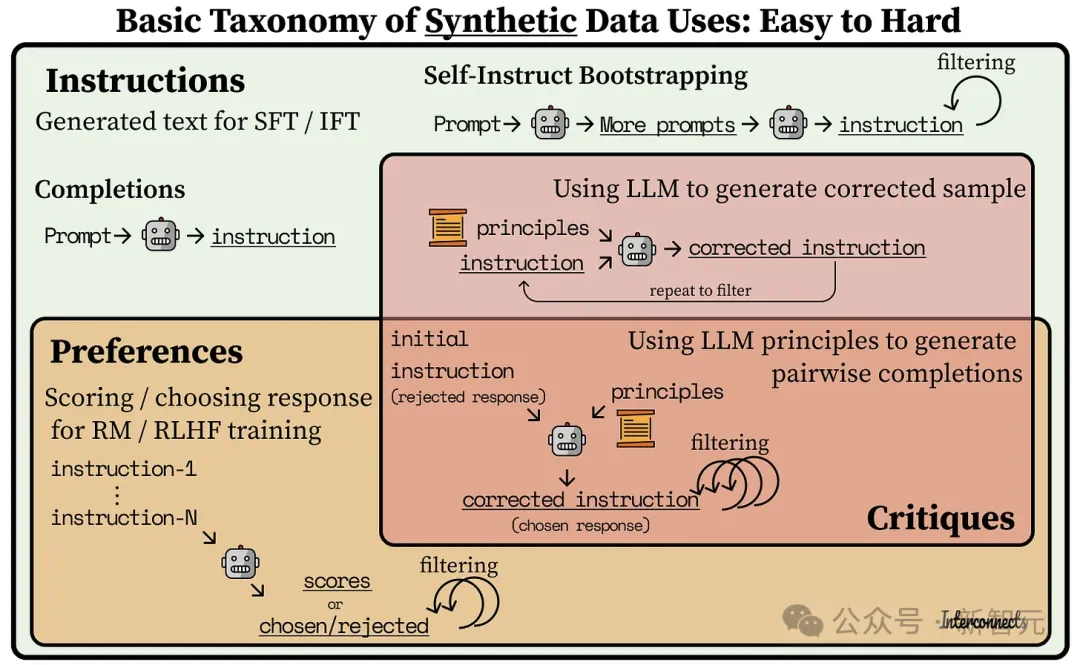

在開源模型里,我們可以清晰地看到合成數(shù)據(jù)應用方式的演進。

2023年初,模型如Alpaca和Vicuna通過使用合成指令數(shù)據(jù)對Llama模型進行監(jiān)督式微調(diào)(SFT),在7-13B參數(shù)規(guī)模上實現(xiàn)了顯著的性能提升。

其中,很多開源指令數(shù)據(jù)集都是基于Self-Instruct方法的進步——先創(chuàng)建一組「種子」指令,然后利用大語言模型(LLM)生成類似的指令。目前有許多方法可以實現(xiàn)這一點,但都還在探索如何為數(shù)據(jù)集增加多樣性的初期階段。

與此同時,一些研究人員通過從互聯(lián)網(wǎng)上抓取提示,并用GPT-4將這些提示轉(zhuǎn)化為指令。但要注意,像ShareGPT這樣的提示數(shù)據(jù)集,其平均質(zhì)量較低,分布也較為窄。

如今,合成偏好開始出現(xiàn)。這主要是通過評分或比較哪個更好來實現(xiàn),類似于MT Bench和AlpacaEval的評分方法,但是會保留分數(shù)或勝負作為訓練數(shù)據(jù)。

例如,UltraFeedback就是從用戶來源(如ShareGPT)和現(xiàn)有的指令數(shù)據(jù)集(如FLAN)中收集提示,并生成模型的評論和完成情況。

最新的進展是通過AI評論生成的偏好或指令數(shù)據(jù)。評論是一個反復利用經(jīng)過特定原則或問題微調(diào)的大語言模型(LLM)的過程。期間,增加更多的上下文信息,會大幅提高模型評論合成數(shù)據(jù)的能力,但系統(tǒng)設計也更加復雜。

像Meta的Shephard和KAIST的Prometheus這樣的評論模型開始出現(xiàn),它們能夠?qū)μ崾?生成對做出響應。但我們距離模型、意圖和知識協(xié)同作用的反饋循環(huán)還有很長的路要走

下面是一張簡單的圖表,用來展示合成指令生成是偏好上游,而偏好既是評論的上游,也是訓練難度的上游。

盡管原始的ChatGPT模型(GPT-3.5-turbo)在執(zhí)行一些任務時會遇到困難,比如返回一個1到10之間的單個整數(shù),但最新的模型輕松做到了這一點。

當開源模型能夠穩(wěn)定地生成評論時,將迎來另一個轉(zhuǎn)折點。

雖然目前還不完全清楚,評論數(shù)據(jù)相比通用偏好評分對于模型的改進到底有多重要,但如果以Claude為例,它肯定是有用的。

兩個合成數(shù)據(jù)的小竅門

1. 始終使用最優(yōu)的模型來生成數(shù)據(jù):

眾所周知,模型的效果完全依賴于數(shù)據(jù)的質(zhì)量。

很多研究者可能不愿意支付OpenAI的數(shù)據(jù)訓練費用,但從成本效益來看,使用SOTA模型絕對是值得的。

這甚至包括使用一些非傳統(tǒng)方法,例如通過網(wǎng)頁版的ChatGPT來生成一系列的提示詞,這是作者親自嘗試過的。

2.API會發(fā)生變化,因此需要盡可能鎖定版本:

這一建議來自于作者數(shù)百次的MT-Bench評估經(jīng)驗——模型API端點的變化可能會導致研究結(jié)果出現(xiàn)重大偏差。

例如,某個API端點會在評分時變得非常嚴厲,并且無緣無故地給出只有1分的評價。

如果不固定API的版本,你可能會遇到一些意想不到的問題,進而無法使合成數(shù)據(jù)完全可靠或符合邏輯。

本文轉(zhuǎn)自 新智元 ,作者:新智元