革新GUI自動化:V-Zen模型引領多模態語言模型新紀元 精華

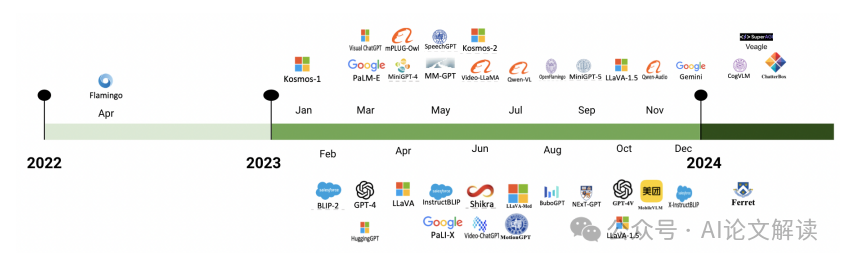

在人工智能領域不斷發展的今天,多模態大型語言模型(MLLMs)已經成為一種變革性的力量,它們能夠跨越不同數據表現形式的鴻溝,實現數據的理解和整合。這些模型擅長從多種模態(如文本和圖像)中整合信息,顯著擴展了研究和實際應用的范圍。在這一領域內,一個關鍵的研究方向是圖形用戶界面(GUI)的任務自動化。GUI任務的自動化為提高各種應用的效率和生產力提供了巨大的潛力。然而,現有的模型和基準主要集中在基于文本的任務上,這種方法忽視了多模態代理有效處理和整合視覺信息以解決問題的巨大潛力。我們研究的主要推動力是這些模型的應用,特別強調在GUI圖像上下文中的“著陸”概念。在MLLMs領域,著陸指的是將語言中的詞語或短語與其他模態中的相應實體關聯起來的過程。例如,在文本-圖像配對中,“蘋果”一詞將與蘋果的圖像相對應。MLLMs在自動化GUI任務中有效且精確地進行著陸尤為關鍵。

論文標題、機構、論文鏈接

論文標題: IV-Zen: Efficient GUI Understanding and Precise Grounding With A Novel Multimodal LLM

機構: SuperAGI Research

論文鏈接: http://arxiv.org/pdf/2405.15341

本研究旨在通過開發一種能夠有效導航、理解和與GUI元素高精度交互的多模態大型語言模型(MLLM),推動基于多模態代理的GUI任務自動化的邊界。

V-Zen模型介紹

V-Zen是一種新型的多模態大型語言模型(MLLM),專為圖形用戶界面(GUI)的理解和精確定位而設計。它不僅僅是一個多模態語言模型,而是一個高級的GUI代理,能夠準確處理圖像和文本輸入,解釋自然語言指令,精確識別GUI元素,并在網站上執行操作以完成用戶定義的目標。

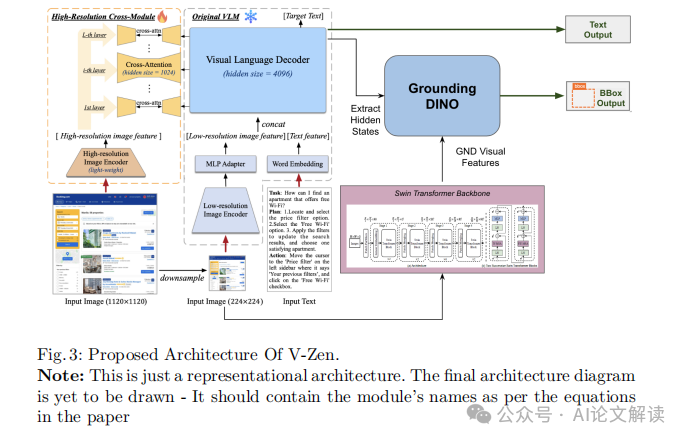

V-Zen的核心在于其視覺定位模塊,該模塊利用DINO檢測器的功能,使其能夠有效處理多模態定位任務。除了LLM的文本響應之外,定位模塊還單獨提供定位坐標,取代了典型的對象檢測模塊,從而確保坐標的精確性。此外,模型的性能通過高交叉分辨率模塊(HRCM)得到進一步增強,該模塊使模型能夠處理高分辨率特征并理解圖像中的文本。

為了推動基于代理的多模態GUI任務自動化的研究邊界,我們還創建了一個名為GUIDE(Graphical User Interface Data for Execution)的數據集,這是一個前沿的基準數據集,包括跨各種GUI平臺收集的邊界框注釋和帶有思維鏈的文本描述。GUIDE數據集在推動代理研究方面起到了助推作用,最終導致了更靈活、響應更快、更類似于人的代理在多個領域的發展。

多模態融合與視覺理解

多模態融合是指在一個模型中整合來自不同數據源(如文本、圖像、聲音等)的信息的過程。在V-Zen模型中,這一過程尤為關鍵,因為它需要處理和理解來自GUI的圖像和文本指令。V-Zen通過幾個關鍵的技術模塊來實現這一點:

1. 低分辨率視覺特征提取器(LRVFE):這一模塊使用低分辨率編碼器(如EVA-2-CLIP)處理輸入圖像,提取圖像的關鍵特征,為后續的高級處理做準備。

2. 多模態投影適配器(MPA):此模塊負責將從LRVFE提取的特征轉換成適合LLM處理的格式,確保圖像特征與文本模態能夠在同一多模態嵌入空間中對齊。

3. 預訓練的帶視覺專家的語言模型(PLMVE):這一模塊結合了視覺專家層和原始LLM層,用于生成基于處理后的圖像特征和文本輸入的文本輸出。

4. 高分辨率交叉視覺模塊(HRCVM):靈感來自于CogAgent,設計用于處理更高分辨率的輸入,它使用更小的視覺編碼器和交叉注意力機制,將高分辨率圖像特征與PLMVE的每一層融合。

5. 高精度定位模塊(HPGM):這一模塊采用增強的DETR對象檢測器(命名為DINO),從PLMVE中提取的隱藏狀態用作視覺定位的查詢,以精確地定位GUI元素。

通過這些模塊的協同工作,V-Zen不僅能夠理解GUI的視覺和文本信息,還能精確地執行定位任務,極大地提高了模型在真實世界應用中的實用性和效率。

精確定位與執行:高精度定位模塊(HPGM)

在多模態大型語言模型(MLLM)的研究和應用中,精確地定位和執行任務是至關重要的一環。特別是在圖形用戶界面(GUI)自動化的背景下,高精度定位模塊(HPGM)的作用尤為突出。HPGM不僅僅是一個普通的對象檢測模塊,它通過使用增強的DETR(名為DINO)對象檢測器,能夠以極高的精度輸出邊界框坐標。

這一模塊的核心在于它如何處理和利用從預訓練語言模型帶有視覺專家(PLMVE)中提取的隱藏狀態。這些隱藏狀態被用作視覺定位的查詢,與多尺度特征集進行交互,以精確地定位GUI元素。多尺度特征集是使用基于Swin Transformer的骨干網絡獲得的,這進一步增強了模型對圖像中細微元素的識別能力。

通過這種方式,HPGM能夠精確地識別和互動GUI元素,這對于提高自動化任務的效率和準確性至關重要。例如,在處理一個包含多個按鈕和圖標的復雜GUI界面時,HPGM能夠準確地識別出用戶指定的操作對象,從而有效地支持后續的自動化操作。

GUIDE數據集的構建與應用

GUIDE(Graphical User Interface Data for Execution)數據集是為了推動多模態大型語言模型(MLLM)在圖形用戶界面自動化領域的應用而特別設計的。這個數據集包含了124,000個數據點,涵蓋了從Apollo.io到Gmail等多種GUI平臺的用戶交互。

每個數據條目都包含一個圖像、一個任務描述、上一個動作和下一個要執行的動作,以及執行動作所需的定位信息。此外,數據集還包括了一個思維鏈(Chain of Thought),記錄了之前的動作歷史,這有助于模型在執行任務時進行上下文推理。

GUIDE數據集的構建使用了先進的注釋工具NEXTAG(Next Action Grounding and Annotation Tool),并且適配了多種操作系統和瀏覽器。通過多個注釋者的協作,數據集能夠捕捉到不同設計風格和用戶交互方式的多樣性。

在實際應用中,GUIDE數據集支持跨界面的自動化任務研究,并鼓勵開發能夠在多平臺上運行的MLLM。數據集的設計不僅僅是為了訓練模型識別下一個任務,更重要的是能夠準確執行與GUI元素(如按鈕、圖標等)的交互,這對于實現高效的GUI自動化至關重要。

實驗設計與結果分析

1. 實驗設計

在我們的研究中,實驗的設計旨在驗證多模態大型語言模型(MLLM)V-Zen在圖形用戶界面(GUI)任務自動化中的有效性。我們特別關注了兩個核心任務:下一任務預測和元素定位(Grounding)。

為了進行這些實驗,我們首先使用了GUIDE數據集,該數據集包括了124,000個數據點,涵蓋了多種GUI環境中的用戶交互。這些數據點不僅包括圖像和任務描述,還包括了執行任務所需的具體動作和位置信息。

我們的模型V-Zen在兩個階段接受訓練:預訓練和特定任務的微調。預訓練階段,模型學習處理高分辨率圖像并適應GUI應用,強調文本識別、視覺定位和理解GUI圖像。微調階段則使用GUIDE數據集,使模型能夠學習復雜的工作流程和動作歷史,從而在遇到新的GUI時,能夠做出準確的推斷和執行相關動作。

2. 結果分析

在下一任務預測方面,V-Zen的表現優于其他同類模型,如CogAgent、GPT-4V等。V-Zen在這一任務中的準確率達到了93.2%,這一結果表明V-Zen能夠準確預測GUI環境中的后續任務,顯示出其在實際應用中的潛力。

在元素定位任務中,V-Zen同樣表現出色,其定位準確率達到了89.7%。這一成績不僅展示了V-Zen在精確定位GUI元素方面的能力,也突顯了其在GUI任務自動化中的實用性。

這些實驗結果驗證了V-Zen在GUI理解和任務執行方面的有效性,同時也展示了其在多模態大型語言模型領域中的先進性。

討論與未來工作

1. 討論

V-Zen模型的成功歸功于其創新的架構,該架構有效地整合了低分辨率和高分辨率視覺模塊、多模態投影適配器和高精度定位模塊。這種設計使得V-Zen能夠有效處理和整合視覺與文本信息,從而提升了其在GUI理解和定位任務中的表現。

此外,GUIDE數據集的使用為模型提供了豐富的訓練資源,使V-Zen能夠從復雜的工作流程和動作歷史中學習,進一步增強了其處理實際GUI元素和任務序列的能力。

2. 未來工作

盡管V-Zen在多個方面表現出色,但仍有改進和擴展的空間。未來的工作將集中在以下幾個方面:

- 性能提升:繼續優化V-Zen的架構,提高其在各種GUI平臺上的表現,尤其是在更復雜或未知的GUI環境中。

- 應用擴展:將V-Zen應用到更廣泛的GUI平臺和實際復雜性場景中,驗證和提升其泛化能力。

- 數據集發展:擴展GUIDE數據集,包括更多種類的GUI環境和任務類型,以支持模型在更廣泛應用中的訓練和測試。

通過這些未來的研究工作,我們希望進一步推動多模態大型語言模型在GUI自動化領域的發展,為實現更智能、更自動的計算體驗開辟新的可能。

總結:V-Zen在多模態大型語言模型中的創新應用及其對GUI自動化的貢獻

在人工智能領域的快速發展中,多模態大型語言模型(MLLMs)已成為一種變革性的力量,它們能夠跨越不同數據表示之間的鴻溝,實現信息的整合和理解。這些模型擅長從多種模態(如文本和圖像)中整合信息,顯著擴展了研究和實際應用的范圍。在這一領域中,一個關鍵的研究方向是圖形用戶界面(GUI)任務的自動化。

1. V-Zen模型的創新設計

我們提出的模型V-Zen,不僅僅是一個MLLM,而是一個高級的GUI代理,能夠準確處理圖像-文本輸入,解釋自然語言指令,精確識別GUI元素,并在網站上執行動作以完成用戶定義的目標。V-Zen集成了一個視覺接地模塊,該模塊利用DINO檢測器的能力,有效地處理多模態接地任務。此外,該模型的性能通過高交叉分辨率模塊(HRCM)進一步增強,該模塊使模型能夠處理高分辨率特征并理解圖像中的文本。

2. GUIDE數據集的開發

為了推動基于代理的研究,我們還創建了一個名為GUIDE(Graphical User Interface Data for Execution)的數據集,這是一個前沿的基準數據集,包括跨各種GUI平臺收集的邊界框注釋和帶有思維鏈的文本描述。GUIDE數據集在提高模型性能方面發揮了關鍵作用,使V-Zen能夠在執行多樣化GUI平臺上的任務時表現出色。

3. 實際應用和未來的研究方向

V-Zen在GUI自動化領域的應用展示了MLLMs在實際操作中的巨大潛力。通過精確地識別和與GUI元素交互,V-Zen不僅增強了這些代理的功能,還顯著提高了它們在現實世界應用中的實用性。我們的研究目標是通過開發能夠有效導航、理解和與GUI元素高精度交互的多模態大型語言模型,推動多模態代理基于GUI任務自動化的邊界。

總之,V-Zen的引入標志著在多模態大型語言模型及其在GUI自動化中應用的一個重要進步。通過其創新的架構和強大的功能,V-Zen為未來的研究和開發奠定了堅實的基礎,展望未來,我們預計將進一步提升V-Zen的性能,并擴展其適用于更廣泛的GUI平臺。

本文轉載自 ??AI論文解讀??,作者:柏企