ECCV2024|LightenDiffusion 超越現有無監督方法,引領低光圖像增強新紀元!

論文鏈接:https://arxiv.org/pdf/2407.08939

git鏈接:https://github.com/JianghaiSCU/LightenDiffusion

亮點直擊

- 提出了一種基于擴散的框架,LightenDiffusion,結合了Retinex理論的優勢和擴散模型的生成能力,用于無監督低光圖像增強。進一步提出了自我約束的一致性損失,以改善視覺質量。

- 提出了一個內容傳輸分解網絡,在潛空間中執行分解,旨在獲取富含內容的反射率圖和無內容的照明圖,以促進無監督恢復。

- 大量實驗證明,LightenDiffusion在超越現有的無監督競爭對手的同時,與監督方法相比具有更好的泛化能力。

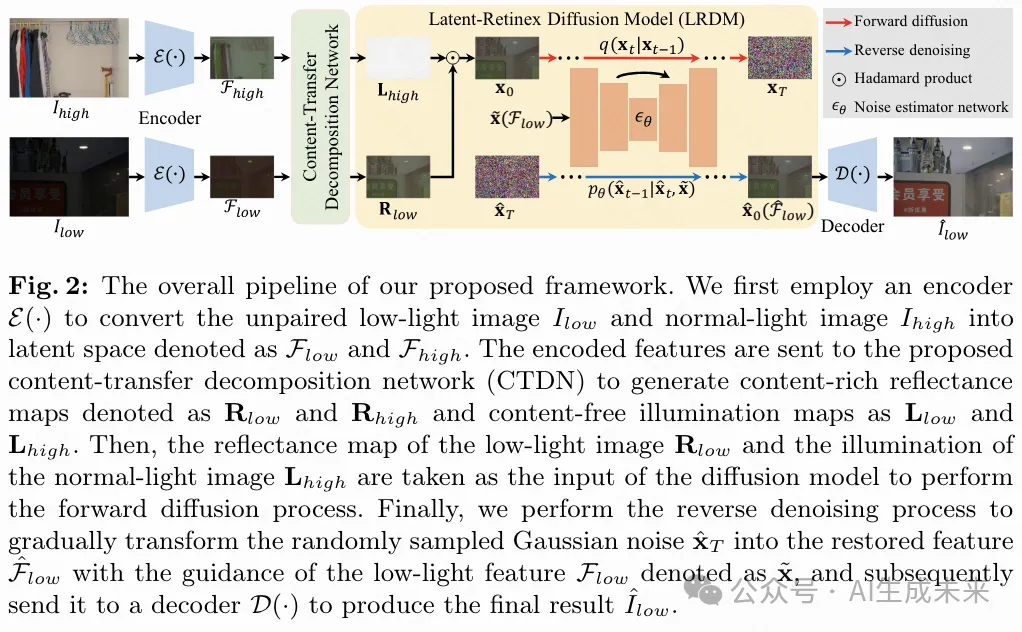

本文提出了一種基于擴散的無監督框架,將可解釋的Retinex理論與低光圖像增強的擴散模型相結合,命名為LightenDiffusion。具體而言,提出了一種內容傳輸分解網絡,在潛空間而非圖像空間中執行Retinex分解,使得未配對的低光和正常光圖像的編碼特征能夠被分解成富含內容的反射率圖和無內容的照明圖。隨后,將低光圖像的反射率圖和正常光圖像的照明圖作為輸入,通過擴散模型進行無監督恢復,以低光特征為指導,進一步提出了自我約束的一致性損失,以消除正常光內容對恢復結果的干擾,從而提高整體視覺質量。在公開的真實世界基準數據集上進行了大量實驗表明,LightenDiffusion在超越現有無監督競爭對手的同時,與監督方法相媲美,并且更具通用性,適用于各種場景。

方法

概述

內容傳輸分解網絡

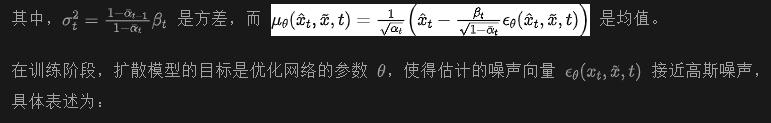

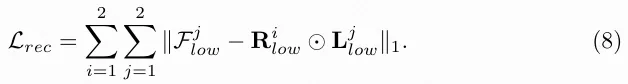

根據Retinex理論,圖像I可以分解為反射率圖R和照明圖L,即:

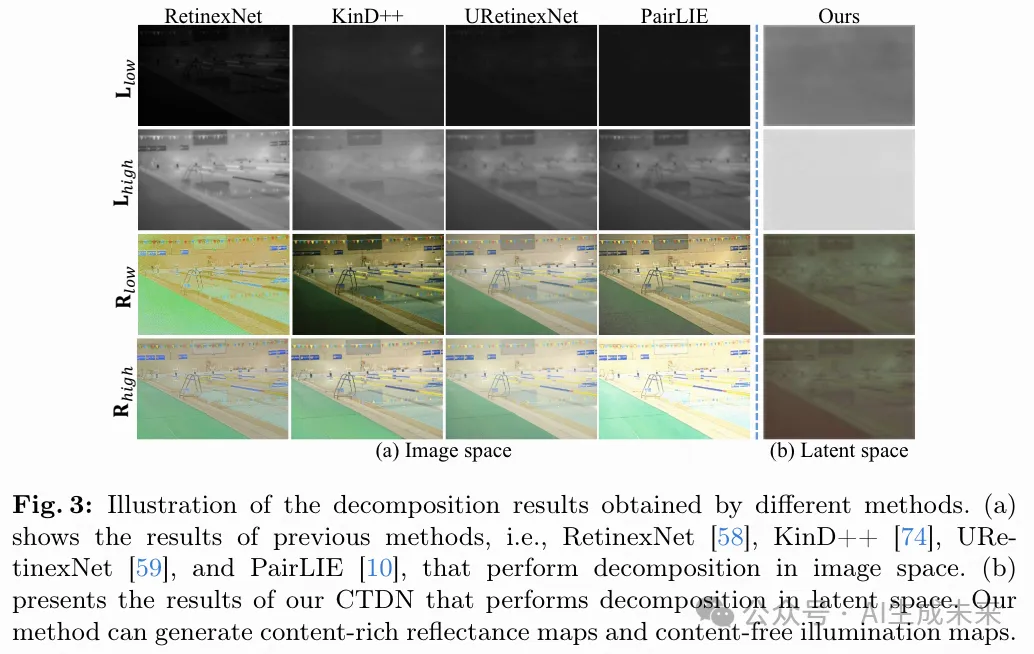

在上述情況下,符號 ⊙ 表示Hadamard乘積運算。其中,R代表應在各種照明條件下保持一致的固有內容信息,而L表示應該是局部平滑的對比度和亮度信息。然而,現有方法通常在圖像空間內執行分解以獲取上述組件,這導致內容信息未能完全分解到反射率圖中,部分保留在照明圖中,如下圖3(a)所示。

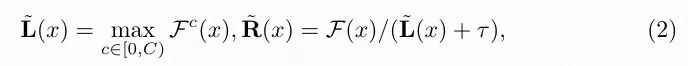

為了緩解這個問題,引入了一個內容傳輸分解網絡(CTDN),它在潛空間內執行分解。通過在這個潛空間中編碼內容信息,CTDN促進了生成包含豐富內容相關細節的反射率圖,并保持不受內容相關影響的照明圖。如下圖4所示,首先按照[14]的方法估計初始的反射率和照明圖為:

如上圖3(b) 所示,CTDN能夠生成內容豐富的反射地圖,充分展示圖像的內在信息,并生成只顯示光照條件的光照地圖。

Latent-Retinex 擴散模型

- Retinex分解不可避免地會導致信息損失;

- 恢復的圖像可能會呈現出現象,因為參考正常光圖像的照明圖仍包含頑固的內容信息。

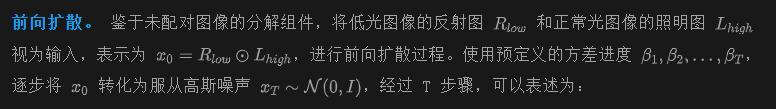

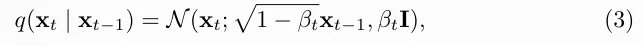

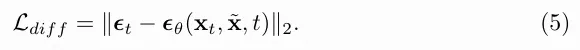

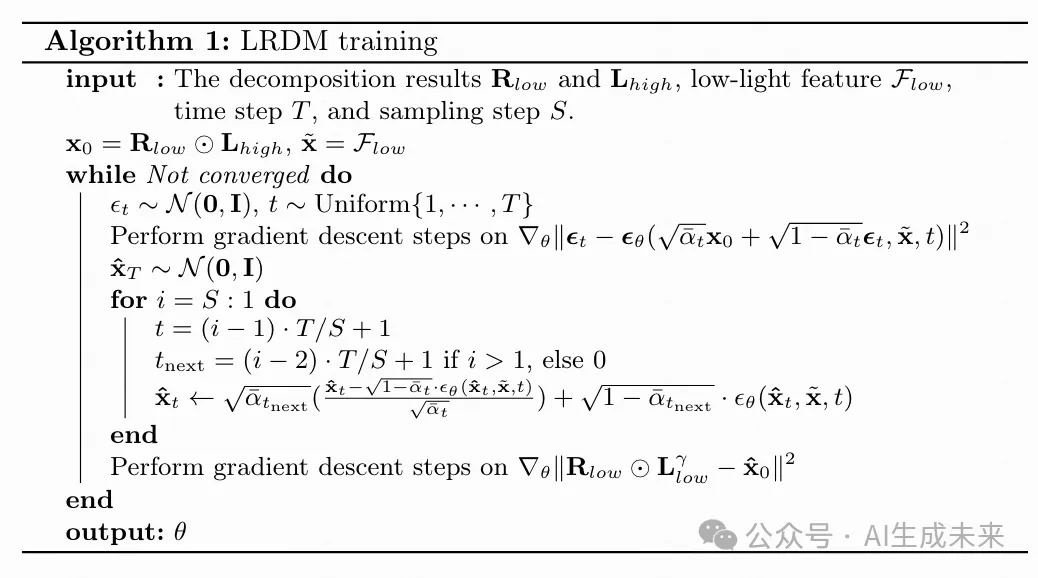

雖然CTDN在大多數場景中通常是有效的,但在一些挑戰性情況下,估計的照明圖的準確性可能會受到影響。為解決這些問題,提出了一種Latent-Retinex擴散模型(LRDM),利用擴散模型的生成能力來補償內容損失并消除潛在的意外現象。方法遵循標準的擴散模型,進行前向擴散和反向去噪過程以生成恢復的結果。

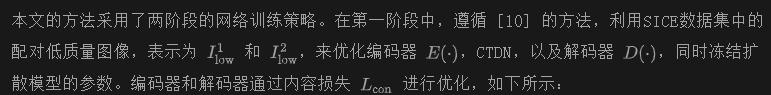

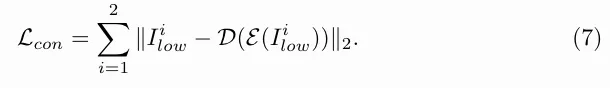

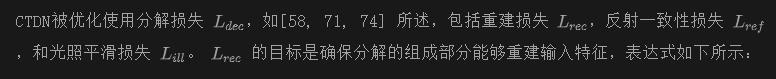

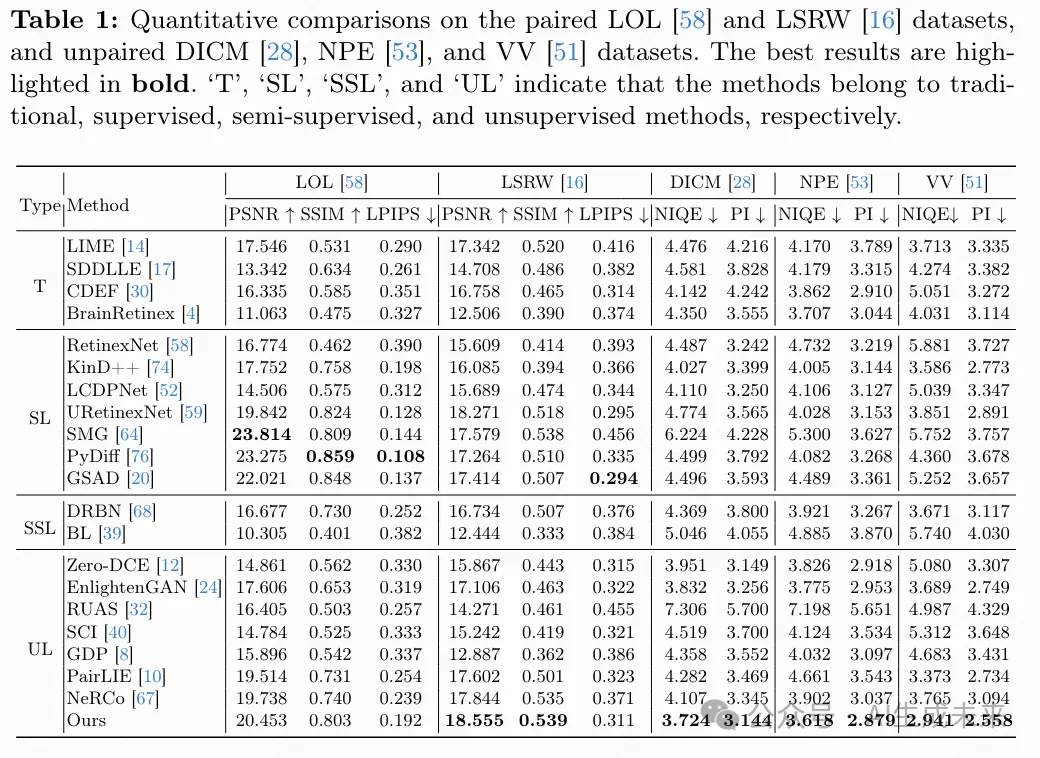

網絡訓練

在第二階段,收集了約180,000對未配對的低光/正常光圖像對,用于在凍結其他模塊參數的同時優化擴散模型。

實驗

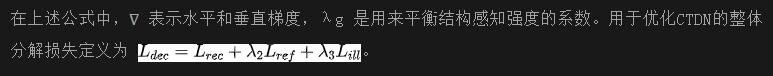

與現有方法的比較

將本文的方法與四類現有的低光圖像增強(LLIE)方法進行比較:

- 傳統方法:包括LIME、SDDLLE、BrainRetinex和CDEF。

- 監督方法:包括RetinexNet、KinD++、LCDPNet、URetinexNet、SMG、PyDiff和GSAD。這些方法在LOL訓練集上進行訓練。

- 半監督方法:包括DRBN和BL。

- 無監督方法:包括Zero-DCE、EnlightenGAN、RUAS、SCI、GDP、PairLIE和NeRCo。

需要注意的是,GDP和本文的方法的性能報告是五次評估的平均值。

定量比較. 首先在LOL和LSRW測試集上將本文的方法與所有比較方法進行量化比較。如下表1所示,LightenDiffusion在這兩個基準上表現優于所有的無監督競爭對手。未能在LOL數據集上超過監督方法的原因是,它們通常在該數據集上進行訓練,因此可以達到令人滿意的性能。然而,本文的方法在LSRW數據集上超過了監督方法,在PSNR和SSIM上達到最高值,盡管在LPIPS方面稍遜色。為了進一步驗證本文方法的有效性,還將提出的LightenDiffusion與比較方法在DICM、NPE和VV這三個未配對基準數據集上進行比較。如表1所示,無監督方法在這些未見過的數據集上表現出比監督方法更好的泛化能力,而本文的方法在所有三個數據集上均取得了最佳結果。這表明本文的方法能夠生成視覺上令人滿意的圖像,并且能夠很好地推廣到各種場景中。

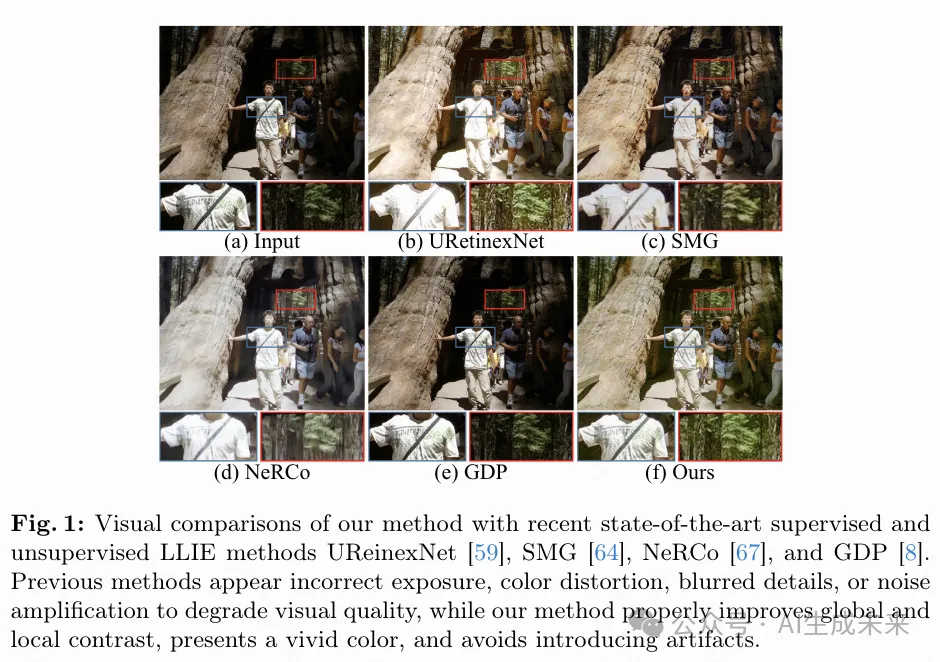

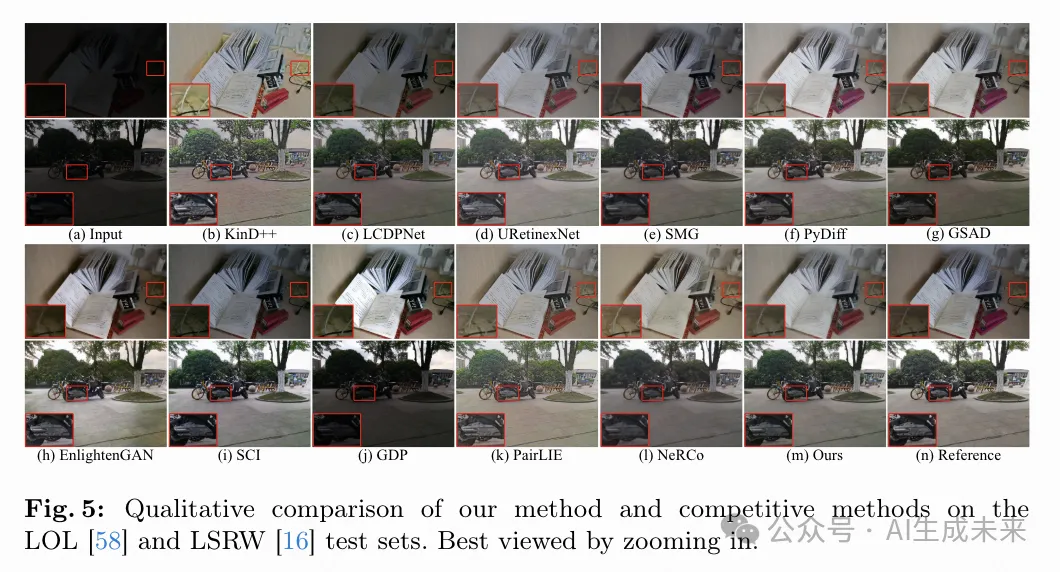

定性比較. 下圖5中展示了本文的方法與競爭方法在配對數據集上的視覺比較結果。圖中的第1至2行分別來自LOL和LSRW測試集。可以看到,先前的方法可能會產生曝光不足、色彩失真或噪聲放大的結果,而本文的方法能夠有效改善全局和局部對比度,重建更清晰的細節,并抑制噪聲,從而產生視覺上令人愉悅的結果。

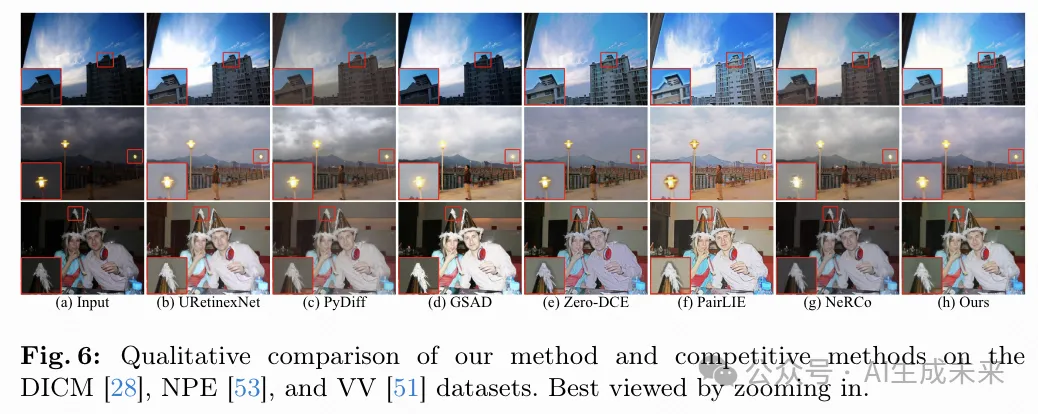

在下圖6中,還提供了在未配對基準數據集上的結果。圖中的第1至3行分別來自DICM、NPE和VV數據集。先前的方法在這些場景中往往表現出泛化能力較差,特別是第2行,在光源周圍產生了偽影或者產生了過曝的結果。相比之下,本文的方法能夠呈現正確的曝光和生動的顏色,證明了在泛化能力上的優勢。

低光人臉檢測

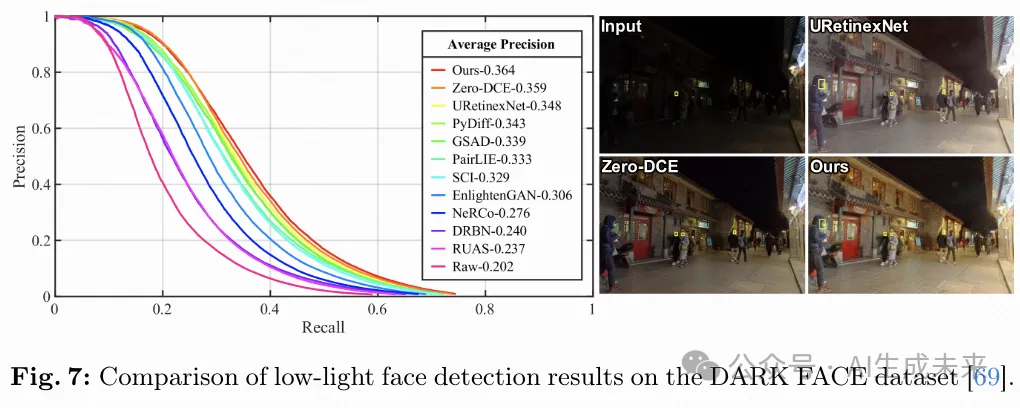

在DARK FACE數據集上進行實驗,該數據集包含6,000張在弱光條件下拍攝的圖像,并帶有標注的標簽用于評估,旨在研究低光圖像增強(LLIE)方法作為預處理步驟在改善低光人臉檢測任務中的影響。遵循文獻 [12, 22, 40] 的方法,使用本文的方法以及其他10種競爭的LLIE方法來恢復圖像,然后使用知名的檢測器RetinaFace在IoU閾值為0.3的條件下進行評估,繪制精確度-召回率(P-R)曲線并計算平均精度(AP)。

如下圖7所示,與未增強的原始圖像相比,本文的方法有效地將RetinaFace的精度從20.2%提高到36.4%,并且在高召回率區域表現優于其他方法,這顯示了本文方法的潛在實際價值。

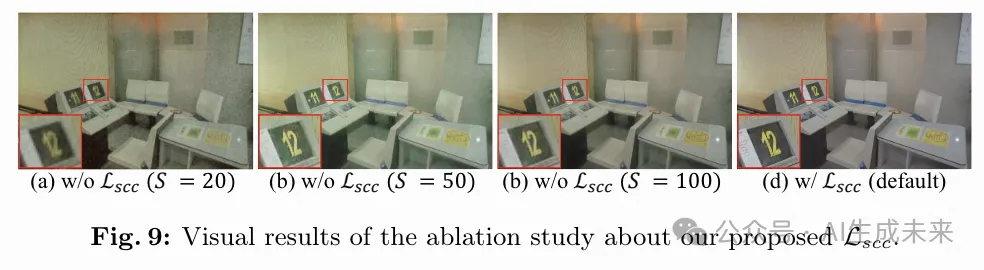

消融實驗

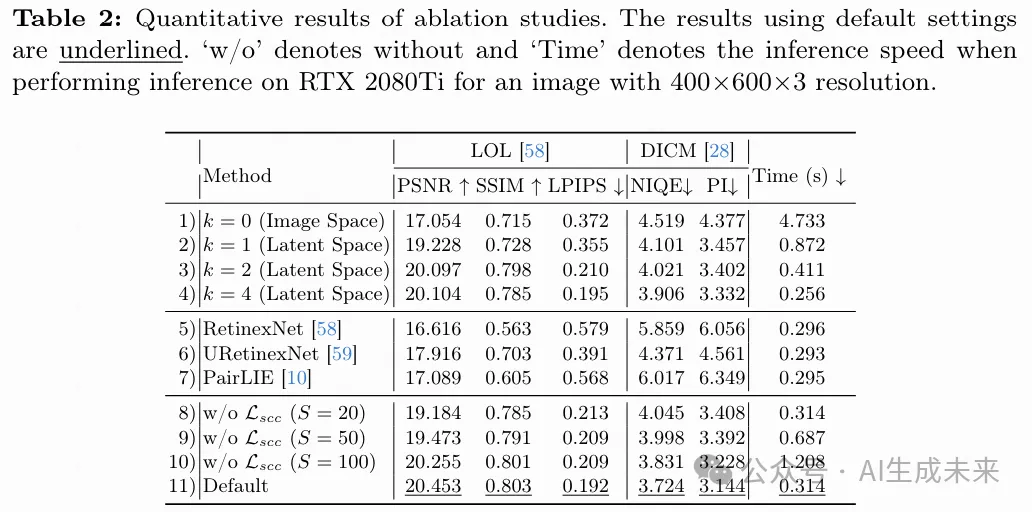

本節進行了一系列消融研究,以驗證不同組件選擇的影響。使用了前文中描述的實現細節進行訓練,并在LOL和DICM數據集上展示了定量結果,如下表2所示。下面討論詳細的設置。

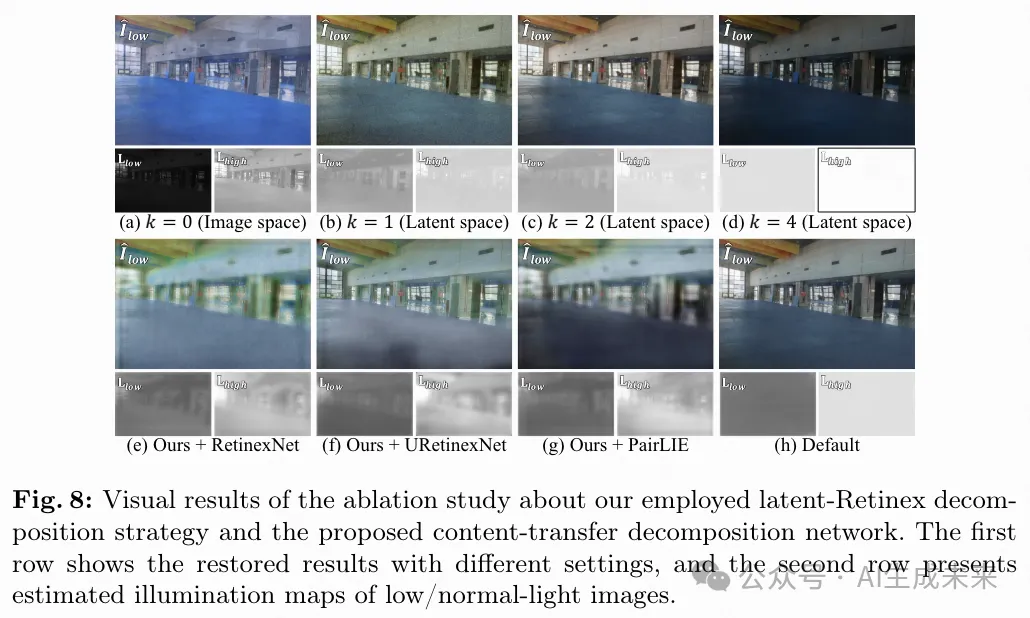

潛空間與圖像空間比較:為了驗證latentRetinex分解策略的有效性,進行了實驗,分別在圖像空間進行分解(即k=0),以及在潛空間的不同尺度進行分解(即k∈[1, 4])。如下圖8(a)所示,在圖像空間進行分解很難實現令人滿意的分解效果,因為光照圖可能會包含某些內容信息,導致恢復的圖像出現偽影。相反,如下圖8(b)-(d)所示,通過在潛空間進行分解可以生成僅表示光照條件的光照圖,這有助于擴散模型生成視覺保真度高的恢復圖像。此外,如上表2的第1-4行報告的結果顯示,增加k可以提升整體性能和推理速度,但在k=4時會因特征信息豐富度大幅降低而導致輕微的性能下降,這對擴散模型的生成能力有不利影響。為了在性能和效率之間找到平衡,選擇k=3作為默認設置。

Retinex分解網絡。 為了驗證CTDN的有效性,將其替換為三種先前基于Retinex的方法的分解網絡,包括RetinexNet、URetinexNet和PairLIE,用于估計反射率和光照圖。如上圖8(e)-(g)所示,先前的分解網絡無法獲得無內容的光照圖,導致恢復的結果具有模糊的細節和偽影。相比之下,本文的方法通過精心設計的CTDN網絡架構,能夠生成富含內容的反射率圖和無內容的光照圖,從而在比較中表現出顯著的性能優勢,如上表2所報告的結果。

結論

LightenDiffusion,這是一個基于擴散的框架,將Retinex理論與擴散模型結合,用于無監督的低光圖像增強(LLIE)。技術上,提出了一個內容轉移分解網絡,它在潛空間內進行分解,以獲取富含內容的反射率圖和無內容的光照圖,從而便于后續的無監督恢復過程。低光圖像的反射率圖和正常光圖像的光照圖在不同場景下作為輸入用于擴散模型的訓練。此外,本文提出了一個自約束一致性損失,進一步約束恢復的結果具有與低光輸入相同的內在內容信息。實驗結果表明,本文的方法在定量和視覺上均優于現有的競爭方法。

本文轉自AI生成未來 ,作者:Hai Jiang等