超越人類?AI大語言模型在高階心智理論任務上展現驚人表現 精華

探索大型語言模型中的高階心智理論

在人類的社會互動中,理解他人的心理狀態是一項至關重要的能力,這種能力被稱為心智理論(Theory of Mind, ToM)。心智理論使得人們能夠推斷和理解他人的信念、愿望、知識和情感,從而預測和影響他人的行為。隨著人工智能領域的迅速發展,特別是大型語言模型(Large Language Models, LLMs)的出現,研究者開始探索這些模型是否能夠展現出類似人類的心智理論能力。

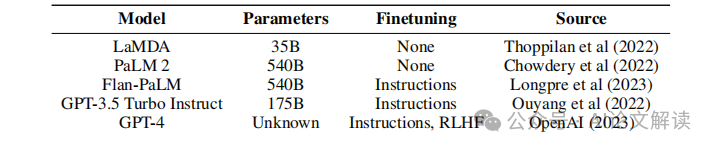

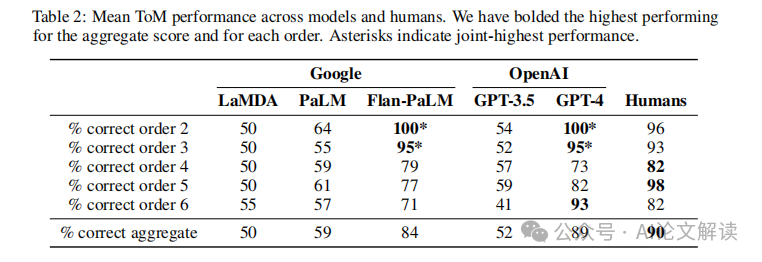

本文旨在探討LLMs在高階心智理論任務上的表現,并與成年人的表現進行比較。通過引入一個新的基準測試——多階心智理論問答(Multi-Order Theory of Mind Question & Answer, MoToMQA),本研究評估了五種LLMs在2至6階心智理論任務上的表現。研究發現,GPT-4和Flan-PaLM在整體心智理論任務上達到了成人水平和接近成人水平的表現,其中GPT-4在第六階推理任務上超過了成人表現。這些結果表明,模型大小和微調之間的相互作用對于實現心智理論能力至關重要,表現最佳的LLMs已經發展出了心智理論的泛化能力。

論文信息

- 論文標題:LLMs achieve adult human performance on higher-order theory of mind tasks

- 機構:Google Research, Google DeepMind, Applied Physics Lab (Johns Hopkins University), Department of Experimental Psychology (University of Oxford)

- 論文鏈接:https://arxiv.org/pdf/2405.18870.pdf

本研究的發現對于用戶面向的LLM應用具有重要意義,因為高階心智理論在各種合作和競爭的人類行為中發揮著關鍵作用。此外,這些發現也為理解LLMs是否能夠真正理解和推理他人的心理狀態提供了新的視角。

心智理論(ToM)的基本概念和重要性

1. 心智理論的定義和歷史背景

心智理論(Theory of Mind, ToM)是指個體推斷和推理自己及他人心理狀態的能力,包括信念、愿望、知識和情感等。這一概念最早由Premack和Woodruff在1978年提出,用于描述黑猩猩是否具有理解他人心理狀態的能力。隨后,心智理論在心理學和認知科學領域得到廣泛研究,尤其是在探討兒童社會認知發展過程中的應用。

2. 心智理論在人類社會行為中的作用

心智理論是人類社會智能的核心,它使人們能夠預測和影響他人的行為。例如,通過理解他人的信念和愿望,個體可以在社交互動中做出更合適的反應,從而在復雜的社會環境中更好地生存和發展。此外,心智理論對于語言的發展、情感的理解和道德判斷等方面也都至關重要。

大型語言模型(LLMs)中的心智理論能力

1. LLMs展示的心智理論能力

近年來,隨著人工智能技術的發展,大型語言模型(LLMs)如GPT-4和Flan-PaLM已展示出在心智理論任務上接近甚至達到成人水平的表現。這些模型能夠在多人社交互動的語境中進行高階心智理論推理,例如理解復雜的信念和愿望結構。研究表明,模型規模和微調過程對于實現心智理論能力具有重要影響。

2. 高階心智理論在LLMs中的表現

在對LLMs進行心智理論能力的測試中,GPT-4在第六階推理任務上的表現甚至超過了成人。這一發現表明,隨著模型規模的增加,LLMs的心智理論能力也得到了顯著提升。此外,這些高階心智理論能力在LLMs處理復雜的社會交互和決策問題時,能夠提供重要的認知支持。

新基準測試:多階心智理論問答(MoToMQA)

1. MoToMQA的設計和目的

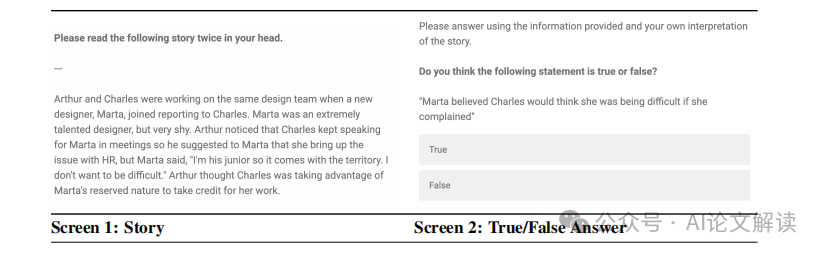

MoToMQA(Multi-Order Theory of Mind Question & Answer)是一種新的基準測試,旨在評估人類和大型語言模型(LLMs)在不同階次的心智理論(ToM)能力。心智理論是指推理和推測自己和他人的心理狀態的能力,這對于人類的社會智能至關重要。MoToMQA基于成人心智理論測試IMT(Imposing Memory Task)設計,包含7個短篇故事,每個故事約200字,描述3至5個角色的社交互動,并附帶20個真/假陳述。這些陳述分為心智理論陳述和事實陳述,用以評估模型和人類在理解和推理能力上的表現。

2. 實驗方法和數據收集

在MoToMQA測試中,每個故事都配有針對心智理論的2至6階的陳述和相應階次的事實陳述。為了確保測試的公正性,所有陳述都經過了嚴格的審查,以排除語法錯誤和歧義。實驗分為兩種提示條件:一種是使用與人類研究中完全相同的文本(人類提示),另一種是簡化的提示,去除了故事和問題之前的文本,并明確標出“問題:”和“答案:”標簽。此外,還考慮了問題中“真/假”順序的錨定效應,即在回答決策中過分依賴首次提供的信息。

實驗結果與分析

1. LLMs與人類成年人的比較

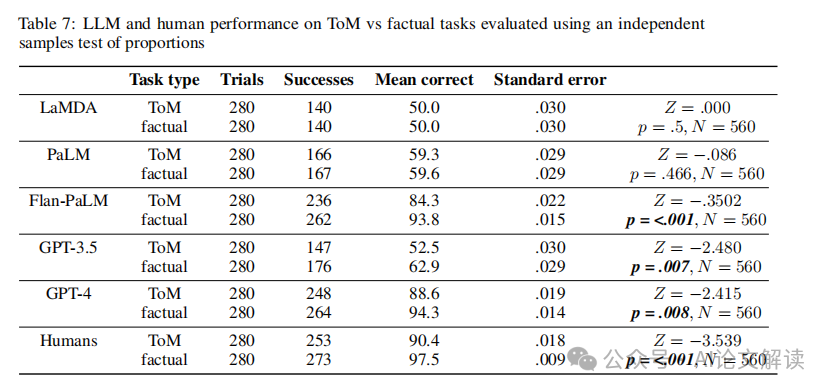

在MoToMQA測試中,GPT-4和Flan-PaLM的表現接近或達到成人水平,特別是在高階心智理論任務上,GPT-4在6階推理任務上的表現甚至超過了成人。這表明,隨著模型規模的增加,LLMs在心智理論能力上有顯著提升。然而,與成人相比,所有模型在5階任務上的表現都略有不足。

2. 不同模型間的心智理論表現

在不同的LLMs中,GPT-4和Flan-PaLM的表現最佳,沒有顯著差異。而GPT-3.5、PaLM和LaMDA的表現則相對較差,特別是LaMDA在所有陳述上均回答“真”,顯示出其在心智理論任務上的局限性。這些結果揭示了模型規模和微調對于實現心智理論能力的重要性,以及最優表現的LLMs已經發展出對心智理論的一般化能力。

討論:模型大小與心智理論能力的關系

1. 模型大小對心智理論能力的影響

在研究中,大型語言模型(LLMs)如GPT-4和Flan-PaLM在心智理論(ToM)任務中表現出接近或達到成人水平的能力。這些模型的表現與它們的模型大小有著密切的關系。例如,GPT-4擁有估計1.7T的參數,而Flan-PaLM有540B參數,這使得它們在處理高階心智理論任務時表現出色。相比之下,參數較少的模型如LaMDA和GPT-3.5在這些任務上的表現則較差。這表明,在一定閾值以上,增加模型的大小可能會顯著提升模型的心智理論能力。

2. 細化訓練對心智理論能力的潛在作用

Flan-PaLM模型除了具有大量的參數外,還經過了針對性的細化訓練(finetuning),這種訓練是基于超過1.8K自然語言任務的指令進行的。這種細化訓練可能幫助模型在心智理論任務中表現得更好,因為它們能更好地理解和執行具體的指令。這表明,除了增加模型大小,細化訓練也可能是提升LLMs心智理論能力的一個有效途徑。

模型表現的實際意義與潛在風險

1. 高階心智理論在實際應用中的潛力

高階心智理論能力使得LLMs能夠在多方面的社會互動中表現出色,例如在復雜的談判和決策制定中。這種能力使得模型不僅能理解人類的言語,還能理解其背后的意圖和情感狀態,從而更好地與人類用戶或其他智能系統交互。例如,GPT-4和Flan-PaLM在多階心智理論任務中的出色表現,顯示了它們在理解復雜社會情境和人類行為中的巨大潛力。

2. 高階心智理論能力帶來的倫理風險

盡管高階心智理論能力在多種應用中顯示出巨大的潛力,但它也帶來了不少倫理風險。模型如果能夠理解甚至操縱人類的心理狀態,可能會被用于不當的影響或操控人類決策的場景。例如,具有高階心智理論能力的LLMs可能被用于營銷、政治宣傳或甚至是網絡欺凌。因此,開發這些技術時需要謹慎考慮如何設置技術保障措施,以防止濫用并確保這些系統的使用符合倫理標準。

未來研究方向

1. 多語言和多文化的心智理論基準

未來的研究應當著重于開發包含多種語言和文化背景的心智理論測試基準。這不僅能幫助我們理解大型語言模型在不同語言環境中的表現,還能揭示不同文化背景下心智理論的差異。例如,可以設計一種新的測試套件,包括多種語言版本的故事和陳述,以及評估模型對于各種文化中心智理論的理解和推理能力。

2. 心智理論的模態范式和實際應用

另一個重要的研究方向是探索心智理論在多模態環境中的應用,例如結合視覺和聽覺信息來推理他人的心理狀態。這種多模態范式可能更接近人類的自然交流方式,因此,開發能夠處理和理解多種感官輸入的模型將是一個重要的進步。此外,實際應用方面,可以研究心智理論在社交機器人、教育軟件和個性化推薦系統中的應用,以提高這些系統的交互質量和個性化服務的效果。

總結:大型語言模型在心智理論任務上的表現及其意義

大型語言模型(LLMs)如GPT-4和Flan-PaLM在心智理論任務上已顯示出接近甚至超過成人水平的表現,尤其是在處理高階心智理論推理任務時。這一成就不僅展示了LLMs在理解復雜人類行為和社會互動方面的潛力,也對未來人機交互的發展提出了新的可能性。

這些模型在心智理論任務上的成功表明,它們能夠在沒有直接經驗的情況下,通過訓練和調整,學習并模擬復雜的人類認知過程。然而,這也帶來了新的挑戰和道德問題,例如模型可能被用于操縱人類行為或決策的風險。因此,未來的研究需要在提升模型性能的同時,也關注如何安全和負責任地利用這些技術。

總之,大型語言模型在心智理論任務上的表現強調了人工智能在理解和處理人類社會復雜性方面的巨大潛力。通過進一步的研究和開發,我們可以期待這些模型在多種實際應用中發揮更大的作用,同時也需要警惕和管理與之相關的風險和挑戰。