視覺(jué)問(wèn)答全景概述:從數(shù)據(jù)集到技術(shù)方法

印度理工學(xué)院 Akshay Kumar Gupta 近日發(fā)布了一篇論文,對(duì)視覺(jué)問(wèn)答方面的數(shù)據(jù)集和技術(shù)進(jìn)行了盤點(diǎn)和比較。機(jī)器之心對(duì)本文內(nèi)容進(jìn)行了摘要式的編譯介紹。

視覺(jué)問(wèn)答(visual question answering/ VQA)是結(jié)合自然語(yǔ)言處理和計(jì)算機(jī)視覺(jué)技術(shù)的一種新興任務(wù)。本文是一份視覺(jué)問(wèn)答技術(shù)研究情況的調(diào)查,我們?cè)谖闹辛信e了一些用于解決這個(gè)任務(wù)的數(shù)據(jù)集和模型。調(diào)查的第一部分詳細(xì)介紹了用于 VQA 的不同數(shù)據(jù)集,并比較了各數(shù)據(jù)集的特點(diǎn)。調(diào)查的第二部分詳細(xì)介紹了 VQA 的不同模型,分為四個(gè)類型:非深度學(xué)習(xí)模型、無(wú)注意機(jī)制(without attention)的深度學(xué)習(xí)模型、有注意機(jī)制(with attention)的深度學(xué)習(xí)模型以及其它模型。最后,我們比較這些模型的性能,并為今后的工作提供一些方向。

一、引言

視覺(jué)問(wèn)答是最近幾年出現(xiàn)的一個(gè)新任務(wù),并引起了機(jī)器學(xué)習(xí)社區(qū)的關(guān)注(Antol 等,2015)(Wu 等,2016a)。該任務(wù)通常分為向計(jì)算機(jī)展示圖像和向計(jì)算機(jī)詢問(wèn)有關(guān)圖像的問(wèn)題兩個(gè)步驟。答案可以是以下任何形式:?jiǎn)卧~、短語(yǔ)、是/否回答、從幾個(gè)可能的答案中選擇或在空白處填寫答案。

視覺(jué)問(wèn)答任務(wù)具有重要性和吸引力,因?yàn)樗Y(jié)合了計(jì)算機(jī)視覺(jué)和自然語(yǔ)言處理領(lǐng)域。計(jì)算機(jī)視覺(jué)技術(shù)用來(lái)理解圖像,NLP 技術(shù)用來(lái)理解問(wèn)題。此外,兩者必須結(jié)合起來(lái)才能有效地回答圖像情境中的問(wèn)題。這相當(dāng)具有挑戰(zhàn)性,因?yàn)閭鹘y(tǒng)上這兩個(gè)領(lǐng)域使用不同的方法和模型來(lái)解決各自的任務(wù)。

本調(diào)查詳細(xì)介紹了用于解決視覺(jué)問(wèn)答任務(wù)的數(shù)據(jù)集和模型,并對(duì)這些模型在各數(shù)據(jù)集上運(yùn)行的效果進(jìn)行了比較。本文分為 4 個(gè)部分:第 2 部分介紹 VQA 數(shù)據(jù)集,第 3 部分介紹模型,第 4 部分討論結(jié)果并提供一些未來(lái)的可能方向。

二、數(shù)據(jù)集

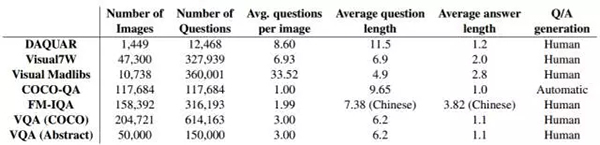

在過(guò)去 2-3 年中,出現(xiàn)了幾個(gè)大型的面向 VQA 任務(wù)的數(shù)據(jù)集。表 1 是這些數(shù)據(jù)集的情況摘要。

表 1:VQA 數(shù)據(jù)集

三、模型

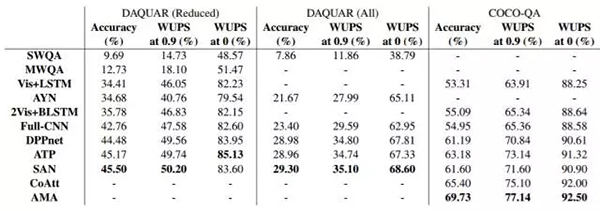

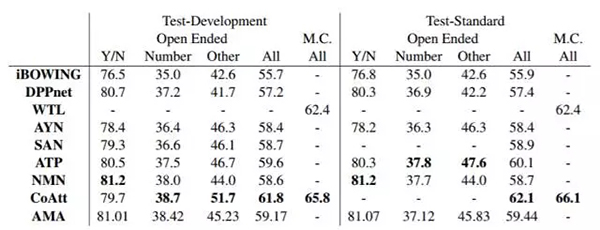

隨著深度學(xué)習(xí)技術(shù)的廣泛普及,VQA 任務(wù)被提出時(shí),深度學(xué)習(xí)領(lǐng)域各種計(jì)算機(jī)視覺(jué)和 NLP 技術(shù)已經(jīng)有了很大發(fā)展。因此,文獻(xiàn)中幾乎所有關(guān)于 VQA 的工作都涉及深度學(xué)習(xí)方法,而不是采用更經(jīng)典的方法,如圖模型(graphical model)。在本部分第 1 小節(jié)中,作者詳細(xì)介紹了幾個(gè)沒(méi)有用神經(jīng)網(wǎng)絡(luò)方法的模型,以及作者在這些模型中使用的幾個(gè)簡(jiǎn)單基線(baseline)算法。第 2 小節(jié)介紹了無(wú)注意機(jī)制的深度學(xué)習(xí)模型。第 3 小節(jié)詳細(xì)介紹了用于 VQA 的有注意機(jī)制的深度學(xué)習(xí)模型。所有模型的結(jié)果總結(jié)在表 2 和表 3 中。

1. 非深度學(xué)習(xí)方法

(1) 回答類型預(yù)測(cè)(Answer Type Prediction/ATP)

(Kafle 和 Kanan,2016)提出了一個(gè)用于 VQA 的貝葉斯框架,他們用模型預(yù)測(cè)一個(gè)問(wèn)題的答案類型,并用它來(lái)產(chǎn)生答案。可能的答案類型隨著數(shù)據(jù)集的不同而有所不同。例如,對(duì)于 COCO-QA,他們考慮四種答案類型:對(duì)象、顏色、計(jì)數(shù)和位置。

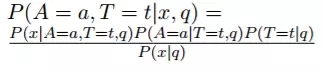

給定圖像 x 和問(wèn)題 q,模型計(jì)算答案 a 和答案類型 t 的概率:

遵循貝葉斯定理。然后,計(jì)算所有答案類型邊際分布概率得到 P(A=a|x,q)。對(duì)于給定的問(wèn)題和答案,分母是常數(shù)可以忽略。

他們用三個(gè)獨(dú)立的模型對(duì)分子中的 3 個(gè)概率進(jìn)行建模。第 2 和第 3 個(gè)概率都使用 logistic 回歸進(jìn)行建模。問(wèn)題的特征采用跳躍思維向量表征(skip-thought vector representation)(Kiros 等人,2015)(他們使用預(yù)訓(xùn)練的跳躍思維模型)。第 1 個(gè)概率為條件多元高斯模型,原理上與二次判別分析(Quadratic Discriminant Analysis)相似。此模型采用了原始圖像特征。

作者還介紹了一些簡(jiǎn)單的基線算法,如僅將圖像特征或僅將問(wèn)題特征饋送到 logistic 回歸,將圖像和問(wèn)題特征同時(shí)饋送到邏輯回歸,以及將相同的特征饋送到多層感知器。他們?cè)?DAQUAR、COCO-QA、Visual7W 和 VQA 數(shù)據(jù)集上進(jìn)行了評(píng)估。

(2) 多元世界(Multi-World)問(wèn)答

(Malinowski 和 Fritz,2014)這篇論文將基于問(wèn)題和圖像的答案概率建模為

。這里 T 為隱藏變量,它對(duì)應(yīng)于從問(wèn)題語(yǔ)義分析器(semantic parser)得到的語(yǔ)義樹(shù)(semantic tree)。W 是世界,代表圖像。它可以是原始圖像或從分割塊獲得的附加特征。使用確定性評(píng)價(jià)(deterministic evaluation)函數(shù)來(lái)評(píng)估 P(A|T,W)。使用簡(jiǎn)單的對(duì)數(shù)線性模型得到 P(T|Q)。這個(gè)模型被稱為 SWQA。

作者進(jìn)一步將其擴(kuò)展到多元世界的場(chǎng)景,用來(lái)模擬分割和分類標(biāo)簽的不確定性。不同的標(biāo)簽代表不同的 W,所以概率模型為

這里,S 是帶有類標(biāo)簽分布的一組分割圖像集。因此,從分布中抽樣分割圖像時(shí)將得到其對(duì)應(yīng)的一個(gè)可能的 W。由于上述方程很復(fù)雜,作者僅從 S 中抽樣固定數(shù)量的 W。

這個(gè)模型稱為 MWQA。這些模型在 DAQUAR 數(shù)據(jù)集上進(jìn)行評(píng)估。

2. 無(wú)注意機(jī)制的深度學(xué)習(xí)模型

VQA 的深度學(xué)習(xí)模型通常使用卷積神經(jīng)網(wǎng)絡(luò)(CNN)來(lái)嵌入圖像與循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)的詞嵌入(word embedding)來(lái)嵌入問(wèn)題。這些嵌入以各種方式組合和處理以獲得答案。以下模型描述假設(shè)讀者熟悉 CNN(Krizhevsky 等人,2012)以及 RNN 變體,如長(zhǎng)短時(shí)記憶(LSTM)單元(Hochreiter 和 Schmidhuber,1997)和門控循環(huán)單位(Gated Recurrent Unit/GRU)(Cho 等人,2014)。

一些方法不涉及使用 RNN。我們?cè)陂_(kāi)頭已經(jīng)討論過(guò)這些模型。

(1) iBOWING

(Zhou 等人,2015)提出了一種叫做 iBOWING 的基線模型。他們使用預(yù)訓(xùn)練的 GoogLeNet 圖像分類模型的層輸出來(lái)提取圖像特征。問(wèn)題中每個(gè)詞的詞嵌入都被視為文本特征,因此文本特征是簡(jiǎn)單的詞袋(bag-of-word)。連接圖像和文本的特征,同時(shí)對(duì)答案分類使用 softmax 回歸。結(jié)果表明,該模型在 VQA 數(shù)據(jù)集上表現(xiàn)的性能與幾種 RNN 方法相當(dāng)。

(2) Full-CNN

(Ma 等人,2015)提出了一種僅用 CNN 的模型,稱為 Full-CNN。模型使用三種不同的 CNN:一種用于編碼圖像,一種用于編碼問(wèn)題,一種用于將圖像和問(wèn)題的編碼結(jié)合在一起并產(chǎn)生聯(lián)合表征。

圖像 CNN 使用與 VGG 網(wǎng)絡(luò)相同的架構(gòu),并從該網(wǎng)絡(luò)的第二層獲取長(zhǎng)度為 4096 的向量。這通過(guò)另一個(gè)完全連接的層,以獲得大小為 400 的圖像表征向量。句子 CNN 涉及 3 層卷積和最大池化(max pooling)。卷積感受野(receptive field)的大小設(shè)置為 3。換句話說(shuō),核函數(shù)(kernel)會(huì)計(jì)算該詞及其相鄰的鄰居。聯(lián)合 CNN 稱為多元模態(tài) CNN(multi-modal CNN),在問(wèn)題表征上的卷積感受野大小為 2。每個(gè)卷積運(yùn)算都在完整的圖像上進(jìn)行。將多元模態(tài) CNN 的最終表征結(jié)果傳入 softmax 層以預(yù)測(cè)答案。該模型在 DAQUAR 和 COCO-QA 數(shù)據(jù)集上進(jìn)行評(píng)估。

以下模型同時(shí)使用了 CNN 和 RNN 算法。

(3) 神經(jīng)元詢問(wèn)(Ask Your Neurons/AYN)(Malinowski 等人,2016)

該模型使用 CNN 對(duì)圖像 x 進(jìn)行編碼并獲得圖像的連續(xù)向量表征。問(wèn)題 q 使用 LSTM 或 GRU 網(wǎng)絡(luò)進(jìn)行編碼,其中在時(shí)間 t 步驟的輸入是問(wèn)題的第 t 個(gè)詞 q_t 的詞嵌入與圖像向量編碼。問(wèn)題編碼是最終時(shí)間步驟獲得的隱藏向量。作者使用的一個(gè)簡(jiǎn)單的詞袋基線是將問(wèn)題的所有詞嵌入的總和作為編碼。

解碼答案可以用兩種不同的方式,一種是對(duì)不同答案的分類,另一種是答案的生成。分類由完全連接層生成輸出并傳入覆蓋所有可能答案的 softmax 函數(shù)。另一方面,生成由解碼器 LSTM 執(zhí)行。在每個(gè)時(shí)間點(diǎn)的 LSTM 將前面生成的詞以及問(wèn)題和圖像編碼作為輸入。下一個(gè)詞使用覆蓋詞匯表的 softmax 函數(shù)來(lái)預(yù)測(cè)。需要注意的一點(diǎn)是,該模型在編碼器和解碼器 LSTM 之間共享一些權(quán)重。該模型在 DAQUAR 數(shù)據(jù)集上進(jìn)行評(píng)估。

(4) Vis + LSTM(Ren 等人,2015)

該模型與 AYN 模型非常相似。該模型使用 VGG 網(wǎng)絡(luò)的最終層來(lái)獲得圖像編碼使用 LSTM 對(duì)問(wèn)題進(jìn)行編碼。與之前的模型相反,在編碼問(wèn)題之前,它們將圖像編碼作為第一個(gè)「詞」傳入 LSTM 網(wǎng)絡(luò)。該 LSTM 的輸出先通過(guò)完全連接層,然后通過(guò) softmax 層。

作者還提出了一種使用雙向 LSTM 的 2Vis+BLSTM 模型。向后的 LSTM 也將圖像編碼作為第一個(gè)輸入。兩個(gè) LSTM 的輸出相連接,然后通過(guò)一個(gè) dense 和 softmax 層。

(5) 動(dòng)態(tài)參數(shù)預(yù)測(cè)(DPPnet)(Noh 等人,2016)

本論文的作者認(rèn)為,設(shè)定一組固定參數(shù)并不足以滿足 VQA 任務(wù)。他們采用 VGG 網(wǎng)絡(luò)架構(gòu),刪除最終 softmax 層,并添加三個(gè)全連接層,并最后使用覆蓋所有可能答案的 softmax 函數(shù)。這些完全連接層的第 2 層沒(méi)有固定的一組參數(shù)。相反,參數(shù)來(lái)自 GRU 網(wǎng)絡(luò)。該 GRU 網(wǎng)絡(luò)用于對(duì)問(wèn)題進(jìn)行編碼,并且 GRU 網(wǎng)絡(luò)的輸出通過(guò)完全連接層給出候選參數(shù)的權(quán)重小向量。然后使用逆哈希函數(shù)(inverse hashing function)將該向量映射到第 2 完全連接層所需的參數(shù)權(quán)重大向量中。這種哈希(hashing)技術(shù)被用于避免預(yù)測(cè)全部的參數(shù)權(quán)重而帶來(lái)的計(jì)算成本高昂,并避免由此導(dǎo)致的過(guò)擬合。或者可以將動(dòng)態(tài)參數(shù)層視為將圖像表征和問(wèn)題表征相乘得到的聯(lián)合表征,而不是傳統(tǒng)的以線性方式組合。該模型在 DAQUAR、COCO-QA 和 VQA 數(shù)據(jù)集上進(jìn)行評(píng)估。

3. 基于注意機(jī)制的深度學(xué)習(xí)技術(shù)

基于注意機(jī)制的技術(shù)是最受歡迎的技術(shù)之一,在機(jī)器翻譯(Bahdanau 等人,2014)、圖像描述(Xu 等人,2015)等眾多任務(wù)中使用。對(duì)于 VQA 任務(wù),注意機(jī)制模型聚焦在圖像、問(wèn)題或兩者的重要部分,從而有效地給出答案。

(1) Where To Look(WTL)

(Shih 等人,2016)提出了以下稱為 WTL 的基于注意機(jī)制的模型。他們使用 VGGnet 對(duì)圖像進(jìn)行編碼,并連接最后兩層 VGGnet 的輸出,以獲得圖像編碼。問(wèn)題表征是通過(guò)對(duì)問(wèn)題中每個(gè)詞的詞向量求平均得到的。在圖像特征集上計(jì)算注意向量,以確定圖像中的哪個(gè)區(qū)域重要。該向量用下面的方式計(jì)算:如果 V=(-→v1,-→v2 ... -→vK)是圖像特征的集合,而-→q 是問(wèn)題嵌入,則第 j 個(gè)區(qū)域的重要性被計(jì)算為 g_j=(A-→vj+bA)T(B-→q+bB)

注意向量的權(quán)重通過(guò)標(biāo)準(zhǔn)化-→g 獲得。最終的圖像表征是不同區(qū)域的注意值加權(quán)和。這與嵌入問(wèn)題相連接,并傳入 dense+softmax 層。該模型在 VQA 數(shù)據(jù)集上進(jìn)行評(píng)估。損失函數(shù)是基于 VQA 評(píng)估指標(biāo)的最大邊際損失(margin based loss)。

(2) 循環(huán)空間注意(Recurrent Spatial Attention/R-SA)(Zhu 等人,2016)

本模型在兩個(gè)方面比上一個(gè)模型超前一步。首先,它使用 LSTM 對(duì)問(wèn)題進(jìn)行編碼,其次,在掃描問(wèn)題的每個(gè)詞之后,它重復(fù)地計(jì)算圖像的注意值。更具體地說(shuō),在 LSTM 的每個(gè)時(shí)間步長(zhǎng) t,我們反復(fù)計(jì)算圖像特征的注意值加權(quán)和 r_t,r_t 用作 LSTM 的下一個(gè)時(shí)間步長(zhǎng)的附加輸入。利用 LSTM 之前的隱藏狀態(tài) ht-1 和圖像本身,用于得到 r_t 的注意向量的權(quán)重用 dense+softmax 層計(jì)算得出。從生理角度,當(dāng)我們閱讀問(wèn)題時(shí),我們會(huì)不斷地決定圖像的哪部分需要注意,而現(xiàn)在注意的部分取決于當(dāng)前的詞和 ht-1 狀態(tài)前的注意加權(quán)圖像。

該模型在 Visual7W 數(shù)據(jù)集上進(jìn)行評(píng)估,該數(shù)據(jù)集用于文本回答任務(wù)以及指點(diǎn)任務(wù)(指出圖像中的區(qū)域作為答案)。實(shí)際和預(yù)測(cè)答案之間的 softmax 交叉熵?fù)p失函數(shù)(cross entropy loss)用于文本回答任務(wù)。對(duì)于指點(diǎn)任務(wù),通過(guò)采用表示該區(qū)域的特征的點(diǎn)積和 LSTM 的最后狀態(tài)來(lái)獲得候選區(qū)域的對(duì)數(shù)似然值(log likelihood)。再次使用交叉熵?fù)p失函數(shù)來(lái)訓(xùn)練模型。

(3) 堆疊注意網(wǎng)絡(luò)(Stacked Attention Networks/SAN)(Yang 等人,2016)

本模型在思想上與之前的模型相似,因?yàn)樗磸?fù)計(jì)算對(duì)圖像的注意向量,以獲得更細(xì)粒度的視覺(jué)信息來(lái)預(yù)測(cè)答案。然而,雖然之前的模型對(duì)問(wèn)題逐詞計(jì)算,本模型首先使用 LSTM 或 CNN 對(duì)整個(gè)問(wèn)題進(jìn)行編碼。這里的問(wèn)題編碼用與之前類似的方程來(lái)注意圖像。然后,連接注意加權(quán)圖像與問(wèn)題編碼,并將其再次用于計(jì)算對(duì)原始圖像的注意。這可以重復(fù) k 次,之后使用問(wèn)題和最終圖像表征來(lái)預(yù)測(cè)答案。作者認(rèn)為,這種「堆疊」注意有助于模型迭代地丟棄圖像中不重要的區(qū)域。作者對(duì) k=1 和 k=2 進(jìn)行了實(shí)驗(yàn),并在 DAQUAR、COCO-QA 和 VQA 數(shù)據(jù)集上進(jìn)行評(píng)估。

(4) 層次協(xié)同注意(Hierarchical Co-attention/CoAtt)(Lu 等人,2016)

本文不同于之前基于注意的方法,它的模型除了對(duì)視覺(jué)注意外,還同時(shí)注意問(wèn)題(問(wèn)題的哪部分重要)。模型有兩種協(xié)同注意的形式:1)并行協(xié)同注意,其中圖像和問(wèn)題的注意同時(shí)進(jìn)行。這通過(guò)計(jì)算親和矩陣(affinity matrix)C=tanh(Q^TWI) 來(lái)完成,其中 W 是可學(xué)習(xí)的權(quán)重矩陣,C_ij 表示問(wèn)題中第 i 個(gè)詞和圖像中第 j 個(gè)區(qū)域的親和值。該矩陣 C 用于獲得圖像和問(wèn)題注意向量。2)交替協(xié)同注意,這里我們迭代地注意圖像,然后查詢,然后再次注意圖像(類似于 SAN 的思想)。

作者使用的另外一個(gè)想法是在不同的抽象層上編碼問(wèn)題:詞、短語(yǔ)和問(wèn)題層面。通過(guò) LSTM 獲得問(wèn)題的表征,而從 CNN 獲得詞和短語(yǔ)的表征。該模型在 VQA 和 COCOQA 數(shù)據(jù)集上進(jìn)行評(píng)估。

4. 其它模型

不同于前面的模型,下面的模型使用了更多的思想,而不僅僅是在計(jì)算圖像或問(wèn)題的注意值方面作改變。

(1) 神經(jīng)模塊網(wǎng)絡(luò)(NMN/Neural Module Network)

(Andreas 等人,2016)該模型為每個(gè)圖像和問(wèn)題同時(shí)不間斷地生成一個(gè)神經(jīng)網(wǎng)絡(luò)。具體的實(shí)現(xiàn)方式為:從各種基于問(wèn)題的子模塊中選擇,并組合它們生成神經(jīng)網(wǎng)絡(luò)。有五種模塊:注意 [c](其計(jì)算給定圖像和給定 c 的注意映射;c 可以是「狗」,然后注意 [狗] 將嘗試找到含有狗的圖像),分類 [c](對(duì)于給定的圖像和注意映射,其輸出屬于 c 的標(biāo)簽的分布;c 可以是「顏色」),重新注意 [c](它使用注意映射并基于 c 重新計(jì)算這個(gè)映射;c 可以是「上面」,意味著將注意力向上移動(dòng)),測(cè)量 [c](它僅通過(guò)注意映射輸出標(biāo)簽的分布)和組合 [c](它合并由 c 確定的兩個(gè)注意映射,c 可以是「與」或「或」)。

決定組合哪些模塊之前,模型首先使用依存句法分析器(dependency parser)來(lái)解析問(wèn)題,并使用此依存關(guān)系創(chuàng)建基于中心詞的符號(hào)表達(dá)。本論文的一個(gè)例子是「What is standing on the field(站在運(yùn)動(dòng)場(chǎng)上的是什么)」變?yōu)椤竪hat(stand)」。然后用這些符號(hào)形式來(lái)確定要使用的模塊。之后通過(guò)反向傳播端到端(end-to-end)地訓(xùn)練整個(gè)系統(tǒng)。模型在 VQA 數(shù)據(jù)集與一個(gè)更具挑戰(zhàn)性的合成數(shù)據(jù)集(由于發(fā)現(xiàn) VQA 數(shù)據(jù)集不需要太多的高級(jí)推理或組合)上評(píng)估。

(2) 包含知識(shí)庫(kù)

(Wu 等人,2016b)提出了「詢問(wèn)任何問(wèn)題」(Ask Me Anything/AMA)模型,該模型試圖借助外部知識(shí)庫(kù)中的信息來(lái)幫助指導(dǎo)視覺(jué)問(wèn)答。它首先基于圖像的標(biāo)題獲得一組屬性,如對(duì)象名稱、屬性等。圖像標(biāo)題模型在 MS-COCO 數(shù)據(jù)集上使用標(biāo)準(zhǔn)的圖像加標(biāo)題技術(shù)訓(xùn)練。該模型生成 256 個(gè)可能的屬性,并且屬性生成器使用 VGG 網(wǎng)絡(luò)的變體在 MS-COCO 數(shù)據(jù)集上訓(xùn)練。前 5 個(gè)屬性用于生成查詢 DBpedia 數(shù)據(jù)庫(kù)的語(yǔ)句。每次查詢返回一個(gè)用 Doc2Vec 算法排序匯總的文本。該匯總文本作為附加輸入傳給生成回答的 LSTM 解碼器。模型在 VQA 和 COCO-QA 數(shù)據(jù)集上進(jìn)行評(píng)估。

表 2:不同模型在 DAQUAR(部分)、DAQUAR(全部)、COCO-QA 數(shù)據(jù)集上的表現(xiàn)

表 3:不同模型在 VQA 數(shù)據(jù)集上的表現(xiàn)

四、討論以及未來(lái)的工作

在所有 VQA 數(shù)據(jù)集上,深度學(xué)習(xí)模型的表現(xiàn)比早期基于圖模型的方法出色,這已經(jīng)成為近年來(lái)的趨勢(shì)。然而,有趣的是,我們看到 ATP 模型的表現(xiàn)優(yōu)于非注意模型,這證明簡(jiǎn)單地引入卷積和/或循環(huán)神經(jīng)網(wǎng)絡(luò)是不夠的:原則上識(shí)別相關(guān)的圖像部分是重要的。ATP 甚至可以與一些注意模型(如 WTL 和 SAN)相媲美甚至表現(xiàn)更好。

CoAtt 的表現(xiàn)有顯著的提升,該模型首先注意問(wèn)題然后注意圖像。這對(duì)于長(zhǎng)問(wèn)題可能是有幫助的,由于這些問(wèn)題更難用 LSTM/GRU 編碼表示為單個(gè)向量,因此首先對(duì)每個(gè)詞進(jìn)行編碼,然后使用圖像來(lái)注意重要的詞,這樣有助于提高模型的準(zhǔn)確率。NMN 模型使用了為每個(gè)(圖像/問(wèn)題)對(duì)自動(dòng)組合子模型的新穎想法,它的表現(xiàn)效果類似于在 VQA 數(shù)據(jù)集上的 CoAtt 模型,但是在需要更高級(jí)推理的合成數(shù)據(jù)集上優(yōu)于所有模型,表明該模型在實(shí)際中可能是一種有價(jià)值的方法。然而,需要更多的測(cè)試來(lái)判斷該模型的性能。

在 COCO-QA 數(shù)據(jù)集上表現(xiàn)最好的模型是 AMA 模型,它包含外部知識(shí)庫(kù)(DBpedia)的信息。這樣做的一個(gè)可能的原因是知識(shí)庫(kù)幫助解決涉及常識(shí)的問(wèn)題,而這些知識(shí)可能不在數(shù)據(jù)集中。該模型在 VQA 數(shù)據(jù)集上的表現(xiàn)不是很好,這可能是因?yàn)檫@個(gè)數(shù)據(jù)集沒(méi)有太多的問(wèn)題需要常識(shí)。自然地這種模型會(huì)為未來(lái)的工作帶來(lái)兩大方向。第一個(gè)方向是認(rèn)識(shí)到外部知識(shí)的必要性:某種 CoAtt 和 AMA 的混合模型加上是否訪問(wèn)知識(shí)庫(kù)的決策器可能會(huì)兼有兩種模型的優(yōu)點(diǎn)。該決策器可能是面向應(yīng)用的,以實(shí)現(xiàn)端到端的訓(xùn)練。第二個(gè)方向是探索使用其它知識(shí)庫(kù),如 Freebase、NELL 或 OpenIE 的信息提取。

正如我們所看到的,在這個(gè)任務(wù)上,注意值的新穎計(jì)算方法能持續(xù)改善模型的效果。這也是在文本問(wèn)答(textual question answering)任務(wù)中看到的,因此可以用文本問(wèn)答的更多模型來(lái)指導(dǎo) VQA 模型。對(duì)各種 VQA 數(shù)據(jù)集的性能上限估計(jì)的研究將是非常有價(jià)值的,以便找到可能的改進(jìn)方法,特別是對(duì)于自動(dòng)生成的 COCO-QA 數(shù)據(jù)集。最后,大多數(shù) VQA 任務(wù)將回答視為分類任務(wù)。將回答作為生成任務(wù)將是有趣的,但數(shù)據(jù)集的收集和評(píng)估方法仍然是一個(gè)有待解決的問(wèn)題。

五、結(jié)論

盡管 VQA 只有幾年的發(fā)展時(shí)間,VQA 任務(wù)已經(jīng)得到了跨越式發(fā)展。VQA 的深度學(xué)習(xí)方法持續(xù)收到了最多的關(guān)注并擁有最先進(jìn)的結(jié)果。我們調(diào)查了這些模型中最突出的一些模型,并列出了它們?cè)诟鞣N大型數(shù)據(jù)集上的表現(xiàn)。我們不斷看到在許多數(shù)據(jù)集上顯著的性能改進(jìn),這意味著未來(lái)在此任務(wù)上很大的創(chuàng)新空間。

論文原文請(qǐng)?jiān)L問(wèn):https://arxiv.org/abs/1705.03865

【本文是51CTO專欄機(jī)構(gòu)機(jī)器之心的原創(chuàng)譯文,微信公眾號(hào)“機(jī)器之心( id: almosthuman2014)”】