收藏!2017年AI圈大事最全盤點 !(附視頻)

假設你在2017年昏睡了一年,忽然驚醒的時候,想要了解這個世界在今年有哪些最值得驕傲的成就,這篇文章值得你花幾十分鐘讀一讀。

這一年,谷歌發布了Google Translate的新模型,并詳細描述了網絡結構——循環神經網絡。Facebook的聊天機器人,因為失控創造了自己的語言被關閉。DeepMind 的研究員在他們的文章中展示了如何生成語音。一個已經成功超越人類的深度學習成就叫做唇語識別。

本文將帶你瀏覽2017年幾乎所有最有意義的AI研究,從文本、語音、計算機視覺到強化學習和最重要的新聞。

其中的大部分事件,文摘菌都在其發生之時做過相關報道,回憶起來,感慨萬分,我們也在相應部分附上了報道鏈接,方便查看細節。

1. 文本

1.1谷歌神經機器翻譯

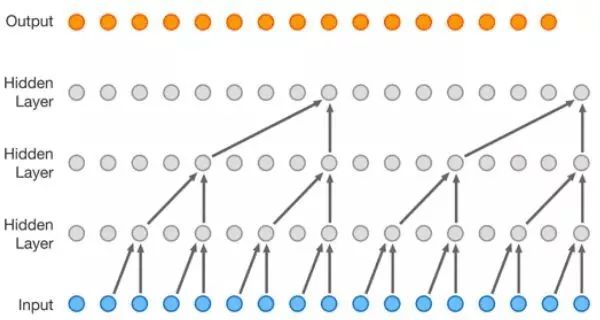

大約一年前,谷歌發布了Google Translate的新模型,并詳細描述了網絡結構——循環神經網絡。

鏈接:https://blog.statsbot.co/machine-learning-translation-96f0ed8f19e4

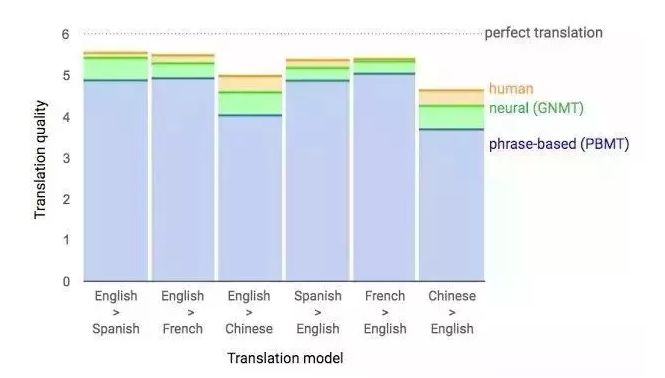

關鍵成果:與人類翻譯的準確率之差縮小了55%-85% (研究者使用6分制打分標準評估得到)。如果不依賴谷歌龐大的數據庫進行訓練,這一結果很難復現。

1.2: 談判

你可能聽過這個謠言:Facebook的聊天機器人,因失控創造自己的語言而被關閉。

該聊天機器人原本被設計用來談判,其目的是與其他機器人(代理)進行文本談判并達成協議:如何在兩個人之間分配物品(書籍和帽子等)。每一個機器人(代理)有對方不掌握的交易信息。同時,談判的設定是不達成交易就不終止。

他們收集了一個人類談判的數據庫,并訓練出了一個監督式的循環網絡。隨后,他們讓強化訓練后的機器人,通過自我對話的方式繼續訓練,直到與人類語言近似到一定程度為止。

該機器人已經學會了一種真正的談判技巧——對交易中的某些因素假裝表現出興趣,隨后僅僅通過犧牲它們來達成真正目的。

新聞里聲稱機器人發明了一種新語言,這種說法有點過于夸張。當用同一個機器人來訓練的時候,它沒有被限制必須用與人類語言,所以算法進行了一些變異,這很正常。

文章鏈接:https://blog.statsbot.co/machine-learning-translation-96f0ed8f19e4

在過去的一年里,循環網絡得到了很大的改進,并被應用于諸多領域。RNN的結構也越來越復雜,但是在某些領域,簡約前向網絡(DSSM)都取得了相似的結果。例如,在郵件智能回復方面,谷歌取得了與LSTM之前一樣的效果。另外,Yandex基于這套網絡,發布了新的搜索引擎。

2. 語音

2.1:WaveNet,一種針對音源的生成模型

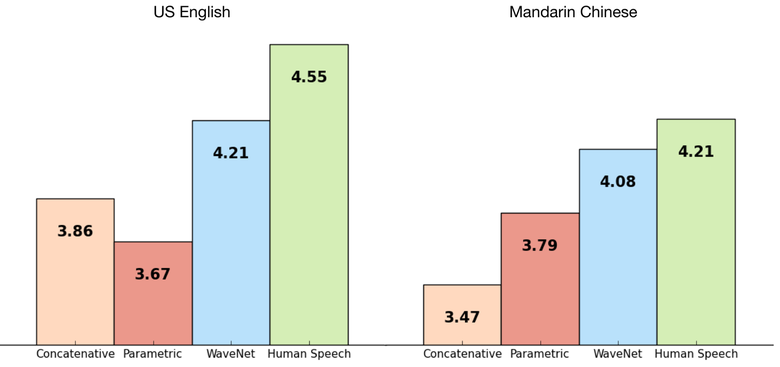

DeepMind 的研究員在他們的文章中展示了如何生成語音。簡單的說,他們基于之前生成圖像的方法,PixelRNN 和PixelCNN,創造了一個自回歸全卷積的WaveNet模型。

該網絡被以點到點的方式訓練:文本作為輸入,語音作為輸出。最終研究人員取得了極好的結果。在語音生成方面,機器人與人類的差距縮小了50%。

該網絡的主要缺陷在于效率低下。因為使用了自回歸技術,音頻是按順序生成,并且每1-2分鐘,才能生成一秒語音。

如果去掉對文字輸入的依賴,僅僅基于前期產生的語音,該網絡會產生出類似人類的語言。但這樣并沒有實際意義。

這一模型不僅僅可以用于語音生成,也可以用于音樂創作。設想,在不依賴輸入數據的情況下,僅僅被鋼琴游戲的數據庫訓練,該模型便可生成音頻。

2.2:唇語識別

唇語識別是另外一個已經成功超越人類的深度學習成就。

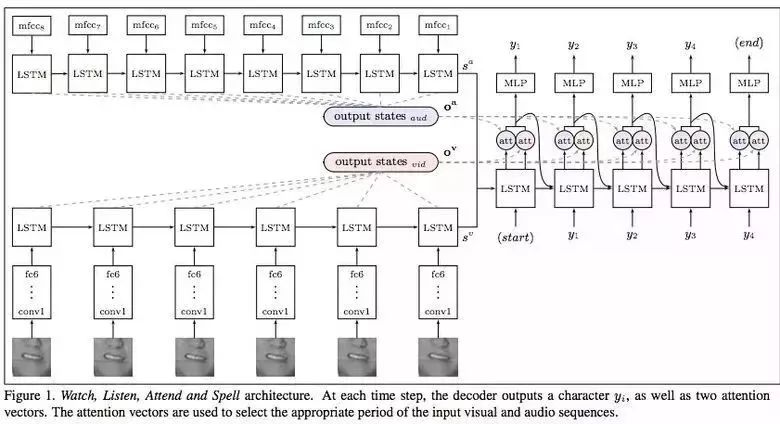

《Lip ReadingSentences in the Wild》。Google Deepmind 在這篇于牛津大學合作發表的論文中,公布了他們給予電視數據訓練的模型。該模型性能超越了BBC頻道專業的唇語閱讀員。

該數據集包括10萬條配有音頻和視頻的語句。LSTM訓練音頻,CNN+LSTM訓練視頻。最后將兩者的狀態向量作為最終LSTM模型的輸入,以產生文字輸出。

訓練中,使用不同的數據類型,包括音頻,視頻以及音頻+視頻。換句話說,這是個多渠道模型。

2.3:合成奧巴馬——從音頻中同步嘴唇動作

華盛頓大學進行了一項研究,以合成美國前總統奧巴馬的嘴唇動作。選擇他為對象的原因在于,在網絡上有大量他的視頻(17小時的高清視頻)。

他們不能過多地直接使用網絡模型輸出的合成畫面。因此,論文的作者使用了一些技巧來改善紋理的時間方面的問題。

效果如此令人震驚。也許不久的將來,即使是總統演講視頻都有可能是合成的。

3. 計算機視覺

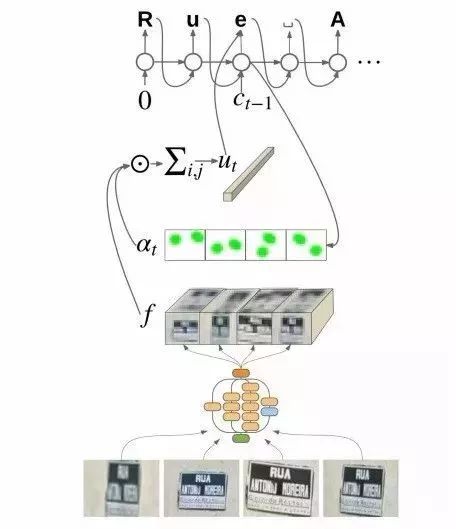

3.1:OCR——谷歌地圖和街景

谷歌大腦團隊在他們公布的文章中,介紹了他們如何將新一代OCR(光學字符識別)引擎引入谷歌地圖中,以實現街道標志和店鋪標志的自動識別。

在開發過程中,谷歌解碼了新的FSNS(法語街道名標示),有很多復雜的場景。

為了識別出每一個標志,網絡模型最多使用了標志的四張圖片。特征通過CNN提取后,經過空間變化(考慮像素坐標)再輸入到LSTM模型中。

相似的方法被用于識別布告牌中店鋪名稱的的項目。但是該項目的圖像數據有很多無關信息,網絡模型必須對焦正確的信息進行讀取。這一算法已經被應用于800億張圖片上。

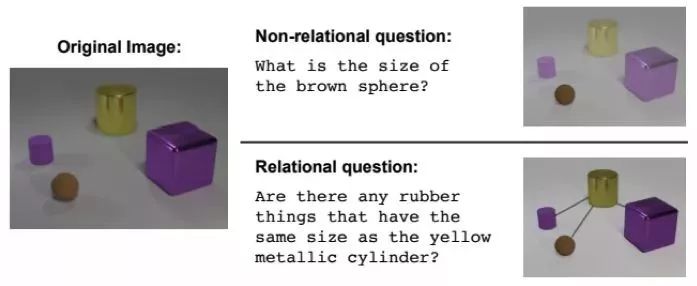

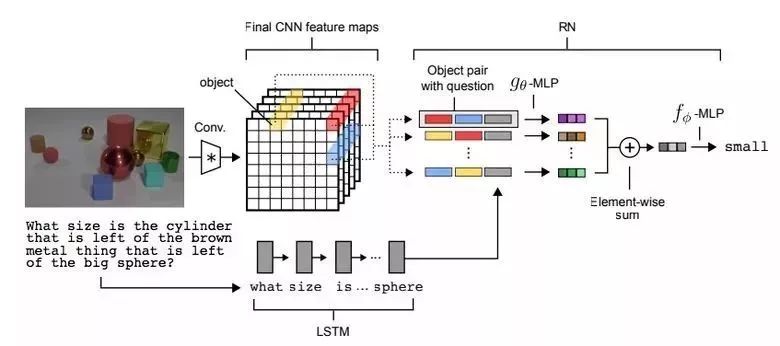

3.2:視覺推理

另一種稱做視覺推理的任務,是要讓神經網絡利用圖片中信息來回答問題。例如:圖片中有于黃色金屬圓柱體一般大的橡膠物品么?這種問題對算法來講很難,到目前為止,準確率只有68.5%。

DeepMind在這一領域取得了突破,在CLEVR數據集中,他們取得了95.5% 的超高準確率。

這一網絡模型的結構很有意思:

- 通過預訓練好的LSTM模型,從文字問題中抽象出問題。

- 使用4層的CNN模型,從圖片中得到特征圖(下圖中的黃色,藍色,和紅色部分),再加入坐標,將其與文字對應起來。

- 之后,再用另一個網絡模型處理并集成這三類特征。

- 最終,通過一個前反饋網絡中的柔性最大激活函數(softmax),將答案呈現出來。

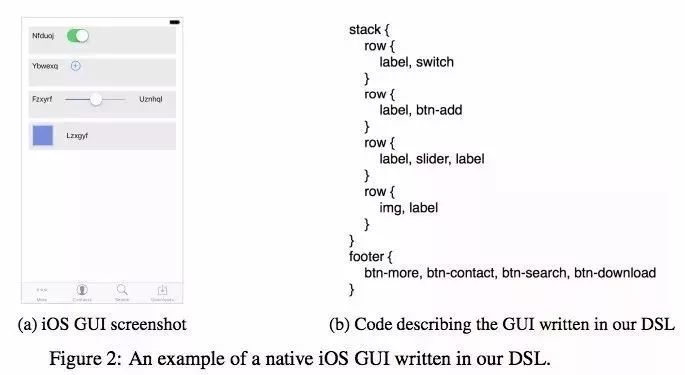

3.3:Pix2Code——用戶圖形界面代碼自動生成

Uizard(一家哥本哈根創業公司)開發了一款趣味十足的基于神經網絡的應用程序:它能夠根據界面設計師的截屏圖片生成GUI(圖形用戶界面)的布局代碼。

這是一款十分實用的神經網絡應用程序,它能夠讓軟件開發變得更加容易。開發者(作者)聲稱該應用可以達到77%的準確率。不過,這款應用程序仍處在研究階段,尚未投入實際使用。

現在暫無項目的開源代碼和數據集,但是該公司承諾未來會在網上發布。

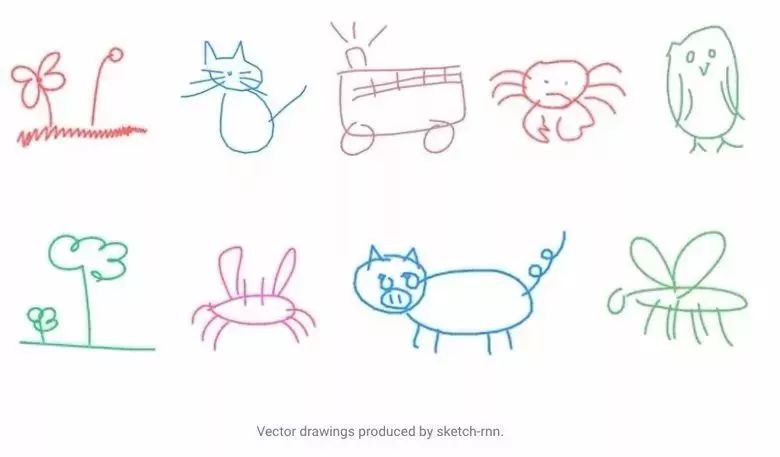

3.4:SketchRNN——教會機器如何作畫

也許你已經見識過了谷歌的“Quick,Draw!”,一款讓用戶在20秒內畫出不同物體草圖的小程序。谷歌公司收集該程序的數據集來教會神經網絡如何作畫,正如他們在博客和文章中介紹的那樣。

公司收集到的數據集中包含70000張草圖,這個數據集現已公開。草圖不是以圖片的形式表示的,而是以圖中線條的詳細的向量形式表示。

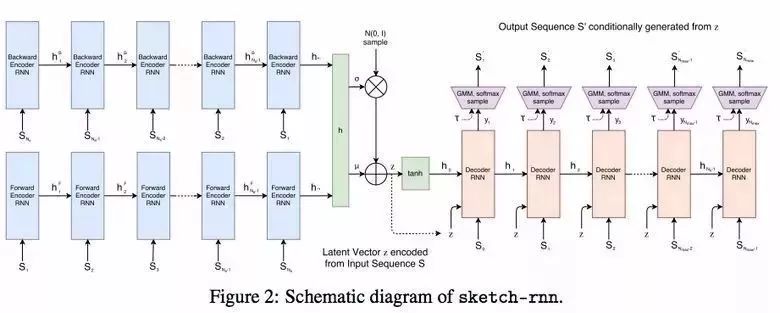

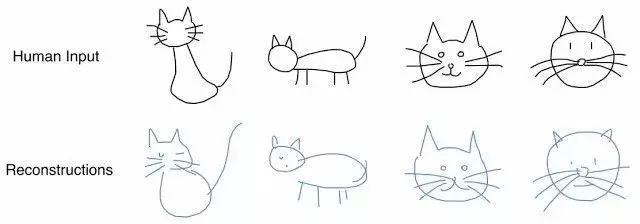

研究人員使用RNN訓練出序列到序列的變分自動編碼器來作為編碼/解碼機制。

最后,為了適應自動編碼器,模型接收描述原始圖片特征的特征向量(隱向量)作為輸入。

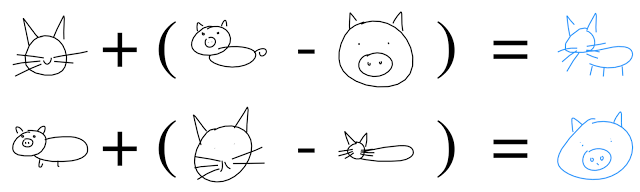

而解碼器可以從輸入的向量中提取出一個圖,并且可以通過改變輸入向量獲得新的草圖。

甚至可以通過向量運算創造出“catpig”(貓豬)的形象。

3.5:生成對抗網絡(GANS)

生成對抗網絡(GANS)是深度學習中最受關注的主題之一。多數情況下,這個網絡是用來處理圖像的。

文章鏈接:https://blog.statsbot.co/generative-adversarial-networks-gans-engine-and-applications-f96291965b47

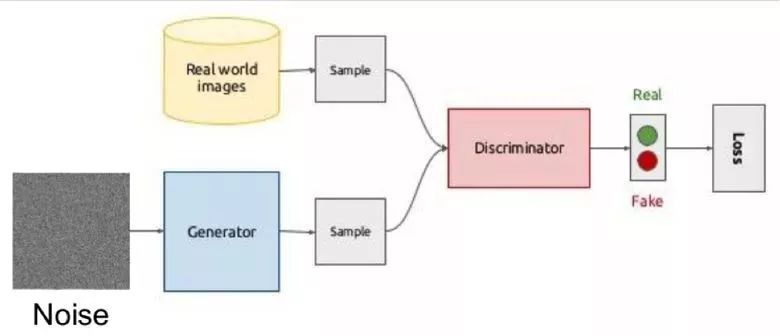

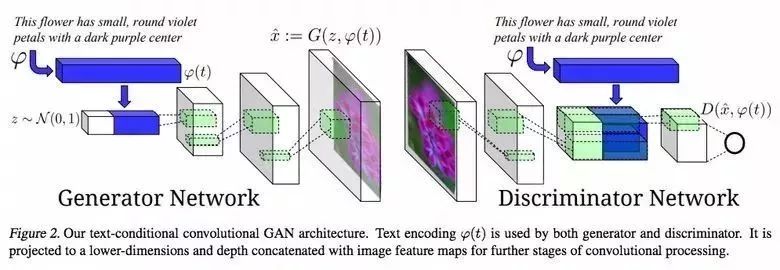

GANS的思想是兩個網絡——生成器和鑒別器——的競爭。第一個網絡生成一張圖片,第二個網絡則是試圖分辨出該圖片是真正的圖片還是生成的圖片。

GANS的示意圖如下所示:

在訓練過程中,生成器首先通過一個隨機向量(噪音)生成圖像,然后把它輸入能夠判別圖像真假的鑒別器中。來自真實世界的圖像同樣會被輸入到鑒別器中。

這樣的結構難以訓練,因為很難找到兩個網絡之間的平衡點。多數情況鑒別器獲勝然后訓練過程陷入停滯。不過,該系統的優點是可以解決鑒別器的損失函數(比如,提高照片的質量)難以設置的問題。

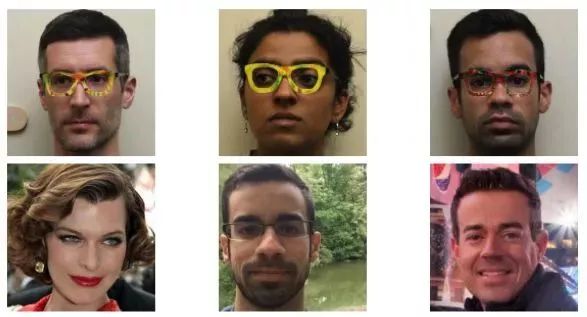

經典的GAN訓練結果樣例是臥室圖片以及人臉圖片:

先前我們討論了自動編碼(Sketch-RNN),即將原始數據編碼成一個潛在的表示形式。生成器的工作原理也是一樣的。

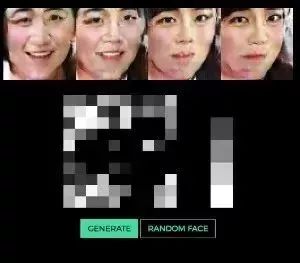

使用向量生成圖像的想法在這個項目中的人臉生成樣例中有很好的體現。你可以通過改變向量來觀察人臉是如何改變的。

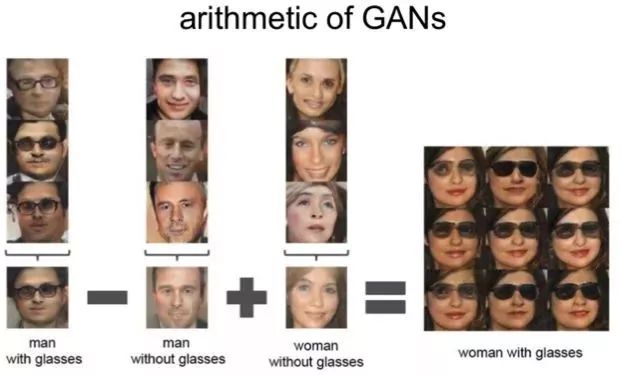

同樣的算法也適用于潛空間:

“戴眼鏡的男人”-“男人”+“女人”= “戴眼鏡的女人”

3.6:通過GANS改變臉部年齡

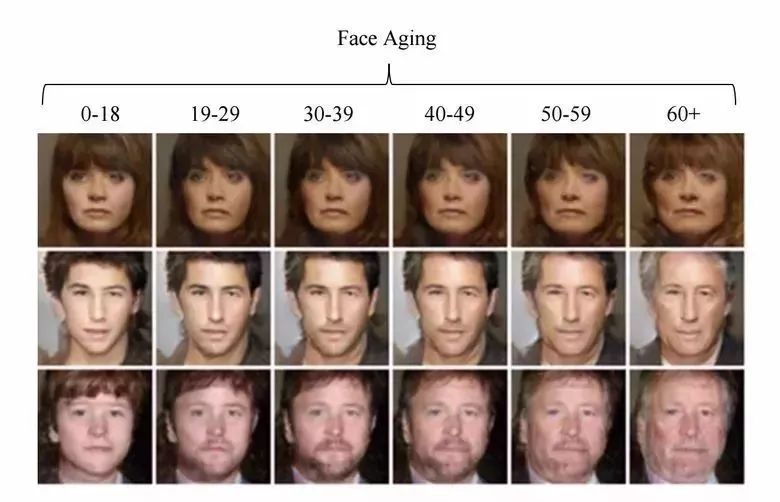

如果在訓練過程中,你賦予潛向量一個被控參數,那么當你生成該向量時,你就可以通過改變它來管理圖片中必需的圖像了。這種方法稱為條件GAN(conditional GAN)。

“Face Aging With Conditional Generative Adversarial Networks.” 的作者們就是這樣做的。通過IMDB數據集中年齡已知的演員的照片來訓練模型,研究人員們就有機會來改變他們的臉部年齡。

3.7:專業照片

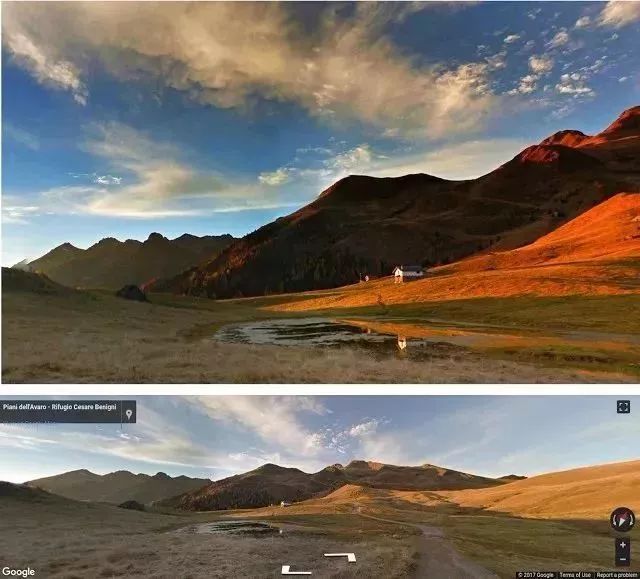

谷歌又找到了一個GAN的趣味應用——篩選并改善照片。GAN由專業圖片數據集訓練而來:生成器要改善不盡人意的照片),而鑒別器要做到區分“改善后的”照片和真實的專業照片。

訓練好的算法通過谷歌街景全景尋找最佳的構圖,同時獲得一些專業的、半專業質量的圖片。(根據攝像師的等級)

3.8:通過文本描述生成圖像

一個令人印象深刻的GANs的例子是通過文本生成圖像。

這項研究的作者提出不僅要將文本嵌入生成器(條件GAN)的輸入中,還要嵌入到鑒別器中,以便驗證文本和圖片的相關性。為了確保鑒別器能夠學習并執行預期的功能,除了正常的訓練過程,他們還添加了錯誤描述真實圖片的文本及相應圖片,并一起投入訓練。

3.9:Pix2pix

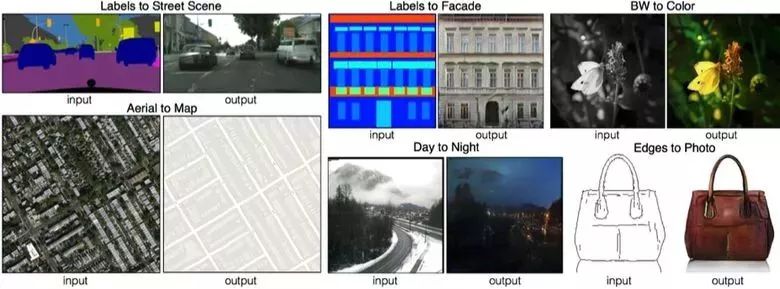

2016年度引人注目的文章之一是BAIR的“Image-to-Image Translation with Conditional AdversarialNetworks” 。研究人員解決了由圖像生成圖像的問題,比如當需要由衛星圖像生成地圖或者通過草圖繪制物體的真實紋理。

這是條件GAN的又一個出色表現的例子。在這個例子中,條件由整個圖片決定。圖像分割中的熱門技術UNet被用來作為生成器的結構,新提出的PatchGAN分類器被用來作為鑒別器以防圖像難以區分。(圖片被分割為N小塊,每一塊的真假分別預測)

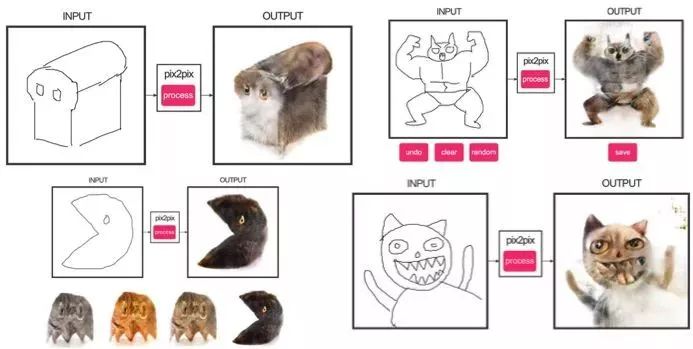

Christopher Hesse做了一個貓的演示,這個演示引起了用戶對Pix2pix的極大興趣。

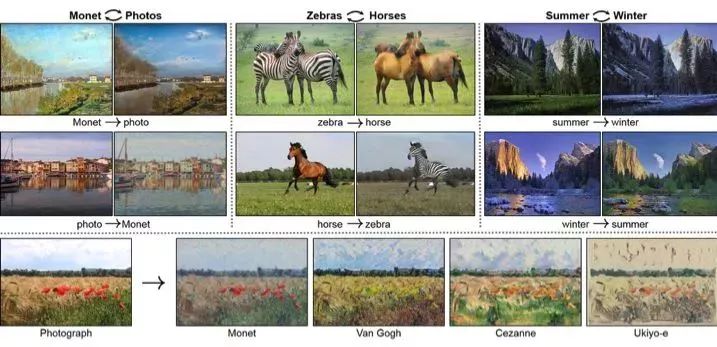

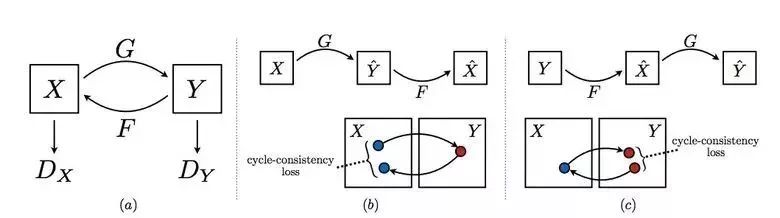

3.10:CycleGAN

為了應用Pix2pix,你需要來自不同領域的對應成對的圖片數據集。比如,在這種情況下,通過紙牌來生成這樣的數據集并不是件難事兒。然而,如果你想做些更復雜的,像“改變”圖片中的物體或圖片風格,從原則上來講這樣的數據集無法獲取。

因此,Pix2pix的作者們繼續深入思考并提出了CycleGAN來實現不同領域圖片之間的轉換而不需要明確的匹配——“Unpaired Image-to-Image Translation.”

CycleGAN的思路是訓練兩對生成器-鑒別器來把圖像從一個領域轉變到另一個領域再轉變回來,這樣的話需要保證周期一致性——在一系列的轉變之后,要得到與原始L1損失相近的圖像。周期損失則是保證生成器轉變后的圖片不會與原始圖片完全不相關。

這個方法能讓你把馬變成斑馬:

這樣的轉變并不穩定,經常會出現失敗案例:

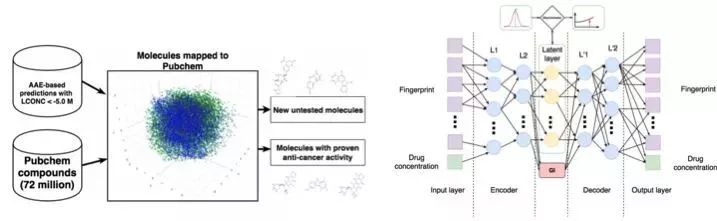

3.11:腫瘤分子的發展

機器學習同樣在醫藥領域大展身手。除了超聲波圖像、核磁共振圖像和診斷識別外,機器學習還可以用于尋找新的抗癌藥物。

我們曾經報道過該研究的詳細內容。簡單來說就是在對抗自編碼器(AEE)的幫助下,可以得到分子的潛在表示并用以尋找新的分子。基于此,已有69種新分子被發現,約有35種已經投入到對抗癌癥的使用中,其余的分子也擁有巨大潛力。

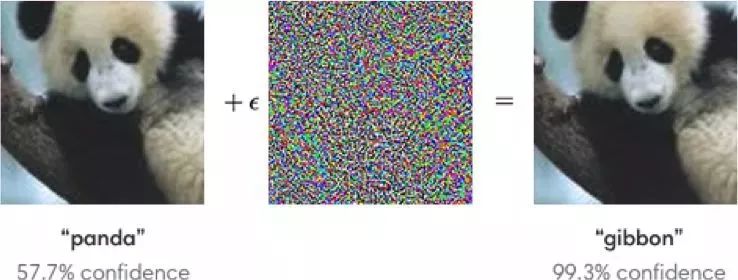

3.12:對抗性攻擊

很多學者都對對抗性攻擊這個主題展開了積極探索。什么是對抗性攻擊?舉個例子,在ImageNet上訓練得到的標準網絡在受到特殊噪聲影響的圖片上進行分類會變得十分不穩定。在下面的例子中可以看到,人眼觀察到經過噪聲影響的圖像與原始圖像相比基本沒有變化,但是模型卻出現預測錯誤的問題。

模型的穩定通過FGSM算法已經實現:通過調節模型的參數,可以朝著期望類別的方向改變一個或多個梯度步長,并且改變原始圖片。

Kaggle上的一個項目就與此相關:參賽者需要創造萬能的攻擊/防御圖片,最終決出誰是最好的。

為什么還應該研究攻擊呢?第一,如果我們想要保護自己的產品,可以在驗證碼上添加噪聲來阻止垃圾信息傳播者自動識別它們。第二,算法逐漸融入到我們的生活中——人臉識別和自動駕駛。這時候,攻擊者就可以利用算法的弱點了。

下面是一個特殊眼鏡欺騙人臉識別系統并“冒充他人”的例子。因此,在訓練模型的時候我們應該把可能遭受的攻擊納入考慮范圍內。

這樣處理后的指示牌也是無法正確識別的。

4. 強化學習

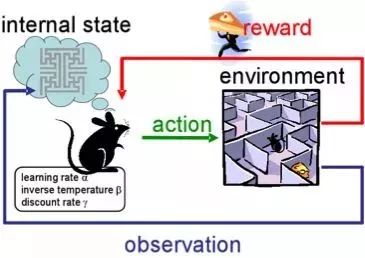

強化學習是機器學習中最有意思且最有活力的發展路徑之一。

這種路徑的核心在于學習agent的成功行為,而這基于一個通過經驗給予獎勵的環境,就和人類通過他們的生活學習一樣。

強化學習被積極應用于游戲、機器人和系統控制中(比如交通系統)

當然很多人都已經聽說“阿法狗”在比賽中戰勝了頂級的職業選手。研究人員使用“加強學習”訓練機器人,機器人通過自己的演練,來提升自己的策略。

4.1:強化訓練與不受控制的輔助任務

在過去的幾年里,DeepMind已經學會了使用深度強化學習來玩游戲,甚至比人類玩得更好。目前,算法已經學會玩更復雜的游戲,比如Doom。

大部分的注意力集中于加速學習,因為在與環境的交互作用下,agent的經驗需要在modern GPUs上進行大量訓練。

在他的博客中,Deepmind報告說,引入額外的損耗(輔助任務),比如預測幀的變化(像素控制),使agent更好地理解行為的結果,從而顯著加快學習速度。

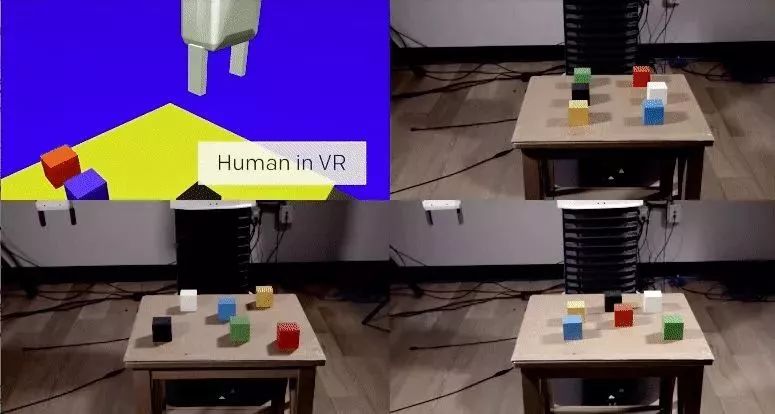

在OpenAI中,他們通過虛擬環境中的人已經積極研究出了agent的培養方式,與現實生活相比較而言,這對于實驗來說更安全。

在其中一項研究中,研究小組展示了one-shot learning的可能性:一個人在虛擬現實中展示如何執行一項特定的任務,而一個演示足以讓算法學會它,然后在實際情況下進行復制。

4.2:學習人類的偏好

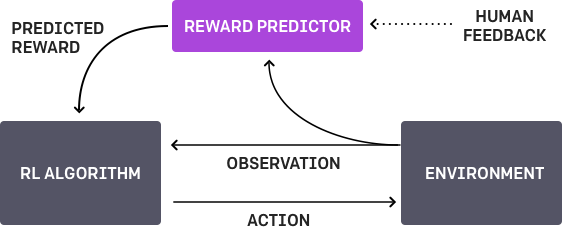

OpenAI和DeepMind都在這個問題上進行了研究探索。項目的底線是每一個agent有一個任務,該算法為人提供兩種可能的解決方案,并指出哪一個更好。這個過程迭代重復,并且從人學習如何解決這個問題的過程中得到900位反饋(二進制標記)。

在訓練過程中,有一個問題需要認真思考 - 我們正在教給機器什么。例如,計算機決定該算法真的想要獲取這個對象,但實際上,他只是模擬了這個動作。

4.3:在復雜環境中的運動

還有另一項來自DeepMind的研究。教機器人復雜的行為(行走、跳躍等),甚至做得和人類很相似。你必須大量地參與到損耗功能的選擇中,這將鼓勵期望的行為。然而,如果算法自己能通過簡單的獎勵來學習復雜行為,就更好了。

研究人員成功地做到了這一點:他們通過構建一個帶有障礙物的復雜環境以及用簡單的獎勵來教agent(身體模擬器)完成復雜的動作,促進運動的進展。

通過視頻你可以看到機器人已經做得很好了。

5. 其它

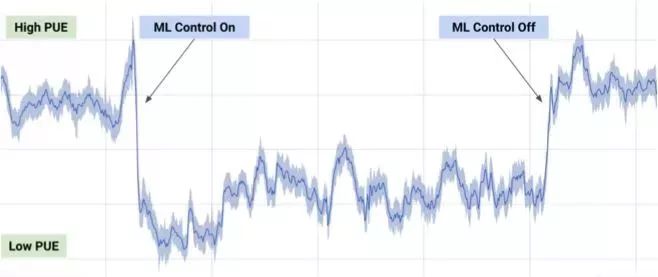

5.1:冷卻數據中心

在2017年7月,谷歌宣稱他們利用Deep Mind在機器學習開發中的優勢成果,來減少其數據中心的能源損耗。

基于來自數據中心的上千個傳感器所傳遞的信息,谷歌的開發人員編寫了一個模型來預測PUE(能源使用效率)以及更高效的數據中心管理模式。該項目意義深遠。

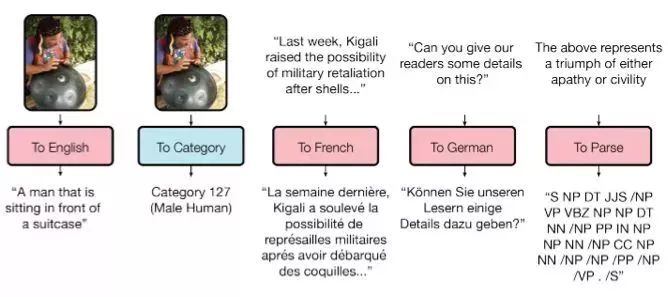

5.2:全能模型

訓練模型在任務與任務間的轉換很差,每一個任務都需要特定的模型加以對應,在一篇題為“萬能模型”的文章中提到,谷歌大腦的模型在適用的普遍性上已小有成就。

論文鏈接:https://arxiv.org/abs/1706.05137

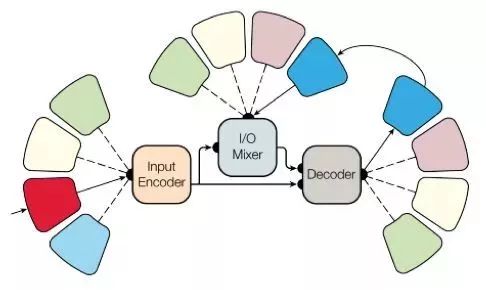

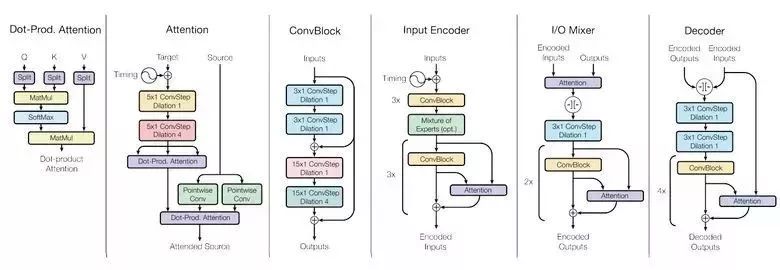

研究人員已經編寫了一個可以在不同領域(文本、語音和圖像)執行8個任務的模型。例如,翻譯不同的語言,文本解析,圖像和聲音識別。

為了實現這一點他們搭建了一個復雜的網絡架構,并利用不同的模塊處理輸入的數據和生成的結果。編碼與解碼的模塊主要有三種類型:卷積、attention、混合專家系統。

主要成果:獲得了近乎完美的模型(作者沒有對超參數進行微調)。

不同領域間的知識轉換,也就是說,在擁有充分數據的項目預測中,模型表現很穩定。

不同任務所需要的模塊之間不僅不會相互干擾而且還會彼此增益,比如MoE用于 Imagenet 任務。

順便說一下,這個模型存出現于T2T之中……

5.3:一小時學習Imagenet

在他們的帖子里,Facebook的工作人員告訴我們,他們的工程師們僅用一個小時內就能在Imagenet上教授resnet - 50模型。這需要256個gpu(特斯拉P100)的集群。

他們使用Gloo和caffe2來進行分布式學習。為了使過程有效,必須要大量的整學習策略 (8192個元素):梯度平均、預熱階段、特殊學習速率等。

因此,當從8擴展到256 GPU時,可以達到90%的效率。現在,來自Facebook的研究人員可以更快進行實驗。

6. 新聞

6.1:自動駕駛汽車

自動駕駛汽車領域正在快速發展,也進入了積極的測試階段。最近行業內的大事件主要有Intel MobilEye的收購,Uber和谷歌前雇員盜取技術的丑聞,使用自動駕駛儀造成的第一起死亡事故。

谷歌Waymo正在推出一個beta程序。谷歌是該領域的先驅,技術廣受認可,他們的汽車已經累計行駛了超過300萬英里。

最近美國各州已經允許自動駕駛汽車運行上路了

6.2:醫療保健

機械學習正在被引入醫學。例如,谷歌與醫療中心合作幫助病患診斷。

Deepmind甚至建立了一個獨立的業務單元。

今年,在“Data Science Bowl”的項目下,舉辦了一項獎金為100萬美元競賽,競賽內容是以高清圖像為基礎,對肺癌一年內的發病率進行預測。

6.3:投資

就像之前大量資本進入大數據產業一樣,機器學習也在投資界受到熱捧。

中國在人工智能領域投資1500億美元,成為該領域的先驅。

我們看一組對比數據。百度研究院雇傭了1300人,在同領域臉書只雇了80個。

學習“機器學習”永遠不會算太晚。無論如何,隨著時間的推移,所有開發人員都將使用機器學習,這將成為一項通用技能,就像今天大家都會使用數據庫一樣。

原文鏈接:https://blog.statsbot.co/deep-learning-achievements-4c563e034257