企業界遲遲未采用深度學習的四大原因

譯文【51CTO.com快譯】在過去的幾年里,許多公司獲得了采用數據驅動型方法帶來的好處。數據2.0戰略將由新的人工智能技術驅動,比如深度學習、強化學習和貝葉斯機器學習。

深度學習是***進的人工智能方法,涉及機器翻譯、計算機視覺和自然語言處理。不使用這些技術會影響收入,并限制最終用戶的體驗。

使用深度學習的方法可全面解決問題。換句話說,我們讓算法而不是人類來決定什么是解決問題的要點。這種方法簡化了系統,并讓數據可以做決策。更重要的是,它***限度地減小了人類帶來自身偏見的可能性。

1. 深度學習很深奧,要招聘合適的人員。

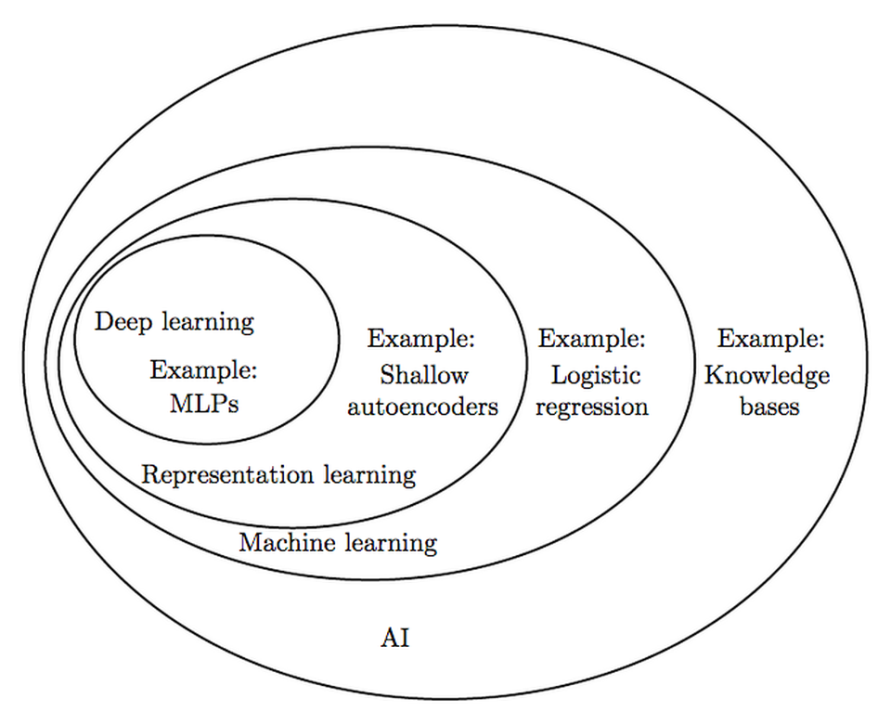

深度學習是人工智能這個更廣泛的領域的分支。

深度學習是個龐大的研究領域。如今許多公司使用的機器學習大多可能基于廣為人知、較為悠久的算法,這些算法可使用scikit-learn之類的開源工具輕松構建。然而,深度學習還沒有達到那么成熟的地步。谷歌員工François Chollet開發的Keras、Facebook的PyTorch和谷歌開發的Tensorflow,諸如此類的工具已讓深度學習更普及開來。

雖然讓簡單的深度學習例子切實有用比較容易,但改變行業規則的重大結果卻需要我們所說的“魔法”。深度學習的秘訣在于,***進的結果需要大量的計算資源、深入了解訓練技巧以及特別熟悉某種特定的方法。

解決辦法:招聘構建過深度學習系統,而不是只會復制粘貼的研究人員。這些人不需要都有博士學位,一些***的機器學習研究人員連大學學位都沒有。

2. 可解釋性重要嗎?

深度學習中的可解釋性是指明白為什么系統做出某個決策。這是人工智能界的一個熱門話題,具體歸結為企業的使用場景和風險容忍度。對于制藥公司來說,明白算法為什么做出可影響我們生活的決策是個好想法。對于客戶流失預測來說,如果系統能大大降低流失率,可解釋性可能不是很重要。

正如Facebook的人工智能研究主任Yann LeCun在《人工智能大辯論》中所說:“如果你向一家公司展示兩個系統,一個是表現還行的可解釋的簡單系統,另一個是表現更好的較復雜系統,公司每次都會選擇后者,每次都是如此。”

我在自己的工作和研究中經常聽到的就是所謂的“黑盒子謬誤”(black box fallacy)。數據科學家常常將神經網絡稱為無法理解的黑盒子。雖然解釋結果不如更傳統的方法那么清楚,但是我們開發出了許多方法來探究這些網絡的內部。這應該不會阻止公司采用深度學習。

解決辦法:確定可解釋性在貴公司帶來的實際影響。另外構建簡單的模型,以便有一個基準。如果你的深度學習方法好得多,它可能會提供更引人入勝的商業理由。

3. 你需要更多的數據和GPU。

數據和計算能力是當今深度學習切實可行的兩大原因。GPU將計算時間從幾星期縮短到幾小時。TPU的速度更快。要是沒有這些GPU,你不可能足夠快地訓練這些模型、獲得顯著成效。貴公司可以自行購買GPU,也可以向亞馬遜網絡服務(AWS)或谷歌云等提供商租用。

深度學習方法需要大量數據才能發現不太明顯的模式。如果沒有足夠的數據,這些系統注定會失敗,或者給人以一種性能良好的假象(即:過度擬合)。

解決辦法:收集你所有產品的原始信號。別害怕在GPU上花錢。

4. 人工智能戰略的目標不夠遠大

為什么深度學習因大數據而變得更有意義?

手動特征工程是指人類選擇對算法來說很重要的東西。由于這個環節牽涉人類,這些系統的性能受制于人類的創造力。一種更好的方法是,使用來自貝葉斯機器學習的技術將人類的直覺添加到系統中。

數據科學團隊認為深度學習對于大多數問題而言大材小用。雖然神經網絡無法解決所有問題,但它們是***進的方法,涉及計算機視覺、音頻和自然語言處理。這種思維人為地限制了系統的性能。如果你知道汽車比馬快,為什么還要繼續騎馬?

解決辦法:使用較悠久的機器學習方法構建強大的基準。如果深度學習能超過這個基準,就使用深度學習。這讓你得以量化這些技術相對于更簡單的方法所提供的價值。

結束語

深度學習已離開了學術界,準備改變公司企業。別害怕負責任地使用深度學習。不正確的采用會導致數據出現偏差,因而會損害貴公司和最終用戶。深度學習有助于將人類從機器學習這條環中解放出來,***限度地減小系統出現偏差的可能性。構建任何機器學習系統時,始終恪守倫理道德很重要。

原文標題:4 Reasons Why Companies Struggle To Adopt Deep Learning,作者:William Falcon

【51CTO譯稿,合作站點轉載請注明原文譯者和出處為51CTO.com】