前沿科技分享:把腦信號譯成語音 AI算法讓有望讓失語人士正常發聲

在近期發表在“自然”雜志上的一項研究中,加利福尼亞大學舊金山分校的神經科學家團隊介紹了一種神經解碼器,可以根據大腦活動合成自然發聲的語音。

這項研究由演講科學家Gopala Anumanchipalli和Chang實驗室的生物工程研究生Josh Chartier領導。它正在加利福尼亞大學神經外科教授Edward Chang的實驗室中開發。

為什么要引入這種神經解碼器?

由于中風,創傷性腦損傷或神經退行性疾病(如帕金森病,多發性硬化癥和肌萎縮側索硬化癥),讓許多人喪失語言能力

目前,跟蹤非常小的眼睛或面部肌肉運動的輔助設備使得嚴重語言障礙的人能夠通過逐字逐句地表達他們的想法。然而,用這樣的設備生成文本或合成語音通常是耗時,費力且容易出錯的。這些設備的另一個限制是它們只允許每分鐘產生最多10個字。

這項研究表明,有可能生成一個人的聲音的合成版本,可以通過他們的大腦活動來控制。研究人員相信,將來,這種裝置可用于使嚴重言語障礙的人能夠進行流暢的溝通。它甚至可以再現人類聲音的一些“音樂性”,表達說話者的情感和個性。

“這項研究表明,我們可以根據個人的大腦活動生成完整的口語句子,”Chang說。 “這是一個令人振奮的原理證據,即已經觸手可及的技術,我們應該能夠構建一種在語言丟失患者中具有臨床可行性的設備。”

這個系統如何運作?

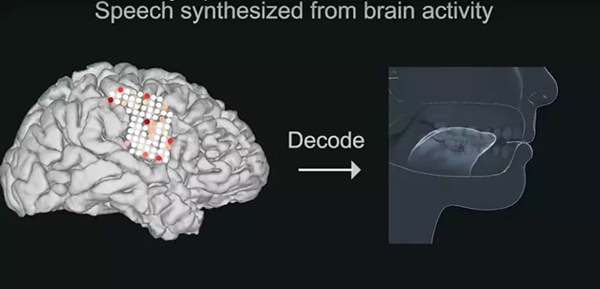

這項研究是基于Josh Chartier和Gopala K. Anumanchipalli的另一項研究,該研究展示了我們大腦中的語音中心如何編排嘴唇,下巴,舌頭和其他聲道組件的運動以產生流暢的語音。

在這項新的研究中,Anumanchipalli和Chartier要求5名患者大聲朗讀幾個句子。這些患者將電極植入他們的大腦中以繪制他們病情發作的來源以準備神經外科手術。同時,研究人員記錄了已知涉及語言生成的大腦區域的活動。

研究人員使用志愿者聲音的錄音來理解產生這些聲音所需的聲道運動。通過這個詳細的聲音解剖圖譜,科學家們為每個志愿者創造了一個真實的虛擬聲道,可以通過他們的大腦活動來控制。

該系統由兩個神經網絡組成:

- 解碼器,用于將語音期間產生的大腦活動模式轉換為虛擬聲道的運動。

- 一種合成器,用于將這些聲道運動轉換為志愿者聲音的合成近似值。

研究人員觀察到,與直接從志愿者的大腦活動中解碼的合成語音相比,該系統產生的合成語音要好得多。

該系統仍處于早期階段。 Chartier解釋了它的局限性,他說:“我們仍然有辦法完全模仿口語。 我們非常擅長合成較慢的語音,如“sh”和“z”,以及保持語音的節奏和語調以及說話者的性別和身份,但是一些更突然的聲音,如'b'和'p'得到了 有點模糊。 盡管如此,與目前可用的相比,我們在這里制作的準確度水平將是實時通信的驚人改進。“