游戲 AI 挑戰(zhàn)進(jìn)階,即時(shí)策略游戲和非完美信息游戲成為熱點(diǎn)

在前面兩篇文章中,我們回顧了游戲 AI 歷史上的幾個(gè)經(jīng)典算法和里程碑事件,還介紹了如何從數(shù)學(xué)角度衡量象棋、圍棋、撲克、麻將等棋牌類游戲 AI 的復(fù)雜度。在這篇文章里,我們將分享幾個(gè)近年來非常成功的游戲 AI,同時(shí)介紹幾個(gè)尚未被 AI 攻克的流行游戲,它們無疑代表著未來游戲 AI 的發(fā)展方向和趨勢。

達(dá)到或超過人類水平的游戲 AI

多人德州撲克:Pluribus

不同于國際象棋和圍棋,德州撲克作為一個(gè)不完美信息游戲,有著不同的挑戰(zhàn):玩家看不見彼此的牌,并且玩家往往會利用這種不對稱進(jìn)行詐唬(Bluff),從而誤導(dǎo)對手。AlphaGo/AlphaZero 等適用于完美信息游戲的算法無法在撲克中直接使用。在 AI 領(lǐng)域,德州撲克仍然被視為尚未被攻克的挑戰(zhàn)。

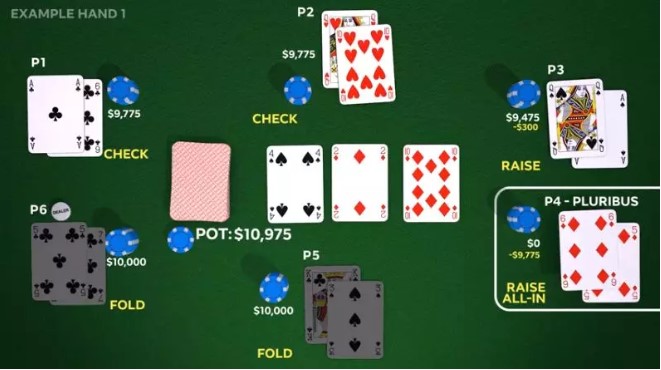

最近由 CMU 聯(lián)合 Facebook 開發(fā)的 Pluribus,在六人不限注德州撲克中戰(zhàn)勝了人類玩家。這些人類玩家都是曾經(jīng)贏下超過百萬美金的職業(yè)選手,Pluribus 在12天之內(nèi)和這些人類玩家進(jìn)行了超過10,000次對局,并最終取得勝利。

Pluribus 的訓(xùn)練并未借助人類牌譜,而是從零開始,通過與6個(gè)自己的副本進(jìn)行對戰(zhàn),不斷提高自己的性能。在自我對局中,Pluribus 通過基于 MCCFR(Monte Carlo CFR)算法搜索和學(xué)習(xí)更好的打牌技巧,并將不同的自我對局結(jié)果稱之為藍(lán)圖(Blueprint)策略。由于不限注德州撲克的狀態(tài)空間過大,該藍(lán)圖策略只能涉及到有限的策略空間,因此在實(shí)際對戰(zhàn)中, Pluribus 會采用藍(lán)圖策略做初步?jīng)Q策;并在之后的對局中,通過往前搜索有限的幾步來做進(jìn)一步細(xì)化的決策。Pluribus 的主要開發(fā)者 Noam Brown 相信,Pluribus 的一些策略將會改變職業(yè)玩家的打法。

但是,盡管德州撲克屬于非完美信息游戲,給定任何局面,每個(gè)對手可能的隱藏狀態(tài)數(shù)目只有一千多種(從50張牌中選擇2張)。不管是 Pluribus,還是另一個(gè)非常成功的撲克 AI DeepStack 的算法,都非常依賴于對手牌的概率分布的估計(jì)來做細(xì)粒度搜索,其實(shí)現(xiàn)難度相對可控。而這些近似算法在隱藏狀態(tài)數(shù)目大得多的游戲中(比如橋牌和麻將),是很難適用的。

圖1:Pluribus在和五個(gè)職業(yè)玩家的對戰(zhàn)中做了一個(gè)詐唬

星際爭霸2:AlphaStar

AlphaStar 是由 DeepMind 聯(lián)合暴雪開發(fā)的「星際爭霸2」游戲 AI,其在2019年1月戰(zhàn)勝了頂尖的職業(yè)玩家。

「星際爭霸」是一款多人即時(shí)戰(zhàn)略游戲,常見的1v1對戰(zhàn)模式中,每個(gè)玩家會從三個(gè)種族中選擇一個(gè),在不同的地圖上進(jìn)行對戰(zhàn)。游戲開始時(shí),每個(gè)玩家會分配一些初始單位,基于這些單位,玩家需要從地圖上獲取可發(fā)展資源,并利用這些資源建造更多的單位和科技。游戲的目標(biāo)是通過運(yùn)營資源,制造軍隊(duì),從而摧毀對方所有的單位。

星際爭霸玩家需要同時(shí)考慮宏觀規(guī)劃和微觀操作,游戲的時(shí)間可以長達(dá)一個(gè)小時(shí),這意味著 AI 的策略需要有長期規(guī)劃的能力。且不同于傳統(tǒng)的棋牌游戲,星際玩家需要在短時(shí)間內(nèi)連續(xù)地操作分布于不同地區(qū)的多個(gè)單位。此外,星際爭霸也是一個(gè)不完美信息游戲,初始的地圖上彌漫著一層「戰(zhàn)爭迷霧」,使得對方的信息不可見,因此玩家需要不斷地試探對方的位置,并作出相應(yīng)的應(yīng)對操作。

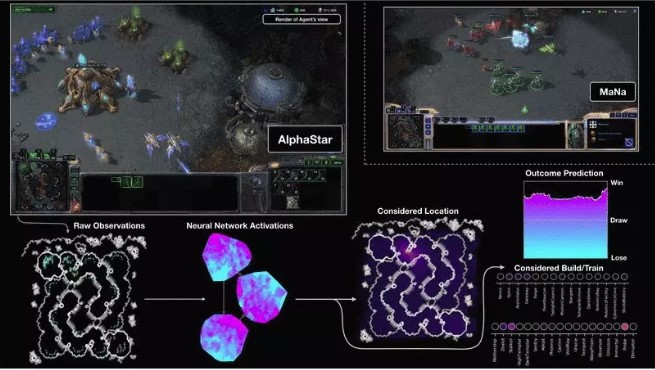

AlphaStar 使用深度神經(jīng)網(wǎng)絡(luò)接收由暴雪提供的游戲內(nèi)部信息,然后輸出一系列指令來指導(dǎo) AI 做出行為選擇。該智能體首先通過學(xué)習(xí)人類玩家的對戰(zhàn)模式,然后通過多智能體(multi-agent)強(qiáng)化學(xué)習(xí)算法來進(jìn)一步提高性能。AlphaStar 的網(wǎng)絡(luò)結(jié)構(gòu)結(jié)合了Transformer、LSTM、Auto-Regressive policy head、指針網(wǎng)絡(luò)(pointer network)以及中心化評分基準(zhǔn)(centralized value baseline)。

在監(jiān)督學(xué)習(xí)之后,AlphaStar 創(chuàng)建了一個(gè)可以讓 AI 之間自我學(xué)習(xí)的聯(lián)賽機(jī)制,通過基于人口理論的強(qiáng)化學(xué)習(xí)算法,使得 AI 可以在保持足夠的多樣性的前提下,能夠不斷地變得強(qiáng)大。由于星際爭霸2中不同的策略和種族有一些相生相克的關(guān)系,該訓(xùn)練方式使得 AI 能夠朝著綜合實(shí)力更強(qiáng)的方向進(jìn)行訓(xùn)練。

AlphaStar 無疑是非常成功的,但是也有很多人持有不同的看法,在和人類的較量中,AlphaStar 仍然存在策略之外的不對等:AI 可以在極短的時(shí)間內(nèi),高細(xì)粒度地操控上百個(gè)不同的個(gè)體,進(jìn)行不同的任務(wù)。這種短時(shí)間內(nèi)的高細(xì)粒度、多任務(wù)的操控,與人類玩家相比,有著巨大的優(yōu)勢。此外,AlphaStar 只在特定地圖上訓(xùn)練了特定的種族,仍然可能有短板。

AlphaStar 開發(fā)團(tuán)隊(duì)希望他們的模型可以對其他任務(wù)有所幫助,尤其是需要對長序列進(jìn)行建模,并且有很大的輸出空間的任務(wù),比如機(jī)器翻譯、語言模型和視覺表達(dá)等。

圖2:AlphaStar 和 MaNa(頂級人類玩家)對戰(zhàn)的可視化。圖中展示了 AI 眼中的游戲:包括輸入到神經(jīng)網(wǎng)絡(luò)的原始信息,神經(jīng)網(wǎng)絡(luò)的內(nèi)部激活單元,一些備選的動作以及輸贏的概率等。

Dota2:OpenAI Five

Dota2 也是一款需要多人參與的即時(shí)戰(zhàn)略游戲(MOBA),比賽由兩個(gè)隊(duì)伍進(jìn)行對戰(zhàn),每個(gè)團(tuán)隊(duì)由五位「英雄」組成,這些英雄往往有著不同的特色和各自的職責(zé),因此,團(tuán)隊(duì)的獲勝依賴于不同職責(zé)的選手們之間的分工合作,是一款非常強(qiáng)調(diào)團(tuán)隊(duì)協(xié)作的游戲。和星際爭霸類似,Dota2 也是非完美信息游戲,玩家們需要搶占地圖上的不同資源和視野,最終打倒對方隊(duì)伍的核心建筑。

不同于 AlphaStar,Dota2 的訓(xùn)練則完全從自我對戰(zhàn)中進(jìn)行學(xué)習(xí),通過近端策略優(yōu)化(Proximal Policy Optimization)來更新它們的神經(jīng)網(wǎng)絡(luò)。很多研究員認(rèn)為,要想解決 Dota 中的長期規(guī)劃問題,需要類似分層強(qiáng)化學(xué)習(xí)這樣的技術(shù)來分別處理長期和短期的規(guī)劃。但他們驚喜地發(fā)現(xiàn),僅僅通過強(qiáng)化學(xué)習(xí)訓(xùn)練的策略也會擁有長期規(guī)劃的能力。

OpenAI Five 用五個(gè)神經(jīng)網(wǎng)絡(luò)代表五位“英雄”。五位“英雄”的神經(jīng)網(wǎng)絡(luò)之間并沒有顯式的連接,而是通過控制自己和團(tuán)隊(duì)的獎勵(reward)的權(quán)重來學(xué)習(xí)協(xié)作。

2019年4月,OpenAI Five 在三局兩勝制的比賽中,以2-0的分?jǐn)?shù)戰(zhàn)勝了 Dota2 世界冠軍 OG 俱樂部。但隨著 OpenAI Five 的策略被進(jìn)一步地分析,網(wǎng)友們也找到了OpenAI Five 的弱點(diǎn)——擅長團(tuán)隊(duì)作戰(zhàn)卻不擅長分推,并根據(jù)弱點(diǎn)定制戰(zhàn)術(shù),戰(zhàn)勝了OpenAI Five.

游戲 AI 的下一輪挑戰(zhàn):橋牌和麻將

在以上游戲中,AI 均可以達(dá)到或者超過頂尖人類玩家的水平。而擁有廣泛群眾基礎(chǔ)的橋牌和麻將,因?yàn)橛兄T多不同的屬性,現(xiàn)有的算法并不能很好地處理。毋庸置疑,它們將會是游戲 AI 的下一輪挑戰(zhàn)目標(biāo)。

橋牌

橋牌是非完美信息4人游戲,在游戲的開始,玩家只能看見自己的手牌。橋牌分為叫牌、打牌兩個(gè)步驟。

不同于德州撲克,橋牌擁有大得多的隱藏信息,尤其是在叫牌和打牌的初期階段。計(jì)算機(jī)非常擅長在完全信息下做搜索,但人類玩家更擅長在非完美信息下進(jìn)行推理和決策,而這恰恰是計(jì)算機(jī)不擅長的。此外,橋牌中4個(gè)玩家之間既有競爭又有合作,玩家在兩兩合作的同時(shí),不僅需要估計(jì)對手的信息,還需要估計(jì)隊(duì)友的信息。

現(xiàn)在的橋牌算法會隨機(jī)生成很多次符合當(dāng)前局面的對手手牌,然后使用雙明手算法(double-dummy-solver)估算出牌方式,最終選擇所有抽樣手牌中綜合性能好的出牌。這樣的算法非常依賴于隨機(jī)生成手牌的數(shù)量和質(zhì)量,以及雙明手算法的性能。在游戲快結(jié)束的時(shí)候,因?yàn)殡[藏的手牌不多,通過抽樣做搜索的算法可能會更加有效。

從1997年開始,每年都有世界計(jì)算機(jī)橋牌大賽,但是至今仍然沒有一個(gè) AI 可以戰(zhàn)勝頂級的人類玩家。

麻將

麻將也是一個(gè)多人非完美信息博弈游戲,在世界各地,尤其是亞洲有著廣泛的群眾基礎(chǔ)。

常見的麻將由4位玩家組成,每個(gè)玩家可以有13張私有手牌。類似于圍棋,麻將有著巨大的狀態(tài)復(fù)雜度。和德州撲克相比,麻將在任一局面下,每個(gè)對手的隱藏狀態(tài)數(shù)要大出十幾個(gè)數(shù)量級,這種不確定性讓玩家很難估計(jì)對手的狀態(tài)。人類玩家在游戲的過程中,會根據(jù)“直覺”估算對手的一些影響自己決策的信息,比如聽牌狀態(tài)、聽牌分?jǐn)?shù)等;而對于自己的手牌部分,往往對能夠拿到什么分?jǐn)?shù)做了精確的搜索。如何平衡模糊估計(jì)和精確搜索,對 AI 來說是一個(gè)巨大的挑戰(zhàn)。

不同于德州撲克和橋牌,麻將玩家在出牌前,需要從底牌中隨機(jī)抽出一張牌替換丟掉的這張手牌。因?yàn)檫@張隨機(jī)抽取的底牌,麻將的強(qiáng)隨機(jī)性貫穿游戲的始終,并將深刻地改變游戲的結(jié)果。舉個(gè)例子,如果有兩位玩家同時(shí)聽相同的牌,最終誰是贏家,主要取決于運(yùn)氣。

麻將的強(qiáng)隨機(jī)性將使 AI 的學(xué)習(xí)效率成為一種挑戰(zhàn)。假如我們想知道:“玩家打贏了,是因?yàn)榇虻煤眠€是運(yùn)氣好?”,要想得到這個(gè)答案,我們通常需要進(jìn)行大量的游戲來衡量。如何在強(qiáng)隨機(jī)性的環(huán)境中更高效地進(jìn)行自我學(xué)習(xí),是 AI 需要解決的一個(gè)難題。

同時(shí),由于麻將游戲強(qiáng)大的隨機(jī)性,如何衡量麻將 AI 的水平也是一個(gè)挑戰(zhàn)。

小結(jié)

為了解決這些新的挑戰(zhàn),未來,游戲 AI 需要具備在大量隱藏狀態(tài)下進(jìn)行推理決策、高效學(xué)習(xí)的能力,也需要更強(qiáng)大的應(yīng)對隨機(jī)事件能力和協(xié)作能力。我們期待游戲 AI 技術(shù)能夠在這些充滿挑戰(zhàn)的游戲中不斷突破,同時(shí)將從游戲中學(xué)到的經(jīng)驗(yàn)和能力應(yīng)用在真實(shí)世界中,幫助人類更出色地完成各種復(fù)雜任務(wù)。