PhegData核心原力:RDMA的躍進之力

為了解決爆炸式增長的數據存儲和讀取效率問題,尤其是當前應用無論存儲延遲還是高吞吐都有很高要求,傳統架構已很難滿足需求。利用分布式存儲實現多節點橫向空間擴展、多節點性能高并發訪問越來越受到歡迎。

但也帶來了因為節點間數據交互導致存儲網絡繁忙,一旦因擁塞造成丟包,將會引發IO請求重傳,不僅降低效率,還會加重擁塞。同時傳統的網絡協議棧(如TCP/IP)并不是針對高性能應用場景設計的,因此難以提供高效的通信支持,系統調用和內存復制等操作都會帶來巨大的性能開銷。

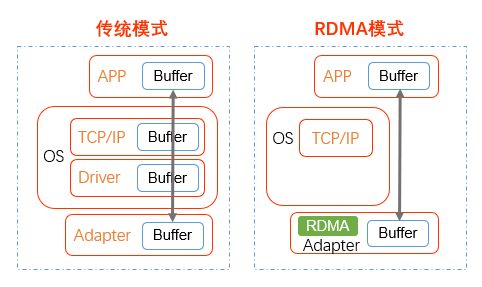

為了降低網絡延遲,提高處理效率,RDMA技術應運而生,通過允許用戶態的應用程序直接讀取和寫入遠程內存,而無需CPU介入多次拷貝內存,并可繞過內核直接向網卡寫數據,實現了高吞吐量、超低時延和低CPU開銷的效果。

RDMA是一種通過網絡把數據直接傳入另一臺計算機內存區域的技術,其很少占用CPU資源,不需要進行內存復制,基本可以不需要內核介入數據傳輸過程。這種數據傳輸方式可以提供低延時,高帶寬和低CPU使用率,最大化的利用網絡設備本身的資源,避免各種協議棧的開銷,其作為NVMe over Fabric的傳輸網絡非常合適。

RDMA(RemoteDirect Memory Access)技術全稱遠程直接內存訪問,就是為了解決網絡傳輸中服務器端數據處理的延遲而產生的。

它將數據直接從一臺計算機的內存傳輸到另一臺計算機,無需雙方操作系統的介入。這允許高吞吐、低延遲的網絡通信,尤其適合在大規模并行計算機集群中使用。

RDMA通過網絡把資料直接傳入計算機的存儲區,將數據從一個系統快速移動到遠程系統存儲器中,而不對操作系統造成任何影響,這樣就不需要用到多少計算機的處理能力。它消除了外部存儲器復制和上下文切換的開銷,因而能解放內存帶寬和CPU周期用于改進應用系統性能。

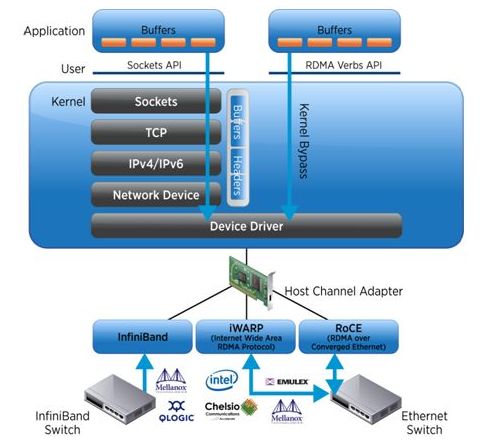

目前,大致有三類RDMA網絡,分別是Infiniband、RoCE、iWARP。

其中,Infiniband是一種專為RDMA設計的網絡,從硬件級別保證可靠傳輸 。而RoCE 和 iWARP都是基于以太網的RDMA技術,支持相應的verbs接口。在Ethernet以太網上,根據協議棧融合度的差異,分為iWARP和RoCE兩種技術,而RoCE又包括RoCEv1和RoCEv2兩個版本(RoCEv2的最大改進是支持IP路由),各RDMA網絡協議棧的對比如下圖所示:

Infiniband,支持RDMA的新一代網絡協議。由于這是一種新的網絡技術,因此需要支持該技術的Infiniband網卡和交換機,性能體驗上最佳。

RoCE,一個允許在以太網上執行RDMA的網絡協議。其較低的網絡標頭是以太網標頭,其較高的網絡標頭(包括數據)是InfiniBand標頭。這支持在標準以太網基礎設施(交換機)上使用RDMA。需要支持RoCE網絡協議的以太網卡才可使用,性能接近Infiniband

iWARP,一個允許在TCP上執行RDMA的網絡協議。IB和RoCE中存在的功能在iWARP中不受支持。這支持在標準以太網基礎設施(交換機)上使用RDMA,需要支持iWARP特性的網卡才可以使用,對比Infiniband RDMA 和ROCE性能較差

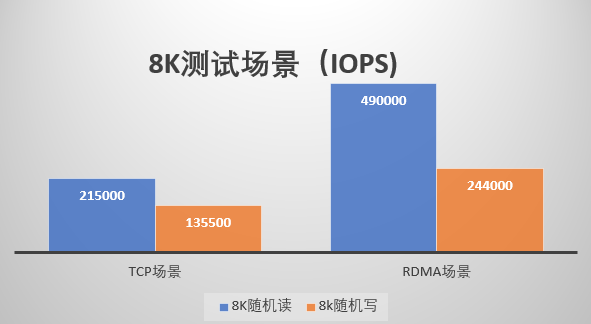

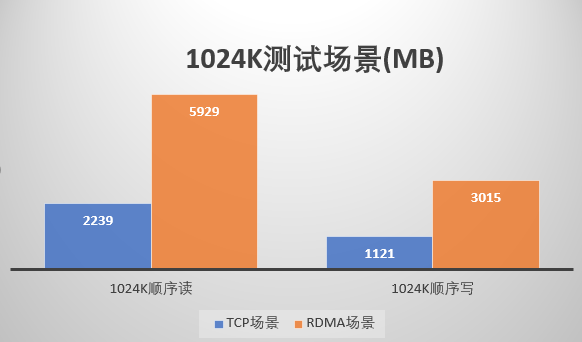

PhegData-X研發團隊自研存儲引擎SmartStor-X集成RDMA通訊功能,支持通過InfiniBand、RoCE或TCP模式實現計算到存儲端、存儲節點之間數據傳輸。

配合自研高性能SmartCache緩存模塊、自研高并發塊客戶端,為客戶提供高性能低延遲的理想型分布式存儲解決方案。下圖為通過Infiniband RDMA方式和以太網TCP方式的性能對比,無論8k場景或1024k場景下隨機讀寫性能RDMA方式對比TCP均要提升一倍左右。

作為分布式存儲的新原力,通過軟件定義,具有如下特點:

- 高度的開放兼容性,支持主流X86,申威以及飛騰平臺,不受硬件廠商綁定

- 高性能,Phegdata X通過SSD緩存加速,采用全并發IO引擎,支持IB,萬兆上去行,能夠提供高性能存儲服務

- 高可靠性,Phegdata X支持多副本,節點或磁盤異常后能夠自動重構,具有高可靠性的特點

- 高擴展能力,Phegdata X采用去中心化架構,支持磁盤和節點擴展,擴展后自動均衡,最大支持4096個節點

面向未來數據中心設計打造的PhegData-X系列同時兼顧傳統業務應用,既可以滿足數據庫等傳統核心關鍵業務需求,也可以完美支持大數據分析、虛擬化、容器、私有云等新型業務應用。

典型應用場景

結合RDMA高速網絡解決方案,PhegData-X可以解決客戶絕大多數高性能需求場景,保證客戶業務高效穩定運行的同時,提升業務的敏捷性與競爭力。