微軟 AI 新技術:讓你的頭像照片動起來,并有感情地“講話”

本文轉自雷鋒網,如需轉載請至雷鋒網官網申請授權。

越來越多的研究表明,只要有足夠多的語料庫,人類的面部動作和語音行為是能夠同步的。兩年前,卡內基·梅隆大學的研究人員曾發表了一篇論文,敘述了一種將一個人的面部動作轉移至另一個人的方法。

而就在今年六月份的時候,三星的應用科學家就介紹了一種端對端的模型,能夠將人頭部特寫中的眉毛、嘴巴、睫毛和臉頰生成動畫。僅僅幾周后,Udacity 展示了一個可以從音頻旁白中自動生成站立演講視頻的系統。

基于前面的研究和工作,微軟研究團隊在本周提出了一項技術。他們宣稱,這一技術能夠提升傳聲頭像動畫的逼真度。在此之前,頭部動畫的生成需要清晰,相對無噪聲的音頻以及中性的音調。而現在,研究人員表示,他們的技術能夠將音頻序列分解成語音內容和背景噪聲等因素,由此可以使用有噪聲和“有感情色彩”的數據樣本。

雷鋒網注:圖片來源于 Microsoft

眾所周知,語音是具有差異性的。不同的人在不同的環境下使用同一個詞,其持續性、振動幅度、語調等等都各不相同。除了語音內容方面,語音自身還承載著豐富的信息,它能夠揭示人的情緒狀態,身份(性別、年齡、種族)和個性等。

事實上,微軟研究人員提出的技術是基于學習潛在顯示的變自編碼器(雷鋒網(公眾號:雷鋒網)按:variational autoencode,VAE)。VAE 能夠將輸入的音頻分解成不同的表現形式,包括編碼內容、表情以及其它變化的因素,在輸入音頻的基礎上,從分布中采樣一些內容表示序列,該序列連同輸入的人臉圖像一同被饋送到視頻生成器進行面部動畫處理。

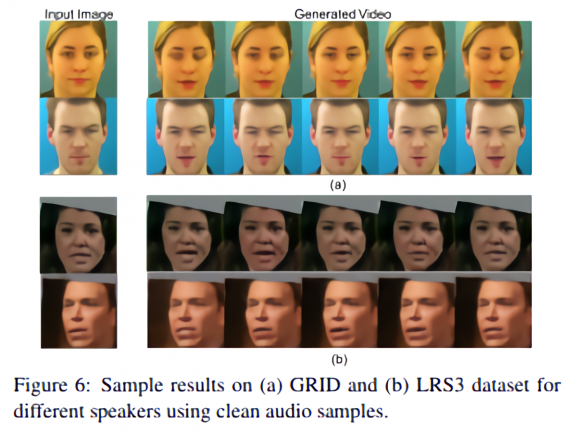

為了訓練和測試 VAE,研究人員選取了三個數據集,分別如下:

-

GRID:這是一個視聽語料庫,每個語料庫包含了 34 為說話者的 1000 份錄音;

-

CREMA-D:包含了 7442 個影視片段,來自 91 位不同種族演員;

-

LRS3:包含了超過 10 萬個 TED 視頻中的口語句子的數據庫。

研究人員將 GRID 和 CREMA-D 的數據輸入到模型中,讓其識別語音和情感表征,然后使用一對定量指標——峰值信噪比(PSNR)和結構相似度指數(SSIM)——來評估視頻生成的質量。

該研究團隊表示,就表現而言,他們的方法和其它清晰的、中性的口語表達方法在所有指標上都是一樣的。并且他們注意到,這種方法不僅能夠在整個情緒光譜上持續表現,還能夠兼容所有目前最先進的傳聲頭像方法。

值得一提的是,其變種特異性的可學先驗方法還能夠擴展到其它語音因素,例如身份和性別,這些因素能夠作為未來工作的一部分探索。通過對噪音和情緒音頻樣本進行測試,研究人員驗證了其模型,表明了在音頻變化的情況下,該方法是優于目前已有的技術水平的。

注:本文編譯自 KYLE WIGGERS 發表于 venturebeat 上的文章。