人人可用的在線摳圖,AI自動化的那種!北大校友算法玩出新高度

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

現在人人可試可玩的圖像分割來了。

在線API,只需輸入圖片網址,即可自動刪除目標背景。

就拿今天凌晨剛奪得歐冠冠軍的拜仁來試試手~

然后就變成了這樣。

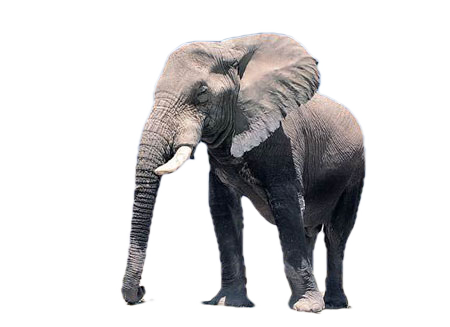

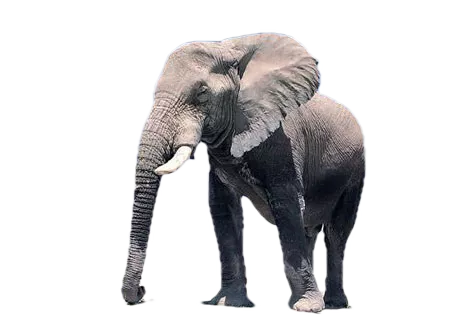

不過,也有翻車的時候,就像這頭大象。

分割之后…誒,它的另一只牙去哪了?

以及,在同時有手和貓的時候。

它呈現的結果就……有點怪異。

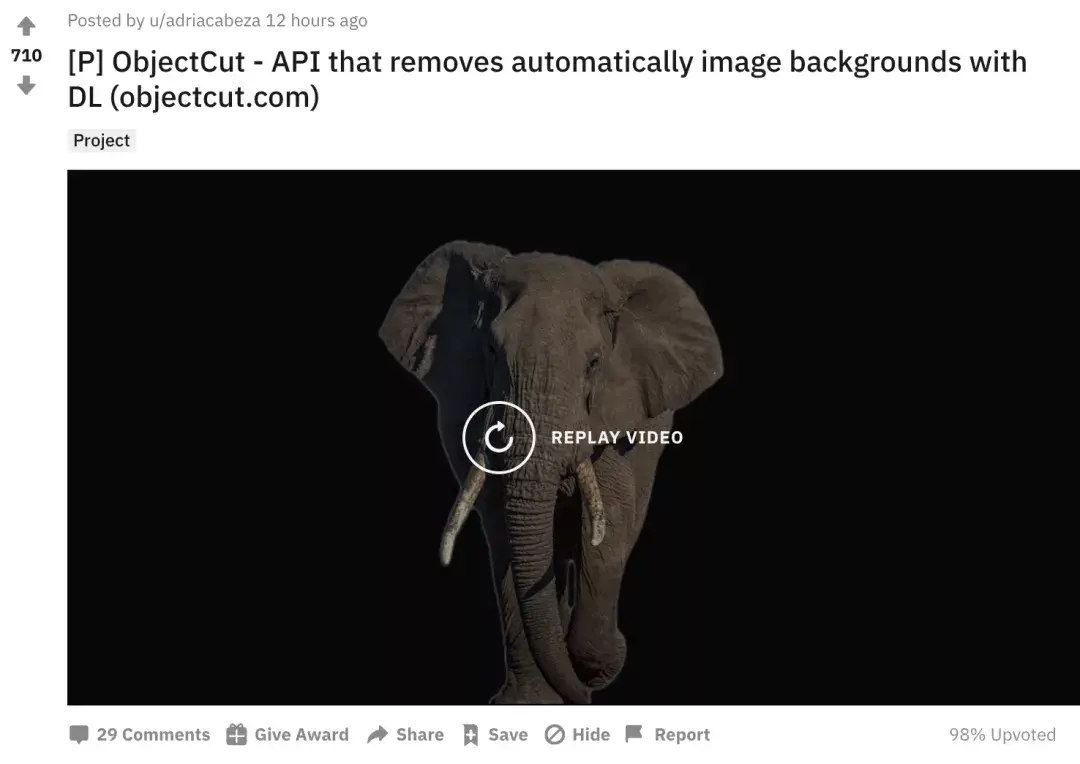

這項新應用名叫ObjectCut,在Reddit上一經發布,12小時就獲得700+的熱度。

不少網友表示:It’s amazing!

簡單三步,人人可試可玩

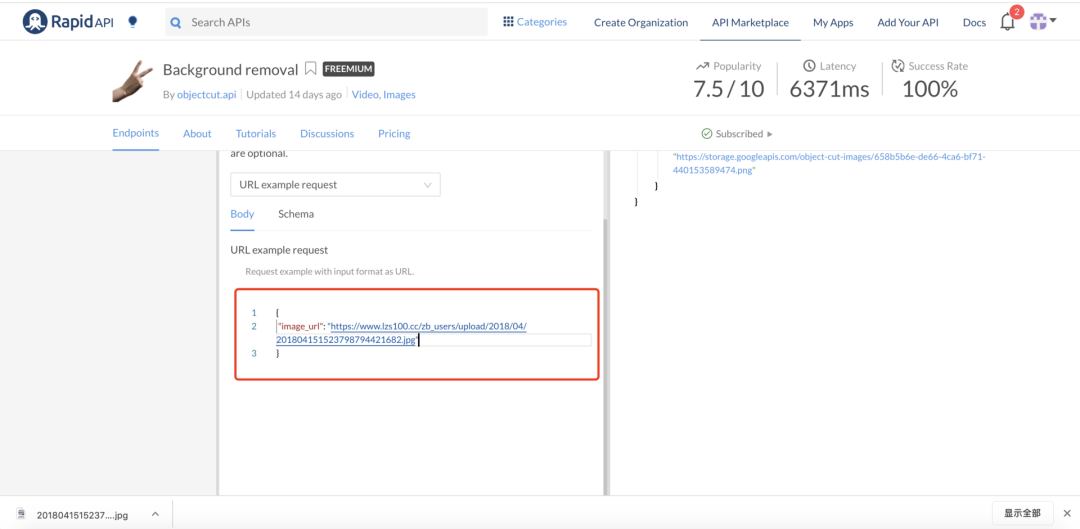

就以上面那頭大象為例,使用步驟非常簡單。

首先,任意選擇一張圖片,復制圖片地址。

第二步,網站上將地址粘貼到指定位置,然后點擊Test Endpoint。

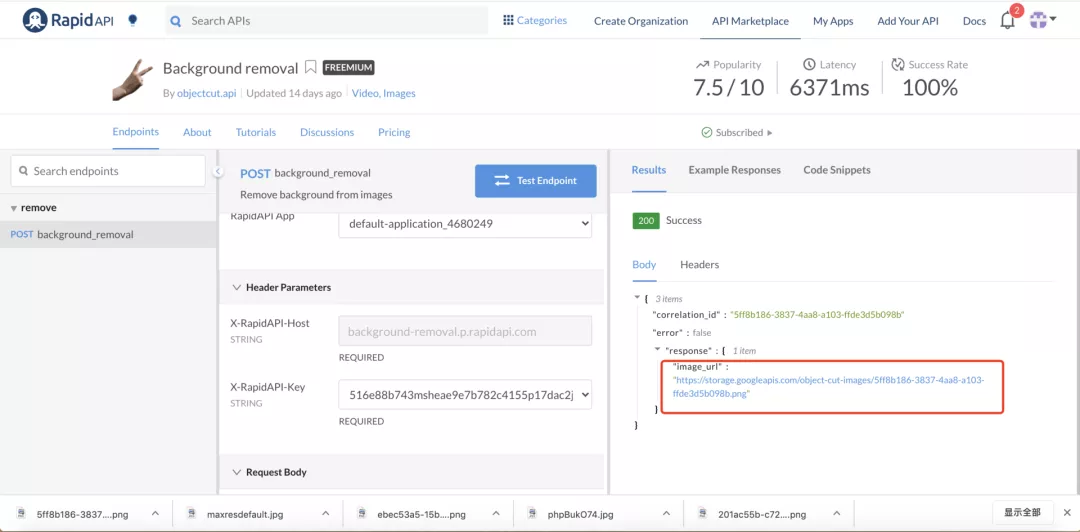

等待幾秒之后,點擊旁邊生成的網址,就大功告成啦!

然后就變成了這樣一頭少了一顆牙的大象。

還是那個北大校友的研究

是不是覺得這項技術很熟悉,簡單幾步就可以去移除圖片背景?

跟之前的AR應用AR Cut & Paste——將現實物體隔空「復制粘貼」進電腦有異曲同工之妙。

這兩項應用背后的主要技術,都是一個叫做BASNet的顯著目標檢測方法。

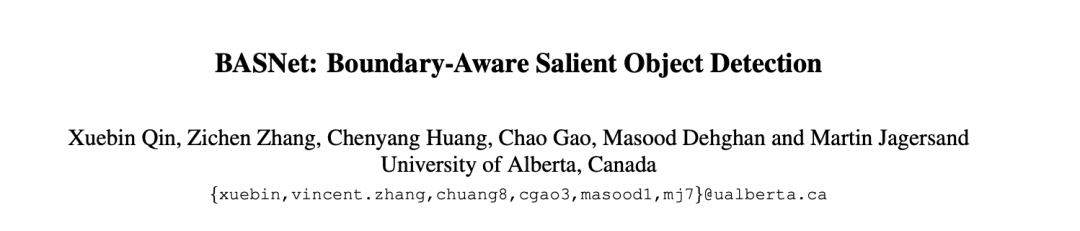

這篇研究入圍了CVPR 2019,其論文一作是位華人小哥哥——秦雪彬,已經于今年2月在在加拿大阿爾伯塔大學拿到了博士學位,碩士就讀于北京大學。

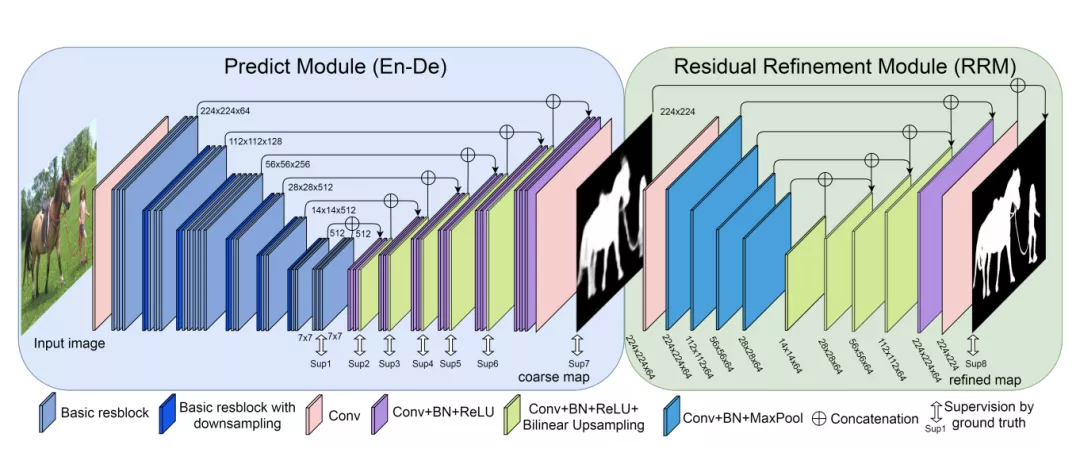

BASNet的核心框架如下圖所示,主要由2個模塊組成:

第一個模塊是預測模塊,這是一個類似于U-Net的密集監督的Encoder-Decoder網絡,主要功能是從輸入圖像中學習預測saliency map。

第二個模塊是多尺度殘差細化模塊(RRM),主要功能是通過學習殘差來細化預測模塊得到的Saliency map,與groun-truth之間的殘差,從而細化出預測模塊的Saliency map。

而除了BASNet,還有網友推薦了U2-Net,依然來自同一個作者,其效果更好。

其研究是《U2 -Net: Going Deeper with Nested U-Structure for Salient Object Detection》

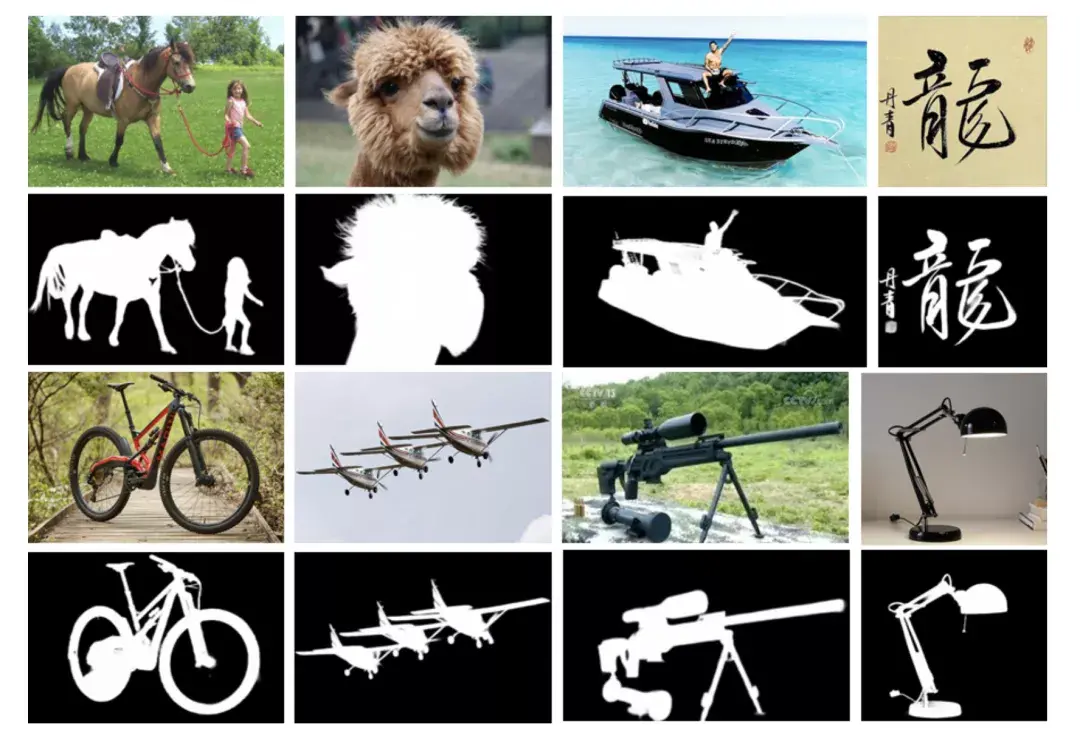

實驗結果像這樣:

同一項技術,不一樣的玩法,你覺得這個方法還可以做什么有趣的應用?

另外,想要去試試這個在線圖像分割應用,可戳下方鏈接哦~

網址:

https://rapidapi.com/objectcut.api/api/background-removal