Tiedemann 發布的數據集讓非洲語言也能「機翻」

孩童時候,看哆啦A夢印象比較深的一集就是「翻譯年糕」,那時候就希望自己能吃一塊能讀懂各種外語,次次考滿分......如今來看,實現這個「小目標」有希望了!

赫爾辛基大學語言技術教授Jörg Tiedemann于2021年3月3號宣布,他已經發布了188種語言的5億多個翻譯句子。

這是一個自動翻譯數據集,可用于數據增強翻譯。

機器翻譯(MT)屬于計算機語言的范疇,其研究借由計算機程序將文字或演說從一種自然語言翻譯成另一種自然語言。

研究機器翻譯的研究人員經常依靠反向翻譯來增加訓練數據。

反向翻譯是指,給定源語言句子x,目標語言句子y, 用訓練好的目標語言到源語言的翻譯模型得到偽句對(x’, y),加入到平行句對中一起訓練。

這種訓練方式也能起到去噪的作用,即不完美的機翻模型的輸出包含了噪聲。

在有噪聲的情況下,訓練(x', y)和(x, y)的翻譯模型如果都能得到y的輸出,則提升了泛化性能。

當更多的單語目標語言數據被翻譯成源語言時,反向翻譯使得深度學習系統 CUBITT 能夠“超越人工翻譯”。

反向翻譯的有用性取決于目標語言數據的廣泛可獲得性,這對于使用人數少的小語種來說比較麻煩。

反向翻譯對于檢測機器翻譯內容的方法也很關鍵,尤其是現在初創公司將人工智能驅動的「文本生成」技術逐漸商業化。

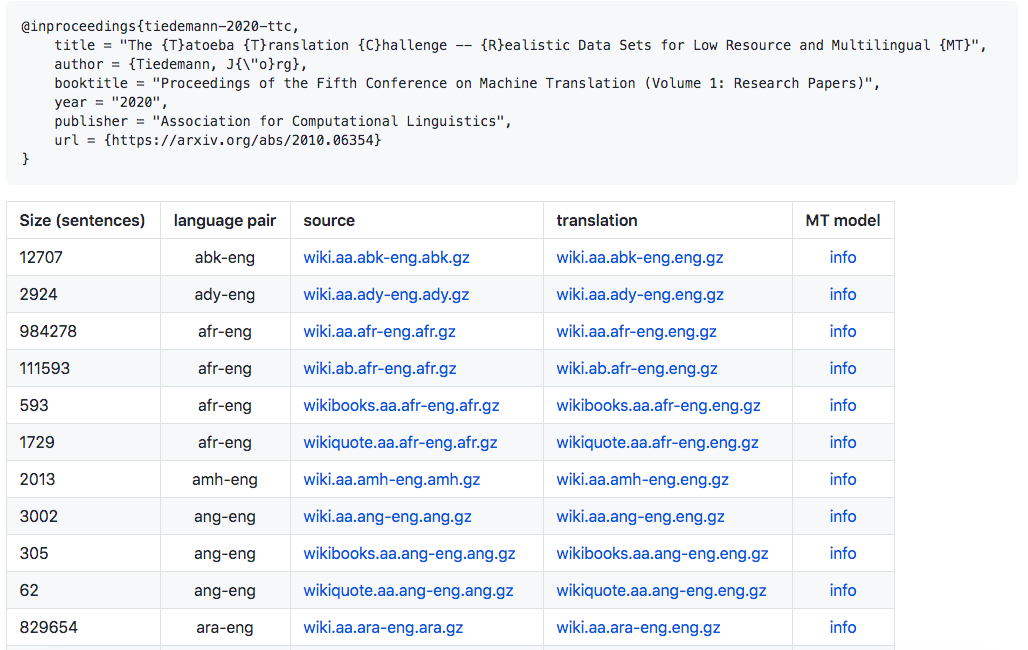

目前,Tiedemann的論文和數據集已經發布在了GitHub上。

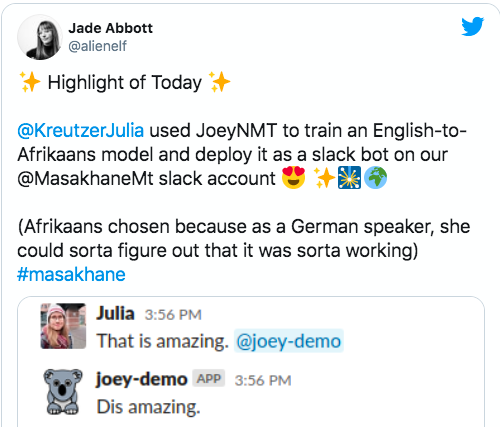

這并不是Tiedemann第一次試圖通過MT為各種語言創造一個「地球村」。自2018年以來,Masakhane項目一直在專門針對NLP中代表不足的非洲語言收集語言數據并微調語言模型。

這個語言模型取得了不錯的效果,這位德國在讀博士就對這個模型給予了肯定。

Tatoeba 是一個龐大的句子和翻譯數據庫。Tatoeba 提供了一個工具,可以讓你看到你所需要的單詞在句子上下文中是如何使用的。

在2020年10月關于Tatoeba翻譯挑戰的相關論文中,Tiedemann寫道,“我們的主要目標是促進開放翻譯工具和模型的開發,從而更廣泛地覆蓋世界各種語言。”

有多寬泛?訓練和測試數據涵蓋500種語言和語言變體,以及大約3000種語言對。忍不住唱一句「你看這個數據集它又大又寬」。

根據 Tiedemann 的說法,還有很多工作要做。他在推特上寫道: “無論如何,這不會是我將要發布的最后一套翻譯版本”。“很快還會有更多語言從英語轉向其它語言... ...”