10+款Redis容器化技術選型對比,K8S并非萬金油

今天將分享的內容分為以下4個方面:

- 一、緣起

- 二、介紹多樣的容器化技術

- 三、Redis介紹

- 四、Redis容器化方案的對比

一、緣起

首先我們先聊一下為什么今天我會分享這個主題。我和朋友一起組織了一個 Redis技術交流群,到現在已經經營了6年左右的時間,其中某一天在群里有一個小伙伴就拋出來一個問題:

他問大家線上的Redis有沒有使用Docker安裝?Docker使用Host的網絡模式、磁盤使用本地掛載模式這種方案怎么樣?這里的話我們暫時先不說這個方案如何,因為在今天的分享之后,我相信大家對于這個方案應該會有一個更清晰的認識和評價。

二、介紹多樣的容器化技術

1、chroot和jails

在容器化技術方面,其實歷史很久遠了。雖然我們現在用的容器化技術,或者說 k8s,還有云原生的概念是近幾年才火起來的,但是實際上就容器化技術的發展來說,其實是很早的了。比如說最早的時候來自chroot,chroot大家可能都用過,或者都有了解過,在1979年的時候它是來自Unix,它主要的功能是可以修改進程和子進程的/。

通過使用chroot達到什么樣效果呢?使用chroot加某一個目錄,然后再啟動一個進程,那么這個進程自己所看到的 /,就是我們平時所說的 / 目錄,這個 / 就會是我們剛才指定的文件夾,或者說剛才指定的路徑。這樣子的話可以有效的保護我們操作系統上面的一些文件,或者說權限和安全相關的東西。

在2000年的時候,出現了一個新的技術,叫做jails,其實它已經具備了sandbox,就是沙箱環境的雛形。使用jails的話,可以讓一個進程或者說創建的環境擁有獨立的網絡接口和IP地址,而當我們提到使用jails的話,我們肯定會想到一個問題,就是如果你有了獨立的網絡接口和IP地址,這樣的話就不能發原始的套接字,通常跟原始的套接字接觸得比較多的就是我們使用的Ping命令。默認的情況下,這樣子是不允許使用原始的套接字的,而有自己的網絡接口和IP地址,這個感覺上就像是我們常用的虛擬機。

2、Linux VServer和OpenVZ

接下來在2001年的時候,在Linux社區當中就出現了一個新的技術叫做Linux VServer。Linux VServer有時候可以簡寫成lvs,但是和我們平時用到的4層的代理lvs其實是不一樣的。它其實是對Linux內核的一種Patch,它是需要修改Linux內核,修改完成之后,我們可以讓它支持系統級的虛擬化,同時使用Linux VServer的話,它可以共享系統調用,它是沒有仿真開銷的,也就是說我們常用的一些系統調用、系統調用的一些函數都是可以共享的。

在2005年的時候,出現的一個新的技術—OpenVZ。OpenVZ其實和Linux VServer有很大的相似點,它也是對內核的一種Patch,這兩種技術最大的變化就是它對Linux打了很多的Patch,加了很多新的功能,但是在2005年的時候,沒有把這些全部都合并到Linux的主干當中,而且在使用OpenVZ的時候,它可以允許每個進程可以有自己的/proc或者說自己的/sys。

其實我們大家都知道在Linux當中,比如說啟動一個進程,你在他的/proc/self下面,你就可以看到進程相關的信息。如果你有了自己獨立的/proc,其實你就可以達到和其他的進程隔離開的效果。

接下來另外一個顯著的特點就是它有獨立的users和groups,也就是說你可以有獨立的用戶或者獨立的組,而且這個是可以和系統當中其他的用戶或者組獨立開的。

其次的話OpenVZ是有商業使用的,就是有很多國外的主機和各種VPS都是用OpenVZ這種技術方案。

3、namespace 和 cgroups

到了2002年的時候,新的技術是namespace。在Linux當中我們有了新的技術叫做namespace,namespace可以達到進程組內的特定資源的隔離。因為我們平時用到的namespace其實有很多種,比如說有PID、net等,而且如果你不在相同的namespace下面的話,是看不到其他進程特定的資源的。

到了2013年的時候,產生了一個新的namespace的特性,就是user namespace。其實當有了user namespace,就和上文提到的OpenVZ實現的獨立用戶和組的功能是比較像的。

對于namespace的操作當中,通常會有三種。

1)Clone

可以指定子進程在什么namespace下面。

2)Unshare

它是與其他進程不共享的,unshare再加一個-net,就可以與其他的進程獨立開,不共享自己的net,不共享自己的網絡的namespace。

3)Setns

就是為進程設置 namespace。

到了2008年,cgroups開始被引入到Linux內核當中,它可以用于隔離進程組的資源使用,比如說可以隔離CPU、內存、磁盤,還有網絡,尤其是他在2013年和user namespace進行了一次組合之后,并且進行了重新的設計,這個時候,就變得更現代化了,就像我們現在經常使用到的Docker的相關特性,其實都來自于這個時候。所以說cgroups和namespace構成現代容器技術的基礎。

4、LXC 和 CloudFoundry

在2008年的時候,新的一項技術叫做LXC, 我們也會叫他Linux Container(以下均簡稱LXC)。上文我們提到了很多容器化的技術,比如Linux VServer、OpenVZ,但是這些都是通過打Patch來實現的,而LXC是首個可以直接和上游的Linux內核共同工作的。

LXC是可以支持特權容器的,意思就是說可以在機器上面去做uid map、gid map,去做映射,而且不需要都拿root用戶去啟動,這樣子就具備了很大的便利性。而且這種方式可以讓你的被攻擊面大大縮小。LXC支持的這幾種比較常規的操作,就是LXC-start,可以用來啟動container,LXC-attach就可以進入container當中。

到2011年的時候,CloudFoundry開始出現了,他實際上是使用了LXC和 Warden這兩項技術的組合,在這個時候不得不提到的,就是他的技術架構是CS的模式,也就是說還有一個客戶端和server端,而 Warden容器,它通常是有兩層,一層是只讀os的,就是只讀的操作系統的文件系統,另外一層是用于應用程序和其依賴的非持久化的讀寫層,就是這兩層的組合。

我們之前提到的技術,大多數都是針對于某一臺機器的,就是對于單機的。CloudFoundry它最大的不同就是它可以管理跨計算機的容器集群,這其實就已經有了現代容器技術的相關特性了。

5、LMCTFY和systemd-nspawn

在2013年的時候, Google開源了自己的容器化的解決方案,叫做LMCTFY。這個方案是可以支持CPU、內存還有設備的隔離。而且它是支持子容器的,可以讓應用程序去感知到自己當前是處在容器當中的。另外還可以再為自己創建一個子容器,但是隨著2013年發展之后,它逐漸發現只依靠自己不停的做這些技術,就相當于單打獨斗,發展始終是有限的,所以它逐步的將自己的主要精力放在抽象和移植上,把自己的核心特性都移植到了libcontainer。而libcontainer之后就是Docker的運行時的一個核心,再之后就是被Docker捐到了OCI,再然后就發展到了runC。這部分內容我們稍后再詳細講解。

大家都知道服務器它肯定是有一個 PID為1的進程。就是它的初始進程、守護進程,而現代的操作系統的話,大多數大家都使用的是systemd,同樣systemd它也提供了一種容器化的解決方案,叫做 systemd-nspawn。這個技術的話,它是可以和systemd相關的工具鏈進行結合的。

systemd除了有我們平時用到的systemctl之類的,還有systemd machine ctl,它可以去管理機器,這個機器支持兩種主要的接口,一種是管理容器相關的接口,另外一種是管理虛擬機相關的接口。

而我們通常來講,就是說systemd提供的容器技術解決方案,它是允許我們通過machine ctl去容器去進行交互的,比如說你可以通過machine ctl start,去啟動一個systemd支持的容器,或者通過 machine ctl stop,去關掉它,而在這種技術下,它是支持資源還有網絡等隔離的,其實它最主要的是systemd ns,它其實是使用namespace去做隔離。對于資源方面是來自于systemd,systemd是可以使用cgroups去做資源隔離的,其實這也是這兩種兩種技術方案的組合。

6、Docker

而在2013年Docker也出現了。通常來講,Docker是容器時代的引領者,為什么這么說呢?因為Docker在2013年出現的時候,他首先提到了標準化的部署單元,就是Docker image。同時它還推出了DockerHub,就是中央鏡像倉庫。允許所有人通過DockerHub去下載預先已經構建好的Docker image,并且通過一行Docker run就可以啟動這個容器。

在眾多使用起來比較繁瑣、比較復雜的技術下,Docker這時提出來,你只需要一行Docker run,就可以啟動一個容器,它大大簡化了大家啟動容器的復雜度,提升了便捷性。

所以Docker這項技術就開始風靡全球。而Docker它主要提供的一些功能是什么呢?比如說資源的隔離和管理。而且Docker在0.9之前,它的容器運行時是LXC,在0.9之后,他就開始把LXC替換掉,替換成了libcontainer,而這個libcontainer其實就是我們在上文提到的Google的 LMCTFY。再之后libcontainer捐給了OCI。而那之后Docker現在的容器運行時是什么呢?是containerd。containerd的更下層是runc,runc的核心其實就是libcontainer。

而到了2014年的時候, Google發現大多數的容器化解決方案,其實都只提供了單機的解決方案,同時由于Docker也是CS架構的,所以它需要有一個Docker demand,它是需要有守護進程存在的,而這個守護進程的話,是需要用root用戶去啟動的,而root用戶啟動的守護進程,其實是增加了被攻擊面,所以 Docker的安全問題也被很多人詬病。

在這個時候 Google就發現了這個點,并且把自己的Borg系統去做了開源,開源版本就是Kubernetes。Google還聯合了一些公司,組建了一個云原生基金會(CNCF)。

7、Kubernetes

通常來講Kubernetes是云原生應用的基石,也就是說在Kubernetes出現之后,我們的云原生技術開始逐步地發展起來,逐步地引領了潮流,Kubernetes提供了一些主要的特性。

它可以支持比較靈活的調度、控制和管理,而這個調度程序的話,除了它默認的以外,也可以比較方便的去對它做擴展,比如說我們可以自己去寫自己的調度程序,或者說親和性、反親和性,這些其實都是我們比較常用到的一些特性。

還有包括他提供的一些服務,比如說內置的 DNS、kube-DNS或者說現在的CoreDNS,通過域名的方式去做服務發現,以及Kubernetes當中有很多的控制器。它可以將集群的狀態調整至我們預期的狀態,就比如說有一個pod掛掉了,它可以自動的把它再恢復到我們預期想要的樣子。

另外就是它支持豐富的資源種類,比如說幾個主要的層級,最小的是pod,再往上有deployment,或者有StatefulSets,類似于這樣子的資源。

最后一點是它讓我們更加喜歡它的因素,就是它有豐富的CRD的拓展,即可以通過自己去寫一些自定義的資源,然后對它進行擴展,比如CRD。

8、更多的容器化技術

除了剛才我們提到的這些主要的技術以外,其實還有很多我們沒有提到的一些容器化的技術,比如說像runc,上文我們沒有太多的介紹,還有containerd。containerd其實也是Docker開源出來的自己的核心,他的目標是做一個標準化工業可用的容器運行時,還有CoreOS開源出來的解決方案叫做rkt。而rkt瞄準的點就是上文提到的Docker相關的安全問題。但是rkt現在項目已經終止了。

還有紅帽(Red Hat)開源出來的 podman, podman是一種可以用它來啟動容器,可以用它去管理容器,而且沒有守護進程,所以就安全性來講的話,podman可以說比Docker的安全性直觀上來看的話會好一些,但是它的便捷性來講的話,就要大打折扣了。比如說容器的重啟、開機起之類的,但是我們都是有一些不同的解決方案的。

在2017年的時候,這個時候有一個 Kata Container,而這個Kata Container它有一段發展過程,最開始是英特爾,英特爾在搞自己的容器運行時,還有一家初創公司叫做hyper.sh,這家公司也在搞自己的容器運行時,這兩家公司瞄準的都是做更安全的容器,他們使用的底層的技術都是基于K8S。而之后這兩家公司做了合并,hyper.sh它開源出來的一個解決方案是runv,被英特爾看上了之后就誕生了 Kata Container。在2018年的時候,AWS開源出來自己的Firecracker。

這兩項技術和我們上文提到的機器上的容器化技術其實大有不同,因為它的底層其實相當于是虛擬機,而我們通常來講,都認為它是輕量級虛擬機的一種容器化的技術。以上就是關于多樣的容器化技術的介紹。

三、Redis介紹

接下來進入關于Redis相關的介紹,以下是從Redis的官網上面摘抄的一段介紹。

1、Redis使用的主要場景

其實Redis現在是使用最廣泛的一種KV型數據庫。而我們在使用它的時候,主要的使用場景可能有以下幾種:

- 把它當緩存使用,把它放在數據庫之前,把它當做緩存去使用。

- 把它當DB來用,這種就是需要把真正的拿它來存數據做持久化。

- 做消息隊列,它支持的數據類型也比較多,這里就不再做介紹了。

2、Redis的特點

- 它是一個單線程的模型,它其實是可以有多個線程的,但是它的worker線程只有一個,在Redis6.0開始,它支持了io多線程,但io多線程只是可以有多線程去處理有網絡相關的部分,實際上你真正去處理數據還是單線程,所以整體而言,我們仍然把它叫做單線程模型。

- Redis的數據其實都在內存里頭,它是一個內存型的數據庫。

- 與HA相關, Redis想要做HA,我們以前在做 Redis的HA主要靠Redis sentinel,而后面在Redis出來cluster之后,我們主要靠Redis cluster去做HA,這是兩種主要HA的解決方案。

四、Redis容器化方案的對比

當我們提到做 Redis運維相關的時候,我們有哪些需要考慮的點:

- 部署,如何快速的部署,如何能夠快速的部署,而且還要去管理監聽的端口,讓端口不起沖突,還有日志和持久化文件之類的,這部分都屬于部署相關的內容;

- 擴/縮容,也是我們經常會遇到的問題;

- 監控和報警;

- 故障和恢復。

以上都是我們最關注的幾個方面。我接下來就對這幾個方面去做一些介紹。

1、部署

當我們提到去做單機多實例的時候,Redis作單機多實例去部署的時候,首先第一點就是我們希望能夠有進程級別的資源隔離,我們某一個節點上面所有部署的Redis實例,可以有自己的資源,可以不受別的實例的影響,這就是對于進程級別的資源隔離。

進程級別的資源隔離,它其實主要分為兩個方面,一方面是CPU,另一方面是內存,其次的話我們希望在單機上面我們也可以有自己的端口管理,或者說我們可以有獨立的網絡資源隔離的相關的技術。

在這種情況下,首先我們提到說進程級別的資源隔離,我們介紹了那么多的容器化相關技術,我們已經知道了,支持進程級別的資源隔離的話,有最簡單的一種方案就是用cgroups,如果想要去做網絡資源隔離的話,我們有namespace,也就是說所有支持cgroups和 namespace的這種計劃的解決方案,都可以滿足我們這個地方的需求。

再有一種方案就是虛擬化的方案,也就是我們上文提到比如說Kata Container,Kata Container這種基于虛擬化的方式,因為虛擬化的方案其實大家都有所接觸,大家都知道就是虛擬化的這種技術,其實默認情況下,剛開始全部都做隔離。

所以對于部署而言,如果你使用的是比如說像Docker,比如說你想使用的像 systemd-nspawn這些它都可以既用到cgroups,又用到了 namespace,是都可以去用的,只不過是你需要考慮一些便捷性,比如說你如果是使用Docker的話,進行一個Docker命令跑過去,然后只要讓它映射到不同的端口,其實就結束了。

如果你使用是systemd-nspawn,這樣子的話,你需要去寫一些配置文件。如果你要是去用一些虛擬化的解決方案的話,同樣的也需要去準備一些鏡像。

2、擴/縮容

關于擴/縮容,其實會有兩種最主要的場景,一種場景就是單實例 maxmemory 調整,就是我們最大內存的調整。還有一種是對于我們的集群化的集群解決方案,就是Redis Cluster。對于這種集群規模,我們有擴/縮容的話,會有兩方面的變化。

一方面是 Node,就是我們的節點的變更,如果會新增節點,也可能會去移除節點。

另外一種就是Slot的變更,就是希望把我的 slot 去做一些遷移,當然這些和Node節點會是相關的,因為當我們去做擴容的時候,我們把Redis Cluster當中的一些Node節點增多,增多了之后,就可以不給他分配Slot,或者說我想要讓某些Slot集中到某些節點上面,其實這些需求也是同樣存在的。

那我們來看一下,如果你當時想要去做maxmemory的調整,如果我們是前提已經做了容器化,想通過 cgroups去對它做資源的限制,就需要有一個可以支持動態調整 cgroups配額的解決方案。

比如說我們用到Docker update,它是可以直接修改某個實例,或者說其中的某一個容器的cgroups資源的一些限制,比如說我們可以Docker update,給它指定新的內存,可以限制它最大可用內存,當你把它的可用內存數調大,接下來你就可以對實例去調整它的 maxmemory ,也就是說對于單實例 maxmemory,其實最主要的就是需要有cgroups的技術,向cgroups的技術提供一些支持。

對于集群節點的變更的話,這個部分稍后再做詳細介紹。

3、監控報警

第三點就是監控報警,不管是使用物理機也好,或者使用云環境也好,或者使用任何解決方案都好,監控報警我們最想要得到的效果就是,它可以自動發現。

我們希望當啟動一個實例之后,我們就可以立馬知道這個實例A他已經起來了,并且知道他的狀態是什么,而監控報警的話,這部分其實是不依賴于特定的容器化技術的,就即使是在純粹的物理機上部署,也可以通過一些解決方案自動的發現它,自動的把它注冊到我們的監控系統當中去,所以它是屬于監控報警的這部分,其實它是不依賴于特定的容器技術的,但唯一的一個問題就是說假如說使用了容器化的方案,可以讓常用的 Redis exporter,配合Prometheus去做監控,可以讓 Redis exporter和 Redis server,這兩個進程可以處于同一個網絡的命名空間。

如果他們兩個處于同一個網絡的命名空間的話,可以直接通過127.0.0.1:6379,然后直接去聯通它,如果我們使用的是k8s的話,可以直接把它倆放到一個pod當中,但是這些都無關緊要,因為它是不依賴于特定的容器化技術的,你可以使用任何你想要用的技術,都可以去做監控和報警。

4、故障恢復

最后我們提到的部分是故障和恢復。在這個部分我認為最主要的有三個方面:

- 第一個是實例的重啟。

有可能在某些情況下,某些場景下,你的實例在運行過程當中它可能會宕掉,如果你想讓他自動重啟的話,你需要有一個進程管理的工具。對于我們而言,上文我們提到了systemd,systemd是可以支持對于某一個進程的自動拉起的,還可以支持進程掛掉之后自動拉起, 可以 restart,或者你使用Docker,它也有一個restart policy,可以指定他為 always或者指定為on-failure,然后讓它在掛掉的時候再把它給拉起來。

如果你使用的是k8s,那么就更簡單了,可以自動拉起來。

- 第二個是主從切換。

主從切換相對來說是一個常態,但在這里我也把它列到故障恢復當中,是因為可能在主從切換的過程當中,有可能你的集群狀況已經不健康了,是會有這種情況存在的。那主從切換的時候我們需要做什么?第一方面,需要讓他能夠有數據的持久化,另一方面在主從切換的時候,有可能會遇到一種情況,就是資源不夠,導致主從切換失敗,在這種情況下,其實和我們上文前面提到的擴/縮容其實是相關的,所以在這種情況下就必須得給他加資源,而最好的辦法是可以自動給他加資源。

在k8s當中,想要讓它自動加資源,我們通常會給他設置它的request和limit,就是資源的配額,希望它能自動的加起來,我們通常把他叫做vpa。

- 第三個是數據恢復。

通常來講,比如說我們開了 RDB和AOF,而且希望我們的數據可以保存下來,以便于在我們數據恢復的時候可以直接開始使用。所以數據持久化也是一方面。

我們去做容器化的時候,我們需要考慮哪些點?如果說你是使用Docker的話,你需要去掛一個券,然后你可以把這個數據去做持久化,比如說你使用systemd-nspawn也需要有一個文件目錄去把這個數據做持續化。

如果你使用的是k8s的話,在掛券的時候,你會有各種各樣的選擇,比如說你可以去掛 ceph的RDB、s3或者一個本地的某一個文件目錄。但是為了更高的可靠性,可能會使用副本數更多的分布式存儲。

5、Node節點變更

接下來,我們來聊一下上文我們在提到服務擴/縮容的時候,提到的關于Node節點變更,比如說我想要讓我的某一個Redis cluster,去擴充一些節點,擴充節點的時候,那就意味著你必須能夠加入集群,能夠和集群正常通信,這才說明你真正的加入到了集群當中。

而我們也知道在Redis cluster當中,你要去做集群,最大的一個問題就是k8s,k8s當中做服務發現其實它都是大多數通過一個域名,而我們的Redis當中,比如說我們的NodeIP,它其實只支持IP,它并不支持我們的域名。

所以如果說Node節點變更,需要做的事情就是允許我們動態地去把NodeIP寫到我們的集群配置當中。

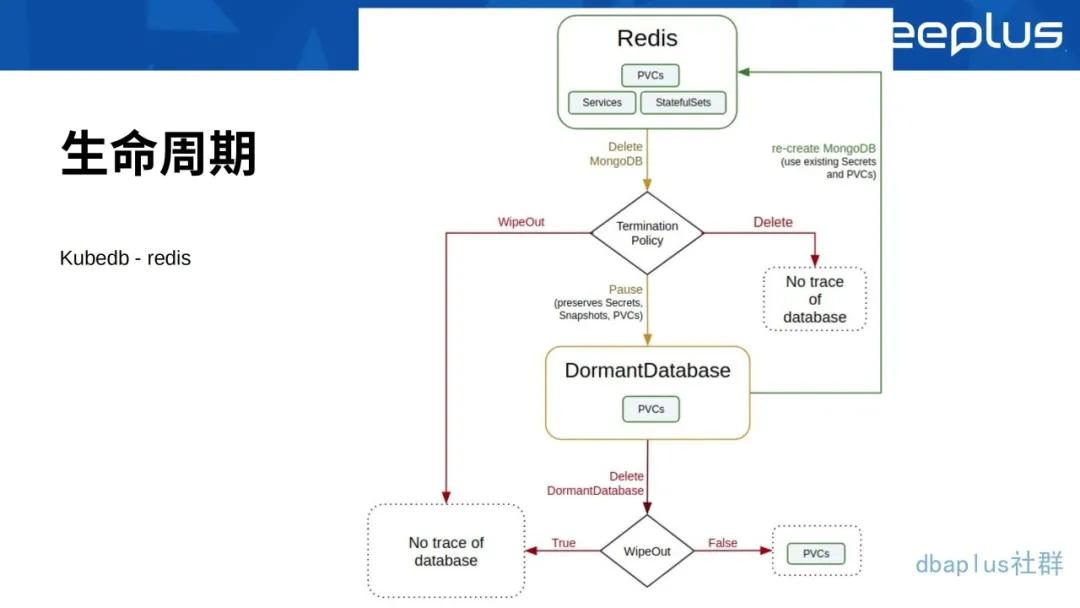

如果想要讓它有一個完整的生命周期,以下截圖是來自于一個叫Kubedb的operator,在下圖中可以看到,Redis這個地方提供了最主要的三個部分:

- PVCs,PVCs就是做數據的持久化。

- Services,Services就是做服務發現。

- StatefulSets,StatefulSets其實就是k8s當中的一種資源,而這資源它對于我們的有狀態應用會更友好一些。

其實在整個內容當中還有一點沒有介紹的是什么呢?就是Redis背后的公司叫做Redis Labs,它提供了一種商業化的方案,就是Redis Enterprise一種解決方案。其實也是在k8s的解決方案之上的,也是用了Redis operator。他的方案和Kubedb這種方案基本類似,因為核心還都是用的StatefulSets,然后再加上自己的Controller,去完成這個事情。

五、總結

我們來看一下今天的總結。如果是我們單機使用的話,我們可以交給Docker或者其他支持cgroups或者namespace資源管理的工具。因為當你使用了cgroups、namespace的話,你可以做到資源的隔離,可以避免網絡的端口的沖突之類的事情都可以實現。

而如果是像我在上文提到的小伙伴提到的那個問題:他打算使用主機的網絡,僅僅是想讓Docker去做一個進程管理,而且你也不希望引入新的內容。那么systemd或者systemd-nspawn都是可以考慮的,因為這也是容器化的解決方案。

如果是在復雜場景下的調度和管理的話,比如想要有很大的規模,并且想要有更靈活的調度和管理,我推薦你使用的是Kubernetes operator,比如說Kubedb,其實也是一種解決方案。如果你的場景沒有那么復雜,比較簡單,其實原生的Kubernetes StatefulSets稍微做一些調整和修改,也是可以滿足你的需求。

以上就是我今天分享的主要內容了,感謝大家的參與。

張晉濤,負責DevOps的實踐和落地,推進容器化技術落地和運維自動化等。

參與了眾多知名開源項目,對Docker、Kubernetes及相關生態有大量生產實踐和深入源碼的研究。