國科大提出CNN和Transformer雙體基網模型 準確率高達84.1%

Transformer和CNN在處理視覺表征方面都有著各自的優勢以及一些不可避免的問題。因此,國科大、鵬城實驗室和華為研究人員首次將二者進行了融合并提出全新的Conformer模型,其可以在不顯著增加計算量的前提下顯著提升了基網表征能力。論文已被ICCV 2021接收。

卷積運算善于提取局部特征,卻不具備提取全局表征的能力。

為了感受圖像全局信息,CNN必須依靠堆疊卷積層,采用池化操作來擴大感受野。

Visual Transformer的提出則打破了CNN在視覺表征方面的壟斷。

得益于自注意力機制,Visual Transformer (ViT、Deit)具備了全局、動態感受野的能力,在圖像識別任務上取得了更好的結果。

但是受限于計算復雜度,Transformer需要減小輸入分辨率、增大下采樣步長,這造成切分patch階段損失圖像細節信息。

因此,中國科學院大學聯合鵬城實驗室和華為提出了Conformer基網模型,將Transformer與CNN進行了融合。

Conformer模型可以在不顯著增加計算量的前提下顯著提升了基網表征能力。目前,論文已被ICCV 2021接收。

論文地址:https://arxiv.org/abs/2105.03889

項目地址:https://github.com/pengzhiliang/Conformer

此外,Conformer中含有并行的CNN分支和Transformer分支,通過特征耦合模塊融合局部與全局特征,目的在于不損失圖像細節的同時捕捉圖像全局信息。

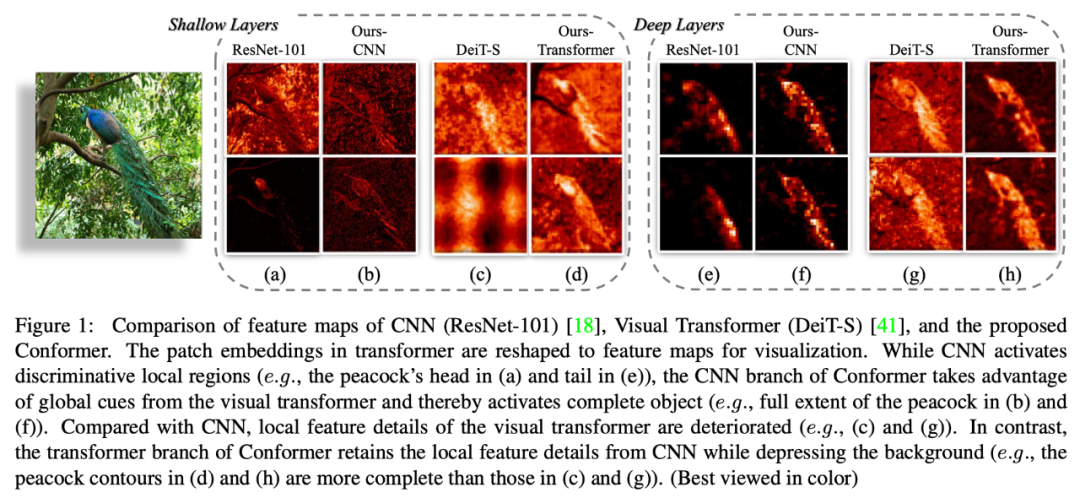

特征圖可視化

對一張背景相對復雜的圖片的特征進行可視化,以此來說明Conformer捕捉局部和全局信息的能力:

- 淺層Transformer(DeiT)特征圖(c列)相比于ResNet(a列)丟失很多細節信息,而Conformer的Transformer分支特征圖(d列)更好保留了局部特征;

- 從深層的特征圖來看,DeiT特征圖(g列)相比于ResNet(e列)會保留全局的特征信息,但是噪聲會更大一點;

- 得益于Transformer分支提供的全局特征,Conformer的CNN分支特征圖(f列)會保留更加完整的特征(相比于e列);

- Transformer分支特征圖(h列)相比于DeiT(g列)則是保留了更多細節信息,且抑制了噪聲。

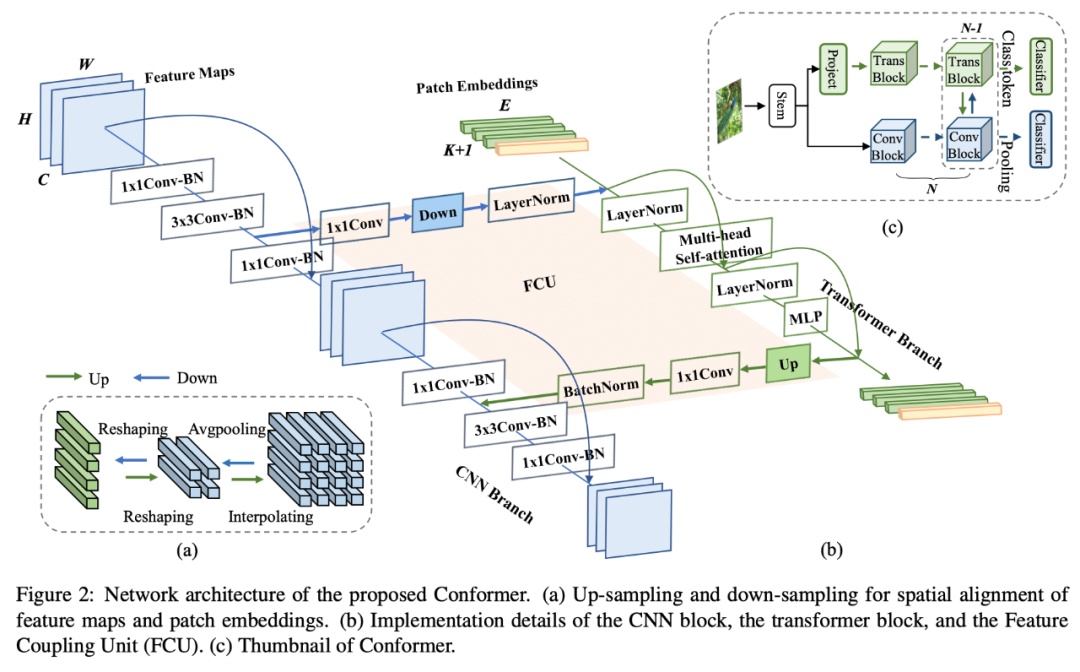

網絡結構

Conformer是一個并行雙體網結構,其中CNN分支采用了ResNet結構,Transformer分支則是采用了ViT結構。

網絡結構圖

(c)展示了Conformer的縮略圖:一個標準的ResNet stem結構,兩條并行分支,兩個分類器。

(b)展示了每個block中Trans和Conv的連接關系:以2個bottleneck為例,經過第一個bottleneck 3x3卷積后的局部特征經過特征耦合模塊(FCU)傳給Transformer block。

Transformer block將此局部特征與前一個Trans block的全局特征相加通過當前的trans block,運算結束后再將結果通過FCU模塊反傳給Conv block。

Conv block的最后一個bottleneck將其與經過1x1卷積后的局部特征相加,一起輸入3x3卷積。

之所以將Transformer block夾在兩個3x3卷積之間的原因有兩個:

- bottleneck中3x3卷積的channel比較少,使得FCU的fc層參數不會很大;

- 3x3卷積具有很強的位置先驗信息,保證去掉位置編碼后的性能。

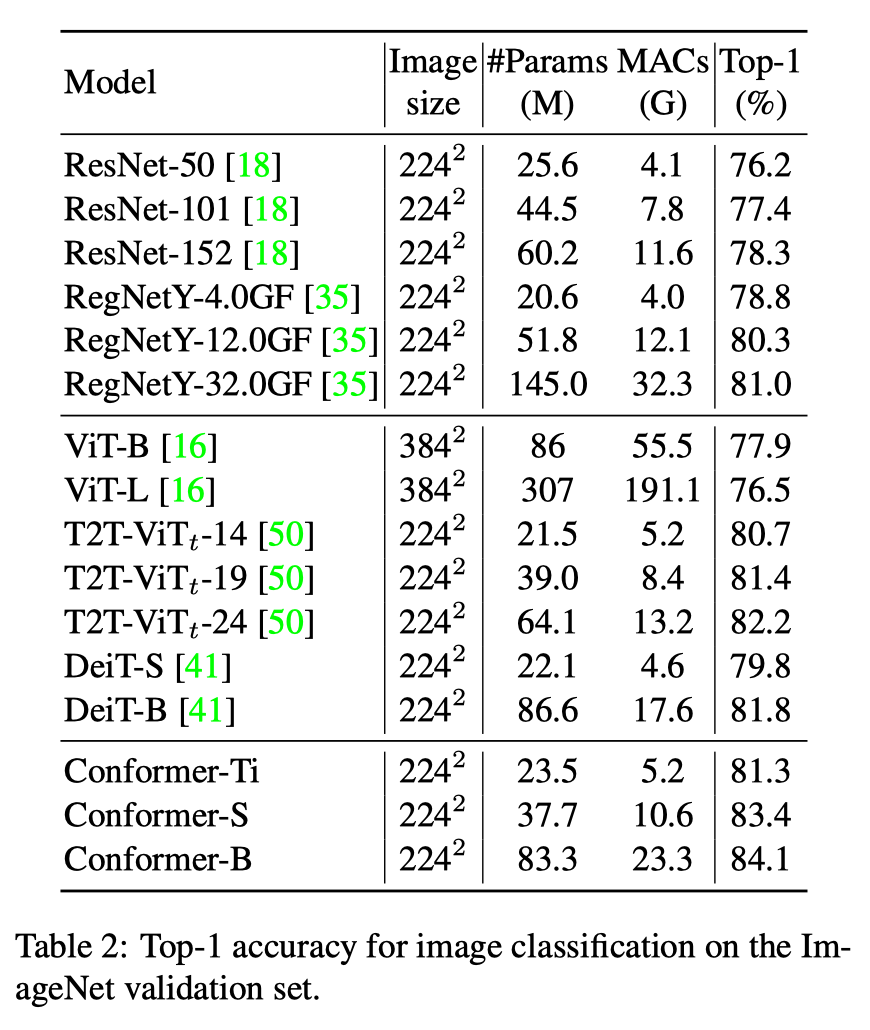

實驗結果

Conformer網絡在ImageNet上做了分類實驗,并做為預訓練模型在MSCOCO上做了目標檢測和實例分割實驗。

分類準確率對比

參數量為37.7M,計算量為10.6GFlops的Conformer-S超過了參數量為86.6M,計算量為17.6GFlops的DeiT-B 約1.6%的準確率。

當Conformer-S增大參數量到83.3M,準確率則是達到84.1%。

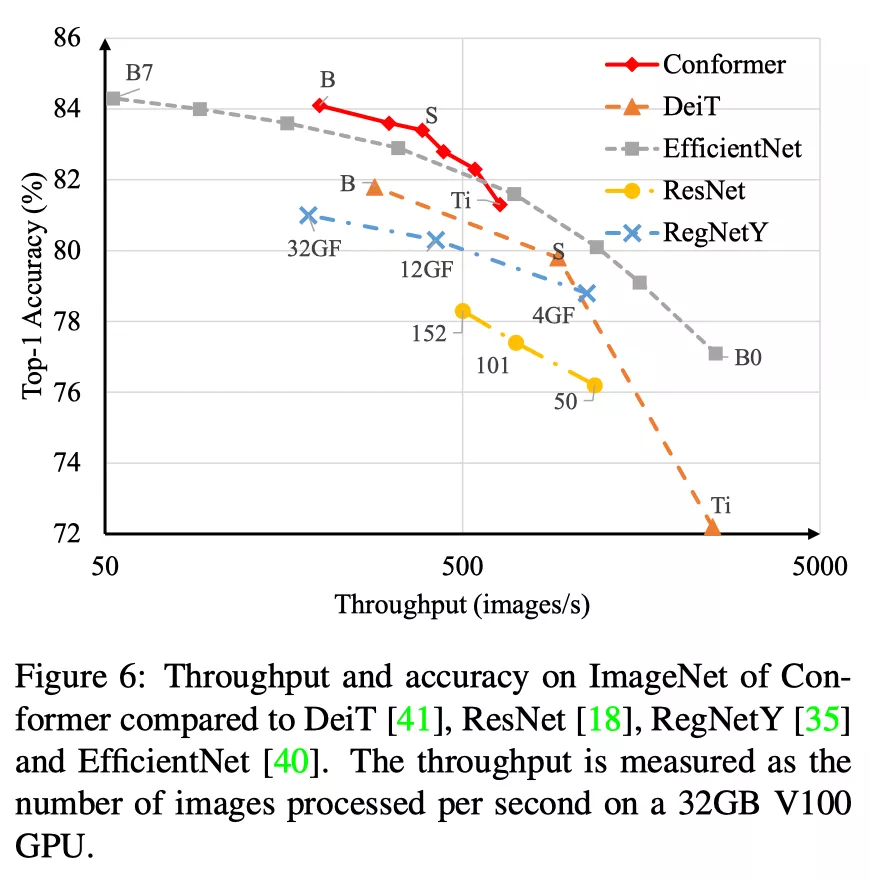

不同基網在分類速度和準確率上的對比:

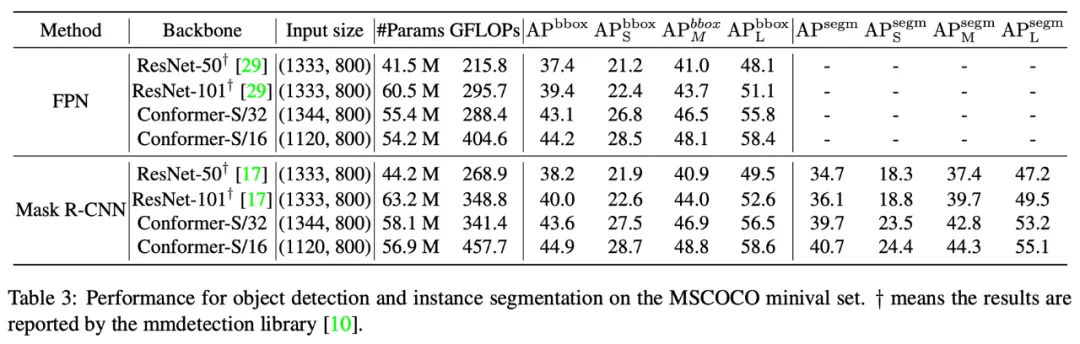

目標檢測和實例分割結果的對比

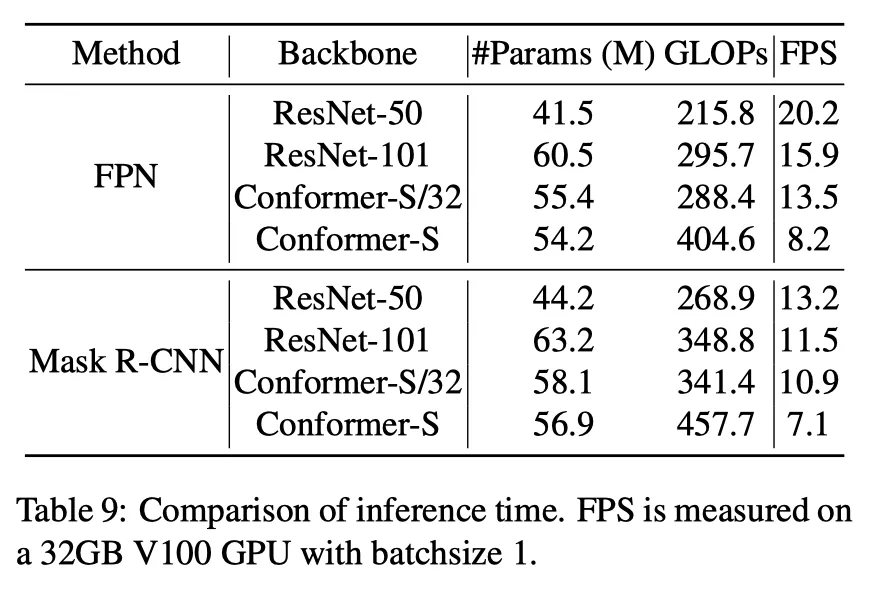

運行幀率為:

目標檢測和實例分割幀率對比

在使用FPN+Faster Mask R-CNN框架時,Conformer-S/32在幀率/參數/計算量可比的情況下,目標檢測精度超過Faster RCNN 3.7%,實例分割超過Mask R-CNN 3.6%。

分析總結

Conformer是第一個并行的CNN和Transformer混合網絡,通過提出的特征耦合模塊FCU在每個階段的局部特征和全局特征都會進行交互,使得Conformer兼具兩者的優勢。

在分類上,能夠以更小的參數和計算量取得更高的準確率,在目標和實例分割上也能一致地取得大幅度的提升。

目前Conformer只是在ImageNet1K數據集合上訓練,其結合更大預訓練數據(如ImageNet21K)集合以后將成為一種很有潛力的基網結構。

作者介紹

彭智亮、黃瑋,中國科學院大學在讀碩士生

顧善植,鵬城實驗室工程師

王耀威,鵬城實驗室研究員

謝凌曦,華為公司研究員

焦建彬、葉齊祥,中國科學院大學教授