最會造假的GAN模型!Facebook發(fā)布IC-GAN,遷移能力史上超強

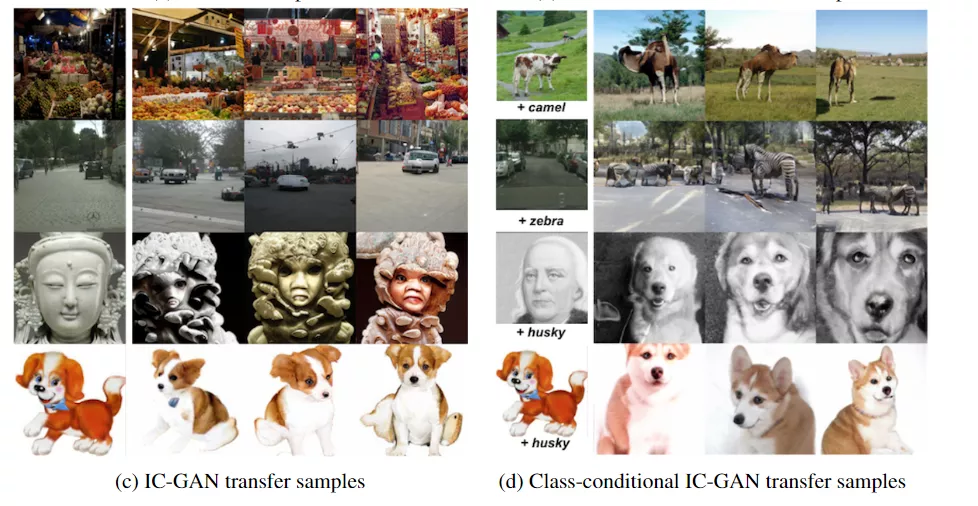

GAN模型好是好,但就是對訓練數(shù)據(jù)的要求太高,并且在場景和物體的語義組合時容易出現(xiàn)不合常理的生成圖像,導致一眼假!最近Facebook發(fā)布了一個IC-GAN模型,遷移能力號稱史上最強,能把各種場景和物體組合起來,訓練集中沒出現(xiàn)過的也能完美復原!甚至把雪地和駱駝放一起都毫無違和感!

生成對抗網(wǎng)絡 (GAN) 在圖像生成領(lǐng)域可以說是最強大的 AI 模型,無論是逼真的圖片、抽象的拼貼畫、風格遷移都不在話下。

但GAN 也有神經(jīng)網(wǎng)絡模型所共有的致命缺點,就是具有局限性,通常只能生成與訓練數(shù)據(jù)集密切相關(guān)的物體或場景的圖像。

例如,在汽車圖像上訓練的 GAN 在生成汽車相關(guān)圖像時可以做到特別逼真,但可能讓它生成鮮花、動物之類的模型就會一眼假,因為生成的圖像可能會違反物理常識等。

Facebook AI Research 為了解決這個問題,提出了一個新模型Instance-Conditioned GAN (IC-GAN) ,可以生成逼真的、沒有見過的圖像組合。

https://arxiv.org/abs/2109.05070

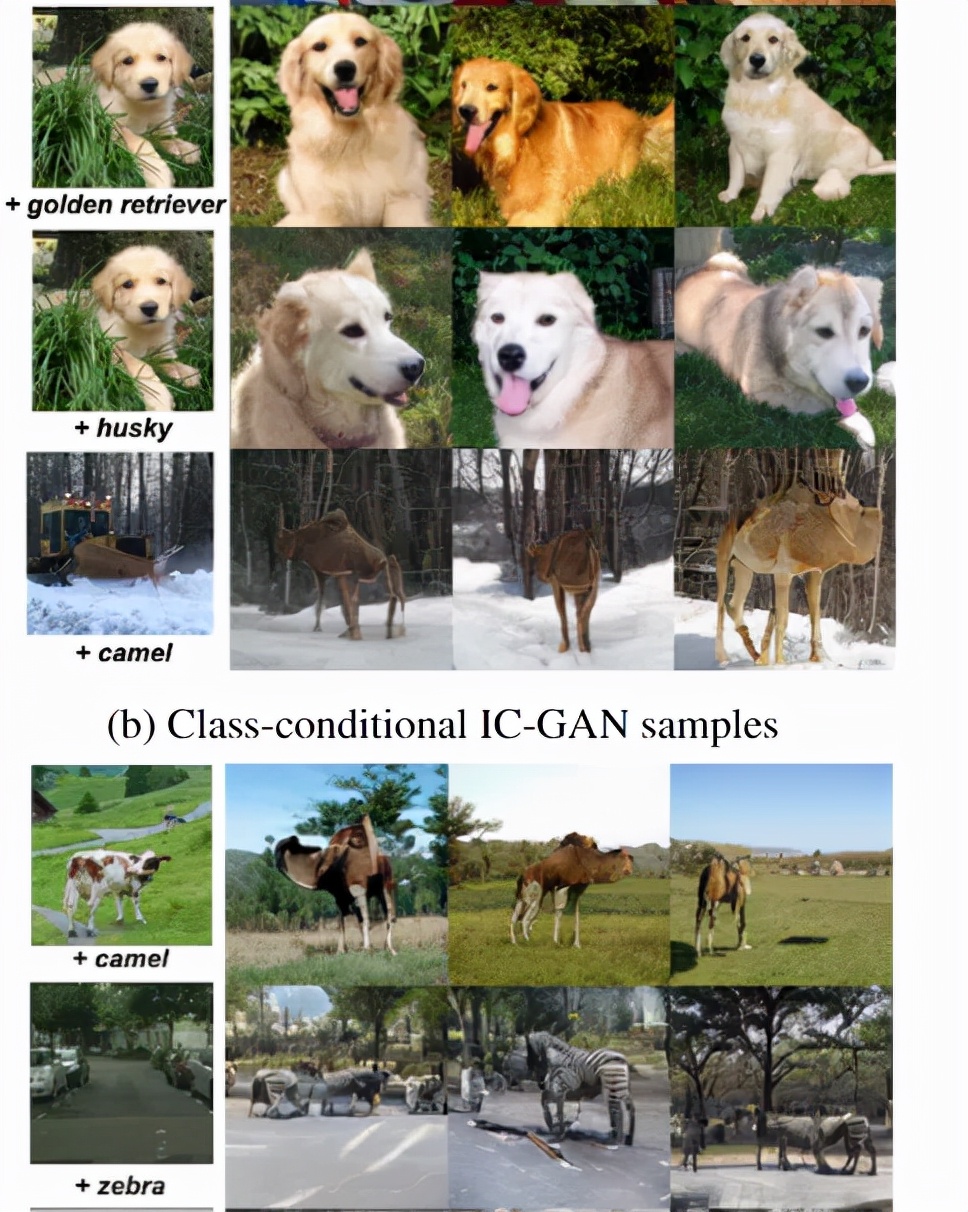

例如雪和駱駝這種照片或者在城市中的斑馬,可以無縫銜接起來。

目前代碼已經(jīng)開源。

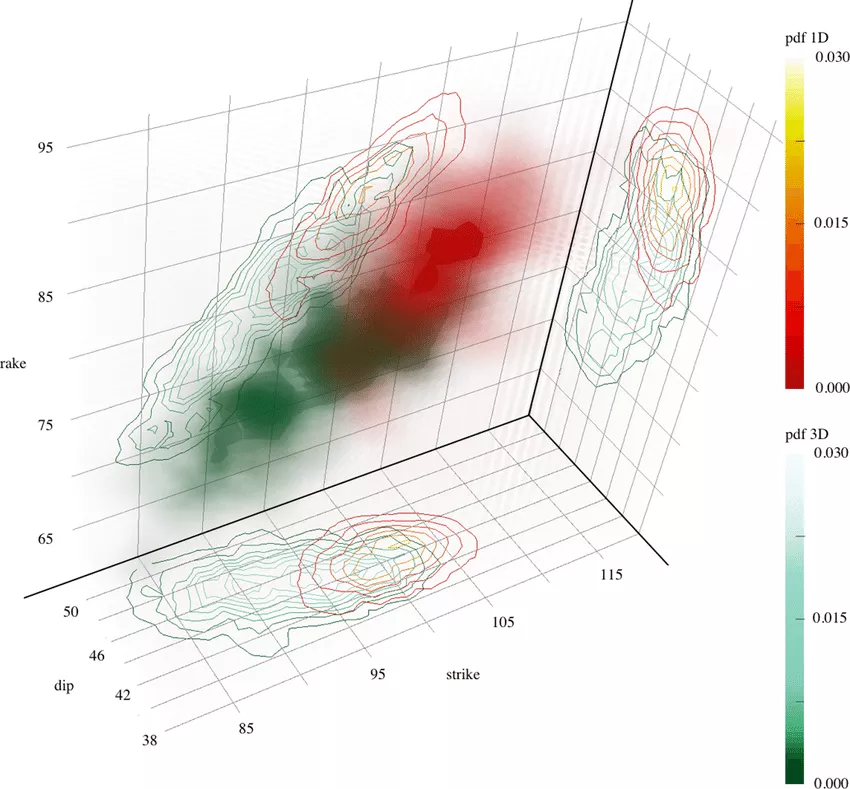

研究人員從核密度估計(kernel density estimation, KDE)技術(shù)中得到啟發(fā),引入了一種非參數(shù)化方法來建模復雜數(shù)據(jù)集的分布。KDE是一種非參數(shù)密度估計器,以參數(shù)化核的混合形式對每個訓練數(shù)據(jù)點周圍的密度進行建模。

IC-GAN可以看作是一種混合密度估計器,其中每個分量都是通過對訓練實例進行條件化得到的。

然而與KDE不同的是,IC-GAN 沒有顯式地對數(shù)據(jù)概率進行建模,而是采用了一種對抗性的方法,其中我們使用一個神經(jīng)網(wǎng)絡隱式地對局部密度進行建模,該神經(jīng)網(wǎng)絡將條件實例和噪聲向量作為輸入。

因此,IC-GAN中的內(nèi)核不再獨立于我們所處理的數(shù)據(jù)點,我們通過選擇實例的鄰域大小來控制平滑度,而不是內(nèi)核帶寬參數(shù),我們從中采樣真實樣本以饋送到鑒別器。

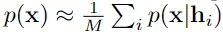

IC-GAN 將數(shù)據(jù)流形劃分為由數(shù)據(jù)點及其最近鄰描述的重疊鄰域的混合物,IC-GAN模型能夠?qū)W習每個數(shù)據(jù)點周圍的分布。通過在條件實例周圍選擇一個足夠大的鄰域,可以避免將數(shù)據(jù)過度劃分為小的聚類簇。

當給定一個具有M個數(shù)據(jù)樣本的未標記數(shù)據(jù)集的嵌入函數(shù)f,首先使用無監(jiān)督或自我監(jiān)督訓練得到f來提取實例特征(instance features)。

然后使用余弦相似度為每個數(shù)據(jù)樣本定義k個最近鄰的集合。

使用生成器隱式地模擬條件分布p(x | hi) 時,生成器從單位高斯先驗z∼ N(0, 1)變換樣本從條件分布中抽取樣本x,其中hi是從訓練數(shù)據(jù)中抽取的實例xi的特征向量。

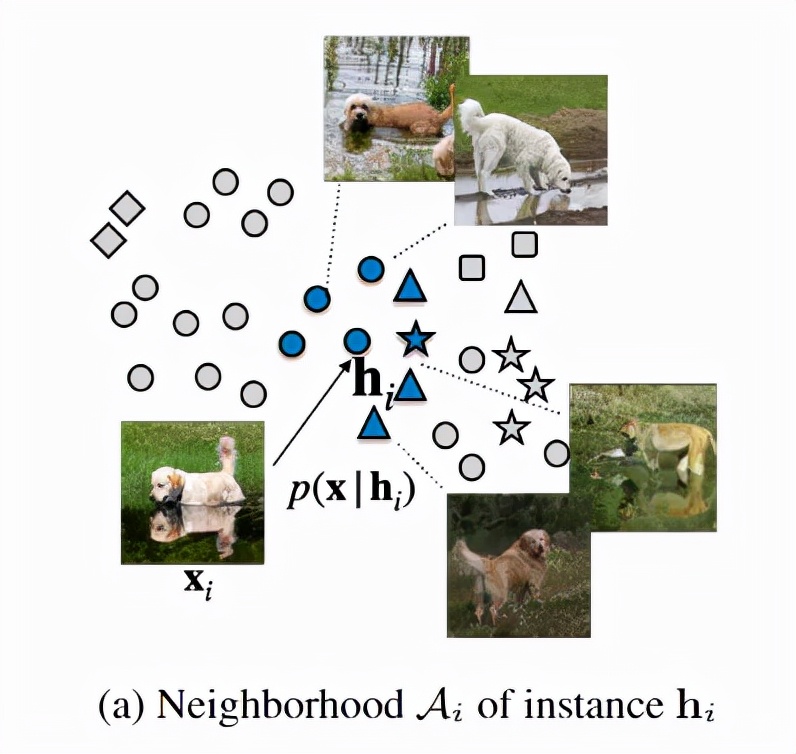

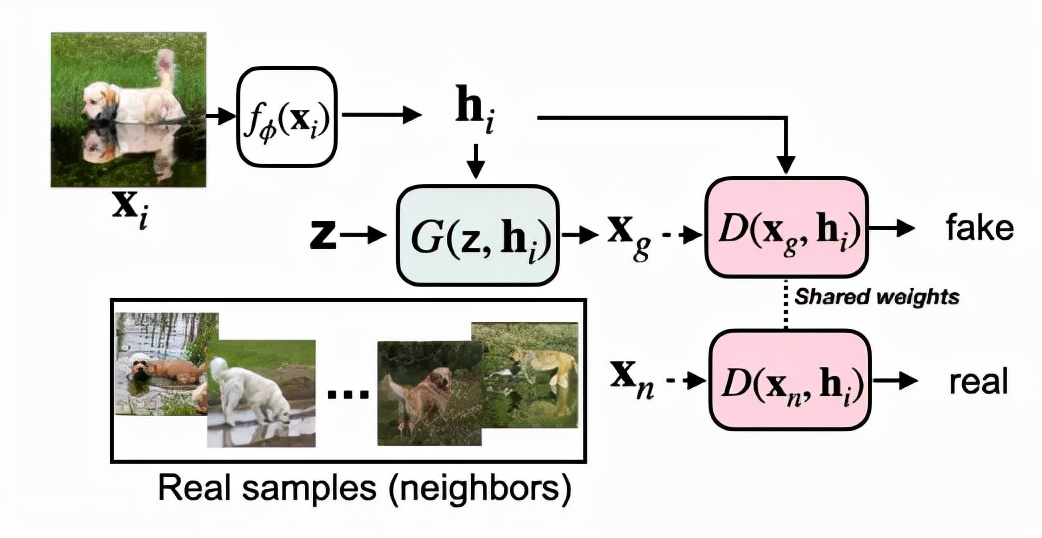

在IC-GAN中,采用對抗式方法來訓練生成器,因此生成器與判別器可以聯(lián)合訓練,判別器用來區(qū)分hi的真實相鄰節(jié)點和生成的相鄰點。對于每個hi,真實鄰居都從Ai中均勻采樣。

生成器 G和判別器 D都參與了一個兩人最小-最大博弈,在博弈中,二者試圖找到目標的納什均衡的等式。

在訓練IC-GAN時,使用所有可用的訓練數(shù)據(jù)點來微調(diào)模型。在推理時,與KDE等非參數(shù)密度估計方法一樣,IC-GAN的生成器也需要實例特征,這些特征可能來自于訓練分布或不同的分布。

并且這種方法可以擴展到具有類條件(class condition)的生成上。通過在類標簽y上添加一個額外的生成器和判別器,可以讓IC-GAN 用于有類條件的生成。IC-GAN 通過向生成器和判別器提供實例的表示作為額外的輸入,并通過使用實例的鄰居作為鑒別器的真實樣本,學習對數(shù)據(jù)點(也稱為實例)的鄰域的分布建模。

與對離散簇索引進行條件處理不同,對實例表示進行條件處理自然會導致生成器為相似實例生成相似樣本。并且一旦訓練完成,IC-GAN可以通過在推理時簡單地交換條件實例,輕松地遷移到訓練期間未看到的其他數(shù)據(jù)集。

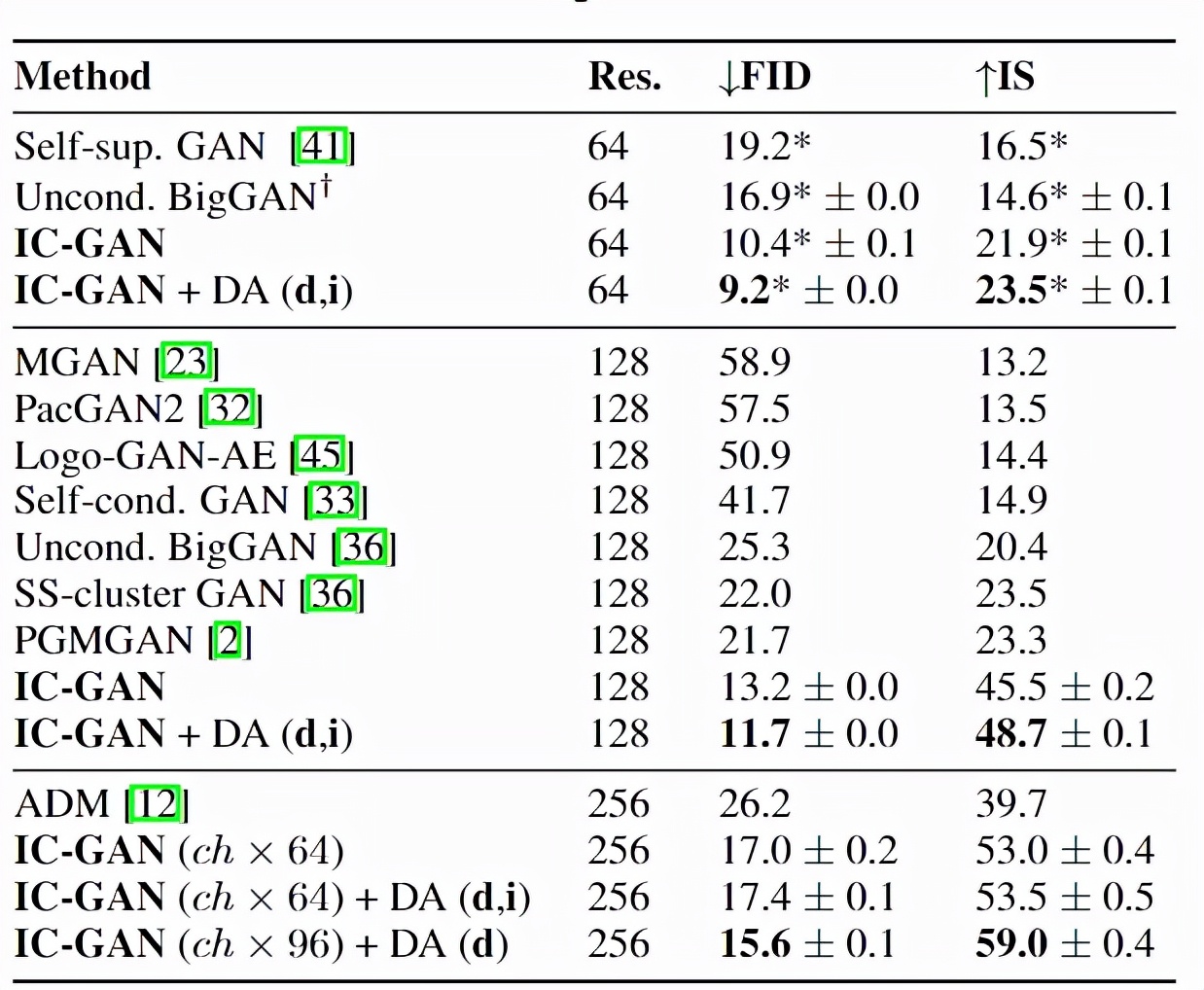

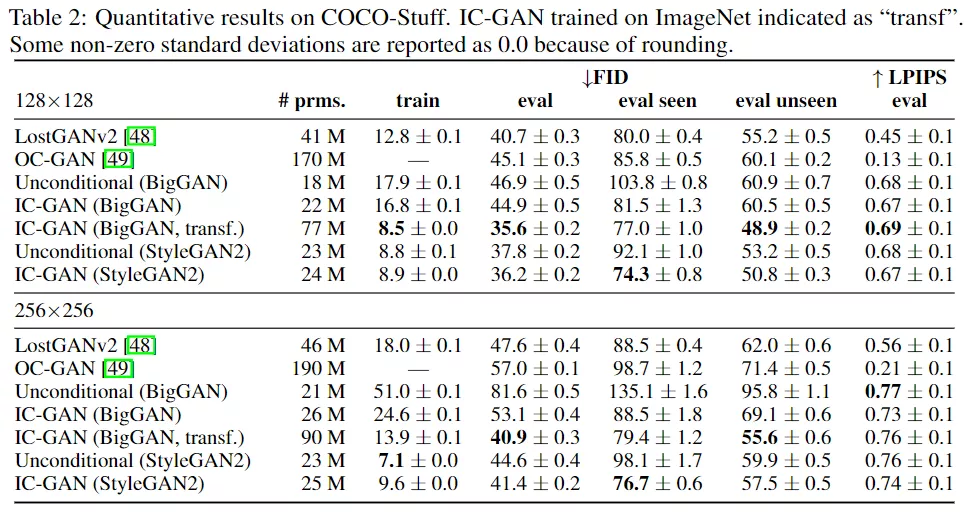

實驗部分研究人員使用了ImageNet和COCO Stuff數(shù)據(jù)集,實驗結(jié)果表明,與無條件模型和無監(jiān)督數(shù)據(jù)分割基線相比,IC-GAN顯著提高了性能。

非選擇性的基線模型BigGAN 是通過將訓練集中的所有標簽設置為零來訓練的,IC-GAN在FID和IS分數(shù)方面均以64×64和128×128分辨率超過了所有以前的方法,并可以在高分辨率下生成更高的質(zhì)量的圖像。

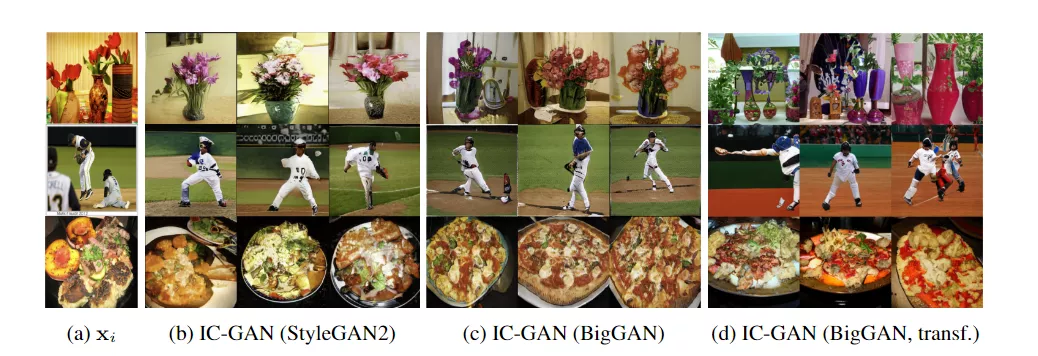

在進行遷移實驗時,首先使用ImageNet上使用BigGAN架構(gòu)訓練IC-GAN,并在測試時使用COCO Stuff實例生成圖像,這種數(shù)據(jù)分割模式都包含未見過的對象組合方式。在ImageNet上訓練的IC-GAN在所有分割方面都優(yōu)于在COCO Stuff上訓練的相同模型:在128分辨率下8.5比16.8訓練FID。

為了研究ImageNet和COCO Stuff數(shù)據(jù)分布的接近程度,研究人員以128×128分辨率計算了兩個數(shù)據(jù)集的實際數(shù)據(jù)序列分割之間的FID 得分為37.2。

因此,IC-GAN的顯著遷移能力不能用數(shù)據(jù)集的相似性來解釋,而可以歸因于ImageNet預先訓練的特征提取器和生成器的有效性。

將COCO Stuff中的條件實例替換為ImageNet中的條件實例時,可以得到43.5的訓練FID分數(shù),強調(diào)了通過改變條件實例可以實現(xiàn)的重要分布遷移。

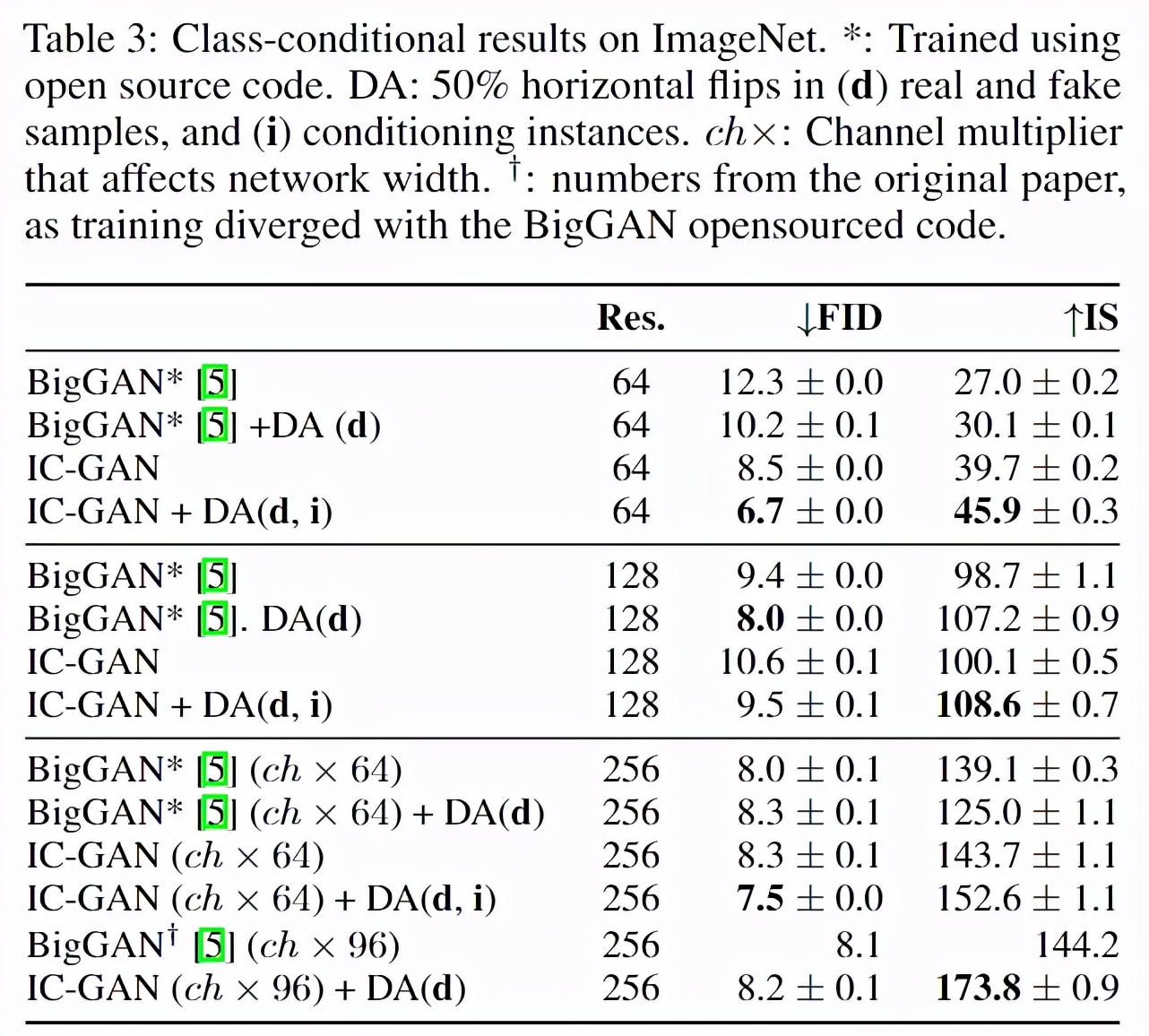

研究人員將IC-GAN擴展到類條件情況,并在ImageNet上顯示語義可控生成和可比的量化結(jié)果。

類條件IC-GAN在FID和所有分辨率方面都優(yōu)于BigGAN,除了FID在128×128分辨率下的分數(shù)。與BigGAN不同,IC-GAN可以通過固定實例特征和交換類條件,或者通過固定類條件和交換實例特征來控制生成圖像的語義。

生成的圖像保留了類標簽和實例的語義,可以在相似的背景下生成不同的狗品種,或在雪地中生成駱駝,在ImageNet中屬于未知場景。

憑借這些新功能,IC-GAN 可用于創(chuàng)建新的視覺示例,以擴充數(shù)據(jù)集以包含不同的對象和場景;為藝術(shù)家和創(chuàng)作者提供更廣泛、更有創(chuàng)意的 AI 生成內(nèi)容;并推進高質(zhì)量圖像生成的研究。