GAN歸來:模型大幅簡化,訓練更穩定,逆襲擴散模型,AI社區瘋傳

2025 年了,GAN 能否擊敗擴散模型?答案是 Yes!

本周五,AI 社區開始討論一種全新極簡主義 GAN(生成對抗網絡)。

現代版 GAN 基準論文成為了周五 HuggingFace 熱度最高的研究。該論文也入選了 NeurIPS 2024。

它并不像以往那樣走 tricks 路徑 —— 通過一場「現代化」改造,GAN 現在可以進行更長時間的訓練(與擴散模型的訓練步驟數相當),一旦 GAN 訓練時間足夠長,并且架構足夠強大,它們就可以勝過擴散模型,并成為更好、更快、更小的模型。

來自布朗大學、康奈爾大學的研究者們表示,通過引入一個新的損失函數,我們就可以解決以往 GAN 模式崩潰(collapse)和不穩定性的問題。

為了證明可行性,他們測試了 GAN 里流行的 StyleGAN2,通過新的理論進行最簡升級(修改后改名為「R3GAN」)。結果雖然模型變得更簡單了,但 R3GAN 在圖像生成和數據增強任務上性能還是超過了所有 GAN 模型和擴散模型。

新的方法給未來的研究奠定了一個更為整潔、可擴展的基礎。

- 論文鏈接:https://arxiv.org/abs/2501.05441

- GitHub 鏈接:https://github.com/brownvc/R3GAN

- HuggingFace:https://huggingface.co/spaces/multimodalart/R3GAN

有一種廣泛流傳的說法認為 GAN 很難訓練,并且文獻中的 GAN 架構充斥著大量的經驗性 tricks。但是作者團隊提供了反駁這一說法的證據,并以更有原則的方式建立了一個現代版 GAN 基線。

在該研究中,作者首先通過推導出一個行為良好的正則化相對 GAN 損失函數,解決了模式 dropping 和不收斂問題,而這些問題在以前經常是通過大量 ad-hoc tricks 來應對的。他們從數學層面分析了這一損失函數,并證明它具有局部收斂保證,這與大多數現有的相對損失函數不同。

其次,這個損失函數能夠拋棄所有的 ad-hoc tricks,并用現代版架構替代常見的 GAN 中所使用的過時的骨干網絡。以 StyleGAN2 為例,他們展示了一個簡化過的現代版路線圖 ——R3GAN(Re-GAN)。盡管方法非常簡單,但它在 FFHQ、ImageNet、CIFAR 和 Stacked MNIST 數據集上卻超越了 StyleGAN2,并且在與最先進的 GAN 和擴散模型的比較中表現出色。

在生成式 AI 技術興起之前,GAN 是 AI 領域中的熱門研究方向,該方法能讓我們能夠在一次前向傳遞中生成高質量圖像。然而我們無法忽略的是,Goodfellow 等人構建的原始目標因其極小極大特性而極難優化,訓練的不穩定性一直對 GAN 的研究產生著負面影響。

與擴散模型等其他生成模型相比,GAN 的發展一直比較緩慢。考慮到一旦得到了表現良好的損失函數,我們就可以自由地設計現代 SOTA 主干架構。在新工作中,作者剝離了 StyleGAN 的所有功能,找出那些必不可少的功能,然后從現代 ConvNets 和 transformer 中借用了架構設計,包括一系列 ResNet 設計、初始化、重采樣、分組卷積、no normalization 等,引出了一種比 StyleGAN 更簡單的設計。

該工作率先從數學上證明了 GAN 不需要通過改進的正則化損失來進行訓練。

提高訓練穩定性

該研究證明,通過將目標進展與正則化訓練損失結合起來,GAN 獲得了更高的訓練穩定性,能夠用現代骨干網絡升級 GAN。

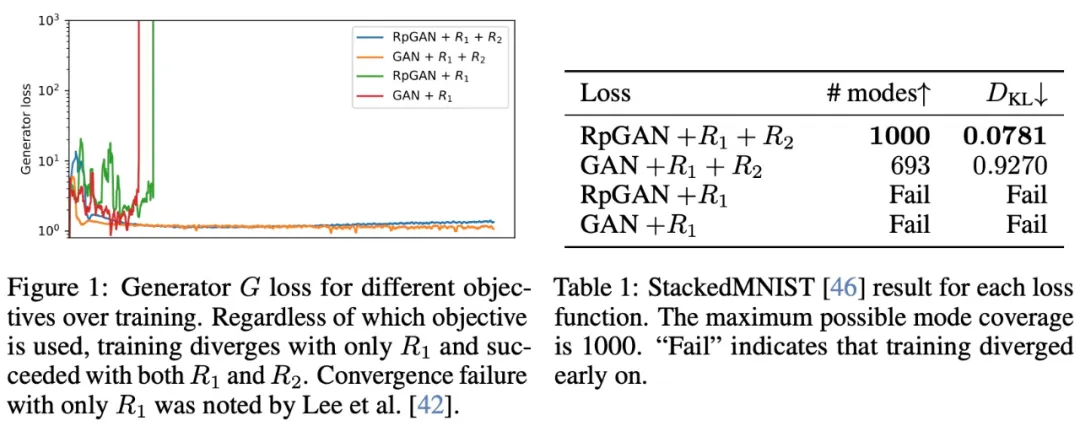

首先,該研究提出了一個新的目標,通過零中心梯度懲罰增強 RpGAN,提高穩定性。該研究從數學上證明,梯度懲罰 RpGAN 與正則化經典 GAN 享有相同的局部收斂保證,并且刪除正則化方案會導致不收斂。

在定義 GAN 的目標時,研究者需要應對兩個挑戰:穩定性和多樣性。為了在這兩方面同時取得進展,該研究將 stable 方法與基于理論的簡單正則化器結合起來。

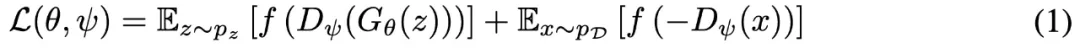

傳統 GAN 被表述為判別器 D_ψ 和生成器 G_θ 之間的極小極大博弈:

在實際實現中,傳統 GAN 容易受到兩種常見故障場景的影響:模式 collapse/dropping 和不收斂。

該研究采用了一種略有不同的極小極大博弈 ——RpGAN,由 Jolicoeur-Martineau 等人提出,以解決模式 dropping 問題。

一般的 RpGAN 定義為:

然而,經驗表明,未正則化的 RpGAN 表現不佳。

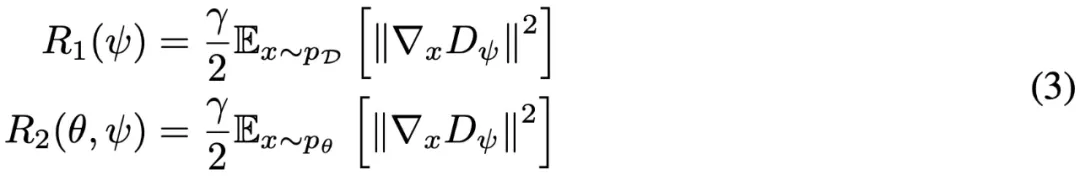

為了解決 RpGAN 不收斂的問題,該研究探索梯度懲罰作為解決方案,因為事實證明,零中心梯度懲罰 (0-GP) 有助于經典 GAN 的收斂訓練。兩個最常用的 0-GP 是 R1 和 R2:

研究團隊認為實際的解決方案是在真實數據和虛假數據上對 D 進行正則化。此外,如 Fang et al.(2022) 所言,真實數據和虛假數據具有大致相同的梯度范數可能會減少判別器過擬合。

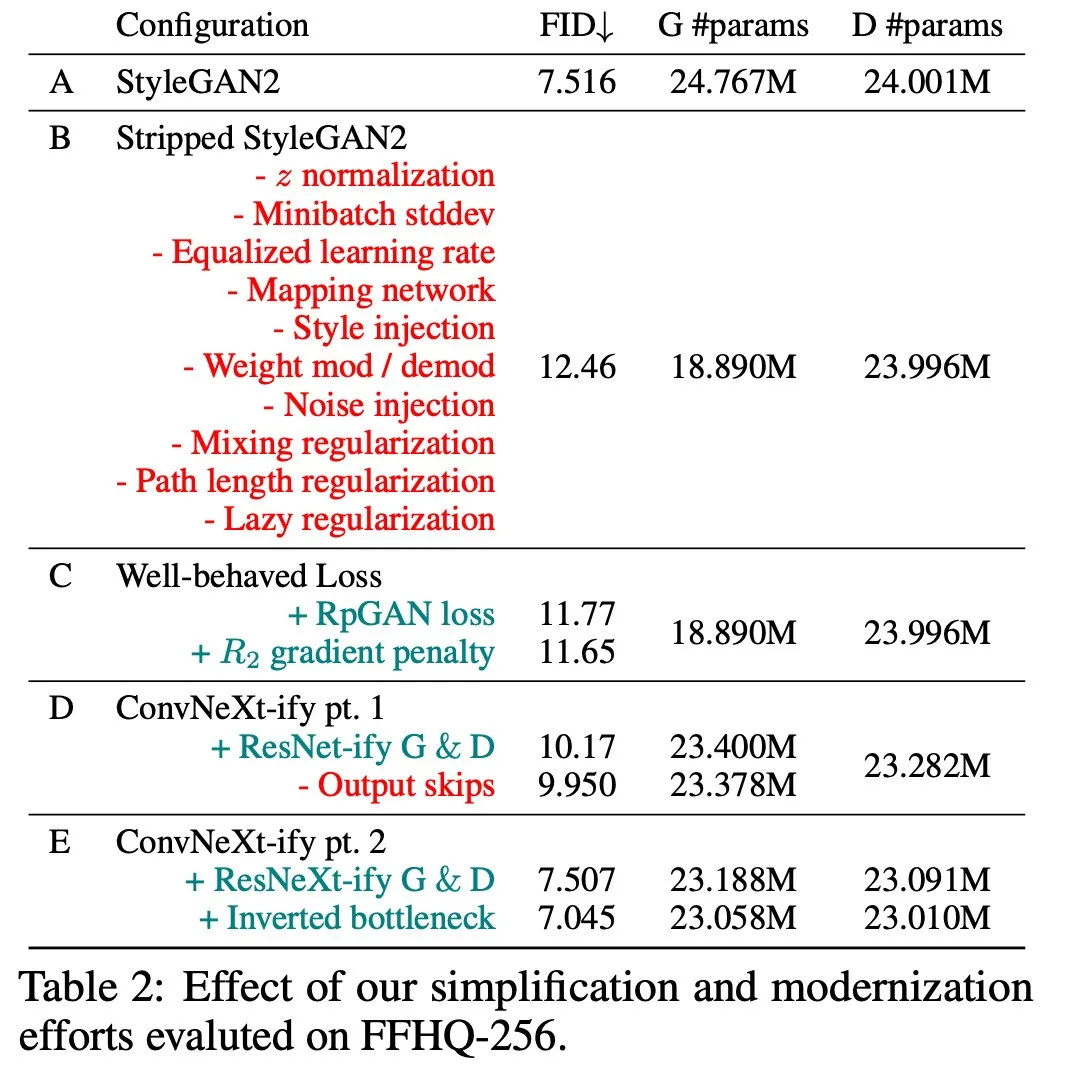

新基線的路線圖 — R3GAN

行為良好的 RpGAN + R1 + R2 損失函數緩解了 GAN 優化中的問題,同時根據近期的骨干網絡進展,這使他們能夠構建一個極簡版基線 ——R3GAN。這不僅僅只是提出一種新方法,而是從 StyleGAN2 基線中繪制出一條路線圖。

這個模型(配置 A)包括一個類似于 VGG 的骨干網絡(G),一個 ResNet(D),一些有助于基于風格生成的 tricks,以及許多作為修補弱骨干網絡的 tricks。接著去除了 StyleGAN2 中所有非必要的特性(配置 B),并應用他們的損失函數(配置 C),逐步現代化網絡骨干(配置 D-E)。

架構比較

實驗細節

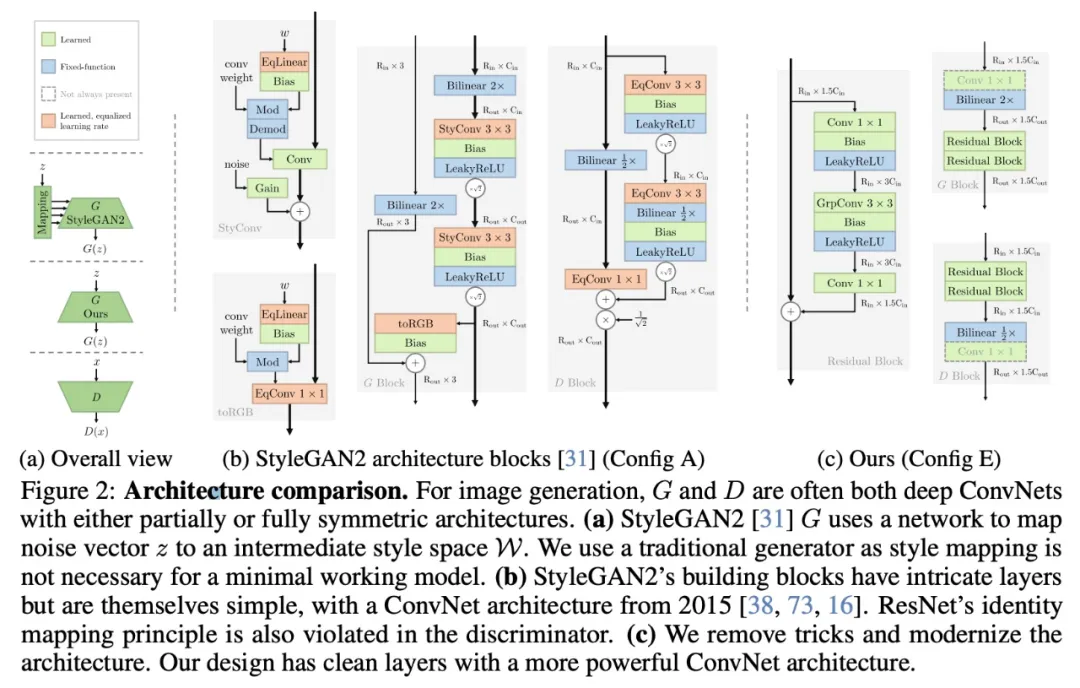

模式恢復 — StackedMNIST

研究團隊在 StackedMNIST(無條件生成)上重復了之前在 1000-mode 收斂實驗中的做法,但這一次使用了更新后的架構,并與最先進的 GAN 及基于似然的方法進行了比較。

在 Stacked-MNIST 上使用配置 E 生成的樣本定性示例

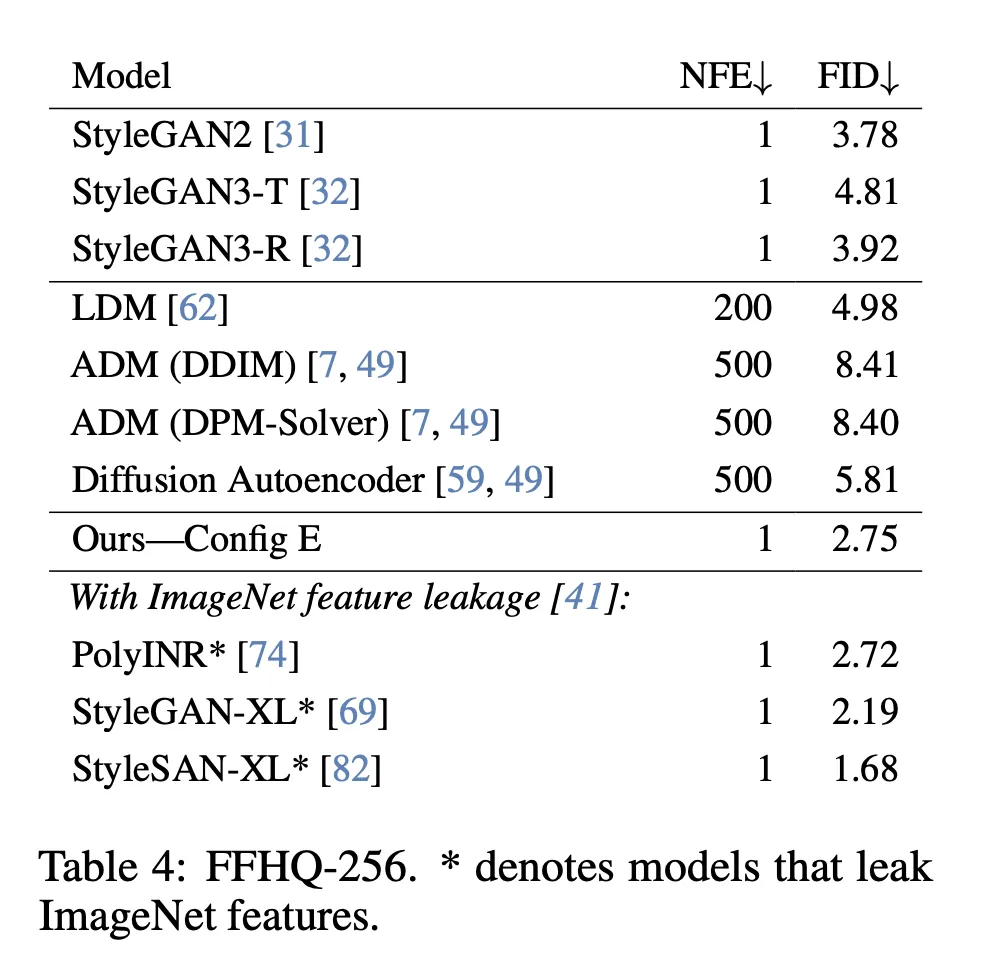

FID — FFHQ-256

研究者訓練配置 E 模型直到收斂,并在 FFHQ 數據集上使用優化的超參數和訓練計劃進行 256×256 分辨率的無條件生成。

在 FFHQ-256 上使用配置 E 生成的樣本定性示例

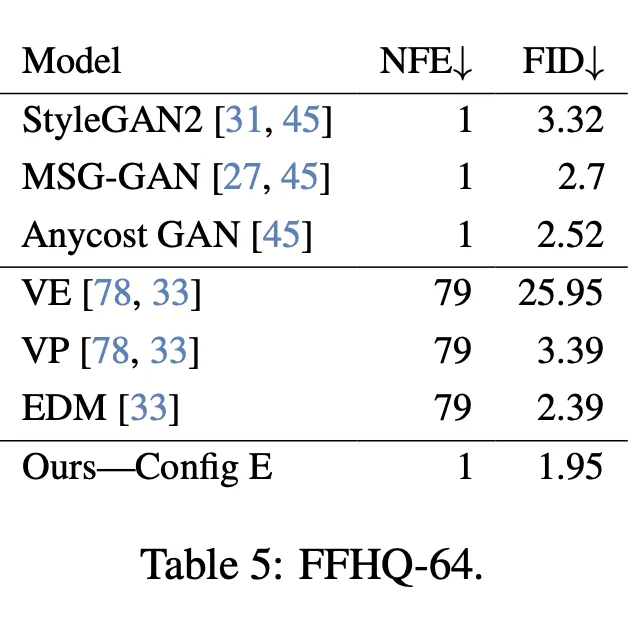

FID — FFHQ-64

為了與 EDM 進行直接比較,研究團隊在 64×64 分辨率的 FFHQ 數據集上評估了模型。為此,他們去除了 256×256 模型中的兩個最高分辨率階段,從而得到了一個生成器,其參數數量不到 EDM 的一半。盡管如此,他們的模型在該數據集上的表現仍是超過了 EDM,并且只需要一次函數評估。

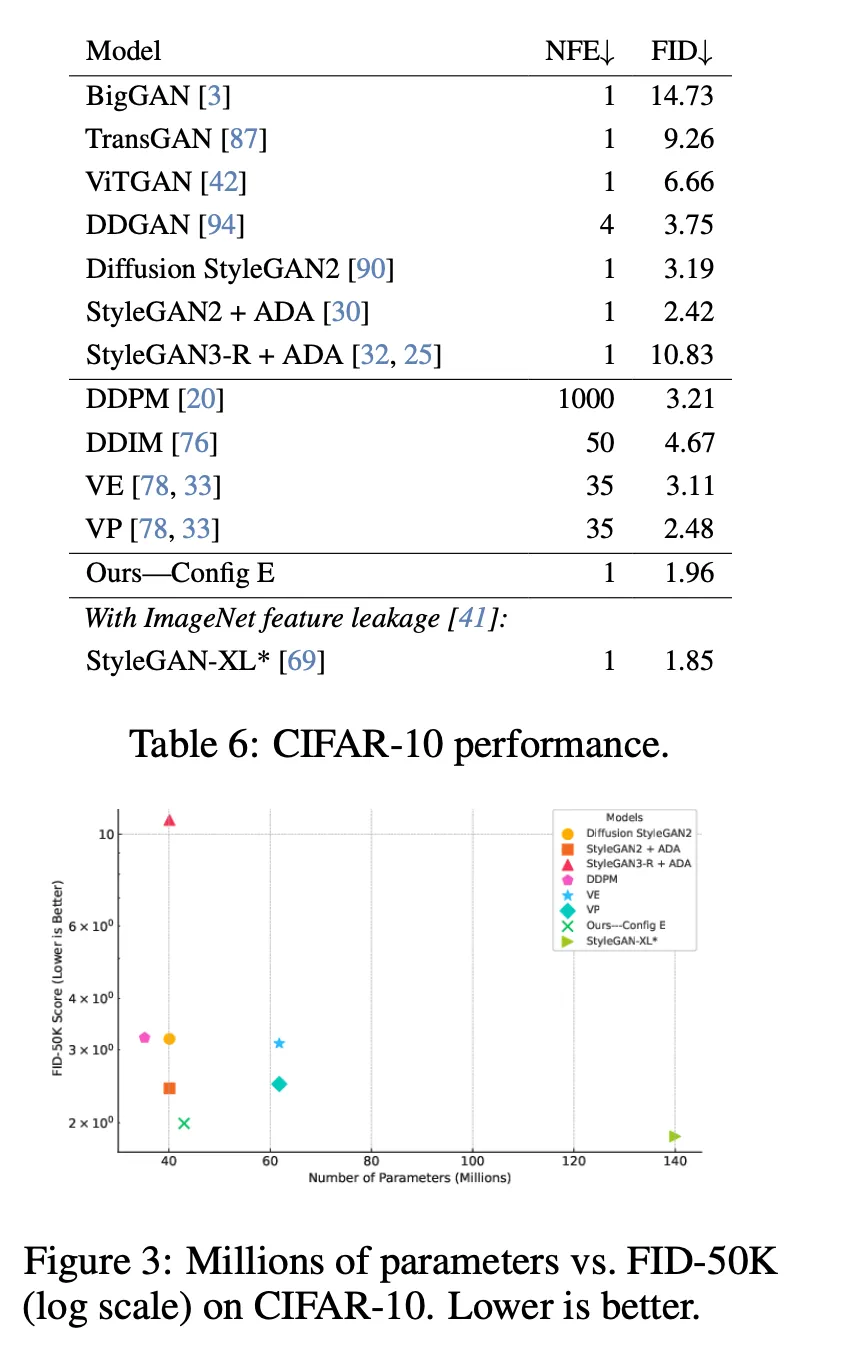

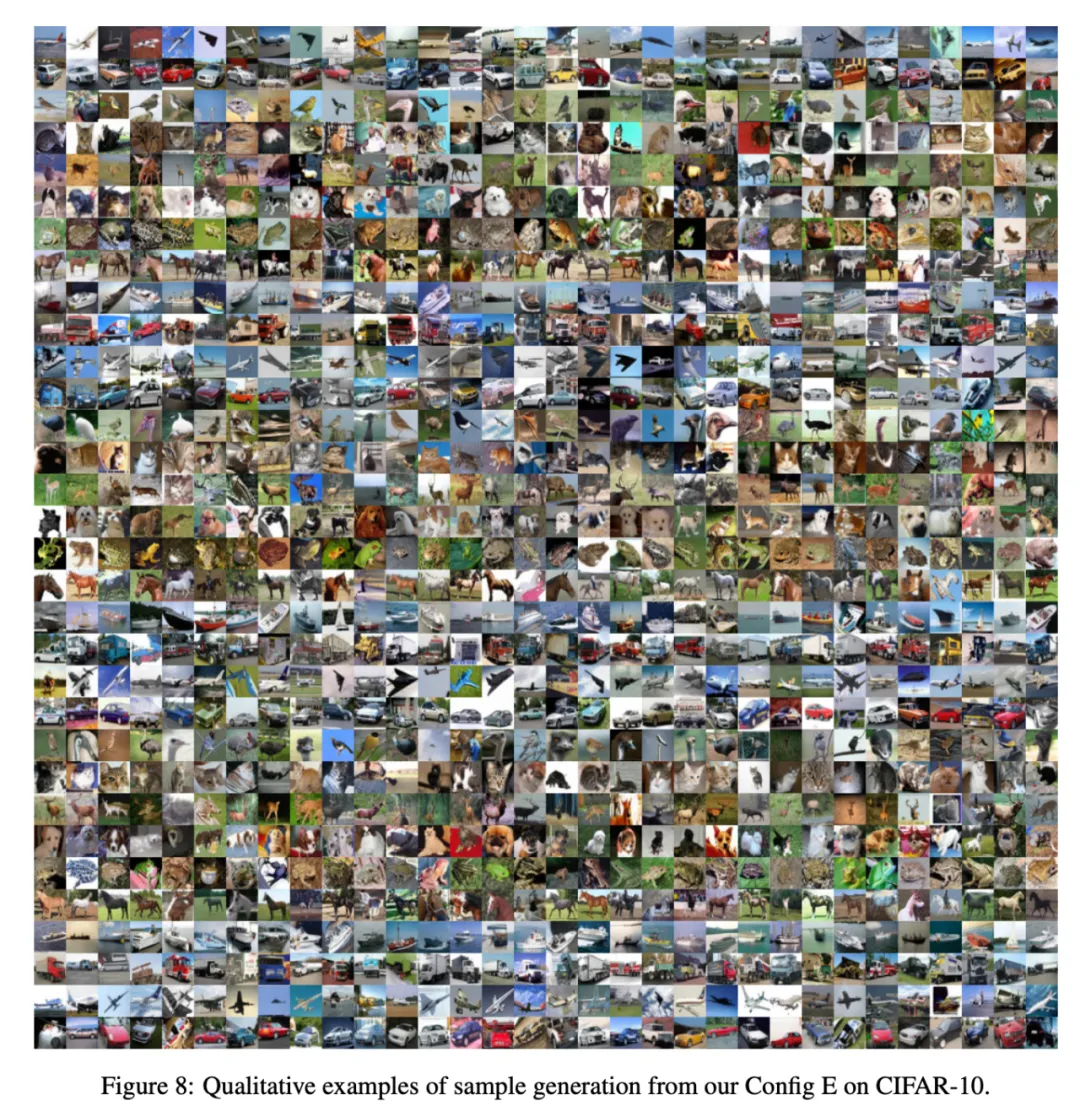

FID — CIFAR-10

研究者訓練配置 E 模型直到收斂,并在 CIFAR-10 數據集上使用優化的超參數和訓練計劃進行條件生成。盡管模型容量相對較小,他們的方法在 FID 指標上超過了許多其他 GAN 模型。

在 CIFAR-10 上使用配置 E 生成的樣本的定性示例

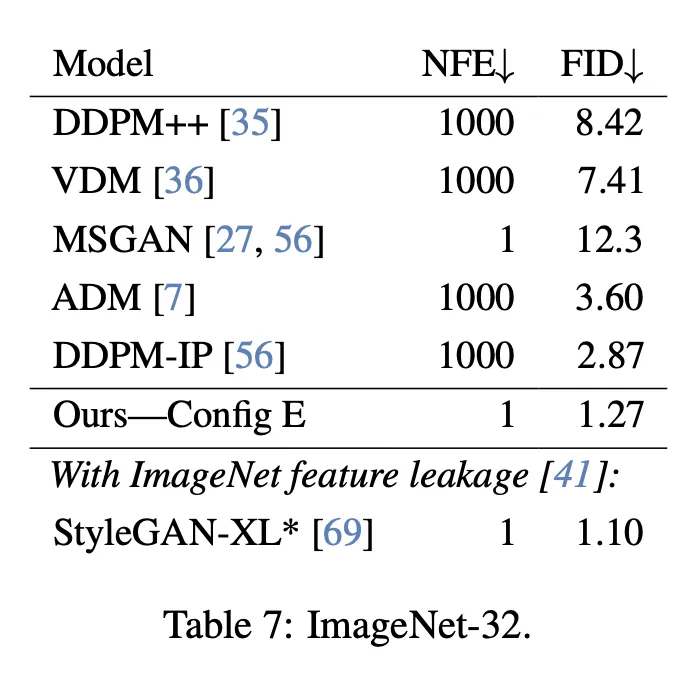

FID — ImageNet-32

研究者訓練配置 E 模型直到收斂,在 ImageNet-32 數據集上使用優化的超參數和訓練計劃進行條件生成,并與近期的 GAN 模型和擴散模型進行了比較(見下圖)。

作者團隊調整了模型生成器的參數數量,使其與 StyleGAN-XL 的生成器相匹配(84M 參數)。盡管使用了比判別器小 60% 的模型,并且沒有使用預訓練的 ImageNet 分類器,該方法仍然達到了可媲美的 FID 值。

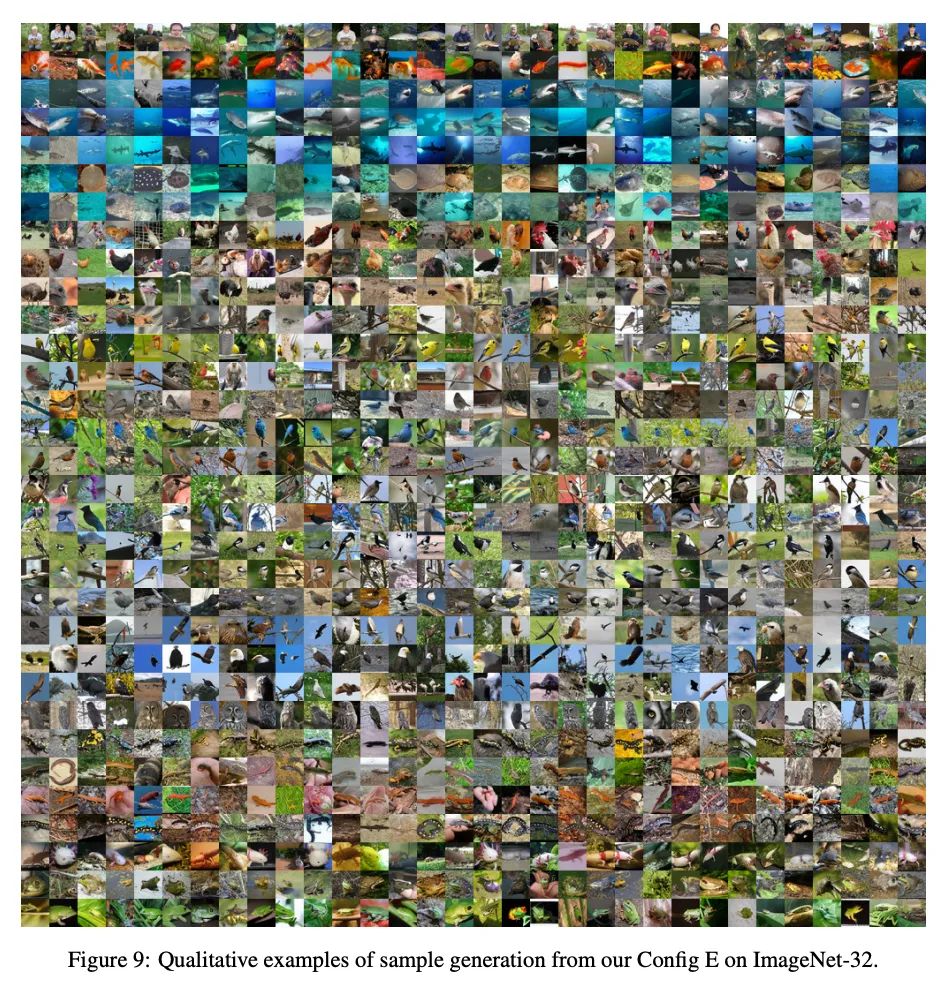

在 ImageNet-32 上使用配置 E 生成的樣本定性示例

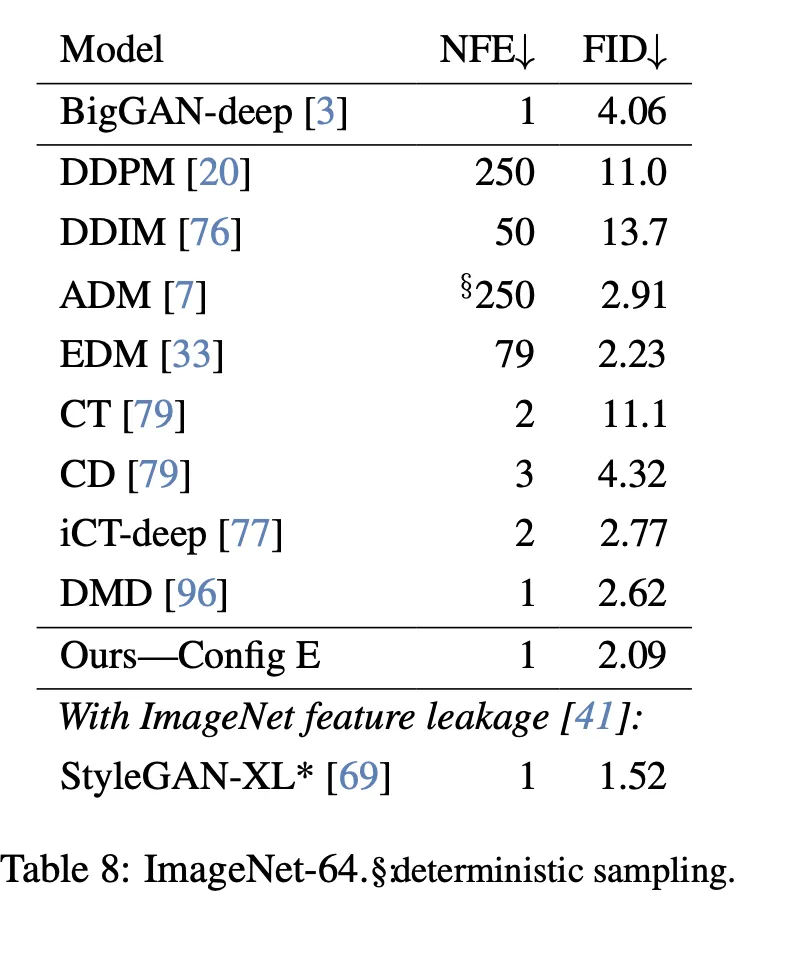

FID — ImageNet-64

研究團隊在 ImageNet-64 數據集上評估了他們的模型,以測試其可擴展性。他們在 ImageNet-32 模型的基礎上增加了一個分辨率階段,從而得到了一個包含 104M 參數的生成器。該模型的參數量幾乎是依賴于 ADM 骨干網絡的擴散模型 的三分之一,這些模型的參數量大約為 300M。

盡管模型較小,并且他們的模型在一步生成樣本的同時,其在 FID 指標上超越了更大參數量的擴散模型(見下圖)。

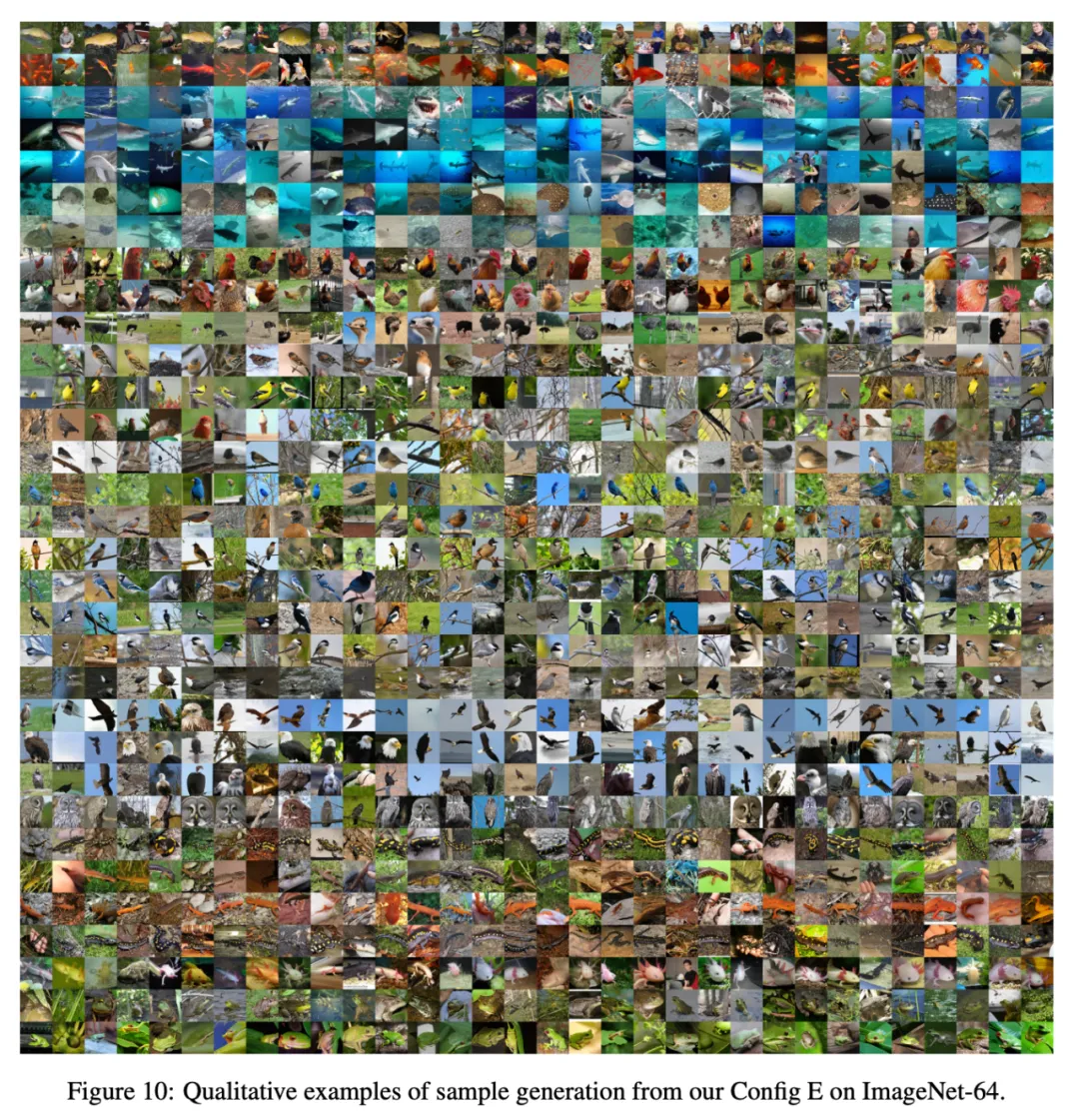

在 ImageNet-64 上使用配置 E 生成的樣本定性示例

新 GAN 研究正在社區獲得越來越多的關注。StabilityAI 的研究總監也轉發了該篇論文,并對作者團隊去除了 StyleGAN 中許多復雜性并且提高性能一點,給出了高度評價。

GAN 加入了現代化元素之后,是否可以重新起航逆襲 Stable Diffusion?對此,你怎么看?