深度強(qiáng)化學(xué)習(xí)探索算法最新綜述,近200篇文獻(xiàn)揭示挑戰(zhàn)和未來(lái)方向

當(dāng)前,強(qiáng)化學(xué)習(xí)(包括深度強(qiáng)化學(xué)習(xí)DRL和多智能體強(qiáng)化學(xué)習(xí)MARL)在游戲、機(jī)器⼈等領(lǐng)域有⾮常出⾊的表現(xiàn),但盡管如此,在達(dá)到相同⽔平的情況下,強(qiáng)化學(xué)習(xí)所需的樣本量(交互次數(shù))還是遠(yuǎn)遠(yuǎn)超過(guò)⼈類(lèi)的。這種對(duì)⼤量交互樣本的需求,嚴(yán)重阻礙了強(qiáng)化學(xué)習(xí)在現(xiàn)實(shí)場(chǎng)景下的應(yīng)⽤。為了提升對(duì)樣本的利⽤效率,智能體需要⾼效率地探索未知的環(huán)境,然后收集⼀些有利于智能體達(dá)到最優(yōu)策略的交互數(shù)據(jù),以便促進(jìn)智能體的學(xué)習(xí)。近年來(lái),研究⼈員從不同的⻆度研究RL中的探索策略,取得了許多進(jìn)展,但尚⽆⼀個(gè)全⾯的,對(duì)RL中的探索策略進(jìn)⾏深度分析的綜述。

最新綜述,近200篇文獻(xiàn)揭示挑戰(zhàn)和未來(lái)方向">

最新綜述,近200篇文獻(xiàn)揭示挑戰(zhàn)和未來(lái)方向">論文地址:https://arxiv.org/pdf/2109.06668.pdf

本⽂介紹深度強(qiáng)化學(xué)習(xí)領(lǐng)域第⼀篇系統(tǒng)性的綜述⽂章Exploration in Deep Reinforcement Learning: A Comprehensive Survey。該綜述⼀共調(diào)研了將近200篇⽂獻(xiàn),涵蓋了深度強(qiáng)化學(xué)習(xí)和多智能體深度強(qiáng)化學(xué)習(xí)兩⼤領(lǐng)域近100種探索算法。總的來(lái)說(shuō),該綜述的貢獻(xiàn)主要可以總結(jié)為以下四⽅⾯:

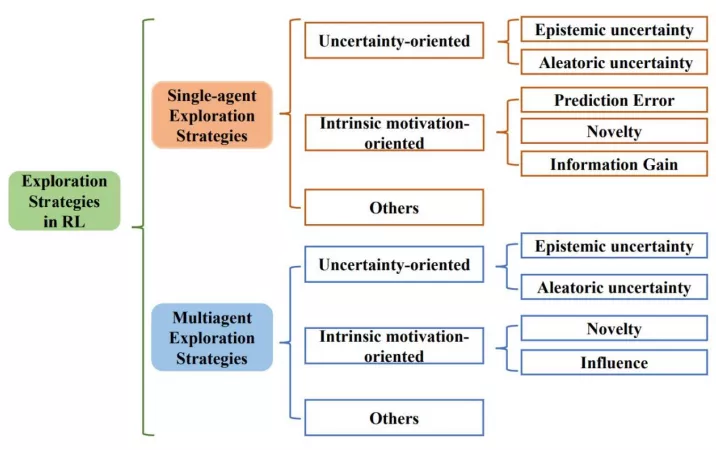

- 三類(lèi)探索算法。該綜述⾸次提出基于⽅法性質(zhì)的分類(lèi)⽅法,根據(jù)⽅法性質(zhì)把探索算法主要分為基于不確定性的探索、基于內(nèi)在激勵(lì)的探索和其他三⼤類(lèi),并從單智能體深度強(qiáng)化學(xué)習(xí)和多智能體深度強(qiáng)化學(xué)習(xí)兩⽅⾯系統(tǒng)性地梳理了探索策略。

- 四⼤挑戰(zhàn)。除了對(duì)探索算法的總結(jié),綜述的另⼀⼤特點(diǎn)是對(duì)探索挑戰(zhàn)的分析。綜述中⾸先分析了探索過(guò)程中主要的挑戰(zhàn),同時(shí),針對(duì)各類(lèi)⽅法,綜述中也詳細(xì)分析了其解決各類(lèi)挑戰(zhàn)的能⼒。

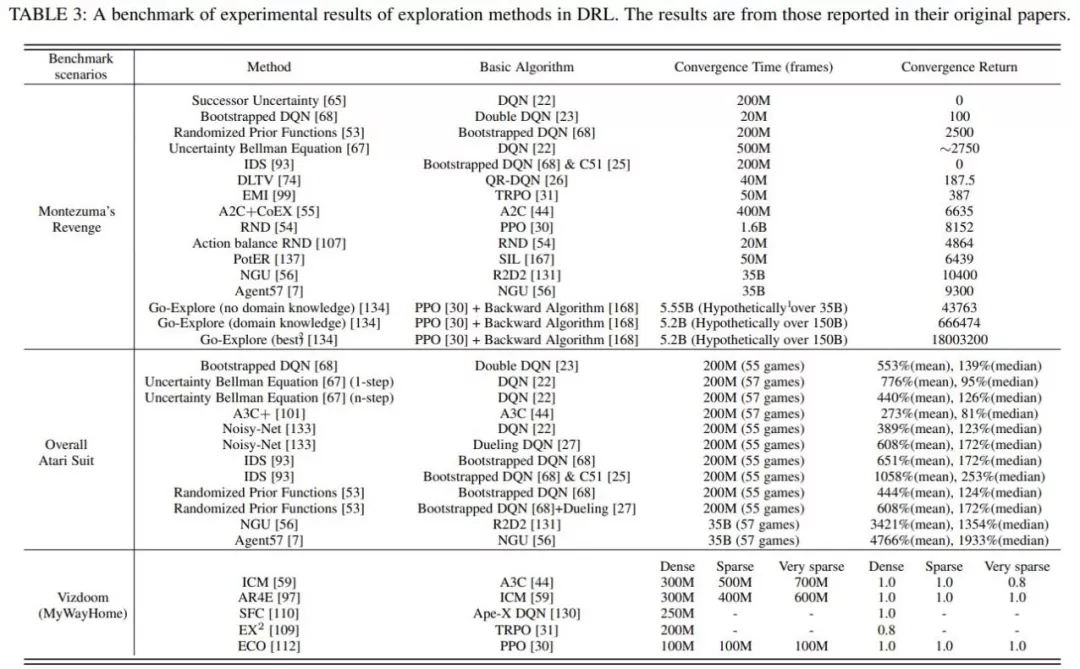

- 三個(gè)典型benchmark。該綜述在三個(gè)典型的探索benchmark中提供了具有代表性的DRL探索⽅法的全⾯統(tǒng)⼀的性能⽐較。

- 五點(diǎn)開(kāi)放問(wèn)題。該綜述分析了現(xiàn)在尚存的亟需解決和進(jìn)⼀步提升的挑戰(zhàn),揭⽰了強(qiáng)化學(xué)習(xí)探索領(lǐng)域的未來(lái)研究⽅向。

接下來(lái),本⽂從綜述的四⼤貢獻(xiàn)⽅⾯展開(kāi)介紹。

三類(lèi)探索算法

最新綜述,近200篇文獻(xiàn)揭示挑戰(zhàn)和未來(lái)方向">

最新綜述,近200篇文獻(xiàn)揭示挑戰(zhàn)和未來(lái)方向">上圖展⽰了綜述所遵循的分類(lèi)⽅法。綜述從單智能體深度強(qiáng)化學(xué)習(xí)算法中的探索策略、多智能體深度強(qiáng)化學(xué)習(xí)算法中的探索策略?xún)?#12068;⽅向系統(tǒng)性地梳理了相關(guān)⼯作,并分別分成三個(gè)⼦類(lèi):⾯向不確定性的(Uncertainty-oriented)探索策略、⾯向內(nèi)在激勵(lì)的(Intrinsic motivation oriented)探索策略、以及其他策略。

1、⾯向不確定性的探索策略

通常遵循“樂(lè)觀(guān)對(duì)待不確定性”的指導(dǎo)原則(OFU Principle)「1」。這類(lèi)做法認(rèn)為智能體對(duì)某區(qū)域更⾼的不確定性(Uncertainty)往往是因?yàn)閷?duì)該區(qū)域不充分的探索導(dǎo)致的,因此樂(lè)觀(guān)地對(duì)待不確定性,也即引導(dǎo)智能體去探索不確定性⾼的地⽅,可以實(shí)現(xiàn)⾼效探索的⽬的。

強(qiáng)化學(xué)習(xí)中⼀般考慮兩類(lèi)不確定性,其中引導(dǎo)往認(rèn)知不確定性⾼的區(qū)域探索可以促進(jìn)智能體的學(xué)習(xí),但訪(fǎng)問(wèn)環(huán)境不確定性⾼的區(qū)域不但不會(huì)促進(jìn)智能體學(xué)習(xí)過(guò)程,反⽽由于環(huán)境不確定性的⼲擾會(huì)影響到正常學(xué)習(xí)過(guò)程。因此,更合理的做法是在樂(lè)觀(guān)對(duì)待認(rèn)知不確定性引導(dǎo)探索的同時(shí),盡可能地避免訪(fǎng)問(wèn)環(huán)境不確定性更⾼的區(qū)域。基于此,根據(jù)是否在探索中考慮了環(huán)境不確定性,綜述中將這類(lèi)基于不確定性的探索策略分為兩個(gè)⼩類(lèi)。

第⼀類(lèi)只考慮在認(rèn)知不確定性的引導(dǎo)下樂(lè)觀(guān)探索,典型⼯作有RLSVI「2」、Bootstrapped DQN「3」、OAC「4」、OB2I「5」等;第⼆類(lèi)在樂(lè)觀(guān)探索的同時(shí)考慮避免環(huán)境不確定性的影響,典型⼯作有IDS「6」、DLTV「7」等。

2、⾯向內(nèi)在激勵(lì)信號(hào)的探索策略

⼈類(lèi)通常會(huì)通過(guò)不同⽅式的⾃我激勵(lì),積極主動(dòng)地與世界交互并獲得成就感。受此啟發(fā),內(nèi)在激勵(lì)信號(hào)導(dǎo)向的探索⽅法通常通過(guò)設(shè)計(jì)內(nèi)在獎(jiǎng)勵(lì)來(lái)創(chuàng)造智能體的成就感。從設(shè)計(jì)內(nèi)在激勵(lì)信號(hào)所使⽤的技術(shù),單智能體⽅法中⾯向內(nèi)在激勵(lì)信號(hào)的探索策略可分為三類(lèi),也即估計(jì)環(huán)境動(dòng)⼒學(xué)預(yù)測(cè)誤差的⽅法、狀態(tài)新穎性估計(jì)⽅法和基于信息增益的⽅法。⽽在多智能體問(wèn)題中,⽬前的探索策略主要通過(guò)狀態(tài)新穎性和社會(huì)影響兩個(gè)⻆度考慮設(shè)計(jì)內(nèi)在激勵(lì)信號(hào)。

估計(jì)環(huán)境動(dòng)⼒學(xué)預(yù)測(cè)誤差的⽅法主要是基于預(yù)測(cè)誤差,⿎勵(lì)智能體探索具有更⾼預(yù)測(cè)誤差的狀態(tài),典型⼯作有ICM「8」、EMI「9」等。

狀態(tài)新穎性⽅法不局限于預(yù)測(cè)誤差,⽽是直接通過(guò)衡量狀態(tài)的新穎性(Novelty),將其作為內(nèi)在激勵(lì)信號(hào)引導(dǎo)智能體探索更新穎的狀態(tài),典型⼯作有RND「10」、Novelty Search「11」、LIIR「12」等。

基于信息增益的⽅法則將信息獲取作為內(nèi)在獎(jiǎng)勵(lì),旨在引導(dǎo)智能體探索未知領(lǐng)域,同時(shí)防⽌智能體過(guò)于關(guān)注隨機(jī)領(lǐng)域,典型⼯作有VIME「13」等。

而在多智能體強(qiáng)化學(xué)習(xí)中,有⼀類(lèi)特別的探索策略通過(guò)衡量“社會(huì)影響”,也即衡量智能體對(duì)其他智能體的影響作⽤,指導(dǎo)作為內(nèi)在激勵(lì)信號(hào),典型⼯作有EITI和 EDTI「14」等。

3、其他

除了上述兩⼤類(lèi)主流的探索算法,綜述⾥還調(diào)研了其他⼀些分⽀的⽅法,從其他⻆度進(jìn)⾏有效的探索。這些⽅法為如何在DRL中實(shí)現(xiàn)通⽤和有效的探索提供了不同的見(jiàn)解。

這主要包括以下三類(lèi),⼀是基于分布式的探索算法,也即使⽤具有不同探索行為的異構(gòu)actor,以不同的⽅式探索環(huán)境,典型⼯作包括Ape-x「15」、R2D2「16」等。⼆是基于參數(shù)空間噪聲的探索,不同于對(duì)策略輸出增加噪聲,采⽤噪聲對(duì)策略參數(shù)進(jìn)⾏擾動(dòng),可以使得探索更加多樣化,同時(shí)保持⼀致性,典型⼯作包括NoisyNet「17」等。除了以上兩類(lèi),綜述還介紹了其他⼏種不同思路的探索⽅法,包括Go-Explore「18」,MAVEN「19」等。

四大挑戰(zhàn)

綜述重點(diǎn)總結(jié)了⾼效的探索策略主要⾯臨的四⼤挑戰(zhàn)。

- ⼤規(guī)模狀態(tài)動(dòng)作空間。狀態(tài)動(dòng)作空間的增加意味著智能體需要探索的空間變⼤,就⽆疑導(dǎo)致了探索難度的增加。

- 稀疏、延遲獎(jiǎng)勵(lì)信號(hào)。稀疏、延遲的獎(jiǎng)勵(lì)信號(hào)會(huì)使得智能體的學(xué)習(xí)⾮常困難,⽽探索機(jī)制合理與否直接影響了學(xué)習(xí)效率。

- 觀(guān)測(cè)中的⽩噪聲。現(xiàn)實(shí)世界的環(huán)境通常具有很⾼的隨機(jī)性,即狀態(tài)或動(dòng)作空間中通常會(huì)出現(xiàn)不可預(yù)測(cè)的內(nèi)容,在探索過(guò)程中避免⽩噪聲的影響也是提升效率的重要因素。

- 多智能體探索挑戰(zhàn)。多智能體任務(wù)下,除了上述挑戰(zhàn),指數(shù)級(jí)增長(zhǎng)的狀態(tài)動(dòng)作空間、智能體間協(xié)同探索、局部探索和全局探索的權(quán)衡都是影響多智能體探索效率的重要因素。

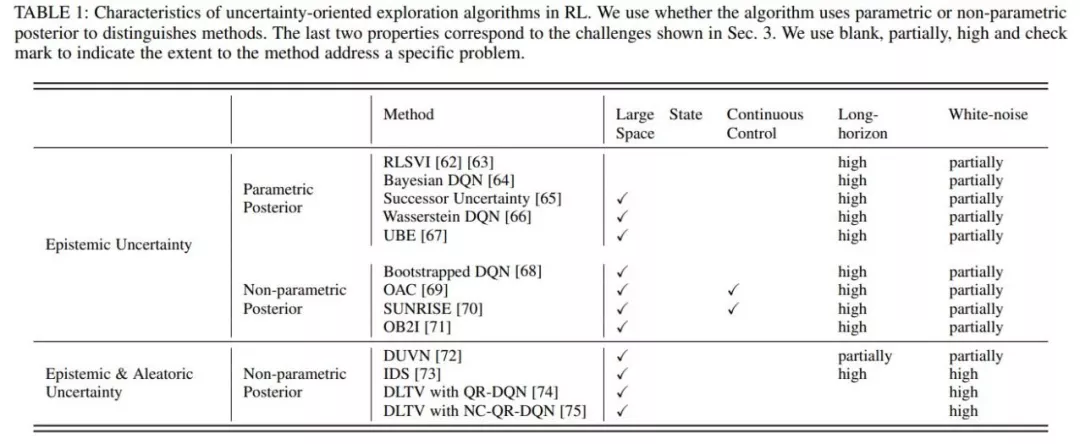

綜述中總結(jié)了這些挑戰(zhàn)產(chǎn)⽣的原因,及可能的解決⽅法,同時(shí)在詳細(xì)介紹⽅法的部分,針對(duì)現(xiàn)有⽅法對(duì)這些挑戰(zhàn)的應(yīng)對(duì)能⼒進(jìn)⾏了詳細(xì)的分析。如下圖就分析了單智能體強(qiáng)化學(xué)習(xí)中基于不確定性的探索⽅法解決這些挑戰(zhàn)的能⼒。

最新綜述,近200篇文獻(xiàn)揭示挑戰(zhàn)和未來(lái)方向">

最新綜述,近200篇文獻(xiàn)揭示挑戰(zhàn)和未來(lái)方向">三個(gè)經(jīng)典的benchmark

為了對(duì)不同的探索⽅法進(jìn)⾏統(tǒng)⼀的實(shí)驗(yàn)評(píng)價(jià),綜述總結(jié)了上述⼏種有代表性的⽅法在三個(gè)代表性 benchmark上的實(shí)驗(yàn)結(jié)果: 《蒙特祖瑪?shù)膹?fù)仇》,雅達(dá)利和Vizdoom。

蒙特祖瑪?shù)膹?fù)仇由于其稀疏、延遲的獎(jiǎng)勵(lì)成為⼀個(gè)較難解決的任務(wù),需要RL智能體具有較強(qiáng)的探索能⼒才能獲得正反饋;⽽穿越多個(gè)房間并獲得⾼分則進(jìn)⼀步需要⼈類(lèi)⽔平的記憶和對(duì)環(huán)境中事件的控制。

整個(gè)雅達(dá)利系列側(cè)重于對(duì)提⾼RL 智能體學(xué)習(xí)性能的探索⽅法進(jìn)⾏更全⾯的評(píng)估。

Vizdoom是另⼀個(gè)具有多種獎(jiǎng)勵(lì)配置(從密集到⾮常稀疏)的代表性任務(wù)。與前兩個(gè)任務(wù)不同的是,Vizdoom是⼀款帶有第⼀⼈稱(chēng)視⻆的導(dǎo)航(和射擊)游戲。這模擬了⼀個(gè)具有嚴(yán)重的局部可觀(guān)測(cè)性和潛在空間結(jié)構(gòu)的學(xué)習(xí)環(huán)境,更類(lèi)似于⼈類(lèi)⾯對(duì)的現(xiàn)實(shí)世界的學(xué)習(xí)環(huán)境。

最新綜述,近200篇文獻(xiàn)揭示挑戰(zhàn)和未來(lái)方向">

最新綜述,近200篇文獻(xiàn)揭示挑戰(zhàn)和未來(lái)方向">基于上表所⽰的統(tǒng)⼀的實(shí)驗(yàn)結(jié)果,結(jié)合所提出的探索中的主要挑戰(zhàn),綜述中詳細(xì)分析了各類(lèi)探索策略在這些任務(wù)上的優(yōu)劣。

關(guān)于探索策略的開(kāi)放問(wèn)題和未來(lái)方向

盡管探索策略的研究取得了⾮常前沿的進(jìn)展,但是仍然存在⼀些問(wèn)題沒(méi)有被完全解決。綜述主要從以下五個(gè)⻆度討論了尚未解決的問(wèn)題。

- 在⼤規(guī)模動(dòng)作空間的探索。在⼤規(guī)模動(dòng)作空間上,融合表征學(xué)習(xí)、動(dòng)作語(yǔ)義等⽅法,降低探索算法的計(jì)算復(fù)雜度仍然是⼀個(gè)急需解決的問(wèn)題。

- 在復(fù)雜任務(wù)(時(shí)間步較長(zhǎng)、極度稀疏、延遲的獎(jiǎng)勵(lì)設(shè)置)上的探索,雖然取得了一定的進(jìn)展,⽐如蒙特祖瑪?shù)膹?fù)仇,但這些解決辦法代價(jià)通常較⼤,甚⾄要借助⼤量⼈類(lèi)先驗(yàn)知識(shí)。這其中還存在較多普遍性的問(wèn)題值得探索。

- ⽩噪聲問(wèn)題。現(xiàn)有的⼀些解決⽅案都需要額外估計(jì)動(dòng)態(tài)模型或狀態(tài)表征,這⽆疑增加了計(jì)算消耗。除此之外,針對(duì)⽩噪聲問(wèn)題,利⽤對(duì)抗訓(xùn)練等⽅式增加探索的魯棒性也是值得研究的問(wèn)題。

- 收斂性。在⾯向不確定性的探索中,線(xiàn)性MDP下認(rèn)知不確定性是可以收斂到0的,但在深度神經(jīng)⽹絡(luò)下維度爆炸使得收斂困難。對(duì)于⾯向內(nèi)在激勵(lì)的探索,內(nèi)在激勵(lì)往往是啟發(fā)式設(shè)計(jì)的,缺乏理論上合理性論證。

- 多智能體探索。多智能體探索的研究還處于起步階段,尚未很好地解決上述問(wèn)題,如局部觀(guān)測(cè)、不穩(wěn)定、協(xié)同探索等。

主要作者介紹

楊天培博⼠,現(xiàn)任University of Alberta博⼠后研究員。楊博⼠在2021年從天津⼤學(xué)取得博⼠學(xué)位,她的研究興趣主要包括遷移強(qiáng)化學(xué)習(xí)和多智能體強(qiáng)化學(xué)習(xí)。楊博⼠致⼒于利⽤遷移學(xué)習(xí)、層次強(qiáng)化學(xué)習(xí)、對(duì)⼿建模等技術(shù)提升強(qiáng)化學(xué)習(xí)和多智能體強(qiáng)化學(xué)習(xí)的學(xué)習(xí)效率和性能。⽬前已在IJCAI、AAAI、ICLR、NeurIPS等頂級(jí)會(huì)議發(fā)表論⽂⼗余篇,擔(dān)任多個(gè)會(huì)議期刊的審稿⼈。

湯宏垚博⼠,天津⼤學(xué)博⼠在讀。湯博⼠的研究興趣主要包括強(qiáng)化學(xué)習(xí)、表征學(xué)習(xí),其學(xué)術(shù)成果發(fā)表在AAAI、IJCAI、NeurIPS、ICML等頂級(jí)會(huì)議期刊上。

⽩⾠甲博⼠,哈爾濱⼯業(yè)⼤學(xué)博⼠在讀,研究興趣包括探索與利⽤、離線(xiàn)強(qiáng)化學(xué)習(xí),學(xué)術(shù)成果發(fā)表在ICML、NeurIPS等。

劉⾦毅,天津⼤學(xué)智能與計(jì)算學(xué)部碩⼠在讀,研究興趣主要包括強(qiáng)化學(xué)習(xí)、離線(xiàn)強(qiáng)化學(xué)習(xí)等。

郝建業(yè)博⼠,天津⼤學(xué)智能與計(jì)算學(xué)部副教授。主要研究⽅向?yàn)樯疃葟?qiáng)化學(xué)習(xí)、多智能體系統(tǒng)。發(fā)表⼈⼯智能領(lǐng)域國(guó)際會(huì)議和期刊論⽂100余篇,專(zhuān)著2部。主持參與國(guó)家基⾦委、科技部、天津市⼈⼯智能重⼤等科研項(xiàng)⽬10余項(xiàng),研究成果榮獲ASE2019、DAI2019、CoRL2020最佳論⽂獎(jiǎng)等,同時(shí)在游戲AI、⼴告及推薦、⾃動(dòng)駕駛、⽹絡(luò)優(yōu)化等領(lǐng)域落地應(yīng)⽤。