拯救深度學(xué)習(xí):標(biāo)注數(shù)據(jù)不足下的深度學(xué)習(xí)方法

摘要:解決深度學(xué)習(xí)對數(shù)據(jù)的依賴問題和減少數(shù)據(jù)標(biāo)注成本成為了業(yè)界的研究熱點(diǎn)。本文將介紹以下幾個研究方向:半監(jiān)督/弱監(jiān)督學(xué)習(xí)、數(shù)據(jù)合成、主動學(xué)習(xí)、自監(jiān)督。

01.引言

得益于深度學(xué)習(xí)的發(fā)展,許多計(jì)算機(jī)視覺任務(wù)在近幾年取得了不錯的效果。但是,現(xiàn)有的深度學(xué)習(xí)算法多是有監(jiān)督學(xué)習(xí)算法,依賴大量人工標(biāo)記的訓(xùn)練數(shù)據(jù),而標(biāo)注數(shù)據(jù)十分耗費(fèi)人力成本。因此,解決深度學(xué)習(xí)對數(shù)據(jù)的依賴問題和減少數(shù)據(jù)標(biāo)注成本成為了業(yè)界的研究熱點(diǎn)。本文選取了相關(guān)領(lǐng)域的部分論文,將介紹以下幾個方向:半監(jiān)督/弱監(jiān)督學(xué)習(xí);數(shù)據(jù)合成;主動學(xué)習(xí);自監(jiān)督。

02.半監(jiān)督/弱監(jiān)督學(xué)習(xí)

半監(jiān)督學(xué)習(xí)是監(jiān)督學(xué)習(xí)和無監(jiān)督學(xué)習(xí)相結(jié)合的一種學(xué)習(xí)方法。半監(jiān)督/弱監(jiān)督學(xué)習(xí)使用大量的未標(biāo)注數(shù)據(jù)/弱標(biāo)注數(shù)據(jù),同時使用小部分已標(biāo)注數(shù)據(jù),來訓(xùn)練機(jī)器學(xué)習(xí)模型。它預(yù)期的結(jié)果是通過對大部分未標(biāo)注數(shù)據(jù)/弱標(biāo)注數(shù)據(jù)的利用,得到的模型優(yōu)于單純只用已標(biāo)注數(shù)據(jù)訓(xùn)練的模型。弱標(biāo)注數(shù)據(jù)的數(shù)據(jù)標(biāo)簽信息量較少且標(biāo)注難度小,比如在目標(biāo)檢測任務(wù)中,通常需要標(biāo)注目標(biāo)的類別和坐標(biāo),弱標(biāo)注數(shù)據(jù)則只標(biāo)注出圖像中的目標(biāo)類別,沒有坐標(biāo)信息。

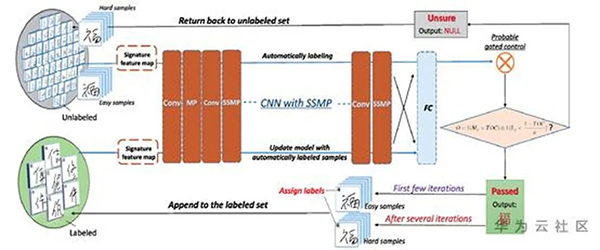

論文[1] 是半監(jiān)督方向的圖像分類論文,實(shí)驗(yàn)主要在手寫體圖像數(shù)據(jù)集上進(jìn)行,包括MNIST、CIFAR等,圖1是該論文方法的架構(gòu)。如圖所示,圖中左上角和左下角分別是未標(biāo)注數(shù)據(jù)集U和已標(biāo)注L,中間的橘紅色模塊是論文的神經(jīng)網(wǎng)絡(luò),右側(cè)是數(shù)據(jù)的篩選模塊。流程如下:先使用已標(biāo)注數(shù)據(jù)集L訓(xùn)練得到初始模型M1,然后使用M1在未標(biāo)注數(shù)據(jù)集U上進(jìn)行推理,U中的每張圖像都會得到一個分類結(jié)果和對應(yīng)的置信度S。基于S對U中的樣本進(jìn)行篩選,將分類置信度較高的樣本U1和對應(yīng)的推理結(jié)果當(dāng)作GT,加入已標(biāo)注樣本中L=L+U1,繼續(xù)訓(xùn)練模型得到M2。之后重復(fù)上述流程,訓(xùn)練集數(shù)量不斷增加,模型性能也逐漸變好。最終得到的模型M性能要遠(yuǎn)遠(yuǎn)優(yōu)于只使用L訓(xùn)練得到的模型M1。

圖1

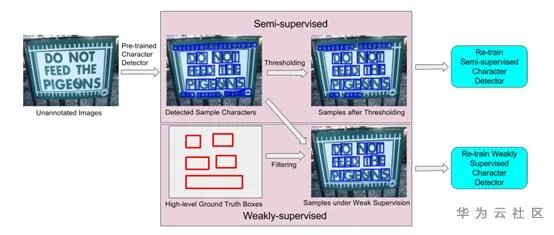

論文[2]使半監(jiān)督和弱監(jiān)督學(xué)習(xí)在字符級別的文本檢測領(lǐng)域的一篇論文,思想跟[1]類似,也是通過增量學(xué)習(xí)的方式來boost模型。如圖2所示,使用預(yù)訓(xùn)練的字符集檢測模型對左側(cè)的未標(biāo)注數(shù)據(jù)集U進(jìn)行推理,得到檢測結(jié)果D。圖2中間上下模塊分別表示半監(jiān)督和弱監(jiān)督篩選模塊。半監(jiān)督模塊通過置信度閾值剔除掉D中檢測不標(biāo)準(zhǔn)的檢測框,弱監(jiān)督模塊帶有“單詞級”的標(biāo)注框信息,所以將不在“單詞級”標(biāo)注框內(nèi)的字符檢測框剔除掉。之后用兩個模塊的輸出結(jié)果重新訓(xùn)練模型。

圖2

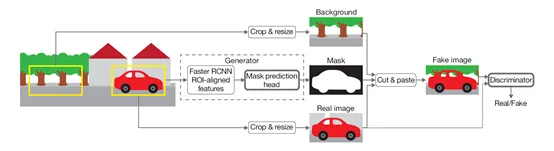

論文[3]是使用檢測框標(biāo)注信息做分割任務(wù)的GAN(generative adversarial network)文章。如圖[3]所示,左側(cè)為帶有檢測框信息的圖像,中間為生成器generator,右側(cè)為鑒別器discriminator。圖3中間的上支路在原始圖像標(biāo)注框外裁剪出背景區(qū)域,下支路從原始圖像裁剪出標(biāo)注框的目標(biāo)區(qū)域,中間的生成器在原圖標(biāo)注框內(nèi)生成mask,之后將mask和上下支路的兩張圖像結(jié)合成fake image,鑒別器需要鑒別圖像是真實(shí)的還是合成的。通過生成對抗的方式,最后訓(xùn)練出一個良好的生成器分割網(wǎng)絡(luò),而全過程只使用了檢測框標(biāo)注信息監(jiān)督,沒有分割標(biāo)注信息參與。

圖3

03.數(shù)據(jù)合成

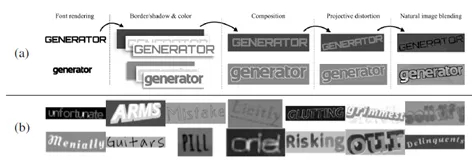

既然有監(jiān)督學(xué)習(xí)無法避免模型對標(biāo)注數(shù)據(jù)的依賴,那么自動生成數(shù)據(jù)也是減少人工成本的一個方式。數(shù)據(jù)合成的方式很多,包括人工設(shè)計(jì)規(guī)則,使用GAN網(wǎng)絡(luò)生成等。論文[4]針對文本識別任務(wù)提出了基于人工設(shè)計(jì)規(guī)則的合成數(shù)據(jù)方法。合成的圖像樣本由前景圖像層、背景圖像層、邊緣/陰影層組成,合成步驟分為六步:

font rendering:隨機(jī)選擇字體并將文本呈現(xiàn)入前景層;

border/shadow rendering:從前景層的文字中產(chǎn)生邊緣陰影等;

base coloring:給三個圖層填色;

projective distortion:對前景和陰影進(jìn)行隨機(jī)扭曲變換;

natural data blending:將圖像跟真實(shí)場景圖像進(jìn)行混合;

noise:加入高斯噪聲等。

圖4

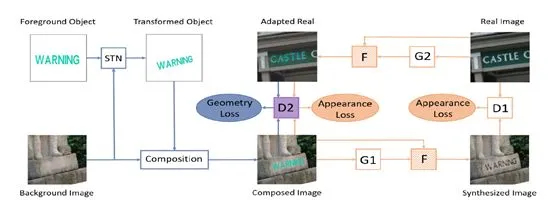

利用GAN進(jìn)行domain adaptation,合成數(shù)據(jù)也是一個研究方向。主要關(guān)注點(diǎn)包括source domain和target domain的appearance和geometry的相似程度。論文[5]則同時考慮兩種相似來做生成對抗。

圖5

04.主動學(xué)習(xí)

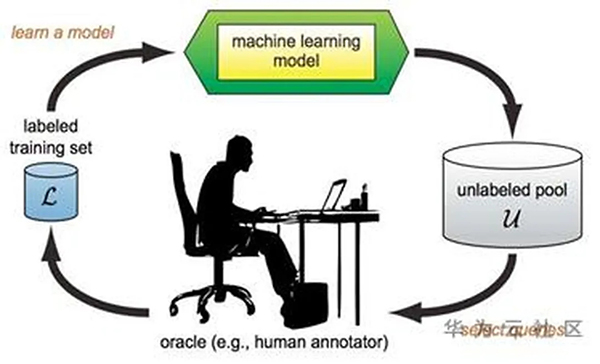

不同樣本對現(xiàn)有模型的提升幫助是不同的,正如人類的學(xué)習(xí)過程一樣,只學(xué)習(xí)小學(xué)知識的人很難突破初中知識的瓶頸。主動學(xué)習(xí)的出發(fā)點(diǎn)與此類似,就是希望從未標(biāo)注數(shù)據(jù)集中挑選對模型提升幫助最大的子集交給人工標(biāo)注。因此在標(biāo)注同樣數(shù)據(jù)量的樣本的情況下(同樣的標(biāo)注成本),采用主動學(xué)習(xí)策略挑選樣本訓(xùn)練的模型是接近最優(yōu)的。主動學(xué)習(xí)的流程如圖6所示,左側(cè)的已標(biāo)注數(shù)據(jù)集訓(xùn)練得到模型,模型在未標(biāo)注數(shù)據(jù)集上推理,并將標(biāo)注意義較大的樣本推給人工標(biāo)注,再將新標(biāo)注的數(shù)據(jù)集重新訓(xùn)練和提升模型。

圖6

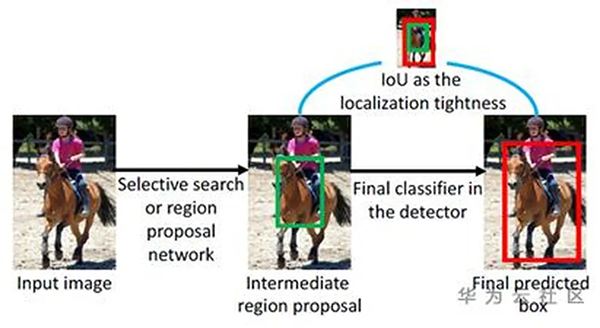

主動學(xué)習(xí)領(lǐng)域定義未標(biāo)注數(shù)據(jù)對模型提升幫助的指標(biāo)包括不確定性、差異性和多樣性等。不確定性指現(xiàn)有模型對該樣本的推理置信度不夠高,差異性指新樣本跟已標(biāo)注數(shù)據(jù)集的樣本差異,多樣性則是強(qiáng)調(diào)新樣本內(nèi)部足夠多樣化。在分類問題中,論文[6]是分類任務(wù)中的主動學(xué)習(xí)過程,根據(jù)模型對輸入圖像的生成patch預(yù)測的差異性和不確定度來衡量。論文[7]則強(qiáng)調(diào)檢測任務(wù)中檢測框的置信度只代表分類置信度,不具有位置置信度,因此提出位置置信度補(bǔ)充評價檢測框的優(yōu)劣:二階段檢測器中RPN和最終輸出框的差異(圖7),數(shù)據(jù)擴(kuò)充后的檢測框與原圖檢測框的差異。

圖7

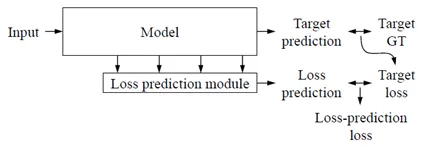

論文[8]則指出現(xiàn)有主動學(xué)習(xí)模型大多是task-specific,因此提出了task-agnostic的挑選樣本策略,并在分類、檢測等任務(wù)中驗(yàn)證了實(shí)驗(yàn)。如圖8所示,論文提出了可旁加在主干任務(wù)學(xué)習(xí)網(wǎng)絡(luò)的loss預(yù)測分支,對未標(biāo)注數(shù)據(jù)集進(jìn)行l(wèi)oss預(yù)測,預(yù)測loss大的樣本表面模型對它的不確定性高。Loss預(yù)測分支在訓(xùn)練階段時的監(jiān)督信息是主干任務(wù)學(xué)習(xí)網(wǎng)絡(luò)的loss。

圖8

05.自監(jiān)督

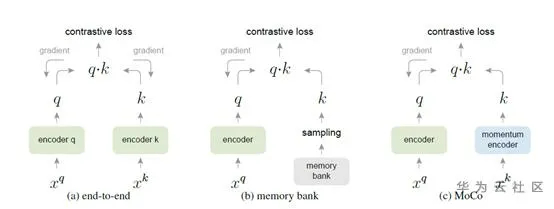

自監(jiān)督學(xué)習(xí)是無監(jiān)督學(xué)習(xí)的一種,近期是學(xué)術(shù)界的研究熱點(diǎn)。它通過利用無標(biāo)簽的數(shù)據(jù)本身的結(jié)構(gòu)或者特性,人為構(gòu)造標(biāo)簽出來監(jiān)督網(wǎng)絡(luò)學(xué)習(xí)。通常自監(jiān)督學(xué)習(xí)的模型并不直接應(yīng)用在目標(biāo)任務(wù)上,而是作為下游任務(wù)的預(yù)訓(xùn)練模型。論文[9]是自監(jiān)督學(xué)習(xí)的一個新進(jìn)展,使用該論文方法得到的無監(jiān)督模型,作為預(yù)訓(xùn)練模型在許多下游任務(wù)fine-tune后的效果優(yōu)于使用有監(jiān)督學(xué)習(xí)的預(yù)訓(xùn)練模型fine-tune的。圖9(c)是MoCo的算法圖,(a)(b)表示之前的相關(guān)方法。

Contrastive learning是MoCo的出發(fā)點(diǎn),即對輸入樣本做數(shù)據(jù)擴(kuò)充得到擴(kuò)充集,之后在圖中左側(cè)encoder輸入,右側(cè)encoder輸入或中的樣本,其中是不同于的其他樣本,通過contrastive loss優(yōu)化網(wǎng)絡(luò)對相同樣本源的輸入編碼出相似特征,對不同樣本源的輸入編碼出差異特征。在該過程中,有兩個關(guān)鍵點(diǎn):計(jì)算量不能太大,否則計(jì)算資源不允許;右側(cè)的encoder提取的特征k應(yīng)盡可能是由最新的encoder得到的。圖9(a)分別是使用mini-batch中的一個樣本作為,剩余樣本作為,好處是每個mini-batch中的k都是最新的,壞處是k的數(shù)量太少,受mini-batch限制。圖9(b)則是對所有樣本進(jìn)行編碼存入memory bank中,并定期更新,好處是k的數(shù)量可以不受限制,壞處是的特征不一定是最新的。MoCo則使用了隊(duì)列存儲的特征,將最新的樣本特征送入隊(duì)列,隊(duì)尾的特征剔除,隊(duì)列大小可控,且k基本是最近時期的encoder提取的。

圖9

06.總結(jié)

減少數(shù)據(jù)標(biāo)注成本已經(jīng)成為深度學(xué)習(xí)領(lǐng)域一個不可回避的研究課題,一方面,合成數(shù)據(jù),讓機(jī)器自動標(biāo)注數(shù)據(jù)是值得深挖的方向,另一方面,減少神經(jīng)網(wǎng)絡(luò)的數(shù)據(jù)依賴或者能模型認(rèn)識數(shù)據(jù)本身的內(nèi)在結(jié)構(gòu)也尤為重要。更有業(yè)界權(quán)威人士認(rèn)為,數(shù)據(jù)提煉或是人工智能的下一個突破口。