汽車機器人如何看清世界?解析自動駕駛感知的硬件基礎之一——攝像頭

汽車機器人是如何看清世界的?汽車機器人的眼睛應該是什么形態?機器人視覺的未來技術趨勢可能會是怎么樣的?11月13日,集度聯合歐菲光作了一場以“機器人之眼”為主題的技術交流會,圍繞自動駕駛的感知硬件基礎之一——攝像頭做了深入的解答。

自動駕駛的核心技術之一——感知

自動駕駛一直是一個很容易觸發社會熱點的“流量密碼”,總有很多爭議性的事件發生——比如有車主過分相信智能駕駛輔助,注意力放松、完全沒有控制車輛導致傷亡事故。這些事故的背后是因為現階段的輔助駕駛技術有不足之處,例如三角錐桶和前方靜止車輛的識別困難,而這,都指向了自動駕駛的核心技術之一——感知技術。

在“軟硬一體“的時代,感知的硬件基礎非常重要,是在給”大腦“提供視覺數據。機器人或自動駕駛汽車,在視覺上需要三個信息:詳細的平面信息,高速及全天候的預判信息,精確的距離信息。為了解決信息輸入的準確,車企已經先紛紛在硬件上“內卷”起來。一些車企選擇多傳感器融合的路線,不吝嗇在車上搭載激光雷達,激光雷達從1個逐步堆積到4個,足夠讓大家感到“內卷“。當然,也有深耕自動駕駛多年的百度Apollo以及特斯拉選擇純視覺自動駕駛的道路。

無論是激光雷達加多傳感器的技術路徑,還是純視覺的技術實現手段,攝像頭一直是自動駕駛的靈魂所在。

自動駕駛需要哪些攝像頭?

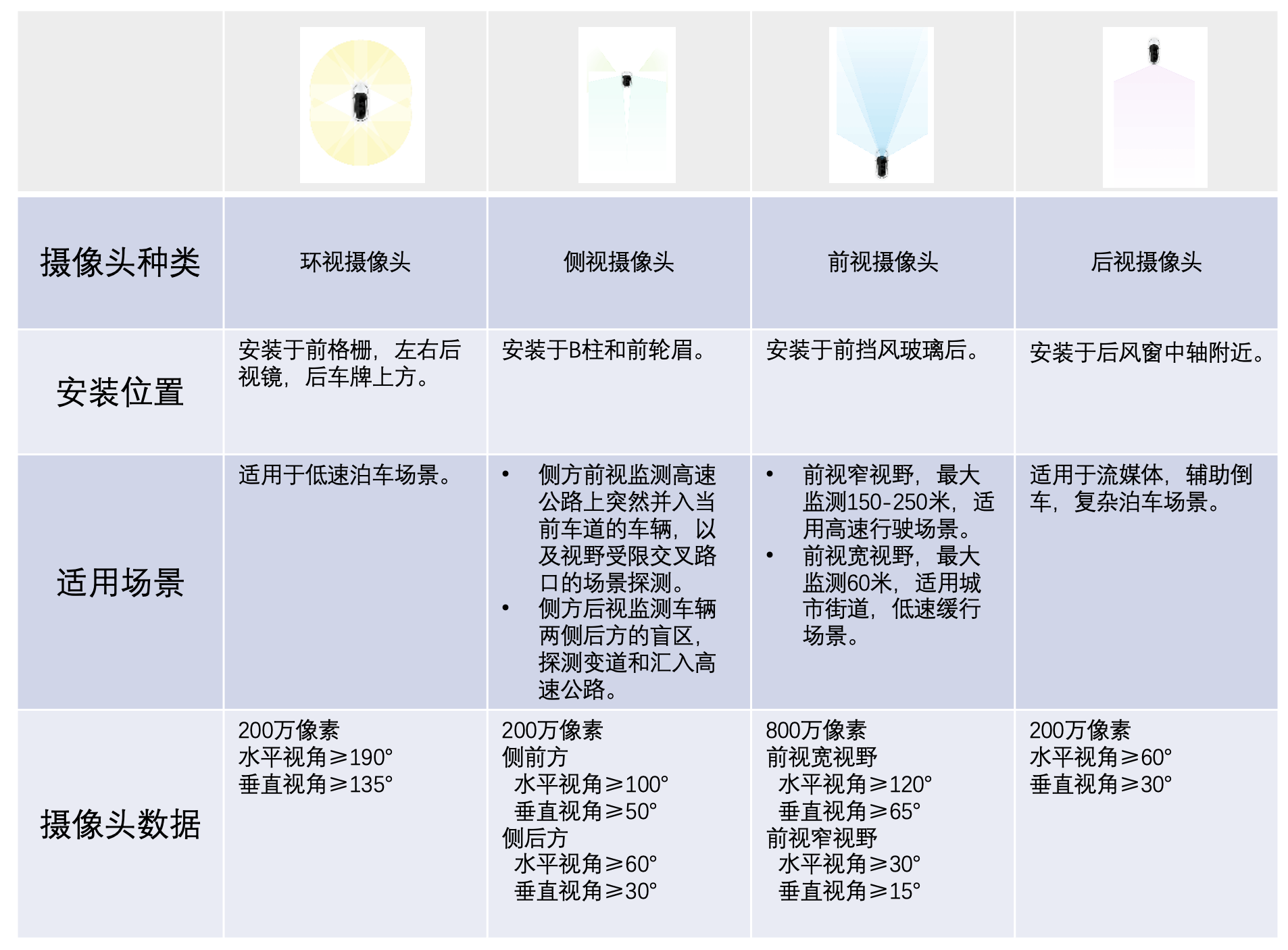

目前的自動駕駛功能攝像頭一般有12-13個,按照功能進行分類,分別用于環視、側視、前視和后視。環視攝像頭一般用于低速泊車;側視攝像頭用于補充后方盲區的監測,探測變道和并入主路;前視攝像頭主要用于高速和低速的自動駕駛;后視攝像頭則主要用于復雜環境下的泊車。

通過這四種攝像頭布局在全車四周,就能達到近乎無死角的視覺覆蓋,為自動駕駛決策提供足夠的視覺感知數據。

隨著自動駕駛的技術進步,目前攝像頭的發展也在動態地調整,正朝著高像素、低照度、寬動態等方向發展。

2023年,頭部圖像傳感器廠家將陸續量產車規1500萬像素的Sensor,其應用將有效減少攝像頭個數,實現大于200米距離范圍識別20x20cm目標,為路徑規劃保留足夠的時間余量。

夜晚,攝像頭處于低照度環境下,識別的精度會受到影響。目前,頭部圖像傳感器廠家都已開發出可在0.1Lux(勒克斯,光照單位)下成像的傳感器,可在沒有路燈的情況下識別車輛和行人。而一些高清攝像頭,也可以將四個小像素合成一個大像素組合輸出,有效提升了靈敏度。圖像傳感器的感知范圍也從可見光譜向近紅外光譜延伸,還可以通過紅外補光燈+紅外線攝像機+感知算法,保證在低照度下的視覺感知功能。

寬動態HDR是圖像傳感器面向自動駕駛應用的關鍵指標。反映了極大光比情況下對于環境的感知能力。圖像傳感器受光線影響較大,在強光或是極暗的情況下,可能出現曝光過度和曝光不足的問題。另外,傳感器對于光線的快速變化也很難及時做出調整,魯棒性相對較低。對于自動駕駛來說,是極為嚴峻的考驗。目前車規級COMS圖像傳感器動態范圍已達140dB,160dB的Sensor也在開發中。

此外,3DTOF相機、事件驅動的圖像傳感器、視覺傳感器與空間傳感器的前融合等技術,也是目前攝像頭以及圖像傳感技術的發展方向。

機器人視覺的未來

現實場景中,機器視覺既需要事件信號做快速的預判,也需要圖像信號做精細的判斷或重建,還需要深度信息做精準的距離判斷。因此既需要事件相機捕捉動態信息,也需要傳統 CIS (視覺識別系統)呈現細節豐富的靜態信息,還需要類似3DTof(將二維視覺轉換為三維信息)輸出的深度信息。

而機器人視覺的未來,可能是有一款相機,可以集成基于幀的圖像傳感器,基于事件驅動的傳感器,基于3DTOf 的傳感器技術。除了可以輸出與普通圖像傳感器相同的幀圖像,還能同時輸出以事件流的數據形式異步輸出變化的信息(包括時間、空間及變化的屬性信息),并能同步分離深度信息。

李彥宏曾說,AI的最終體現是一個完全自動駕駛的機器人。AI的表現其實就是智能機器人。至于這個機器人的形狀,可能更像一個人,也可能更像一輛車。集度是第一個要做汽車機器人的公司,致力于打造可自由移動、可自然交流、可自我進化的汽車機器人。隨著攝像頭向高像素、寬動態、低照度的方向發展,汽車機器人的眼睛也會更加明澈,為自由移動實現更堅實的基礎。