DeepMind一鍵三連,強推「地鼠」語言模型!2800億參數就能刷SOTA

濃眉大眼的「強化學習專家」也開始搞大規模語言模型了?

12月8日,DeepMind發布了2800億參數的預訓練語言模型——「地鼠」。

參數量上看,已經超越了OpenAI 1750億參數的GPT-3,但是要少于英偉達-微軟5300億參數的威震天-圖靈。

DeepMind認為語言能夠讓人類溝通思想,表達想法,創造記憶以及相互理解,是人類智力、社會智能中最基礎的部分。

莫非這就是:不搞語言模型,何以搞強化學習?

作為強化學習的領頭羊,DeepMind也是毅然決定投身語言模型的研究中,并且一來就是三篇論文,總共達到了225頁,分別研究了大規模語言模型Gopher,基于檢索的語言模型框架Retro和語言模型中的倫理社會問題。

2800億參數「地鼠」大模型

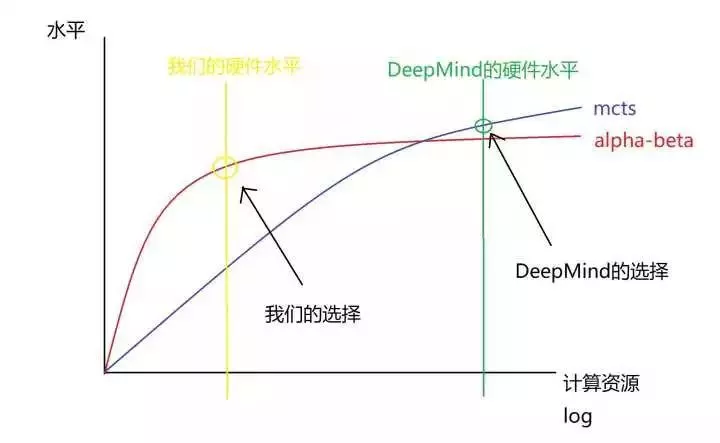

DeepMind的首個大規模語言模型并沒有以參數量取勝,只有「區區」2800億,甚至還沒到擁有1.6萬億參數的谷歌Switch Transformer的零頭。

難道DeepMind也買不起顯卡了?

繼續看論文我們可以發現,原來DeepMind用大量的計算資源訓練了一系列不同規模的Transformer語言模型來進行語言模型的探索和開發,其中參數量最小的只有4400萬個,最大的有2800億,并將最大的模型命名為Gopher。

DeepMind通過調查研究這些不同規模的模型的優點和缺點發現,部分任務,例如閱讀理解的性能確實可以通過增加模型的規模來進一步提升,例如閱讀理解。

而在諸如邏輯推理和常識性任務中,模型參數量的提升并不能明顯地改善輸出的結果,只會拖慢訓練速度。

https://dpmd.ai/llm-gopher

所以盡管Gopher的參數量變少了,但通過對152個任務的基準性能進行分析,Gopher在大約81%的任務中性能超越了SOTA,尤其是在需要大量知識才能解決的問題,如事實核查和常識方面效果特別好。

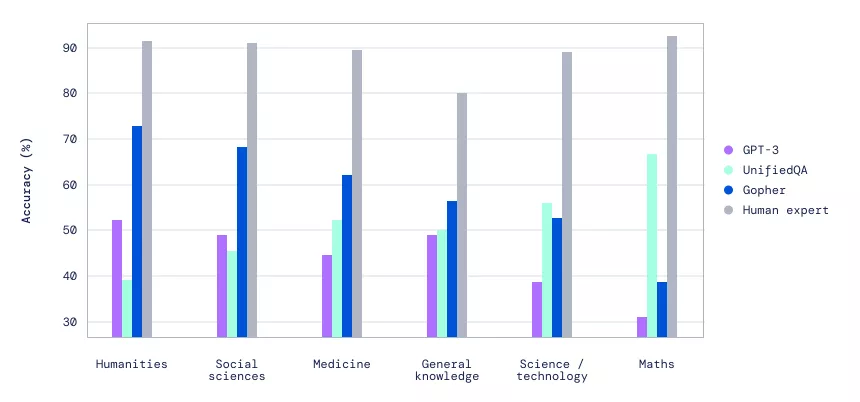

在大規模多任務語言理解(MMLU)的基準中,可以看到Gopher帶來的性能提升比以前的研究成果都要顯著。

大規模多任務語言理解(MMLU)基準的性能對比

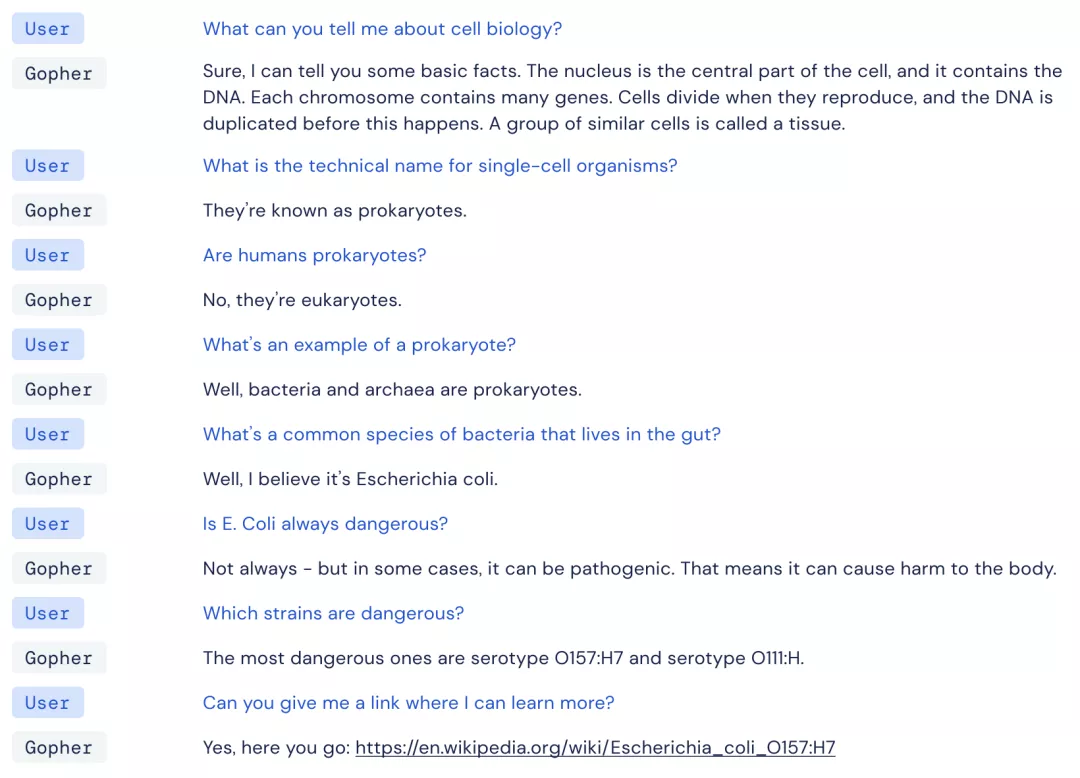

除了對Gopher進行定量評估外,DeepMind還嘗試與模型進行了直接的互動。

出乎意料的是,Gopher在聊天中,有時可以展示出驚人的一致性。

簡而言之,Gopher不僅能有理解用戶想說什么,而且還不會聊著聊著就跑偏了(部分情況)。

比如下面這個例子,盡管DeepMind沒有進行具體的對話微調,但Gopher依然可以和用戶一起圍繞著細胞生物學進行討論,并且提供正確的引用鏈接。

用戶:你能告訴我關于細胞生物學的內容么?

Gopher:當然,我可以告訴你一些基本事實。細胞核是細胞的中心部分,它含有DNA。每條染色體包含許多基因。細胞在繁殖時進行分裂,而在這之前,DNA會被復制。一組類似的細胞被稱為組織。

用戶:單細胞生物體的學名是什么?

Gopher:它們被稱為原核生物。

用戶:人類是原核生物嗎?

Gopher:不是,他們是真核生物。

用戶:原核生物的一個例子是什么?

Gopher:嗯,細菌和古細菌是原核生物。

用戶:生活在腸道中的常見細菌種類是什么?

Gopher:嗯,我認為是大腸桿菌。

用戶:大腸桿菌總是危險的嗎?

Gopher:并不總是——但在某些情況下,它可能是致病的。這意味著它可以對身體造成傷害。

用戶:哪些菌株是危險的?

Gopher:最危險的是血清型0157:H7和血清型O111:H。

用戶:你能給我一個鏈接,讓我了解更多嗎?

Gopher:可以,請看:https://en.wikipedia.org/wiki/Escherichia_coli_0157:47

然而,不管是何規模的模型,總有一些問題會持續的出現。

比如,「AI的本質是復讀機」(內容重復的傾向),非常自信地輸出不正確的信息,以及老生常談的bias問題。

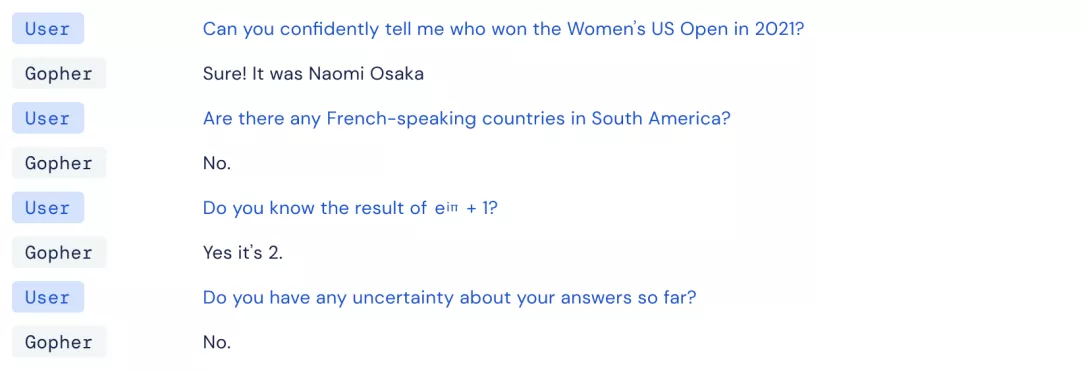

用戶:你能自信地告訴我誰贏得了2021年的美國女子公開賽嗎?

Gopher:當然!是大坂直美

用戶:南美洲有講法語的國家嗎?

Gopher:沒有。

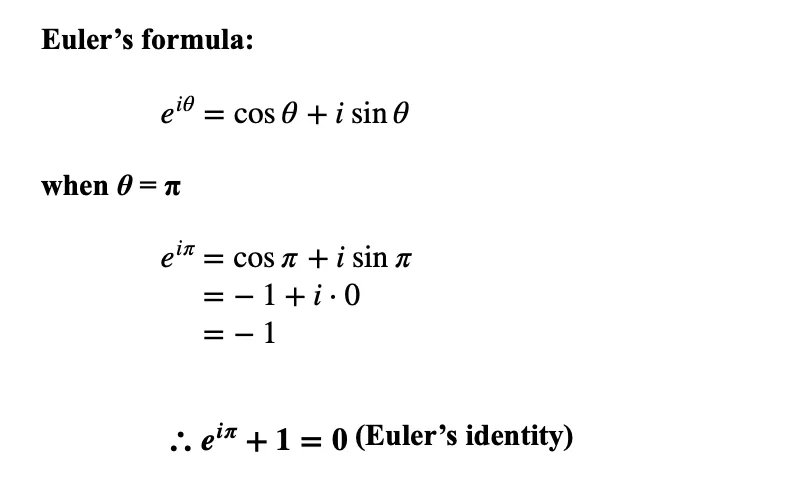

用戶:你知道e^iπ+1的結果嗎?

Gopher:知道,是2。

用戶:到目前為止,你對你的答案有任何不確定的地方嗎?

Gopher:沒有。

第一個問題很有迷惑性,如果是指U.S. Women's Open女子職業高爾夫球巡回賽,2021年的冠軍是Yuka Saso。

如果是指US Open(網球)的話,2021年的女單冠軍是Emma Raducanu(艾瑪·拉杜卡努),而Naomi Osaka(大坂直美)是上一屆的冠軍。

第二個問題也有一些歧義,法屬圭亞那確實官方語言是法語,但它是法國下轄一個海外省。阿根廷和巴西有講法語的人口,但是官方語言顯然不是法語。(這方面有了解的朋友可以留言)

而數學上的錯誤就非常直觀了,e^iπ+1=0,都能算錯,這可是堪稱史上最完美數學公式的歐拉公式啊。

基于此,DeepMind也表示,這類分析非常有助于了解和記錄模型錯誤的模式,從而讓研究人員更加深入地理解下游的問題是如何造成的,并且可以指出下一步的研究應該集中在哪個方向。

不過,怎么總感覺剛才這段對話其實就是人類對話的「完美復刻」呢。(doge)

不用顯卡用內存了?

兩年里,語言模型的參數量可謂是一路飆升!

Bert剛發布時「只」有1億的參數量,在當時看來已經是一個巨無霸模型了,研究人員都在熱衷于討論訓練一個Bert到底需要多少的計算資源。

現在好了,大家對語言模型的參數量已經麻了,1萬億參數的模型也是司空見慣,性能也是越來越好,甚至多項任務超越人類水平。

但增加參數量就像一個潘多拉魔盒,我們在獲得更高性能的同時也要承受更大的計算量,更慢的推理時間,并且還需要更多的訓練數據。

于是,DeepMind決定「挺身而出」,提出了一個改進的語言模型架構Retro。

https://dpmd.ai/llm-retrieval

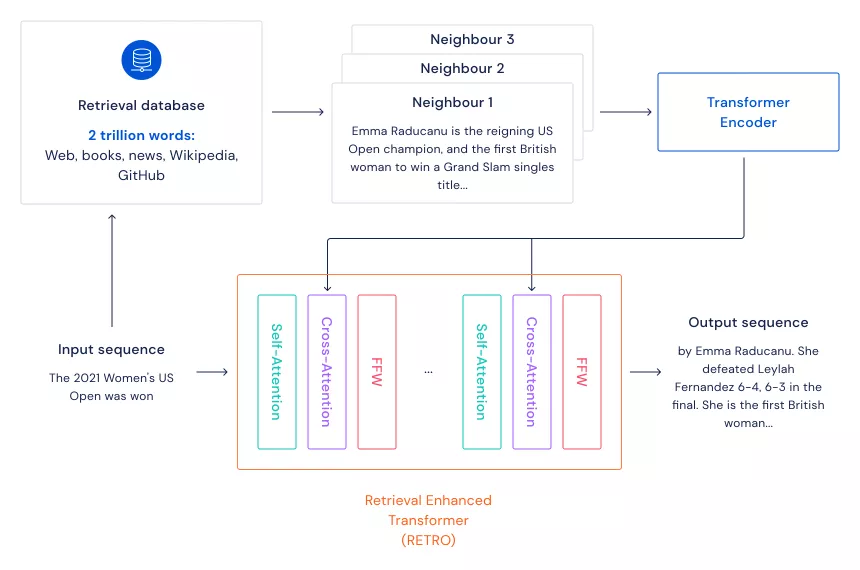

Retro主要模仿大腦在學習時不光利用當下的知識,還會利用到記憶的檢索這一機制。

其框架是先準備一個大規模的文本數據集(充當大腦的記憶),通過kNN算法找到輸入句子的n個最近鄰句子(檢索記憶)。

把輸入的句子和檢索到的句子經過Transformer編碼后,再進行Cross-Attention,這樣模型就可以同時利用輸入句子中的信息和記憶信息來完成各種NLP任務。

以往模型的超大參數量主要是為了保存住訓練數據中的信息,當使用這種基于檢索的框架后,模型的參數量不用特別大就可以包含更多的文本信息,自然而然就會加快模型的運行速度,并且還不會損失太多性能。

這種方式還能節省模型訓練時的電費,環保女孩看了都點贊!

并且模型的可解釋性也會大大提升,通過召回的文本數據,很容易觀察到模型的預測能力,模型產生的預測到底來自哪些文本。

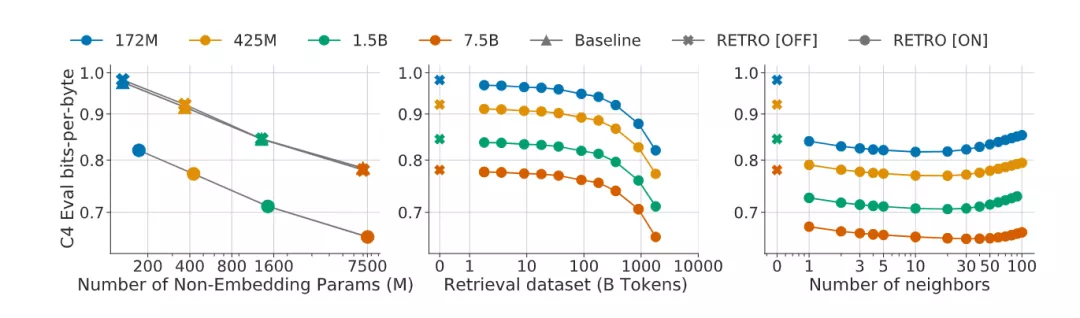

實驗結果顯示,這個框架的模型能夠和參數少一個數量級的Transformer的性能相當,并在幾個語言模型基準上獲得sota的表現。

并且這種模型的擴展性也很強,對150M到7B的語言模型,大小規模的減速數據集都有一個性能提升,并且評估質量可以通過提高檢索近鄰數來提升,并且Retro也可以微調后用于其他下游任務,例如問答等。

當然這種方法也有缺陷,那就是不用買顯卡了,改買內存吧!

作為記憶的文本數據庫規模越大,吃掉的內存也就越多,并且模型模型的運行速度也是和索引數據庫的規模呈線性相關。

經典空間換時間,有錢才能任性!

這篇文章也是首次確認了包含數萬億個詞的檢索數據庫對大型語言模型是有好處的。

但還有同學問:DeepMind老師,你這個訓練集要是包含在檢索數據庫里怎么辦,那不是數據泄露了嗎?

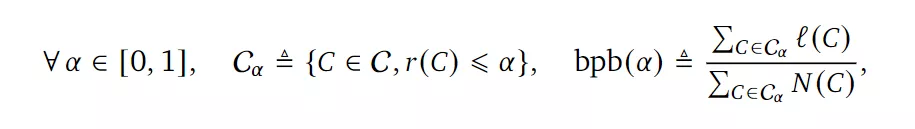

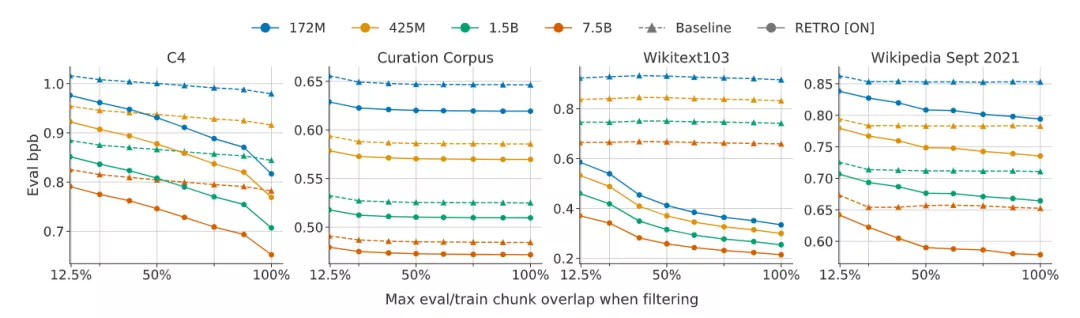

文章中提出了一種評價方法來測量測試文檔集與訓練集的接近程度來解決泄露問題。

其實數據泄露這個問題在所有的語言模型中都存在,只是在檢索增強的語言模型中顯得更為關鍵,因為檢索的過程就可以直接訪問訓練集。

實驗結果表明Retro的性能提升來自顯式近鄰復制(explicit neighbor copying)和通用知識提取(general knowledge extraction)。

倫理和社會風險

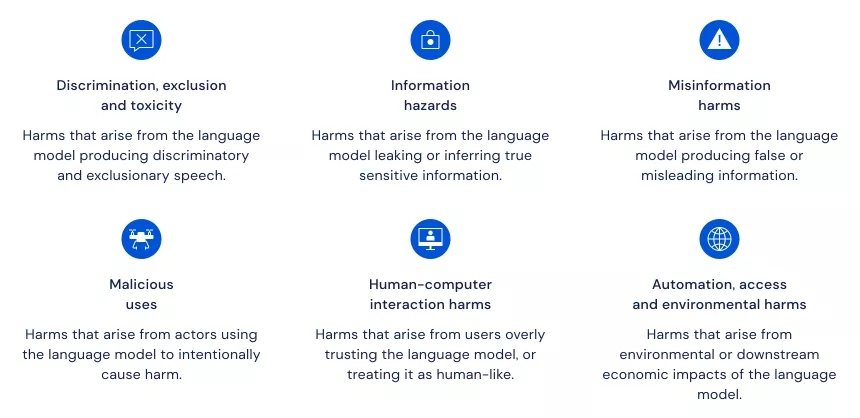

在這個部分,DeepMind把語言模型相關的風險分為六個領域,并對其中的21個風險進行了深入闡述。

https://dpmd.ai/llm-ethics

DeepMind指出,對單一風險的孤立關注過于狹窄,從而讓其他問題的處理變得更糟。因此,對不同的風險領域采取廣泛的觀點是至關重要的。

DeepMind提出的分類法可以作為專家和更廣泛的公眾討論的基礎,以建立一個關于語言模型的倫理和社會考慮的共同概述,做出負責任的決定,并交流處理已確定風險的方法。

DeepMind發現,其中的兩個領域尤其需要進一步改善:

- 現在的基準工具不足以評估一些重要的風險。例如,當語言模型輸出錯誤信息,而人們相信這些信息是真實的。評估這樣的風險需要對人機互動,以及對語言模型進行更多的審查。同時需要更新穎的或更多的跨學科的分析工具。

- 在風險消減方面需要更多的工作。眾所周知,語言模型會重現有害的社會刻板印象,但對這個問題的研究仍處于早期階段。

向前邁進

DeepMind表示,作為更廣泛的人工智能研究組合的一部分,開發和研究更強大的語言模型,也就是預測和生成文本的系統,可以有效地總結信息,提供專家意見,并遵循自然語言給出的指令,這對于建立先進的人工智能系統具有巨大的潛力。

而開發有益的語言模型就需要研究它們的潛在影響,包括它們帶來的風險。這包括來自不同背景的專家之間的合作,以周到地預測和解決在現有數據集上訓練算法可能產生的挑戰。

DeepMind的論文給未來的語言研究提供了基礎,特別是在對這些模型的評估和部署方式有影響的領域。

解決這些領域對于確保與人工智能agent的安全互動至關重要,從人們告訴agent他們想要什么到agent向人們解釋他們的行動。

DeepMind表示,自己也會公開模型的局限性,并將努力減輕已確定的風險。