10億參數、多項SOTA,智源開源視覺基礎模型EVA

- 論文地址:https://arxiv.org/abs/2211.07636

- 代碼地址:https://github.com/baaivision/EVA

作為一種視覺預訓練方法,掩碼圖像建模(Masked Image Modeling,簡稱 MIM)近期得到了蓬勃發展,自從 BEiT 開始,一系列新方法諸如 SimMIM、MAE、MVP 等被陸續設計出,這個領域也受到了很大關注。然而,在十億參數量級別的視覺預訓練模型中,最具競爭力的模型例如 ViT-g、SwinV2、CoCa 等仍然嚴重依賴有監督或弱監督訓練,以及不可公開訪問的數億級有標簽數據。

理想的視覺預訓練應當只需簡單的操作:譬如抓好語義學習和幾何結構學習這兩個關鍵點,基本可以搞定絕大部分的視覺任務。

智源曹越團隊最新開源的視覺預訓練模型 EVA,將最強語義學習(CLIP)與最強幾何結構學習(MIM)結合,僅需使用標準的 ViT 模型,并將其規模擴大到十億參數(1-Billion)進行訓練,即可得到當前最強大的十億級視覺基礎模型 EVA。

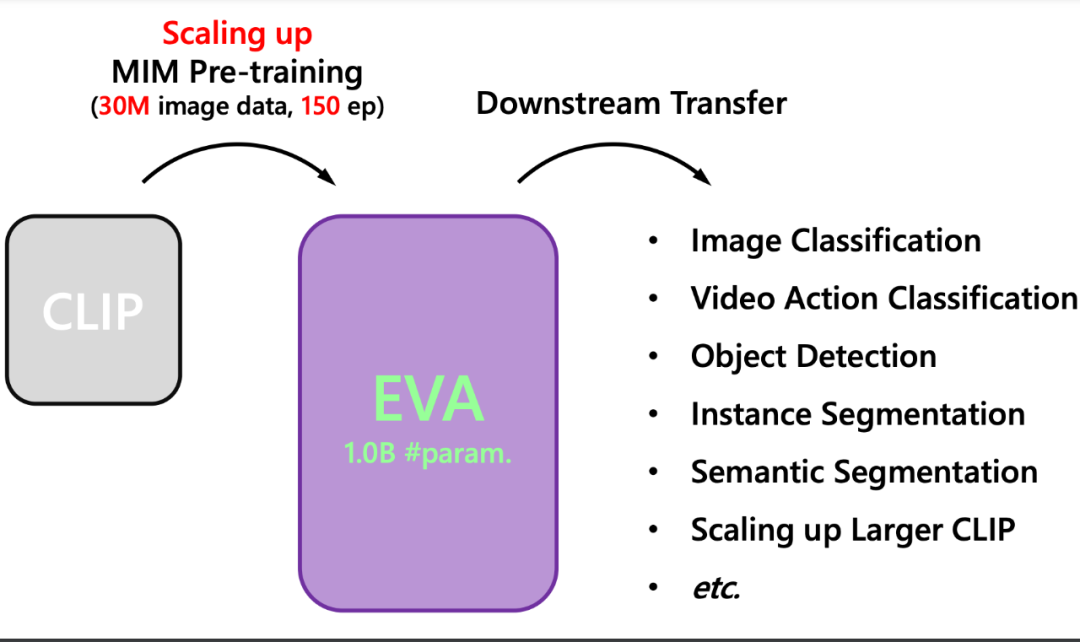

具體而言,EVA 的訓練方法與 MVP、MILLAN 類似,即通過重構 CLIP 特征來進行掩碼圖像建模(masked image modeling)。如下圖所示,CLIP 模型輸入為完整的圖像,而 EVA 模型的輸入為有遮蓋的圖像,訓練過程是讓 EVA 模型遮蓋部分的輸出去重構 CLIP 模型對應位置的輸出,從而以簡單高效的方式讓 EVA 模型同時擁有了最強語義學習 CLIP 的能力和最強幾何結構學習 MIM 的能力。不同于之前的方法,EVA 證明了這種訓練方式可以幫助模型將參數擴展到十億量級,并且在這個參數量級下在廣泛下游任務中取得出色的性能。

總結而言,EVA 具有以下特點:

1. 高效

EVA 僅使用開源的純圖像數據即可進行掩碼預測任務,不需要預訓練階段重新學習語義以及不需要巨量的成對有標注數據。相比而言,主流標桿性模型(ViT-g、SwinV2、CoCa 等)仍依賴于冗長的有監督或弱監督訓練,以及不可公開訪問的數億級有標簽數據。

2. 簡單

EVA 無需特殊設計網絡結構。使用簡單的網絡結構—標準的 ViT-g,而無需額外特殊設計的算子,使得其非常容易的遷移到廣泛的下游任務,并且可以和其他模態共享。

實驗

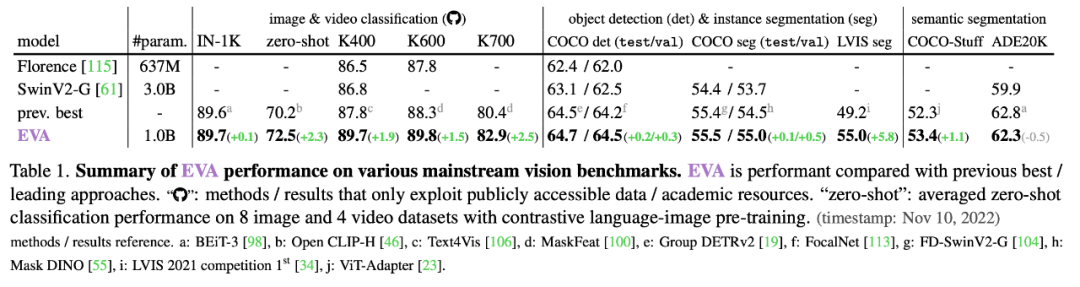

目前,EVA 在主流任務評測中的表現都可圈可點:

1. 多項重要視覺感知任務取得 state-of-the-art 性能

ImageNet 圖像分類中取得 89.7% 的 top-1 準確率;Kinetics-700 視頻動作識別取得 82.9% 的 top-1 準確率;COCO 目標檢測取得 64.7 mAP、實例分割取得 55.5 mAP;LVIS 的實例分割取得 55.0 mAP;語義分割的 COCO-stuff 取得 53.4 mIoU、ADE-20K 取得 62.3 mIoU。

2. 參數量變引發性能質變:在 LVIS 上性能極強;可以穩定并加速 CLIP 訓練,產生當前最強的開源 CLIP 模型。

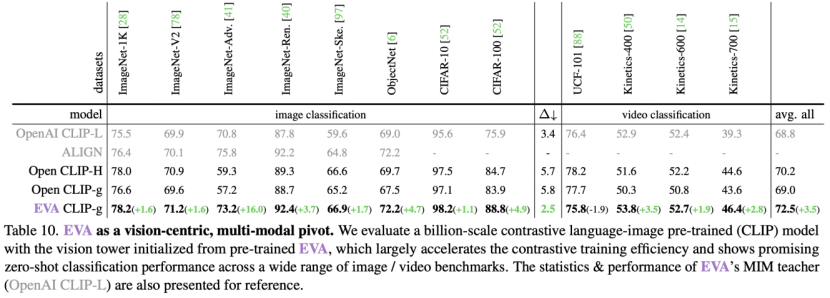

首先,在 LVIS(超過一千類)實例分割任務上表現和 COCO(80 類)相仿,比之前的 SOTA 方法 MAE 高出 5.8 個點;第二,使用 EVA 作為 CLIP 訓練的初始化,其性能遠超隨機初始化的 CLIP 訓練,如下圖所示,在十億參數量級下,和 Open CLIP 官方使用完全一樣的訓練方式下,在幾乎所有的零樣本基準下均有顯著的性能提升,除此之外,EVA 可以極大地穩定巨型 CLIP 的訓練和優化過程,訓練過程僅需使用 FP16 混合精度,綜合來看,EVA 幫助訓練得到當前最強且最大的開源 CLIP 模型,已經有團隊在嘗試使用其幫助 AIGC 模型的生成質量。

圈重點:EVA 全家桶開源!

十億參數的預訓練模型,下游 ImageNet 圖像分類、Kinetics 視頻動作識別、COCO 和 LVIS 目標檢測和分割、ADE20K 語義分割、以及最強 CLIP 模型,全部開源!

歡迎感興趣的小伙伴前去使用!