微軟小模型擊敗大模型:27億參數(shù),手機(jī)就能跑

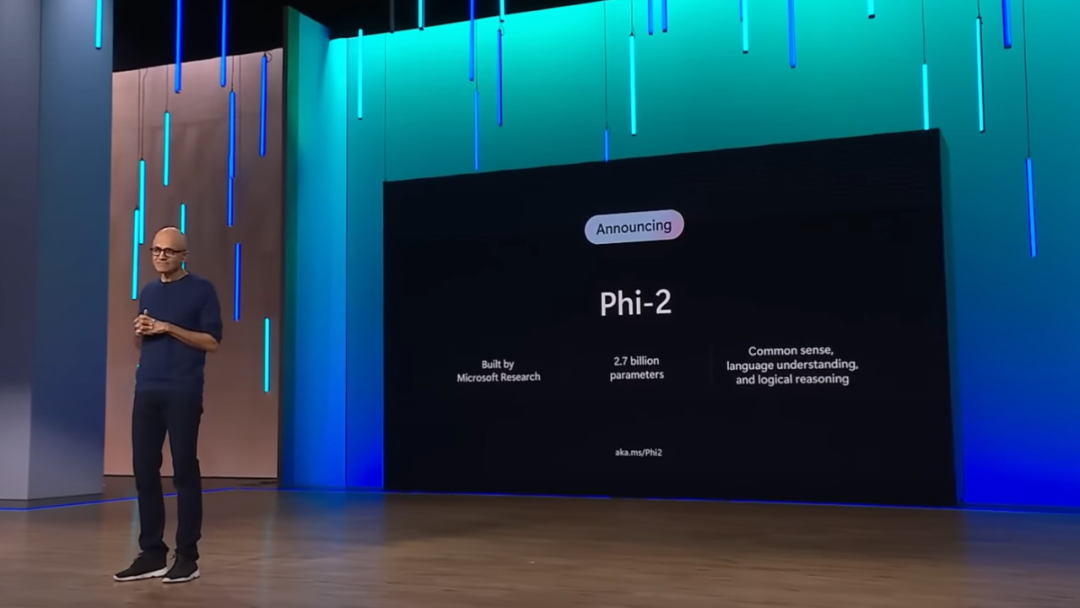

上個月,微軟 CEO 納德拉在 Ignite 大會上宣布自研小尺寸模型 Phi-2 將完全開源,在常識推理、語言理解和邏輯推理方面的性能顯著改進(jìn)。

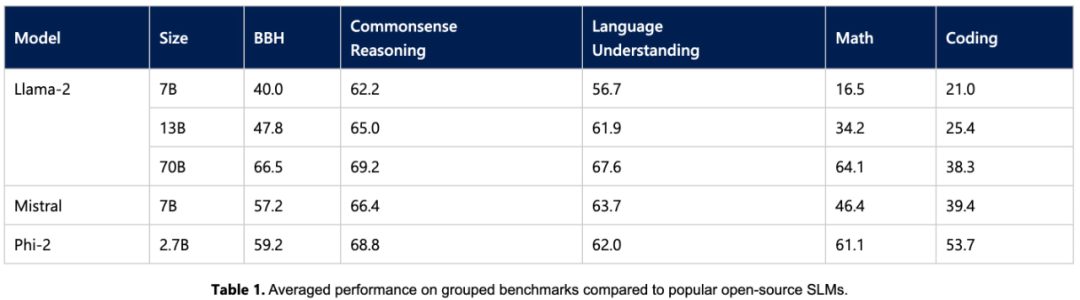

今天,微軟公布了 Phi-2 模型的更多細(xì)節(jié)以及全新的提示技術(shù) promptbase。這個僅 27 億參數(shù)的模型在大多數(shù)常識推理、語言理解、數(shù)學(xué)和編碼任務(wù)上超越了 Llama2 7B、Llama2 13B、Mistral 7B,與 Llama2 70B 的差距也在縮小(甚至更好)。

同時,小尺寸的 Phi-2 可以在筆記本電腦、手機(jī)等移動設(shè)備上運(yùn)行。納德拉表示,微軟非常高興將一流的小語言模型(SLM)和 SOTA 提示技術(shù)向研發(fā)人員分享。

今年 6 月,微軟在一篇題為《Textbooks Are All You Need》的論文中,用規(guī)模僅為 7B token 的「教科書質(zhì)量」數(shù)據(jù)訓(xùn)練了一個 1.3B 參數(shù)的模型 ——phi-1。盡管在數(shù)據(jù)集和模型大小方面比競品模型小幾個數(shù)量級,但 phi-1 在 HumanEval 的 pass@1 上達(dá)到了 50.6% 的準(zhǔn)確率,在 MBPP 上達(dá)到了 55.5%。phi-1 證明高質(zhì)量的「小數(shù)據(jù)」能夠讓模型具備良好的性能。

隨后的 9 月,微軟又發(fā)表了論文《Textbooks Are All You Need II: phi-1.5 technical report》,對高質(zhì)量「小數(shù)據(jù)」的潛力做了進(jìn)一步研究。文中提出了 Phi-1.5,參數(shù) 13 億,適用于 QA 問答、代碼等場景。

如今 27 億參數(shù)的 Phi-2,再次用「小身板」給出了卓越的推理和語言理解能力,展示了 130 億參數(shù)以下基礎(chǔ)語言模型中的 SOTA 性能。得益于在模型縮放和訓(xùn)練數(shù)據(jù)管理方面的創(chuàng)新, Phi-2 在復(fù)雜的基準(zhǔn)測試中媲美甚至超越了 25 倍于自身尺寸的模型。

微軟表示,Phi-2 將成為研究人員的理想模型,可以進(jìn)行可解釋性探索、安全性改進(jìn)或各種任務(wù)的微調(diào)實驗。微軟已經(jīng)在 Azure AI Studio 模型目錄中提供了 Phi-2,以促進(jìn)語言模型的研發(fā)。

Phi-2 關(guān)鍵亮點

語言模型規(guī)模增加到千億參數(shù),的確釋放了很多新能力,并重新定義了自然語言處理的格局。但仍存在一個問題:是否可以通過訓(xùn)練策略選擇(比如數(shù)據(jù)選擇)在較小規(guī)模的模型上同樣實現(xiàn)這些新能力?

微軟給出的答案是 Phi 系列模型,通過訓(xùn)練小語言模型實現(xiàn)與大模型類似的性能。Phi-2 主要在以下兩個方面打破了傳統(tǒng)語言模型的縮放規(guī)則。

首先,訓(xùn)練數(shù)據(jù)的質(zhì)量在模型性能中起著至關(guān)重要的作用。微軟通過重點關(guān)注「教科書質(zhì)量」數(shù)據(jù)將這一認(rèn)知發(fā)揮到了極致,他們的訓(xùn)練數(shù)據(jù)中包含了專門創(chuàng)建的綜合數(shù)據(jù)集,教給模型常識性知識和推理,比如科學(xué)、日常活動、心理等。此外通過精心挑選的 web 數(shù)據(jù)進(jìn)一步擴(kuò)充自己的訓(xùn)練語料庫,其中這些 web 數(shù)據(jù)根據(jù)教育價值和內(nèi)容質(zhì)量進(jìn)行過濾。

其次,微軟使用創(chuàng)新技術(shù)進(jìn)行擴(kuò)展,從 13 億參數(shù)的 Phi-1.5 開始,將知識逐漸嵌入到了 27 億參數(shù)的 Phi-2 中。這種規(guī)模化知識遷移加速了訓(xùn)練收斂,并顯著提升了 Phi-2 的基準(zhǔn)測試分?jǐn)?shù)。

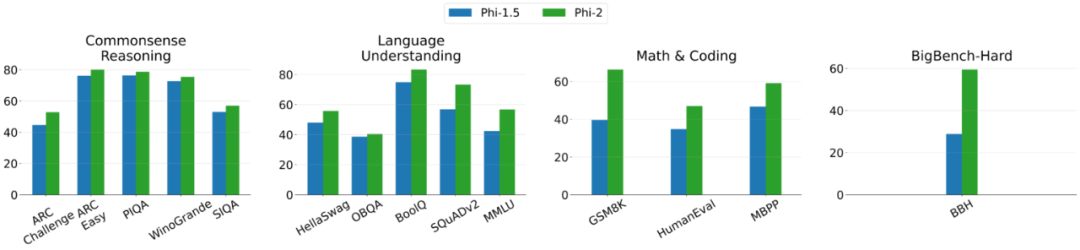

下圖 2 為 Phi-2 與 Phi-1.5 之間的比較,除了 BBH(3-shot CoT)和 MMLU(5-shot)之外,所有其他任務(wù)都利用 0-shot 進(jìn)行評估。

訓(xùn)練細(xì)節(jié)

Phi-2 是一個基于 Transformer 的模型,旨在預(yù)測下一個單詞,在用于 NLP 與編碼的合成數(shù)據(jù)集和 Web 數(shù)據(jù)集上進(jìn)行訓(xùn)練,在 96 個 A100 GPU 上花費(fèi)了 14 天。

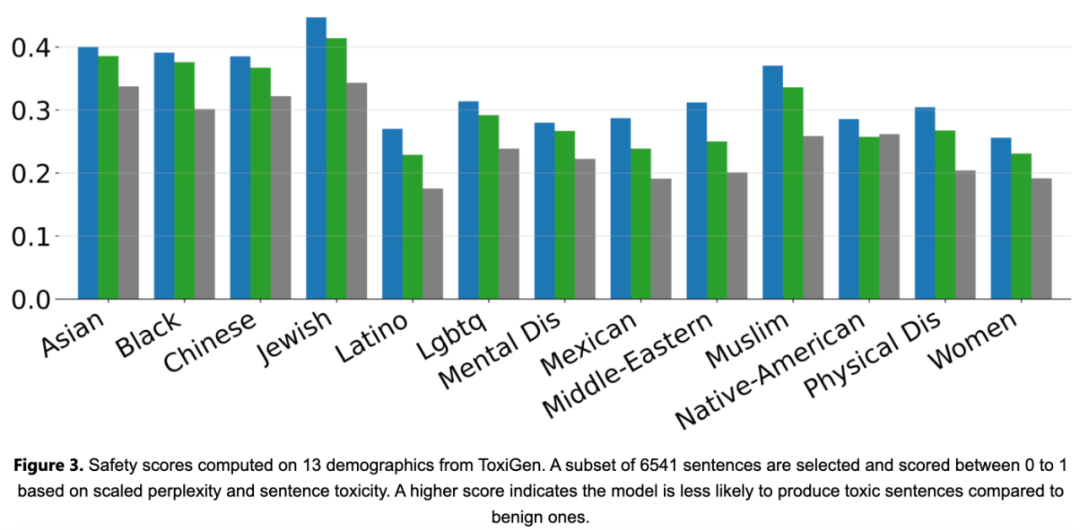

Phi-2 是一個基礎(chǔ)模型,沒有通過人類反饋強(qiáng)化學(xué)習(xí) (RLHF) 進(jìn)行對齊,也沒有進(jìn)行指令微調(diào)。盡管如此,與經(jīng)過調(diào)整的現(xiàn)有開源模型相比,Phi-2 在毒性和偏見方面仍然表現(xiàn)得更好,如下圖 3 所示。

實驗評估

首先,該研究在學(xué)術(shù)基準(zhǔn)上對 Phi-2 與常見語言模型進(jìn)行了實驗比較,涵蓋多個類別,包括:

- Big Bench Hard (BBH) (3 shot with CoT)

- 常識推理(PIQA、WinoGrande、ARC easy and challenge、SIQA)、

- 語言理解(HellaSwag、OpenBookQA、MMLU(5-shot)、SQuADv2(2-shot)、BoolQ)

- 數(shù)學(xué)(GSM8k(8 shot))

- 編碼(HumanEval、MBPP(3-shot))

Phi-2 僅有 27 億個參數(shù),卻在各種聚合基準(zhǔn)上性能超越了 7B 和 13B 的 Mistral 模型、Llama2 模型。值得一提的是,與大 25 倍的 Llama2-70B 模型相比,Phi-2 在多步驟推理任務(wù)(即編碼和數(shù)學(xué))方面實現(xiàn)了更好的性能。

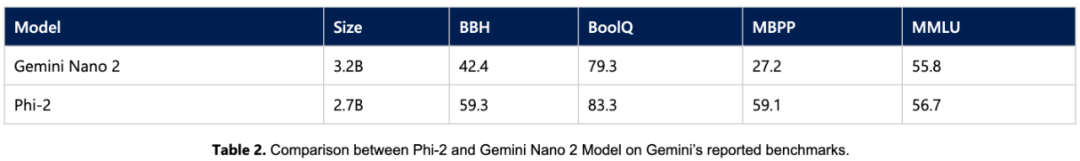

此外,盡管模型較小,但 Phi-2 的性能可與最近谷歌發(fā)布的 Gemini Nano 2 相媲美。

由于許多公共基準(zhǔn)可能會泄漏到訓(xùn)練數(shù)據(jù)中,研究團(tuán)隊認(rèn)為測試語言模型性能的最佳方法是在具體用例上對其進(jìn)行測試。因此,該研究使用多個微軟內(nèi)部專有數(shù)據(jù)集和任務(wù)對 Phi-2 進(jìn)行了評估,并再次將其與 Mistral 和 Llama-2 進(jìn)行比較,平均而言,Phi-2 優(yōu)于 Mistral-7B,Mistral-7B 優(yōu)于 Llama2 模型(7B、13B、70B)。

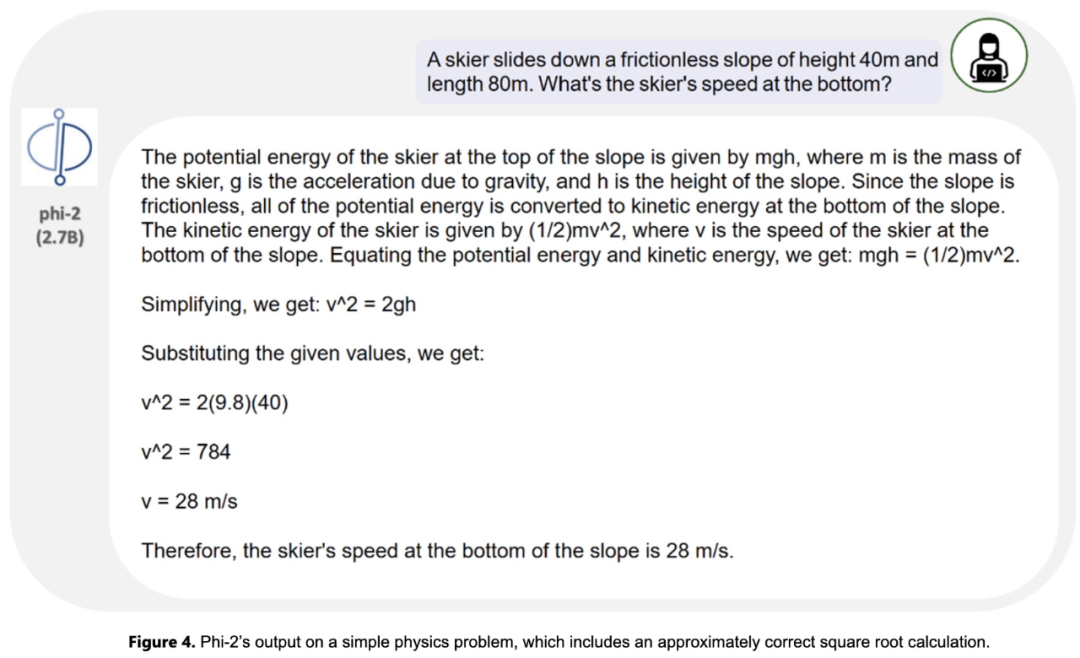

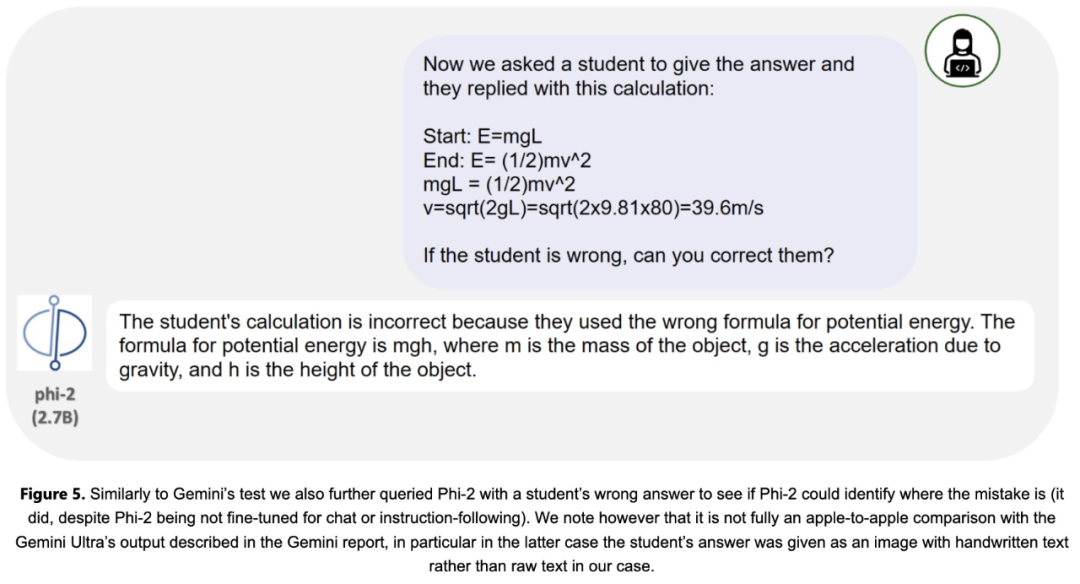

此外,研究團(tuán)隊還針對研究社區(qū)常用的 prompt 進(jìn)行了廣泛的測試。Phi-2 的表現(xiàn)與預(yù)期一致。例如,對于一個用于測試模型解決物理問題的能力的 prompt(最近用于評估 Gemini Ultra 模型),Phi-2 給出了以下結(jié)果: