最孤獨的神經網絡:只有一個神經元,但會「影分身」

要說世界上最先進的神經網絡模型是什么?那絕對是人腦莫屬了。

人腦有860億個神經元,相互結合在一起構成的神經網絡不僅在性能上超越人工神經網絡,能量消耗也少的驚人。

當下的人工智能系統試圖通過創建多層神經網絡來模仿人腦,旨在將盡可能多的神經元塞進盡可能少的空間。

這種方式雖然取得了性能進步,但這樣的設計不僅需要大量的電力,并且輸出的結果與人腦相比也是相形見絀。

根據估計,OpenAI在微軟數據中心使用 Nvidia GPU 訓練神經網絡GPT-3時,大約需要 190,000 千瓦時的電量,相當于丹麥 126 戶家庭每年使用的電量。如果換算成化石燃料產生的二氧化碳含量來算,相當于駕駛一輛汽車從地球出發往返一趟月球。

并且神經網絡以及使用巨大數據集訓練它們所需的硬件數量,還在不斷增長。以GPT為例,在GPT-3時已經有1750億個參數了,比前身GPT-2的參數量要多100倍。

這種「越大越好」的神經網絡設計顯然不符合可持續的科學發展觀。

來自柏林工業大學的一個多學科研究小組最近創建了一個新型神經「網絡」。但叫它網絡還是比較勉強的,因為它新就新在,只有一個神經元!

研究人員提出一種新的方法,能夠將一個任意大小的深度神經網絡折疊成一個具有多個延時反饋的單一神經元循環。這個單神經元深度神經網絡只包括一個單一的非線性和適當地調整反饋的信號,可以完全表示標準的深度神經網絡(DNN),包含稀疏DNN,和將DNN的概念擴展到動態系統的實現。

這個新模型也稱為時間折疊(Folded-in-time) Fit-DNN,在基準任務的測試中也表現出相當強的性能。

獨木難成林?

一個常規的神經網絡網絡需要在空間上申請多個節點彼此連接,而單個神經元模型則是在時間維度上進行擴散連接。

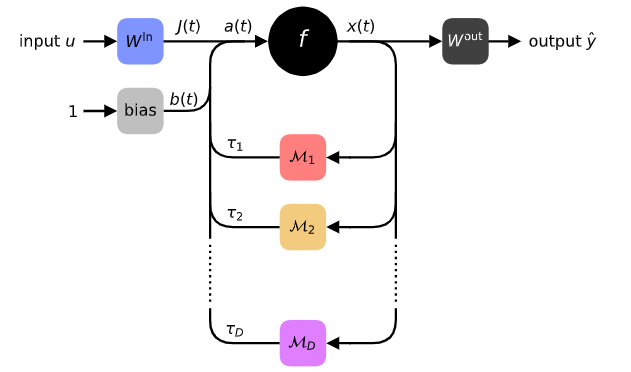

研究人員設計的多層前饋DNN的完全時間折疊的方法,只需要一個帶有反饋調節延遲環的單一神經元。通過非線性操作的時間順序化,可以實現一個任意深度或寬度的DNN。

在傳統的神經網絡中,如GPT-3,每個神經元都有一個權重值,以便對結果進行微調。但這種方式導致的結果通常是更多的神經元,產生更多的參數,而只有更多的參數才能產生更精確的結果。

但柏林工業大學的團隊發現,他們可以通過在不同時間對同一神經元進行不同的加權,而不是在空間上分散不同加權的神經元來實現類似功能。

這就好比在宴會上,你可以通過快速切換座位的方式,裝作不同的客人說出不同的部分來模擬餐桌上的對話。

聽起來有點「人格分裂」,但通過這種時序上的擴展,一個人(神經元)也可以完成多個人才能完成的事。

剛才提到「快速」切換,柏林團隊表示,這種說法已經很低調了。

實際上他們的系統通過激光在神經元中激活基于時間的反饋回路,理論上可以達到接近宇宙極限的速度——也就是以光速或接近光速進行神經網絡切換。

根據研究人員的說法,這對人工智能來說意味著,能夠顯著降低訓練超大規模神經網絡的能源成本。

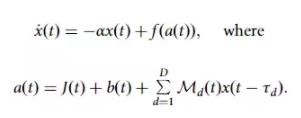

為了實現上述想法,研究人員假設系統狀態根據一般形式的微分方程在連續時間內演變。

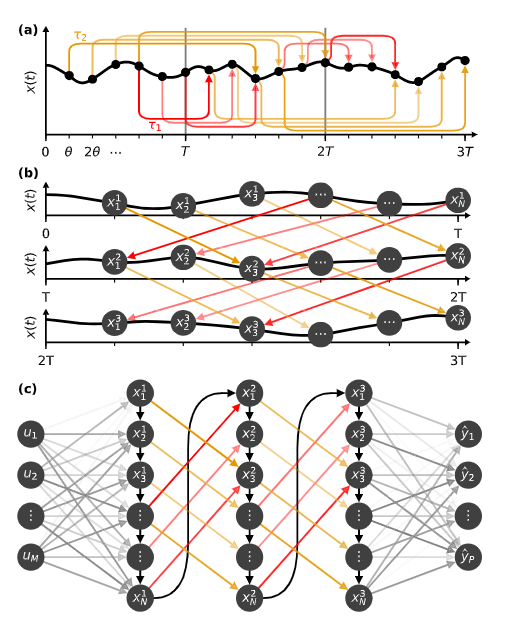

這里x(t)表示神經元在時間t的狀態;f是一個非線性函數,其參數a(t)結合了數據信號J(t)、時間變化的偏置b(t)以及由函數Md(t)調制的延時反饋信號x(t -τd)。可以明確考慮不同延遲長度τd的多個環路。由于反饋環路,系統成了一個所謂的延遲動力系統。

直觀地說,Fit-DNN中的反饋回路導致神經元重新引入已經通過非線性f的信息,這使得非線性f可以多次連鎖。經典的DNN通過逐層使用神經元來構成其可訓練的表征,而Fit-DNN則通過重復向同一神經元引入反饋信號來實現同樣的目的。

在每個pass中,時變的偏置b(t)和延遲線上的調制Md(t)確保系統的時間演變以期望的方式處理信息。為了獲得數據信號J(t)和輸出y,兩個變量都需要一個適當的前處理或后處理操作。

為了進一步說明Fit-DNN在功能上等同于多層神經網絡,可以看到Fit-DNN可以將具有多個延遲環的單個神經元的動態性轉化為DNN。

x(t)的時間演化可以分為長度為T的時間間隔,每個間隔模擬一個隱藏層。在每個區間中,選擇N個點。使用一個具有小時間間隔θ的等距時間網格。對于有N個節點的隱藏層來說,可以得出θ=T/N。在每個時間網格點tn=nθ,將系統狀態x(tn)作為一個獨立變量。每個時間網格點tn將代表一個節點,而x(tn)代表其狀態。可以進一步假設數據信號J(t)、偏置b(t)和調制信號Md(t)是步長為θ的步長函數。

作為一個非常稀疏的網絡,研究人員首先將Fit-DNN應用于圖像去噪任務:在Fashion-MNIST數據集的圖像中加入強度為方差為1的高斯噪聲,將其視為值在0(白色)和1(黑色)之間的向量。然后截斷閾值0和1處剪切所得到的向量條目,以獲得有噪聲的灰度圖像。去噪的任務就是要從其噪聲版本中重建原始圖像。

實驗結果對比了原始Fashion-MNIST圖像、其噪聲版本和重建圖像的例子。可以看到恢復的效果還是相當不錯的。

但Fit-DNN真正的問題是,時間循環的單個神經元是否能產生與數十億個神經元相同的結果。

為了證明Fit-DNN和時間狀態下的計算能力,研究人員選了五個圖像分類任務:MNIST40、Fashion-MNIST41、CIFAR-10、CIFAR-100,以及SVHN。

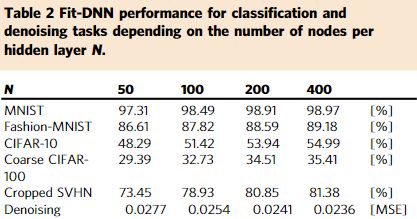

實驗對比了Fit-DNN在上述任務中每個隱藏層的不同節點數N=50、100、200和400時的表現。從結果中可以看到對相對簡單的MNIST和Fashion-MNIST任務上單個神經元取得了很高的準確率。但對于更具挑戰性的CIFAR-10、CIFAR-100和SVHN任務的準確率則比較低。

雖然這些結果顯然不能與當下sota模型創造的性能記錄相媲美,但它們是在一個新穎的、完全不同的架構上實現的。特別是,這里的Fit-DNN只使用了權重矩陣可用對角線的一半。對于測試的任務,增加N顯然會導致性能的提高。

隨著進一步的發展,科學家們相信該系統可以擴展到時間維度上「無限數量的」神經元連接。

他們表示,這樣的系統是可行的,它可以超越人腦,成為世界上最強大的神經網絡,這就是人工智能專家所說的「超級智能」。