深度學(xué)習(xí)入門課程筆記 神經(jīng)網(wǎng)絡(luò)

神經(jīng)網(wǎng)絡(luò):

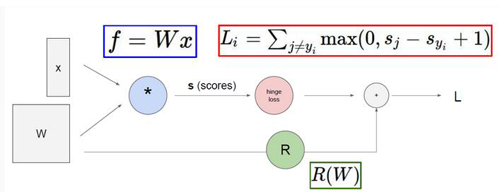

首先咱們先來(lái)回顧一下之前課程所講前向傳播和反向傳播知識(shí)點(diǎn),前往傳播 就是從輸入X到最終得到LOSS值的過(guò)程,反向傳播 是從最終的LOSS值經(jīng)過(guò)梯度的傳播最終計(jì)算出權(quán)重矩陣W中所有參數(shù)對(duì)于最終的LOSS值影響大小,更新參數(shù) 就是通過(guò)不同權(quán)重參數(shù)對(duì)終LOSS值的影響來(lái)調(diào)節(jié)參數(shù),使得咱們的參數(shù)矩陣W能夠更擬合咱們的數(shù)據(jù),也就是使得最終的LOSS值能夠降低。這一系列的過(guò)程就是相當(dāng)于完成了一次迭代

神經(jīng)網(wǎng)絡(luò)本質(zhì)

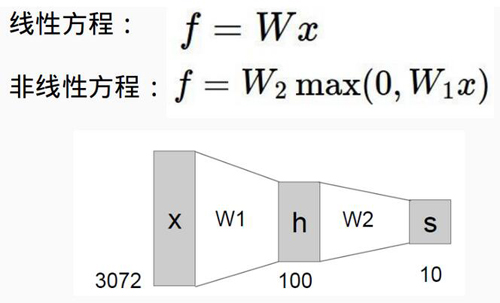

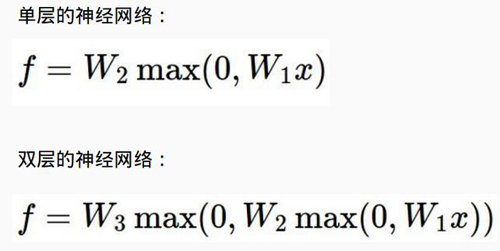

下面咱們就來(lái)看看神經(jīng)網(wǎng)絡(luò)跟傳統(tǒng)的線性分類到底有什么區(qū)別,從公式中我們可以看出,一個(gè)最明顯的區(qū)別就是神經(jīng)網(wǎng)絡(luò)函數(shù)多了一個(gè)MAX()計(jì)算 也就是說(shuō)我們?cè)蹅儸F(xiàn)在的函數(shù)公式變成了一個(gè)非線性的操作,也正是這種非線性的函數(shù)使得神經(jīng)網(wǎng)絡(luò)相比于傳統(tǒng)的線性分類更強(qiáng)大,因?yàn)榉蔷€性可以使得咱們的函數(shù)去擬合更復(fù)雜的數(shù)據(jù)。

神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)

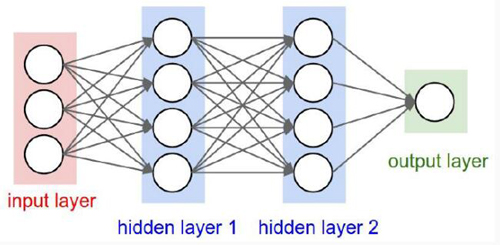

接下來(lái)咱們就來(lái)看一下神經(jīng)網(wǎng)絡(luò)的結(jié)構(gòu),從途中可以看出,神經(jīng)網(wǎng)絡(luò)是一個(gè)層次的結(jié)構(gòu)

輸入層 也就是代表著數(shù)據(jù)源

隱層 這個(gè)大家理解起來(lái)可能有些費(fèi)勁,咱們可以把隱層當(dāng)成是中間層也就是在這里對(duì)輸入數(shù)據(jù)進(jìn)行了非線性的變換

激活函數(shù) 它是跟隱層在一起的,比如這個(gè)MAX()函數(shù)就是一個(gè)激活函數(shù),正是因?yàn)榧せ詈瘮?shù)的存在才使得整個(gè)神經(jīng)網(wǎng)絡(luò)呈現(xiàn)出一種非線性的模式。

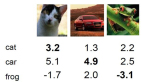

輸出層 這個(gè)就是最終得到的結(jié)果了,比如一個(gè)分類任務(wù),最終的輸出就是每個(gè)類別的概率值了

我們可以看到對(duì)應(yīng)于多層的網(wǎng)絡(luò)也就是有多個(gè)隱層,相當(dāng)于咱們又加了一層非線性函數(shù)MAX() ,這個(gè)理解起來(lái)很簡(jiǎn)單了吧,對(duì)于深層網(wǎng)絡(luò)來(lái)說(shuō),它具有更好的非線性也就是說(shuō)網(wǎng)絡(luò)的層數(shù)越深就更能夠去擬合更復(fù)雜的數(shù)據(jù)。

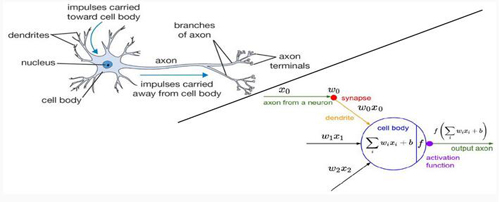

生物學(xué)上的結(jié)構(gòu)

看過(guò)很多講解都提高了把神經(jīng)網(wǎng)絡(luò)和人類的腦結(jié)構(gòu)相對(duì)比,我覺(jué)得這有些增加了游戲難度,因?yàn)楹芏嗤瑢W(xué)本身對(duì)生物學(xué)結(jié)構(gòu)就不是很清楚,又搞了這多名詞出來(lái),理解起來(lái)好像更費(fèi)勁了,這里咱們就不說(shuō)生物學(xué)結(jié)構(gòu)了,直接看右半部分,和之前的線性分類***的區(qū)別就是我們多了一個(gè)activation function 也就是咱們剛才所說(shuō)的激活函數(shù),可以說(shuō)正是激活函數(shù)的存在使得整個(gè)神經(jīng)網(wǎng)絡(luò)變得強(qiáng)大起來(lái)。

神經(jīng)元

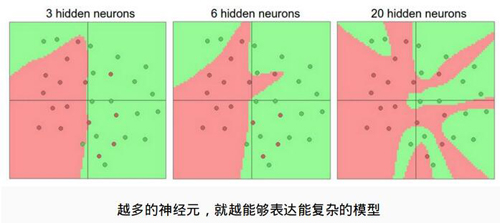

那么神經(jīng)網(wǎng)絡(luò)能表達(dá)多復(fù)雜的數(shù)據(jù)信息是由什么決定的呢?這個(gè)例子給了咱們很好的解釋,神經(jīng)網(wǎng)絡(luò)是表達(dá)能力是由神經(jīng)元的個(gè)數(shù),也就是每一個(gè)隱層所函數(shù)神經(jīng)元的個(gè)數(shù)來(lái)決定的,神經(jīng)元越多,層數(shù)越深表達(dá)的能力也就越強(qiáng),理論上我們認(rèn)為神經(jīng)元越多越好!

防止過(guò)擬合

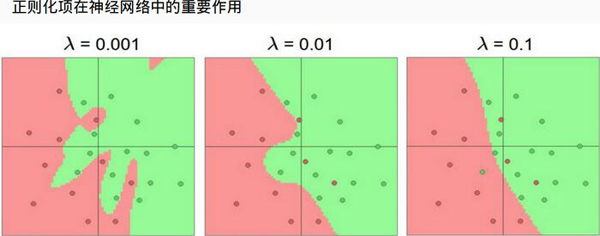

咱們剛才說(shuō)了神經(jīng)網(wǎng)絡(luò)具有很強(qiáng)的表達(dá)能力,但是也很危險(xiǎn)的,就是說(shuō)神經(jīng)網(wǎng)絡(luò)很容易發(fā)成過(guò)擬合現(xiàn)象,因?yàn)樵蹅冇写罅康纳窠?jīng)元也就是導(dǎo)致了我們需要的參數(shù)是極其多的,那么該怎么辦呢?最直接的方法就是加上正則化項(xiàng),它可以使得咱們的神經(jīng)網(wǎng)絡(luò)不至于過(guò)擬合很嚴(yán)重也是咱們訓(xùn)練神經(jīng)網(wǎng)絡(luò)必做的一項(xiàng),圖中顯示了正則化的作用!

【本文是51CTO專欄作者唐宇迪的原創(chuàng)稿件,轉(zhuǎn)載請(qǐng)注明出處】