Jeff Dean等人新作:換個角度審視語言模型,規(guī)模不夠發(fā)現(xiàn)不了

?近年來,語言模型對自然語言處理 (NLP) 產(chǎn)生了革命性影響。眾所周知,擴展語言模型,例如參數(shù)等,可以在一系列下游 NLP 任務上帶來更好的性能和樣本效率。在許多情況下,擴展對性能的影響通常可以通過擴展定律進行預測,一直以來,絕大多數(shù)研究者都在研究可預測現(xiàn)象。

相反,包括 Jeff Dean 、 Percy Liang 等在內(nèi)的 16 位研究者合作的論文《 Emergent Abilities of Large Language Models 》,他們討論了大模型不可預測現(xiàn)象,并稱之為大型語言模型的突現(xiàn)能力( emergent abilities)。所謂的突現(xiàn),即有些現(xiàn)象不存在于較小的模型中但存在于較大的模型中,他們認為模型的這種能力是突現(xiàn)的。

突現(xiàn)作為一種想法已經(jīng)在物理學、生物學和計算機科學等領域討論了很長時間,本論文從突現(xiàn)的一般定義開始,該定義改編自 Steinhardt 的研究,并植根于 1972 年諾貝爾獎獲得者、物理學家 Philip Anderson 的一篇名為 More Is Different 的文章。

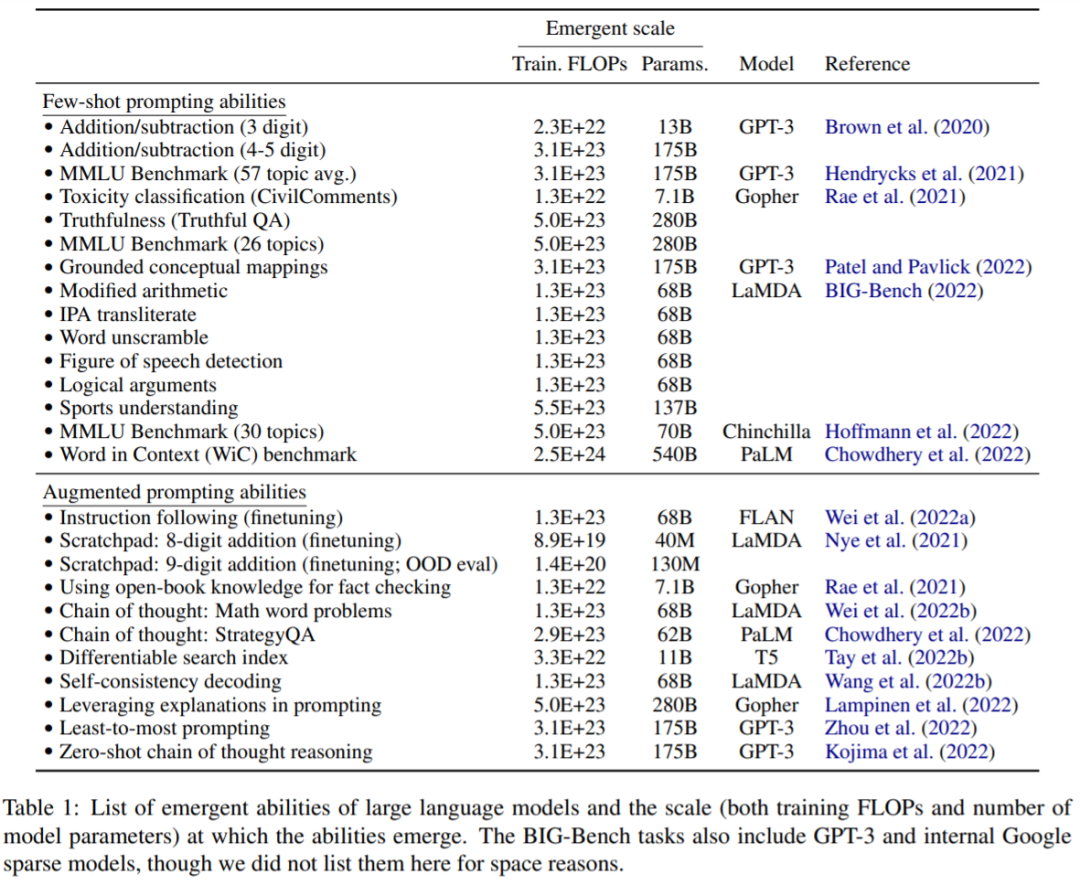

本文探討了模型規(guī)模的突現(xiàn),通過訓練計算和模型參數(shù)來衡量。具體而言,本文將大型語言模型的突現(xiàn)能力定義為在小規(guī)模模型中不存在、但在大規(guī)模模型中存在的能力;因此,大型模型不能通過簡單地推斷小規(guī)模模型的性能改進來進行預測。該研究調(diào)查了在一系列先前工作中觀察到的模型突現(xiàn)能力,并將它們進行分類:小樣本提示和增強提示等設置。

模型的這種突現(xiàn)能力激發(fā)了未來的研究,即為什么會獲得這些能力,以及更大的規(guī)模是否會獲得更多的突現(xiàn)能力,并強調(diào)了這項研究的重要性。

論文地址:https://arxiv.org/pdf/2206.07682.pdf

小樣本提示任務

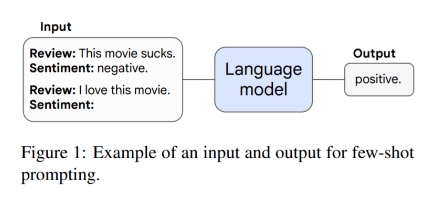

本文首先討論了提示范式中的突現(xiàn)能力。例如在 GPT-3 提示中,給出預訓練語言模型任務提示,模型無需進一步訓練或?qū)?shù)進行梯度更新即可完成響應。此外,Brown 等人提出了小樣本提示,他們將模型上下文(輸入)中的一些輸入輸出示例作為提示(preamble),然后要求模型執(zhí)行未見過的推理任務。圖 1 為一個提示示例。

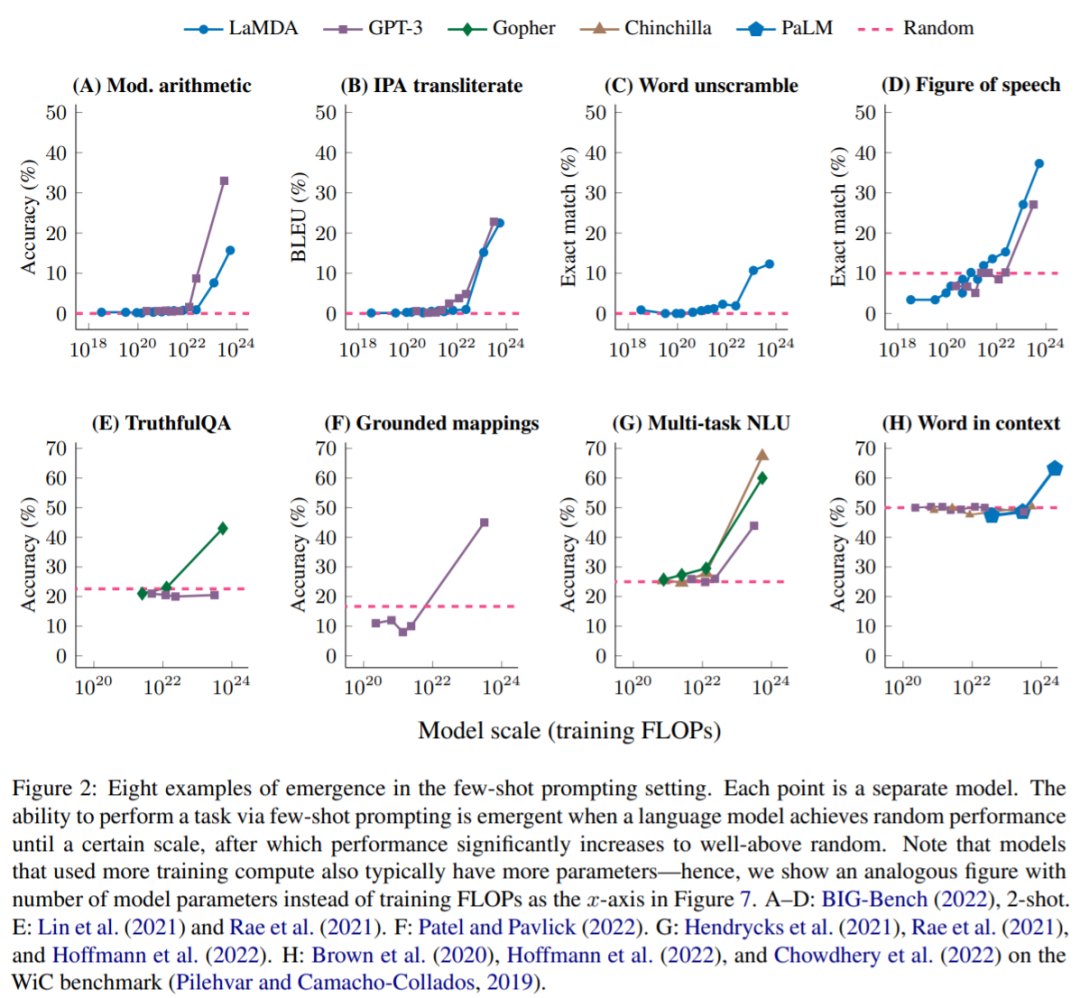

當模型具有隨機性能且具有一定規(guī)模時,通過小樣本提示就可以執(zhí)行任務,這時突現(xiàn)能力就會出現(xiàn),之后模型性能遠遠高于隨機性能。下圖展示了 5 個語言模型系列(LaMDA、GPT-3、Gopher、Chinchilla 以及 PaLM )的 8 種突現(xiàn)能力。

BIG-Bench:圖 2A-D 描述了來自 BIG-Bench 的四個突現(xiàn)小樣本提示任務,BIG-Bench 是一個由 200 多個語言模型評估基準的套件。圖 2A 顯示了一個算術基準,它測試了 3 位數(shù)字的加減法,以及 2 位數(shù)字的乘法。表 1 給出了 BIG-Bench 更多突現(xiàn)能力。

增強提示策略

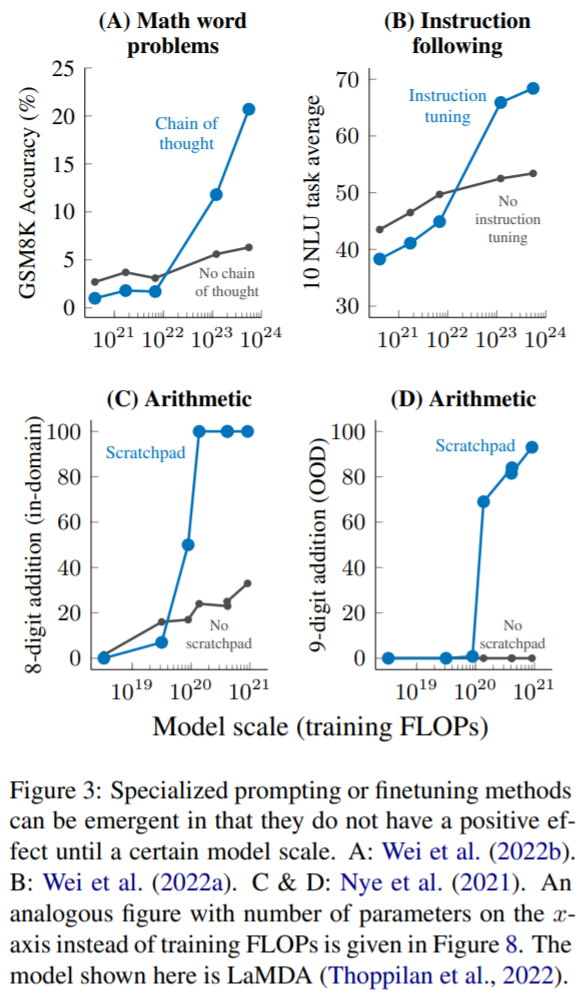

目前來看,盡管小樣本提示是與大型語言模型交互的最常見方式,但最近的工作已經(jīng)提出了其他幾種提示和微調(diào)策略,以進一步增強語言模型的能力。如果一項技術在應用到一個足夠大的模型之前沒有顯示出改進或者是有害的,本文也認為該技術也是一種突現(xiàn)能力。

多步推理(Multi-step reasoning):對于語言模型和 NLP 模型來說,推理任務,尤其是那些涉及多步推理的任務一直是一個很大的挑戰(zhàn)。最近有一種名為思維鏈(chain-of-thought)提示策略,通過引導語言模型在給出最終答案之前生成一系列中間步驟,從而使它們能夠解決這類問題。如圖 3A 所示,當擴展到 1023 次訓練 FLOP(~ 100B 參數(shù))時,思維鏈提示只超過了沒有中間步驟的標準提示。

指令( Instruction following ):如圖 3B 所示,Wei 等人發(fā)現(xiàn),當訓練 FLOP 為 7 · 10^21 (8B 參數(shù))或更小時,指令微調(diào)(instruction-finetuning)技術會損害模型性能,在將訓練 FLOP 擴展到 10^23 (~100B 參數(shù))時才能提高性能。

程序執(zhí)行( Program execution ):如圖 3C 所示,在 8 位加法的域內(nèi)評估中,使用暫存器僅有助于 ~9 · 10^19 個訓練 FLOP(40M 參數(shù))或更大的模型。圖 3D 顯示這些模型也可以泛化到域外 9 位加法,它出現(xiàn)在 ~1.3 · 10^20 個訓練 FLOPs(100M 參數(shù))。

本文討論了語言模型的突現(xiàn)能力,到目前為止,僅在一定的計算規(guī)模上才能觀察到有意義的性能。模型的這種突現(xiàn)能力可以跨越各種語言模型、任務類型和實驗場景。這種突現(xiàn)的存在意味著額外的規(guī)模擴展可以進一步擴大語言模型的能力范圍。這種能力是最近發(fā)現(xiàn)的語言模型擴展的結(jié)果,關于它們是如何出現(xiàn)的,以及更多的擴展是否會帶來更多的突現(xiàn)能力,可能是NLP領域未來重要的研究方向。

更多內(nèi)容,請參考原論文。?