谷歌PaLM模型也被外行宣布覺醒了?業內人:理性測試只比GPT好3%

「通用人工智能」現在幾乎已經成了2020年代的「水變油」科技,差不多每半個月都會有人宣布發現/確信某個大模型的表現是已經覺醒了人性、AI「活過來」了。 最近此類消息鬧得最兇的是谷歌。廣為人知的是前研究員Blake Lemoine說大語言模型LaMDA「活了」,這位老哥不出所料地進入了被離職流程。

其實幾乎與之同時的,還有《大西洋月刊》的谷歌準軟文在說,另一個新款大語言模型PaLM也成了「真正的通用人工智能」(It is a true artificial general intelligence)。

《大西洋月刊》強行宣布PaLM成AGI

只不過這篇文章幾乎沒人讀,因此引發的討論和抨擊只有寥寥而已。

然而,世界級大刊吹捧世界級大廠的稿件,即使再沒人讀,也像老電影臺詞說的一樣,「就好像黑夜里的螢火蟲一樣,那么鮮明,那么出眾……」 2022年6月19日,《大西洋月刊》發布題為《人工意識好無聊》(Artificial Consciousness Is Boring)的文章。

而《大西洋月刊》此文的網頁標題比欲蓋彌彰的文章標題直白:《谷歌的PaLM AI比真實意識要奇怪得多》(Google's PaLM AI Is Far Stranger Than Conscious)。

內文不出意料,是作者采訪谷歌大腦的PaLM項目組成員之后的種種溢美之詞: 5400億參數,能不預先訓練就完成數百種不同的任務。能說笑話,能總結概述文本。 如果用戶輸入孟加拉語問題,PaLM模型可以用孟加拉語和英語答復。

如果用戶要求把一段代碼從C語言譯為Python,PaLM模型也能快速完成。 但此文逐漸從疑似軟文的夸夸訪談稿,走向了一個吹吹翻車稿:宣布PaLM模型是「真正的通用人工智能」(It is a true artificial general intelligence)。

「PaLM的功能嚇到了開發者們,需要智識上的酷炫和距離、才能不被嚇到且接受—PaLM具有理性。」(the function that has startled its own developers, and which requires a certain distance and intellectual coolness not to freak out over. PaLM can reason.)

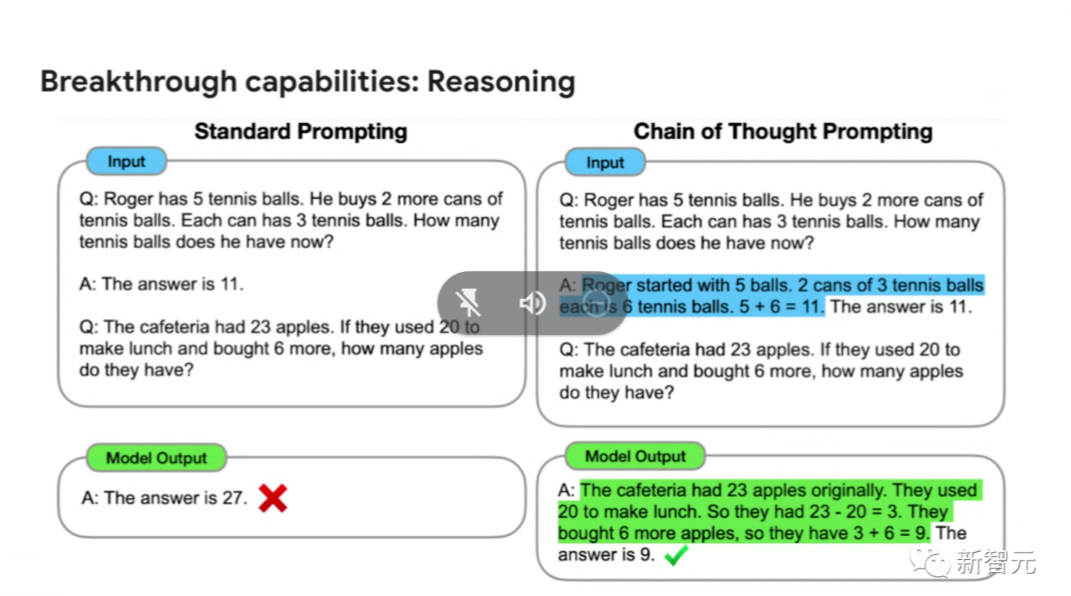

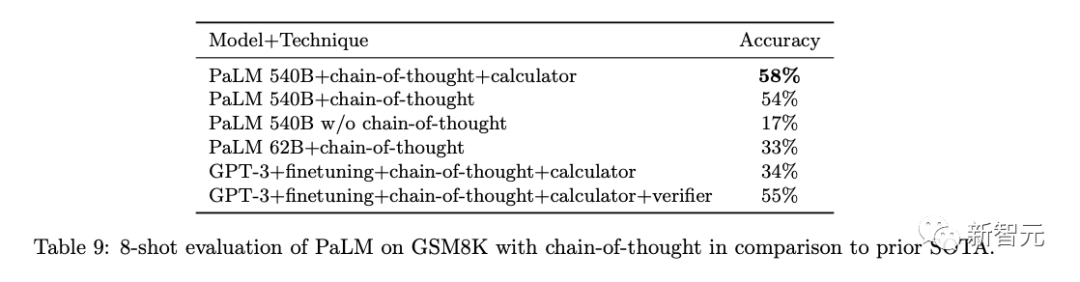

這是谷歌本月第二次有大模型被強行宣布是AGI了。 這個宣稱的依據何在呢?按此文作者說,是因為PaLM模型可以在沒有預先特定訓練的前提下,自行「跳出定式」來解決不同的智能任務。 而且PaLM模型擁有「思維鏈提示」功能,用白話說是將問題求解過程給PaLM模型拆解、解釋、演示一遍后,PaLM就能自行得出正確答案啦。

Jeff Dean本人從未說過PaLM是AGI

噱頭和證據之間的差距,有極大的「褲脫看這」感覺:原來《大西洋月刊》的作者,也有不查料就開始采訪人寫稿的習慣啊。

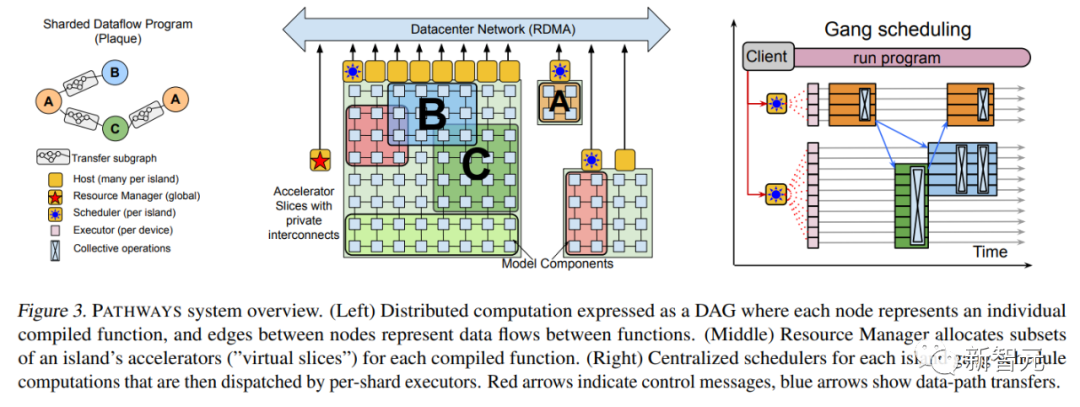

之所以這么說,是因為Jeff Dean老師帶隊推出PaLM模型時,介紹過「思維鏈提示」功能。但谷歌大腦可絕不敢自吹這個產品是個已經活過來的「終結者」。 2021年10月,Jeff Dean親自撰文介紹了一個全新的機器學習架構——Pathways。 目的很簡單,就是讓一個AI能夠跨越數以萬計的的任務,理解不同類型的數據,并同時以極高的效率實現:

在大半年之后的2022年3月,Jeff Dean終于發布了Pathways的論文。  論文地址:https://arxiv.org/abs/2203.12533 其中,補充了不少技術上的細節,比如最基本的系統架構等等。

論文地址:https://arxiv.org/abs/2203.12533 其中,補充了不少技術上的細節,比如最基本的系統架構等等。

2022年4月,谷歌用Pathways系統構造的PaLM語言模型面試世,這個擁有5400億參數的Transformer語言模型,接連打破多項自然語言處理任務的SOTA。 除了用到強大的Pathways系統外,論文中介紹PaLM的訓練用到了6144個TPU v4,使用了7800億token的高質量數據集,并且其中有22%的非英文、多語種語料。

論文地址:https://arxiv.org/abs/2204.02311 「自監督學習」、「思維鏈提示」在此前就是AI業界不陌生的概念,PaLM模型只是更進一步將概念落地具現化。 而雪上加霜的是,《大西洋月刊》此文直說了「谷歌研究者們也不清楚PaLM模型為何能達到此功能」………… 這是嫌Jeff Dean老師太閑、給他找事做啊。

批評者:《大西洋月刊》說法不靠譜

果然,美國加州圣菲研究所的成員Melanie Mitchell教授在自己的社交網站賬號上發連續貼,含蓄但堅定地質疑了《大西洋月刊》此文。

Melanie Mitchell表示:「這文章很有趣,不過我認為作者可能沒有采訪谷歌研究者以外的AI界專業人士。

比如其中種種聲稱PaLM模型『真正AGI』的證據。我本人是沒有使用PaLM的權限啊,不過谷歌4月自己發布論文中只是在幾個基準測試上有效果顯著的小樣本學習測試,但并非PaLM的所有小樣本學習測試結果都同樣穩健。

并且其中測試中使用的基準,有多少使用『捷徑學習』這一簡化難度的技術,論文中也未提到。 按照《大西洋月刊》文章的措辭,PaLM至少可以高可靠度、高通用度、一般精度來完成各種任務。

然而不論是此文還是谷歌4月論文,都沒有詳細描述PaLM模型在通用智能方面的能力與局限,也沒有提及測試此方面能力的基準。

并且PaLM『具有理性』的聲稱尤其需要被驗證。 GPT系列的類似聲稱,因為其訪問權限的開放性,已經被在其上跑各種實驗的業內人士證偽了。如果PaLM要獲得如此殊榮,就該接受同等程度的對抗性驗證。

還有,按谷歌4月論文的自白,PaLM的理性方面基準測試也就比業內幾個同類SOTA模型好一點點,優勝不多。

最關鍵一點,PaLM的論文未經同儕評議、模型也不對外界開放任何訪問權限。所有聲稱都只算一張嘴在吹,無法證實、無法復現、無法評估。」