完爆GPT3、谷歌PaLM!檢索增強模型Atlas刷新知識類小樣本任務SOTA

不知不覺間,大模型+小樣本成為了小樣本學習領域的主流打法,在許多的任務背景下,一套通用的思路是先標注小數據樣本,再從預訓練大模型的基礎上使用小數據樣本進行訓練。盡管如我們所見,大模型在一眾小樣本學習的任務上都取得了驚人的效果,但是它也自然而然的將一些大模型固有的弊病放置在了小樣本學習的聚光燈下。

小樣本學習期望模型具有依據少量樣本完成自主推理的能力,也就是說理想中的模型應該通過做題而掌握解題思路,從而面對新出現的題可以舉一反三。然而大模型+小樣本的理想且實用的學習能力,似乎卻是靠大模型訓練期間儲存的大量信息來生生把一道題解設答的過程背誦下來,盡管在各個數據集上神勇無比,但總會給人帶來疑惑依照這種方法學習出來的學生真的是一個有潛力的學生嗎?

而今天介紹的這篇由 Meta AI 推出的論文,便另辟蹊徑的將檢索增強的方法應用于小樣本學習領域,不僅僅用64個示例便在自然問答數據集(Natural Questions)上取得了42%的正確率,同時還對標大模型 PaLM 將參數量減少了 50 倍(540B—>11B),并且在可解釋性、可控性、可更新性等方面上都具有其余大模型所不具備的顯著優勢。

論文題目:Few-shot Learning with Retrieval Augmented Language Models論文鏈接:https://arxiv.org/pdf/2208.03299.pdf

檢索增強溯源

論文一開始,便向大家拋出了一個問題:“在小樣本學習領域,使用巨量的參數去存儲信息真的是必要的嗎?”,縱觀大模型的發展,前仆后繼的大模型可以樂此不疲的刷SOTA的原因之一,便是其龐大的參數存儲了問題所需的信息。從 Transformer 橫空出世以來,大模型一直是 NLP 領域的主流范式,而隨著大模型的逐步發展,“大”的問題不斷暴露,追問所謂“大”的必要性便相當有意義,論文作者從這個問題出發,給予了這個問題否定的答案,而其方法,便是檢索增強模型。

溯源檢索增強,其實盡管其技術主要被應用于諸如開放域問答、機器閱讀以及文本生成等任務之中,但是檢索增強的思想可以一直上溯到 NLP 的 RNN 時代。RNN 模型無法解決數據長期依賴關系的硬傷促使研究者們開始廣泛探索解決之道,而我們相當熟悉的 Transformer 便使用 Attention 機制有效解決了這個模型記不住的問題,從而開啟了預訓練大模型的時代。

而在當時,其實還有另外一條路子,便是 Cached LM,它的核心思想在于,既然 RNN 一上考場就有可能記不住,那么干脆就讓 RNN 開卷考試,通過引入 Cache 機制,把訓練時預測的詞語存在 Cache 中,預測時便可以結合 query 與 Cache 索引兩方面的信息來完成任務,從而解決當時 RNN 模型的硬傷。

由此,檢索增強技術便走上了一條與大模型依賴參數記憶信息的迥然不同的道路。基于檢索增強的模型允許引入不同來源的外部知識,而這些檢索源有訓練語料、外部數據、無監督數據等多種選擇。檢索增強模型一般由一個檢索器與一個生成器構成,通過檢索器根據 query 從外部檢索源獲得相關知識,通過生成器結合 query 與檢索到的相關知識進行模型預測。

歸根結底,檢索增強模型的目標是期望模型不僅學會記憶數據,同時希望模型學會自己找到數據,這點特性在許多知識密集型的任務中具有極大的優勢并且檢索增強模型也在這些領域取得了巨大的成功,但是檢索增強是否適用于小樣本學習卻不得而知。回到 Meta AI 的這篇論文,便成功試驗了檢索增強在小樣本學習中的應用,Atlas 便應運而生。

模型結構

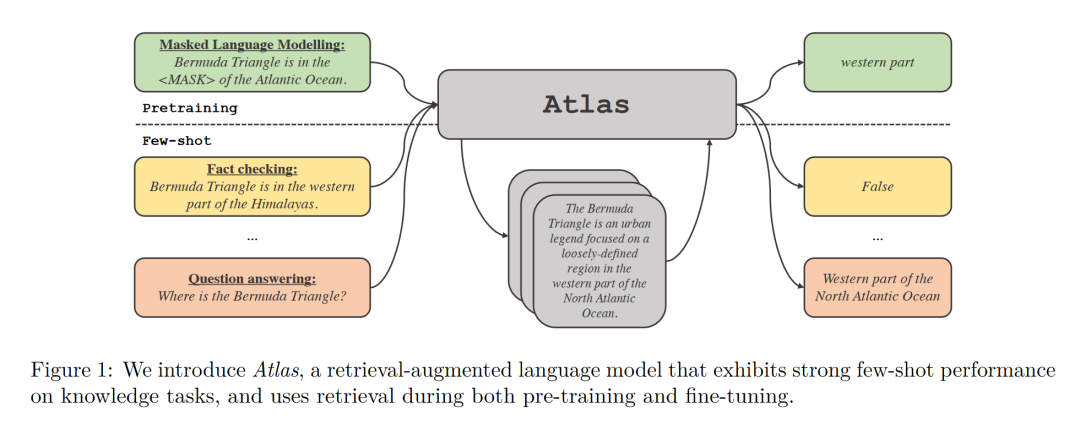

Atlas 擁有兩個子模型,一個檢索器與一個語言模型。當面對一個任務時,Atlas 依據輸入的問題使用檢索器從大量語料中生成出最相關的 top-k 個文檔,之后將這些文檔與問題 query 一同放入語言模型之中,進而產生出所需的輸出。

Atlas 模型的基本訓練策略在于,將檢索器與語言模型使用同一損失函數共同訓練。檢索器與語言模型都基于預訓練的 Transformer 網絡,其中:

- 檢索器基于 Contriever 設計,Contriever 通過無監督數據進行預訓練,使用兩層編碼器,query 與 document 被獨立的編碼入編碼器中,并通過相應輸出的點乘獲得 query 與 document 的相似度。這種設計使得 Atlas 可以在沒有文檔標注的情況下訓練檢索器,從而顯著降低內存需求。

- 語言模型基于 T5 進行訓練,將不同文檔與 query 相互拼接,由編碼器分別獨立處理,最后,解碼器對于所有檢索的段落串聯進行 Cross-Attention 得到最后的輸出。這種 Fusion-in-Decoder 的方法有利于 Atlas 有效的適應文檔數量的擴展。

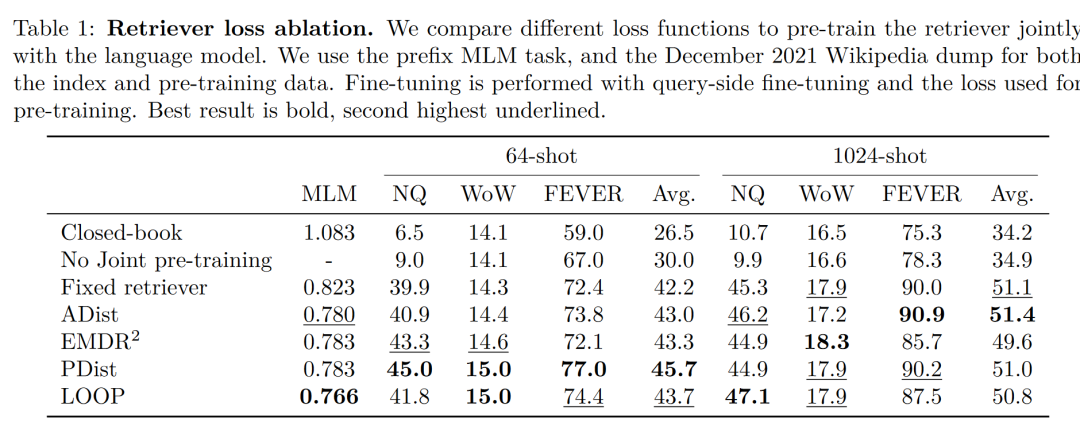

值得注意的是,作者對比試驗了四種損失函數以及不做檢索器與語言模型聯合訓練的情況,結果如下圖:

可以看出,在小樣本環境下,使用聯合訓練的方法所得到的正確率顯著高于不使用聯合訓練的正確率,因此,作者得出結論,檢索器與語言模型的這種共同訓練是 Atlas 獲得小樣本學習能力的關鍵。

實驗結果

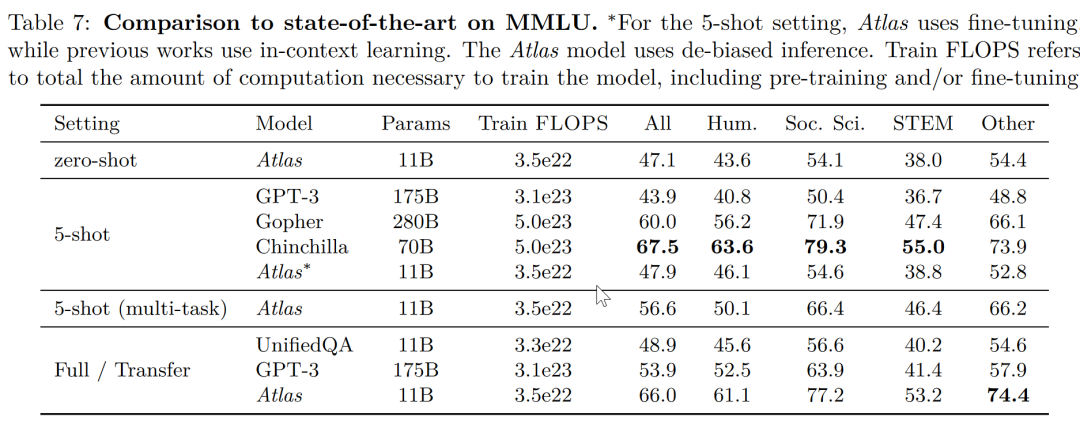

在大規模多任務語言理解任務(MMLU) 中,對比其他模型,Atlas 在參數量只有 11B 的情況下,具有比 15 倍于 Atlas 參數量的 GPT-3 更好的正確率,在引入多任務訓練后,在 5-shot 測試上正確率甚至逼近了 25 倍于 Atlas 參數量的 Gopher。

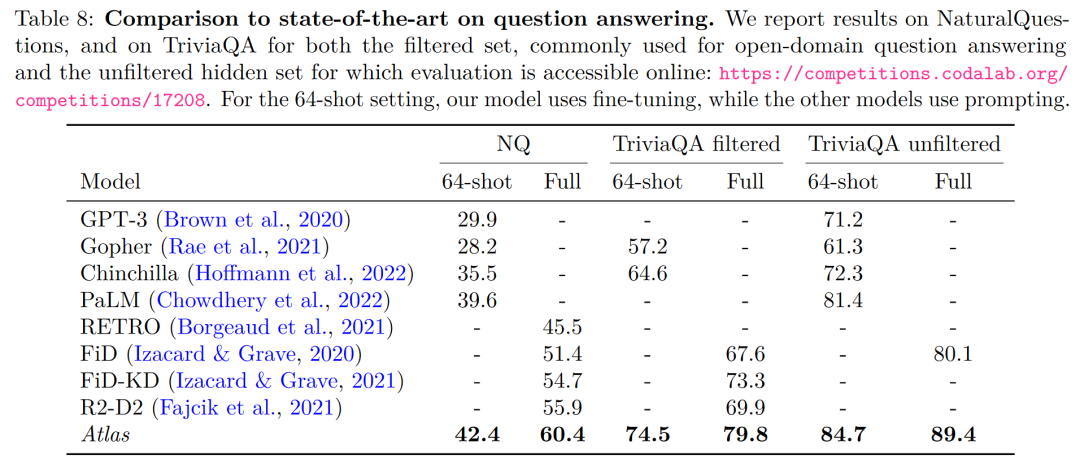

在開放域問答的兩個測試數據——NaturalQuestions 以及 TriviaQA 中,對比了 Atlas 與其他模型在 64 個例子上的表現以及全訓練集上的表現如下圖所示,Atlas 在 64-shot 中取得了新的 SOTA,在 TrivuaQA 上僅用 64 個數據便實現了 84.7% 的準確率。

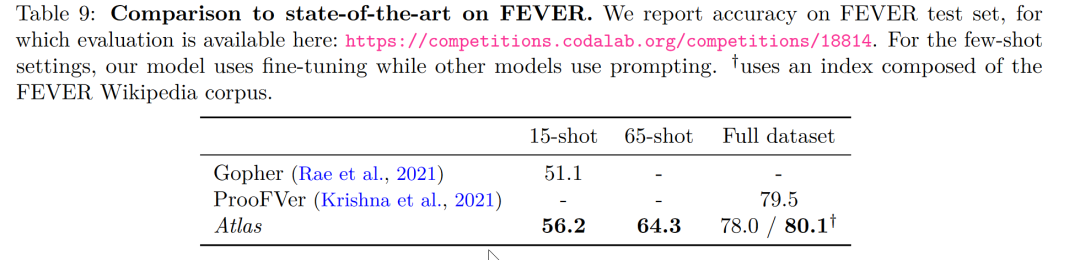

在事實核查任務(FEVER)中,Atlas 在小樣本的表現也顯著優于參數量數十倍于 Atlas 的 Gopher 與 ProoFVer,在 15-shot 的任務中,超出了 Gopher 5.1%。

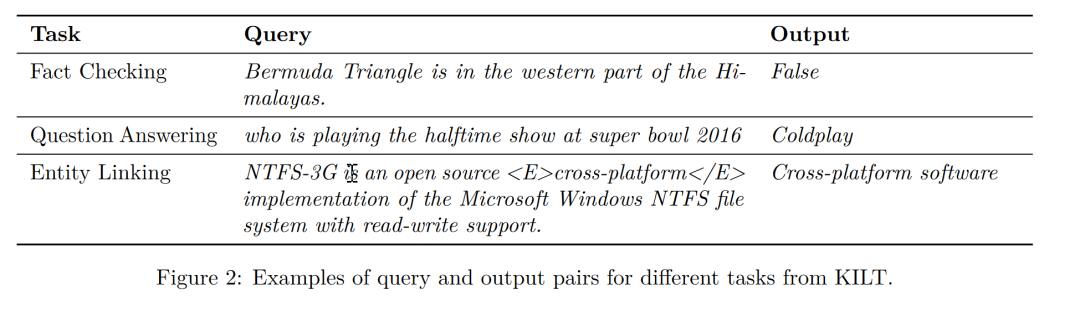

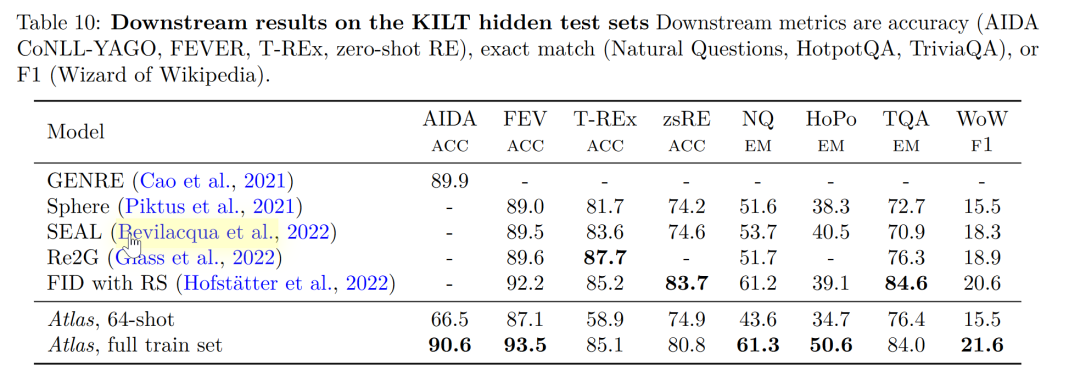

在自家發布的知識密集型自然語言處理任務基準 KILT 上,在一些任務里使用 64 個樣本訓練的 Atlas 的正確率甚至接近了其他模型使用全樣本所獲得的正確率,在使用全樣本訓練 Atlas 后,Atlas 在五個數據集上都刷新了 SOTA。

可解釋性、可控性、可更新性

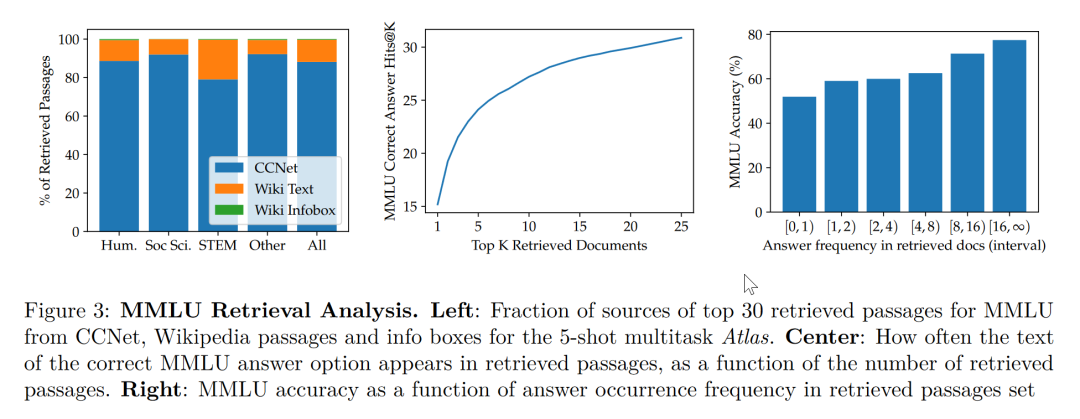

根據這篇論文的研究,檢索增強模型不僅兼顧了更小與更好,同時在可解釋性方面也擁有其他大模型不具備的顯著優勢。大模型的黑箱屬性,使得研究者很難以利用大模型對模型運行機理進行分析,而檢索增強模型可以直接提取其檢索到的文檔,從而通過分析檢索器所檢索出的文章,可以獲得對 Atlas 工作更好的理解。譬如,論文發現,在抽象代數領域,模型的語料有 73% 借助了維基百科,而在道德相關領域,檢索器提取的文檔只有3%來源于維基百科,這一點與人類的直覺相符合。如下圖左邊的統計圖,盡管模型更偏好使用 CCNet 的數據,但是在更注重公式與推理的 STEM 領域,維基百科文章的使用率明顯上升。

而根據上圖右邊的統計圖作者發現,隨著檢索出的文章中包含正確答案的次數的升高,模型準確率也不斷上升,在文章不包含答案時正確只有 55%,而在答案被提到超過 15 次時,正確率來到了 77%。除此之外,在人為檢查了 50 個檢索器檢索出的文檔時,發現其中有 44% 均包含有用的背景信息,顯然,這些包含問題背景信息的資料可以為研究者擴展閱讀提供很大的幫助。

一般而言,我們往往會認為大模型存在訓練數據“泄露”的風險,即有時大模型針對測試問題的回答并非基于模型的學習能力而是基于大模型的記憶能力,也就是說在大模型學習的大量語料中泄露了測試問題的答案,而在這篇論文中,作者通過人為剔除可能會發生泄露的語料信息后,模型正確率從56.4%下降到了55.8%,僅僅下降0.6%,可以看出檢索增強的方法可以有效的規避模型作弊的風險。

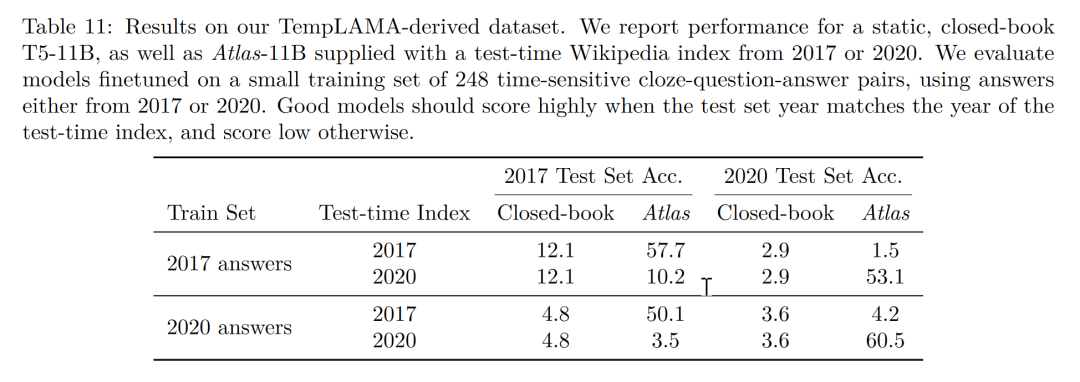

最后,可更新性也是檢索增強模型的一大獨特優勢,檢索增強模型可以無需重新訓練而只需更新或替換其依托的語料庫實現模型的時時更新。作者通過構造時序數據集,如下圖所示,在不更新 Atlas 參數的情況下,僅僅通過使用 2020 年的語料庫 Atlas 便實現了 53.1% 的正確率,而有趣的是即使是用2020年的數據微調 T5 ,T5 也沒有很好的表現,作者認為,原因很大程度上是由于 T5 的預訓練使用的數據是 2020 年以前的數據。

結論

我們可以想象有三個學生,一個學生解題只靠死記硬背,一道數學題可以把答案分毫不差的背誦下來,一個學生就靠查書,遇到不會先去翻找資料找到最合適的再一一作答,而最后一個學生則天資聰明,簡單的學習一些教科書上的知識便可以自信去考場揮毫潑墨指點江山。

顯然,小樣本學習的理想是成為第三個學生,而現實卻很可能停留在了第一個學生之上。大模型很好用,但“大”絕不是模型最終的目的,回到小樣本學習期望模型具有與人類相似的推理判斷與舉一反三能力的初心,那么我們可以看到,這篇論文是換個角度也好是前進一步也罷,至少是讓那個學生可以輕松一點不往腦袋里裝那么多可能大量冗余的知識,而可以拎起一本教科書輕裝上陣,或許哪怕允許學生開卷考試帶著教科書不斷翻查,也會比學生生搬硬套死記硬背更接近智能吧!